1.什么是眼控技术

眼控,顾名思义就是用眼睛来控制我们身边需要用手去操作的事物,从而解放我们的双手。具体来讲,眼控技术是用精密的光学装置和先进的图像识别算法实时计算眼睛所在的位置,并用眼睛来控制WEB网页原型终端、APP原型终端、车载HMI原型、以及VR虚拟现实、AR等测试载体。

2.眼控交互的五种方法

01 侵入式的搜索线圈法

作为最早的眼控交互设计方法,需要参与试验的人员佩戴镜片,这种镜片需要具有磁场感应线圈,并通过固定的磁场测量眼球的运动形式,这种方法作为先驱者是一种突破性的发展,但由于该种侵入式设备对用户不太友好,很容易干扰用户眼睛的判断行为,导致实验数据不太完美。

02 眼电图法

该方法的实现主要基于眼球运动时视网膜与角膜之间的电位差,此电位差因眼球各位置代谢能力的不同而产生0.4-1.0mV的差异,但这种侵入式设备需要两对电极置于眼睛左右、上下两侧,虽然解决了成本的问题,但是对人的干扰太大。

03 瞳孔-角膜反射法

注视点位置是通过测定瞳孔中心及角膜反射来确定,当红外线照射到使用者眼睛时,瞳孔最暗,然后利用参照点即可判断出瞳孔中心和确定眼睛的注视点,对于这种方法,高精度计算机器处理器,光学元件以及高级的图像处理算法都是必要的,作为非侵入式的实现检测方法,具备对人体干扰少,精度高等优点。Tobii系列眼动仪采用该技术。

04 Leading-EDGE活动照明技术

FaceLAB4.0眼动仪中使用该技术,极大提高了注视的可靠性和精度,利用多部立体摄像机,双图独立追踪,利用红外光照,解决了正常光照下人脸的识别难题。

05 视线跟踪法

采用普通摄像头作为输入设备,大大降低了成本,与此同时也减少了对用户的干扰,虽然引入了粒子滤波、卡尔曼滤波、3D模型匹配等算法,但仍然无法解决速度、准确性和鲁棒性三者之间的矛盾。

3.ErgoLAB新型交互模式---眼控交互

为给广大研究学者和老师们带来更好的用户体验,ErgoLAB在人机交互领域不断探索,除键鼠交互、手指轨迹交互、语音交互外还融入了眼控交互技术作为新型辅助交互方式,进一步实现与网页原型终端、APP原型终端、以及车载HMI原型进行交互控制。

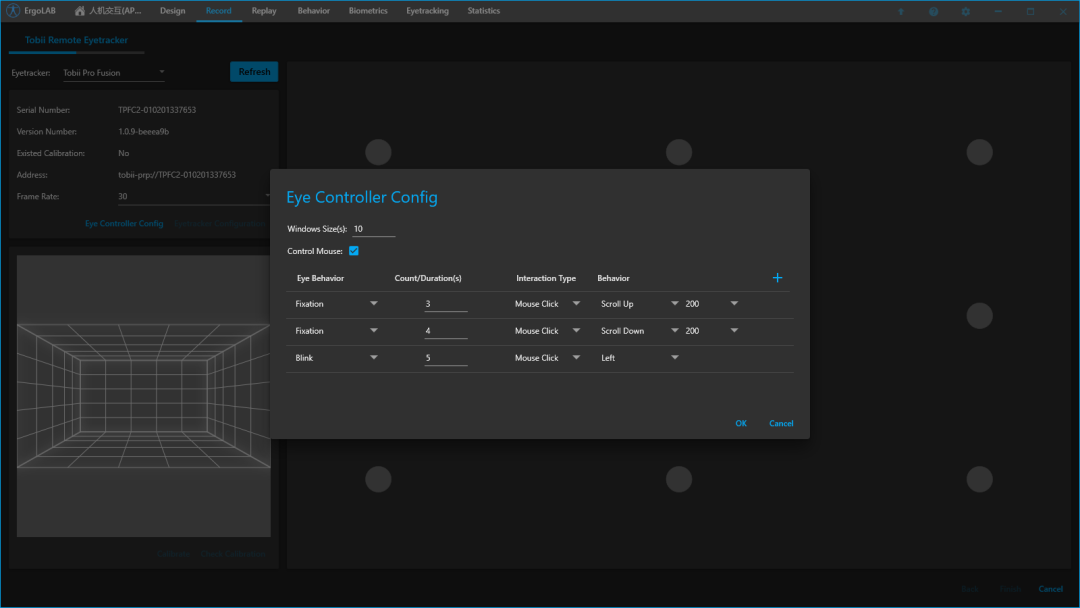

详细配置如下:

-

实验开始前,用户自定义眼动状态如:眨眼(次数)、注视(时长)等状态作为人机交互的控制信号源;支持将眼动状态转化为鼠标行为、键盘行为、以及多类型的自定义行为进行外部设备的交互与控制。

-

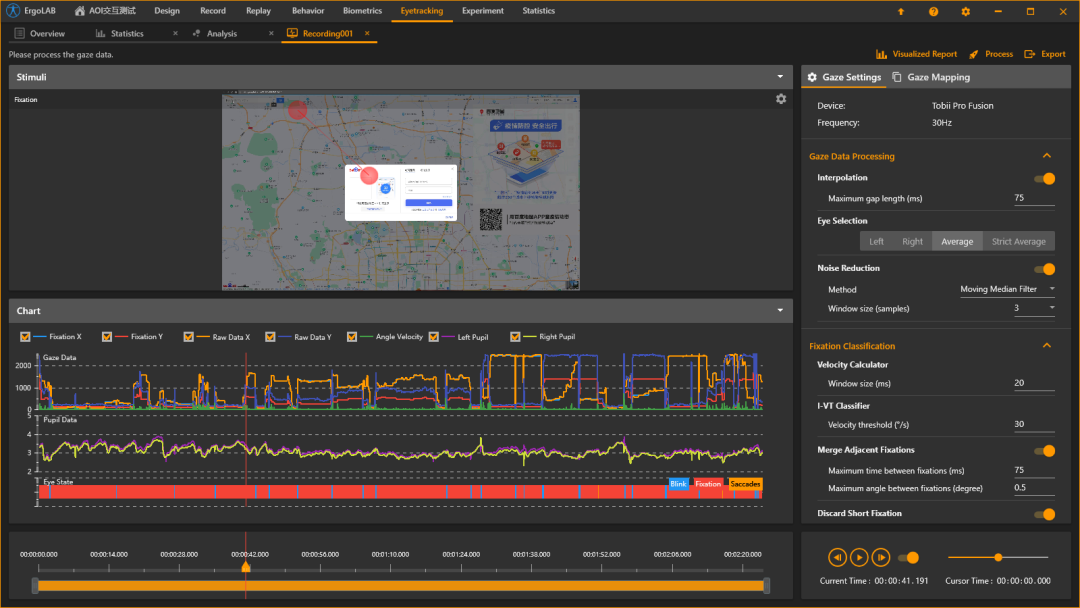

实验记录过程中,完成眼动仪设备配置之后,系统将会自动地实时在线处理眼动原始数据,基于IVT算法精确提取个体的眼动状态信号源,并转化为控制信号;

-

实时交互的载体支持WEB网页原型终端、APP原型终端、车载HMI原型、以及VR虚拟现实、AR等测试载体进行交互与控制。

-

记录结束后,可以在同一时间轴同步回放刺激、眼控交互数据、以及多模态生理信号等,可以基于时间点与时间片段进行划分数据。

-

交互数据统计,支持统计眼控交互数据,以及不同眼控交互状态下的情感数据、动作姿态数据、以及大脑活动数据等,进行综合的交叉统计分析。

眼控交互的应用

在高过载环境下,飞行员肢体活动困难,追踪目标时眼球移动先于头部移动,利用眼睛注视方向瞄准比用头部位置瞄准能更快地锁定目标并发起攻击,此时可以设置注视2s发起攻击,同时可以设置眨眼3次为停止攻击。还可以进行眼动控制,利用人眼注视位置进行定位、锁定等操作;通过采集、分析实战训练中飞行员的视线动作,评判其技能、心理、意图等,提升训练效果,辅助现场操作和决策等。

4.ErgoLAB眼动分析方法

01 眼动状态实时监测与数据编码

对采集的眼动原始数据提取Fixation,实时监测注视位置,以及注视、眨眼、扫视等行为,精确计算瞳孔大小、眨眼次数、眼跳距离等状态数据。

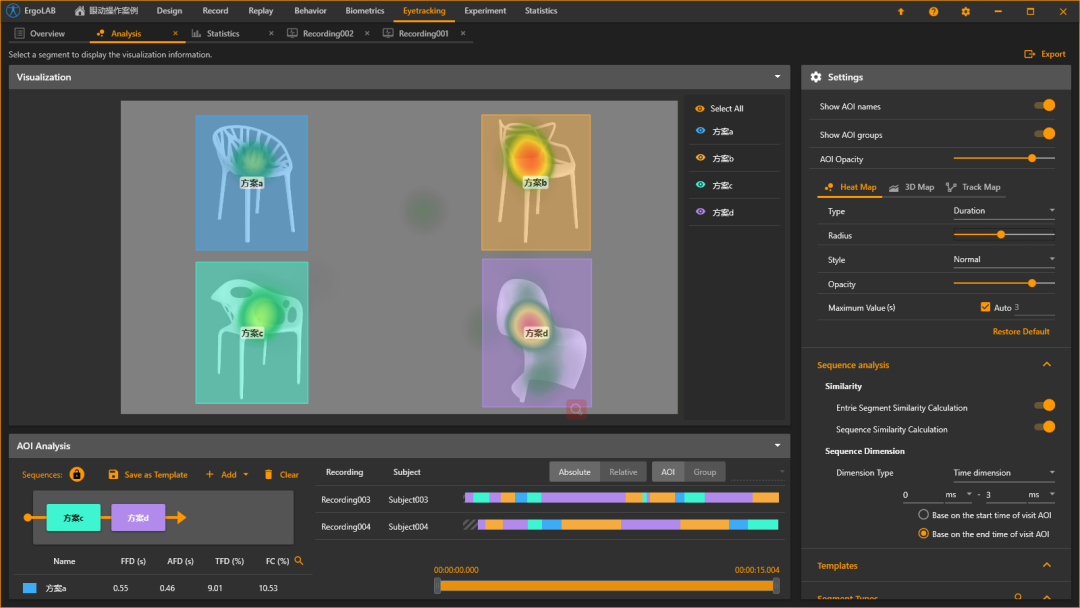

02 眼动可视化分析------注视热区与注视轨迹

对采集的注视数据与场景生成可视化叠加报告,可以直观的了解被测者重点关注了哪里 、对场景的关注轨迹,包括热点图、轨迹图、彩虹图、3D图、透视图等。

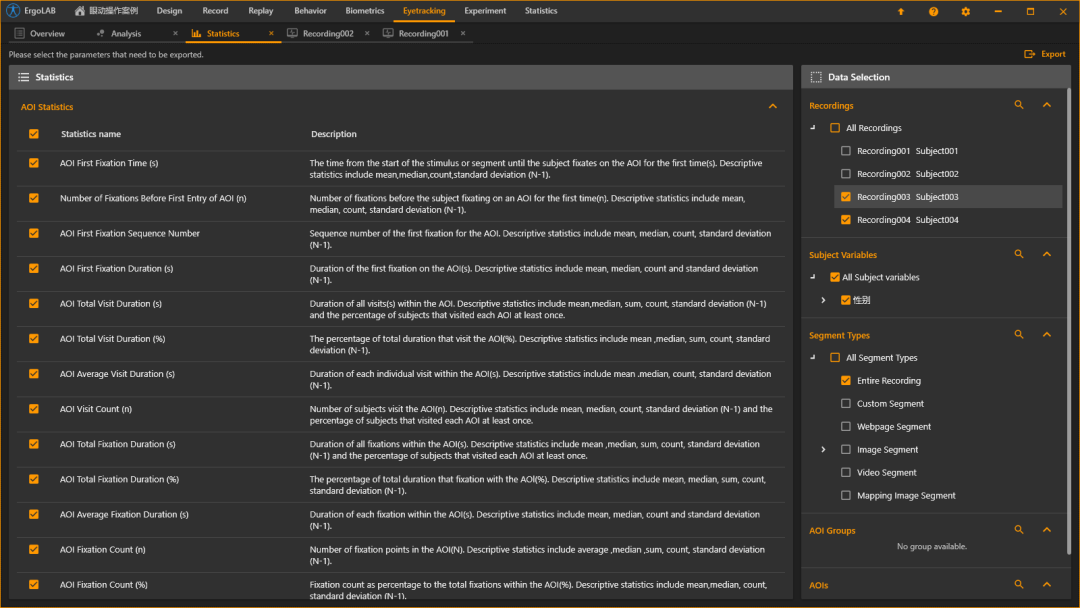

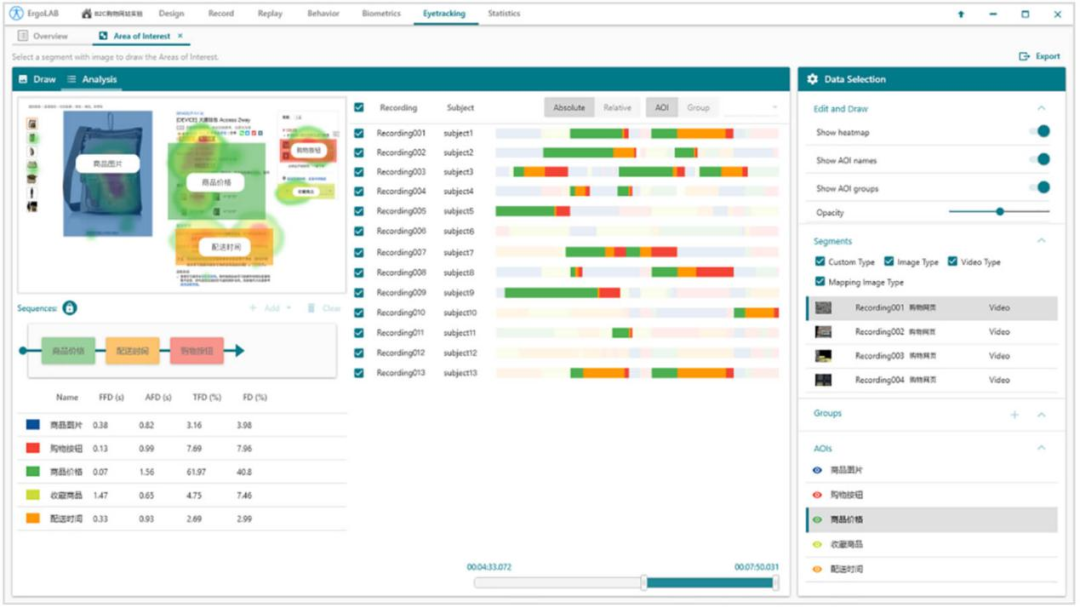

03 AOI统计分析

对采集的眼动数据,可任意设定静态/动态场景的区域范围(AOI),分析被测者注视了哪块区域,注视了多久,访问的次数、注视的次数、注视的时间占比等数百种统计指标。同时,支持多名被测人员的数据统计。

04 AOI视线序列分析与轨迹相似度分析

分析眼睛关注不同AOI的顺序性问题,探究被测者在人机交互过程中的视觉加工路径与行为模式。系统自动提取计算多被试的典型加工路径以及轨迹相似度,进而优化界面设计。

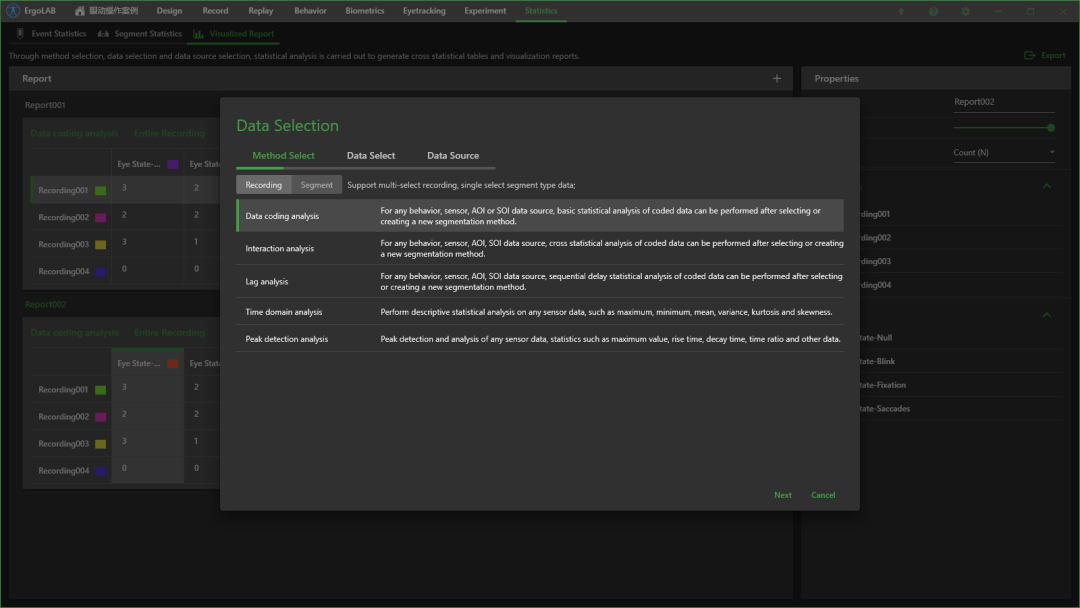

05 眼动数据高级统计

系统内置10余种统计方法,用户可以任意选择数据源进行分析,支持定制开发算法内嵌。包括时域分析、频域分析、峰值检测、数据编码分析、延迟分析、交叉分析等。

06 眼动与其他数据的多模态交叉分析

系统支持将眼动数据与其他数据做交叉融合分析,包括生理、行为、脑电、近红外、人机交互数据、以及主观测评数据等。可分析测试者在注视到AOI-N区域的条件下,其生理变化、脑认知状态、疲劳水平等。