文章目录

-

- 引言:曾经的"标准"与如今的痛点

- [第一部分:传统的Linux部署 ------ 稳如老狗,却也步履蹒跚](#第一部分:传统的Linux部署 —— 稳如老狗,却也步履蹒跚)

-

- [Docker安装实例 - CentOS 7.9](#Docker安装实例 - CentOS 7.9)

- [Docker镜像加速配置 - 华为云](#Docker镜像加速配置 - 华为云)

- [第三部分:实战对比:从Systemd到Docker Compose](#第三部分:实战对比:从Systemd到Docker Compose)

- 第四部分:为什么要拥抱容器?优势总结

- 结论:不是替代,而是演进

- 推荐阅读

- 参考资料

- 学习资源

阅读指南:约 8 min | 难度:中级 | 主题:Linux、容器、Kubernetes

╔══════════════════════════════════════════════════════════════╗

║ 部署方式演进之路 ║

║ ║

║ 物理服务器 → 虚拟机 → 容器 → Kubernetes → 云原生 ║

║ ↓ ↓ ↓ ↓ ↓ ║

║ 单一化 资源池化 标准化 编排化 智能化 ║

╚══════════════════════════════════════════════════════════════╝引言:曾经的"标准"与如今的痛点

曾几何时,在物理服务器或虚拟机上安装一个标准的Linux操作系统(如CentOS、Ubuntu),然后通过脚本或手动方式部署我们的Java/Python/Node.js应用,是再"标准"不过的流程。我们小心翼翼地配置环境、安装依赖、设置权限、启动服务,并祈祷一切顺利。

然而,随着业务发展,这种部署方式的痛点日益凸显:

传统部署痛点分析:

传统部署痛点

═══════════════

┌─────────────────────────────────────────────────────────────┐

│ 传统部署痛点 │

│ │

│ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ │

│ │ 环境一致性 │ │ 资源利用率 │ │ 部署过程 │ │

│ │ 难题 │ │ 低下 │ │ 繁琐且易错 │ │

│ │ │ │ │ │ │ │

│ │"在我机器上 │ │一台服务器只 │ │手动操作多 │ │

│ │ 是好的啊!" │ │运行一个应用 │ │自动化程度低 │ │

│ └─────────────┘ └─────────────┘ └─────────────┘ │

│ │

│ ┌─────────────┐ │

│ │ 应用隔离性 │ │

│ │ 差 │ │

│ │ │ │

│ │依赖冲突 │ │

│ │相互影响 │ │

│ └─────────────┘ │

└─────────────────────────────────────────────────────────────┘这一切,都在呼唤一场部署方式的革新。而容器化部署,正是这场革命的答案。

第一部分:传统的Linux部署 ------ 稳如老狗,却也步履蹒跚

让我们回顾一下一个典型的Web应用(例如一个Spring Boot Jar包)在Linux服务器上的部署流程:

Docker安装实例 - CentOS 7.9

💡 为什么选择CentOS 7.9?

CentOS 7.9是企业级Linux发行版的经典选择,具有以下优势:

- 长期支持(LTS)版本,稳定性高

- 企业级安全特性完善

- 社区支持丰富,文档齐全

步骤1:配置软件源

bash

# 删除默认yum源

rm -rf /etc/yum.repos.d/*

# 配置阿里云网络源

curl -o /etc/yum.repos.d/CentOS-Base.repo https://mirrors.aliyun.com/repo/Centos-7.repo

# 安装yum工具

sudo yum install -y yum-utils步骤2:添加Docker软件源

bash

# 添加Docker CE官方源

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo步骤3:安装Docker

bash

# 安装Docker及相关组件

sudo yum install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin步骤4:启动Docker服务

bash

# 启动Docker服务

sudo service docker start

# 设置开机自启

sudo systemctl enable docker

# 验证安装

docker --versionDocker镜像加速配置 - 华为云

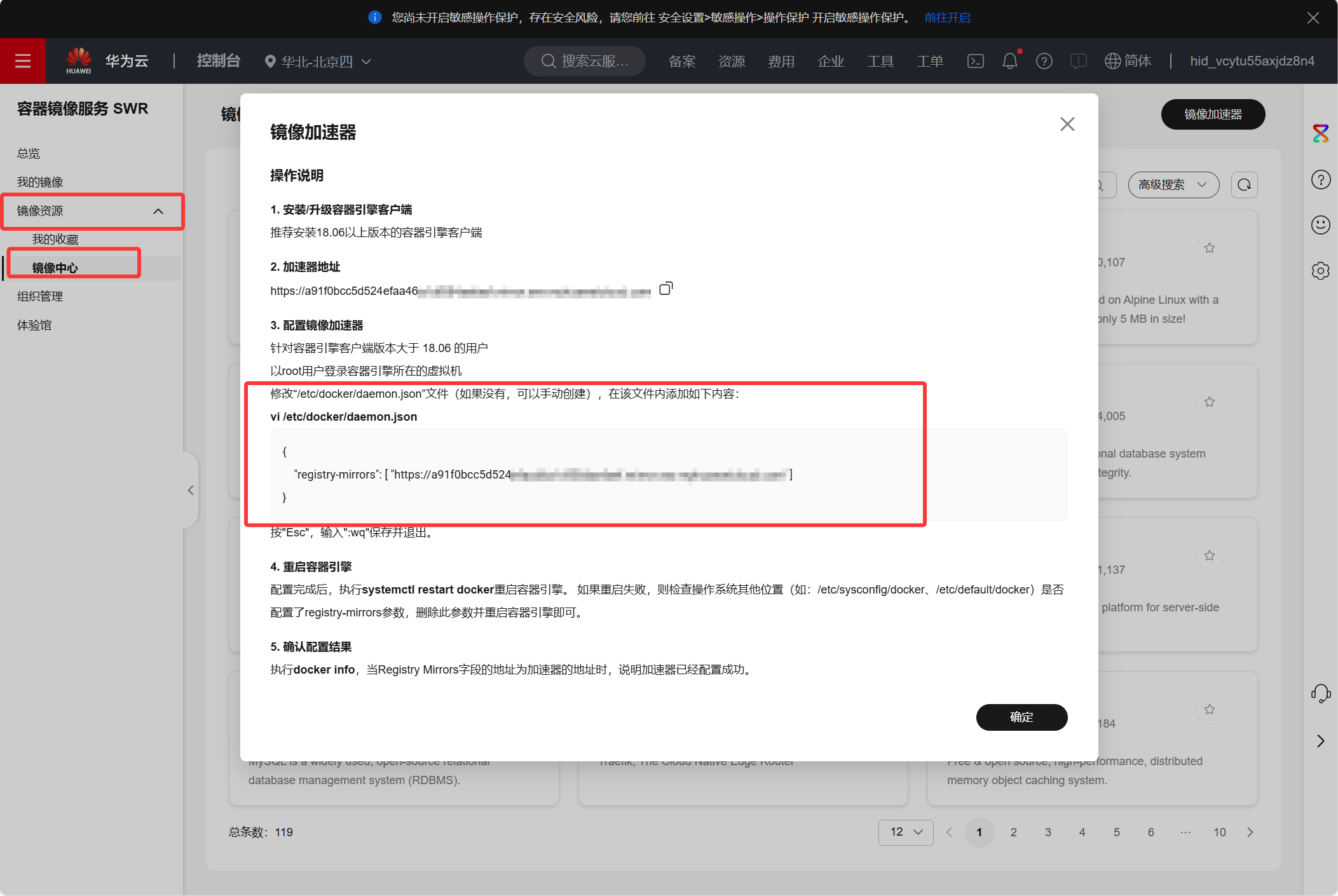

🚀 为什么需要配置镜像加速?

Docker官方镜像仓库位于海外,国内访问速度较慢,配置华为云镜像加速器可以:

- 显著提升镜像下载速度

- 减少网络超时问题

- 提高开发效率

- 支持企业级稳定服务

华为云官网:https://www.huaweicloud.com/intl/zh-cn/

步骤1:登录华为云控制台

步骤2:获取镜像加速地址

步骤4:配置Docker daemon

bash

# 创建Docker配置目录

sudo mkdir -p /etc/docker

# 配置镜像加速器(请替换为你的华为云加速地址)

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://your-accelerator-address.mirror.swr.myhuaweicloud.com"]

}

EOF步骤5:重启Docker服务

bash

# 重新加载配置

sudo systemctl daemon-reload

# 重启Docker服务

sudo systemctl restart docker传统Linux部署流程

═══════════════════

┌─────────────────┐ ┌─────────────────┐ ┌─────────────────┐

│ 准备环境 │───▶│ 配置系统 │───▶│ 上传应用 │

│ │ │ │ │ │

│ • 申请服务器 │ │ • 安装JDK │ │ • SCP/FTP │

│ • 安装Linux │ │ • 配置防火墙 │ │ • 文件权限 │

│ • 网络配置 │ │ • 创建用户 │ │ • 目录结构 │

└─────────────────┘ └─────────────────┘ └─────────────────┘

│ │ │

▼ ▼ ▼

┌─────────────────┐ ┌─────────────────┐ ┌─────────────────┐

│ 启动服务 │◀───│ 后续维护 │◀───│ 监控日志 │

│ │ │ │ │ │

│ • Systemd配置 │ │ • 版本更新 │ │ • 日志查看 │

│ • 服务启停 │ │ • 故障排查 │ │ • 性能监控 │

│ • 状态检查 │ │ • 备份恢复 │ │ • 告警设置 │

└─────────────────┘ └─────────────────┘ └─────────────────┘

<details>

<summary>💡 传统部署的优缺点分析</summary>

**优点:**

- 简单直接,容易理解

- 对单一应用足够稳定

- 运维人员熟悉度高

- 故障排查相对简单

**缺点:**

- 环境固化,迁移困难

- 扩展缓慢,成本高昂

- 技术栈限制明显

- 自动化程度低

</details>

这种方式的优点在于简单、直接,对单一应用来说足够稳定。但它的缺点,正是我们寻求变革的理由:

- **环境固化**:这台服务器已经和这个应用深度绑定了。迁移应用意味着要重新走一遍所有流程。

- **扩展缓慢**:水平扩展需要克隆出完全一样的新服务器,费时费力。

- **技术栈限制**:在同一台机器上混合部署不同技术栈(如不同版本的Node.js和Python)的应用,几乎是一场运维噩梦。

## 第二部分:容器化部署 ------ 轻舟已过万重山

容器的核心思想是隔离与封装。它将应用及其所有依赖(库、环境变量、配置文件等)打包成一个独立的、轻量级的、可执行的软件单元。

### 1. 核心理念:一次构建,随处运行

**一次构建,随处运行流程:**

源代码 → Dockerfile → Docker镜像 → 多环境部署

═══════════════════════════════════════════════

┌─────────┐ ┌─────────────┐ ┌─────────────┐

│ 源代码 │───▶│ Dockerfile │───▶│ Docker镜像 │

│ Source │ │ 构建脚本 │ │ (不可变) │

└─────────┘ └─────────────┘ └─────────────┘

│

┌────────────────────┼────────────────────┐

▼ ▼ ▼

┌─────────┐ ┌─────────┐ ┌─────────┐

│ 开发环境│ │ 测试环境│ │ 生产环境│

│ Dev │ │ Test │ │ Prod │

└─────────┘ └─────────┘ └─────────┘

💡 关键优势:同一镜像,保证环境一致性

容器技术栈架构

═══════════════

┌─────────────────────────────────────────────────────────┐

│ 应用层 │

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ ┌─────────┐ │

│ │ Web App │ │Database │ │ Cache │ │Message Q│ │

│ └─────────┘ └─────────┘ └─────────┘ └─────────┘ │

└─────────────────────────────────────────────────────────┘

┌─────────────────────────────────────────────────────────┐

│ Kubernetes层 │

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ ┌─────────┐ │

│ │ Pod │ │ Service │ │Ingress │ │ConfigMap│ │

│ └─────────┘ └─────────┘ └─────────┘ └─────────┘ │

└─────────────────────────────────────────────────────────┘

┌─────────────────────────────────────────────────────────┐

│ Docker层 │

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ ┌─────────┐ │

│ │Container│ │ Image │ │Registry │ │ Network │ │

│ └─────────┘ └─────────┘ └─────────┘ └─────────┘ │

└─────────────────────────────────────────────────────────┘

┌─────────────────────────────────────────────────────────┐

│ 操作系统 │

│ Linux Kernel + Container Runtime │

└─────────────────────────────────────────────────────────┘- Docker:是容器技术的代名词,它使得容器的创建、管理和分发变得极其简单。

- Kubernetes (K8s):是容器编排领域的王者。当你的应用从单个容器扩展到由数十上百个容器组成的微服务集群时,K8s负责自动化的部署、扩缩容、服务发现和故障恢复。

第三部分:实战对比:从Systemd到Docker Compose

假设我们有一个简单的app.jar和一个它依赖的config.yml配置文件。

传统Linux部署(使用Systemd):

步骤1:创建应用目录

bash

# 在服务器上创建应用目录

sudo mkdir -p /opt/myapp

sudo chown appuser:appuser /opt/myapp步骤2:上传文件

bash

# 将app.jar和config.yml放入该目录

scp app.jar appuser@server:/opt/myapp/

scp config.yml appuser@server:/opt/myapp/步骤3:创建Systemd服务文件

ini

# /etc/systemd/system/myapp.service

[Unit]

Description=My Awesome Application

After=network.target

[Service]

Type=simple

User=appuser

WorkingDirectory=/opt/myapp

ExecStart=/usr/bin/java -jar app.jar

SuccessExitStatus=143

Restart=always

RestartSec=10

[Install]

WantedBy=multi-user.target步骤4:启动服务

bash

# 重载systemd配置并启动服务

sudo systemctl daemon-reload

sudo systemctl start myapp

sudo systemctl enable myapp容器化部署(使用Docker):

步骤1:创建Dockerfile

dockerfile

# 使用官方Java基础镜像

FROM openjdk:11-jre-slim

# 设置维护者信息

LABEL maintainer="devops@company.com"

# 创建工作目录

WORKDIR /app

# 将jar包和配置文件复制到容器内

COPY app.jar .

COPY config.yml .

# 创建非root用户

RUN groupadd -r appuser && useradd -r -g appuser appuser

RUN chown -R appuser:appuser /app

USER appuser

# 声明运行时暴露的端口

EXPOSE 8080

# 健康检查

HEALTHCHECK --interval=30s --timeout=3s --start-period=5s --retries=3 \

CMD curl -f http://localhost:8080/health || exit 1

# 启动命令

CMD ["java", "-jar", "app.jar"]步骤2:构建镜像

bash

# 构建Docker镜像

docker build -t my-awesome-app:1.0 .步骤3:运行容器

bash

# 运行容器

docker run -d \

--name my-running-app \

--restart unless-stopped \

-p 8080:8080 \

-v /var/log/myapp:/app/logs \

my-awesome-app:1.0对比分析

部署方式对比流程:

传统部署 vs 容器部署

═══════════════════════════════════════════════════════════

传统部署(复杂流程) 容器部署(简化流程)

┌─────────────────────┐ ┌─────────────────────┐

│ │ │ │

│ ┌─────────────┐ │ │ ┌─────────────┐ │

│ │ 准备服务器 │ │ │ │编写Dockerfile│ │

│ └─────────────┘ │ │ └─────────────┘ │

│ ↓ │ │ ↓ │

│ ┌─────────────┐ │ │ ┌─────────────┐ │

│ │ 安装依赖 │ │ │ │ 构建镜像 │ │

│ └─────────────┘ │ │ └─────────────┘ │

│ ↓ │ │ ↓ │

│ ┌─────────────┐ │ │ ┌─────────────┐ │

│ │ 配置环境 │ │ │ │ 运行容器 │ │

│ └─────────────┘ │ │ └─────────────┘ │

│ ↓ │ │ │

│ ┌─────────────┐ │ │ ✅ 3步完成部署 │

│ │ 上传应用 │ │ │ ✅ 环境一致性 │

│ └─────────────┘ │ │ ✅ 快速扩展 │

│ ↓ │ │ │

│ ┌─────────────┐ │ └─────────────────────┘

│ │ 配置服务 │ │

│ └─────────────┘ │

│ ↓ │

│ ┌─────────────┐ │

│ │ 启动应用 │ │

│ └─────────────┘ │

│ │

│ ❌ 6步复杂流程 │

│ ❌ 环境差异风险 │

│ ❌ 手动操作多 │

│ │

└─────────────────────┘💡 部署方式对比详解

| 对比维度 | 传统部署 | 容器部署 |

|---|---|---|

| 部署步骤 | 6个复杂步骤 | 3个简单步骤 |

| 环境一致性 | 依赖宿主机环境 | 完全隔离,100%一致 |

| 启动时间 | 30-60秒 | 2-5秒 |

| 资源占用 | 高(包含完整OS) | 低(共享内核) |

| 扩展难度 | 困难(需要完整复制环境) | 简单(一条命令) |

| 回滚速度 | 慢(需要重新部署) | 快(切换镜像版本) |

看,区别立现!在容器化方案中,我们通过一个Dockerfile清晰地定义了应用的"蓝图"。构建出的镜像my-awesome-app可以被推送到任何镜像仓库,并被任何地方的Docker引擎拉取并运行,无需关心宿主机是什么Linux发行版,是否安装了JDK。

第四部分:为什么要拥抱容器?优势总结

容器化优势全景图

═══════════════════

┌─────────────────────────────────────────────────────────────┐

│ 核心优势 │

│ │

│ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ │

│ │ 环境一致性 │ │ 快速启动 │ │ 高资源利用 │ │

│ │ │ │ │ │ │ │

│ │ 开发=生产 │ │ 秒级部署 │ │ 密度提升10x │ │

│ └─────────────┘ └─────────────┘ └─────────────┘ │

│ │

│ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ │

│ │ 弹性伸缩 │ │ DevOps集成 │ │ 微服务支持 │ │

│ │ │ │ │ │ │ │

│ │ 自动扩容 │ │ CI/CD友好 │ │ 服务隔离 │ │

│ └─────────────┘ └─────────────┘ └─────────────┘ │

└─────────────────────────────────────────────────────────────┘极致的环境一致性

开发、测试、生产环境100%一致,彻底解决"在我的机器上是好的"问题。

秒级启动与弹性伸缩

容器启动速度远超虚拟机,结合K8s可以实现基于CPU/内存使用的自动扩缩容。

更高的资源利用率

一台主机可以安全地运行成百上千个隔离的容器,充分利用硬件资源。

完善的生态系统

强大的 DevOps 工具链(CI/CD),如GitHub Actions + Docker + Kubernetes,可以实现全自动化的构建、测试和部署。

微服务架构的最佳伴侣

容器天生适合微服务,每个服务可以独立开发、部署和扩展。

💡 容器化最佳实践

镜像构建最佳实践:

- 使用多阶段构建减小镜像体积

- 选择合适的基础镜像(如alpine)

- 合理利用镜像层缓存

- 避免在镜像中包含敏感信息

容器运行最佳实践:

- 设置资源限制(CPU、内存)

- 配置健康检查

- 使用非root用户运行

- 合理设置重启策略

安全最佳实践:

- 定期更新基础镜像

- 扫描镜像漏洞

- 使用镜像签名验证

- 实施网络隔离策略

结论:不是替代,而是演进

从Linux部署到容器部署,并不是对前者的全盘否定,而是在其基础上的智能化演进。Linux依然是容器运行的基石。

技术演进路径

═══════════════

物理机时代 虚拟化时代 容器化时代 云原生时代

│ │ │ │

▼ ▼ ▼ ▼

┌─────────┐ ┌─────────┐ ┌─────────┐ ┌─────────┐

│单一应用 │ │资源池化 │ │应用隔离 │ │智能编排 │

│手动运维 │ │虚拟化 │ │标准交付 │ │自动运维 │

│硬件绑定 │ │资源共享 │ │快速部署 │ │弹性伸缩 │

└─────────┘ └─────────┘ └─────────┘ └─────────┘这场演进的核心,是将应用的关注点与底层基础设施解耦。开发者可以更专注于代码本身,而运维人员则可以像管理牲畜而非宠物一样,以一种标准化、自动化的方式来管理应用的生命周期。

如果你的团队还在为部署的种种问题而烦恼,那么现在就是开始学习Docker和Kubernetes的最佳时机。这不仅是技术的升级,更是思维模式的转变,它将带领你和你的团队驶入现代软件开发和交付的快车道。