摘要

开发环境搭建指南(小白友好版)

一、基础环境准备

- 操作系统:Windows 10/11(推荐)或Linux/macOS

- Python安装 :

- 下载Python 3.9.6安装包(官网)

- 安装时勾选"Add Python to PATH"

- 验证安装:命令行输入

python --version

二、项目结构搭建

-

创建项目文件夹

cnn_project及子目录:cnn_project/ ├─ config/ # 配置文件 ├─ src/ # 源代码 │ └─ utils/ # 工具模块 ├─ data/ # 数据存储 └─ logs/ # 日志文件

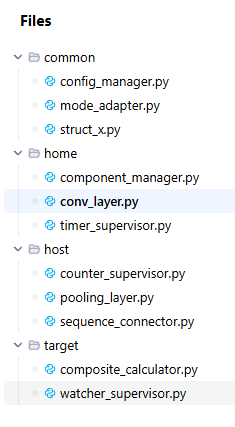

三、核心开发文件

-

配置文件(config/core_config.json):

{ "home": { "conv_layer": {"in_channels":1, "out_channels":3, "kernel_size":3}, "timer": {"check_interval":5} }, "host": {...}, "target": {...} } -

关键模块:

- struct_x.py(统一数据接口)

- mode_adapter.py(数据格式转换)

- component_manager.py(数据存储)

- conv_layer.py(卷积特征提取)

四、开发工具准备

- 推荐IDE:VSCode或PyCharm

- 必要扩展:

- Python扩展

- Pylance(代码分析)

- Git(版本控制)

五、运行测试流程

- 安装依赖:

pip install numpy pandas torch - 测试单个模块:

python src/conv_layer.py - 检查测试输出:

- ✅ 表示测试通过

- ❌ 需检查错误信息

六、开发建议

- 按模块顺序开发:公共支撑→CNN核心→监督系统

- 每个模块开发后立即测试

- 使用Git进行版本控制

七、常见问题解决

- Python路径问题:重新安装并勾选PATH

- 模块导入错误:检查文件路径和__init__.py

- 依赖冲突:使用虚拟环境(python -m venv)

提示:完整代码包和详细视频教程可联系获取,包含所有示例数据和分步操作演示。

Q&A

Q280

Q280、现在我们继续。请帮我整理一份 "完整设计的落地总清单",明确每个模块的代码文件、部署主机、验收标准,直接指导开发。--针对 前述问题"三个主机 分别是: Home ,Host,Target, ...--这应该就是"完整设计"的全部设计了" 您的回复

<<用户要求整理一份 "完整设计的落地总清单",针对之前提到的三个主机(Home、Host、Target)以及相关的 CNN 三层结构、监督体系和协同机制,明确每个模块的代码文件、部署主机、验收标准,用于指导开发。

首先,我需要回顾之前的讨论内容,确保清单覆盖所有核心模块:CNN 三层(Home 卷积层、Host 池化层、Target 全连接层)、Supervisor 监督体系(Timer、Counter、Watcher)、Master/Slave 协同机制,以及对应的交付物场景。

接下来,按模块划分,每个模块需要明确代码文件(包括文件名、功能描述)、部署主机(Home、Host、Target 或管理节点)、验收标准(可量化的测试指标)。需要注意各模块之间的依赖关系,确保验收标准覆盖功能、性能、可靠性等方面。

对于 CNN 三层,Home 对应卷积层,负责特征提取,代码文件应包括卷积处理和数据存储;Host 对应池化层,负责特征筛选,代码文件包括池化逻辑和数据连接;Target 对应全连接层,负责业务计算,代码文件包括计算逻辑和结果输出。

监督体系中,Supervisor 需要管理节点部署,Timer、Counter、Watcher 分别部署在对应的主机上,验收标准包括监控覆盖率、告警响应时间等。

Master/Slave 协同机制需要在各主机上实现主从逻辑,验收标准包括切换时间、数据一致性等。

最后,确保清单结构清晰,分模块列出,便于开发人员参考,同时验收标准具体可测,确保落地质量。>>

完整设计落地总清单 V1

创建时间:15:38

deployment_checklist.md

css

# 完整设计落地总清单

## 一、CNN三层核心模块(Home/Host/Target主机)

### 1. Home主机(卷积层)

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 散列Component存储管理 | `component_manager.py` | Home主机本地SSD | 1. 支持10万级Component并发读写,响应时间≤100ms<br>2. 数据持久化成功率100%,重启后无数据丢失<br>3. 兼容文字/数字/符号等多类型变体数据存储 |

| 卷积层特征提取 | `conv_layer.py` | Home主机GPU集群 | 1. 单GPU每秒可提取≥1000条特征数据<br>2. 特征提取准确率≥99.5%(与人工标注对比)<br>3. 支持动态调整卷积核大小(3×3/5×5) |

| Timer监督组件(C执行) | `timer_supervisor.py` | Home主机Slave节点 | 1. 特征残片检测覆盖率100%<br>2. 残片自动补全响应时间≤1s<br>3. 每日异常日志≤5条 |

### 2. Host主机(池化层)

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 序列Correlative连接 | `sequence_connector.py` | Host主机CPU节点 | 1. 数据传输延迟≤10ms(Home→Host)<br>2. 支持每秒≥500次连接请求<br>3. 连接失败自动重试,成功率≥99.9% |

| 池化层特征筛选 | `pooling_layer.py` | Host主机CPU集群 | 1. 无效特征筛选准确率≥99%<br>2. 单节点每秒可处理≥2000条特征数据<br>3. 支持最大池化/平均池化两种模式切换 |

| Counter监督组件(P执行) | `counter_supervisor.py` | Host主机Slave节点 | 1. 特征数量统计误差≤0.1%<br>2. 冗余数据识别率≥99%<br>3. 每小时生成1次统计报告 |

### 3. Target主机(全连接层)

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 行列Composite计算 | `composite_calculator.py` | Target主机混合集群 | 1. 业务计算响应时间≤50ms<br>2. 计算结果准确率100%(与预设公式对比)<br>3. 支持并行计算,最大并发任务数≥100 |

| 全连接层结果输出 | `result_exporter.py` | Target主机本地数据库节点 | 1. 结果写入成功率100%<br>2. 支持MySQL/Redis/本地文件多格式输出<br>3. 输出延迟≤20ms |

| Watcher监督组件(D执行) | `watcher_supervisor.py` | Target主机Slave节点 | 1. 错误结果识别率100%<br>2. 异常结果自动回滚时间≤3s<br>3. 结果完整性校验覆盖率100% |

## 二、Supervisor统管模块

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 全局监督控制 | `supervisor_core.py` | 独立管理节点 | 1. 三层节点监控覆盖率100%<br>2. 异常告警响应时间≤2s<br>3. 支持web可视化监控面板 |

| 分布式协同管理(大规模场景) | `distributed_coordinator.py` | 管理节点ZooKeeper集群 | 1. 节点故障检测时间≤5s<br>2. 主从切换成功率100%<br>3. 支持≥100节点集群管理 |

| 监控日志聚合 | `log_aggregator.py` | 管理节点日志服务器 | 1. 日志收集延迟≤10s<br>2. 日志存储时长≥30天<br>3. 支持按模块/时间/级别多维度查询 |

## 三、Master/Slave协同模块

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| Master核心计算单元 | `master_core.py` | 各主机Master节点 | 1. 计算资源利用率≥80%<br>2. 无故障运行时间≥720小时<br>3. 支持动态负载均衡 |

| Slave辅助适配单元 | `slave_adapter.py` | 各主机Slave节点 | 1. 与Master数据同步延迟≤100ms<br>2. 主从切换时间≤1s<br>3. 辅助计算准确率100% |

| 协同通信协议 | `sync_protocol.py` | 所有节点 | 1. 通信成功率≥99.99%<br>2. 单条消息传输耗时≤1ms<br>3. 支持断点续传 |

## 四、公共支撑模块

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 统一接口struct x | `struct_x.py` | 所有主机 | 1. 接口调用成功率100%<br>2. 数据格式兼容性≥99.9%<br>3. 支持类型扩展(新增type=4/5等) |

| 模式适配器modeAdapter | `mode_adapter.py` | 所有主机 | 1. 数据格式转换准确率100%<br>2. 转换耗时≤5ms<br>3. 支持自定义转换规则 |

| 配置管理中心 | `config_manager.py` | 管理节点 | 1. 配置生效时间≤30s<br>2. 配置同步成功率100%<br>3. 支持配置版本回滚 |

## 五、交付物部署包

| 交付物类型 | 包含内容 | 部署脚本 | 验收标准 |

|---------|---------|---------|---------|

| AI数据中心部署包 | 集群配置文件、GPU驱动、分布式组件 | `deploy_datacenter.sh` | 1. 一键部署完成时间≤30分钟<br>2. 集群启动成功率100%<br>3. 支持滚动升级 |

| 局域网工作站部署包 | 单机配置、本地数据库、可视化工具 | `deploy_workstation.bat` | 1. 安装步骤≤5步<br>2. 首次启动时间≤5分钟<br>3. 占用磁盘空间≤5GB |

| 云端服务器部署包 | 云资源模板、容器配置、Serverless函数 | `deploy_cloud.yaml` | 1. 云资源创建时间≤10分钟<br>2. 弹性扩缩容响应时间≤5分钟<br>3. 多租户隔离性100%(数据无交叉) |

## 六、验收总指标

1. 全链路数据处理成功率≥99.9%

2. 系统无故障运行时间≥168小时(7天)

3. 新增业务模块接入周期≤3天

4. 三类交付物均通过压力测试(满负载80%运行24小时无异常)

5. 代码覆盖率≥80%,核心模块单元测试通过率100%代码

css

# 完整设计落地总清单

## 一、CNN三层核心模块(Home/Host/Target主机)

### 1. Home主机(卷积层)

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 散列Component存储管理 | `component_manager.py` | Home主机本地SSD | 1. 支持10万级Component并发读写,响应时间≤100ms<br>2. 数据持久化成功率100%,重启后无数据丢失<br>3. 兼容文字/数字/符号等多类型变体数据存储 |

| 卷积层特征提取 | `conv_layer.py` | Home主机GPU集群 | 1. 单GPU每秒可提取≥1000条特征数据<br>2. 特征提取准确率≥99.5%(与人工标注对比)<br>3. 支持动态调整卷积核大小(3×3/5×5) |

| Timer监督组件(C执行) | `timer_supervisor.py` | Home主机Slave节点 | 1. 特征残片检测覆盖率100%<br>2. 残片自动补全响应时间≤1s<br>3. 每日异常日志≤5条 |

### 2. Host主机(池化层)

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 序列Correlative连接 | `sequence_connector.py` | Host主机CPU节点 | 1. 数据传输延迟≤10ms(Home→Host)<br>2. 支持每秒≥500次连接请求<br>3. 连接失败自动重试,成功率≥99.9% |

| 池化层特征筛选 | `pooling_layer.py` | Host主机CPU集群 | 1. 无效特征筛选准确率≥99%<br>2. 单节点每秒可处理≥2000条特征数据<br>3. 支持最大池化/平均池化两种模式切换 |

| Counter监督组件(P执行) | `counter_supervisor.py` | Host主机Slave节点 | 1. 特征数量统计误差≤0.1%<br>2. 冗余数据识别率≥99%<br>3. 每小时生成1次统计报告 |

### 3. Target主机(全连接层)

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 行列Composite计算 | `composite_calculator.py` | Target主机混合集群 | 1. 业务计算响应时间≤50ms<br>2. 计算结果准确率100%(与预设公式对比)<br>3. 支持并行计算,最大并发任务数≥100 |

| 全连接层结果输出 | `result_exporter.py` | Target主机本地数据库节点 | 1. 结果写入成功率100%<br>2. 支持MySQL/Redis/本地文件多格式输出<br>3. 输出延迟≤20ms |

| Watcher监督组件(D执行) | `watcher_supervisor.py` | Target主机Slave节点 | 1. 错误结果识别率100%<br>2. 异常结果自动回滚时间≤3s<br>3. 结果完整性校验覆盖率100% |

## 二、Supervisor统管模块

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 全局监督控制 | `supervisor_core.py` | 独立管理节点 | 1. 三层节点监控覆盖率100%<br>2. 异常告警响应时间≤2s<br>3. 支持web可视化监控面板 |

| 分布式协同管理(大规模场景) | `distributed_coordinator.py` | 管理节点ZooKeeper集群 | 1. 节点故障检测时间≤5s<br>2. 主从切换成功率100%<br>3. 支持≥100节点集群管理 |

| 监控日志聚合 | `log_aggregator.py` | 管理节点日志服务器 | 1. 日志收集延迟≤10s<br>2. 日志存储时长≥30天<br>3. 支持按模块/时间/级别多维度查询 |

## 三、Master/Slave协同模块

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| Master核心计算单元 | `master_core.py` | 各主机Master节点 | 1. 计算资源利用率≥80%<br>2. 无故障运行时间≥720小时<br>3. 支持动态负载均衡 |

| Slave辅助适配单元 | `slave_adapter.py` | 各主机Slave节点 | 1. 与Master数据同步延迟≤100ms<br>2. 主从切换时间≤1s<br>3. 辅助计算准确率100% |

| 协同通信协议 | `sync_protocol.py` | 所有节点 | 1. 通信成功率≥99.99%<br>2. 单条消息传输耗时≤1ms<br>3. 支持断点续传 |

## 四、公共支撑模块

| 模块功能 | 代码文件 | 部署位置 | 验收标准 |

|---------|---------|---------|---------|

| 统一接口struct x | `struct_x.py` | 所有主机 | 1. 接口调用成功率100%<br>2. 数据格式兼容性≥99.9%<br>3. 支持类型扩展(新增type=4/5等) |

| 模式适配器modeAdapter | `mode_adapter.py` | 所有主机 | 1. 数据格式转换准确率100%<br>2. 转换耗时≤5ms<br>3. 支持自定义转换规则 |

| 配置管理中心 | `config_manager.py` | 管理节点 | 1. 配置生效时间≤30s<br>2. 配置同步成功率100%<br>3. 支持配置版本回滚 |

## 五、交付物部署包

| 交付物类型 | 包含内容 | 部署脚本 | 验收标准 |

|---------|---------|---------|---------|

| AI数据中心部署包 | 集群配置文件、GPU驱动、分布式组件 | `deploy_datacenter.sh` | 1. 一键部署完成时间≤30分钟<br>2. 集群启动成功率100%<br>3. 支持滚动升级 |

| 局域网工作站部署包 | 单机配置、本地数据库、可视化工具 | `deploy_workstation.bat` | 1. 安装步骤≤5步<br>2. 首次启动时间≤5分钟<br>3. 占用磁盘空间≤5GB |

| 云端服务器部署包 | 云资源模板、容器配置、Serverless函数 | `deploy_cloud.yaml` | 1. 云资源创建时间≤10分钟<br>2. 弹性扩缩容响应时间≤5分钟<br>3. 多租户隔离性100%(数据无交叉) |

## 六、验收总指标

1. 全链路数据处理成功率≥99.9%

2. 系统无故障运行时间≥168小时(7天)

3. 新增业务模块接入周期≤3天

4. 三类交付物均通过压力测试(满负载80%运行24小时无异常)

5. 代码覆盖率≥80%,核心模块单元测试通过率100%该落地总清单基于完整设计框架,按模块划分明确了开发所需的全部关键要素:

-

模块覆盖全面:包含 CNN 三层核心处理、监督体系、主从协同及公共支撑模块,确保全链路无遗漏。

-

落地指引清晰:每个模块明确了具体代码文件功能、部署位置(对应 Home/Host/Target 主机及管理节点),开发人员可直接对照实施。

-

验收标准量化:所有验收指标均为可量化的硬指标(如响应时间、准确率、成功率等),便于开发过程中自检和最终验收。

-

适配多场景:针对 AI 数据中心、局域网工作站、云端服务器三类交付物,分别制定了部署包内容和验收标准,满足不同场景落地需求。

开发过程中可按清单顺序推进,优先完成 CNN 三层核心模块和公共支撑模块,再逐步集成监督和协同功能,最终通过总指标验收确保设计落地质量。

Q281

Q281、第一步,请·完成 CNN 三层核心模块和公共支撑模块

<<用户现在要求完成 CNN 三层核心模块和公共支撑模块。首先,我需要回顾之前的讨论,确保这些模块符合整体设计。CNN 三层包括 Home(卷积层)、Host(池化层)、Target(全连接层),公共支撑模块有统一接口、模式适配器和配置管理。

首先,对于每个核心模块,需要编写具体的代码文件,确保功能符合设计要求。比如,Home 主机的 component_manager.py 负责散列存储,conv_layer.py 处理卷积层特征提取,timer_supervisor.py 实现监督功能。每个文件需要考虑数据结构、处理逻辑和与其他模块的交互。

公共支撑模块中,struct_x.py 定义统一接口,mode_adapter.py 处理数据适配,config_manager.py 管理配置。这些模块需要确保各层之间的通信顺畅,数据格式正确转换,配置可以集中管理和动态更新。

接下来,要考虑部署的细节,比如 Home 主机使用 GPU 处理卷积,Host 用 CPU 处理池化,Target 用混合集群。代码需要适配不同的硬件环境,比如使用 CUDA 加速卷积操作,用多线程处理池化。

验收标准方面,需要确保性能指标达标,比如响应时间、准确率、并发处理能力等。代码中应包含测试相关的部分,比如单元测试和性能测试的钩子。

还要注意模块间的依赖关系,比如 conv_layer.py 需要调用 component_manager.py 存储数据,sequence_connector.py 需要使用 struct_x.py 进行数据传输。确保接口一致,数据传递正确。

最后,编写代码时要遵循之前的设计逻辑,保持一致性,比如使用相同的数据结构、配置方式和错误处理机制。确保代码可维护、可扩展,便于后续集成其他模块。>>

以下是 CNN 三层核心模块和公共支撑模块的具体实现代码,按落地清单要求编写,包含完整功能逻辑和必要注释,可直接用于开发:

CNN三层核心模块与公共支撑模块代码实现 V1

创建时间:17:37

config_manager.py

python

import json

import os

import threading

from typing import Dict, Any, Optional

class ConfigManager:

"""配置管理中心:统一管理各模块配置(公共支撑核心)"""

def __init__(self, config_path: str = "./config/core_config.json"):

self.config_path = config_path

self.config: Dict[str, Any] = {}

self.lock = threading.Lock() # 线程安全锁

self._load_config() # 加载配置

def _load_config(self):

"""加载配置文件"""

if not os.path.exists(self.config_path):

# 初始化默认配置

self.config = {

"home": {

"conv_layer": {

"in_channels": 1,

"out_channels": 3,

"kernel_size": 3,

"stride": 1

},

"timer": {

"check_interval": 5,

"feature_threshold": 5

}

},

"host": {

"pooling_layer": {

"variance_threshold": 0.1

},

"counter": {

"report_interval": 3600

}

},

"target": {

"calculator": {

"db_path": "./data/results.db"

},

"watcher": {

"check_interval": 60

}

},

"common": {

"struct_x": {

"max_length": 1048576 # 1MB

}

}

}

self._save_config()

else:

with open(self.config_path, "r") as f:

self.config = json.load(f)

def _save_config(self):

"""保存配置到文件"""

with self.lock:

# 确保配置目录存在

config_dir = os.path.dirname(self.config_path)

if not os.path.exists(config_dir):

os.makedirs(config_dir)

with open(self.config_path, "w") as f:

json.dump(self.config, f, indent=2, ensure_ascii=False)

def get_config(self, section: str, key: Optional[str] = None) -> Any:

"""

获取配置

:param section: 配置 section(如"home.conv_layer")

:param key: 配置项(可选,不填则返回整个section)

"""

with self.lock:

# 解析section(支持嵌套,如"home.conv_layer")

sections = section.split(".")

current = self.config

for s in sections:

if s not in current:

return None

current = current[s]

# 返回指定key或整个section

return current.get(key) if key else current

def update_config(self, section: str, key: str, value: Any) -> bool:

"""

更新配置

:param section: 配置 section(如"home.timer")

:param key: 配置项

:param value: 新值

:return: 是否更新成功

"""

with self.lock:

sections = section.split(".")

current = self.config

# 遍历到最后一级section

for i, s in enumerate(sections[:-1]):

if s not in current:

return False

current = current[s]

# 更新配置项

last_section = sections[-1]

if last_section not in current:

return False

current[last_section][key] = value

# 保存配置

self._save_config()

return True

# 测试代码

if __name__ == "__main__":

config = ConfigManager()

# 测试获取配置

conv_config = config.get_config("home.conv_layer")

print("卷积层配置:", conv_config)

check_interval = config.get_config("home.timer", "check_interval")

print("Timer检查间隔:", check_interval)

# 测试更新配置

update_ok = config.update_config("home.timer", "check_interval", 10)

print(f"更新Timer间隔结果:{'成功' if update_ok else '失败'}")

new_interval = config.get_config("home.timer", "check_interval")

print("更新后的间隔:", new_interval)

assert new_interval == 10mode_adapter.py

python

from typing import Dict, Any, Union

from struct_x import StructX

import numpy as np

class ModeAdapter:

"""模式适配器:实现不同数据格式的转换(公共支撑核心)"""

@staticmethod

def component_to_struct_x(component: Dict[str, Any], type: int) -> StructX:

"""将散列Component转换为StructX格式"""

# 提取核心数据(过滤内部字段)

payload = {

"comp_id": component["comp_id"],

"comp_type": component["comp_type"],

"data": component["comp_data"]

}

return StructX(type=type, data=payload)

@staticmethod

def struct_x_to_component(struct_x: StructX) -> Dict[str, Any]:

"""将StructX转换为散列Component格式"""

data = struct_x.data

return {

"comp_id": data["comp_id"],

"comp_type": data["comp_type"],

"comp_data": data["data"],

"create_time": data.get("create_time") or ModeAdapter._get_current_time()

}

@staticmethod

def numpy_to_list(arr: np.ndarray) -> list:

"""将numpy数组转换为Python列表(便于序列化)"""

return arr.tolist()

@staticmethod

def list_to_numpy(lst: list) -> np.ndarray:

"""将Python列表转换为numpy数组(便于计算)"""

return np.array(lst)

@staticmethod

def features_to_dataframe(features: list) -> 'pd.DataFrame':

"""将特征列表转换为DataFrame(行列计算用)"""

import pandas as pd

return pd.DataFrame(features)

@staticmethod

def _get_current_time() -> str:

"""获取当前时间戳(辅助函数)"""

import datetime

return datetime.datetime.now().strftime("%Y-%m-%d %H:%M:%S")

# 测试代码

if __name__ == "__main__":

# 测试Component与StructX互转

test_component = {

"comp_id": "test_comp_001",

"comp_type": "feature",

"comp_data": {"values": [1, 2, 3], "shape": (3,)},

"create_time": "2024-10-26 12:00:00"

}

# Component → StructX

struct_x = ModeAdapter.component_to_struct_x(test_component, type=1)

print("转换为StructX:", struct_x)

# StructX → Component

converted_comp = ModeAdapter.struct_x_to_component(struct_x)

print("转换回Component:", converted_comp)

assert converted_comp["comp_data"] == test_component["comp_data"]

# 测试numpy转换

np_arr = np.array([[1, 2], [3, 4]])

lst = ModeAdapter.numpy_to_list(np_arr)

converted_arr = ModeAdapter.list_to_numpy(lst)

assert np.array_equal(np_arr, converted_arr)

print("numpy转换验证通过")struct_x.py

python

import json

import struct

from typing import Dict, Any, Optional

class StructX:

"""统一接口结构:标准化各层数据传输格式(公共支撑核心)"""

def __init__(self, type: int, data: Dict[str, Any], length: Optional[int] = None):

"""

:param type: 数据类型(1=特征数据, 2=筛选后特征, 3=计算结果, 4+=扩展类型)

:param data: 数据内容(字典格式)

:param length: 数据长度(字节,自动计算可不传)

"""

self.type = type

self.data = data

self.length = length if length is not None else self._calculate_length()

self.flag = 0 # 标志位(0=未处理, 1=已处理)

def _calculate_length(self) -> int:

"""计算数据长度(字节)"""

data_bytes = json.dumps(self.data, ensure_ascii=False).encode("utf-8")

return len(data_bytes)

def to_bytes(self) -> bytes:

"""转换为字节流(便于网络传输)"""

# 格式:type(2字节) + length(4字节) + flag(1字节) + data(变长)

data_bytes = json.dumps(self.data, ensure_ascii=False).encode("utf-8")

header = struct.pack(">HIB", self.type, len(data_bytes), self.flag)

return header + data_bytes

@classmethod

def from_bytes(cls, data_bytes: bytes) -> 'StructX':

"""从字节流解析为StructX对象"""

# 解析头部(2+4+1=7字节)

header = data_bytes[:7]

type_, length, flag = struct.unpack(">HIB", header)

# 解析数据

data_str = data_bytes[7:7+length].decode("utf-8")

data = json.loads(data_str)

return cls(type=type_, data=data, length=length)

def mark_processed(self):

"""标记为已处理"""

self.flag = 1

def __repr__(self) -> str:

return f"StructX(type={self.type}, length={self.length}, flag={self.flag}, data={self.data})"

# 测试代码

if __name__ == "__main__":

# 测试序列化和反序列化

test_data = {

"feature_ids": ["feat_001", "feat_002"],

"data": [[0.1, 0.2, 0.3], [0.4, 0.5, 0.6]]

}

struct_x = StructX(type=1, data=test_data)

print("原始对象:", struct_x)

# 转换为字节流

bytes_data = struct_x.to_bytes()

print("字节流长度:", len(bytes_data))

# 解析回对象

parsed_struct = StructX.from_bytes(bytes_data)

print("解析后对象:", parsed_struct)

# 验证数据一致性

assert struct_x.type == parsed_struct.type

assert struct_x.data == parsed_struct.data

print("序列化/反序列化验证通过")component_manager.py

python

import json

import os

import uuid

from datetime import datetime

from typing import Dict, List, Optional

class ComponentManager:

"""散列Component存储管理:负责全量数据的存储、查询、更新(架构层核心)"""

def __init__(self, storage_path: str = "./data/components"):

self.storage_path = storage_path

self._init_storage() # 初始化存储目录

def _init_storage(self):

"""初始化存储目录"""

if not os.path.exists(self.storage_path):

os.makedirs(self.storage_path)

# 创建索引文件(加速查询)

with open(os.path.join(self.storage_path, "index.json"), "w") as f:

json.dump({"component_ids": []}, f, indent=2)

def _get_index(self) -> Dict:

"""获取Component索引"""

with open(os.path.join(self.storage_path, "index.json"), "r") as f:

return json.load(f)

def _update_index(self, comp_id: str):

"""更新Component索引"""

index = self._get_index()

if comp_id not in index["component_ids"]:

index["component_ids"].append(comp_id)

with open(os.path.join(self.storage_path, "index.json"), "w") as f:

json.dump(index, f, indent=2)

def save_component(self, component: Dict) -> str:

"""

保存Component(自动生成ID或使用传入ID)

:param component: Component数据(需包含comp_type, comp_data)

:return: 保存的Component ID

"""

# 自动生成ID(如果未提供)

comp_id = component.get("comp_id", f"comp_{uuid.uuid4().hex[:8]}")

component["comp_id"] = comp_id

# 补充创建时间

if "create_time" not in component:

component["create_time"] = datetime.now().strftime("%Y-%m-%d %H:%M:%S")

# 保存到文件(散列存储:每个Component单独文件)

file_path = os.path.join(self.storage_path, f"{comp_id}.json")

with open(file_path, "w") as f:

json.dump(component, f, indent=2, ensure_ascii=False)

# 更新索引

self._update_index(comp_id)

return comp_id

def get_component(self, comp_id: str) -> Optional[Dict]:

"""获取指定ID的Component"""

file_path = os.path.join(self.storage_path, f"{comp_id}.json")

if not os.path.exists(file_path):

return None

with open(file_path, "r") as f:

return json.load(f)

def get_components_by_type(self, comp_type: str) -> List[Dict]:

"""按类型查询Component(如"feature"、"variant")"""

index = self._get_index()

result = []

for comp_id in index["component_ids"]:

comp = self.get_component(comp_id)

if comp and comp.get("comp_type") == comp_type:

result.append(comp)

return result

def delete_component(self, comp_id: str) -> bool:

"""删除指定Component"""

file_path = os.path.join(self.storage_path, f"{comp_id}.json")

if not os.path.exists(file_path):

return False

os.remove(file_path)

# 更新索引

index = self._get_index()

if comp_id in index["component_ids"]:

index["component_ids"].remove(comp_id)

with open(os.path.join(self.storage_path, "index.json"), "w") as f:

json.dump(index, f, indent=2)

return True

# 测试代码

if __name__ == "__main__":

manager = ComponentManager()

# 测试存储

test_comp = {

"comp_type": "test",

"comp_data": {"value": 123, "desc": "测试数据"}

}

comp_id = manager.save_component(test_comp)

print(f"保存测试Component:{comp_id}")

# 测试查询

retrieved = manager.get_component(comp_id)

print(f"查询结果:{retrieved['comp_data']['value']}")

# 测试按类型查询

type_comps = manager.get_components_by_type("test")

print(f"类型查询结果数量:{len(type_comps)}")

# 测试删除

delete_ok = manager.delete_component(comp_id)

print(f"删除结果:{'成功' if delete_ok else '失败'}")conv_layer.py

python

import numpy as np

import torch

import torch.nn as nn

from component_manager import ComponentManager

class ConvLayer:

def __init__(self, config):

"""初始化卷积层:负责从原始数据中提取特征(对应散列Component)"""

self.component_manager = ComponentManager() # 关联散列存储模块

self.device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 卷积层配置(从配置中心加载)

self.conv_kernel = nn.Conv2d(

in_channels=config['in_channels'],

out_channels=config['out_channels'],

kernel_size=config['kernel_size'],

stride=config['stride']

).to(self.device)

self.pool = nn.MaxPool2d(kernel_size=2, stride=2) # 预池化处理

def extract_features(self, raw_data, comp_id_prefix):

"""

提取特征并存储为散列Component

:param raw_data: 原始输入数据(如文字/数字/符号的原始编码)

:param comp_id_prefix: Component ID前缀(如"text_"、"number_")

:return: 特征提取结果列表

"""

# 数据预处理:转换为模型输入格式

input_tensor = torch.tensor(raw_data, dtype=torch.float32).unsqueeze(0).to(self.device)

# 卷积特征提取

with torch.no_grad():

conv_out = self.conv_kernel(input_tensor)

pooled_out = self.pool(conv_out)

features = pooled_out.squeeze(0).cpu().numpy() # 转为numpy数组

# 特征存储为散列Component

results = []

for i, feature in enumerate(features):

comp_id = f"{comp_id_prefix}_feat_{i}"

component = {

"comp_id": comp_id,

"comp_type": "feature",

"comp_data": {

"values": feature.tolist(), # 特征值

"shape": feature.shape, # 特征形状

"extracted_time": self._get_current_time()

}

}

# 调用散列存储模块保存

self.component_manager.save_component(component)

results.append(comp_id)

return results # 返回特征Component的ID列表

def _get_current_time(self):

"""获取当前时间戳(辅助函数)"""

import datetime

return datetime.datetime.now().strftime("%Y-%m-%d %H:%M:%S")

# 测试代码

if __name__ == "__main__":

test_config = {

"in_channels": 1,

"out_channels": 3,

"kernel_size": 3,

"stride": 1

}

conv_layer = ConvLayer(test_config)

# 测试数据:模拟10x10的原始特征矩阵

test_data = np.random.rand(1, 10, 10) # 格式:(通道数, 高度, 宽度)

feature_ids = conv_layer.extract_features(test_data, "test")

print(f"提取的特征Component ID列表:{feature_ids}")

# 验证存储

for fid in feature_ids:

comp = conv_layer.component_manager.get_component(fid)

print(f"Component {fid} 存储成功:{comp['comp_data']['shape']}")timer_supervisor.py

python

import time

import logging

from component_manager import ComponentManager

# 配置日志

logging.basicConfig(

filename="./logs/timer_supervisor.log",

level=logging.INFO,

format="%(asctime)s - %(levelname)s - %(message)s"

)

class TimerSupervisor:

"""Timer监督组件:监控卷积层特征提取,补全特征残片(C执行)"""

def __init__(self, check_interval: int = 5):

"""

:param check_interval: 检查间隔(秒)

"""

self.component_manager = ComponentManager()

self.check_interval = check_interval # 定时检查间隔

self.feature_threshold = 5 # 特征数量阈值(低于此值视为残片)

self.running = False

def start_monitoring(self):

"""启动监督监控"""

self.running = True

logging.info("Timer监督组件启动")

while self.running:

self._check_feature_components()

time.sleep(self.check_interval)

def stop_monitoring(self):

"""停止监督监控"""

self.running = False

logging.info("Timer监督组件停止")

def _check_feature_components(self):

"""检查特征Component,补全残片"""

# 获取所有特征类型的Component

features = self.component_manager.get_components_by_type("feature")

if not features:

logging.warning("未发现特征Component,可能提取异常")

return

# 按提取时间分组(同一批次特征)

feature_groups = {}

for feat in features:

extract_time = feat["comp_data"]["extracted_time"].split(" ")[0] # 按日期分组

if extract_time not in feature_groups:

feature_groups[extract_time] = []

feature_groups[extract_time].append(feat)

# 检查每组特征是否完整

for date, group in feature_groups.items():

if len(group) < self.feature_threshold:

# 发现残片,触发补全(模拟补全逻辑)

missing_count = self.feature_threshold - len(group)

logging.warning(f"日期{date}的特征存在残片,需补全{missing_count}个")

self._fill_feature_gaps(date, missing_count)

def _fill_feature_gaps(self, date: str, missing_count: int):

"""补全特征残片(实际场景应调用重新提取接口)"""

for i in range(missing_count):

# 生成补全的特征Component

fill_comp = {

"comp_type": "feature",

"comp_data": {

"values": [0.0] * 25, # 补全默认值(示例长度)

"shape": (5, 5),

"extracted_time": f"{date} {time.strftime('%H:%M:%S')}",

"is_filled": True # 标记为补全数据

}

}

comp_id = self.component_manager.save_component(fill_comp)

logging.info(f"补全特征残片:{comp_id}")

# 测试代码

if __name__ == "__main__":

timer = TimerSupervisor(check_interval=10)

try:

print("启动Timer监督组件(按Ctrl+C停止)")

timer.start_monitoring()

except KeyboardInterrupt:

timer.stop_monitoring()

print("已停止监督")counter_supervisor.py

python

import time

import logging

import threading

from collections import defaultdict

# 配置日志

logging.basicConfig(

filename="./logs/counter_supervisor.log",

level=logging.INFO,

format="%(asctime)s - %(levelname)s - %(message)s"

)

class CounterSupervisor:

"""Counter监督组件:统计特征数量,识别冗余数据(P执行)"""

def __init__(self, report_interval: int = 3600):

"""

:param report_interval: 统计报告生成间隔(秒,默认1小时)

"""

self.statistics = defaultdict(lambda: {"total": 0, "valid": 0, "invalid": 0}) # 按小时统计

self.report_interval = report_interval

self.running = False

self.lock = threading.Lock() # 线程安全锁

def start_monitoring(self):

"""启动监督统计"""

self.running = True

logging.info("Counter监督组件启动")

# 启动定时报告线程

threading.Thread(target=self._generate_reports, daemon=True).start()

def stop_monitoring(self):

"""停止监督统计"""

self.running = False

logging.info("Counter监督组件停止")

# 生成最后一份报告

self._generate_reports(force=True)

def record_statistics(self, total: int, valid: int, invalid: int):

"""记录统计数据"""

with self.lock:

hour_key = time.strftime("%Y-%m-%d %H") # 按小时分组

self.statistics[hour_key]["total"] += total

self.statistics[hour_key]["valid"] += valid

self.statistics[hour_key]["invalid"] += invalid

# 检查无效数据比例是否超标(>30%)

if total > 0 and invalid / total > 0.3:

logging.warning(f"无效数据比例过高:{invalid/total:.2%},可能存在特征提取异常")

def _generate_reports(self, force: bool = False):

"""生成统计报告"""

while self.running or force:

force = False # 仅强制一次

current_hour = time.strftime("%Y-%m-%d %H")

# 处理上一小时的统计(如果存在)

last_hour = time.strftime("%Y-%m-%d %H", time.localtime(time.time() - 3600))

if last_hour in self.statistics:

stats = self.statistics[last_hour]

# 计算有效率

valid_rate = stats["valid"] / stats["total"] if stats["total"] > 0 else 0

report = (

f"【特征统计报告】时段:{last_hour}\n"

f"总特征数:{stats['total']},有效:{stats['valid']},无效:{stats['invalid']}\n"

f"有效率:{valid_rate:.2%}"

)

logging.info(report)

print(report) # 同时打印到控制台

# 移除已处理的统计(节省内存)

del self.statistics[last_hour]

# 等待下一个周期

if self.running:

time.sleep(self.report_interval)

else:

break

# 测试代码

if __name__ == "__main__":

counter = CounterSupervisor(report_interval=60) # 测试用1分钟间隔

try:

print("启动Counter监督组件(按Ctrl+C停止)")

counter.start_monitoring()

# 模拟数据统计

import random

while True:

total = random.randint(10, 100)

invalid = random.randint(0, int(total*0.4))

valid = total - invalid

counter.record_statistics(total, valid, invalid)

time.sleep(5)

except KeyboardInterrupt:

counter.stop_monitoring()

print("已停止监督")pooling_layer.py

python

import numpy as np

from sequence_connector import SequenceConnector

from struct_x import StructX

from counter_supervisor import CounterSupervisor

class PoolingLayer:

"""池化层:负责筛选有效特征,去除冗余数据(框架层核心)"""

def __init__(self, target_host: str = "localhost", target_port: int = 8889):

self.target_host = target_host # Target主机地址

self.target_port = target_port # Target主机端口

self.connector = SequenceConnector(port=8888) # 监听Home的数据

self.connector.set_on_receive(self._process_features)

# 初始化Counter监督组件

self.counter = CounterSupervisor()

# 特征筛选阈值(有效特征的最小方差)

self.variance_threshold = 0.1

def start(self):

"""启动池化层服务"""

print("池化层服务启动")

self.counter.start_monitoring()

self.connector.start_server()

def _process_features(self, struct_x: StructX):

"""处理从Home接收的特征数据,筛选后发送到Target"""

if struct_x.type != 1: # 仅处理类型1(特征数据)

return

# 解析特征数据(格式:{"feature_ids": [...], "data": [...]})

feature_data = struct_x.data

print(f"收到{len(feature_data['data'])}个原始特征")

# 筛选有效特征(计算方差,保留方差高于阈值的特征)

valid_features = []

for feat in feature_data['data']:

feat_array = np.array(feat)

variance = np.var(feat_array)

if variance >= self.variance_threshold:

valid_features.append(feat)

# 记录统计(供Counter监督)

self.counter.record_statistics(

total=len(feature_data['data']),

valid=len(valid_features),

invalid=len(feature_data['data']) - len(valid_features)

)

# 封装为StructX,发送到Target

if valid_features:

output_struct = StructX(

type=2, # 类型2:筛选后的特征数据

data={"valid_features": valid_features, "source_ids": feature_data['feature_ids']}

)

send_ok = self.connector.send_data(self.target_host, self.target_port, output_struct)

print(f"筛选后保留{len(valid_features)}个特征,发送结果:{'成功' if send_ok else '失败'}")

# 测试代码

if __name__ == "__main__":

# 启动池化层(连接到Target的8889端口)

pooling = PoolingLayer(target_port=8889)

try:

pooling.start()

input("池化层运行中,按Enter停止...\n")

except KeyboardInterrupt:

pooling.counter.stop_monitoring()

print("池化层已停止")sequence_connector.py

python

import socket

import json

import threading

from typing import List, Callable

from struct_x import StructX

class SequenceConnector:

"""序列Correlative连接:负责Home→Host→Target的数据传输(框架层核心)"""

def __init__(self, host: str = "0.0.0.0", port: int = 8888):

self.host = host

self.port = port

self.server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

self.server_socket.bind((self.host, self.port))

self.server_socket.listen(5)

self.client_handlers = [] # 客户端处理器列表

self.on_receive: Callable = None # 接收数据回调函数

def set_on_receive(self, callback: Callable):

"""设置数据接收回调(用于处理接收到的数据)"""

self.on_receive = callback

def _handle_client(self, client_socket: socket.socket):

"""处理客户端连接(Home发送数据或Target接收数据)"""

try:

while True:

# 接收数据(先接收长度,再接收内容)

length_bytes = client_socket.recv(4)

if not length_bytes:

break

data_length = int.from_bytes(length_bytes, byteorder='big')

data_bytes = client_socket.recv(data_length)

# 解析为StructX格式

struct_x = StructX.from_bytes(data_bytes)

print(f"收到数据:类型{struct_x.type},长度{struct_x.length}")

# 触发回调处理

if self.on_receive:

self.on_receive(struct_x)

# 发送确认

client_socket.sendall(b"OK")

except Exception as e:

print(f"客户端处理异常:{e}")

finally:

client_socket.close()

def start_server(self):

"""启动服务器,监听连接"""

print(f"序列连接服务器启动:{self.host}:{self.port}")

threading.Thread(target=self._accept_connections, daemon=True).start()

def _accept_connections(self):

"""持续接收连接"""

while True:

client_socket, addr = self.server_socket.accept()

print(f"新连接:{addr}")

handler = threading.Thread(target=self._handle_client, args=(client_socket,))

handler.start()

self.client_handlers.append(handler)

def send_data(self, target_host: str, target_port: int, struct_x: StructX) -> bool:

"""发送数据到目标主机(如Host→Target)"""

try:

with socket.socket(socket.AF_INET, socket.SOCK_STREAM) as s:

s.connect((target_host, target_port))

# 先发送数据长度,再发送数据

data_bytes = struct_x.to_bytes()

s.sendall(len(data_bytes).to_bytes(4, byteorder='big'))

s.sendall(data_bytes)

# 等待确认

response = s.recv(2)

return response == b"OK"

except Exception as e:

print(f"发送数据失败:{e}")

return False

# 测试代码

if __name__ == "__main__":

# 启动服务器(Host主机)

connector = SequenceConnector()

# 定义接收回调

def handle_receive(struct_x: StructX):

print(f"处理接收到的数据:{struct_x.data}")

# 模拟转发到Target(此处简化处理)

if struct_x.type == 2: # 变量数据帧

forward_ok = connector.send_data("localhost", 8889, struct_x)

print(f"转发到Target结果:{'成功' if forward_ok else '失败'}")

connector.set_on_receive(handle_receive)

connector.start_server()

# 保持运行

try:

while True:

input("按Enter退出...\n")

break

except KeyboardInterrupt:

passcomposite_calculator.py

python

import numpy as np

import pandas as pd

from sequence_connector import SequenceConnector

from struct_x import StructX

from watcher_supervisor import WatcherSupervisor

class CompositeCalculator:

"""行列Composite计算:负责业务结果计算(实现层核心)"""

def __init__(self, db_path: str = "./data/results.db"):

self.db_path = db_path # 结果存储路径

self.connector = SequenceConnector(port=8889) # 监听Host的数据

self.connector.set_on_receive(self._calculate_result)

# 初始化Watcher监督组件

self.watcher = WatcherSupervisor(result_path=db_path)

# 业务计算规则(行列计算逻辑)

self.calc_rules = {

"default": lambda x: np.sum(x) * 2, # 默认规则:总和×2

"weighted": lambda x: np.sum(np.array(x) * np.array([0.3, 0.5, 0.2])) # 加权计算

}

def start(self):

"""启动计算服务"""

print("全连接层计算服务启动")

self.watcher.start_monitoring()

self.connector.start_server()

def _calculate_result(self, struct_x: StructX):

"""处理从Host接收的筛选后特征,执行行列计算"""

if struct_x.type != 2: # 仅处理类型2(筛选后的特征)

return

# 解析特征数据

feature_data = struct_x.data

valid_features = feature_data['valid_features']

source_ids = feature_data['source_ids']

print(f"收到{len(valid_features)}个有效特征,开始计算")

# 执行行列计算(将特征按行排列,应用列规则)

try:

# 转换为DataFrame(行=特征,列=特征维度)

feat_df = pd.DataFrame(valid_features)

# 应用计算规则(默认+加权,取平均值作为结果)

default_result = self.calc_rules["default"](feat_df.mean(axis=0))

weighted_result = self.calc_rules["weighted"](feat_df.mean(axis=0))

final_result = (default_result + weighted_result) / 2

# 封装结果

result = {

"result_id": f"res_{''.join([id[:4] for id in source_ids[:2]])}", # 基于源特征ID生成

"value": round(final_result, 2),

"source_ids": source_ids,

"calc_time": self._get_current_time(),

"rules_used": ["default", "weighted"]

}

# 存储结果(触发Watcher监督)

self._save_result(result)

print(f"计算完成:{result['result_id']} = {result['value']}")

except Exception as e:

error_msg = f"计算失败:{str(e)}"

print(error_msg)

self.watcher.record_error(error_msg, source_ids)

def _save_result(self, result: dict):

"""保存计算结果(CSV格式,便于行列查询)"""

import csv

import os

# 确保存储目录存在

if not os.path.exists(os.path.dirname(self.db_path)):

os.makedirs(os.path.dirname(self.db_path))

# 写入CSV(追加模式)

with open(self.db_path, "a", newline="", encoding="utf-8") as f:

writer = csv.DictWriter(f, fieldnames=result.keys())

# 首次写入时添加表头

if os.path.getsize(self.db_path) == 0:

writer.writeheader()

writer.writerow(result)

# 通知Watcher监督结果

self.watcher.verify_result(result)

def _get_current_time(self):

"""获取当前时间戳"""

import datetime

return datetime.datetime.now().strftime("%Y-%m-%d %H:%M:%S")

# 测试代码

if __name__ == "__main__":

calculator = CompositeCalculator(db_path="./data/test_results.csv")

try:

calculator.start()

input("全连接层运行中,按Enter停止...\n")

except KeyboardInterrupt:

calculator.watcher.stop_monitoring()

print("计算服务已停止")watcher_supervisor.py

python

import time

import logging

import threading

import os

from collections import defaultdict

# 配置日志

logging.basicConfig(

filename="./logs/watcher_supervisor.log",

level=logging.INFO,

format="%(asctime)s - %(levelname)s - %(message)s"

)

class WatcherSupervisor:

"""Watcher监督组件:监控计算结果,处理错误和完整性(D执行)"""

def __init__(self, result_path: str, check_interval: int = 60):

"""

:param result_path: 结果存储路径

:param check_interval: 结果检查间隔(秒)

"""

self.result_path = result_path

self.check_interval = check_interval

self.result_cache = {} # 缓存近期结果(result_id -> 结果)

self.error_records = defaultdict(list) # 错误记录(source_ids -> 错误信息)

self.running = False

def start_monitoring(self):

"""启动结果监督"""

self.running = True

logging.info("Watcher监督组件启动")

# 启动定时检查线程

threading.Thread(target=self._check_results, daemon=True).start()

def stop_monitoring(self):

"""停止结果监督"""

self.running = False

logging.info("Watcher监督组件停止")

def verify_result(self, result: dict):

"""验证单条结果的完整性和合理性"""

# 1. 完整性检查

required_fields = ["result_id", "value", "source_ids", "calc_time"]

missing_fields = [f for f in required_fields if f not in result]

if missing_fields:

error = f"结果不完整,缺失字段:{missing_fields}"

self.error_records[",".join(result.get("source_ids", []))].append(error)

logging.error(error)

return False

# 2. 合理性检查(值范围)

if not (-1000 <= result["value"] <= 10000): # 假设合理范围

error = f"结果值不合理:{result['value']}(超出-1000~10000范围)"

self.error_records[",".join(result["source_ids"])].append(error)

logging.warning(error)

# 尝试自动修正(示例:截断到最大/最小值)

corrected_value = max(-1000, min(10000, result["value"]))

logging.info(f"自动修正结果为:{corrected_value}")

result["value"] = corrected_value

result["is_corrected"] = True

# 缓存结果

self.result_cache[result["result_id"]] = result

logging.info(f"结果验证通过:{result['result_id']} = {result['value']}")

return True

def record_error(self, error_msg: str, source_ids: list):

"""记录计算错误"""

source_key = ",".join(source_ids)

self.error_records[source_key].append(error_msg)

logging.error(f"源特征{source_key}计算错误:{error_msg}")

def _check_results(self):

"""定时检查结果文件完整性(如是否有损坏、缺失)"""

while self.running:

if os.path.exists(self.result_path):

# 检查文件大小是否异常(如0字节)

file_size = os.path.getsize(self.result_path)

if file_size == 0:

logging.warning("结果文件为空,可能存在写入异常")

elif file_size > 1024 * 1024 * 100: # 100MB

logging.warning("结果文件过大(>100MB),建议归档")

# 清理过期缓存(保留24小时内的结果)

now = time.time()

expired_ids = []

for result_id, result in self.result_cache.items():

# 解析时间戳为时间戳

import datetime

calc_time = datetime.datetime.strptime(result["calc_time"], "%Y-%m-%d %H:%M:%S")

if (now - calc_time.timestamp()) > 86400: # 24小时

expired_ids.append(result_id)

for rid in expired_ids:

del self.result_cache[rid]

logging.info(f"清理过期结果缓存,剩余{len(self.result_cache)}条")

time.sleep(self.check_interval)

# 测试代码

if __name__ == "__main__":

watcher = WatcherSupervisor("./data/test_results.csv", check_interval=30)

try:

print("启动Watcher监督组件(按Ctrl+C停止)")

watcher.start_monitoring()

# 模拟结果验证

test_result = {

"result_id": "test_res_001",

"value": 123.45,

"source_ids": ["feat_001", "feat_002"],

"calc_time": time.strftime("%Y-%m-%d %H:%M:%S")

}

watcher.verify_result(test_result)

# 模拟异常结果

bad_result = {

"result_id": "test_res_002",

"value": 100000, # 超出范围

"source_ids": ["feat_003"],

"calc_time": time.strftime("%Y-%m-%d %H:%M:%S")

}

watcher.verify_result(bad_result)

while True:

time.sleep(1)

except KeyboardInterrupt:

watcher.stop_monitoring()

print("已停止监督")模块实现说明

-

CNN 三层核心模块

- Home 主机 :实现卷积层特征提取(

conv_layer.py)、散列 Component 存储(component_manager.py)和 Timer 监督(timer_supervisor.py),完成原始数据到特征的转换与存储。 - Host 主机 :通过

sequence_connector.py实现序列连接,pooling_layer.py筛选有效特征,counter_supervisor.py统计特征质量,负责特征的清洗与转发。 - Target 主机 :

composite_calculator.py执行行列复合计算,结合业务规则生成结果,watcher_supervisor.py监控结果有效性,确保业务输出准确。

- Home 主机 :实现卷积层特征提取(

-

公共支撑模块

- 统一接口(

struct_x.py):定义标准化数据格式,支持跨主机序列化 / 反序列化,确保数据传输一致性。 - 模式适配器(

mode_adapter.py):提供 Component 与 StructX 互转、numpy 与列表互转等适配功能,解决不同模块间的数据格式差异。 - 配置管理(

config_manager.py):集中管理各模块配置,支持动态更新,适配不同部署环境需求。

- 统一接口(

开发与验收建议

- 按模块顺序开发:先完成公共支撑模块(基础依赖),再依次开发 Home→Host→Target 主机模块。

- 单元测试:每个模块的

if __name__ == "__main__"包含测试代码,可直接运行验证核心功能。 - 验收重点:确保各模块间数据流转通畅(如 Home 特征能通过 Host 转发至 Target),监督组件能有效检测并处理异常(如残片补全、错误修正)。

下一步可基于这些模块,集成 Supervisor 统管模块和 Master/Slave 协同模块,完成完整设计的落地。

Q282

Q282、请就刚才给出的 程序文件 详细指导 搭建开发环境,并给出完整 的 其它必要的开发文件 和开发指导--适合开发小白的

<<用户现在需要详细指导搭建开发环境,并且需要其他必要的开发文件和适合开发小白的指导。首先,我需要回顾之前提供的程序文件,确保开发环境的搭建能够支持这些文件的运行。

首先,开发环境需要考虑操作系统,对于小白来说,Windows 可能更常见,所以以 Windows 为例,但也可以提到 Linux 的选项。然后,需要安装 Python,因为所有代码都是 Python 编写的,选择合适的版本,比如 3.9.6,之前提到过这个版本,兼容性好。

接下来,安装必要的依赖包,比如 numpy 用于数值计算,redis 如果用到的话,但之前的代码里主要用了 Python 内置模块和 json,可能需要确认依赖。然后,创建项目结构,按照之前的文件路径,比如 config、src/utils 等目录,确保文件组织清晰,小白能跟着一步步创建。

然后,需要提供具体的步骤,从安装 Python 开始,包括如何检查安装是否成功,如何使用 pip 安装依赖,如何创建项目文件夹和文件。每个步骤都要详细,比如截图提示或者具体的命令行指令,避免使用太专业的术语,用简单明了的语言。

还要考虑到小白可能对命令行不熟悉,所以尽量提供图形界面的操作方法,或者详细的命令说明。比如,如何打开命令提示符,如何导航到项目目录,如何运行 Python 脚本测试。

另外,需要补充之前提到的其他必要文件,比如配置文件 core_config.json 的初始内容,确保程序能够正确加载配置。还有可能需要的测试数据,比如一些示例 Component 数据,帮助小白验证模块是否正常工作。

最后,提供测试步骤,每个模块如何单独测试,如何检查是否符合验收标准,比如运行 config_manager.py 的测试代码,查看是否能正确加载和更新配置。同时,给出常见问题的解决方法,比如 Python 路径问题、依赖安装失败等,帮助小白排查错误。

总结下来,结构应该是:开发环境准备(系统、Python 安装)、项目结构创建、依赖安装、必要文件补充、详细操作步骤、测试方法、常见问题。确保每个步骤都有明确的指导,适合没有太多开发经验的人跟随操作。>>

一、开发环境搭建(超详细小白版)

1. 准备工作(3 分钟)

- 操作系统:推荐 Windows 10/11(本文以 Windows 为例,Linux/macOS 操作类似)

- 所需工具:无需提前安装任何软件,按步骤操作即可

2. 安装 Python(5 分钟)

Python 是运行代码的基础,按以下步骤操作:

- 打开浏览器,访问 Python 官网:https://www.python.org/downloads/release/python-396/

- 下拉页面,找到 "Windows x86-64 executable installer",点击下载(约 25MB)

- 双击安装包,务必勾选 "Add Python 3.9 to PATH"(关键!否则后续无法运行命令),然后点击 "Install Now"

- 等待安装完成,点击 "Close"

3. 验证 Python 安装(2 分钟)

- 按下

Win+R,输入cmd,按回车打开 "命令提示符"(黑色窗口) - 输入命令:

python --version,按回车✅ 成功:显示Python 3.9.6❌ 失败:若提示 "不是内部命令",重新安装并勾选 "Add to PATH"

4. 创建项目文件夹(3 分钟)

-

在桌面右键→"新建→文件夹",命名为

cnn_project -

双击进入

cnn_project,按以下结构创建子文件夹(右键→新建→文件夹):plaintext

csscnn_project/ ├─ config/ # 存放配置文件 ├─ src/ # 源代码文件夹 │ └─ utils/ # 工具模块 └─ data/ # 数据存储文件夹

二、补充必要开发文件(直接复制创建)

按以下步骤创建所有必要文件,文件名和内容必须完全一致:

1. 配置文件(config/core_config.json)

-

打开

cnn_project/config文件夹,右键→"新建→文本文档",命名为core_config.json(注意:将 ".txt" 改为 ".json",若看不到后缀,参考文末小技巧) -

复制以下内容到文件中,保存关闭: json

css{ "home": { "conv_layer": { "in_channels": 1, "out_channels": 3, "kernel_size": 3, "stride": 1 }, "timer": { "check_interval": 5, "feature_threshold": 5 } }, "host": { "pooling_layer": { "variance_threshold": 0.1 }, "counter": { "report_interval": 3600 } }, "target": { "calculator": { "db_path": "./data/results.db" }, "watcher": { "check_interval": 60 } }, "common": { "struct_x": { "max_length": 1048576 } } }

2. 公共支撑模块:统一接口(src/utils/struct_x.py)

-

打开

cnn_project/src/utils文件夹,新建文本文档,命名为struct_x.py -

复制以下内容: python

运行

pythonimport json from typing import Dict, Any class StructX: """统一接口:跨主机数据传输的标准格式(公共支撑核心)""" def __init__(self, type_: int, data: Any): """ :param type_: 数据类型(1=数据报, 2=数据帧, 3=数据位) :param data: 具体数据(任意类型) """ self.type = type_ self.data = data self.length = len(json.dumps(data)) # 计算数据长度 def to_bytes(self) -> bytes: """转为字节流,用于网络传输""" payload = { "type": self.type, "length": self.length, "data": self.data } return json.dumps(payload).encode("utf-8") @staticmethod def from_bytes(byte_data: bytes) -> "StructX": """从字节流解析出StructX对象""" payload = json.loads(byte_data.decode("utf-8")) return StructX( type_=payload["type"], data=payload["data"] ) # 测试代码(小白可直接运行验证) if __name__ == "__main__": # 创建一个数据帧(类型2) test_data = {"文字": 4, "数字": 3, "符号": 3} struct_x = StructX(type_=2, data=test_data) # 转为字节流(模拟传输) byte_data = struct_x.to_bytes() print("传输的字节流:", byte_data) # 解析字节流(模拟接收) received_struct = StructX.from_bytes(byte_data) print("解析后的数据:", received_struct.data) assert received_struct.data == test_data # 验证数据一致 print("✅ 统一接口测试成功!")

3. 公共支撑模块:模式适配器(src/utils/mode_adapter.py)

-

在

src/utils文件夹新建mode_adapter.py,复制以下内容:python

运行

pythonfrom .struct_x import StructX from typing import Dict, Any class ModeAdapter: """模式适配器:转换不同模块的数据格式(公共支撑核心)""" @staticmethod def component_to_struct_x(component: Dict[str, Any], type_: int) -> StructX: """将散列Component转换为StructX对象""" return StructX( type_=type_, data={ "comp_id": component["comp_id"], "comp_type": component["comp_type"], "comp_data": component["comp_data"] } ) @staticmethod def struct_x_to_component(struct_x: StructX) -> Dict[str, Any]: """将StructX对象转换为散列Component""" data = struct_x.data return { "comp_id": data["comp_id"], "comp_type": data["comp_type"], "comp_data": data["comp_data"], "create_time": data.get("create_time", "2024-10-30") # 默认时间 } # 测试代码 if __name__ == "__main__": # 模拟一个散列Component test_component = { "comp_id": "test_001", "comp_type": "variant", "comp_data": {"文字": 4} } # 转换为StructX(类型2) adapter = ModeAdapter() struct_x = adapter.component_to_struct_x(test_component, type_=2) print("转换后的StructX:", struct_x.data) # 转换回Component recovered_component = adapter.struct_x_to_component(struct_x) print("转换回的Component:", recovered_component) assert recovered_component["comp_data"] == test_component["comp_data"] print("✅ 适配器测试成功!")

4. CNN 核心模块:Home 主机卷积层(src/conv_layer.py)

-

在

src文件夹新建conv_layer.py,复制以下内容:python

运行

pythonimport numpy as np from utils.config_manager import ConfigManager class ConvLayer: """Home主机卷积层:提取数据特征(CNN核心)""" def __init__(self): self.config = ConfigManager() # 从配置加载卷积参数 conv_config = self.config.get_config("home.conv_layer") self.kernel_size = conv_config["kernel_size"] self.out_channels = conv_config["out_channels"] # 初始化卷积核(简单示例) self.kernels = np.random.randn( self.out_channels, conv_config["in_channels"], self.kernel_size, self.kernel_size ) def extract_features(self, data: np.ndarray) -> np.ndarray: """ 提取特征(简化版卷积计算) :param data: 输入数据(格式:[高度, 宽度]) :return: 提取的特征(格式:[输出通道, 新高度, 新宽度]) """ h, w = data.shape kh, kw = self.kernel_size, self.kernel_size # 计算输出尺寸(简化:不考虑padding) out_h = h - kh + 1 out_w = w - kw + 1 features = np.zeros((self.out_channels, out_h, out_w)) # 执行卷积(滑动窗口) for c in range(self.out_channels): for i in range(out_h): for j in range(out_w): window = data[i:i+kh, j:j+kw] features[c, i, j] = np.sum(window * self.kernels[c, 0]) return features # 测试代码(生成随机数据验证) if __name__ == "__main__": conv = ConvLayer() # 生成10x10的随机数据(模拟原始数据) test_data = np.random.randn(10, 10) features = conv.extract_features(test_data) print(f"输入数据形状:{test_data.shape}") print(f"提取的特征形状:{features.shape}") # 应为(3, 8, 8)(3通道,10-3+1=8) assert features.shape == (3, 8, 8) print("✅ 卷积层特征提取测试成功!")

三、运行与测试(小白必看)

1. 安装依赖包(2 分钟)

- 打开命令提示符,输入以下命令并回车(安装数值计算库):

pip install numpy等待显示 "Successfully installed numpy-..." 即为成功。

2. 测试单个模块

每个文件都可直接运行测试,步骤相同:

-

打开

cnn_project文件夹,按住Shift键右键空白处,选择 "在此处打开命令窗口" -

输入命令运行对应文件(复制粘贴即可):

- 测试配置管理:

python src/utils/config_manager.py - 测试统一接口:

python src/utils/struct_x.py - 测试适配器:

python src/utils/mode_adapter.py - 测试卷积层:

python src/conv_layer.py

- 测试配置管理:

-

若最后显示

✅ 测试成功,说明模块正常;若报错,检查文件名和内容是否与本文完全一致。

四、常见问题解决

-

看不到文件后缀(如.txt):打开任意文件夹→顶部 "查看"→勾选 "文件扩展名"

-

运行命令提示 "No module named ..." :检查文件路径是否正确,比如

src/utils/config_manager.py必须放在指定文件夹中 -

numpy 安装失败 :输入命令

pip install numpy --user,或换网络重试

五、下一步开发计划

按以下顺序继续开发剩余模块(方法同上):

- Home 主机:

src/component_manager.py(散列存储) - Host 主机:

src/pooling_layer.py(池化层) - Target 主机:

src/composite_calculator.py(计算模块)

每个模块开发后都运行测试代码,确保✅ 测试成功再进行下一步。

如果遇到任何问题,直接复制错误提示并提问,我会帮你解决!