本文根据 2025云栖大会演讲整理而成,演讲信息如下:

演讲人:魏博文(阿里云智能集团计算平台事业部解决方案负责人)

演讲主题:人工智能+大数据平台加速企业模型后训练

目前大模型能力已经足够优秀,模型后训练作为大模型落地的重要一环,能显著优化模型性能,适配特定领域需求。相比于模型预训练,后训练阶段对计算资源和数据资源需求更小,更易迭代,为大语言模型提供了针对特定业务场景调优的能力,打通了通用大模型到垂直领域应用的"最后一公里"。

阿里云大数据 AI 平台重磅发布大模型后训练解决方案,通过全栈 AI 能力 ,为企业提供从算力到平台的"后训练"一体化支撑 。凭借稳定、高效、全能的产品特性,让企业从容面对大模型后训练阶段复杂的系统性工程挑战。使用阿里云大数据 AI 平台大模型后训练解决方案,实现训练加速比3倍、训练效率100%的提升,有效助力大模型后训练技术在各行各业的落地。

一、"大模型训练"落地方案的演进

在 AI 加速重塑千行百业的浪潮中,大模型的落地路径正持续演进,逐步从通用能力构建走向深度场景化应用。

2022年,随着大规模预训练模型的兴起,企业开始聚焦基础预训练,探索模型的通用能力,开启了AI大模型的产业化序幕。2023年,行业转向"继续预训练",结合领域内的专有数据与公开语料,进一步提升模型在特定场景中的语义理解与表达能力。进入2024年,以监督微调(SFT)为代表的后训练技术成为主流,企业得以在少量高质量数据的基础上,高效实现模型能力的定制化提升,显著降低了训练成本与资源消耗。而自2025年起,强化学习(RL)与Agentic AI理念深度融合,推动大模型向自主决策、多轮交互、工具调用等复杂任务迈进,成为垂直领域智能化升级的关键驱动力。

在此背景下,以 Qwen 为代表的高性能开源大模型,凭借其强大的基础能力,为企业提供了理想的起点。通过结合行业高质量数据进行系统性后训练,企业不仅能够精准解决实际业务问题,更可突破通用模型的性能瓶颈,实现超越闭源模型的领域专精能力。这一从"预训练"到"后训练"的完整演进路径,正构筑起企业构建专属AI大脑的核心基石,加速千行百业的智能化转型进程。

后训练不仅关乎算法层的优化,更依赖底层算力、平台能力与应用层协同,确保全链路的可行性与稳定性。用户对平台的需求,不再是预训练阶段仅需把数据规整好提供给平台后等待结果那么简单了,在后训练阶段,用户需要的是一个安全稳定、性能卓越且功能全面的平台。越来越多企业认识到:唯有"云+AI"的融合,才能从底层资源到应用层全面释放 AI 价值。

二、企业级大模型后训练解决方案突破效能边界

针对企业大模型后训练的需求,阿里云大数据 AI 平台发布基于"人工智能+大数据平台"的企业级大模型后训练解决方案。依托人工智能平台 PAI、云原生大数据计算服务 MaxCompute 等系列产品,以稳定、高效、全能的方案优势,全面打通从数据预处理、模型训练到推理部署的全链路,助力企业高效构建具备领域深度的 Agentic AI 应用。大模型后训练解决方案将企业从繁重的底层工程中解放出来,专注于业务创新。

围绕"数据-训练-推理-AI应用"的全生命周期,阿里云大数据 AI 平台为后训练提供端到端支撑,保障从基模选择、数据准备、模型训练到部署上线的每一个环节都能高效运行且无缝对接。

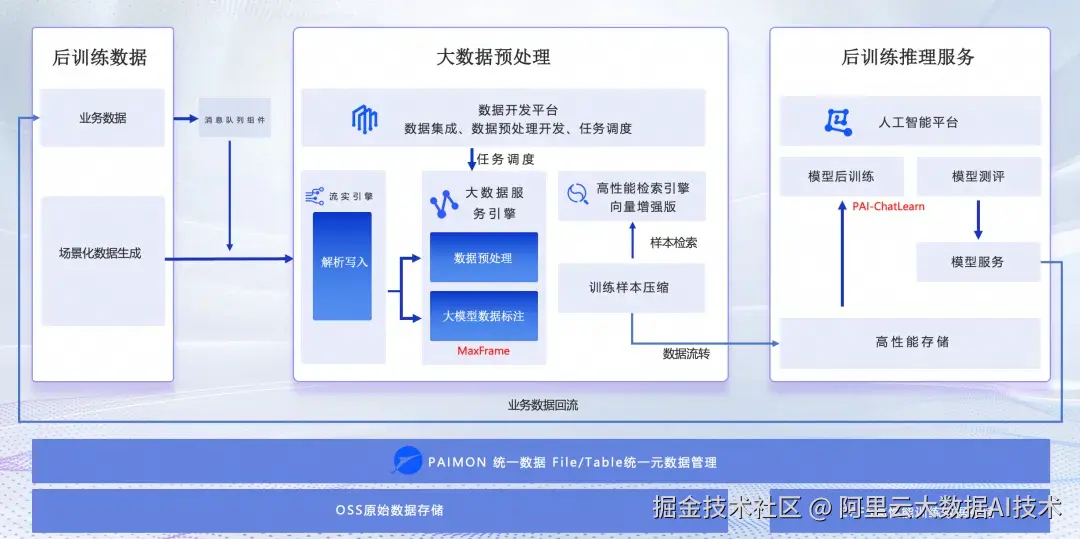

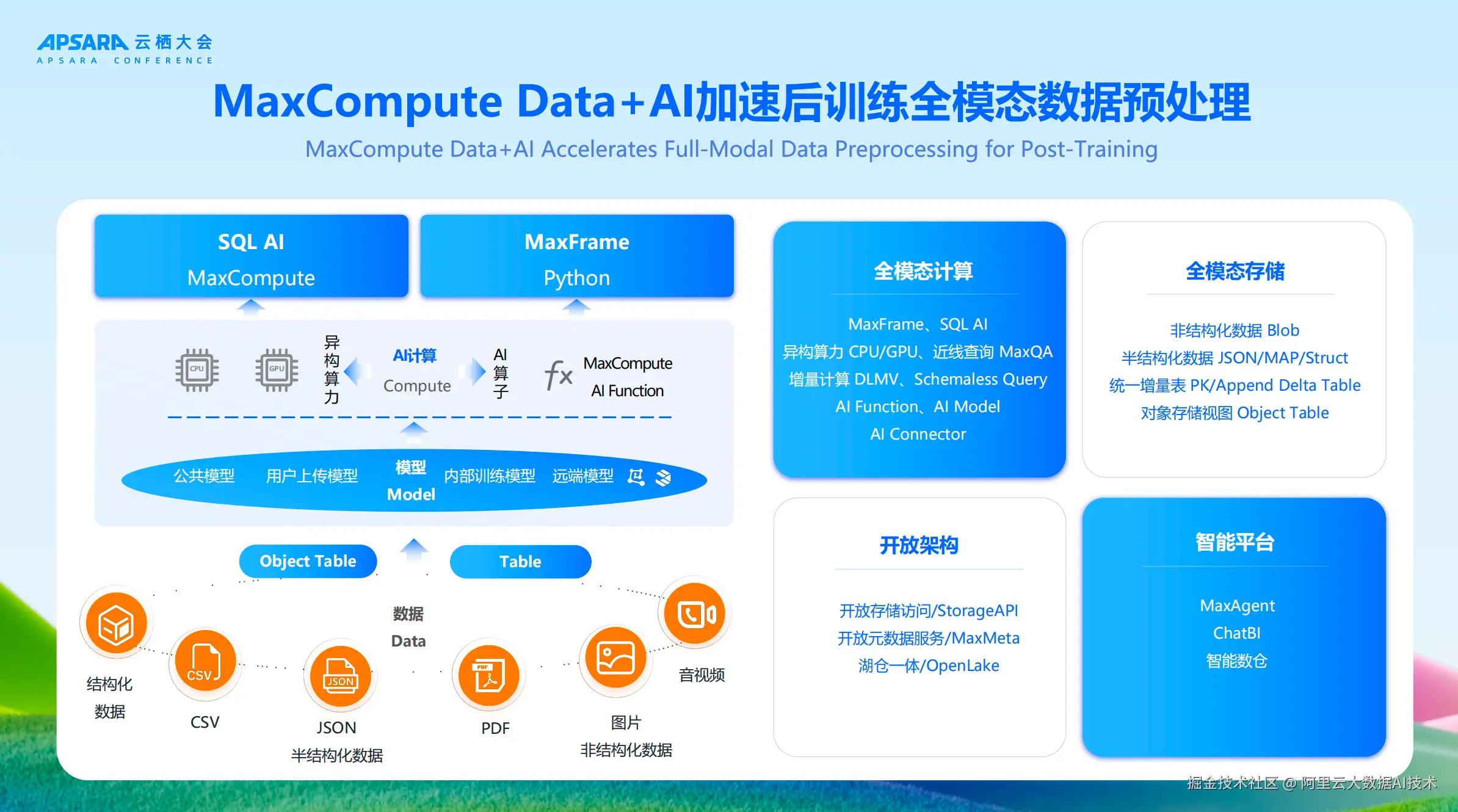

在数据处理阶段 ,阿里云提供面向AI场景的多模态数据处理方案,接入业务数据和场景化合成的数据,通过 MaxCompute MaxFrame+PAI-EAS+Flink 等产品实现统一的数据处理体验,支持百万任务调度与管理,整体数据处理效率提升10倍以上,数据处理推理任务优化提速1倍以上,相同资源产能提升1倍。大数据开发治理平台 DataWorks 负责数据集成、数据预处理任务开发和任务调度,确保数据能够被高效地处理和利用。实时计算 Flink 版作为流式引擎,提供端到端亚秒级实时数据分析能力,实时解析并写入接收到的数据,将其转化为可处理的格式。MaxCompute 将 AI 的能力应用于数据预处理环节,发布科学计算框架 MaxFrame。MaxFrame 是构建在大规模计算平台 MaxCompute 之上的完全兼容 Python 生态的分布式计算引擎,支持 Python 编程接口,兼容 Pandas 等数据处理及 ML 算子接口且自动实现分布式处理,同时提供 AI Function 调用能力,实时调用大模型,进行多模态数据预处理,以满足用户不断增长的在 Python 生态中高效进行大数据处理和AI开发的需求。方案可集成 Hologres 和高性能向量增强引擎 Elasticsearch 实现海量数据的实时查询和向量数据的毫秒级检索;可使用 Data-Juicer 在亿级别甚至千亿级别的样本量级下,实现高效的大规模数据预处理。

在模型训练阶段,围绕大模型后训练的三大核心挑战------长上下文训练效率低、MoE(混合专家)模型通信开销大、强化学习环境复杂,推出多项技术创新。

随着参数规模变大,专家负载不均、路由不稳定、通信开销爆炸------尤其是在数千卡甚至万卡以上集群,如何提升算力利用率就成为了模型迭代的生命线。人工智能平台 PAI 重磅推出专为大规模 MoE 模型训练而生的 paiMoE 框架,通过规范调度策略、计算通信掩盖、计算显存分离式并行,实现超大规模算力情况下高效训练计算。实测达到 Qwen3 训练端到端加速比提效 3 倍。MoE 高性能训练优化 Tangram, 通过五级PP调度(segment/chunk/slice/phase/fragment),分段策略(Front Segment显存优化+Backbone Segment高效调度),实现计算通信精细掩盖与显存灵活管理;长序列训练优化 ChunkFlow 针对变长/超长序列数据集,通过重组为等长Chunk(8K),解决显存浪费、负载不均、PP Bubble等问题。已在 Qwen 全系模型SFT/CPT阶段作为默认方案,实现2倍+性能提升。

同时,推出灵活、易用、高效的大规模强化学习训练框架 PAI-Chatlearn,支持 RLHF、DPO、GRPO 等多种先进的 Alignment 训练算法,支持任意模型的后训练任务快速配置。实验数据表明,Qwen3-30B-A3B 模型在相同的硬件环境下,PAI-ChatLearn 相较于开源的框架来说,训练的吞吐基本上提升2倍以上 。

在模型部署阶段, 模型在线服务平台 PAI-EAS 面向Agentic-AI时代全面升级。PAI-EAS 提供分布式推理能力,通过多机Prefill-Decode-EP分离架构,结合 LLM 智能路由和 MoE 分布式推理调度引擎 Llumnix,能显著提升推理速度和资源利用率以降低模型使用成本,做到首Token生成响应时间降低92%,端到端服务吞吐提升5倍+。 同时,PAI-ModelGallery 支持包含 Qwen、DeepSeek 在内的 300 +模型的零代码一键后训练、评测、部署。

新发布的企业级大模型后训练解决方案在性能、成本、功能、安全等多维度均有着突出优势:

- 模型训练效率提升:训练加速比 3 倍提升,训练资源规模效率提升 100%;

- 模型推理效率提升:首 Token 生成响应时间降低 92%,端到端服务吞吐提升 5 倍+;

- 一体化开发效率提速:数据包处理效率相比自建提升 10 倍以上,数据处理推理任务优化提速 1 倍以上,相同资源产能提升 1 倍;

- 支持百万级任务管理及并发调度,每拉起 10000 CU资源运行仅需不到 10 秒;

- 全链路样本数据血缘存储和检索分析,数据合规安全保护;

- 企业级 Serverless 化平台,稳定可靠,兼容开源生态。

三、技术底座揭秘:解决方案核心产品全解析

大模型后训练解决方案是基于人工智能平台和大数据产品构建的,关键场景的产品作用见下表:

| 关键场景 | 核心产品 | 特性与优势 |

|---|---|---|

| 数据集成、数据开发与任务调度 | 大数据开发治理平台DataWorks | 相较于 Airflow/Argo Workflow,DataWorks在以下方面具有优势: * 部署方式:多可用区部署,具备容灾能力 * 调度方式:Task 和 Workflow两种调度单位,可任意灵活组合使用 * 开发方式:提供了以 VSCode为基础的智能开发调试环境,一套完整的研发工程流程,开发便利。 具备Copilot能力(包括语法提示、代码补全)、发布中心、检查器等 * 运维方式:运维中心提供了丰富的运维手段,且可视化能力。包括大屏、DAG图、多场景补数据、数据回刷、智能诊断、引擎联动、丰富的重跑策略(关键字、优先级) |

| 大数据服务引擎 | 云原生大数据计算服务MaxCompute | MaxFrame 是构建在大规模计算平台 MaxCompute 之上的分布式计算引擎 * 支持上万任务并发运行,单任务可调用超4万Core,最大可分配资源超10万Core * 相比开源Ray on K8s,MaxFrame算子性能提升超2倍,且兼容CPU/GPU资源混合调度,适配主流GPU,满足不同计算场景。最大支持20GB单文件处理能力 |

| 模型训练、推理、评测 | 人工智能平台 PAI | 企业级的大模型工程化能力,提供包含数据集管理、算力管理、模型工具链、模型开发、模型训练、模型部署、AI资产管理在内的功能模块,内置 100+ 种大模型最佳实践。 * MoE 高性能训练优化 Tangram,长序列训练优化 ChunkFlow * 大规模强化学习训练框架 PAI-ChatLearn。支持 RLHF、DPO、GRPO 等多种先进的 Alignment 训练算法,支持 300B+300B 量级的 Policy 和 Reward 模型协同训练和任意模型的后训练任务快速配置 * 模型推理服务 PAI-EAS 提供分布式推理服务,通过创新的多机Prefill-Decode-EP分离架构,结合 LLM 智能路由和 MoE 分布式推理调度引擎 Llumnix,显著提升推理速度和资源利用率 * PAI-ModelGallery 支持300+模型的零代码一键后训练、评测、部署 |

| 数据预处理框架 | 数据预处理算子引擎 Data-Juicer | 提供 100 多个核心算子和 50 多个专用工具套件,支持在亿级别甚至千亿级别的样本量级下,实现高效的大规模数据的数据分析、清洗和合成。同时,提供快速入门指南和包含丰富使用示例的DJ-Cookbook,支持灵活实现自己的OP,自定义数据处理工作流。目前,PAI 已将其能力集成到 PAI 的数据处理产品中。 |

| 实时数据处理 | 实时计算 Flink 版 | 实时应用的作业开发、数据调试、运行与监控、自动调优、智能诊断等全生命周期能力,支持高吞吐量和低延迟的数据处理需求,确保数据流动的实时性和准确性 |

| 向量数据检索 | 检索分析服务 Elasticsearch 版 | 向量增强版可实现PB级文本与图片的向量数据检索,精准快速。 |

| 向量数据检索 | 智能开放搜索 OpenSearch | 内置各行业的查询语义理解、机器学习排序算法等能力,提供充分开放的引擎能力,快速搭建更高性能、更高搜索基线效果的智能搜索服务。 |

| 数据查询 | 实时数仓 Hologres | PB级超大规模的实时在线AP分析,数据写入即可查,资源隔离,十万级QPS点查能力。 |

大模型后训练方案的发布,标志着我们在构建高质量、可落地的大模型应用道路上迈出了坚实一步。未来,阿里云大数据AI平台将持续深耕大模型全生命周期的技术能力建设,不断优化数据处理、模型训练与推理效率,推动大模型在更多行业与场景中的深入应用,助力企业实现智能化升级与业务突破。