一、引言:传输层协议的核心定位

在Linux服务器编程体系中,TCP(传输控制协议)与UDP(用户数据报协议)是传输层的两大核心协议。二者均基于IP协议实现端到端通信,但设计理念存在本质差异:TCP以"可靠性"为核心目标,通过复杂机制保障数据完整有序;UDP以"高效性"为核心,舍弃冗余机制追求低延迟与高吞吐量。

本文将从连接特性、数据传输模式、可靠性机制、性能资源消耗四个维度,结合Linux环境下的编程实践(含完整代码示例),系统对比TCP与UDP的差异,并通过JavaScript绘制可视化图表直观呈现核心逻辑,同时给出协议选择的工程化建议。

二、核心差异深度解析(含实践代码)

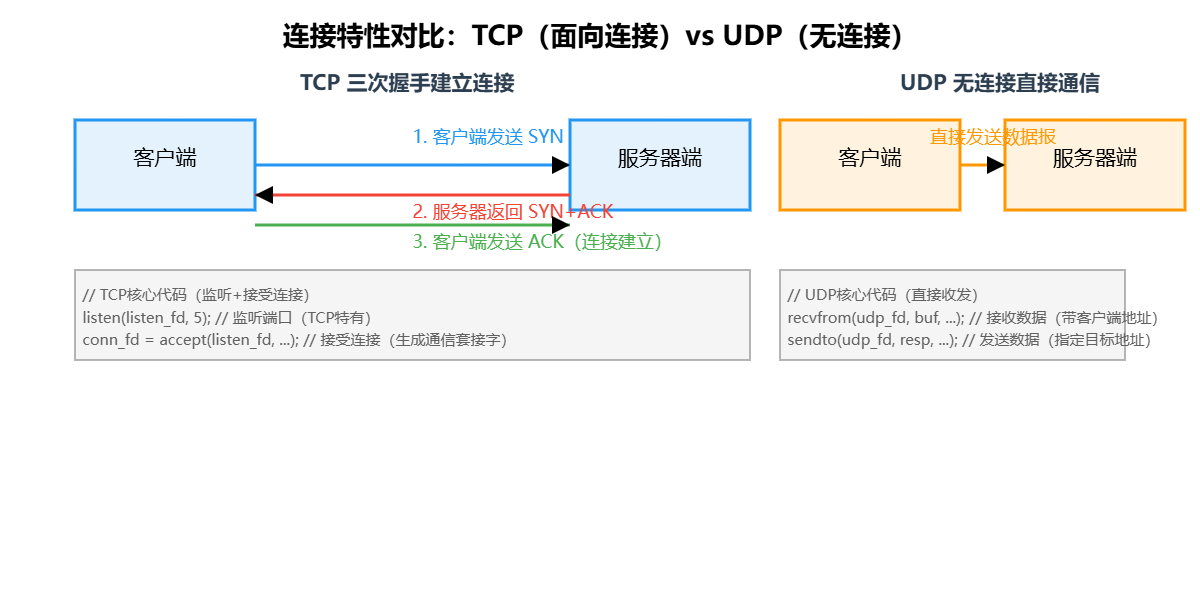

2.1 连接特性:面向连接(TCP)vs 无连接(UDP)

TCP是典型的"面向连接"协议,通信前必须通过"三次握手"建立逻辑连接,连接状态贯穿通信全程;UDP为"无连接"协议,无需预先建立连接,发送端可直接向目标地址发送数据报,接收端被动接收,无连接状态维护。

Linux编程实践:连接建立代码对比

1. TCP服务端(需监听与接受连接)

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <stdio.h>

#include <unistd.h>

#include <errno.h>

#define TCP_PORT 8080

int main() {

// 1. 创建TCP套接字(SOCK_STREAM表示字节流)

int listen_fd = socket(PF_INET, SOCK_STREAM, 0);

if (listen_fd == -1) {

perror("socket create failed");

return errno;

}

// 2. 设置端口复用(避免TIME_WAIT状态占用端口)

int reuse = 1;

if (setsockopt(listen_fd, SOL_SOCKET, SO_REUSEADDR, &reuse, sizeof(reuse)) == -1) {

perror("setsockopt SO_REUSEADDR failed");

close(listen_fd);

return errno;

}

// 3. 绑定IP与端口

struct sockaddr_in serv_addr = {0};

serv_addr.sin_family = AF_INET; // IPv4

serv_addr.sin_addr.s_addr = htonl(INADDR_ANY); // 监听所有网卡

serv_addr.sin_port = htons(TCP_PORT); // 端口转网络字节序

if (bind(listen_fd, (struct sockaddr*)&serv_addr, sizeof(serv_addr)) == -1) {

perror("bind failed");

close(listen_fd);

return errno;

}

// 4. 监听连接(TCP特有,5为半连接队列大小)

if (listen(listen_fd, 5) == -1) {

perror("listen failed");

close(listen_fd);

return errno;

}

printf("TCP server listening on port %d...\n", TCP_PORT);

// 5. 接受客户端连接(阻塞等待,返回新的通信套接字)

struct sockaddr_in client_addr;

socklen_t client_len = sizeof(client_addr);

int conn_fd = accept(listen_fd, (struct sockaddr*)&client_addr, &client_len);

if (conn_fd == -1) {

perror("accept failed");

close(listen_fd);

return errno;

}

// 打印客户端信息

printf("TCP client connected: %s:%d\n",

inet_ntoa(client_addr.sin_addr), ntohs(client_addr.sin_port));

// 关闭连接

close(conn_fd);

close(listen_fd);

return 0;

}2. UDP服务端(无需监听,直接收发)

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <stdio.h>

#include <unistd.h>

#include <string.h>

#include <errno.h>

#define UDP_PORT 8080

#define BUF_SIZE 1024

int main() {

// 1. 创建UDP套接字(SOCK_DGRAM表示数据报)

int udp_fd = socket(PF_INET, SOCK_DGRAM, 0);

if (udp_fd == -1) {

perror("socket create failed");

return errno;

}

// 2. 绑定IP与端口(服务端必须绑定,客户端可选)

struct sockaddr_in serv_addr = {0};

serv_addr.sin_family = AF_INET;

serv_addr.sin_addr.s_addr = htonl(INADDR_ANY);

serv_addr.sin_port = htons(UDP_PORT);

if (bind(udp_fd, (struct sockaddr*)&serv_addr, sizeof(serv_addr)) == -1) {

perror("bind failed");

close(udp_fd);

return errno;

}

printf("UDP server running on port %d...\n", UDP_PORT);

// 3. 接收客户端数据(无需建立连接,直接接收)

char recv_buf[BUF_SIZE] = {0};

struct sockaddr_in client_addr;

socklen_t client_len = sizeof(client_addr);

ssize_t recv_len = recvfrom(udp_fd, recv_buf, BUF_SIZE-1, 0,

(struct sockaddr*)&client_addr, &client_len);

if (recv_len == -1) {

perror("recvfrom failed");

close(udp_fd);

return errno;

}

// 打印客户端数据与信息

printf("UDP data from %s:%d (len=%ld): %s\n",

inet_ntoa(client_addr.sin_addr), ntohs(client_addr.sin_port),

recv_len, recv_buf);

// 4. (可选)回复客户端

const char* resp = "UDP server received your data";

sendto(udp_fd, resp, strlen(resp), 0,

(struct sockaddr*)&client_addr, client_len);

// 关闭套接字

close(udp_fd);

return 0;

}关键差异点: TCP需通过listen()监听端口、accept()获取连接,且通信依赖新生成的conn_fd;UDP仅需1个udp_fd即可完成所有收发,核心接口为recvfrom()(带客户端地址)与sendto()。

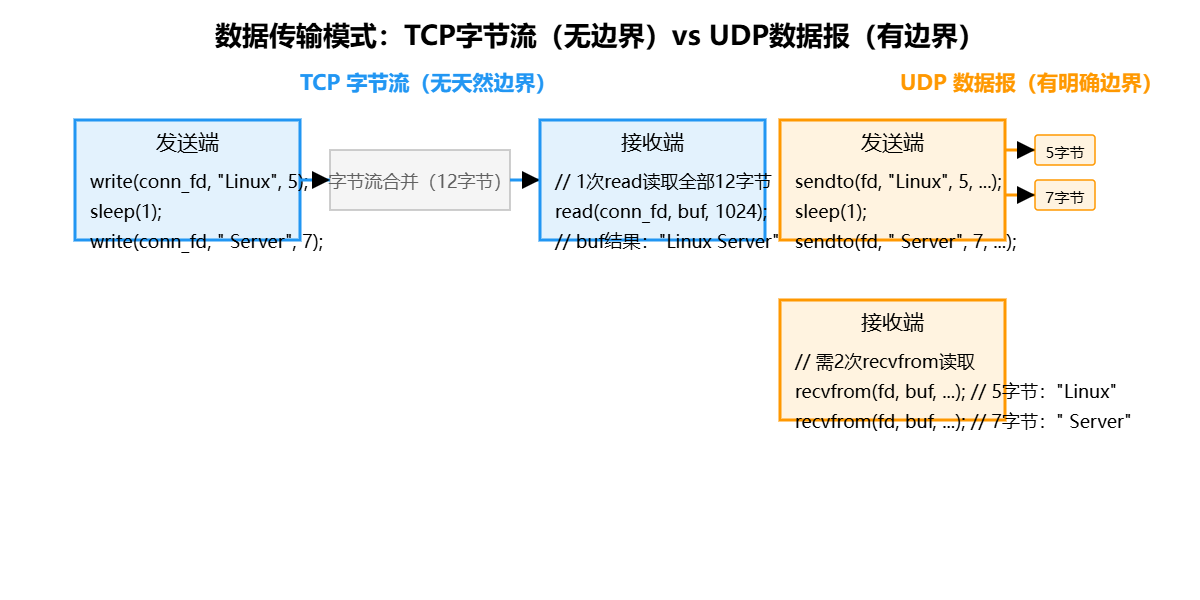

2.2 数据传输:字节流(TCP)vs 数据报(UDP)

TCP传输的是"字节流",数据无天然边界,发送端多次调用write()写入的数据,可能被TCP协议栈合并为一个报文段发送;接收端需通过应用层逻辑(如固定长度、分隔符、长度字段)界定数据边界。

UDP传输的是"数据报",每个数据报是独立的传输单元,发送端1次sendto()对应1个数据报,接收端1次recvfrom()必须读取完整数据报(若接收缓冲区不足,超出部分会被截断)。

实践验证:数据收发边界差异

// 1. TCP数据收发(字节流无边界)

// 客户端发送(2次write)

write(conn_fd, "Linux", 5); // 写入5字节

sleep(1);

write(conn_fd, " Server", 7); // 写入7字节

// 服务端接收(可能1次read到全部12字节)

char tcp_buf[1024];

ssize_t tcp_recv = read(conn_fd, tcp_buf, sizeof(tcp_buf));

// 结果:tcp_recv=12,tcp_buf内容为"Linux Server"

// 2. UDP数据收发(数据报有边界)

// 客户端发送(2次sendto)

sendto(udp_fd, "Linux", 5, 0, &serv_addr, sizeof(serv_addr));

sleep(1);

sendto(udp_fd, " Server", 7, 0, &serv_addr, sizeof(serv_addr));

// 服务端接收(需2次recvfrom,每次读取1个数据报)

char udp_buf[1024];

ssize_t udp_recv1 = recvfrom(udp_fd, udp_buf, sizeof(udp_buf), 0, &cli_addr, &cli_len);

// 结果:udp_recv1=5,udp_buf内容为"Linux"

ssize_t udp_recv2 = recvfrom(udp_fd, udp_buf, sizeof(udp_buf), 0, &cli_addr, &cli_len);

// 结果:udp_recv2=7,udp_buf内容为" Server"| 对比维度 | TCP(字节流) | UDP(数据报) |

|---|---|---|

| 数据边界 | 无,需应用层定义(如HTTP的Content-Length) | 有,1次发送对应1次接收 |

| 收发次数对应 | 发送次数 ≠ 接收次数(合并/拆分) | 发送次数 = 接收次数(一一对应) |

| 数据截断 | 不会截断,未读数据留存内核缓冲区 | 接收缓冲区不足时,超出部分丢弃 |

| 典型应用 | 文件传输(FTP)、网页(HTTP) | DNS查询、视频直播(RTP) |

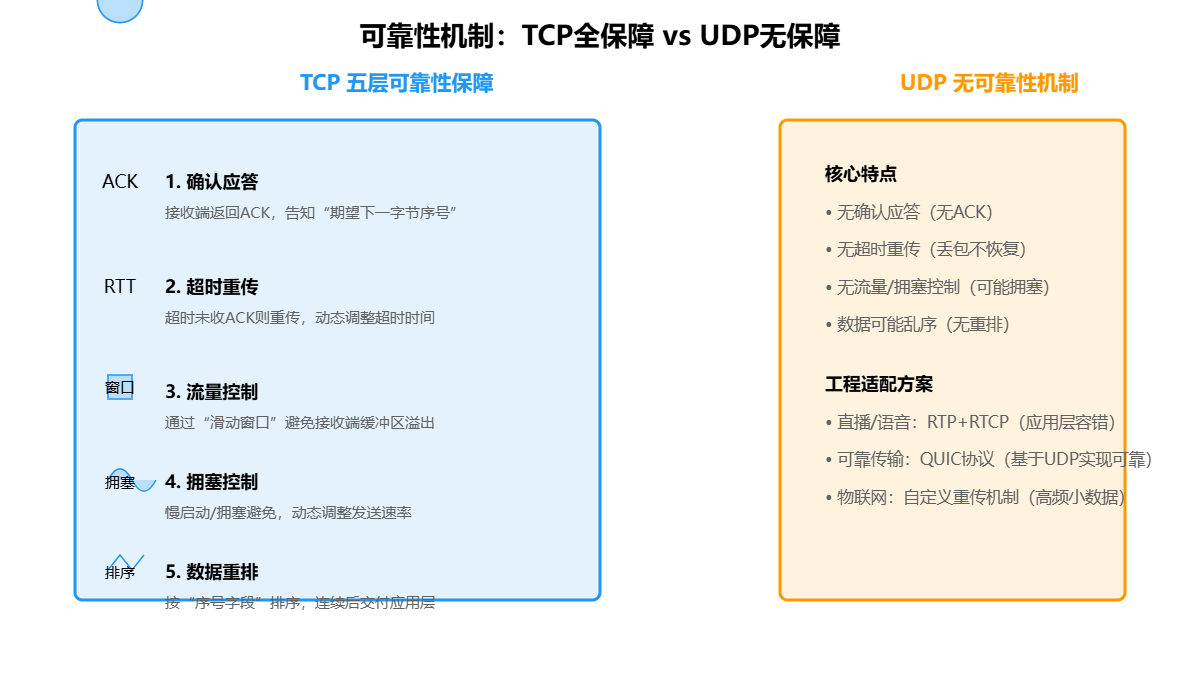

2.3 可靠性机制:TCP全保障 vs UDP无保障

TCP通过多层机制实现"可靠传输",核心包括:确认应答(ACK)、超时重传、拥塞控制、流量控制、数据重排;UDP无任何可靠性保障,数据可能丢失、乱序、重复,仅依赖IP层的校验和(可选)检测数据错误。

TCP核心可靠性机制解析

- 确认应答(ACK):接收端收到数据后,向发送端返回ACK报文,携带"期望接收的下一字节序号"(如接收1-100字节,ACK=101),发送端通过ACK确认数据已送达。

- 超时重传:发送端发送数据后启动定时器,若超时未收到对应ACK,自动重传数据;超时时间会根据网络RTT(往返时间)动态调整。

- 流量控制:基于"滑动窗口"机制,接收端通过TCP头部的"窗口大小"字段,告知发送端当前可接收的最大字节数,避免接收端缓冲区溢出。

- 拥塞控制:通过"慢启动""拥塞避免""快速重传""快速恢复"四个阶段,根据网络拥塞程度动态调整发送速率,避免网络崩溃。

- 数据重排:TCP报文段可能因路由差异乱序到达,接收端通过"序号字段"对数据排序,待数据连续后再交付应用层。

UDP的"不可靠"与工程适配:UDP虽无可靠性保障,但可通过应用层协议补充(如RTP+RTCP用于直播,QUIC协议基于UDP实现可靠传输),兼顾低延迟与可靠性。

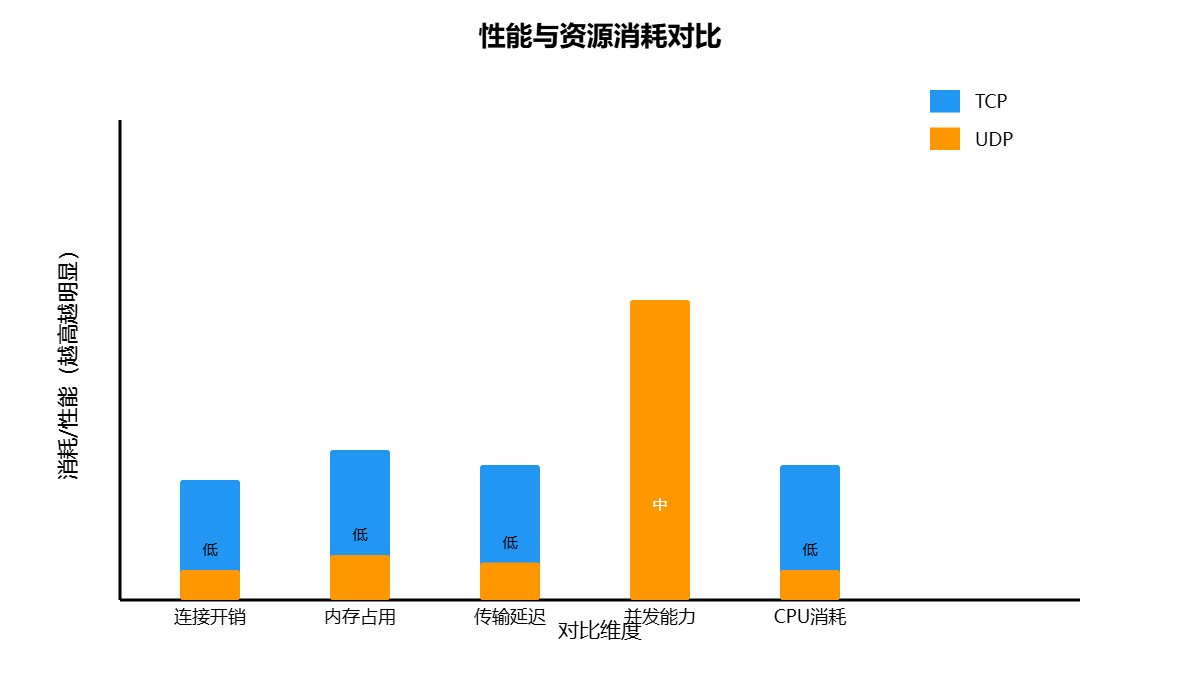

2.4 性能与资源:TCP重量级 vs UDP轻量级

TCP因连接管理、可靠性机制,资源消耗显著高于UDP;UDP无连接状态、无冗余计算,资源占用低,适合高并发、低延迟场景。二者在连接开销、内存占用、延迟、并发能力上差异明显。

| 性能维度 | TCP | UDP |

|---|---|---|

| 连接开销 | 三次握手建立连接(约1-3ms),四次挥手关闭连接,开销高 | 无连接建立/关闭开销,直接收发 |

| 内存占用 | 内核需维护TCP连接状态(如ESTABLISHED、TIME_WAIT)、滑动窗口、重传队列,单连接内存消耗约4KB | 仅维护套接字文件描述符,无额外状态,单套接字内存消耗约几百字节 |

| 传输延迟 | ACK等待、重传、拥塞控制导致延迟高(通常10-100ms) | 无额外延迟,仅受网络RTT影响(通常1-10ms) |

| 并发能力 | 受限于文件描述符数量、内存,单机并发约10万级(需优化) | 轻量级,单机并发可达百万级(如DNS服务器) |

| CPU消耗 | 可靠性机制(如拥塞控制计算)消耗CPU,负载高时占比显著 | 无冗余计算,CPU消耗极低 |

Linux性能优化实践:TCP并发优化

针对TCP高并发场景,可通过以下配置提升性能(修改/etc/sysctl.conf):

// 1. 增加文件描述符上限

fs.file-max = 1000000

fs.nr_open = 1000000

// 2. 调整TCP连接参数

net.ipv4.tcp_max_syn_backlog = 65535 // 半连接队列大小

net.ipv4.tcp_syn_retries = 3 // SYN重试次数

net.ipv4.tcp_fin_timeout = 30 // TIME_WAIT状态超时(默认60s)

net.ipv4.tcp_tw_reuse = 1 // 允许TIME_WAIT端口复用

net.ipv4.tcp_tw_recycle = 0 // 禁用TIME_WAIT快速回收(避免网络异常)

net.core.somaxconn = 65535 // 全连接队列大小

// 3. 应用生效

sysctl -p三、协议选择的工程化建议

TCP与UDP无绝对优劣,需结合业务场景的核心需求(可靠性、实时性、并发量)选择,以下为典型场景的协议适配方案:

3.1 优先选择TCP的场景

- 数据完整性优先:如数据库连接(MySQL、PostgreSQL)、支付交易(需确保请求不丢失)、文件传输(FTP、SFTP)------ 数据丢失可能导致业务异常。

- 有序传输需求:如视频点播(VOD)、API接口(REST/GRPC)------ 数据乱序会导致播放卡顿或接口解析失败。

- 长连接交互:如即时通讯(IM)的文字聊天、设备远程控制------ 长连接下TCP的连接维护成本低于UDP的频繁地址指定。

3.2 优先选择UDP的场景

- 实时性优先:如视频直播、语音通话(VoIP)、游戏同步------ 允许少量丢包(可通过应用层容错),但延迟需控制在100ms以内。

- 高频小数据传输:如DNS查询(单请求/响应约50字节)、NTP时间同步(单包约48字节)、物联网设备心跳(10-100字节/次)------ UDP的低开销优势显著。

- 广播/多播需求:如局域网设备发现(如打印机搜索)、多媒体组播(如IPTV)------ TCP仅支持点对点,UDP支持广播(255.255.255.255)与多播。

3.3 混合使用场景(TCP+UDP)

部分复杂业务会结合二者优势,典型案例如下:

- 直播平台:UDP传输实时视频流(低延迟),TCP传输用户评论、点赞、礼物等交互数据(可靠性)。

- 在线游戏:UDP传输玩家位置、动作等实时数据(10-50ms延迟),TCP传输账号登录、道具购买等关键数据(防丢失)。

- 物联网平台:UDP传输设备实时采集的传感器数据(高频小数据),TCP传输设备配置更新、固件升级(大数据量+可靠性)。

四、总结:核心差异速查表

| 对比维度 | TCP | UDP |

|---|---|---|

| 连接模式 | 面向连接(三次握手) | 无连接 |

| 数据形态 | 字节流(无边界) | 数据报(有边界) |

| 可靠性 | 可靠(ACK、重传、拥塞控制) | 不可靠(无重传、无确认) |

| 传输延迟 | 高(毫秒级到百毫秒级) | 低(毫秒级) |

| 资源消耗 | 高(连接状态、缓冲区、CPU) | 低(无状态、低CPU) |

| 并发能力 | 中(万级) | 高(百万级) |

| 核心接口(Linux) | socket、bind、listen、accept、read/write | socket、bind、recvfrom、sendto |

| 典型应用 | HTTP/HTTPS、MySQL、FTP、IM文字聊天 | DNS、RTP(直播)、QUIC、物联网心跳 |

在Linux服务器编程中,协议选择的本质是"业务需求与技术特性的匹配"。理解TCP与UDP的核心差异后,需结合具体场景的 latency、throughput、reliability 需求,选择最适合的传输层方案,必要时通过应用层协议补充(如UDP+可靠性机制),实现业务目标与技术性能的平衡。