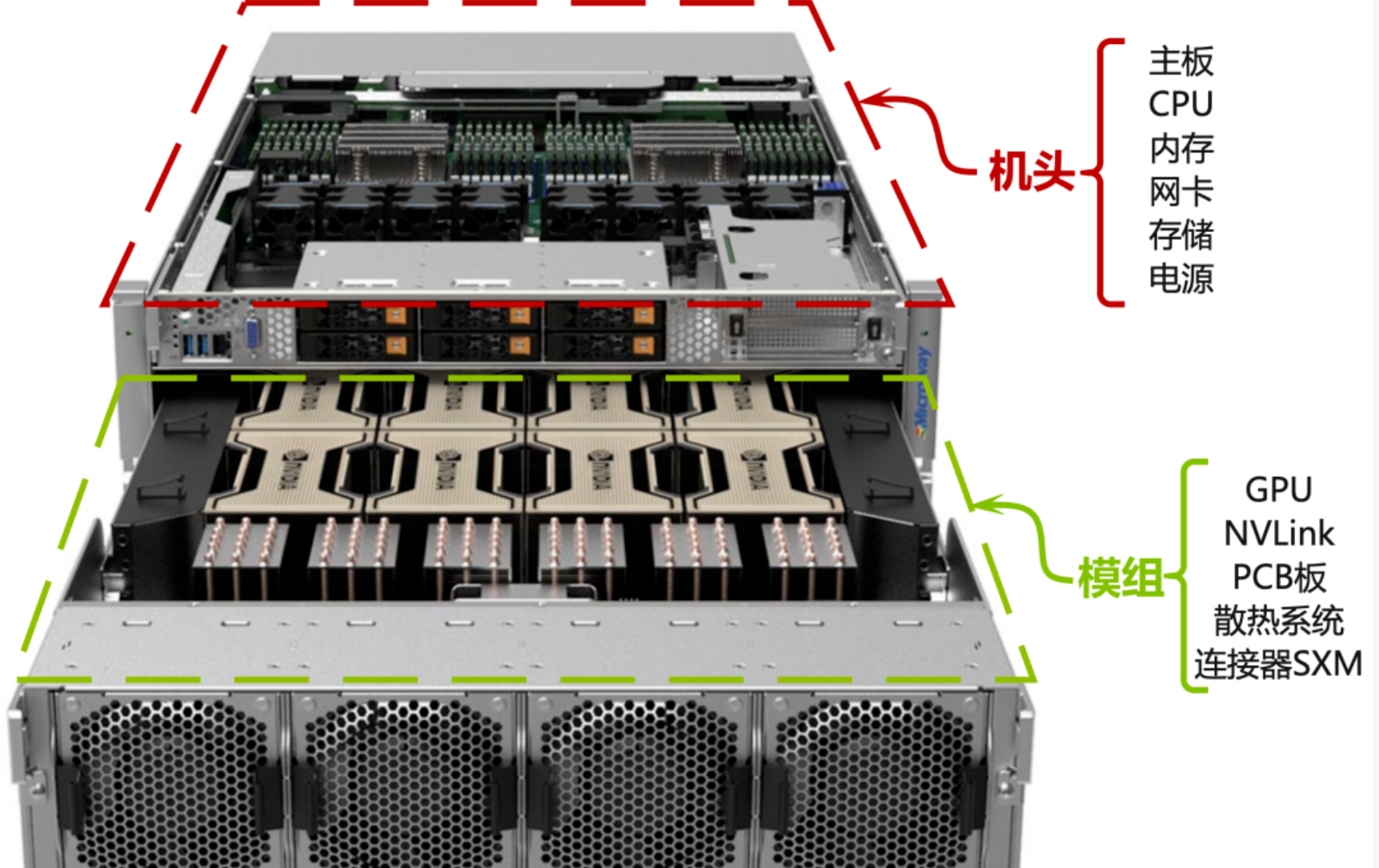

在高端AI服务器的世界里,NVIDIA的DGX系列服务器(如A100、H100、H200)采用了一种高度集成的模块化架构。理解这种架构对于AI基础设施的规划、运维和优化至关重要。本文将深入解析"机头"和"模组"这两个核心概念,以及完整GPU服务器的各个组成部分。

一、机头:GPU服务器的"大脑与中枢神经系统"

1. 机头是什么?

核心定义:机头是服务器中不包含GPU的核心计算和系统控制部分。可以将其想象成一台"没有GPU的超级主板",它负责整个系统的调度、管理、网络和基础计算任务。

设计理念:通过将计算控制与GPU计算分离,实现更好的热管理、电源分配和维护性。

2. 机头的详细构成

2.1. GPU服务器机头子系统技术规格详表

| 子系统 | 技术规格 | 具体配置与特性 | 性能指标 |

|---|---|---|---|

| CPU子系统 | 处理器配置 | • 通常配备2颗高性能服务器级CPU • Intel Xeon Scalable系列(如Platinum 8480+) • AMD EPYC系列(如EPYC 9754) | • 单CPU可达64核甚至更多 • 提供充足的PCIe通道和内存带宽 |

| 主板与芯片组 | 定制化设计 | • 专门为高密度GPU计算优化 • 复杂的PCIe switch网络 • 集成BMC、硬件监控、固件管理等 | • 确保所有GPU都能获得充足带宽 • 优化的信号完整性和电源分配 |

| 内存系统 | 容量配置 | • 通常1-2TB DDR5内存 • 8通道或12通道内存架构 • 错误校正码(ECC)支持 • 内存镜像和热备选项 | • 带宽可达800GB/s以上 • 低延迟访问 • 高可靠性运行 |

| 网络接口 | 高速互联 | • 多个100Gb/200Gb/400Gb端口 • InfiniBand HDR/NDR(NVIDIA ConnectX-7) • RoCEv2以太网 • 支持GPUDirect RDMA | • Fat-Tree、DragonFly+等高级网络拓扑支持 • 超低延迟数据传输 • 高吞吐量通信 |

| 系统管理 | 基板管理控制器(BMC) | • 远程开关机和控制 • 硬件状态监控(温度、电压、功耗) • 固件更新和系统日志 • 管理接口:Redfish API、IPMI • 安全特性:安全启动、硬件信任根 | • 实时系统健康监控 • 远程诊断和维护 • 安全保障机制 |

| 存储控制器 | 本地存储 | • 多个NVMe U.2或M.2接口 • 硬件RAID控制器,支持0/1/10等级别 • 通过PCIe连接JBOD或存储阵列 | • 高速数据读写能力 • 数据冗余保护 • 灵活的存储扩展 |

| 电源分配 | 电源管理 | • 高压直流或交流输入 • 高效的VRM(电压调节模块) • 实时功率测量和限制 | • 高能效转换 • 精确的功率控制 • 稳定的电力供应 |

2.2. 性能与规格总结

| 参数类别 | 规格范围 | 典型配置 | 备注 |

|---|---|---|---|

| 计算性能 | 128核心以上 | 2×64核心 | 支持超线程技术 |

| 内存容量 | 512GB-2TB | 1TB DDR5 | 可扩展至4TB+ |

| 内存带宽 | 600-1000GB/s | 800GB/s | 依赖内存配置 |

| 网络带宽 | 800Gb/s-3.2Tb/s | 1.6Tb/s | 多端口聚合 |

| 存储带宽 | 20-50GB/s | 35GB/s | NVMe RAID配置 |

| 电源效率 | 94-96% | 95% | 钛金级效率 |

| 管理接口 | Redfish/IPMI | 双管理接口 | API驱动自动化 |

二、模组:GPU计算的"动力引擎"

1. 模组是什么?

核心定义:模组是专门承载GPU和其高速互联组件的可插拔单元。一个机头可以连接多个模组,这种设计使得GPU密度最大化,并便于维护和升级。

设计优势:

-

热设计功率(TDP)集中管理

-

缩短信号路径,提高性能

-

模块化维护,降低MTTR

1.1 GPU服务器模组子系统技术规格详表

| 子系统 | 技术规格 | 具体配置与特性 | 性能指标 |

|---|---|---|---|

| GPU阵列 | GPU配置 | • 通常4块或8块高性能GPU • NVIDIA H100:单卡功耗700W • NVIDIA H200:支持更大显存容量 • 接口形式:SXM5封装 | • 单模组AI算力可达数十PetaFLOPS • 提供更高功率和信号完整性 |

| NVLink互联网络 | 交换芯片 | • 专用NVSwitch芯片 • 第四代NVLink:单链路100GB/s • 全互联拓扑:每个GPU与其他所有GPU直连 | • 相比PCIe,带宽提升5-10倍 • 极低延迟通信 • 无缝GPU间数据交换 |

| PCB设计 | 基板材料 | • 高速高频板材,确保信号完整性 • 层数设计:20层以上复杂堆叠 • 电源层:多层专门供电层 | • 应对瞬时电流需求 • 优化的阻抗控制 • 降低信号衰减 |

| 散热系统 | 风冷设计 | • 大功率离心风扇 • 定向风道设计 • 温度反馈控制 | • 高效热量排出 • 精确温度管理 • 自适应冷却策略 |

| 液冷设计 | • 冷板直接接触GPU • 快速接头,支持热维护 • 泄漏检测和保护 | • 更高的散热效率 • 在线维护能力 • 系统安全保护 | |

| 电源管理 | VRM设计 | • 多相供电,每GPU独立控制 • 实时功率测量 • 支持动态功率限制 | • 精确的功率分配 • 实时的能耗监控 • 灵活的功率管理策略 |

| 连接器系统 | 高速连接 | • 专用背板连接器 • 数据传输:PCIe Gen5/CXL • 电源供应:最高可达1000W/GPU • 管理信号:I2C、GPIO等 • 机械锁定设计 | • 高可靠性连接 • 高速数据传输 • 安全的电源供应 • 稳定的机械固定 |

1.2. 性能与规格总结

| 参数类别 | 规格范围 | 典型配置 | 技术优势 |

|---|---|---|---|

| GPU数量 | 4-8个 | 8个H100/H200 | 高计算密度 |

| 互联带宽 | 3.2-6.4TB/s | 4.8TB/s全互联 | 超越PCIe 5.0 |

| PCB层数 | 20-30层 | 24层HDI | 信号完整性优化 |

| 散热能力 | 3000-6000W | 5600W(8×700W) | 高效热管理 |

| 供电能力 | 4000-8000W | 7200W峰值 | 稳定电力供应 |

| 连接可靠性 | 1000+插拔 | 强化锁定机制 | 高可用性设计 |

| 算力性能 | 10-40 PetaFLOPS | 32 PetaFLOPS(FP8) | AI计算优化 |

三、机头与模组的协同关系

1. 系统架构比喻

工厂模型:

整个GPU服务器 → 大型智能工厂

机头 → 中央控制中心和物流枢纽

├── CPU → 总经理和部门经理

├── 系统内存 → 文件档案室

└── 网络接口 → 对外电话和网络

模组 → 自动化生产车间

├── GPU → 生产线上的工业机器人

└── NVLink → 车间内的高速传送带2. 数据流协同

训练工作负载流程:

-

任务分配:机头CPU接收训练任务,进行数据预处理

-

数据加载:从存储系统读取训练数据到系统内存

-

数据传输:通过高速网络接收其他节点的模型参数

-

计算分发:将数据和计算任务分发到各个模组

-

并行计算:模组内GPU通过NVLink协同计算

-

结果汇总:机头收集计算结果,更新模型

3. 资源管理协同

统一的资源管理:

-

功耗管理:机头BMC监控整机功耗,动态调整各模组功率

-

热管理:协调机箱风扇和模组风扇,优化散热效率

-

故障处理:模组故障时自动隔离,机头重新分配计算任务

四、完整GPU服务器的系统组成

1. 机箱与背板系统

1.1. GPU服务器机箱与背板系统技术规格详表

| 子系统 | 技术规格 | 具体配置与特性 | 设计优势 |

|---|---|---|---|

| 机械结构设计 | 机箱材质 | • 高强度钢材 • 电磁屏蔽设计 • 防腐蚀表面处理 | • 优异的结构强度 • EMI/EMC合规性 • 长期可靠性保障 |

| 尺寸标准 | • 符合EIA-310-D机架标准 • 宽度:19英寸(482.6mm) • 高度:多U设计(通常8U-10U) • 深度:1000-1200mm | • 标准化机架安装 • 优化的空间利用率 • 良好的可维护性 | |

| 背板技术 | 电源背板 | • 高电流承载能力(可达200A) • 冗余电源输入 • 热插拔支持 • 电源状态监控 | • 支持高功率GPU运行 • 电源冗余保障系统可用性 • 在线维护能力 |

| 信号背板 | • 高速差分信号对 • 阻抗控制(通常85Ω或100Ω) • 串扰抑制设计 • 信号完整性优化 | • 保证高速数据传输质量 • 减少信号反射和衰减 • 降低误码率 | |

| 风道设计 | 基础风道 | • 前进后出:标准服务器风道 • 分区散热:机头、模组、电源独立风道 • 风压优化设计 | • 高效的热量排出 • 避免热区混合 • 优化的气流效率 |

| 风扇系统 | • 根据散热器阻力特性设计风扇曲线 • N+1风扇冗余设计 • 智能温控调速 | • 自适应冷却能力 • 高可用性设计 • 能效优化 |

1.2. 性能与规格总结

| 参数类别 | 技术规格 | 性能指标 | 行业标准 |

|---|---|---|---|

| 结构强度 | 高强度钢框架 | 承重≥150kg | EIA-310-D |

| 电磁兼容 | 全屏蔽设计 | 符合FCC Class A | EN 55032 |

| 电源背板 | 200A载流 | 支持10kW+系统 | UL/CE认证 |

| 信号完整性 | 阻抗控制±10% | 数据速率32GT/s | PCIe 6.0 |

| 散热能力 | 分区风道 | 散热3000-6000W | ASHRAE A4 |

| 可用性 | 热插拔设计 | 99.999%可用性 | Tier IV |

2. 先进的散热系统

风冷系统深化

风扇子系统:

├── 风扇类型:轴流风扇 vs 离心风扇

├── 控制策略:PWM智能调速

├── 冗余设计:N+1风扇冗余

└── 热插拔:在线更换不影响运行液冷系统详解

-

冷板式液冷:

-

材料:铜冷板+铝鳍片

-

流量:5-15 L/min

-

压降:<2 bar

-

-

浸没式液冷:

-

冷却液:氟化液或矿物油

-

沸点:45-60°C(相变冷却)

-

维护性:在线维护设计

-

散热性能指标

-

PUE优化:从1.6(传统风冷)降至1.1(先进液冷)

-

散热密度:每U可散热1000W以上

-

噪音控制:从70dBA(风冷)降至45dBA(液冷)

3. 高可靠供电系统

电源模块规格

-

功率等级:12kW-15kW冗余配置

-

效率认证:80Plus钛金(>94%效率)

-

输入电压:200-240V AC或380V DC

电源架构

供电拓扑:

市电输入 → PDU → 服务器电源 → 背板 → 模组VRM → GPU核心

↑ ↑ ↑ ↑ ↑

冗余输入 电路保护 N+M冗余 电源监控 多相供电电源管理特性

-

峰值功率:支持200%瞬时过载

-

功率封顶:可在80%额定功率下稳定运行

-

功耗监控:实时测量,历史数据分析

4. 高性能存储系统

存储配置方案

-

启动盘:2×1.92TB NVMe SSD(RAID1)

-

数据盘:8×7.68TB NVMe SSD(RAID0)

-

缓存盘:Optane持久内存(可选)

存储性能指标

-

读取带宽:>50GB/s(顺序读取)

-

IOPS性能:>300万(4K随机读取)

-

延迟特性:<100μs(读写延迟)

数据保护

-

硬件RAID:支持各级别RAID

-

数据加密:AES-256自加密驱动器

-

快照保护:支持瞬时快照

5. 高速网络子系统

网络适配器配置

-

网卡类型:NVIDIA ConnectX-7 DPU

-

端口配置:8×200Gb/s InfiniBand

-

高级特性:

-

GPUDirect RDMA

-

NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)

-

自适应路由

-

网络拓扑支持

-

单机配置:Tor交换机连接

-

集群配置:Spine-Leaf架构

-

超算配置:DragonFly+拓扑

6. 机架集成解决方案

机架导轨系统

-

快速安装:工具-less安装设计

-

承重能力:支持>150kg设备重量

-

维护扩展:完全拉出维护位置

线缆管理

-

电源线缆:

-

C19/C20连接器

-

线径:12AWG(大电流承载)

-

-

数据线缆:

-

DAC(直连铜缆):7m以内

-

AOC(有源光缆):100m以内

-

光纤:长距离连接

-

理线系统

-

垂直理线器:机架两侧线缆管理

-

水平理线器:机架内部线缆整理

-

标签系统:标准化颜色和文字标签

五、实际部署考量

1. 基础设施要求

电力需求

-

典型功耗:10-15kW/台(满载)

-

电路要求:3相208V或单相240V

-

UPS配置:N+1冗余,15分钟备电

冷却需求

-

风冷环境:

-

送风温度:18-27°C

-

湿度范围:20%-80%

-

-

液冷环境:

-

冷却水温度:15-45°C

-

水质要求:去离子水

-

空间规划

-

机柜选择:48U标准机柜,承重>1000kg

-

布局考虑:冷热通道隔离

-

维护空间:前后各保留1.2米维护通道

2. 运维管理建议

监控体系

-

硬件监控:温度、功耗、风扇转速

-

性能监控:GPU利用率、网络带宽、存储IO

-

预警阈值:多级预警,自动通知

维护计划

-

日常检查:日志检查、性能基线对比

-

定期维护:季度深度清洁、年度全面检测

-

应急预案:故障切换、数据备份恢复

结语

H100/H200 GPU服务器的"机头+模组"架构代表了当前AI计算基础设施的最高水平。这种设计不仅提供了极致的计算性能,更重要的是通过模块化设计实现了可维护性、可扩展性和可靠性的最佳平衡。

理解这种架构的各个组成部分及其相互关系,对于AI基础设施的规划、部署和优化都具有重要意义。随着AI模型的不断增大和计算需求的持续增长,这种高度集成的架构将继续演进,为下一代AI应用提供更强有力的算力支撑。