马尔可夫决策过程(MDP)详解

马尔可夫决策过程 (Markov Decision Process, 简称 MDP)是强化学习的数学基础与核心框架。

它用来刻画"智能体(agent)在与环境交互过程中如何决策"的完整数学模型。

1. MDP 的形式化定义

一个 MDP 可以表示为一个五元组:

(S,A,P,R,γ) (\mathcal{S}, \mathcal{A}, P, R, \gamma) (S,A,P,R,γ)

其中:

- S\mathcal{S}S:状态空间(State space)

- A\mathcal{A}A:动作空间(Action space)

- P(s′∣s,a)P(s'|s,a)P(s′∣s,a):状态转移概率(Transition probability)

- R(s,a)R(s,a)R(s,a):奖励函数(Reward function)

- γ∈[0,1]\gamma \in [0,1]γ∈[0,1]:折扣因子(Discount factor)

2. 轨迹与概率

当智能体遵循策略 π\piπ 行动时,会产生一条轨迹(或称"一个 episode"):

τ=(s1,a1,r1,s2,a2,r2,...,sT) \tau = (s_1, a_1, r_1, s_2, a_2, r_2, \dots, s_T) τ=(s1,a1,r1,s2,a2,r2,...,sT)

这条轨迹在策略 π\piπ 下的概率为:

P(τ∣π)=p(s1)∏t=1Tπ(at∣st)P(st+1∣st,at) P(\tau|\pi) = p(s_1) \prod_{t=1}^T \pi(a_t|s_t) P(s_{t+1}|s_t,a_t) P(τ∣π)=p(s1)t=1∏Tπ(at∣st)P(st+1∣st,at)

- p(s1)p(s_1)p(s1):初始状态分布

- π(at∣st)\pi(a_t|s_t)π(at∣st):策略产生动作的概率

- P(st+1∣st,at)P(s_{t+1}|s_t,a_t)P(st+1∣st,at):状态转移概率

3. MDP 的组成部分

✅ 状态(State)

状态表示环境在某一时刻的完整信息。

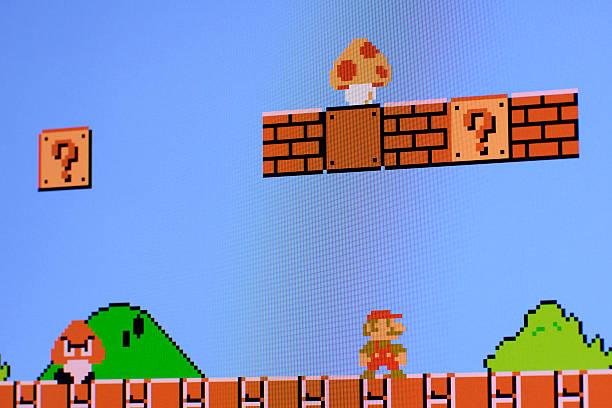

例如在马里奥游戏中,一帧或几帧游戏画面就可以构成状态。

有时我们只能观察到部分状态(partial observation)。

✅ 动作(Action)

动作定义了智能体如何与环境交互。

例如在马里奥中,动作可以是「上、下、左、右」。

所有动作的集合构成动作空间。

✅ 奖励(Reward)

奖励是智能体从环境中获得的反馈信号, 马里奥里面吃金币, 打怪, 最终胜利都是奖励。

合理设计奖励函数是强化学习的关键,它会直接影响学习结果。

✅ 状态转移(State Transition)

状态转移描述了在采取动作 aaa 后,环境从状态 sss 转移到 s′s's′ 的过程:

P(s′∣s,a) P(s'|s,a) P(s′∣s,a)

这种转移可以是随机的(如随机环境),也可以是确定的(如棋类游戏)。

4. 策略(Policy)

策略 π\piπ 定义了智能体在状态下的行动方式,是状态到动作的映射。

强化学习的目标就是找到一个最优策略 π∗\pi^*π∗,以最大化长期期望回报。

-

确定性策略(Deterministic) :

a=π(s) a = \pi(s) a=π(s) -

随机策略(Stochastic) :

π(a∣s)=P(at=a∣st=s) \pi(a|s) = P(a_t = a | s_t = s) π(a∣s)=P(at=a∣st=s)

5. 随机性(Stochasticity)

强化学习中最大的挑战之一就是环境与策略的随机性。

- 环境转移可能是随机的;

- 策略选择动作可能是随机的;

- 奖励也可能带有噪声。

这会导致训练过程难以完全可控,也增加了策略收敛的难度。

6. 回报与折扣回报(Return & Discounted Return)

回报(Return) 表示从某个时间步 ttt 开始后续累计获得的奖励:

Gt=rt+1+rt+2+⋯=∑k=0∞rt+k+1 G_t = r_{t+1} + r_{t+2} + \cdots = \sum_{k=0}^{\infty} r_{t+k+1} Gt=rt+1+rt+2+⋯=k=0∑∞rt+k+1

为了强调短期奖励并保证收敛,我们引入 折扣因子 γ\gammaγ :

Gt=∑k=0∞γkrt+k+1 G_t = \sum_{k=0}^{\infty} \gamma^k r_{t+k+1} Gt=k=0∑∞γkrt+k+1

其中 0≤γ<10 \leq \gamma < 10≤γ<1。

7. 价值函数(Value Function)

价值函数衡量一个状态(或状态-动作对)在长期回报上的"好坏"。

- 状态价值函数(State Value Function):

Vπ(s)=Eπ[Gt∣St=s] V_\pi(s) = \mathbb{E}_\pi [ G_t \mid S_t = s ] Vπ(s)=Eπ[Gt∣St=s]

- 动作价值函数(Action Value Function, Q 函数):

Qπ(s,a)=Eπ[Gt∣St=s,At=a] Q_\pi(s,a) = \mathbb{E}_\pi [ G_t \mid S_t = s, A_t = a ] Qπ(s,a)=Eπ[Gt∣St=s,At=a]

- 最优价值函数(Optimal Value Functions):

V∗(s)=maxπVπ(s),Q∗(s,a)=maxπQπ(s,a) V^*(s) = \max_\pi V_\pi(s), \quad Q^*(s,a) = \max_\pi Q_\pi(s,a) V∗(s)=πmaxVπ(s),Q∗(s,a)=πmaxQπ(s,a)

学习准确的价值函数有助于智能体判断哪种状态或动作更优,从而指导策略改进。

8. 强化学习的目标

强化学习的最终目标就是找到一个最优策略 π∗\pi^*π∗,使得期望折扣回报最大化:

π∗=argmaxπEτ∼P(τ∣π)[∑t=1Tγt−1rt] \pi^* = \arg\max_\pi \mathbb{E}{\tau \sim P(\tau|\pi)} \left[ \sum{t=1}^{T} \gamma^{t-1} r_t \right] π∗=argπmaxEτ∼P(τ∣π)[t=1∑Tγt−1rt]

这也是大多数强化学习算法(如 Q-learning、Policy Gradient、Actor-Critic 等)的核心优化目标。

✅ 总结

- MDP 是强化学习的数学框架。

- 它通过 状态 、动作 、奖励 、转移 、策略 来描述整个交互过程。

- 回报与价值函数是评价策略好坏的核心工具。

- 强化学习的本质就是通过优化策略 π\piπ 来最大化期望折扣回报 J(π)J(\pi)J(π)。