9月26日,云栖大会AI搜索与向量引擎分论坛上,阿里云智能集团技术专家魏子珺 和爱橙科技技术专家**周文喆,**详细阐释了 "AI 原生搜索引擎:Elasticsearch 换芯" 技术主题,重点围绕 AI 原生搜索内核增强技术的升级与替换。通过核心能力重构,让 Elasticsearch 在 AI 原生时代具备更强的多模态理解、自然语言处理以及深度任务执行能力,为搜索场景带来性能、智能化与可扩展性的大幅提升。这标志着 AI 搜索技术从传统架构迈向面向大模型与智能代理的新阶段,为企业和开发者提供更高效、精准、智能的检索体验奠定基础。

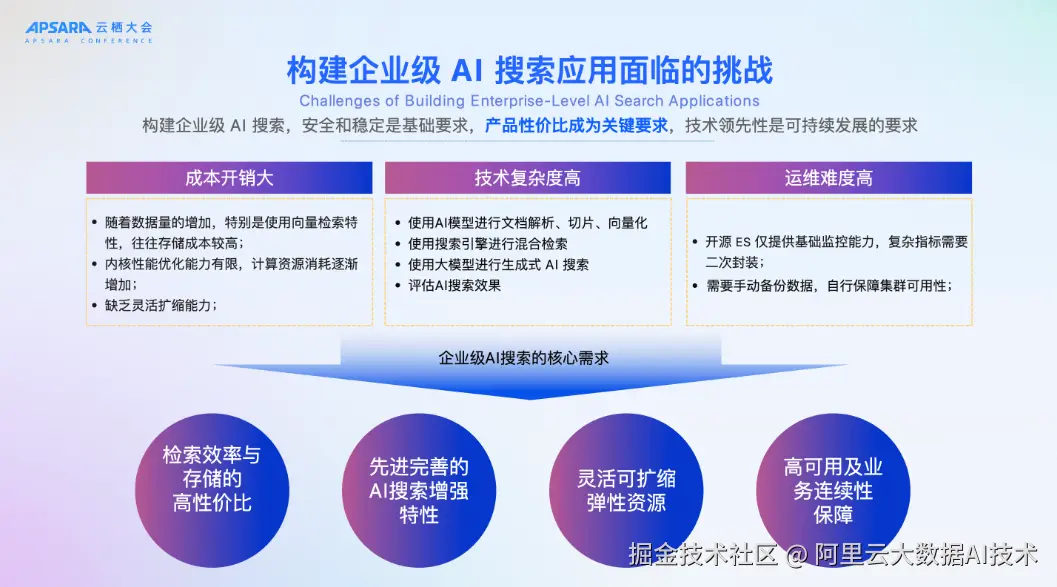

一、构建企业级 AI 搜索的挑战与核心需求

在企业级 AI 搜索的落地过程中,安全性与稳定性是基础要求,产品性价比是关键考量,而技术的领先性更是可持续发展的必要条件。但在实践中,企业往往会面临三类核心挑战:

成本开销大

- 数据量持续增长,尤其在向量检索场景下,存储成本居高不下;

- 内核优化能力受限,计算资源消耗不断攀升;

- 缺乏灵活的资源弹性扩缩容机制。

技术复杂度高

- 需要 AI 模型完成文档解析、语义切分与向量化处理;

- 搜索引擎必须支持多模态与混合检索;

- 在生成式 AI 搜索中,还需评估搜索结果的质量与相关性。

运维难度大

- 开源 Elasticsearch 仅提供基础监控能力,复杂指标需二次开发封装;

- 数据备份与集群高可用性保障依赖人工维护,运维压力高。

基于这些痛点,企业级 AI 搜索普遍有四项核心需求:

- 在检索效率与存储成本之间实现高性价比平衡;

- 拥有先进且完善的 AI 搜索增强能力;

- 具备灵活可扩缩的弹性资源管理机制;

- 确保系统高可用性与业务连续性。

这些挑战与需求正是驱动阿里云 Elasticsearch 换"芯"升级 的根本原因,也为后续架构优化与功能增强明确了发展方向------让搜索引擎从简单的信息检索工具,进化为适配复杂业务场景的主动智能解决方案。

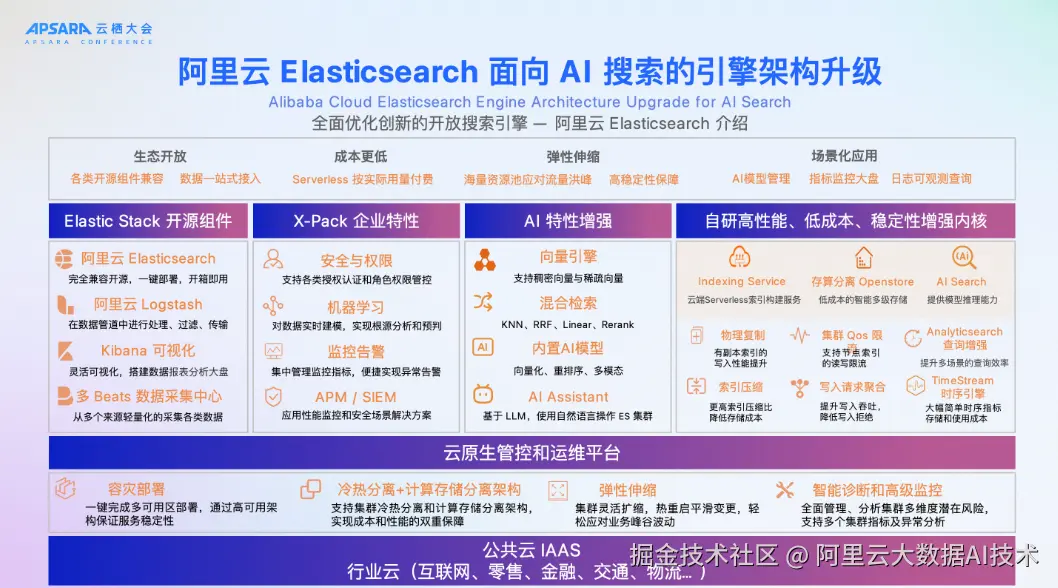

二、阿里云 Elasticsearch 面向 AI 搜索的引擎架构升级

阿里云 Elasticsearch 针对 AI 搜索场景进行了全面的架构革新,从生态开放、企业特性、AI 能力增强到自研高性能内核,全方位满足不同规模和复杂度的智能搜索需求。

1、阿里云 Elasticsearch 的 AI 能力增强:

在 8.17 版本中,阿里云 Elasticsearch AI 增强亮点包括:向量引擎迭代支持千亿规模数据,并引入 Int8 与 BBQ 量化技术;混合检索能力升级,通过 Retrievers 框架支持文本、标量、向量融合查询;Inference Service 深度集成,使引擎可在查询流程内直接调用外部模型,将 Embedding、Rerank 等步骤内置,全面提升 AI 原生搜索性能与智能化水平。

阿里云 Elasticsearch 面向 AI搜索的引擎架构升级特性如下:

- 生态开放: 全面兼容 Elasticsearch、Logstash、Kibana、Beats 等开源组件,实现数据的一站式接入、处理与可视化,支持多源数据统一管理。

- 企业特性: 构建企业级安全与权限管理体系,结合机器学习与集中监控平台,实现丰富的运维指标与日志分析,保障系统治理与运营可靠性。

- AI 特性增强:提供高精度向量引擎及混合检索(KNN、RRF、Linear、Rerank),支持多模态 AI 模型应用,并配备 AI 助手,显著提升搜索的智能化、精准度与复杂任务处理能力。

- 自研高性能内核: 引入 Serverless 索引服务、存算分离 OpenStore 架构、冷热分离存储、QoS 限流控制及时序存储优化等技术,在确保高性能和稳定性的同时,大幅降低存储与计算成本。

2、存算分离架构升级------OpenStore 支持高性能检索场景

OpenStore 作为阿里云 Elasticsearch(ES)的存算分离引擎。今年也全面升级了其架构------从最初仅支持日志分析场景,进化为同时支持日志分析与高性能检索。最大的变化在于存储底座的拓展:除了原有的 OSS 对象存储,新增了 盘古分布式存储支持,并采用 SSD 磁盘的盘古存储方案。相比 OSS,这种架构的 I/O 延迟降低了数个数量级,可轻松满足高性能检索场景的低延迟需求。

OpenStore 存算分离引擎的核心技术能力主要包括三点:

- 三层存储智能调度: 由内存、本地盘和分布式存储构成的三层体系,由 OpenStore 引擎自动、智能调度,确保性能与成本的平衡。

- 数据生命周期自适应复制: 可根据数据生命周期自动选择物理复制或软链复制,保障数据在秒级可见的同时不牺牲性能。

- 冷热共享计算资源: 实现冷热数据共享计算资源,大幅降低集群数据接入和管理的复杂度,并支持快速弹性扩缩容。

在成本优化 方面,基于存算分离架构的 ES 取得了显著成效:日志场景成本下降约 70%,分析场景成本下降约 50%,通用检索场景:成本下降约 40%

底层的云原生管控与运维平台,融合了智能诊断与高级监控能力,可全局分析集群健康状态与潜在风险,多维度指标追踪与异常分析支持系统在互联网、零售、金融、交通、物流等多行业场景中保持高性能、稳定与可扩展性。

本次架构升级通过性能优化、成本控制与智能搜索能力提升,为企业构建新一代 AI 搜索引擎提供了强大的技术支撑。

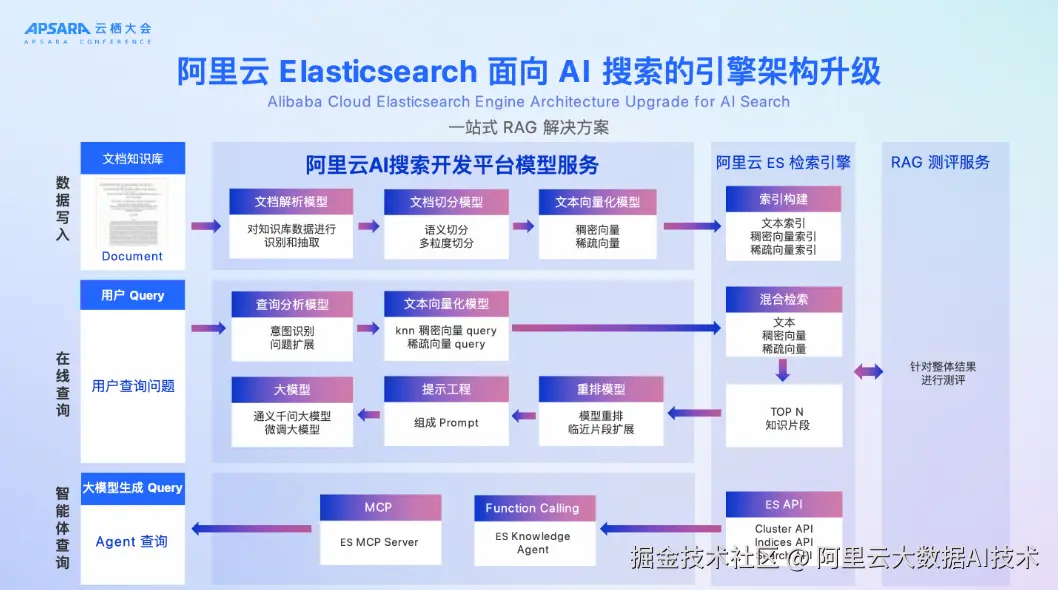

3、一站式 RAG(Retrieval-Augmented Generation) 解决方案

阿里云 Elasticsearch 面向 AI 搜索的引擎架构升级,重点推出了一站式 RAG(Retrieval-Augmented Generation) 解决方案,实现了从数据接入、在线查询到智能体调用的全链路闭环,覆盖模型服务、搜索引擎与评测优化等核心环节:

-

数据写入阶段:

通过 文档解析模型 对知识库内容进行识别与结构化抽取,经 语义驱动的多粒度切分模型 优化检索片段,再由 文本向量化模型 生成稠密与稀疏向量,为索引构建提供高质量特征。

-

在线查询阶段:

查询分析模型 负责识别用户意图并进行需求扩展;随后 文本向量化 将查询转化为可用于 KNN、稠密与稀疏检索的向量表示;最后借助 提示工程与重排模型,生成最优 Prompt,并通过重排序与临近片段扩展提升结果精度。 -

智能体查询阶段:

借助 MCP Server 与 Knowledge Agent(Function Calling) ,可由 Agent 发起跨系统、多数据源的复合查询,调用 Cluster API、Indices API、Search API 高效完成复杂任务分解与执行。

-

搜索引擎执行:

支持文本、稠密与稀疏向量的高效索引构建,并在检索层融合多种向量类型进行 混合检索,返回排序优化后的 TOP N 知识片段。

-

评测与反馈:

通过 RAG 测评服务 对检索与生成的端到端结果进行质量评估与回路优化,实现持续提升。

这一全新架构不仅打通了数据处理---向量化检索---智能重排---Agent 调用---结果评估 的闭环链路,还大幅增强了 AI 搜索在语义理解、精准检索与任务执行方面的能力,为企业级智能搜索提供了高性能、可扩展、可持续优化的技术底座。

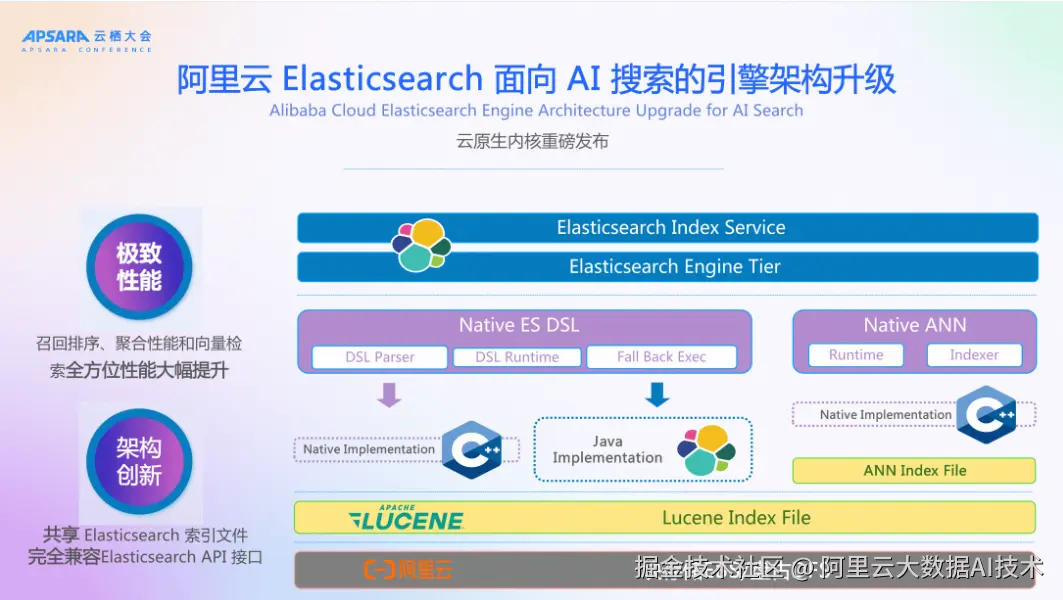

4、云原生内核架构升级:极致性能与架构创新

重磅发布的基于c++从0到1自主研发的云原生内核,在打造极致性能,在召回排序、聚合性能和向量检索全方位性能大幅提升。

核心的架构创新是云原生内核支持直接读取ES索引文件,这样无需重建索引即可使用云原生内核,同时100%兼容Elasticsearch API 接口。

更多技术解读,在第四章有详细分享。

三、阿里云 Elasticsearch 支撑 AI 搜索的关键技术解析

阿里云 Elasticsearch 持续在向量检索这一高资源消耗场景上投入大量核心研发,目标是打造业内最优秀的向量引擎,这不仅仅是一句口号,而是体现在诸多技术细节中:

Elasticsearch 致力于打造最好的向量引擎

- 内存友好模式 :使用 MMAP 方式加载索引,避免将整个索引文件锁定在内存中,有效防止内存溢出,保障服务稳定性。

- 多向量字段联合检索: 支持同时检索多个 kNN 字段,满足多模态与多维度的检索需求。

- 过滤机制灵活:将复杂 Filter 条件预计算成 bitmap result,在 HNSW 图遍历时直接过滤,性能与灵活性兼备。

- 深度优化底层引擎: ES 向量引擎基于 Lucene 自研,与索引构建、合并、查询流程深度整合,减少额外开销并做了大量工程优化。

- GPU + CPU 混合架构 :使用 GPU 加速向量索引构建过程,CPU 执行查询,兼顾构建速度与成本效益。

Elasticsearch 向量引擎持续优化

云原生内核在向量引擎上持续迭代优化,从执行效率、存储成本到检索能力,全链路加速 AI 原生搜索体验。

- VectorAPI 优化: 利用 SIMD 指令加速向量相似度计算,查询性能提升 5 倍。

- 多 Segment 优化: 多 Segment 共享 GlobalQueue,实现多段查询性能提升 2 倍。

- Merge 优化 :基于最大 Segment 优化构建算法,Merge 性能提升 2 倍。

- 堆内存构建优化 :为 HNSW 图添加邻居时动态分配内存,堆内存占用下降 4 倍。

- Filter kNN 优化: 基于 ACORN 算法降低相似度计算次数 ,Filter kNN性能最多提升 5 倍。

- Early Termination 优化 :控制计算次数,在高 Recall 查询下性能提升 50%。

- Ajdk 优化: 针对 Int8 VectorAPI 去除类型转换开销,Int8 查询性能提升 30%。

- 倚天 CPI 优化: 优化 FFI 调用与相似度计算方法,Int8 查询性能再提升 50%。

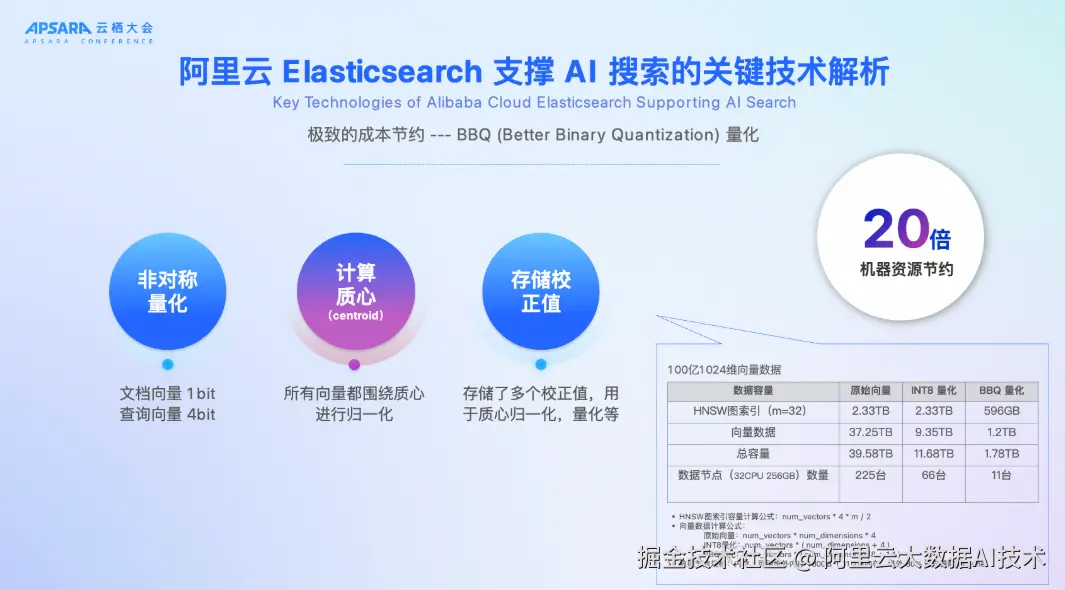

极致的成本节约 --- BBQ (Better Binary Quantization) 量化

- 非对称量化:文档向量存储为 1bit,查询向量使用 4bit 非对称量化。

- 计算质心:计算所有向量的质心并归一化,提升量化精度与召回率。

- 存储校正值:为质心归一化和量化存储多个校正数据,提高搜索准确性。

在 100 亿、1024 维的场景下,BBQ 量化可将机器需求从 225 台降至 11 台,机器资源节约节省资源 20 倍。

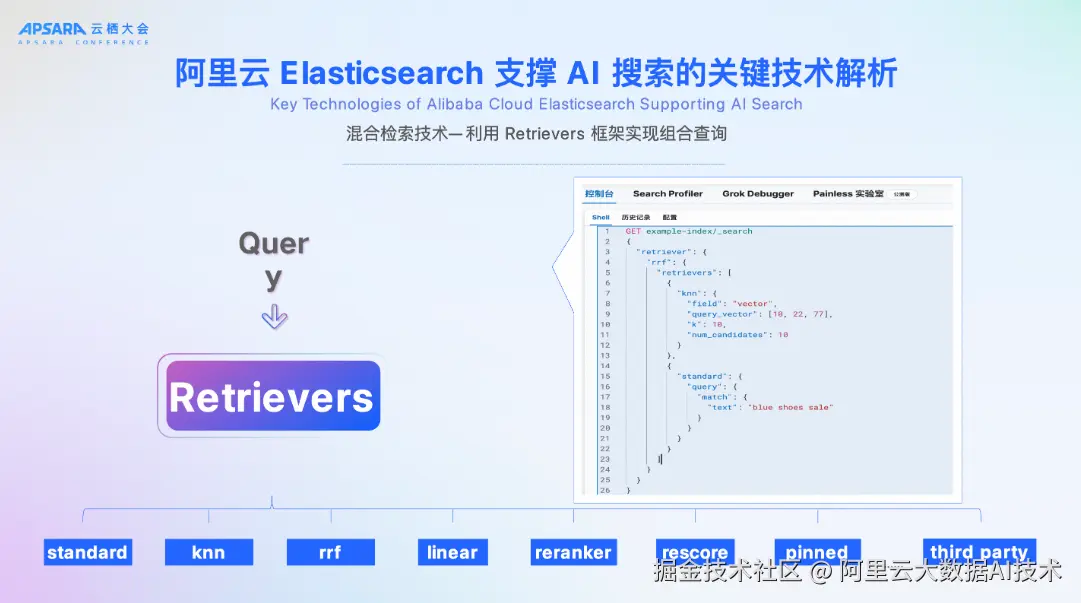

混合检索技术---利用 Retrievers 框架实现组合查询

云原生内核在 Elasticsearch 中新增 Retrievers 框架,支持将多路查询(如向量检索与文本检索)的结果以组合或嵌套的形式整合成单一路径返回。框架内置多种结果融合方式,包括:

- RRF(Reciprocal Rank Fusion)融合

- Linear 加权融合

- Reranker 重新排序

- Rescore 二次评分

这一能力让不同检索类型的结果可以灵活组合,显著提升多模态和混合搜索场景下的检索效果与灵活性。

持续优化与开源贡献

- 阿里云不仅在自用产品中应用这些优化,还将部分能力开源,方便社区用户直接使用。

- 在高并发、多模态搜索、低成本大规模向量检索等应用场景中,保持业内领先性能。

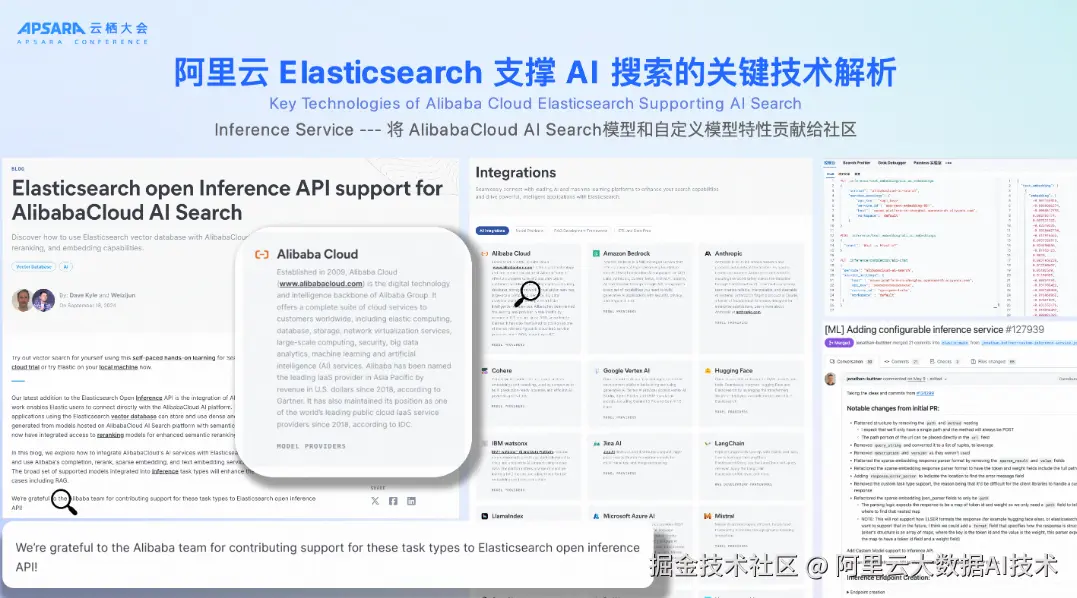

Inference Service --- 将模型调用整合到查询流程

在全新架构中,阿里云 Elasticsearch 通过 Inference API 将模型调用能力深度整合到查询流程,实现了 AI 搜索的端到端智能化处理。系统由 AI 搜索开放内置平台 与 外部模型推理服务两大部分构成,形成了完整的、可扩展的模型推理体系。

- AI 搜索开放内置平台能力

文档解析与切分:支持文档解析、图像解析与语义切片,为多模态内容检索提供结构化输入。 向量表示:生成稠密或稀疏向量,可处理多语言文本,并具备向量降维能力以优化存储与计算效率。 查询分析:提供意图理解、问题扩展功能,并支持 NL2SQL 自然语言转 SQL,实现"所问即所得"的结构化查询。 排序服务:通过重排模型优化检索结果相关性。 微调与评测:支持模型微调和效果评估,确保搜索结果在特定领域的精度与适配度。 大模型服务:兼容搜索专属大模型、通用大模型及第三方开源大模型,灵活适应不同业务场景。

- 外部模型推理服务支持

原生对接阿里云百炼、阿里云人工智能平台 PAI 以及其他第三方模型平台,实现跨平台推理与融合能力。 这一体系让 AI 搜索从文档解析、向量生成、查询理解、结果重排、模型微调到多模型适配形成全链路闭环,不仅提升检索的语义理解深度和查询匹配精准度,更为复杂、多模态、多领域的搜索场景提供了强大的"芯"动能。

这一系列优化,使得阿里云 Elasticsearch 不仅能在海量向量检索任务中提供更稳定的服务、更灵活的查询组合、更高效的底层执行,还为后续 AI 原生搜索在多模态、复杂条件组合、实时响应等场景中的落地打下坚实基础。

四、云原生内核重磅发布:极致性能与架构创新并行

云原生内核性能高提速

云栖大会重磅发布的基于 C++ 从0到1自主研发的云原生内核 ------阿里云 Elasticsearch 云原生内核打造极致性能,在召回排序、聚合性能和向量检索全方位性能大幅提升。通过 高效 Native 实现 + 现代体系结构优化,显著释放了 CPU 潜能,使复杂查询提速最高可达 6 倍。

- 高效 Native 实现: 以 C++ 原生执行替代部分 Java 路径,覆盖 Lucene 索引读取、查询召回、聚合计算以及 ANN 向量索引构建与读取,降低执行开销。

- 现代体系结构优化: 支持批次化执行、消除流水线阻塞,并引入 SIMD 向量化计算加速,从执行链路上提升 IPC 性能。

- 复杂查询提速可达6倍: 100% 查询支持,兼容 Elasticsearch API 及上下游生态,实现性能提升的同时无缝适配现有系统。

这一优化路径让阿里云 ES 在多类型、复杂查询场景中保持稳定低延迟,为 AI 原生搜索的高并发处理提供了坚实基础。

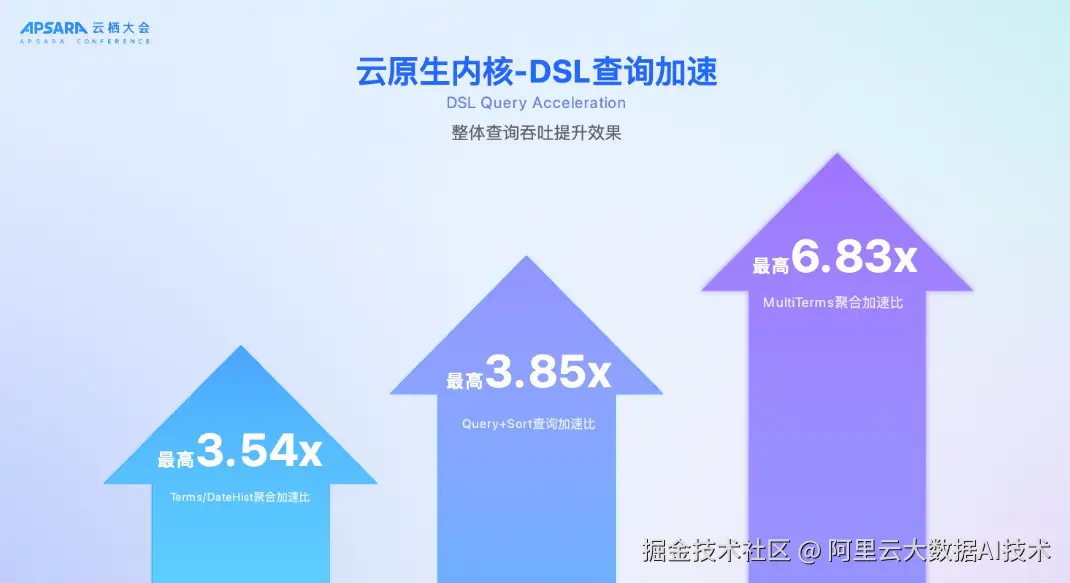

云原生内核-DSL查询加速

在最新的云原生内核中,阿里云对 Elasticsearch 的 DSL 查询处理性能进行了全面升级。基于 esrally 官方数据集和真实场景压测,Native 执行引擎在多类查询中显著优于传统 JVM 路径,最高吞吐加速比达到 6.83 倍。

在不同场景中,优化效果各有侧重:

- 多字段聚合(MultiTerms)加速最为明显,提升 6.83x;

- 排序类查询(Query+Sort)最高加速 3.85x;

- Terms 和 DateHist 类型的聚合查询提升最高可达 3.54x,其他时间聚合和排序场景也稳定提升在 2~3 倍区间。

除了吞吐性能优化,云原生内核在查询延迟方面也针对真实业务场景进行了强化。在单一重复查询(单态压测)下,原 ES JVM 可利用稳定路径降低延迟,但在混合多类查询(动态压测)中,JVM 路径优化失效,原版延迟显著增加;Native 执行引擎则不依赖 JVM 特性,即使在动态场景中也能保持稳定低延迟。

这意味着在高并发、复杂查询模式下,新的内核可以同时保障更高吞吐量与更低响应时间,尤其适合 AI 原生搜索对实时性要求极高的应用场景。

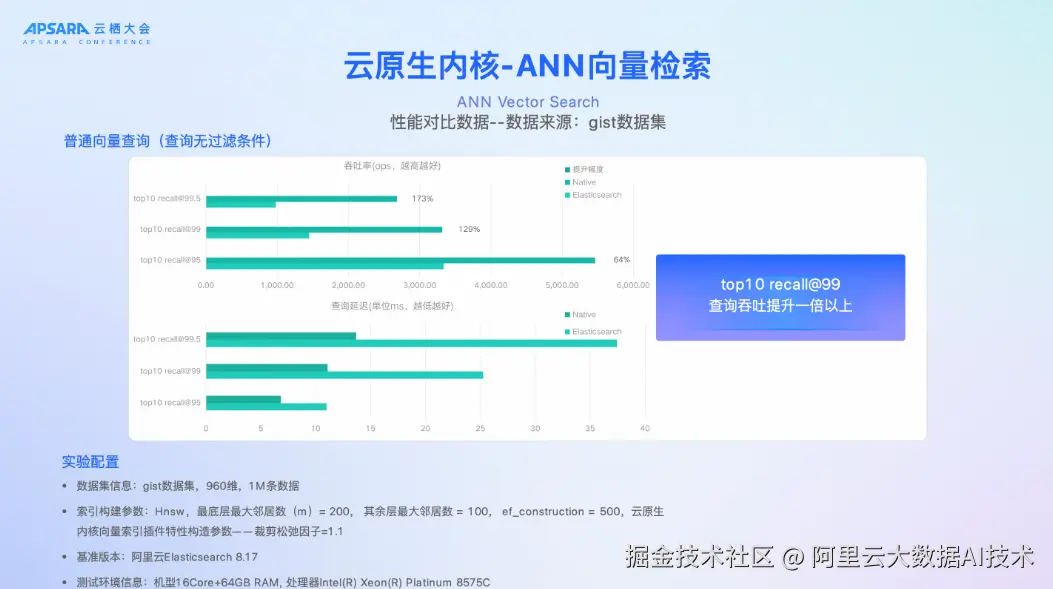

云原生内核-ANN向量检索

在云原生内核的加持下,阿里云 Elasticsearch 的 ANN(近似最近邻)向量检索能力实现了跨越式提升。不仅大幅提升查询吞吐与响应速度、显著降低内存和算力开销,还可以支持更复杂的过滤和多模态搜索场景。

- 普通向量查询(查询无过滤条件) 在 gist 数据集(960维,1百万数据)上的基准测试中,阿里云 Elasticsearch 云原生内核的 Native 执行引擎 相比原生 ES 8.17 展现了显著的吞吐与延迟优势。

- 在常见的 top10 recall@99 场景中,Native 执行吞吐量量,提升了 1 倍以上!

由此可见,Native 执行在相同召回率下能够保持更低的响应时间,实现更高的并发能力与查询效率。

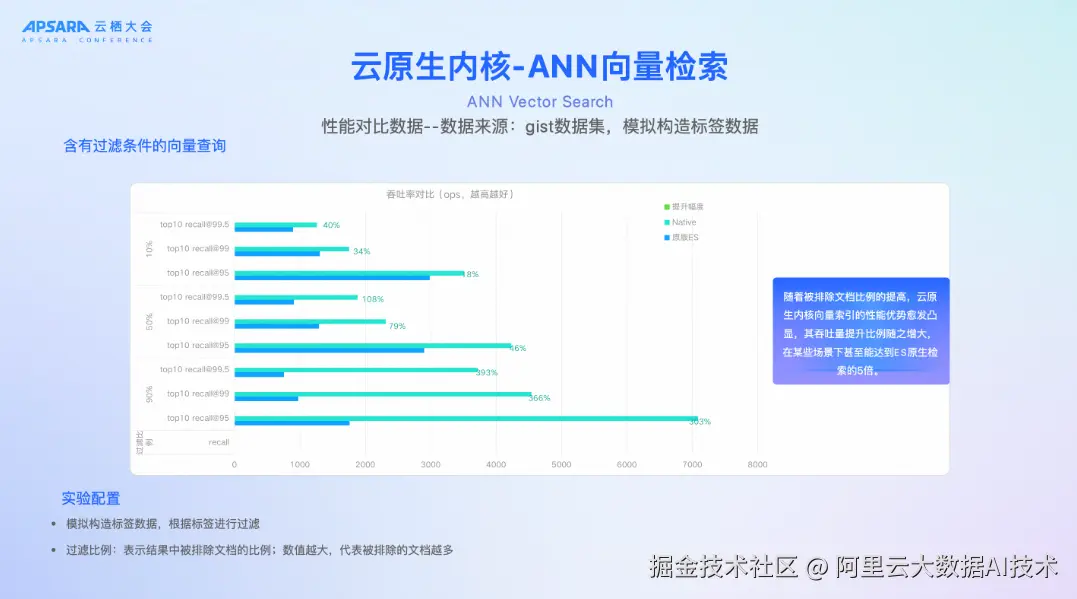

- 含有过滤条件的向量查询

随着被排除文档比例的提高,云原生内核向量索引的性能优势愈发凸显,其吞吐量提升比例随之增大,在某些场景下甚至能达到ES原生检索的5倍。

这些能力让云原生内核的 阿里云 Elasticsearch 的 ANN(近似最近邻)向量检索在不同场景的整体吞吐量实现显著提升!

普通向量查询最高提升 170% ,带过滤向量查询最高提升 400%!

- 云原生内核-ANN向量检索更多特性

- 支持更丰富的向量索引类型: 包括基于聚类的 QC 方法、用于大规模数据的DiskANN 方法(针对大规模数据场景)、rabitQ 等。

- 支持GPU加速检索: 在8核 T4 GPU上,相比基础 HNSW 检索,相同recall 下可以提升6~8倍吞吐。

- 支持查询内并发: 支持单查询内部并发,并发数<=4时,可以实现线性加速比,最高可实现6~7倍加速。

四、结尾

阿里云 Elasticsearch 打通了 内核优化 + RAG 闭环方案 + 云原生推理平台 三大能力模块,换"芯" 不只是简单的引擎升级,而是面向 AI 原生时代的系统性能力重构。让搜索引擎从被动的信息检索工具,跃升为面向复杂任务的主动智能解决方案,在多模态、高精度、低延迟的智能检索场景中,帮助企业构建面向未来的搜索中枢。

"未来请与阿里云一起,拥抱 AI 原生搜索时代,让搜索不止于搜索,让智能驱动业务增长。"