本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

想在本地运行大模型,却卡在环境配置?CUDA和cuDNN是GPU加速的核心,但版本混乱、依赖冲突让无数人头疼。本文从零开始,带你避坑踩雷,5分钟搞定高性能环境,让大模型在你的电脑上"飞"起来!

一、为什么必须配置CUDA/cuDNN?

大模型训练/推理依赖GPU并行计算,CUDA是NVIDIA的并行计算平台,cuDNN是深度学习加速库。没有它们,你的显卡算力将闲置90%!

二、环境准备清单

(1)硬件

NVIDIA显卡(GTX 10系以上,显存≥8GB推荐)

(2)系统

Windows 10/11 或 Ubuntu 20.04+(本文以Windows 11为例)

(3)软件

NVIDIA驱动、cuda、cuDNN

- NVIDIA驱动安装

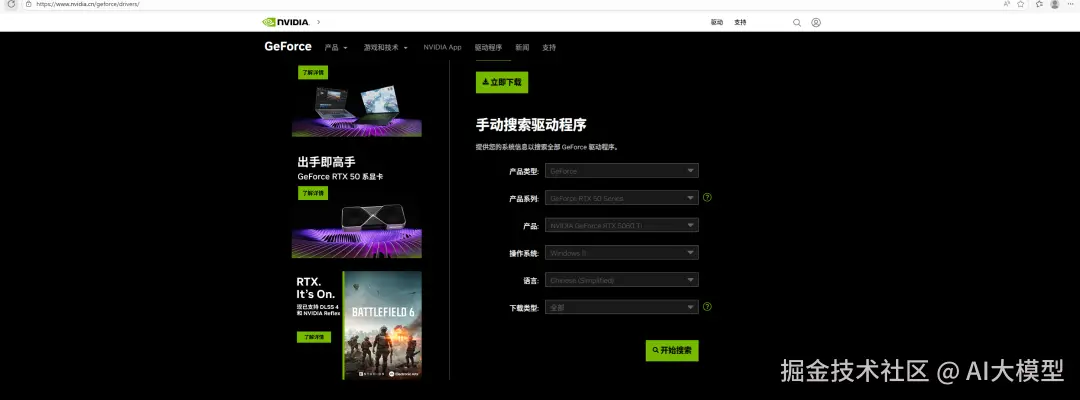

(1)驱动官网:

选择当前电脑显卡的参数,本文以5060Ti为例

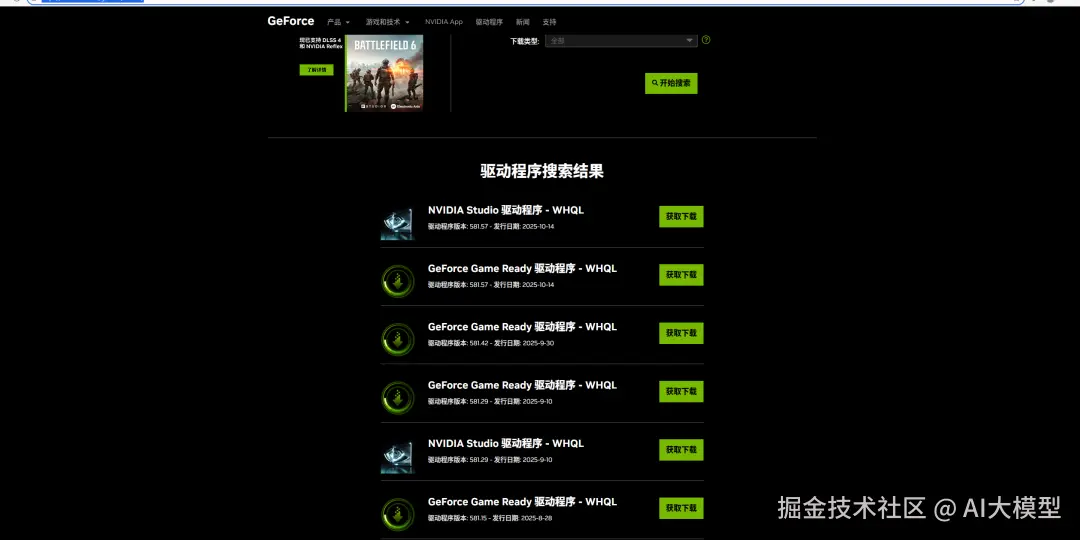

(2)选择要下载的驱动,这里选择GeForce Game Ready

NVIDIA Studio 和GeForce Game Ready 区别不是很大,以下解释来自官网:如果您是游戏玩家,希望在新游戏、新补丁和游戏追加下载内容 (DLC) 的发布日第一时间获得支持,请选择 Game Ready 驱动程序。如果您是内容创作者,优先考虑创意工作流程的稳定性和质量,例如视频编辑、动画、摄影、图形设计和直播等,请选择 Studio 驱动程序。

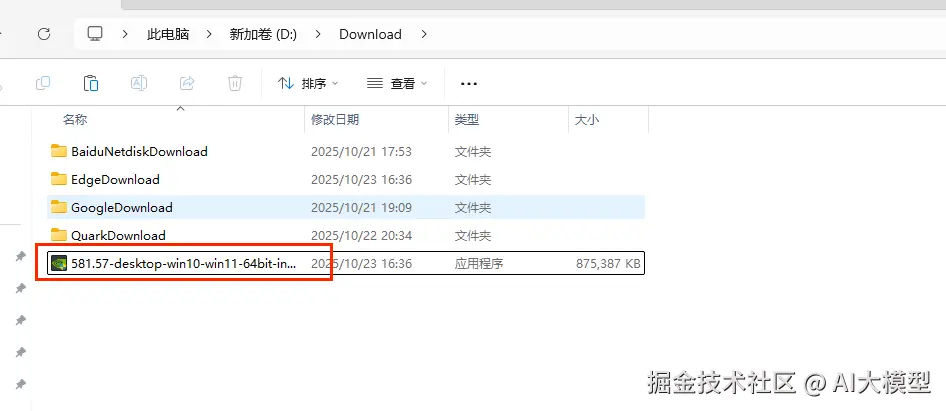

(3)下载完成后,双击安装

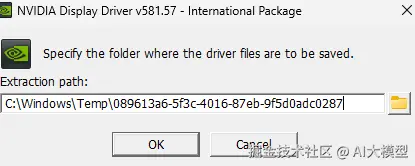

(4)选择安装目录,点击OK即可

- 安装cuda

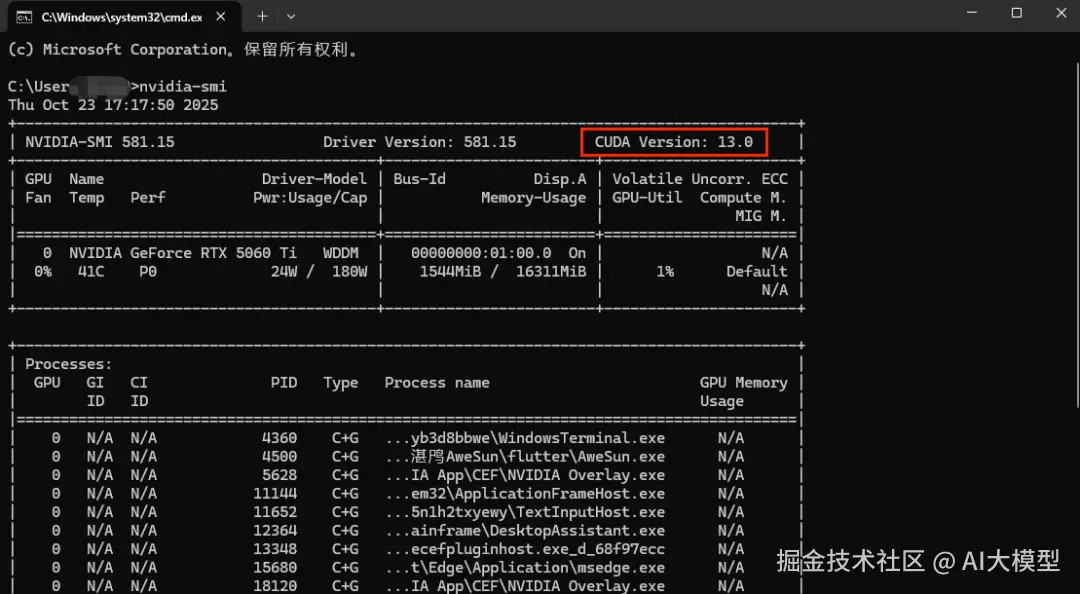

(1)CMD下输入 nvidia-smi,查看显卡支持最高的cuda版本,此电脑最高可安装13.0,考虑到很多项目可能不支持最新版的cuda,这里选择cuda为12.9。

(2)cuda 12.9官网:

developer.nvidia.com/cuda-12-9-0...

(3)下载完成后,直接双击安装

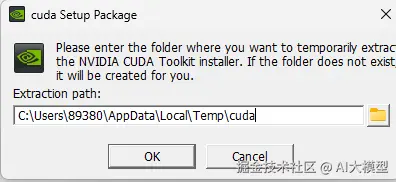

(4)选择安装目录

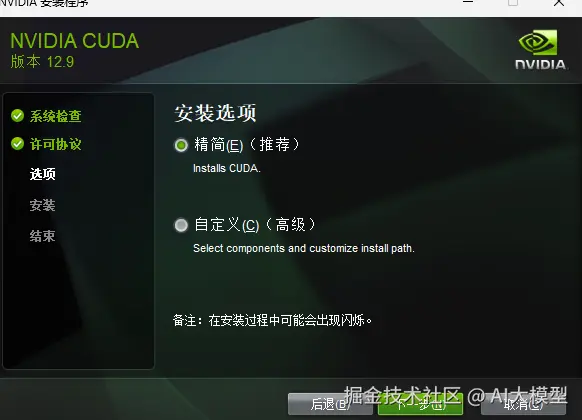

(5)这里选择精简,直接下一步,等待安装完成即可。

- 安装cudnn

(1)cudnn官网:

developer.nvidia.com/rdp/cudnn-a...

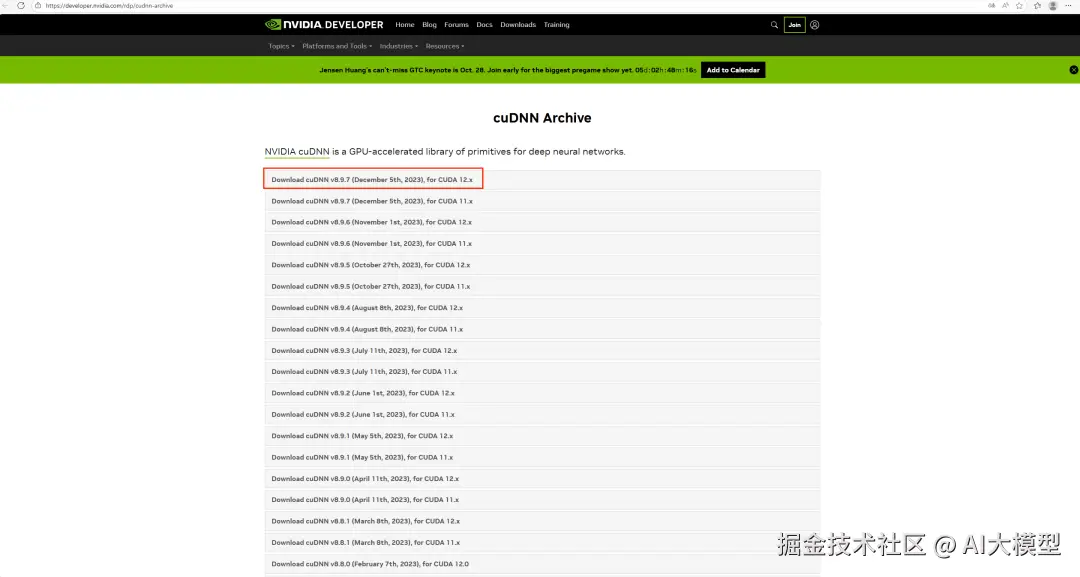

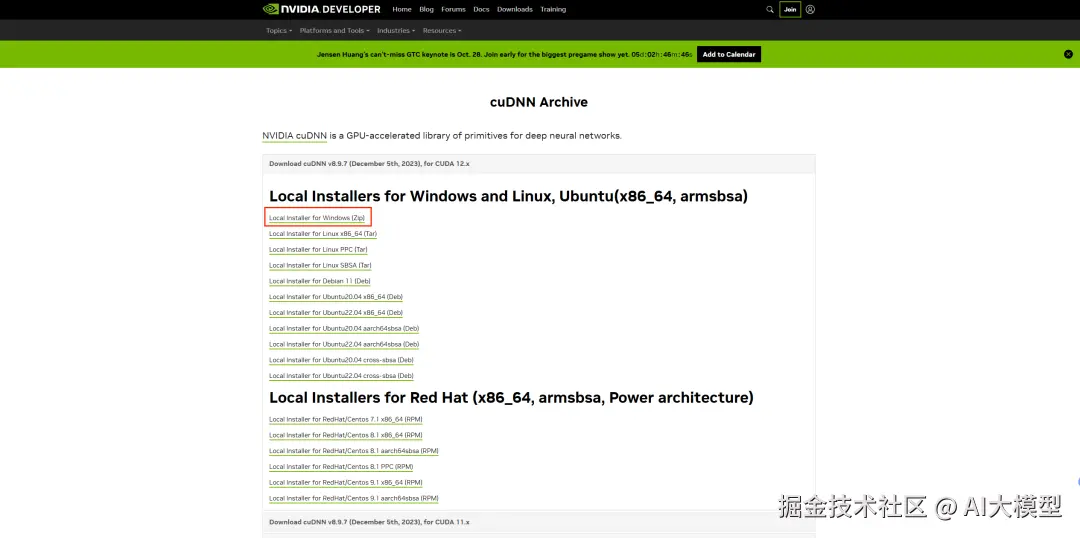

(2)选择cudnn版本

由于电脑cuda版本为12.9,因此这里选择8.9.7

(3)下载Local Installer for Windows (Zip)

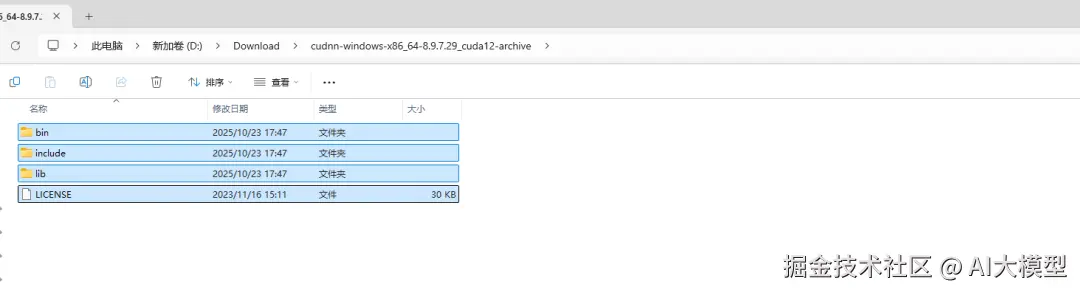

(4)解压cudnn.zip,并全部复制

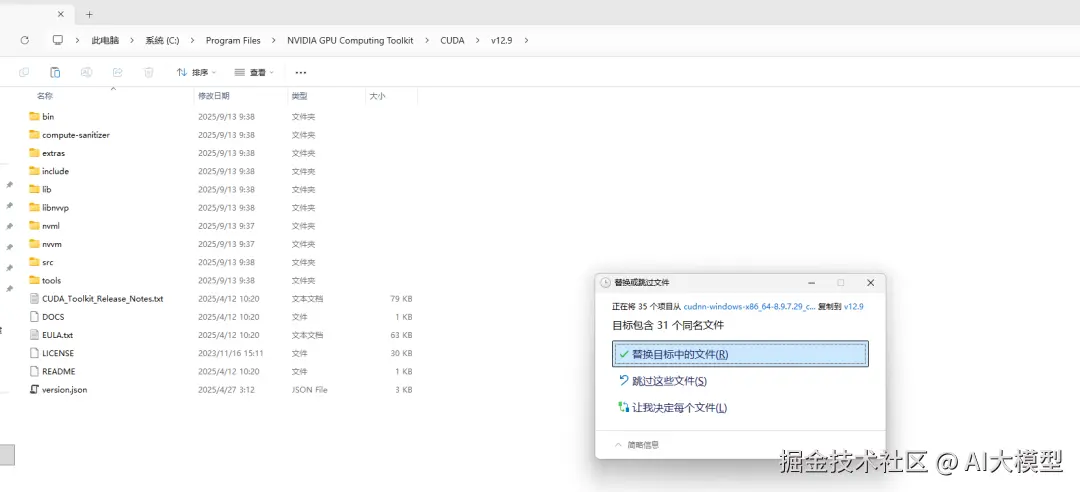

(5)找到cuda的安装目录

(6)直接替换文件

此时驱动、cuda、cudnn已经安装完成。

- 测试验证

运行以下脚本

scss

import torch

print("PyTorch 版本:", torch.__version__)

print("CUDA 是否可用:", torch.cuda.is_available())

print("CUDA 版本:", torch.version.cuda)

print("cuDNN 版本:", torch.backends.cudnn.version())

print("GPU 数量:", torch.cuda.device_count())

if torch.cuda.is_available():

print("当前 GPU:", torch.cuda.get_device_name(0))

# 简单张量计算测试

a = torch.randn(1000, 1000).cuda()

b = torch.randn(1000, 1000).cuda()

c = torch.mm(a, b)

print("GPU 矩阵乘法成功!结果形状:", c.shape)

else:

print("CUDA 不可用,请检查驱动或安装")输出

yaml

PyTorch 版本: 2.8.0+cu129

CUDA 是否可用: True

CUDA 版本: 12.9

cuDNN 版本: 91002

GPU 数量: 1

当前 GPU: NVIDIA GeForce RTX 5060 Ti

GPU 矩阵乘法成功!结果形状: torch.Size([1000, 1000])结语:

搞定CUDA/cuDNN,你就打通了大模型本地部署的"任督二脉"。下一步,我们将实战部署LLaMA、ChatGLM等模型,敬请关注!

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。