📘 摘要

在市政管网、工业巡检与地下管廊检测等场景中,视频链路已不再只是"可视化工具",而是智能系统的神经主干。高温、高湿、长距离、无信号的封闭管道,对视频传输的稳定性、实时性和可扩展性提出了极高要求。过去,单一录像或串流方案往往难以兼顾低延迟与数据复用,成为"智能检测"落地的瓶颈。

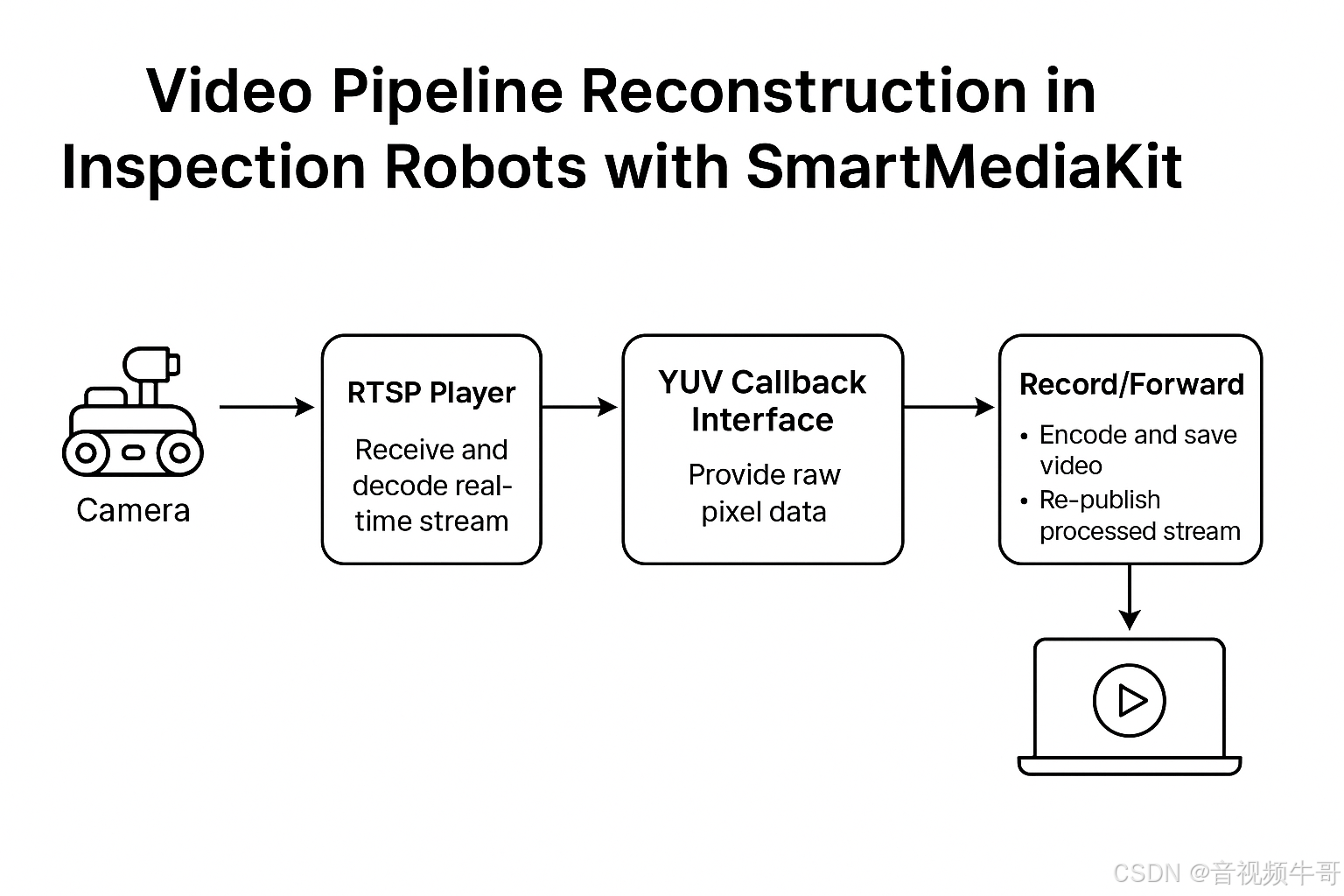

大牛直播SDK(SmartMediaKit)以其全自研的跨平台音视频内核,为检测机器人提供了一条从"感知端"到"协同端"的完整链路。通过 Android 端 RTSP 播放器模块及 YUV 数据回调机制,系统可在实时播放的同时进行 动态水印叠加、录像存档、二次编码以及轻量级 RTSP 服务再发布 。

这种架构让视频数据具备了复用性与可演化性------既能被本地算法使用,又能同步上传至云端平台,实现"边看边算、边传边控"的闭环。

从本质上看,这是一场视频底座的技术重构:

它让机器人拥有了具备延迟可控、结构开放、接口统一的"视觉神经系统",

为工业检测的智能化、网络化与协同化提供了坚实基础。

一、行业痛点:从"能看见"到"能回传"

在传统的管道检测体系中,"可视化"长期停留在单点环节------摄像头负责采集,终端负责显示,而数据流往往止步于屏幕。然而,随着检测任务对实时远程协同、智能分析与系统闭环的需求不断增长,视频链路的短板开始暴露出来。

1️⃣ 传输距离与稳定性的矛盾

模拟方案虽低延迟,却受线缆衰减和信号噪声制约;数字方案虽高清,却常因多层协议叠加导致传输延时与画面抖动。在长距离、复杂管网环境中,信号的"可达"与"可用"始终难以兼得。

2️⃣ 多任务耦合导致系统割裂

传统检测机器人的视频回传、录像、推流、控制往往由不同模块独立实现。这意味着时钟系统各自为政,延迟无法统一,录像与预览不同步、控制反馈滞后等问题频繁出现。系统架构的复杂性不仅增加了维护成本,也让扩展性和复用性几乎为零。

3️⃣ 数据回放与调度的封闭性

许多设备仍依赖自定义封装或离线文件形式存储视频数据,录像文件缺乏标准化索引与协议兼容,无法被调度平台或云端算法实时调用。这让检测数据"沉睡"在设备中,无法真正进入智能化流通体系。

这些问题的根源,不在于编码或带宽,而在于缺乏一个高实时性、可编排、跨协议的视频处理底座。一个能够让"画面"不仅被看见,更能被使用、被分析、被再传递的底层系统。这,正是大牛直播SDK(SmartMediaKit)切入并重构的关键方向。

二、技术核心:Android端 RTSP 播放器 + YUV 回调链

在现代检测机器人中,视频链路的核心不只是"播放画面",

而是如何在多任务环境下实现实时解码、帧级操作与数据再利用 。

大牛直播SDK(SmartMediaKit)在 Android 平台的实现,正是围绕这一目标构建的。

▶ 模块化视频链结构

内部视频数据流可以抽象为三层:

1️⃣ 感知采集层

摄像头采集视频后经 H.264 / H.265 编码,通过内部 RTSP 服务推送至系统主控。

这一层侧重稳定传输与带宽利用,是系统的"前端感知"。

2️⃣ 播放解码层

主控端或 Android 终端通过大牛直播SDK 的 RTSP 播放器模块接入实时流。

SDK 内核以全自研内核实现全链路处理,保证了在嵌入式或定制系统中的可裁剪性与一致性。

3️⃣ 数据回调与复用层

SDK 解码完成后,提供标准化的 YUV 数据回调接口:

java

private static class I420ExternalRender implements NTExternalRender {

// public static final int NT_FRAME_FORMAT_RGBA = 1;

// public static final int NT_FRAME_FORMAT_ABGR = 2;

// public static final int NT_FRAME_FORMAT_I420 = 3;

private WeakReference<LibPublisherWrapper> publisher_;

private ArrayList<WeakReference<LibPublisherWrapper> > publisher_list_;

private int width_;

private int height_;

private int y_row_bytes_;

private int u_row_bytes_;

private int v_row_bytes_;

private ByteBuffer y_buffer_;

private ByteBuffer u_buffer_;

private ByteBuffer v_buffer_;

public I420ExternalRender(LibPublisherWrapper publisher) {

if (publisher != null)

publisher_ = new WeakReference<>(publisher);

}

public I420ExternalRender(LibPublisherWrapper[] publisher_list) {

if (publisher_list != null && publisher_list.length > 0) {

for (LibPublisherWrapper i : publisher_list) {

if (i != null) {

if (null == publisher_list_)

publisher_list_ = new ArrayList<>();

publisher_list_.add(new WeakReference<>(i));

}

}

}

}

private final List<LibPublisherWrapper> get_publisher_list() {

if (null == publisher_list_ || publisher_list_.isEmpty())

return null;

ArrayList<LibPublisherWrapper> list = new ArrayList<>(publisher_list_.size());

for (WeakReference<LibPublisherWrapper> i : publisher_list_) {

if (i != null) {

LibPublisherWrapper o = i.get();

if (o != null && !o.empty())

list.add(o);

}

}

return list;

}

@Override

public int getNTFrameFormat() {

Log.i(TAG, "I420ExternalRender::getNTFrameFormat return "

+ NT_FRAME_FORMAT_I420);

return NT_FRAME_FORMAT_I420;

}

private static int align(int d, int a) { return (d + (a - 1)) & ~(a - 1); }

@Override

public void onNTFrameSizeChanged(int width, int height) {

width_ = width;

height_ = height;

y_row_bytes_ = width;

u_row_bytes_ = (width+1)/2;

v_row_bytes_ = (width+1)/2;

y_buffer_ = ByteBuffer.allocateDirect(y_row_bytes_*height_);

u_buffer_ = ByteBuffer.allocateDirect(u_row_bytes_*((height_ + 1) / 2));

v_buffer_ = ByteBuffer.allocateDirect(v_row_bytes_*((height_ + 1) / 2));

Log.i(TAG, "I420ExternalRender::onNTFrameSizeChanged width_="

+ width_ + " height_=" + height_ + " y_row_bytes_="

+ y_row_bytes_ + " u_row_bytes_=" + u_row_bytes_

+ " v_row_bytes_=" + v_row_bytes_);

}

@Override

public ByteBuffer getNTPlaneByteBuffer(int index) {

switch (index) {

case 0:

return y_buffer_;

case 1:

return u_buffer_;

case 2:

return v_buffer_;

default:

Log.e(TAG, "I420ExternalRender::getNTPlaneByteBuffer index error:" + index);

return null;

}

}

@Override

public int getNTPlanePerRowBytes(int index) {

switch (index) {

case 0:

return y_row_bytes_;

case 1:

return u_row_bytes_;

case 2:

return v_row_bytes_;

default:

Log.e(TAG, "I420ExternalRender::getNTPlanePerRowBytes index error:" + index);

return 0;

}

}

public void onNTRenderFrame(int width, int height, long timestamp)

{

if (null == y_buffer_ || null == u_buffer_ || null == v_buffer_)

return;

Log.i(TAG, "I420ExternalRender::onNTRenderFrame " + width + "*" + height + ", t:" + timestamp);

y_buffer_.rewind();

u_buffer_.rewind();

v_buffer_.rewind();

List<LibPublisherWrapper> publisher_list = get_publisher_list();

if (null == publisher_list || publisher_list.isEmpty())

return;

for (LibPublisherWrapper i : publisher_list) {

i.PostLayerImageI420ByteBuffer(0, 0, 0,

y_buffer_, 0, y_row_bytes_,

u_buffer_, 0, u_row_bytes_,

v_buffer_, 0, v_row_bytes_,

width_, height_, 0, 0,

0,0, 0,0);

}

}

}通过该接口,开发者可直接在内存中获取逐帧图像数据,无需额外解码或拷贝,即可实现多种高阶功能:

-

动态叠加企业 Logo / 时间戳 / 检测编号等水印信息;

-

二次编码生成 MP4录像文件,支持断点续录与边录边传;

-

将处理后的视频流通过轻量级 RTSP 服务再发布,供上位机或远程监控系统实时接入。

▶ 自研内核的技术价值

这一整条"解码---操作---再分发"的链路,完全基于大牛直播SDK自研内核构建。

无第三方依赖意味着:

-

启动更快、延迟更低(平均首帧 < 200ms);

-

模块可独立裁剪与集成;

-

在弱网、嵌入式环境中仍可保持时钟精准与数据连续性。

这种设计,使视频流不再只是显示结果,而成为可计算、可协作、可再利用的数据对象 ,

为后续的动态录制、AI检测、云端推流等功能奠定了统一基础。

三、延迟控制:毫秒级画面的背后

在工业检测机器人中,延迟不仅取决于解码与渲染,而是贯穿整个视频数据链路------

从播放端解码输出,到业务层处理,再到推送端二次编码与再发布。

大牛直播SDK(SmartMediaKit)在 Android 端的实现,正是一个典型的全链路低延迟架构样本。

1️⃣ 播放端:RTSP 解码与 YUV 回调

机器人前端摄像头通过内部 RTSP 服务输出实时码流。

在终端侧(Android 控制端),SmartPlayer 组件基于大牛直播SDK 的 RTSP 播放模块进行接入、解码,并在解码后回调出原始的 YUV 帧数据:

在这一回调中,每一帧都携带完整时间戳(ptsMs),为后续编码、录制与推流提供统一时钟基准。

这也是延迟控制的起点:在播放端即获取原始帧与精准时间线。

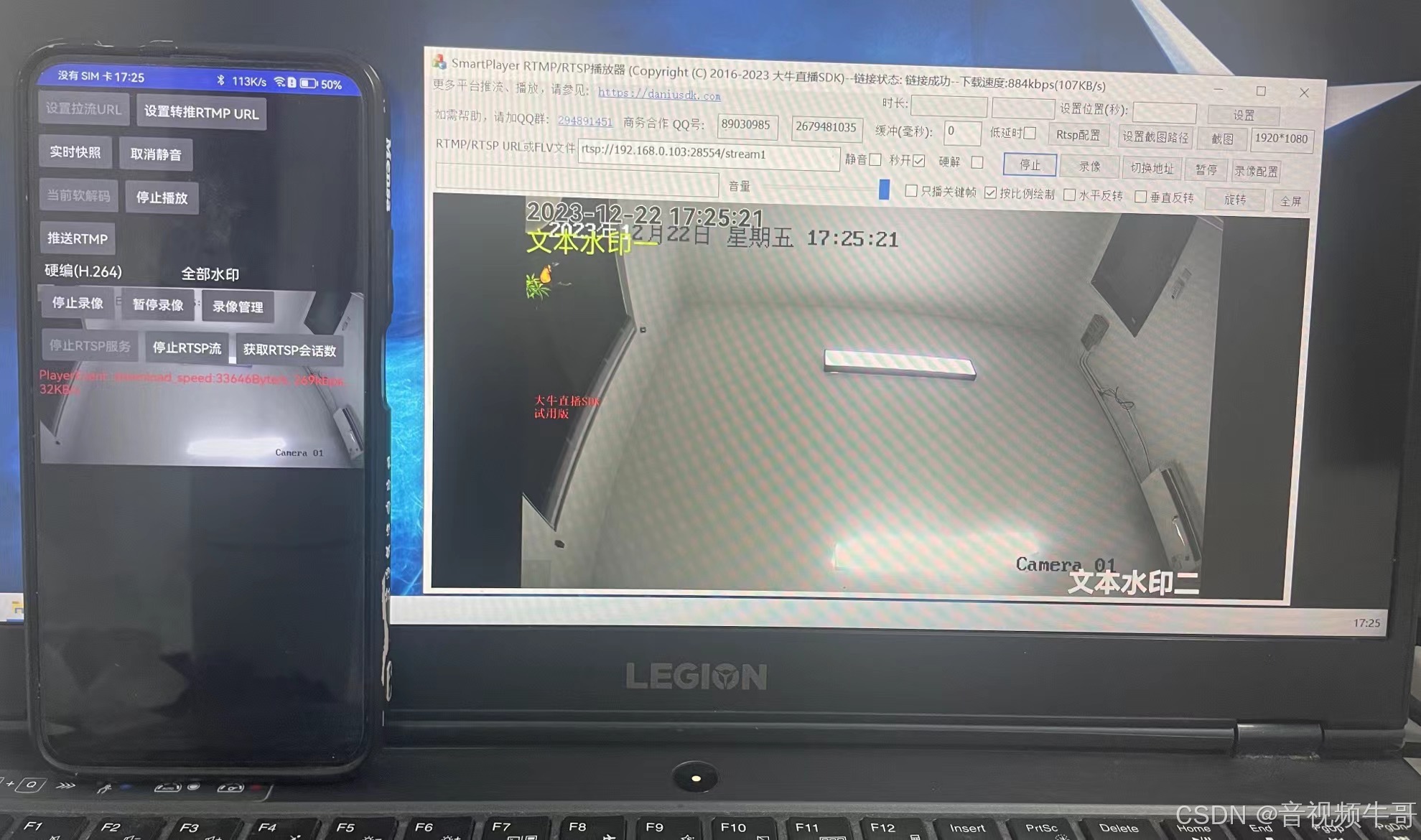

RTMP|RTSP播放器回调RGB数据进行算法分析和二次推流

2️⃣ 中间层:水印叠加与数据转投递

在 demo 中,播放器回调的 YUV 数据会交由业务层进行轻量级图像处理。

常见操作包括:

-

叠加设备编号、时间戳、水印 Logo;

-

局部标注(如检测点框选)。

这部分逻辑通常运行于回调线程或 LayerPostThread 线程中,完成叠加后,处理好的 YUV 帧通过 LibPublisherWrapper 的接口,调用推送端(SmartPublisherJniV2)的编码入口:这一步将播放端的输出转化为推送端的原始输入,既不走文件缓存,也不经中间缓冲区,从而实现"帧级直通"。

Android平台RTSP播放器时延测试

3️⃣ 推送端:再编码与录像/再发布

推送端收到帧数据后,通过 JNI 调用进入 SmartPublisherJniV2 的底层模块,

由其统一调度录像(MP4/FLV)与轻量级 RTSP/RTMP/HTTP-FLV 再发布流程:publisher.startRecorder(); publisher.startRtspService();

此时的延迟主要取决于编码方式与 GOP 策略。通过统一的时间戳管理,录像文件、推流画面与原始播放流完全对齐。无论是边录边传、断点续录还是上位机实时拉流,都能保持毫秒级时序一致。

📊 结果:从播放到再发布,延迟可控

通过这套架构,视频流从解码输出到再编码发布的全过程,在 Android SoC 平台上可稳定控制在 百毫秒级内 。这种"回调即复用"的设计,让检测机器人不仅能看见现场 ,还能即时存档、即时回传、即时共享。

从技术实现上看,这已不再是简单的"播放链路",而是一套具备时钟自洽、任务解耦、延迟可控的视频数据总线,真正让视觉成为机器人系统的"即时神经反射"。

四、模块化设计:一套 SDK,多重用途

在检测机器人系统中,视频不仅是一条单向通路,而是一个需要被采集、分析、再利用的闭环数据流。

SmartMediaKit 的设计哲学,正是通过 "可插拔模块 + 统一内核" 的方式,把这一闭环变得灵活、高效且可复用。

整个 SDK 以统一的媒体内核为中心,围绕视频数据的输入、处理、输出三个阶段,形成了可自由组合的功能单元:

| 模块 | 功能 | 工程意义 / 应用价值 |

|---|---|---|

| RTSP 播放器模块 | 接收前端摄像头实时流,完成解码与时序同步 | 作为机器人"眼睛",提供稳定、低延迟的实时预览与画面感知能力 |

| YUV 回调接口 | 向上层业务输出原始像素帧(Y/U/V 数据 + 时间戳) | 实现动态水印、画面标注、AI 算法输入、再编码等高级定制处理 |

| 推送与录制模块(SmartPublisher) | 将回调帧重新编码并输出为 MP4/FLV 文件,支持断点续录与边录边传 | 支撑检测数据的现场存档、远程取证与历史追溯 |

| 轻量级 RTSP / RTMP推流 / HTTP-FLV 服务模块 | 将处理后的视频再封装、再发布 | 让机器人本身成为可被"拉流"的节点,实现上位机多点共享与云端实时监控 |

| JNI 桥接层(SmartPlayerJniV2 / SmartPublisherJniV2) | 连接 Java 层与 C/C++ 底层内核,统一时钟与缓冲管理 | 确保不同模块在 Android 平台下延迟可控、线程安全、可移植 |

▶ 模块协同的核心逻辑

在实际工程中,这些模块通过 标准化数据接口与统一时钟系统 紧密协作:

1️⃣ 播放器模块(SmartPlayer)从 RTSP 拉流并解码;

2️⃣ 解码后帧通过 YUV 回调直接送入推送端接口(LibPublisherWrapper);

3️⃣ 推送端(SmartPublisher)负责二次编码与录像,再可选开启 RTSP/RTMP 再发布;

4️⃣ 整个过程共享同一时间戳体系,录像、推流与播放保持帧级同步。

这种"单内核多节点"的架构,使得 SmartMediaKit 可以在同一套 SDK 中:

-

同时完成 实时监控 + 本地录像 + 远程转发;

-

在不同项目中灵活复用(例如:检测机器人、工业巡检终端、无人机控制台、远程诊断系统);

-

在不改底层代码的情况下,实现差异化定制(如切换为 HTTPS-FLV、WSS-FLV 或 WebRTC Bridge)。

▶ 设计哲学:一次集成,多场景演化

对开发者而言,SmartMediaKit 不仅仅是"播放端 + 推送端"的组合,

而是一种 以视频为核心的实时数据管线(Real-Time Media Pipeline)。

它让系统拥有三种能力:

-

可看:低延迟、高稳定的实时画面;

-

可用:YUV 数据可供 AI/水印/再编码复用;

-

可传:轻量 RTSP/RTMP/FLV 服务可随时转发。

这种模块化结构,让检测终端真正具备"感知---处理---协同"的闭环能力。

无论部署在地下管网、工业管廊还是低空设备上,

它都能以同一套 SDK,支撑多场景、多链路的实时可视系统。

五、典型应用流程示例

在实际的检测机器人系统中,视频链路不仅要做到"低延迟",更要实现"可复用"。

在大牛直播SDK(SmartMediaKit)架构下,视频帧从解码、处理到再发布的全过程被完整抽象为一个统一管线:

SmartPlayer → LibPublisherWrapper → SmartPublisherJniV2 → 录像/推流模块。

这一链路可视为一次完整的"视频生命周期",贯穿了感知、加工、再利用三个阶段。

▶ Step 1:SmartPlayer ------ 视觉采集与解码

检测机器人前端摄像头通过 RTSP 输出实时视频流,终端端(主控设备或 Android 平台)使用 SmartPlayer 模块拉流、解码。

播放端采用自研 RTSP 协议解析器与解码器,在极端网络条件下仍能保持稳定时序。每一帧视频在解码完成后,会通过 JNI 层回调出 原始 YUV 数据 与对应时间戳:

这一机制让上层应用获得对视频帧的"直接访问权",不再局限于播放器内部渲染,从而为后续的业务加工、录像与再发布提供可能。

▶ Step 2:LibPublisherWrapper ------ 帧级中转与轻量处理

在你的 demo 架构中,LibPublisherWrapper 扮演了桥梁角色:它负责接收播放端的回调帧,并将其作为编码前的输入帧,投递给推送端。在投递之前,可插入定制化的业务逻辑,例如:

-

在 Y 平面直接绘制时间戳或企业 Logo;

-

叠加检测编号或现场参数;

-

对画面区域进行简单遮罩或标注。

该阶段通常运行在单独的回调线程或 LayerPostThread 中,处理耗时控制在 5ms 以内,不阻塞解码主线程。

▶ Step 3:SmartPublisherJniV2 ------ 再编码与多路输出

经过 LibPublisherWrapper 投递的 YUV 帧会被送入 SmartPublisherJniV2,在底层进行统一调度与再编码。编码器支持 H.264/H.265 硬件加速,可选 FLV/MP4 封装,同时提供多路输出能力:

-

录像输出:边录边传,支持断点续录;

-

实时再发布:轻量级 RTSP/RTMP/HTTP-FLV 服务可立即开放访问。

▶ 系统数据流文字示意

bash

┌────────────┐

│ 摄像头模块 │ → H.264/H.265 编码流

└────┬───────┘

│

▼

┌──────────────┐

│ SmartPlayer │ ← RTSP 拉流 + 解码

│ ↳ SmartPlayerSetExternalRender(...) │

└────┬──────────┘

│ YUV + Timestamp

▼

┌────────────────────┐

│ LibPublisherWrapper │ ← 帧级处理 / 水印叠加

│ ↳ PostLayerImageI420ByteBuffer(...) │

└────┬────────────────┘

│ 原始帧投递

▼

┌────────────────────┐

│ SmartPublisherJniV2 │ ← 再编码 + 封装 + 推流

│ ↳ Recorder / RTSP / RTMP / FLV │

└────┬────────────────┘

│ 多路输出

▼

┌──────────────┬──────────────┐

│ 本地录像存档 │ 云端实时监控 │

└──────────────┴──────────────┘▶ 工程总结

在这条链路中,每一个环节都可以被启用或裁剪:

-

如果只需本地录像,可停用 RTSP 服务模块;

-

如果仅做云端推流,可跳过本地存档;

-

如果接入 AI 检测算法,可在 YUV 回调阶段直接送入模型输入端。

这种灵活的模块编排方式,使 SmartMediaKit 成为真正意义上的"多态视频引擎":同一套代码,可支撑检测机器人、无人机巡检、工业远程协作、安防监控、低空经济等多种场景。

六、行业意义:智能检测的"视觉基建"

在智能检测系统中,机械结构与传感器的升级只是"感知"的起点,真正决定系统智能化水平的,是视频链路的实时性与可编排性 。当视频流做到低延迟、可复用、可再分发,机器人就从执行工具变成具备视觉认知与协同能力的节点。

市政管网检测: 在复杂的地下环境中,SmartMediaKit 的 RTSP/RTMP 模块让检测画面实时回传,上位机指令可即时生效,现场与控制端实现"所见即响应"的协作闭环。

工业巡检与能源管廊: 通过 YUV 回调接口,画面帧可直接输入 AI 模型,实时识别裂纹、渗漏、温度异常等特征,并即时触发告警与任务派发,让巡检从"看见问题"变成"自动发现问题"。

应急救援与复杂地形作业: 在灾害、隧道或塌方等极端场景中,轻量级 RTSP/HTTP-FLV 服务可在设备端秒级启动,实时将前线画面传至指挥中心,为决策提供高可靠的"第二视角"。

大牛直播SDK(SmartMediaKit)不只是一个播放或推流组件,而是视觉通信的基础设施------让视频流像数据接口一样被调用、被复用、被编排。

-

对机器人而言,它是视觉感知与决策同步的"神经中枢";

-

对系统集成商而言,它是统一的实时通信底座;

-

对行业而言,它是从"可视化检测"迈向"智能化协同"的关键支撑层。

当视频成为系统级接口,"实时可视"不再只是画面播放,而是一种智能协作能力 。

SmartMediaKit 正在让这种能力,从单点设备扩展为行业级的**"视觉基建"**------让每一台机器都能看见、理解,并即时行动。

七、未来展望:从实时感知到智能协同

随着机器人、无人系统与AI检测的加速融合,"实时感知"正走向"智能协同" 。过去,视频系统的目标是让画面更清晰、更稳定;而未来,真正的竞争力,将在于多节点之间能否协同响应、共享认知、形成决策闭环。

SmartMediaKit 的进化方向,正是沿着这条路径前行。在当前已实现的 RTSP / RTMP / HTTP-FLV / WebSocket-FLV 基础上,它正逐步构建一个跨平台、跨节点、跨协议的实时视频计算底座------

既能服务于单机智能,也能支撑多设备的分布式视觉网络。

1️⃣ 从单机到多节点协同

未来版本将强化节点间的时钟同步与多路调度,让多个机器人、检测终端、摄像节点能够在毫秒级精度下协作。

这意味着:

-

多终端可在统一时间轴上拼接全景画面;

-

分布式 AI 节点可实现任务分流与结果复用;

-

上位系统可在同一链路中统一控制、统一记录。

2️⃣ 从视频流到"智能流"

视频将不再只是渲染素材,而成为数据流的一部分。SDK 将继续开放与 AI 模型层(如 SmartAIAdapter、YOLO/TensorRT/NCNN)的协同接口,让每一帧图像都具备被分析、被决策的价值。图像的"观看"与"理解"将同时发生,推动系统从"可视化"迈向"可理解化"。

3️⃣ 从系统模块到生态接口

SmartMediaKit 的终极形态,是一个可被自由嵌入、自由扩展的视觉生态接口层。打通"端---边---云"的低延迟链路,让视频不仅能被播放、推流,更能被 AI、控制系统、物联网中枢实时调用。

视频链的演进,其实就是智能体系的进化。当视频流具备了时序、语义与协同,它不再是信号,而是认知。SmartMediaKit 将持续以**"毫秒级感知、模块化协同、可编排生态"**为核心,构建智能系统时代的视觉底座------让每一次实时画面,都是系统智能的即时反馈。

📎 CSDN官方博客:音视频牛哥-CSDN博客