我自己的原文哦~ https://blog.51cto.com/whaosoft143/14239588

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

.

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#DMPO

天大等提出DMPO:解耦多预测器优化,30%算力超越对手70%性能

大家好,今天想和大家聊一篇非常有趣的新工作,它来自天津大学,并且已经被ICCV 2025接收。这篇论文旨在解决一个当前大模型领域非常实际的痛点:如何在保证模型性能的同时,大幅提升推理效率,让模型部署更轻快、更经济。

这项技术名为 DMPO (Decoupled Multi-Predictor Optimization) ,即"解耦多预测器优化"。简单来说,它通过一种巧妙的"分工"策略,让大模型在处理任务时,简单的样本可以"提前下班",无需跑完整个网络,从而大大节省计算资源。最惊人的是,实验证明,DMPO只用30%的算力,就能达到甚至超过其他方法70%算力下的性能。

- 论文标题: Decoupled Multi-Predictor Optimization for Inference-Efficient Model Tuning

- 作者: Liwei Luo, Shuaitengyuan Li, Dongwei Ren, Qilong Wang, Pengfei Zhu, Qinghua Hu

- 机构: 天津大学;Xiong'an National Innovation Center Technology Co., Ltd

- 论文地址: https://arxiv.org/abs/2511.03245

- 项目主页: https://github.com/TJU-sjyj/DMPO

- 录用会议: ICCV 2025

背景:早期退出(Early Exiting)的"两难困境"

近年来,大规模预训练模型(如Vision Transformer)效果拔群,但它们巨大的计算量也给实际部署带来了挑战。为了提升效率,研究者们提出了各种方法,其中"早期退出"(Early Exiting)是一个很有前景的思路。

它的核心思想是在模型的不同阶段(stage)加入一些小型的"预测器"(predictors)。当一个输入样本比较简单时,比如一张清晰的小猫图片,可能模型跑到前几个阶段就已经能非常有把握地识别出来了。这时,我们就可以让它"提前退出",直接输出结果,而不必走完后面更深、更复杂的网络层,从而节省了大量的计算。

然而,这个看似简单的想法在实践中却面临一个核心的"两难困境":

- 模型的浅层网络,天然适合提取一些基础、通用的特征(比如边缘、纹理),这些是"代表性"特征(representative ability),需要传递给深层网络做进一步分析。

- 早期退出预测器,则希望浅层网络能直接提供具有足够区分度的"判别性"特征(discriminative ability),以便做出准确预测。

让浅层网络同时做好这两件相互矛盾的事,就像要求一个员工既要打好基础支援后端,又要能独立在前线拿下订单,非常困难。之前的很多方法,比如Dyn-Adapter,试图解决这个问题,但在低算力(比如只用30% FLOPs)的情况下,性能往往会大幅下降。

DMPO:从架构到优化的双重解耦

为了破解这一难题,作者们提出了DMPO,它从"模型架构"和"优化策略"两个层面进行"解耦",让特征各司其职。

架构解耦:旁路模块 + 高阶统计预测器

首先,在模型结构上,DMPO引入了两个关键设计:

- 轻量级旁路模块 (Bypass Module, BYP) :在每个阶段,原始特征

X会被保留,用于传递给下一阶段,保证了基础特征的完整性。同时,一个轻量的旁路模块会处理X,生成一个专门用于当前阶段预测的、更具判别性的新特征X'。这样一来,传给深层网络的特征和用于当前预测的特征就分开了,互不干扰。 - 高阶统计预测器 (High-order Statistics-based Predictor, HP) :传统的线性预测器对于浅层的简单特征可能"心有余而力不足"。DMPO在早期阶段换上了一种更强大的预测器,它能捕捉特征的二阶统计信息(比如协方差),从而从有限的浅层特征中挖掘出更丰富的判别信息,提升早期预测的准确率。

上图的热力图非常直观地展示了这种解耦的效果。对于Dyn-Adapter,传递给下一阶段的特征和用于预测的特征是同一份(图b),显得比较"混乱"。而DMPO中,传递给下一阶段的特征(图c)保留了更多的基础表征,而送入预测器的特征(图d)则更聚焦于物体的判别性区域。

优化解耦:两阶段训练策略

有了好的结构,还需要聪明的训练方法。DMPO采用了一种"两阶段"的解耦优化策略,通过动态调整不同阶段预测器的损失权重(loss weight α)来实现:

- 第一阶段 (R2D - Representative to Discriminative) :在训练初期,给浅层阶段的预测器分配较小的权重(

α_early < α_deep)。这相当于告诉模型:"先别急着在前面就做对,首要任务是学好基础特征,服务好后面的深层网络。" 这保证了模型整体的"代表性"能力。 - 第二阶段 :随着训练的进行,逐步增大浅层阶段的权重(

α_early > α_deep)。现在基础打好了,模型开始被"激励"去加强浅层阶段的"判别性"能力,努力让更多样本能够提前、准确地退出。

这种"先打基础,再练绝活"的训练方式,有效地避免了能力发展的冲突,让模型在不同阶段的学习目标更加清晰。

实验效果:低算力下的王者

DMPO的效果究竟如何?一句话总结:非常出色。

作者在多个数据集(如VTAB-1K, CIFAR-100, FGVC)和多种预训练骨干(如ViT-B, DeiT-S, MAE)上进行了广泛验证。

- 性能超越 :在CIFAR-100和FGVC数据集上,DMPO在仅使用约30%算力(5.19 GFLOPs)的情况下,平均准确率达到88.08%,超过了使用70%算力(11.61 GFLOPs)的Dyn-Adapter(86.80%)和DyT(86.92%)。

- 稳定性强 :当算力从70%降至30%时,其他方法的性能会出现大幅"跳水"(如Dyn-Adapter下降5.13%),而DMPO的性能仅有0.49%的轻微下降,展现了极高的鲁棒性。

- 泛化性好:无论是在小样本学习、域泛化任务中,还是更换不同的预训练模型和微调模块,DMPO都表现出一致的优越性。

消融实验也证明了DMPO的每个组件都是有效的。上表显示,无论是单独使用新的多预测器架构(MPA),还是单独使用解耦优化策略(DO),性能都比基线(Dyn-Adapter)要好。而当两者结合时,性能达到最优。

总结

xxx认为,DMPO的思路非常巧妙,它没有去硬碰硬地解决"代表性"和"判别性"的直接冲突,而是通过架构和训练策略的解耦,让两者在不同"时空"(架构空间和训练时间)下得到发展,最终实现了和谐共存和性能飞跃。这种"分而治之"的哲学在模型设计中或许能给我们带来更多启发。

...

#AdaDEM

华中科大提出AdaDEM:解耦熵最小化,破解"奖励塌陷"与"易类偏见"难题

在机器学习领域,我们总是希望模型能给出自信而准确的预测。熵最小化(Entropy Minimization, EM)就是实现这一目标的经典方法之一,它通过鼓励模型输出更"尖锐"的概率分布(即高置信度),在各种任务中都发挥着重要作用。然而,经典EM方法并非完美,其内在的"耦合"机制限制了其潜能。

最近,来自华中科技大学的研究者们深入剖析了熵最小化的内部机理,并提出了一种全新的**自适应解耦熵最小化(Adaptive Decoupled Entropy Minimization, AdaDEM)**方法。该方法巧妙地解决了经典EM存在的"奖励塌陷"和"易类偏见"两大难题,在多个不完美监督学习(例如,数据标签稀缺、数据分布变化、存在噪声等)任务中取得了显著的性能提升。这项工作已被NeurIPS 2025接收。

- 论文标题: Decoupled Entropy Minimization

- 作者: Jing Ma, Hanlin Li, Xiang Xiang

- 机构: 华中科技大学

- 论文地址: https://arxiv.org/abs/2511.03256

- 代码仓库: https://github.com/HAIV-Lab/DEM/

熵最小化:一个耦合的困境

熵最小化(EM)的核心思想是降低模型预测的不确定性。然而,作者发现,传统的EM损失函数实际上是两种相反作用力的"耦合体":

- 聚类聚合驱动因子 (Cluster Aggregation Driving Factor, CADF): 这个力量会奖励置信度最高的那个类别,驱使模型输出的概率分布向着某个顶点"坍缩",从而形成紧凑的特征簇。

- 梯度缓和校准器 (Gradient Mitigation Calibrator, GMC): 这个力量则像一个"刹车",它会根据预测概率惩罚那些已经非常自信的类别,防止模型变得过于"自负"。

上图直观地展示了这种解耦思想。上侧是经典EM,中间是作者为了分析而构建的DEM*(通过超参数τ和α来分别调整两部分),下侧则是该文最终提出的AdaDEM。

这种看似和谐的耦合设计,却隐藏着两个关键缺陷:

- 奖励塌陷 (Reward Collapse): 当模型对一个样本的预测置信度趋近于1时,EM损失产生的梯度(即奖励信号)会迅速衰减至0。这意味着,那些已经被模型"学会"的样本,在后续的优化过程中几乎不再贡献任何力量,从而限制了模型性能的进一步提升。

- 易类偏见 (Easy-Class Bias): 由于GMC的存在,EM倾向于惩罚所有高置信度的预测,这会导致模型输出的整体类别分布与真实的标签分布产生偏差,尤其偏爱那些更容易学习的类别。

上图左侧清晰地展示了"奖励塌陷"现象:随着预测概率接近1,梯度迅速掉到0。右侧则显示了经典EM方法在ImageNet-C数据集上表现出的"易类偏见",其输出的类别分布与真实的类别分布相去甚远,而AdaDEM则拟合得更好。

AdaDEM:自适应解耦熵最小化

针对上述两个问题,作者提出了自适应解耦熵最小化 (AdaDEM),通过两个核心创新来"解耦"这个困境:

归一化奖励以克服"奖励塌陷"

为了解决奖励塌陷问题,AdaDEM引入了一个非常简洁而有效的策略:对CADF产生的奖励进行L1范数归一化。通过这一操作,无论样本的原始置信度有多高,归一化后的奖励信号都能保持在一个稳定的量级。这确保了即使是高置信度的样本也能持续为模型优化做出贡献,从而打破了性能瓶颈。

边际熵校准器(MEC)以减轻"易类偏见"

为了解决易类偏见,作者设计了**边际熵校准器 (Marginal Entropy Calibrator, MEC)**来替代原有的GMC。与GMC只关注单个样本的预测分布不同,MEC着眼于全局,它会估计整个数据集上的边际类别分布(即模型对所有类别的平均预测倾向),并用这个先验分布来校准梯度。这使得模型能够感知全局的类别信息,从而减少对部分易学类别的过度偏爱,使得最终的输出分布更接近真实的标签分布。

具体细节请查看论文原文。

全方位超越:从TTA到强化学习

论文通过一系列详尽的实验,在多个充满噪声和动态变化的环境中验证了AdaDEM的有效性和泛化能力。

测试时自适应(TTA)与半监督学习

在单域和连续测试时自适应(TTA)任务中,AdaDEM的表现非常出色,其性能全面超越了包括经典EM及其上限变体DEM*在内的多种基线方法。

在半监督学习任务中,无论带标签的样本数量多少,AdaDEM都能带来稳定的性能增益。

鲁棒性与泛化性

消融实验清晰地证明了归一化奖励和MEC两个模块各自的贡献。一个特别亮眼的发现是,AdaDEM对学习率的敏感度大大降低,其鲁棒学习率范围扩大了10倍。这意味着在实际应用中,AdaDEM的调参过程会更加轻松和高效。

此外,实验还拓展到了更具挑战性的场景,如无监督域自适应的语义分割、类别不平衡分类以及强化学习,AdaDEM都展示了其强大的适用性和稳健的性能提升。

总结

xxx认为,这篇论文对经典熵最小化方法的深刻洞察和巧妙改进非常值得称道。AdaDEM不仅效果显著,而且思路清晰,实现简单,极具成为一个"即插即用"的优化模块的潜力。作者已经开源了代码,强烈建议感兴趣的同学去深入研究和尝试。

...

#S²-Transformer

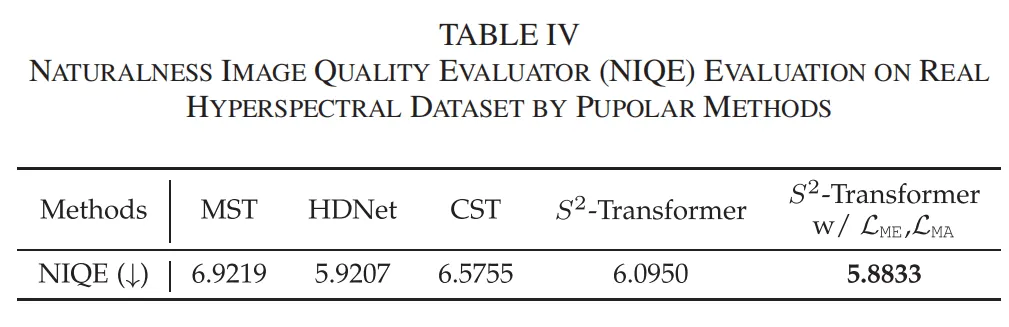

顶刊新成果:S²-Transformer 以物理驱动设计,赋能高光谱图像重建全局 - 局部细节精准恢复

S2-Transformer用并行注意力解纠缠、掩膜加权补黑洞,快照高光谱重建PSNR立涨0.4 dB,更小模型更强细节。

你有没有想过,卫星从太空拍摄的农田照片,不仅能看清作物的形状,还能分析出每一片叶子的"健康密码"?这背后靠的就是高光谱成像技术------它能捕捉肉眼看不到的光谱细节,在遥感、医疗、天文等领域大显身手。

但高光谱成像有个老大难问题:数据量太大了!传统设备要么拍得慢,要么拍得糊。近年来流行的"快照压缩成像(SCI)"技术,比如编码孔径快照光谱成像仪(CASSI),能一次性把三维高光谱数据压缩成二维图像,但这就像把彩色拼图强行塞进黑白相册,信息全缠在了一起,还会因为"掩膜"遮挡丢失部分数据,重建起来特别费劲。

最近,来自国内的研究团队提出了一种叫"S2-Transformer"的新方法,专门解决这些难题。今天就带大家看看,这个黑科技是怎么让高光谱图像重建精度飙升的!

论文信息

题目:S2-Transformer for Mask-Aware Hyperspectral Image Reconstruction

基于掩膜感知的高光谱图像重建的S2-Transformer方法

作者:Jiamian Wang, Kunpeng Li, Yulun Zhang, Xin Yuan, Zhiqiang Tao

01 高光谱成像的两大"拦路虎"

先给大家科普下CASSI的工作原理:它就像一个"光学魔术师",先用一张物理掩膜(类似带孔的挡板)对高光谱数据进行编码,再通过色散器把不同波长的光"错位叠加",最后生成一张二维的测量图。但这个过程会带来两个大麻烦

- 信息纠缠

不同波长的空间细节被强行"挤"在一张图里,就像把红、绿、蓝三种颜色的画叠在一起,想分开看清每种颜色的细节难上加难。

- 掩膜数据丢失

掩膜会遮挡部分光线,被挡住的区域就像照片上的"黑洞",原始信息没了,重建时很容易出错。之前的方法要么只关注空间信息,要么只盯着光谱特征,而且对掩膜区域和正常区域"一视同仁",导致重建结果要么细节模糊,要么被遮挡的地方修复得乱七八糟。

02 S2-Transformer:双管齐下解决难题

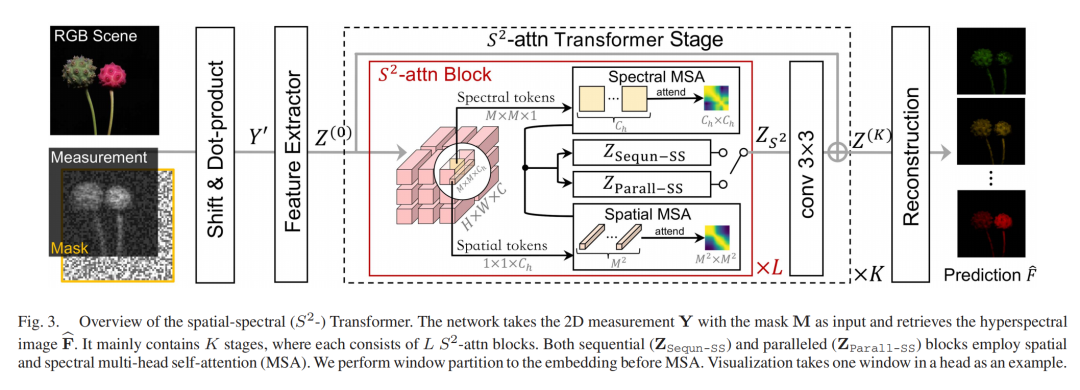

研究团队提出的S2-Transformer(空间光谱Transformer),就像给高光谱重建装了"双引擎",一边精准拆分纠缠的信息,一边重点修复掩膜区域。先来看它的整体架构:

S2-Transformer总体架构

整个网络分为三部分:

- 特征提取器:用3×3卷积层把输入数据转换成特征向量

- S2-attn Transformer阶段:核心部分,通过多个注意力块处理空间和光谱信息

- 重建头:把处理好的特征转换回高光谱图像

而最关键的,就是中间的"并行空间光谱注意力"和"掩膜感知学习"两大绝技。

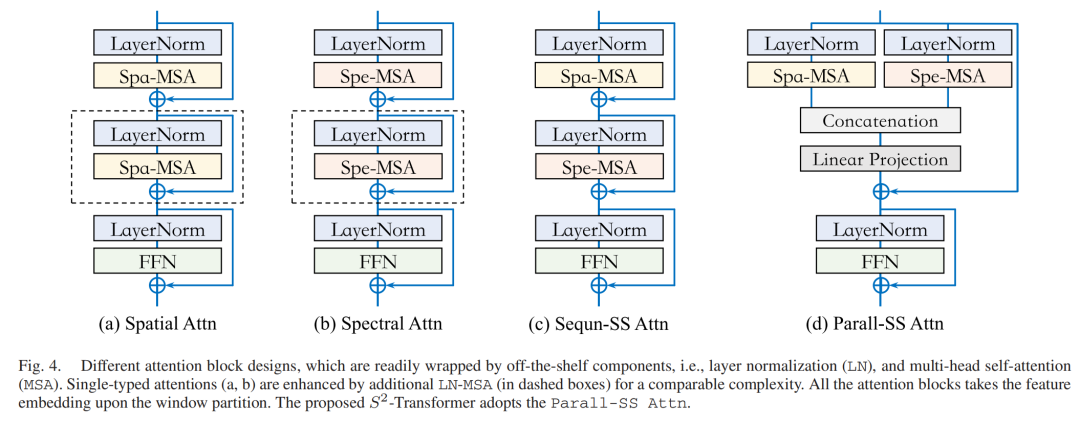

2.1 绝技一:并行注意力,同时抓牢空间和光谱细节

之前的方法要么只用空间注意力(关注像素间的关系),要么只用光谱注意力(关注不同波长的关联),各有各的短板:

- 空间注意力像"近视眼":能看清像素之间的联系,却看不清每个像素在不同波长下的变化

- 光谱注意力像"老花镜":能分析波长规律,却抓不住精细的空间细节

研究团队设计了"并行空间光谱注意力",让两种注意力同时工作,再用可学习的方式融合结果,就像两只眼睛一起看东西,既看得广又看得细。

四种注意力结构对比

从上图可以看到,并行结构(d)比单独的空间(a)、光谱(b)或顺序结构(c)效果好得多。实验显示,这种设计能让重建的PSNR(峰值信噪比)提升0.4dB以上,细节更清晰。

2.2 绝技二:掩膜感知学习,给"黑洞区域"开小灶

被掩膜遮挡的区域重建难度大,但之前的损失函数对所有像素"一碗水端平",导致这些区域总是拖后腿。S2-Transformer的解决思路很简单:难啃的骨头重点啃!

掩膜感知学习策略

它通过两步操作实现:

- 先预训练模型,让它学会识别哪些是掩膜区域(通过拟合编码信号F')

- 正式训练时,给掩膜区域的损失"加权重",让模型更关注这些难修复的地方

就像老师辅导学生,会给基础差的同学多分配精力。理论分析显示,这种策略能让掩膜区域的收敛速度更快,而正常区域不受影响。看下面的对比图,普通方法(a)在掩膜区域(黑色部分)修复得很模糊,而S2-Transformer(b)能精准还原细节:

掩膜区域重建对比

03 实验效果:全方位碾压现有方法

说了这么多,实际效果怎么样?团队在模拟数据和真实数据上做了大量实验,结果相当亮眼。

3.1 定量指标领先

在CAVE和KAIST数据集上,S2-Transformer的PSNR(数值越高越好)比当前最先进的CST方法高0.4dB,比MST方法高1.3dB;SSIM(结构相似性)也全面领先。

更难得的是,它的计算成本还更低------模型大小和浮点运算量(FLOPs)在Transformer类方法中是最小的,兼顾了精度和效率。

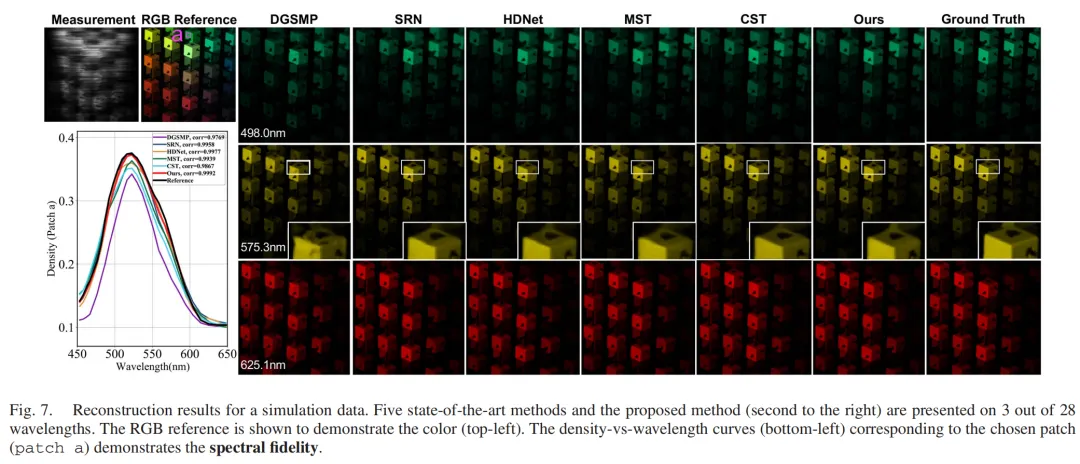

3.2 视觉效果惊艳

看下面三个波长的重建对比,S2-Transformer能恢复更多细节,比如红色框里的纹理,放大后也几乎没有失真:

不同波长重建结果对比

在真实测量数据上,它的优势更明显。比如下面的黄色花朵区域,S2-Transformer能清晰还原花心的小孔洞,而其他方法要么模糊要么丢失细节:

真实数据重建对比

甚至在地质遥感数据上,它也能精准区分不同的地表特征,为资源勘探、环境监测提供更可靠的依据。

04 总结:给高光谱成像装上"智能修复引擎"

S2-Transformer的创新点可以总结为:

- 提出并行空间光谱注意力,解开空间和光谱信息的"纠缠结"

- 设计掩膜感知学习策略,给被遮挡区域"特殊照顾"

- 在精度和效率上实现双赢,适用场景更广泛

这项研究不仅让高光谱图像重建质量上了一个新台阶,还为类似的压缩成像问题提供了新思路------从物理原理出发设计网络,往往能事半功倍。未来,随着技术的落地,我们或许能看到更清晰的卫星遥感图像、更精准的医疗诊断光谱图,甚至手机也能拍出高光谱照片。让我们期待这个黑科技带来更多惊喜!

...

#SAM2-UNeXT

SAM2-UNeXT联手DINOv2,双分辨率+密集粘合层,碾压BiRefNet刷新DIS-VD S-measure

SAM2-UNeXT 通过双分辨率策略并行 SAM2 与 DINOv2 编码器,用密集粘合层融合局部细节与全局语义,在四个二值分割基准上刷新 S-measure、mIoU 等指标,代码已开源。

精简阅读版本

本文主要解决了什么问题

- SAM模型在某些场景下泛化能力受限的问题,特别是在全局语义上下文捕获方面存在局限。

- 如何构建更强大且更具泛化能力的编码器以进一步提升分割性能的问题。

- 传统分割网络通常需要复杂的解码器设计,但一旦知识在编码阶段丢失,就无法在解码阶段完全恢复的问题。

- 如何高效整合多个基础模型以充分利用它们互补优势的问题。

本文的核心创新是什么

- 提出了SAM2-UNeXT框架,通过整合辅助的DINOv2编码器扩展了SAM2的表征能力,实现两个基础模型的协同工作。

- 引入双分辨率策略,让SAM编码器在更高分辨率输入(1024×1024)上运行,而DINOv2编码器处理更低分辨率的输入(448×448),提高计算效率。

- 设计了密集粘合层,通过通道对齐、空间调整和特征融合策略有效整合SAM2和DINOv2的特征,实现互补优势。

- 采用U-Net风格的解码器,并引入额外的部分解码器,提高最终分割特征图的分辨率,有利于边界分割精度敏感的任务。

结果相较于以前的方法有哪些提升

- 在二值图像分割任务上,在DIS-VD子集上将S-measure提升了1.2%,整体性能优于BiRefNet等先前方法。

- 在伪装目标检测任务上,在CHAMELEON数据集上将S-measure提升了2.8%,在所有指标上均实现持续改进。

- 在海洋动物分割任务上,在MAS3K数据集上将mIoU提升了5.4%,显著优于现有方法。

- 在遥感显著性检测任务上,在ORSI-4199数据集上在S-measure上实现了1.1%的提升,在两个数据集上均优于所有竞争方法。

- 在各种复杂场景下(如细粒度的树枝、复杂的多目标组合、光照变化以及具有网格结构和阴影干扰的场景)表现出更优的分割精度,有效处理曲线边缘、细小结构和微妙的视觉边界。

局限性总结

- 双分辨率策略虽然提高了计算效率,但仍然需要处理两个不同分辨率的输入,增加了计算复杂度。

- DINOv2编码器的参数被完全冻结,没有进行微调,可能限制了其在特定任务上的适应能力。

- 模型在所有任务上均以批量大小为1进行训练,可能影响训练效率和模型稳定性。

- 虽然框架具有可扩展性,但论文中只测试了DINOv2作为辅助编码器,其他类型编码器的效果尚未充分探索。

- 在更高分辨率配置下(如DINOv2分支使用672×672),推理成本显著增加,使得这种配置不太实用。

导读

近期研究强调了将Segment Anything Model (SAM)应用于各种下游任务的潜力。然而,构建一个更强大且更具泛化能力的编码器以进一步提升性能仍然是一个开放性挑战。在本工作中,作者提出了SAM2-UNeXT,一个基于SAM2-UNet核心原理的先进框架,通过整合一个辅助的DINOv2编码器扩展了SAM2的表征能力。通过引入双分辨率策略和密集粘合层,SAM2-UNeXT能够在简单架构下实现更精确的分割,减轻了对复杂解码器设计的依赖。在包括二值图像分割、伪装目标检测、海洋动物分割和遥感显著性检测在内的四个基准测试中进行的广泛实验,证明了SAM2-UNeXT具有优越的性能。

代码 https://github.com/WZH0120/SAM2-UNeXT

01 引言

基础模型在计算机视觉、自然语言处理、智能医疗、自动驾驶以及其他领域中正发挥着日益关键的作用。在图像分割领域,Segment Anything模型(SAM)系列引起了广泛关注。传统的较小分割网络通常将大量设计精力投入到复杂的解码器模块中。然而,一个基本局限性依然存在:一旦知识在编码阶段丢失,就无法在解码阶段完全恢复。相比之下,基础模型凭借其庞大的参数容量和复杂的预训练策略来学习高质量的表征,即使采用相对简单的解码器架构也能实现精确的分割性能。

尽管基础模型展现出强大的泛化能力,特定任务的适配,例如参数高效微调(PEFT),对许多下游应用仍然至关重要。近期方法通过将轻量级 Adapter 、LoRA模块或类似组件集成到编码器中,并结合解码器优化策略,取得了显著成果。然而,单纯依赖SAM在某些场景下仍会导致泛化能力受限。例如,在ImageNet分类任务中,SAM编码器的线性 Prob 精度显著低于CLIP和DINOv2等其他大型模型。一个合理的解释是,SAM的类无关分割预训练会导致表征偏差,倾向于捕捉细粒度的局部细节,而忽略了全局语义上下文的捕获。

基于上述分析,作者提出了SAM2-UNeXT,这是一个统一且可扩展的框架,它协同整合了多个基础模型,包括SAM2 和DINOv2,以充分利用它们在细节感知和语义表示方面的互补优势。所提出的SAM2-UNeXT具有以下关键优势:

简洁性。SAM2-UNeXT简化了任何额外的注意力设计,并专注于轻量级且高效的编码器融合策略。

可扩展性。凭借对动态分辨率调整和灵活的辅助编码器配置的支持,SAM2-UNeXT可以方便地适应广泛的下游任务。

有效性。在四个公共基准数据集上的大量实验表明,SAM2-UNeXT在有限的训练轮次下,能够在各种场景中始终实现优异的分割性能。

2 方法

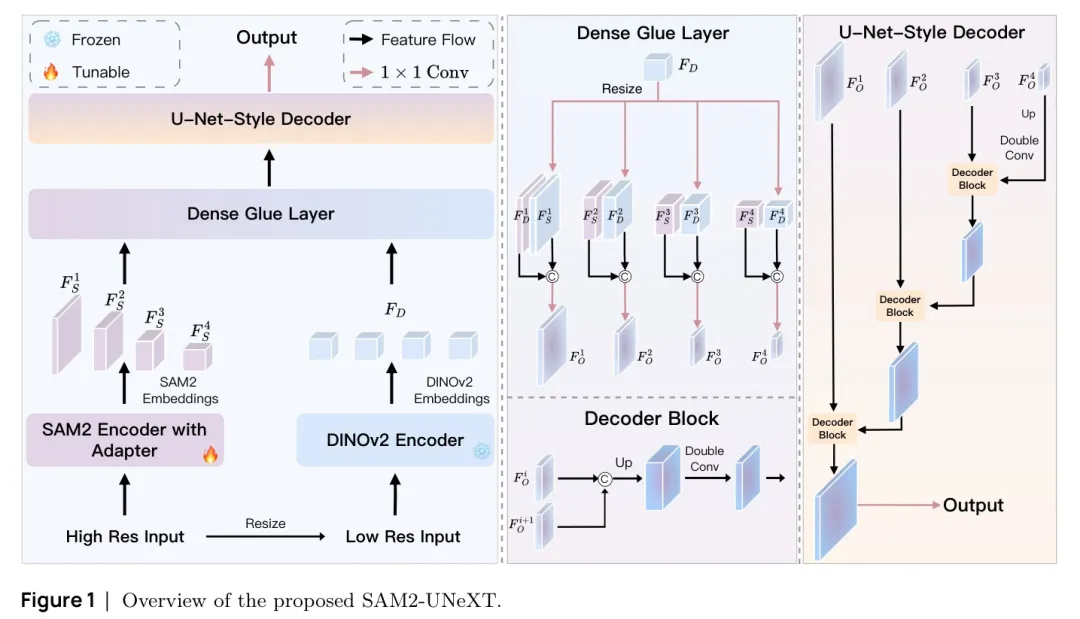

如图1所示,所提出的架构由四个关键组件构成:SAM2编码器、DINOv2编码器、密集粘合层和U-Net风格的解码器。

2.1 SAM2编码器

在这个阶段,作者紧密遵循SAM2-UNet 的实践,从SAM2中采用Hiera 编码器并冻结其所有原始参数。通过在每个Hiera模块之前插入轻量级 Adapter 进行参数高效微调(PEFT)。该 Adapter 采用简单的"MLP-GeLU-MLP-GeLU"结构,具有32通道 Bottleneck 。

2.2 DINOv2编码器

与Segment Anything系列相比,DINOv2作为一个更通用的视觉基础模型,通过自监督学习训练,展现出在广泛视觉任务(包括分类、分割和深度估计)上的强大迁移能力。遵循原始实现方案,作者冻结了所有DINOv2参数,且未采用任何参数高效的微调策略,以平衡训练效率和性能。

2.3 双分辨率设计

将两个大型编码器直接结合的一种简单方法是处理相同分辨率的输入;然而,这种方法在计算上效率低下。特别是对于依赖于标准自注意力机制的DINOv2,提高输入分辨率会导致计算成本大幅增加。考虑到SAM专注于细粒度的局部细节,而DINOv2强调全局语义理解,作者采用双分辨率策略:SAM编码器在更高分辨率的输入 上运行,而DINOv2编码器处理更低分辨率的输入

2.4 密集粘合层

与Hiera的层次化设计不同,DINOv2采用的vanilla Vision Transformer 架构在每一层都生成非层次化、尺度一致的嵌入。利用此类transformer特征的一种常见方法 是增强层次化编码器的最终特征图。相反,作者采用了一种密集融合策略,该策略灵感来源于DINOv2展现出强大零样本能力的观察:其编码表示在主成分分析后变得高度可解释,无需任何微调即可有效突出感兴趣的前景,换句话说,这些特征可被视为富含全局语义信息的空间注意力图。

基于此,作者首先应用四个1×1卷积来对齐DINOv2特征(DINOv2-L的1024个通道)与SAM2编码器四个阶段的特征(Hiera-L的144、288、576和1152个通道)的通道维度。接下来,将DINOv2特征调整大小以匹配每个相应SAM2特征图的空间维度,并通过简单的通道级拼接进行融合。最后,通过1×1卷积将拼接后的特征压缩至128个通道,以提高训练效率。

2.5 U-Net风格解码器

在这个阶段,作者主要遵循SAM2-UNet的设计,通过将SAM2中的基于transformer的解码器替换为U-Net风格的解码器,其中每个解码器块由两个连续的"Conv-BN-ReLU"层组成。主要区别在于作者引入了一个额外的部分解码器,该解码器不进行特征拼接,从而总共形成四个解码阶段。这种修改将最终分割特征图的分辨率提高到高分辨率输入的一半(而不是四分之一),这对于对边界分割精度敏感的任务是有利的。

03 实验

3.1 数据集和基准测试

作者在涵盖多种分割任务的四个公共基准数据集上进行了实验:

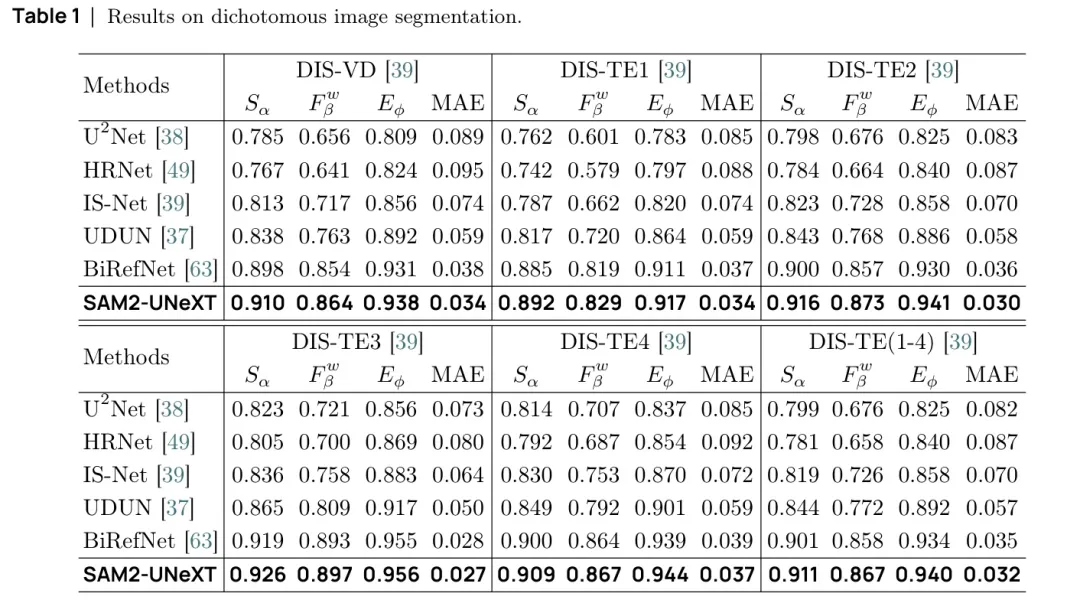

二值图像分割。作者使用DIS5K数据集进行评估。训练集(DIS-TR)包含 3000 张图像,而评估是在五个子集上进行的:DIS-VD(470)、DIS-TE1(500)、DIS5K-TE2(500)、 DIS-TE3(500)和DIS-TE4(500)。性能使用四个指标进行衡量:S度量-、加权 F 度量 、平均 E 度量 [11]和平均绝对误差 (MAE)。

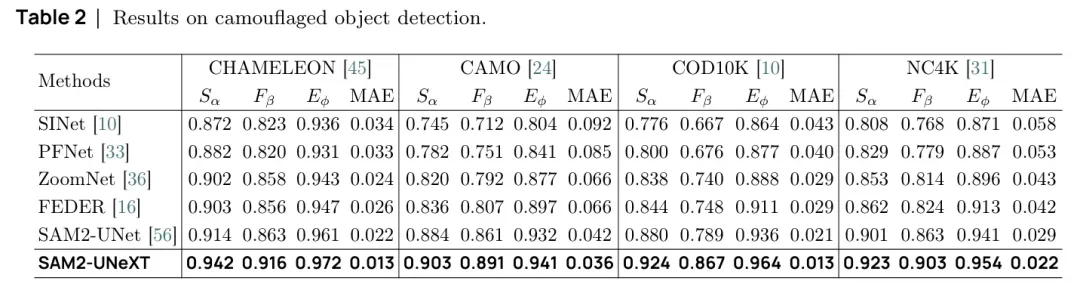

伪装目标检测。作者在四个数据集上进行了评估:CHAMELEON、CAMO、COD10K 和 NC4K。统一训练集包含 4,040 张图像(其中 3,040 张来自 COD10K, 1,000 张来自 CAMO)。其余的 CHAMELEON( 76 张)、CAMO( 250 张)、COD10K( 2,026张)和 NC4K( 4,121 张)图像用于测试。作者使用 S-measure( )、自适应 F-measure 、平均 E -measure( )和平均绝对误差(MAE)报告结果。

海洋动物分割。该任务使用了两个数据集:MAS3K,包含1,769张训练图像和1,141张测试图像;以及RMAS,包含 2,514 张训练图像和 500 张测试图像。评估基于五个指标:mloU、 S 度量 、加权 F 度量 、平均 E 度量 和平均绝对误差(MAE)。

遥感显著性检测。作者使用了两个数据集:EORssD,包含 1,400 张训练图像和 600 张测试图像;以及ORS1-4199,包含 2,000 张训练图像和 2,199 张测试图像。评估使用了五个指标: S 度量 、平均 F 度量( )、最大 F 度量( )、平均 E 度量( )和平均绝对误差(MAE)。

3.2 实现细节

SAM2-UNeXT在PyTorch中实现,并在配备24 GB内存的NVIDIA RTX 4090 GPU上进行训练。作者使用AdamW优化器,初始学习率为 0.0002 ,并应用余弦学习率衰减来稳定训练。整体损失函数由加权交叉嫡损失 和加权IoU损失 组成。在训练过程中采用了两种数据增强策略,包括随机水平墥转和垂直翻转。除非另有说明,作者采用SAM2和DINOv2的大版本。SAM2分支的输入分辨率设置为 ,DINOv2分支的输入分辨率设置为 。所有模型在所有任务上均以批量大小为1进行20个epoch的训练。

3.3 与当前最先进方法比较

在本小节中,作者首先分析了跨多个基准的定量结果,随后对二元图像分割进行了定性的视觉比较。

二值图像分割。结果如表1所示,SAM2-UNeXT在第二优方法BiRefNet之上实现了稳定的性能提升。具体而言,在DIS-VD子集上,SAM2-UNeXT将S-measure提升了1.2%。

伪装目标检测。结果如表2所示。与SAM2-UNet相比,新的SAM2-UNeXT在所有指标上均实现了持续改进。例如,在CHAMELEON数据集上,SAM2-UNeXT将S-measure提升了2.8%。

海洋动物分割。结果如表3所示。SAM2-UNeXT在现有方法中显著表现优异。例如,在MAS3K数据集上,SAM2-UNeXT将mIoU提升了5.4%。遥感显著性检测。结果如表4所示。SAM2-UNeXT在两个数据集上均优于所有竞争方法。值得注意的是,在ORSI-4199数据集上,SAM2-UNeXT在S-measure上实现了1.1%的提升。

定性比较。图2展示了在二元图像分割任务上的视觉比较。SAM2-UNeXT在多种场景中表现出更优的分割精度:细粒度的树枝(第1行)、复杂的多目标组合(第2行)、光照变化(第3行)以及具有网格结构和阴影干扰的场景(第4行)。SAM2-UNeXT有效处理曲线边缘、细小结构和微妙的视觉边界,即使在具有挑战性的条件下也能提供更好的分割结果。

3.4 讨论

在本节中,作者以MAS3K作为代表性基准,分析了SAM2-UNeXT的设计选择。

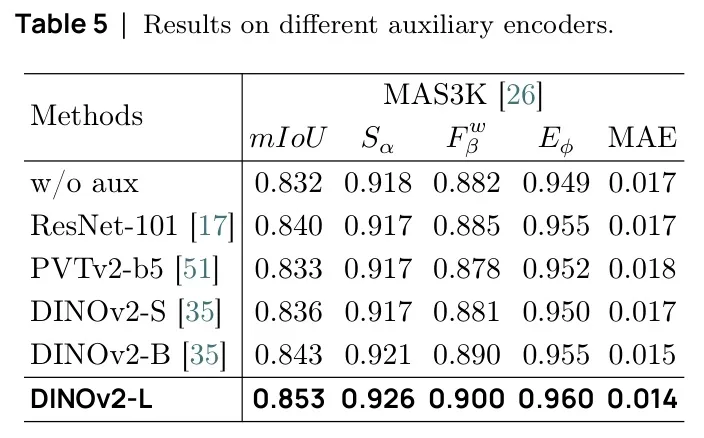

辅助编码器的影响

作者研究了不同辅助编码器设计的影响,如表5所示:

第一行 辅助编码器被移除。在这种情况下,模型大致成为SAM2-UNet的高分辨率变体。尽管其性能优于SAM2-UNet的低分辨率版本,但其准确率仍低于带有辅助编码器的配置。

第2行和第3行。作者使用ResNet-101 PVTv2-b5 作为辅助编码器,其参数可训练。结果表明,与不使用辅助编码器的设置相比,改进效果微乎其微,这表明在简单的融合策略下,这些传统 Backbone 网络带来的好处有限。

第4行和第5行。作者将辅助编码器替换为冻结的小型和基础版本的DINOv2。结果表明,较大的变体通常能获得更好的性能。

动态分辨率的影响

作者还探讨了不同分辨率组合的影响,如表6所示:

第一行. SAM2和DINOv2编码器均在统一的低分辨率352×352下运行。这一设置导致在所有测试配置中性能最低,尽管它仍然优于原始的SAM2-UNet Baseline。

第2行。SAM2分支的高分辨率固定为1024×1024,而DINOv2分支的低分辨率降低至224×224。与448×448设置相比,观察到轻微的性能下降,但它仍然优于均匀的352×352情况。

第3行。高分辨率保持在1024×1024,而低分辨率增加到672×672。与448×448设置相比,性能差异可以忽略不计,但推理成本显著增加,使得这种配置不太实用。

4 相关工作

4.1 融合基础模型

近年来,整合不同基础模型已成为一种常见策略。许多视觉语言模型(Vision-Language Models, VLMs)由一个视觉编码器与一个大语言模型(Large Language Model, LLM)配对组成,能够根据不同应用需求进行灵活组合。对于SAM系列,已有若干研究通过整合CLIP来提升语言理解能力。其他研究则聚焦于通过集成预训练视觉编码器(如DINOv2 )来增强少样本分割能力,以Matcher 为例。与作者研究最相关的是,该研究同样引入了一个辅助DINOv2编码器来构建U型架构。然而,他们的重点在于设计更复杂的解码器结构,例如内容引导注意力机制和小波卷积。

4.2 图像分割

图像分割被视为像素级分类任务,可以广泛分为二值分割、语义分割、实例分割和全景分割等类别。本研究聚焦于二值分割,其中所有前景像素被分配到单一类别,其余像素被视为背景。二值分割是许多重要应用领域的基础,包括二值图像分割、伪装目标检测、海洋动物分割以及遥感显著性检测。现有方法大多倾向于为每种分割场景设计特定的解码器。相比之下,SAM2-UNeXT引入了一个统一框架,该框架能够通过单一模型架构在多个二值分割任务中实现最先进性能。

5 结论

本文介绍了SAM2-UNeXT,一个简单而有效的框架,通过解耦分辨率策略将两个强大的基础模型SAM2和DINOv2进行整合。该设计利用了每个模型的互补特征偏差,从而提升了分割性能。在四个基准数据集上的大量实验验证了该方法的有效性和泛化能力。此外,SAM2-UNeXT具有高度可定制性,非常适合适应各种下游任务。通过调整动态分辨率配置或结合替代的辅助编码器,该框架有望将基于SAM2的模型扩展到此前未充分探索的分割场景。

参考

1\]. SAM2-UNeXT: An Improved High-Resolution Baseline for Adapting Foundation Models to Downstream Segmentation Tasks ... ##### #Sparse Model Inversion 清华\&南洋理工等提出稀疏模型反演:ViT反演加速高达3.79倍,告别无效背景! 最近和大家聊了不少关于数据的话题,特别是在数据隐私和版权日益重要的今天,如何"无米之炊"------在没有原始训练数据的情况下,让AI模型继续发光发热,成了一个热门的方向。今天,我们就来深入探讨一篇非常有意思的工作,来自清华大学(深圳)、南洋理工大学、中山大学等机构的研究者们提出的《Sparse Model Inversion: Efficient Inversion of Vision Transformers for Data-Free Applications》。 这篇论文的核心,在于解决一个叫做"模型反演"(Model Inversion)的技术难题。简单来说,模型反演就像是AI世界的"读心术",它试图从一个已经训练好的模型里,反向推导出当初用来训练它的数据长什么样。这项技术在很多"无数据"场景下特别有用,比如模型压缩、知识迁移等等。但问题是,现有方法在处理像Vision Transformer(ViT)这样的大模型时,效率非常低下。 而这篇论文提出的**稀疏模型反演(Sparse Model Inversion, SMI)** ,就是一把锋利的"手术刀",它能精准地剔除反演过程中的冗余信息,让整个过程变得又快又好,实现了最高**3.79倍**的加速! 下面,我们一起来看看这项工作的基本信息。 * **论文标题**: Sparse Model Inversion: Efficient Inversion of Vision Transformers for Data-Free Applications * **作者团队**: Zixuan Hu, Yongxian Wei, Li Shen, Zhenyi Wang, Lei Li, Chun Yuan, Dacheng Tao * **所属机构**: 清华大学(深圳)、南洋理工大学、中山大学、京东探索研究院、马里兰大学帕克分校 * **论文地址**: https://arxiv.org/abs/2510.27186 * **代码仓库**: https://github.com/Egg-Hu/SMI 现有方法错在哪?"全面反演"的低效困境 想象一下,让你根据记忆画一幅画,画的核心是一只猫,但你却花费了大量精力去描绘猫后面那堵纯白的墙和杂乱的背景。这显然是低效的。 传统的"密集"模型反演(Dense Model Inversion)方法就面临着类似的窘境。它们试图重建图像的每一个像素,不分主次。作者一针见血地指出了这种策略的两个核心弊病: 1. **冗余的背景反演**:模型在反演时,会浪费大量计算资源去生成那些对语义理解毫无帮助的背景噪声。 2. **意外的"幻觉"**:模型在训练时可能会学到一些虚假的关联,比如"牛总是出现在草地上"。在反演时,模型会"脑补"出这些背景,产生所谓的"幻觉"(Hallucination)现象,这不仅影响效率,还可能干扰下游任务。 上图很直观地展示了密集反演的弊端:不仅要费力处理(a)中无意义的背景,还要应对(b)中模型自己"脑补"出来的虚假前景-背景关联。 实验数据也证实了这一点:在反演过程中,背景区域对分类损失的降低贡献微乎其微。这意味着,计算资源被大量错配了。 稀疏之美:只反演"重要"的部分 既然问题找到了,解法也就清晰了:我们能不能只反演那些包含核心语义信息的"前景"区域,而忽略掉无关紧要的"背景"呢? 这正是SMI的核心思想。它像一个聪明的艺术家,懂得在创作时有所取舍,聚焦于最重要的主体。 SMI的实现方式非常巧妙,它是一个即插即用的模块,无需修改现有反演方法的损失函数。其具体流程如下: 1. **输入与输出**:SMI的输入是一个预训练好的ViT模型和一个目标类别(比如"猫"),输出则是一张仅包含核心语义信息的稀疏图像。 2. **重要性评估**:在反演的每个阶段,SMI会评估图像中每个patch(小块)的重要性。作者发现,一个简单的基于分类损失的策略就非常有效:如果某个patch的移除不会显著增加模型的分类损失,那么它很可能就是不重要的背景。 3. **渐进式停止**:SMI并不会一次性丢掉所有背景,而是采用一种"渐进式"的策略。在反演过程中,它会分阶段地、逐步地"冻结"那些被判定为不重要的patch,不再对它们进行梯度计算和更新。 上图清晰地展示了SMI的完整流程。随着反演的进行,越来越多的背景patch(黑色块)被"停用",计算资源被集中用于优化真正的前景patch。最终,我们得到一张稀疏但信息量十足的图像。 xxx觉得,这种"渐进式剪枝"的思路非常优雅,它在计算效率和生成质量之间找到了一个绝佳的平衡点。 效果如何?又快又好! 理论说得再好,终究要靠实验结果说话。SMI在两个主流的无数据应用场景------模型量化和知识迁移中,都表现出了卓越的性能。 无数据模型量化 在模型量化任务中,研究者使用SMI生成的稀疏数据来校准量化参数。结果显示,相比于使用密集反演数据的方法(如DeepInversion),SMI不仅取得了相当甚至更好的模型精度,同时还大幅提升了数据生成的速度。 从上表中可以看到,加速效果实现了2.57至3.79倍,同时计算量(FLOPs)降低74.09%-75.62%,GPU内存占用减少57.42%-62.98%。 无数据知识迁移 在知识迁移(也称知识蒸馏)任务中,目标是让一个小模型(学生)学习一个大模型(教师)的能力。SMI生成的稀疏数据同样胜任了这一任务。 实验结果表明,使用SMI生成的稀疏数据进行训练,学生模型的性能与使用密集数据相当,但训练过程的收敛速度更快,效率更高。 上图的对比曲线非常能说明问题:在训练损失(左)和验证精度(右)上,使用稀疏数据(蓝色曲线)的收敛速度明显优于密集数据(橙色曲线)。 作者还展示了SMI从不同模型和数据集中反演出的图像,效果相当惊艳,无论是自然图像还是细粒度的花卉、鸟类,SMI都能准确捕捉到核心特征。 总而言之,SMI通过一种简单而有效的方式,解决了大模型时代模型反演的效率瓶颈。它告诉我们,在AI的世界里,有时候"少即是多",精准的取舍远比大而全的堆砌更加高效。作者已经开源了代码,感兴趣的朋友不妨去亲自体验一下。 ...