摘要

AI Agent 已从单智能体工具进化为复杂系统,成为企业降本增效、价值重构的核心引擎。本文聚焦三大高级架构 ------ 多智能体系统(协作 / 竞争 / 分工)、分层决策系统(管理者 - 工作者模式)、人类在环机制,从底层原理、技术细节、优化策略到行业落地进行全维度拆解。结合 MetaGPT、CrewAI 等主流框架实操,融入通信协议(MCP/ACP/A2A/ANP)、分层强化学习(NSGA-II+PPO)等核心技术,搭配真实企业案例与可复用代码片段,帮助架构师、开发工程师快速落地复杂 Agent 系统。无论你是 AI 领域研究者还是企业技术决策者,都能从本文获得从设计到落地的完整解决方案。

1. 前言:AI Agent 的进化与复杂系统的崛起

2023 年,AI Agent 实现了 "能对话" 的突破;2024 年,完成了 "能执行" 的落地;2025 年,正迈入 "能协同" 的新阶段 ------ 复杂 Agent 系统已成为企业数字化转型的核心驱动力。行业数据显示,2024 年 AI Agent 市场规模达 51 亿美元,预计 2030 年将突破 471 亿美元,年复合增长率超 40%。

单智能体已无法满足复杂业务需求:一个完整的项目开发需要需求分析、代码编写、测试验收等多环节;一个智能工厂的调度涉及生产计划、设备管理、物流协同等多维度;一个安全防护体系需要威胁检测、分析、响应等多流程。

正是这种复杂场景的需求,催生了 AI Agent 的三大高级架构:多智能体系统通过角色分工与协同机制解决 "多任务并行" 问题;分层决策系统通过目标拆解与资源调度解决 "复杂目标落地" 问题;人类在环机制通过关键决策介入解决 "AI 可靠性" 问题。这三大架构的组合,让 AI Agent 从 "专精工具" 升级为 "数字同事",真正融入企业核心业务流程。

本文基于多个企业级项目落地经验,从架构设计、技术实现、优化策略到行业实战,全方位拆解复杂 Agent 系统的构建逻辑,所有案例均来自真实落地场景,代码片段可直接复用。

2. AI Agent 三大高级架构深度解析

2.1 多智能体系统(MAS):协作、竞争与分工的艺术

多智能体系统(Multi-Agent Systems,MAS)是由多个具备自主决策能力的 Agent 组成,通过特定机制实现交互,共同完成复杂目标的系统。其核心价值在于 "1+1>2"------ 单个 Agent 聚焦专业能力,通过协同实现复杂任务拆解与高效执行。

2.1.1 三大核心交互模式

- 协作型:多个 Agent 目标一致,通过资源共享、任务互补完成复杂目标。例如软件开发场景中,产品经理 Agent 负责需求文档生成,架构师 Agent 设计技术方案,程序员 Agent 编写代码,测试员 Agent 执行自动化测试,通过协同完成全流程开发。

- 竞争型:多个 Agent 在资源有限的环境中争夺资源,通过博弈实现系统整体优化。例如电商平台的定价 Agent,各商家 Agent 根据竞品价格、库存、销量动态调整定价,最终形成市场均衡价,提升平台整体交易额。

- 分工型:基于 "专业人做专业事" 的逻辑,按功能或流程拆分角色,每个 Agent 负责特定环节。例如供应链系统中,市场 Agent 负责需求预测,生产 Agent 负责产能规划,物流 Agent 负责运输调度,分工明确且高效协同。

2.1.2 核心架构设计

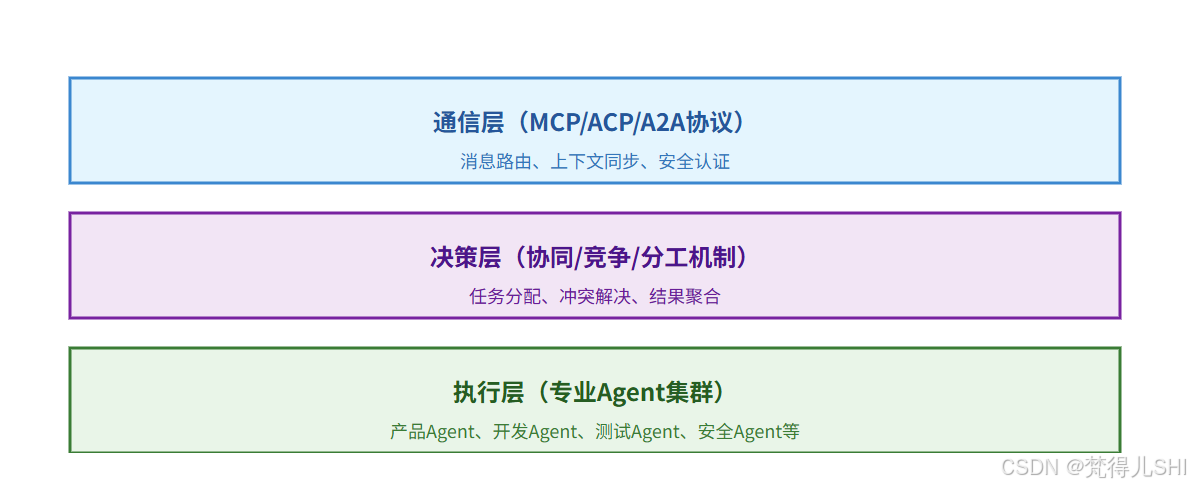

多智能体系统的架构需解决 "如何通信"" 如何分工 ""如何协同" 三大问题,典型架构分为三层:

2.1.3 关键技术:通信协议与协同机制

-

通信协议:解决异构 Agent 间的语义理解与交互标准化问题,核心协议包括:

- MCP(多智能体通信协议):跨系统消息传递,支持 JSON 格式与上下文管理,适合云原生场景。

- ACP(能力协议):本地环境下的能力注册与调用,低延迟,适合边缘计算场景(如工厂自动化)。

- A2A(Agent-to-Agent 协议):基于 Web 标准的协同流程规范,支持任务分配与结果汇总。示例:MCP 协议消息格式

bash{ "header": { "sender": "product_agent_001", "receiver": "developer_agent_002", "timestamp": "2025-11-10T14:30:00" }, "body": { "task_type": "code_development", "requirements": "用户管理模块,支持注册/登录/权限控制", "deadline": "2025-11-15T18:00:00" }, "context": { "project_id": "proj_202511", "priority": "high", "previous_communication_id": "comm_00321" } } -

协同机制:确保多个 Agent 高效配合,核心包括:

- 任务分解:基于领域知识将复杂任务拆分为原子任务,例如 MetaGPT 的 SOP 标准化分解流程。

- 冲突解决:通过协商(纳什均衡)、强化学习、博弈论等方式解决资源竞争或目标冲突。

- 结果聚合:将多个 Agent 的执行结果整合为统一输出,例如多模型推理结果的加权融合。

2.1.4 主流框架实操对比

| 框架 | 核心优势 | 适用场景 | 协作能力 | 落地难度 |

|---|---|---|---|---|

| MetaGPT | 角色分工明确,SOP 标准化 | 软件开发、项目管理 | 支持多角色协同与知识共享 | 中等 |

| CrewAI | 易用性强,10 分钟搭建 | 快速原型、中小规模任务 | 可视化协作流程 | 低 |

| LangChain | 生态完善,模块化扩展 | 知识库协同、工具调用 | 支持自定义协作逻辑 | 中等 |

| Qwen-Agent | 长文本处理,多模态支持 | 复杂文档处理、多模态任务 | 插件化协作 | 中等 |

实操建议:快速验证用 CrewAI,企业级软件开发用 MetaGPT,需要私有化部署用 LangChain + 本地大模型。

2.2 分层决策系统:从宏观目标到执行落地的拆解逻辑

分层决策系统通过 "管理者 Agent + 工作者 Agent" 的层级结构,将宏观目标拆解为可执行的子任务,解决复杂场景下的决策复杂度问题。其核心逻辑是 "上层定方向,下层抓执行",兼顾全局最优与局部高效。

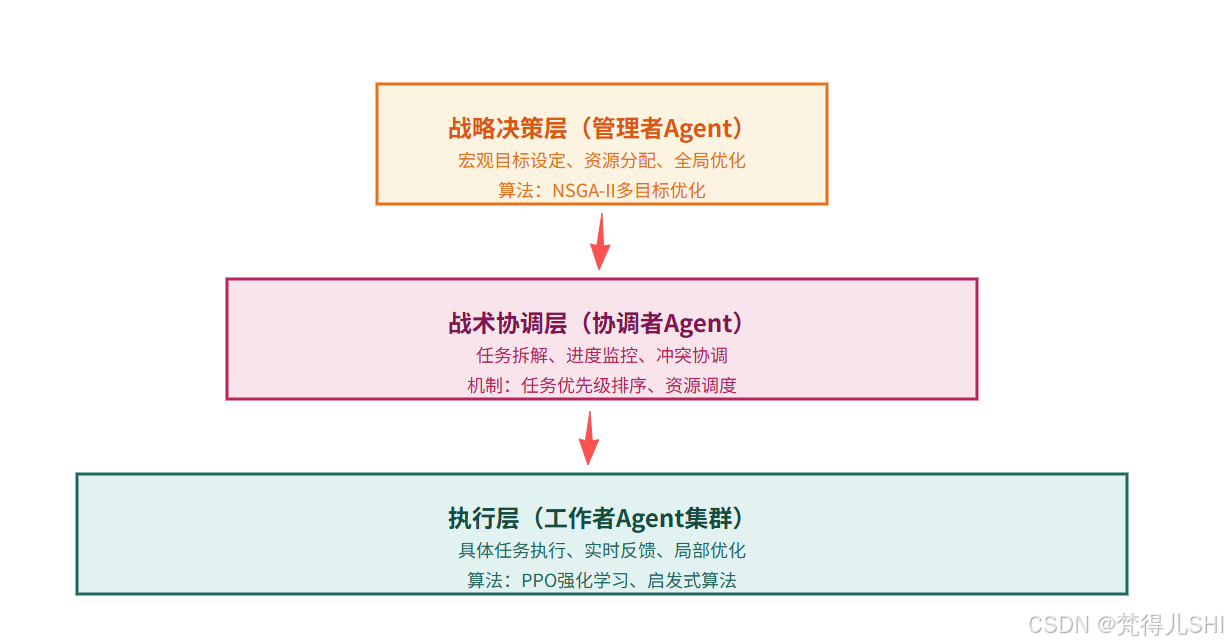

2.2.1 架构设计:三级决策模型

分层决策系统通常分为三级架构,上层聚焦长期目标与资源分配,下层聚焦实时执行与局部优化:

2.2.2 核心算法:分层强化学习实现

分层决策系统的核心是上层与下层的协同优化,常用 "离线元启发式 + 在线 DRL 微调" 的双阶段模型:

- 上层决策:用 NSGA-II(多目标遗传算法)生成 Pareto 最优解集,确定子目标权重与资源分配方案。

- 下层执行:用 PPO(近端策略优化)算法,根据上层权重进行局部优化,快速响应实时状态。

PyTorch+CUDA 实现核心代码(简化版):

python

import torch

import torch.nn as nn

from torch.distributions import Categorical

import numpy as np

# 设备配置(CUDA加速)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 1. 上层NSGA-II生成权重向量(简化版)

class NSGAIIWeightGenerator:

def __init__(self, num_objectives=2, pop_size=50):

self.num_objectives = num_objectives

self.pop_size = pop_size

def generate(self):

# 生成Pareto最优权重向量(简化实现)

weights = []

for i in range(self.pop_size):

w = np.random.rand(self.num_objectives)

w = w / np.sum(w) # 归一化

weights.append(torch.tensor(w, dtype=torch.float32).to(device))

return weights

# 2. 下层PPO执行器

class PPOExecutor(nn.Module):

def __init__(self, obs_dim=10, act_dim=5):

super(PPOExecutor, self).__init__()

# 策略网络

self.actor = nn.Sequential(

nn.Linear(obs_dim, 256),

nn.ReLU(),

nn.Linear(256, act_dim),

nn.Softmax(dim=-1)

).to(device)

# 价值网络

self.critic = nn.Sequential(

nn.Linear(obs_dim, 256),

nn.ReLU(),

nn.Linear(256, 1)

).to(device)

self.optimizer = torch.optim.Adam(self.parameters(), lr=3e-4)

def get_action(self, obs):

obs = torch.tensor(obs, dtype=torch.float32).to(device)

probs = self.actor(obs)

dist = Categorical(probs)

action = dist.sample()

return action.item()

def update(self, weights, trajectories):

# 根据上层权重更新策略

for traj in trajectories:

obs, actions, rewards = traj

# 多目标奖励加权

weighted_reward = torch.matmul(rewards, weights)

# PPO更新逻辑(省略细节)

self.optimizer.zero_grad()

# ... 损失计算与反向传播

self.optimizer.step()

# 3. 分层决策流程

def hierarchical_decision_pipeline():

# 初始化组件

weight_generator = NSGAIIWeightGenerator(num_objectives=2)

executor = PPOExecutor(obs_dim=10, act_dim=5)

# 迭代优化

for generation in range(100):

# 上层:生成权重向量

weights_list = weight_generator.generate()

# 下层:每个权重对应一个PPO策略

for weights in weights_list:

# 收集轨迹

trajectories = collect_trajectories(executor)

# 更新执行器

executor.update(weights, trajectories)

# 评估并更新权重种群

weight_generator.update_population(executor)

# 轨迹收集函数(模拟)

def collect_trajectories(executor):

trajectories = []

for _ in range(10):

obs = np.random.rand(10)

action = executor.get_action(obs)

rewards = torch.tensor([np.random.rand(), np.random.rand()], device=device)

trajectories.append((obs, action, rewards))

return trajectories2.2.3 典型应用场景:智能制造边缘 - 云协同

在智能制造场景中,分层决策系统实现生产全流程优化:

- 上层管理者 Agent:根据订单需求、市场预测,决定哪些工序在边缘节点执行,哪些在云端执行,设定生产截止时间与能耗目标。

- 中层协调者 Agent:将生产任务拆解为加工、装配、质检等子任务,分配给对应车间的工作者 Agent。

- 下层工作者 Agent:在各边缘节点执行具体任务,实时调整设备参数,优化局部能耗与生产效率。

数据显示,该架构使生产总完工时间(Makespan)降低 25%,能耗降低 18%,任务截止期满足率提升至 98%。

2.3 人类在环(Human-in-the-Loop):AI 与人类的协同决策机制

人类在环机制通过设计特定触发条件,让人类在关键决策点介入 Agent 工作流,解决 AI 在高风险、高不确定性场景下的决策可靠性问题。其核心是 "AI 做执行,人类做决策",平衡自动化效率与决策安全性。

2.3.1 核心触发机制

人类介入的触发条件需明确且可量化,避免过度干预或干预不足:

- 风险阈值触发:当决策风险超过设定阈值时触发,例如金融交易 Agent 的单笔交易金额超 50 万元,自动请求人工审批。

- 不确定性触发:当 Agent 对决策结果的置信度低于阈值(如低于 80%)时触发,例如医疗诊断 Agent 对疑难病例的诊断置信度不足,请求医生介入。

- 异常场景触发:当遇到未训练过的异常场景时触发,例如供应链 Agent 检测到突发自然灾害,请求人类制定应急方案。

- 定期审核触发:按固定周期触发人工审核,例如安全 Agent 每周生成风险报告,由安全专家审核优化策略。

2.3.2 交互设计:轻量化高效协作

人类在环的交互设计需遵循 "最小干预原则",减少人类操作成本:

2.3.3 企业级落地实践:决策治理框架

为确保人类在环机制的有效性,企业需构建配套的治理框架:

- 决策追溯:要求 Agent 输出详细的决策依据报告,包括数据来源、推理过程、风险评估,便于人类审核与追溯。

- 守护者 Agent:专门监控核心 Agent 的决策行为,当出现异常(如预算偏差超 10%)时,自动触发人工审核。

- 权限分级:基础任务赋予 Agent 全权限,核心决策需 "Agent 提议 + 人类审批",例如财务 Agent 的小额报销自动处理,大额报销需人工确认。

- 反馈闭环:人类的审核结果作为反馈数据,用于优化 Agent 的决策模型,逐步降低不必要的人工干预。

案例:某头部银行的风控 Agent 系统,通过人类在环机制,将高危威胁漏判率从 15% 降至 2%,同时保持 90% 的自动化处理率。

3. AI Agent 核心优化策略:性能、稳定性与扩展性

3.1 通信效率优化

- 采用轻量化通信协议:优先使用 MCP 协议的精简版,减少消息冗余,核心消息体积控制在 1KB 以内。

- 上下文缓存机制:Agent 间共享上下文缓存池,避免重复传输相同信息,例如项目 ID、基础配置等静态数据。

- 异步通信模式:使用发布 - 订阅(Publish-Subscribe)模式,避免同步等待导致的延迟,适合非实时性任务。

3.2 冲突解决优化

- 协商算法优化:基于纳什均衡设计协商策略,确保 Agent 在追求个体利益的同时,兼顾系统整体最优。

- 优先级动态调整:根据任务紧急程度、Agent 负载状态,动态调整任务优先级,避免资源竞争冲突。

- 强化学习训练:通过多智能体强化学习(MARL),让 Agent 在训练中学习冲突规避策略,提升协同效率。

3.3 鲁棒性与扩展性优化

- 异常检测与降级:为 Agent 设置健康检查机制,当某 Agent 故障时,自动切换至备用 Agent 或降级为人工处理。

- 模块化设计:采用微服务架构,将 Agent 的核心能力拆分为独立模块,支持按需扩展与替换。

- 动态扩缩容:基于任务复杂度和并发量,自动调整 Agent 实例数量,例如电商大促时增加客服 Agent 数量。

- 数据安全保障:通过 OAuth2 认证、数据加密传输、权限分级控制,确保 Agent 间数据交互的安全性。

4. 行业落地实战:从效率提升到价值创造

4.1 软件开发:多智能体全流程协同

基于 MetaGPT 框架构建软件开发多智能体系统,实现从需求到部署的全自动化:

- 产品经理 Agent:接收用户需求,生成结构化需求文档(PRD),明确功能边界与验收标准。

- 架构师 Agent:根据 PRD 设计技术架构,选择技术栈,生成系统设计图。

- 程序员 Agent:按模块拆分任务,编写代码,实现功能开发,支持 Java、Python 等多语言。

- 测试员 Agent:自动生成测试用例,执行单元测试、接口测试,输出测试报告。

- 运维 Agent:自动构建部署包,部署至测试 / 生产环境,监控系统运行状态。

案例数据:该系统使小型项目开发周期从 30 天缩短至 7 天,代码通过率(HumanEval 基准)达 85%,人工干预率仅 15%。

4.2 智能制造:分层决策与边缘 - 云协同

采用分层决策架构,优化生产调度与设备管理:

- 上层管理者 Agent:整合订单、库存、市场数据,制定月度生产计划,分配云 / 边缘计算资源。

- 中层协调者 Agent:拆分生产任务,协调车间、物流、质检等环节的协同。

- 下层工作者 Agent:包括设备 Agent(监控设备状态、优化运行参数)、物流 Agent(调度 AGV 小车)、质检 Agent(产品质量检测)。

核心价值:生产效率提升 40%,设备故障率降低 30%,能耗降低 18%,实现绿色智能制造。

4.3 网络安全:多 Agent 主动防御与人类在环风控

构建 "主动防御 + 人类在环" 的安全多智能体系统:

- 情报 Agent:实时爬取全球黑客论坛、暗网数据,跟踪最新攻击手法,更新威胁情报库。

- 检测 Agent:监控网络流量、系统日志,自动识别异常行为(如异地登录、高频数据下载)。

- 分析 Agent:基于 MITRE ATT&CK 框架,分析攻击路径,评估威胁等级。

- 响应 Agent:低风险威胁自动执行防御动作(如阻断 IP、冻结账户),高风险威胁触发人工审批。

案例:某互联网企业部署该系统后,提前识别并阻断 3 次针对性勒索攻击,减少损失超 2000 万元,SOC 团队重复工作减少 70%。

4.4 供应链管理:协同预测与动态优化

构建多智能体协同的供应链系统,应对市场波动与突发风险:

- 市场 Agent:分析电商销量、社交媒体趋势,预测 15 天内产品需求。

- 生产 Agent:结合需求预测,调整生产计划,优化原料库存,避免积压。

- 物流 Agent:监控港口拥堵、天气、关税政策,优化运输路线,降低物流成本。

- 人类在环:当遇到台风、地震等突发情况时,触发人工干预,调整供应链策略。

案例数据:供应链响应速度提升 80%,库存周转天数减少 30%,突发风险损失降低 80%。

5. 技术挑战与未来展望

5.1 当前挑战

- 协同复杂性:多 Agent 间的语义理解、目标对齐仍存在困难,复杂场景下协同效率有待提升。

- 决策可解释性:Agent 的决策过程黑盒化,难以追溯推理逻辑,影响高风险场景的落地。

- 数据依赖:Agent 的性能高度依赖高质量数据,数据不足或质量差会导致决策偏差。

- 安全风险:Agent 间通信、权限管理存在安全漏洞,可能引发数据泄露或恶意攻击。

5.2 未来展望

- 通用智能体:开发具备跨领域能力的通用 Agent,减少专用 Agent 的开发成本,支持更复杂的任务协同。

- 自主进化能力:通过强化学习、自监督学习,让 Agent 具备自主优化决策策略的能力,适应动态环境。

- 跨模态协同:支持文本、图像、语音、传感器数据等多模态交互,拓展应用场景(如自动驾驶、智能医疗)。

- 标准化生态:建立统一的 Agent 通信、能力描述标准,推动不同框架、不同厂商 Agent 的互联互通。

6. 总结

AI Agent 的三大高级架构 ------ 多智能体系统、分层决策系统、人类在环机制,分别解决了复杂任务的 "协同问题"" 拆解问题 ""可靠性问题",三者的组合应用是实现企业数字化转型的关键。

从技术层面,多智能体系统的核心是通信协议与协同机制,分层决策系统的核心是算法优化与层级衔接,人类在环机制的核心是触发条件与交互设计。从落地层面,需遵循 "从自动化提效切入,逐步迈向价值创造" 的路径,先通过单场景 Agent 验证效果,再构建复杂系统。

未来,AI Agent 将从 "工具级" 应用升级为 "战略级" 资产,重塑企业业务流程与组织架构。对于技术从业者而言,掌握复杂 Agent 系统的设计与优化能力,将成为核心竞争力。

7. 参考文献与延伸阅读

- 多智能体框架调研:10 个主流 AI Agent 框架 - CSDN DevPress

- 分层强化学习的层次化工作流调度策略 - CSDN 文库

- 企业 AI Agent 实战指南:从 "降本增效" 到 "价值创造" - CSDN 博客

- 深入浅出理解智能体 - CSDN 博客

- Agent 四大协议 (MCP/ACP/A2A/ANP) 解析 - CSDN 博客

- 多智能体冲突协同策略 - 洞察研究 - 豆丁网