基于K210的人脸识别开锁

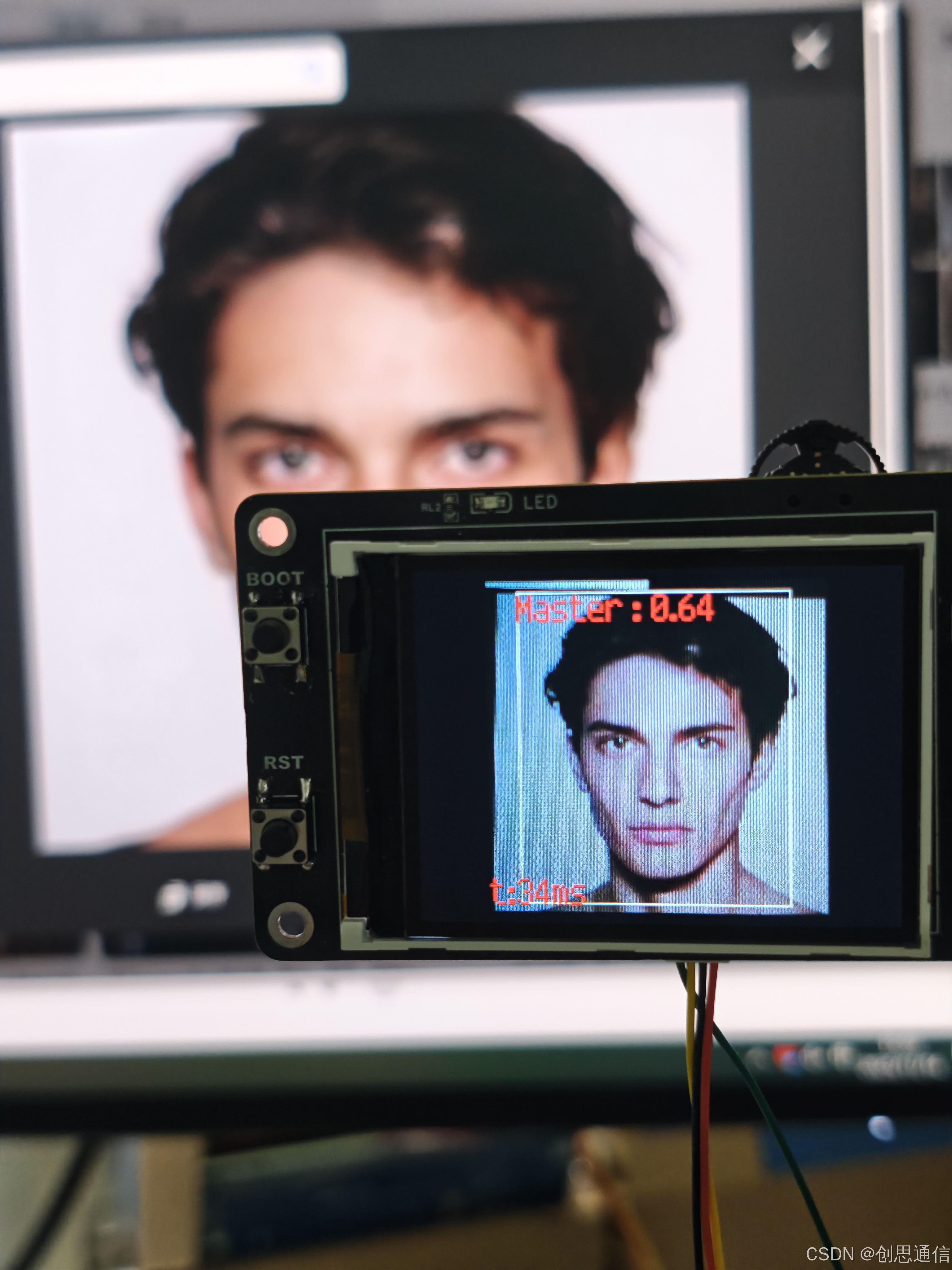

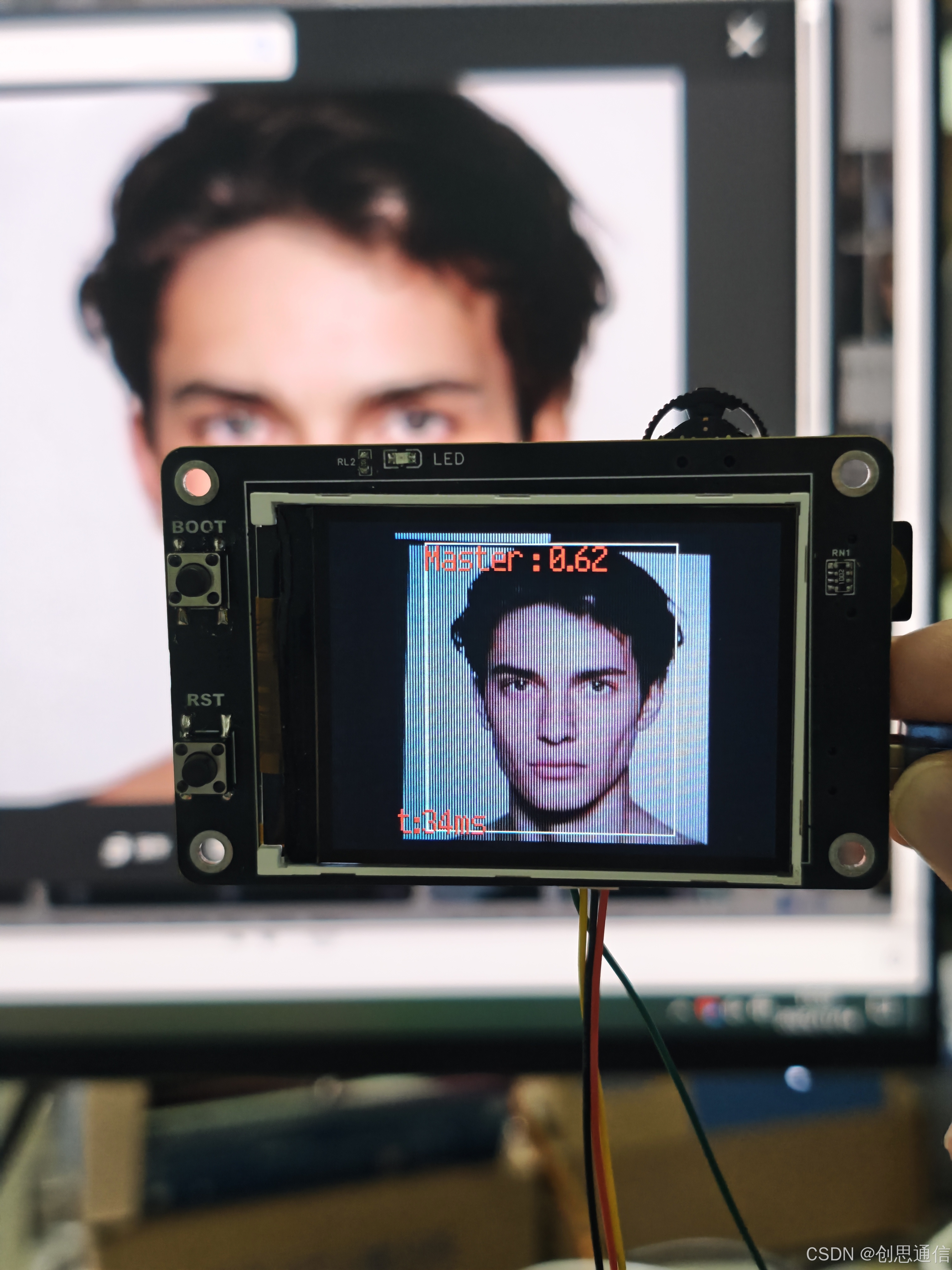

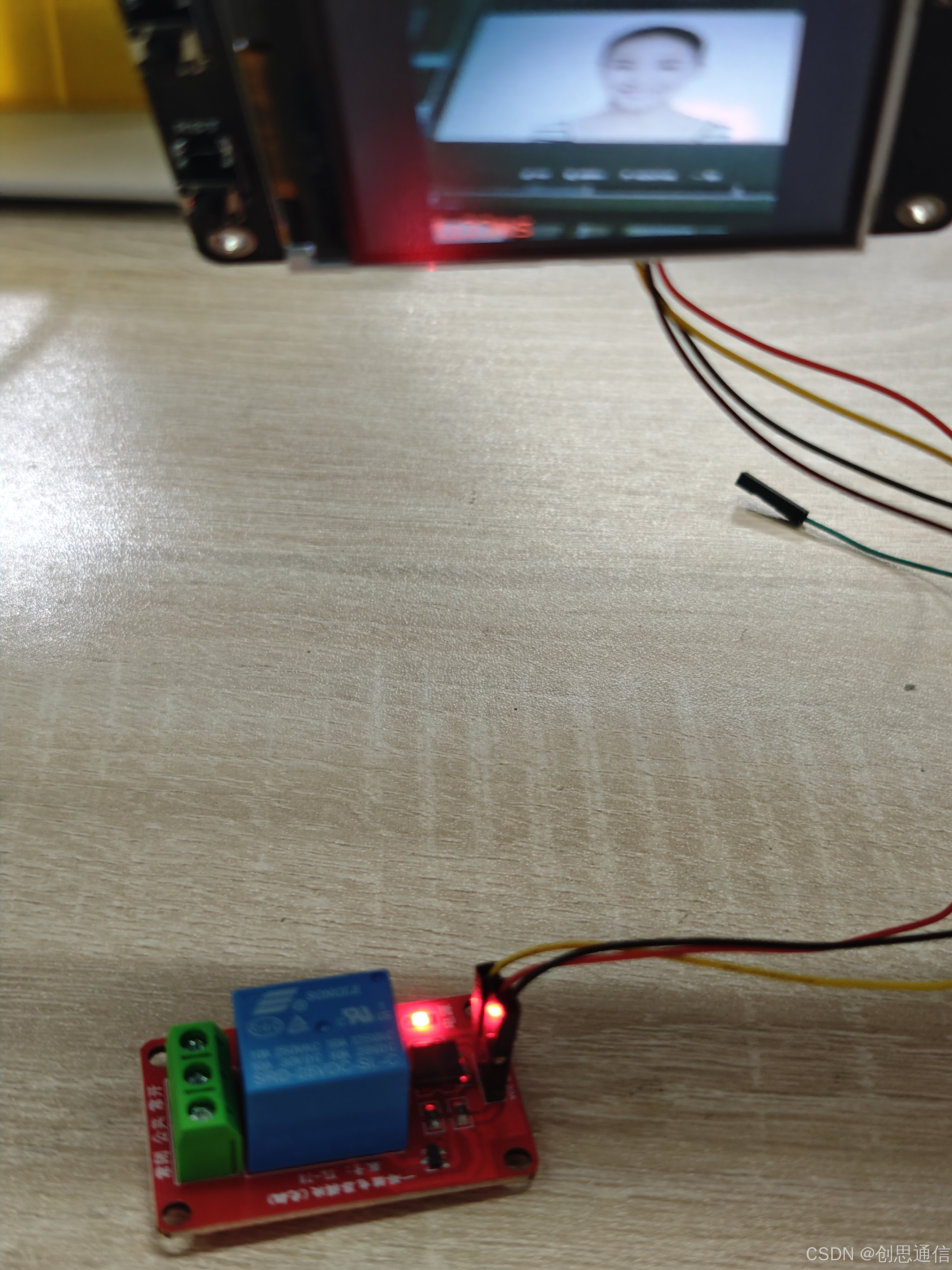

🎯 实现效果图片

- 场景 1:"主人" 面对摄像头→ 屏幕显示 "Master",框选人脸,继电器通电,门锁打开;

- 场景 2:"陌生人" 面对摄像头→ 屏幕不显示,门锁不打开;

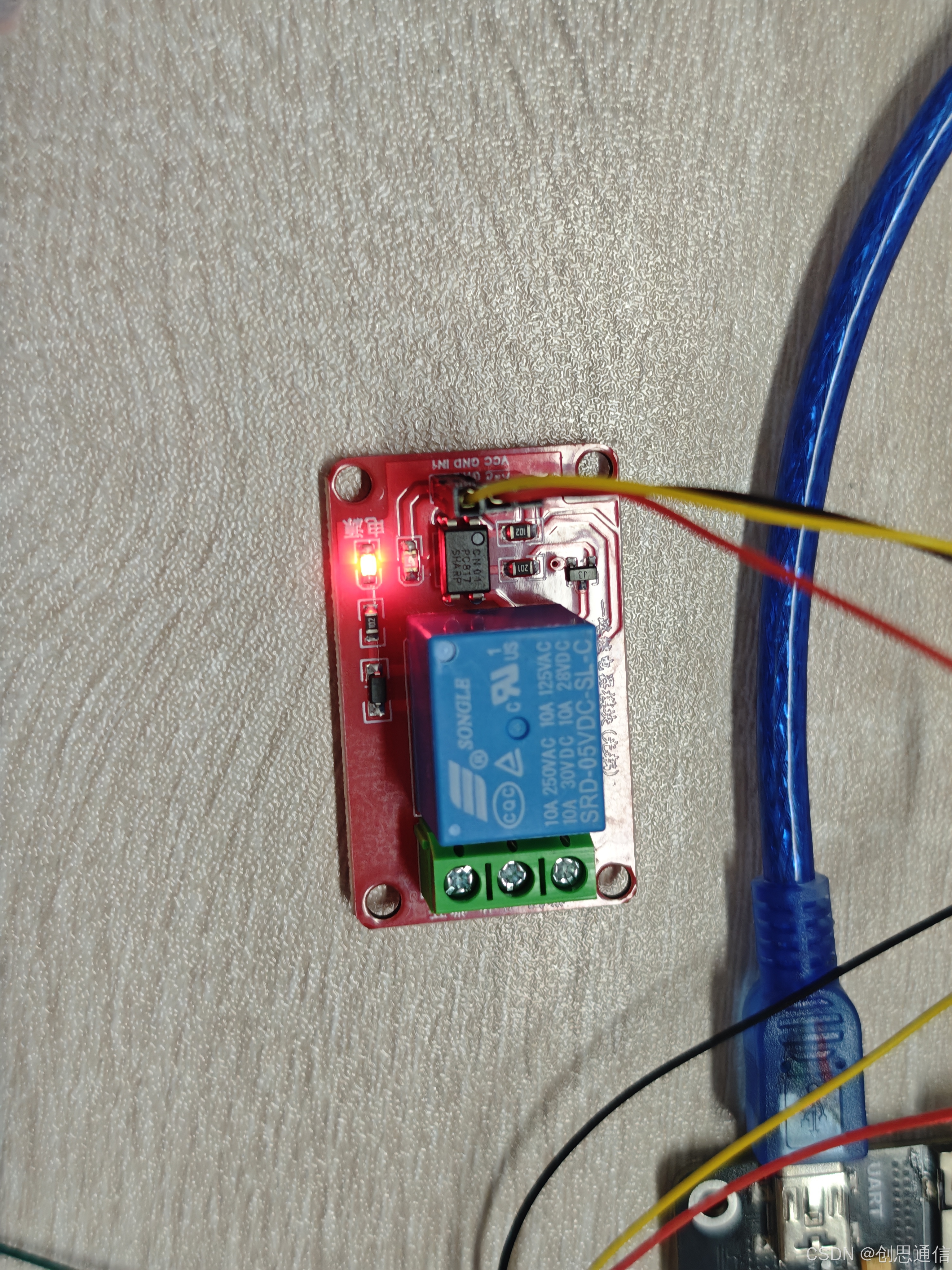

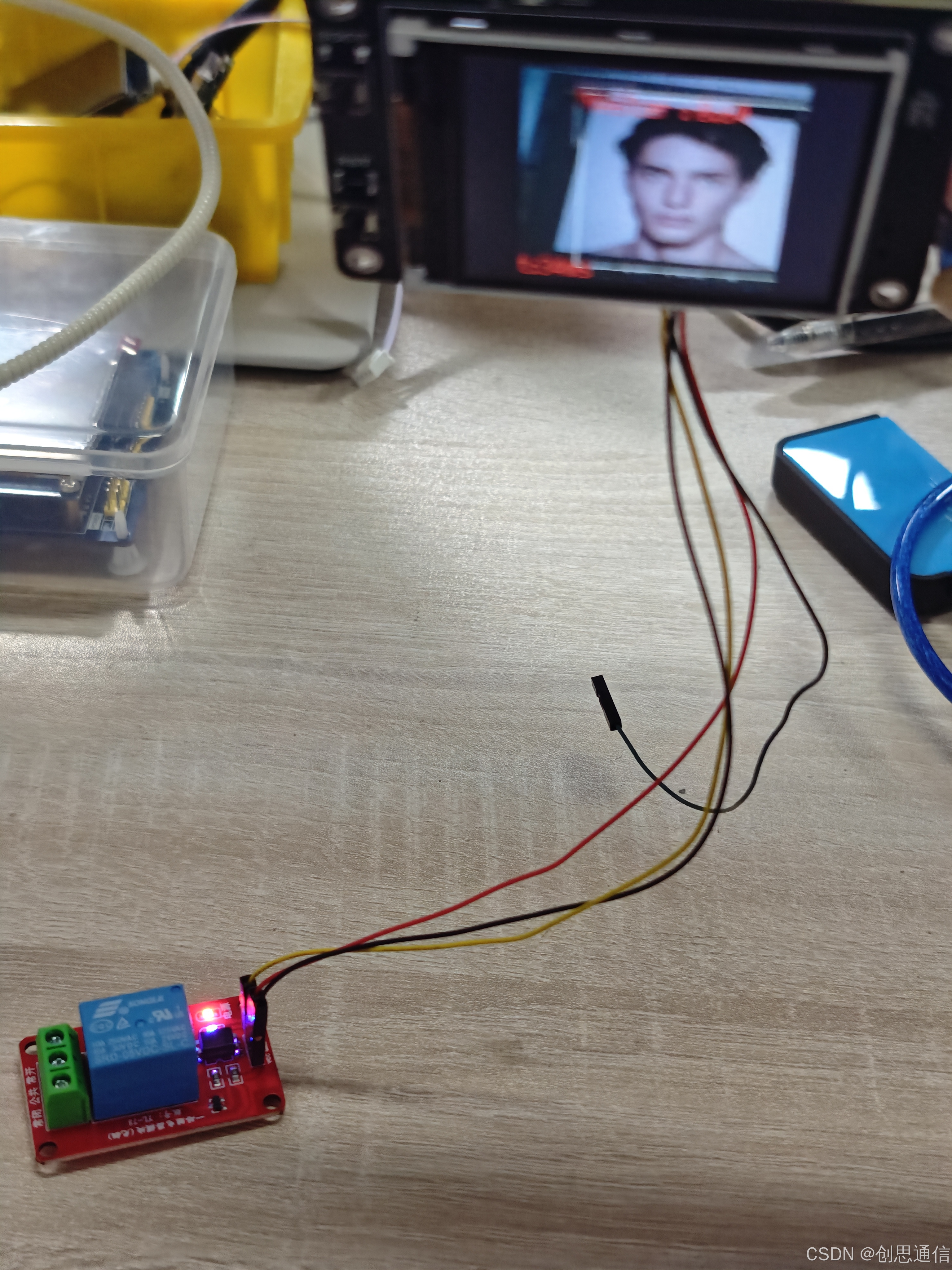

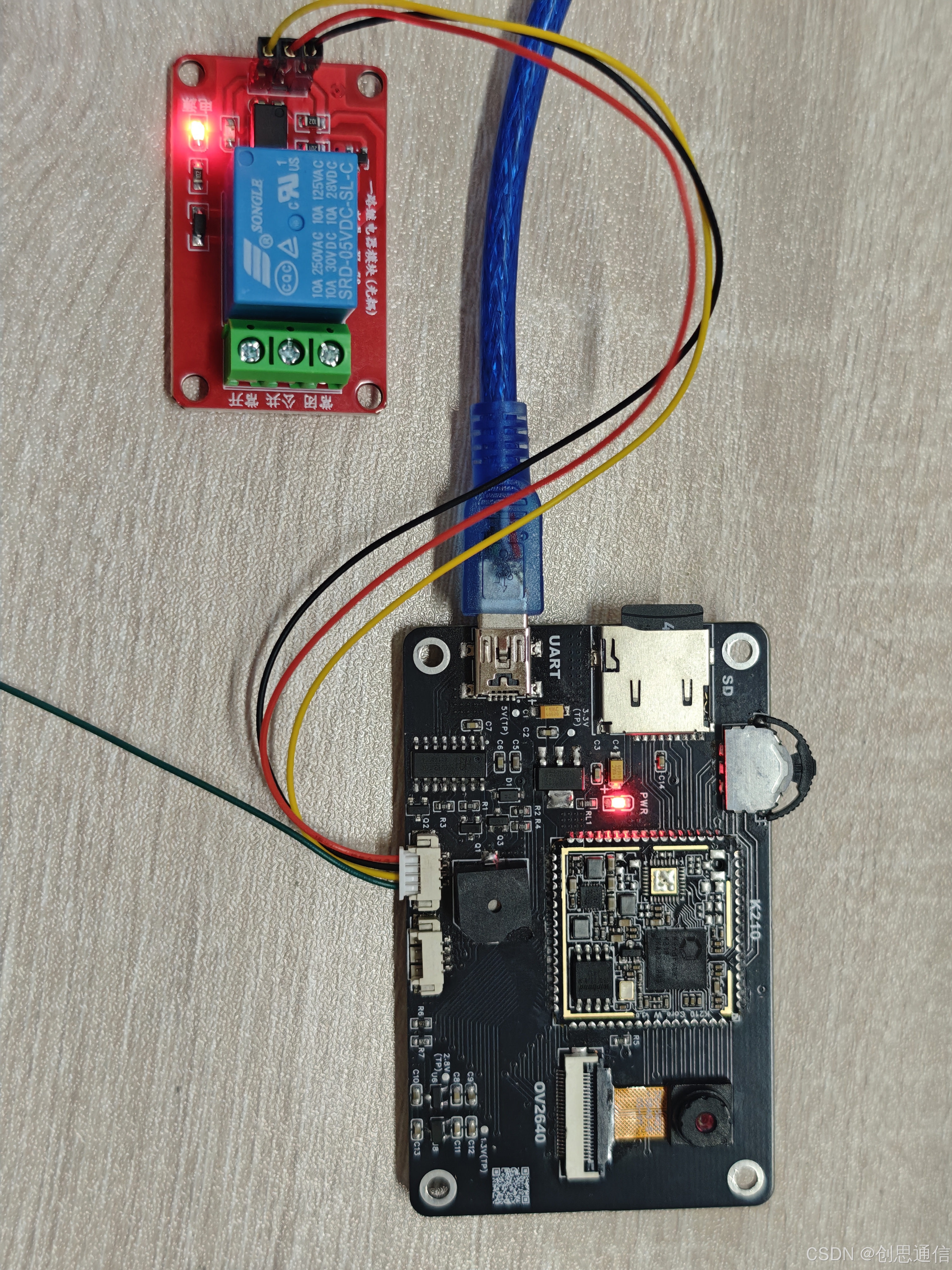

🌟实物图

🎯 系统组成

- 主控模块:K210开发板,作为整个系统的"大脑",负责运行人脸识别算法和控制逻辑;

- 感知模块:摄像头模块,用于实时采集人脸图像;

- 显示模块:LCD屏幕,实时显示采集的图像、识别结果及响应时间;

- 执行模块:继电器与门锁驱动,接收K210指令完成开锁动作;

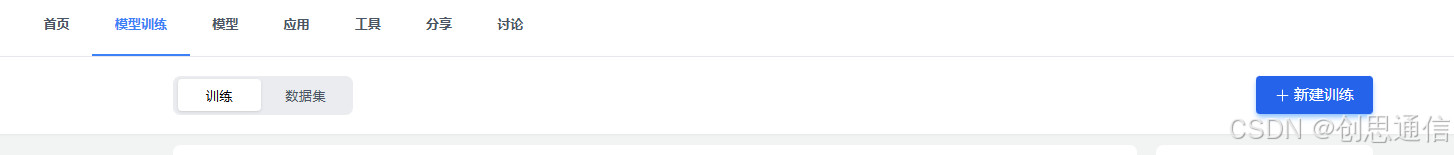

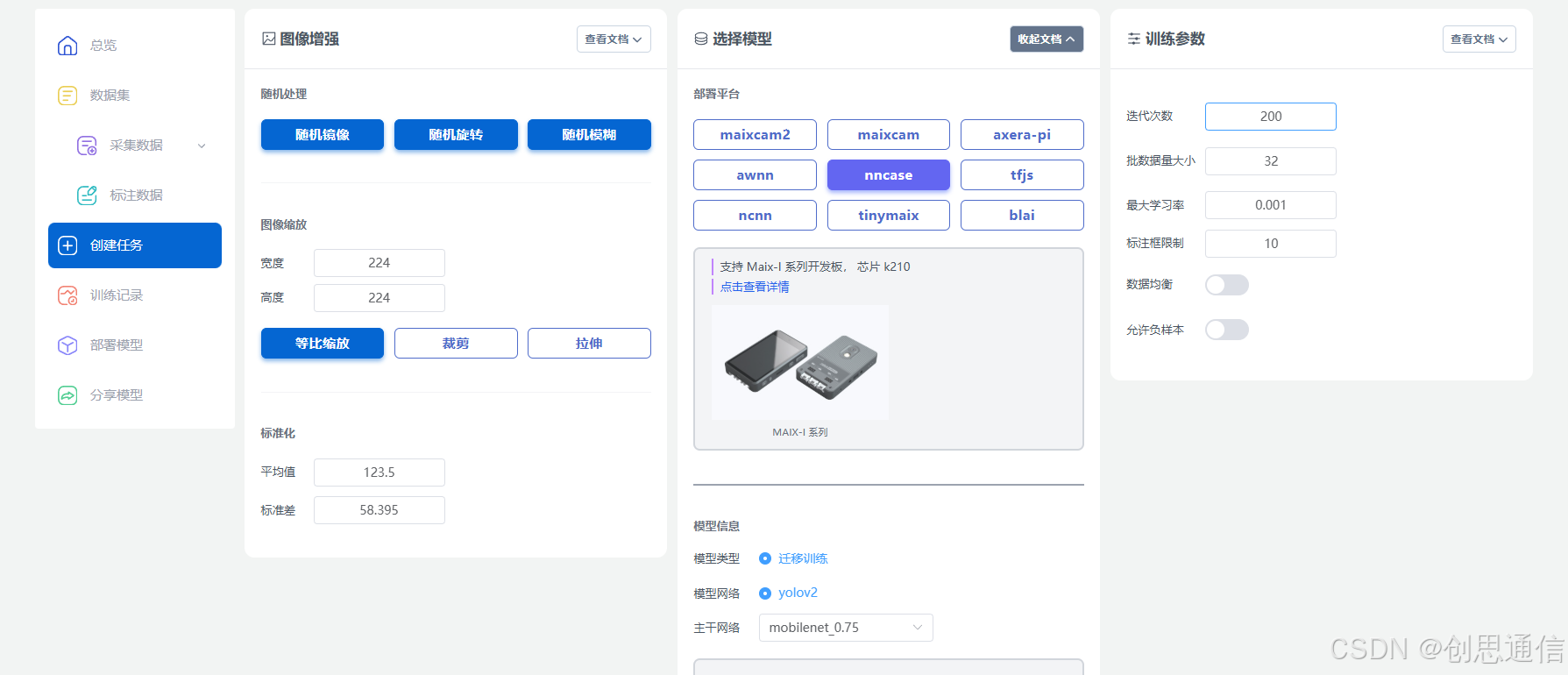

🌟 模型训练

- 准备人脸数据:拍摄50张以上待识别人员的人脸照片

- 打开MaixHub官网,创建新项目并选择"人脸识别"任务,将准备好的人脸照片按要求上传,同时给数据集添加标签

-

设置训练参数:根据需求选择模型类型(推荐YOLOv2轻量化模型,兼顾速度与精度),设置训练迭代次数(一般100-200次即可满足基础需求),点击"开始训练"。

-

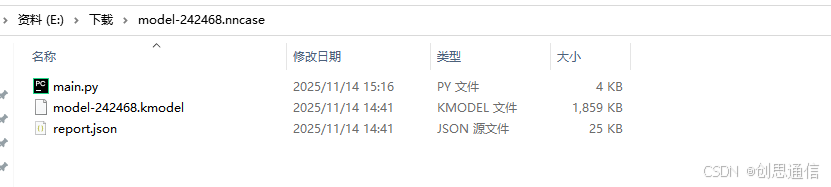

下载部署模型:训练完成后,平台会生成适配K210的.kmodel格式模型文件,将其所有文件复制到TF卡中。把TF卡插入K210开发板,即可完成模型部署,此时门锁就能识别训练好的人脸了。修改里面main.py文件,使其能控制继电器达到开锁关锁效果。

🌟 驱动思路

- 驱动程序基于MaixPy3框架开发,核心逻辑围绕"图像采集-识别处理-执行控制"展开,关键代码功能如下:

硬件初始化

- 硬件外设的初始化,为后续图像采集和设备控制打下基础。蜂鸣器默认关闭,摄像头设置为RGB565格式以平衡图像质量与处理速度。

模型加载与人脸识别

- 通过KPU模块加载预训练的人脸模型,使用YOLOv2算法进行目标检测。设置置信度阈值0.5和非极大值抑制阈值0.3,确保识别准确率,避免误触发。

结果判断与执行控制

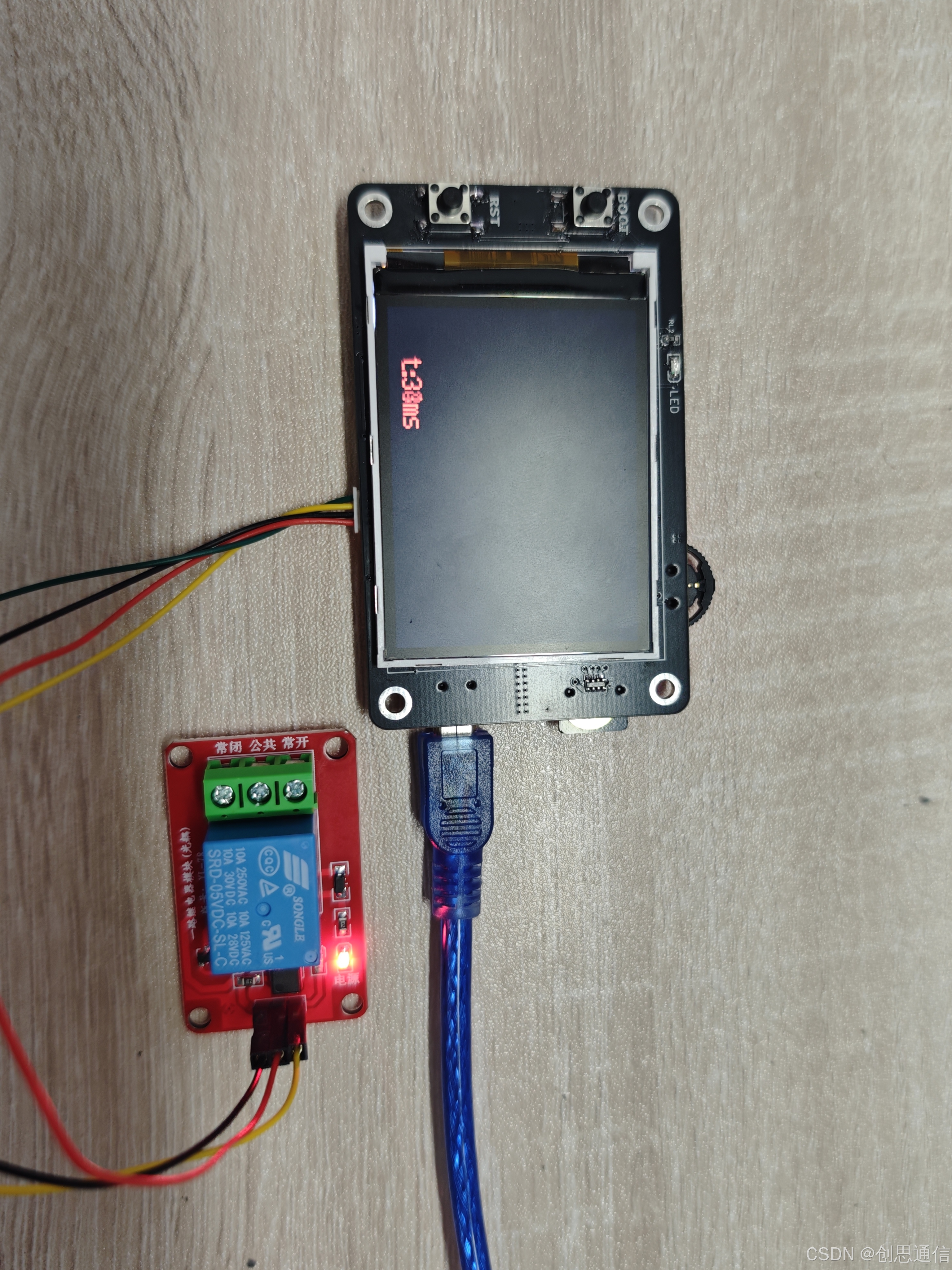

- 系统进入循环后,摄像头实时采集图像并传入KPU进行人脸识别:当检测到授权人脸(标签为"Master")时,立即绘制矩形框标记人脸区域并显示置信度,同时将继电器电平拉低(RELAY.value(0))实现开锁;若未识别到人脸,会启动超时计时,当无有效识别超过5秒且当前处于开锁状态时,自动将继电器复位为高电平(RELAY.value(1)),完成门锁锁定,保障安全性。整个过程中,屏幕会实时显示识别耗时(t:%dms),便于监测系统响应速度。

🌟代码

python

# generated by maixhub, tested on maixpy3 v0.4.8

# copy files to TF card and plug into board and power on

import sensor, image, lcd, time

import KPU as kpu

from machine import UART

import gc, sys

from fpioa_manager import fm

from Maix import GPIO

input_size = (224, 224)

labels = ['Master']

anchors = [5.8, 6.33, 5.25, 5.62, 6.23, 6.16, 5.53, 5.95, 5.94, 5.87]

fm.register(13, fm.fpioa.GPIO0)

RELAY=GPIO(GPIO.GPIO0, GPIO.OUT)

RELAY.value(1)

def lcd_show_except(e):

import uio

err_str = uio.StringIO()

sys.print_exception(e, err_str)

err_str = err_str.getvalue()

img = image.Image(size=input_size)

img.draw_string(0, 10, err_str, scale=1, color=(0xff,0x00,0x00))

lcd.display(img)

class Comm:

def __init__(self, uart):

self.uart = uart

def send_detect_result(self, objects, labels):

msg = ""

for obj in objects:

pos = obj.rect()

p = obj.value()

idx = obj.classid()

label = labels[idx]

msg += "{}:{}:{}:{}:{}:{:.2f}:{}, ".format(pos[0], pos[1], pos[2], pos[3], idx, p, label)

if msg:

msg = msg[:-2] + "\n"

self.uart.write(msg.encode())

def send_command(self, cmd):

self.uart.write(cmd.encode()) # 编码为字节流发送

def init_uart():

fm.register(10, fm.fpioa.UART1_TX, force=True)

fm.register(11, fm.fpioa.UART1_RX, force=True)

uart = UART(UART.UART1, 115200, 8, 0, 0, timeout=1000, read_buf_len=256)

return uart

def main(anchors, labels = None, model_addr="/sd/m.kmodel", sensor_window=input_size, lcd_rotation=2, sensor_hmirror=False, sensor_vflip=False):

sensor.reset()

sensor.set_pixformat(sensor.RGB565)

sensor.set_framesize(sensor.QVGA)

sensor.set_windowing(sensor_window)

#sensor.set_hmirror(sensor_hmirror)

#sensor.set_vflip(sensor_vflip)

sensor.set_hmirror(True)

sensor.set_vflip(True)

sensor.run(1)

lcd.init(type=1)

lcd.mirror(True)# 水平镜像

lcd.rotation(lcd_rotation)

lcd.bgr_to_rgb(True) #bgr转rgb

lcd.clear(lcd.WHITE)

if not labels:

with open('labels.txt','r') as f:

exec(f.read())

if not labels:

print("no labels.txt")

img = image.Image(size=(320, 240))

img.draw_string(90, 110, "no labels.txt", color=(255, 0, 0), scale=2)

lcd.display(img)

return 1

try:

img = image.Image("startup.jpg")

lcd.display(img)

except Exception:

img = image.Image(size=(320, 240))

img.draw_string(90, 110, "loading model...", color=(255, 255, 255), scale=2)

lcd.display(img)

uart = init_uart()

comm = Comm(uart)

try:

task = None

task = kpu.load(model_addr)

kpu.init_yolo2(task, 0.5, 0.3, 5, anchors) # threshold:[0,1], nms_value: [0, 1]

# 记录初始时间

last_time = time.ticks_ms()

interval = 5000 # 间隔 500ms

while(True):

img = sensor.snapshot()

t = time.ticks_ms()

objects = kpu.run_yolo2(task, img)

t = time.ticks_ms() - t

if objects:

for obj in objects:

pos = obj.rect()

img.draw_rectangle(pos)

img.draw_string(pos[0], pos[1], "%s : %.2f" %(labels[obj.classid()], obj.value()), scale=2, color=(255, 0, 0))

RELAY.value(0)

last_time = time.ticks_ms()

else:

current_time = time.ticks_ms()

if time.ticks_diff(current_time, last_time) >= interval and RELAY.value()==0:

last_time = current_time # 更新时间戳

RELAY.value(1)

img.draw_string(0, 200, "t:%dms" %(t), scale=2, color=(255, 0, 0))

lcd.display(img)

except Exception as e:

raise e

finally:

if not task is None:

kpu.deinit(task)

if __name__ == "__main__":

try:

# main(anchors = anchors, labels=labels, model_addr=0x300000, lcd_rotation=0)

main(anchors = anchors, labels=labels, model_addr="/sd/model-242468.kmodel")

except Exception as e:

sys.print_exception(e)

lcd_show_except(e)

finally:

gc.collect()