过去一年,大模型的推理方式正在变得前所未有地多样化。开发者不再满足于"把请求丢给云端 API,然后等待结果"这种单向流程,而是真实地感受到:不同场景,对延迟、隐私、成本、可控性都有完全不同的要求。尤其是在设备与应用碎片化的当下,一个单一模型架构根本无法覆盖所有体验。于是,一个越来越清晰的趋势出现了------Hybrid Inference:让本地模型与云端模型协同工作,让推理不再是单点,而是一条可自适应的推理链路。

这不是一个"用本地模型做点小活、云端做大活"的简单模式,而越来越像是一套"推理操作系统"。它背后的关键问题是:如何在延迟、算力、成本、隐私之间动态调度模型,让系统在不确定性下稳定输出最优结果?

这篇文章想带你把 Hybrid Inference 的底层逻辑讲透,让你既理解它的原理,也真的能动手搭建一套可运行的架构。

一、为什么 Hybrid Inference 是大势所趋?

如果你正在开发智能助手、行业 AI 工具、自动驾驶辅助应用、工作流智能体,或者只是一个本地知识库应用,你一定会发现以下困境:

当你把推理放到云端时:

- 延迟不可控(网络不稳定就是灾难)

- 成本会随调用量指数增长

- 隐私与合规压力始终存在(数据不能随便上传)

- 某些轻任务实在不该用一个 500B 模型去算

而当你把推理放到本地:

- 算力有限(尤其是移动端)

- 无法处理复杂任务(例如复杂推理、长上下文、多模态生成)

- 更新成本高(模型版本难同步)

- 缺乏深度能力(本地小模型的边界很明显)

所以这几年我们看到 Apple、Google、微软、百度、OpenAI 的方向越来越一致: 让云端算力做"重推理",让设备端做"轻推理",并通过统一的调度体系连接它们。

你会发现 Hybrid Inference 本质不是架构问题,而是 推理能力在不同"地理位置"间的协同问题。它更像 CDN 与边缘计算融合后的世界,但这一次的内容不是"静态文件",而是"智能本身"。

二、Hybrid Inference 的底层逻辑(真正理解它需要从这里开始)

如果你只从"本地能做什么、云端能做什么"去理解 Hybrid,会把自己框死在低维度里。正确的切入方式应该是:

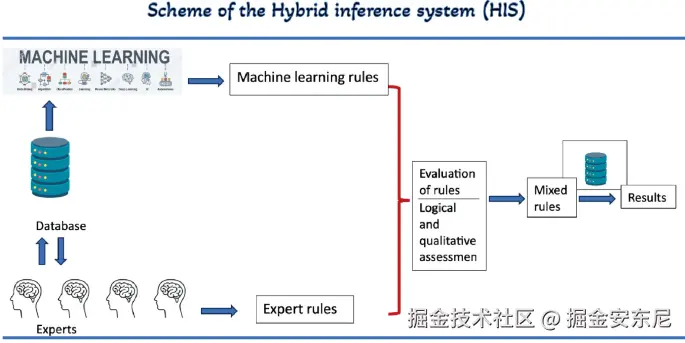

Hybrid Inference = 推理任务拆解 + 模型能力编排 + 路径动态决策

我们可以把它拆成三个关键层:

1)推理任务拆解(Task Decomposition Layer)

大部分推理任务看似"一个问题",但实际包含多个子能力:

举例:

"总结这段财报并生成一份可视化分析报告。"

这背后至少包含:

- 文本理解

- 信息抽取

- 财务知识推理

- 可视化结构规划

- 多轮问题澄清

- 最终格式化生成

关键洞察是:不是每一步都必须用 70B 或 500B 模型。轻能力完全可以本地解决。

2)模型能力编排(Model Orchestration Layer)

你的系统必须知道:

- 哪些任务适用于本地 LLM(低延迟、轻计算)

- 哪些任务必须交给云端 LLM(高推理深度)

- 哪些任务可以由本地模型预处理(降维)

- 哪些任务需要云端模型压轴(升维)

它类似于 Transformer 的层选择,但此时选择的是"推理位置"。

你可以把它想象成:

本地模型负责快速理解、过滤、特征化;云端模型负责深推理、生成与多模态处理。

3)路径动态决策(Dynamic Routing Layer)

这是 Hybrid 的灵魂。

最优路径不是固定的,而是在以下维度之间实时博弈:

- 延迟(网络/设备)

- 隐私级别(如企业内部数据)

- 成本(API 单价)

- 模型能力要求(是否足够聪明)

- 上下文长度

- 设备在线/离线状态

- 任务复杂度动态评估

最终形成一种"推理路由":

markdown

用户输入 → 本地模型初筛 → 动态评估 →

↳ 如果是简单任务 → 直接本地推理

↳ 如果中等复杂 → 分层本地推理 + 云端补洞

↳ 如果是高复杂 → 全链路云端推理看到这里,你应该已经意识到------ Hybrid Inference 的核心不是本地模型,而是"思考如何分配智能工作量"。

三、架构图:让 Hybrid Inference 变得可视化

为了让你脑子里形成一个清晰模型,我用最常见的工业实践画了一张示意结构:

scss

┌───────────────┐

│ User Input │

└───────┬───────┘

│

┌────────▼────────┐

│ Local PreModel │ ← 2B~8B 本地模型

│(理解/分类/过滤) │

└────────┬────────┘

│

┌──────────────▼──────────────┐

│ Dynamic Routing Engine │

│ (复杂度、隐私、成本、延迟判断) │

└───────┬──────────────┬──────┘

│ │

┌─────────────▼───────┐ ┌──▼────────────────┐

│ Local LLM Execution │ │ Cloud LLM Execution│

│ (轻推理/短上下文) │ │(深推理/长上下文) │

└──────────────┬─────┘ └─────────┬──────────┘

│ │

┌────────▼──────────────────▼─────────┐

│ Hybrid Aggregator │

│ (结果合并/角色分工/补全/一致性检查) │

└─────────────────┬────────────────────┘

│

┌──────────▼──────────┐

│ Final Output │

└─────────────────────┘它很像多智能体系统,但这里的智能体不是不同角色,而是不同位置的模型。

四、动手:15 行代码搭一个最简单的 Hybrid Inference 原型

以下是一个"本地模型 + 云端模型"的混合推理路由 Demo(Python):

ini

from transformers import AutoModelForCausalLM, AutoTokenizer

import openai

# 本地轻量模型(例如 1.3B、3B)

local_tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen2-1.5B")

local_model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen2-1.5B")

openai.api_key = "YOUR_API_KEY"

def local_infer(prompt):

inputs = local_tokenizer(prompt, return_tensors="pt")

outputs = local_model.generate(**inputs, max_new_tokens=128)

return local_tokenizer.decode(outputs[0])

def cloud_infer(prompt):

response = openai.chat.completions.create(

model="gpt-4.1",

messages=[{"role": "user", "content": prompt}],

)

return response.choices[0].message["content"]

def hybrid_infer(prompt):

# 本地模型判断"任务复杂度"

judge = local_infer(f"判断此任务是否复杂:{prompt},回答 simple 或 complex")

if "simple" in judge.lower():

return local_infer(prompt)

else:

return cloud_infer(prompt)

print(hybrid_infer("请帮我生成一份有结构的商业计划书"))它并不完美,但它有一个非常重要的意义:

让你真正理解 Hybrid 的逻辑:不是双模型并用,而是让本地模型成为"推理入口"。

你可以在此基础上继续扩展:长上下文检测、本地 embedding 检索、本地多模态预处理、Confidence Routing 等等。

五、Hybrid 架构的一个典型真实案例

假设你做的是「企业内部知识库 + AI 助手」,流程会是这样:

- 本地模型:对用户问题做分类、意图识别 例如识别:行政?合同?流程?财务?

- 本地 embedding 模型:在企业内部知识库中检索内容(不能上云)

- 本地模型:生成 condensed context(压缩摘要)

- 云端模型:在压缩后的上下文上进行深推理与生成(降低 token 成本)

- 本地模型:后处理、补齐企业术语、合规过滤

这种架构不仅提升了隐私和速度,还极大降低了 cloud API 成本------

因为云端模型真正收到的上下文只有必要部分。

这就是 Hybrid 架构真正的价值:让智能系统具备了"工作流式的思考能力",而不是一问一答的反射能力。

六、收尾:Hybrid Inference 不只是架构,而是未来智能系统的地基

如果说单模型推理是"一条直线",那么 Hybrid Inference 就是"一片地形"。

本地模型像是地表的道路,快速、可控、贴近用户;

云端模型像是地下的高速隧道,深邃、有力,却成本高昂。

而动态路由,就是在这些道路之间不断寻找最优路径的交通中枢。

未来的智能系统不会被绑定在单一模型上,它们会像操作系统一样, 把不同位置、不同能力的模型组织成一张智能网络。

Hybrid Inference 不是趋势------它已经开始成为"默认"。

而你现在理解的这些思路,将会在未来几年 AI 应用真正爆发时成为底层基石。

如果你也在构建自己的模型架构、智能助手或企业应用,欢迎在评论区继续交流思路。

让智能系统真正"动"起来,是我们共同的命题。