作者:赵世振

本文整理自 2025 云栖大会,阿里云智能集团产品架构师 赵世振 的主题演讲《Serverless AI 原生应用架构》

在 AI 大模型浪潮席卷全球的今天,企业纷纷加速拥抱 AI,推动智能客服、内容生成、流程自动化等场景快速落地。然而,许多企业在实践中却遭遇了"三高困境"------成本高、复杂度高、风险高。

一位互联网公司 CTO 曾坦言:"智能客服流量暴增,模型服务很容易被打挂,紧急手动扩容后,GPU 闲置率高达 90%,月底账单翻倍,还有数据泄漏风险。"

这并非个例------大量企业仍在用"传统架构"承载"新型 AI 业务",要让 AI 业务简单、稳定、安全落地,我们必须从基础设施到业务接入层,进行一场 AI 原生的架构重塑。

架构变革的底层逻辑

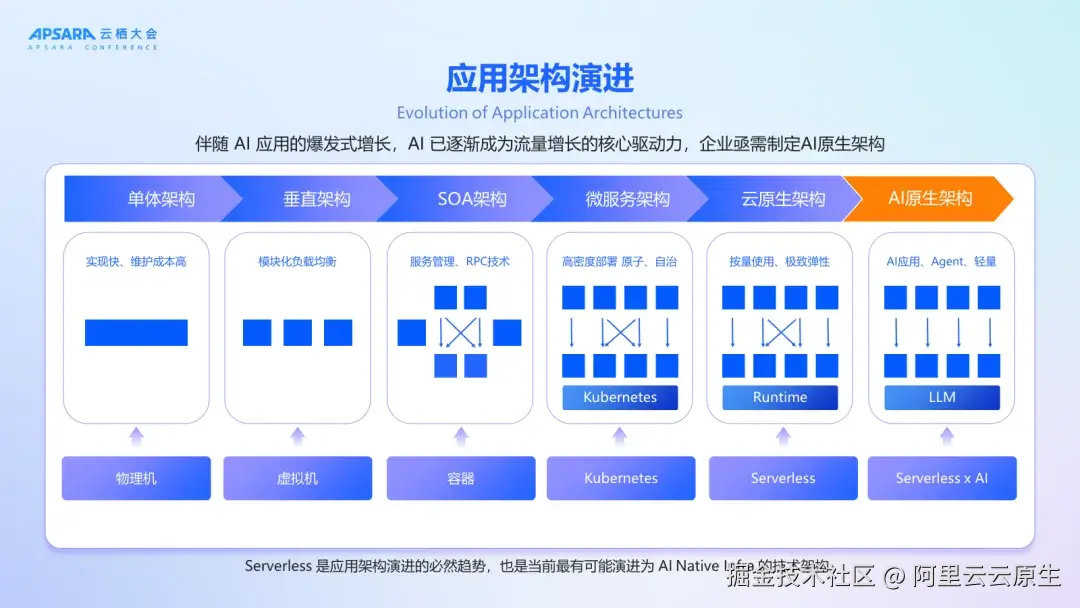

过去十余年间,应用架构持续演进:从单体架构到垂直拆分,历经 SOA、微服务,走向云原生,直至今日的 AI 原生架构。这一进程的本质,是业务逻辑不断解耦、分布化与智能化的过程,旨在实现更快速的业务响应、更灵活的协同能力。

与此同时,底层基础设施也同步进化------从物理机、虚拟机到容器、Kubernetes,再到 Serverless,如今迈向 Serverless AI 的新阶段。其核心在于对资源与能力的极致抽象,实现按需弹性、自动伸缩,让计算如同水电一般随取随用、高效便捷。

两条演进主线共同揭示了一个清晰的趋势:未来的技术重心将愈发聚焦于业务逻辑本身的创新与实现,而基础设施则趋于全面抽象化、自动化和智能化。开发者无需再过多关注底层运维细节,而是可以专注于创造更高价值的业务场景。这不仅是技术的跃迁,更是生产力的一次深刻变革。

AI 原生应用架构的三大核心需求

通过与 300 余家企业的深度交流,AI 原生应用架构的核心需求可归纳为高模型算力 、高可用性 及严格安全管控三大维度:

1. 算力需求

- 成本优化: GPU 算力成本是 CPU 的数倍,且供应波动大。需提供灵活的卡型选择(如 N 分之一卡)、按需付费模式及预留闲置资源策略,以平衡成本与性能。

- 稳定性保障: 通过多可用区部署与动态资源调度,确保模型调用的持续性与资源利用率最大化。

2. 高可用性需求

- 全链路容灾: 支持多可用区部署,避免单点故障;

- 限流与 fallback 机制: 突发流量时自动限流,模型服务异常时无缝切换至备用模型,保障业务连续性。

3. 安全管控需求

- 输入输出合规性: 模型输入输出均设内容安全防护,过滤违规内容、敏感信息等;

- 消费者鉴权: 不同团队或不同用户请求带有不同的鉴权凭证,权限最小化;

- 全链路监控: 实现从网关到算力的全链路可观测体系;

总结来说,AI 原生应用架构需要的是:简单易用的开发体验、生产级的性能、稳定性和安全保障。

Serverless AI 原生架构的全栈能力支撑

为满足上述需求,Serverless AI 原生应用架构应运而生。在该架构中,模型可通过 Serverless GPU(即函数计算 FC)进行部署,与 Agent 相关的 Sandbox、MCP Server、E2B 等服务也可托管于 FC。AI 网关作为模型与 MCP 服务的代理层,提供限流、鉴权、可观测性与安全护栏等功能。AI Agent 的开发支持低代码、零代码及高代码方式,可部署于 FC 或 SAE。Agent 前端通过网关进行代理,全链路配备 AI 应用观测能力,实现端到端可观测。

该架构具备以下特点:

特征一:全栈 Serverless,极致简化运维

整个架构中,函数计算 FC、SAE(Serverless应用引擎)、MSE Nacos、RocketMQ、AI 网关等关键组件均为 Serverless 形态或具备 Serverless 特性。无需管理底层服务器,自动扩缩容真正做到"一键部署、开箱即用"。

特征二:全链路高可用,保障业务连续性

架构中的每一个产品节点均支持多可用区部署,具备跨区域容灾能力。特别是函数计算 FC 提供的 Serverless GPU 实例,已实现三可用区冗余部署,并配备实例级健康检查与自动恢复机制,极大提升了模型服务的稳定性。

此外,AI 网关内置 Fallback 机制,在主模型不可用时可自动切换至备用模型,确保关键业务不中断。

特征三:双层安全保障,构筑可信 AI 防线

安全贯穿整个调用链路:

- 运行时安全:FC 和 SAE 采用实例隔离机制,防止租户间干扰;

- 调用层安全:AI 网关提供消费者鉴权、API Key 管理、内容审核等功能,有效防范未授权访问与恶意攻击。

特征四:简单易用,加速 AI 创新落地

所有产品都是云上托管,一键部署启动,常见模型与 MCP 服务已封装为模板,可在 FunctionAI 平台一键部署,不管你是零代码用户、低代码开发者,还是资深工程师,都能找到适合你的入口。

Serverless AI 架构的核心组件

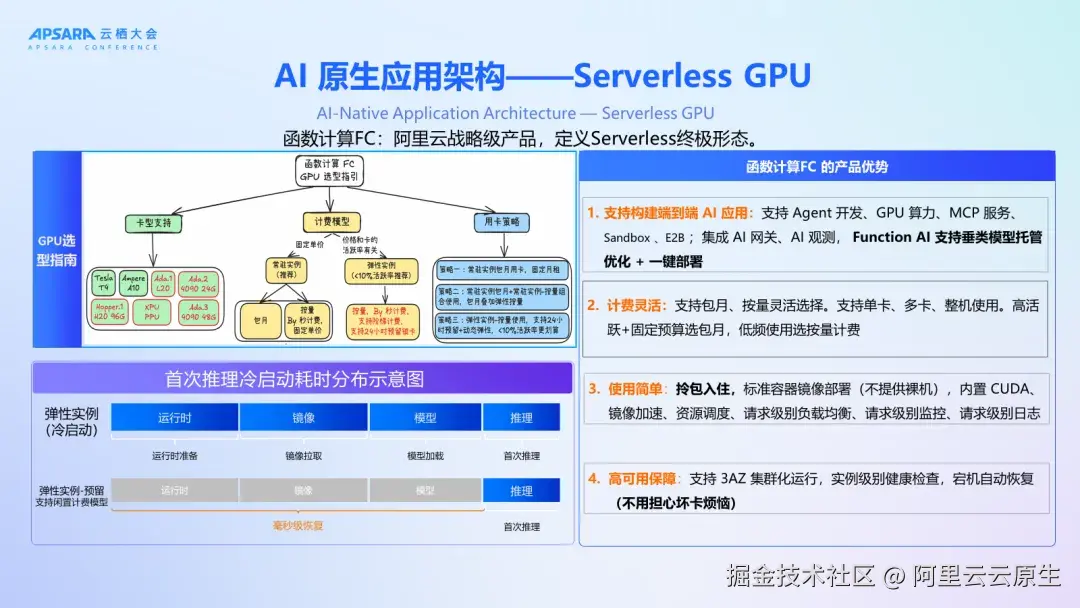

函数计算 FC:定义 Serverless 终极形态

定位为弹性经济的全托管 Serverless 计算服务,专用于部署大模型与 MCP 工具:

- 经济降本:支持卡切分(1/N GPU)、阶梯定价、常驻实例等策略,整体 GPU 利用率超 50%,成本更低。

- 极致弹性 :GPU 实例启动快(毫秒级/秒级) ,通过请求感知调度显著降低 RT 抖动, 支持定时/水位伸缩、延迟释放、会话亲和。

- 开发框架集成:内置 MCP Server、Sandbox 等服务运行时,支持模型微调镜像一键部署;

- 运维能力:提供镜像加速、资源调度、请求级监控日志,实现零运维体验。

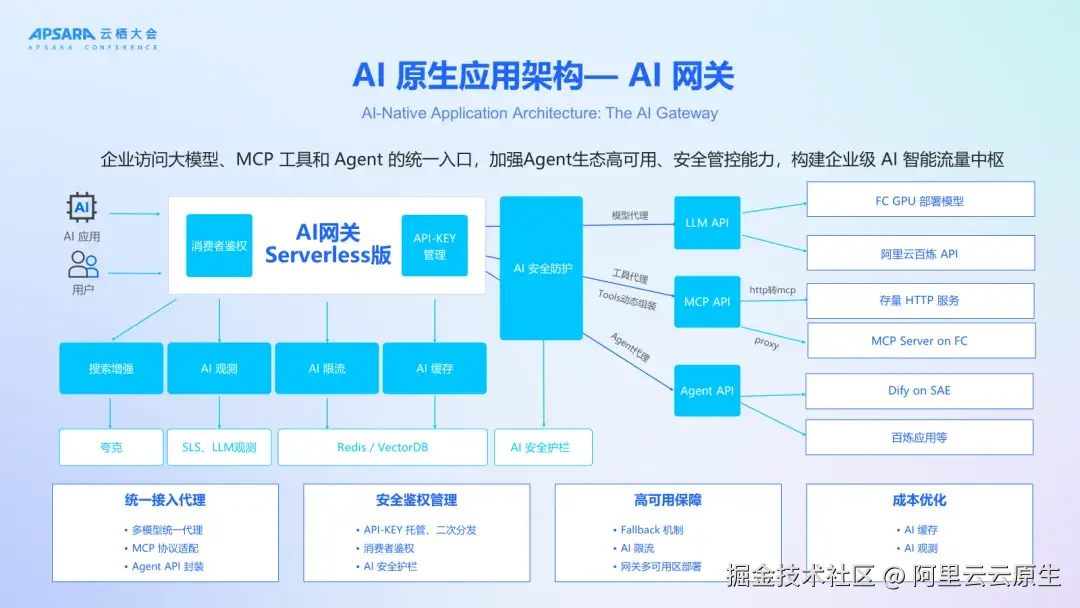

AI 网关:企业级 AI 流量中枢

作为模型、MCP、Agent 的统一接入入口,承担安全、治理与调度职责:

- 统一代理:支持多模型路由、MCP 协议适配、Agent API 封装,简化调用复杂度;

- 安全鉴权:集中管理 API-KEY,支持二次分发与消费者身份验证,设置 AI 安全护栏防范恶意输入与输出;

- 高可用保障:多可用区部署 + fallback 机制,异常时自动切换备用模型,支持精细化限流,保障核心业务稳定性;

- 成本优化:内置 AI 缓存减少算力资源消耗,结合观测能力实现 Token 级成本监控;

- 灵活扩展:支持动态组装 MCP 新工具链,快速接入外部 AI 服务。

总结展望

Serverless AI 原生架构不仅是技术演进,更是企业智能化转型的关键基础设施。它让开发者聚焦业务逻辑,让企业告别"基建焦虑",让 AI 真正"飞入寻常百姓家"。

正如本次演讲尾声所说:"让架构为业务赋能,让 AI 为世界创造更多可能。 "

阿里云将持续投入 Serverless 与 AI 原生架构研发,携手更多行业伙伴,共同构建开放、智能、安全的新一代 AI 应用生态。