在AI图像生成领域,扩散模型(如Stable Diffusion、FLUX)凭借惊人的生成质量成为主流,但"慢"始终是其落地的最大障碍------生成一张高清图往往需要几十步迭代,耗时数十秒,难以满足实时交互、移动端部署等场景需求。

2023年,潜在一致性模型(Latent Consistency Model, LCM)的提出,为这一痛点提供了突破性解决方案:通过"一致性蒸馏"技术,LCM将扩散模型的生成步数从50步压缩至2-4步,速度提升10倍以上,同时保持接近原始模型的生成质量。本文将深入解析LCM的技术原理、蒸馏逻辑与实践价值。

一、从"慢工出细活"到"快刀斩乱麻":扩散模型的效率困局

扩散模型的生成逻辑本质是"逆向加噪":从纯噪声开始,通过多步迭代逐步去除噪声,最终还原出清晰图像。这一过程类似"从模糊草稿慢慢雕琢细节",每一步只能优化少量噪声,必须依赖足够多的步骤才能保证质量。

以Stable Diffusion为例,默认需要50步迭代,每一步都要经过U-Net网络的复杂计算------在普通GPU上,单图生成耗时常超过10秒。这种"慢"的根源在于:

- 步骤依赖:每一步的输出是下一步的输入,无法跳步;

- 冗余计算:大量步骤用于优化细微噪声,对整体质量提升有限;

- 模型笨重:原始扩散模型参数量庞大(通常数十亿级),单步计算成本高。

为解决效率问题,研究者尝试过"减少步数"(如将50步减至20步),但直接缩减会导致图像模糊、细节丢失------就像"没完成雕琢的半成品"。而LCM的创新在于:通过蒸馏技术,让模型学会"跳步生成",用极少的步骤达到接近原始模型的效果。

二、LCM的核心:一致性蒸馏如何实现"跳步生成"?

LCM的本质是对原始扩散模型的"知识蒸馏",但不同于传统蒸馏的"模仿输出",它通过"一致性约束"让模型掌握"从任意噪声状态直接生成清晰图像"的能力。核心逻辑可拆解为三个关键步骤:

1. 定义"一致性":让模型学会"目标唯一"

扩散模型的加噪过程是一条"从清晰图像到纯噪声"的连续轨迹(数学上称为"概率流ODE")。例如,一张猫的图像会逐渐加噪为"轻微模糊的猫→中度模糊的猫→接近噪声的猫→纯噪声"。

LCM的"一致性"指:无论从这条轨迹上的哪个点(如"中度模糊的猫"或"接近噪声的猫")出发,模型都能直接预测出同一张清晰图像(原始猫图)。这种"起点任意,终点唯一"的约束,是LCM能"跳步"的核心------它不需要按顺序迭代,而是直接瞄准终点。

2. 教师模型的"传帮带":提供精准的蒸馏目标

LCM的训练依赖一个"教师模型"(即原始扩散模型,如Stable Diffusion),其作用是提供"标准答案":

- 对训练集中的每张图像,生成其不同加噪程度的版本(如5%、30%、70%噪声);

- 教师模型用自身的多步流程,对每个加噪版本生成对应的清晰图像(作为"标准答案");

- 训练LCM时,要求它对任意加噪版本的输出,必须接近教师模型的"标准答案"。

这一过程类似"学生(LCM)模仿老师(原始模型)的解题思路",但学生被要求"一步写出答案",而老师则"按步骤推导"。通过海量样本学习,LCM逐渐掌握教师模型的"去噪逻辑",但用更高效的方式实现。

3. 轻量化网络:为"快速推理"量身定制

LCM的网络结构基于原始扩散模型的U-Net,但做了针对性轻量化改造:

- 简化网络深度:减少U-Net的 encoder/decoder 层数,降低参数规模(通常为教师模型的1/5-1/10);

- 优化时间步编码:原始扩散模型需要复杂的时间步嵌入(用于区分不同迭代步骤),而LCM因"跳步生成",仅需简单编码当前噪声程度;

- 强化注意力聚焦:保留关键的交叉注意力模块(用于对齐文本提示与图像特征),但简化非关键区域的计算。

这种结构设计让LCM在单步计算效率上远超原始模型,配合"少步生成",最终实现"秒级出图"。

三、训练细节:如何让LCM"既快又准"?

LCM的训练过程围绕"一致性损失函数"展开,核心是让模型输出满足"两个一致性":

-

同图一致性:对同一图像的不同加噪版本,LCM的输出必须是同一张清晰图。例如,"30%噪声的猫图"和"70%噪声的猫图"经LCM处理后,必须都是同一只猫。

-

师生一致性:LCM的输出必须接近教师模型的输出。通过MSE损失函数(均方误差)计算LCM与教师模型输出的差异,强制两者特征分布对齐。

训练数据采用"真实图像+人工加噪"的方式构建:从COCO、LAION等大型图像数据集选取样本,用扩散模型的加噪公式生成不同噪声程度的版本,形成"加噪图-清晰图"训练对。无需依赖教师模型生成数据,避免引入生成误差。

四、效果与价值:从技术突破到落地场景

LCM的核心优势在于"速度与质量的平衡":

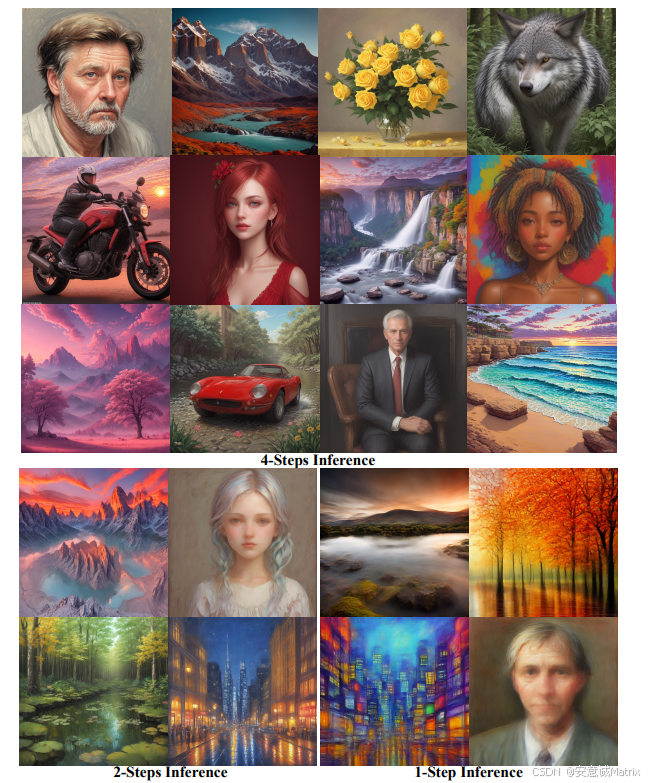

- 速度提升:在相同硬件下,生成步数从50步减至2-4步,推理速度提升10-25倍。例如,Stable Diffusion生成一张512x512图像需10秒,LCM仅需0.5-2秒;

- 质量保留:通过一致性蒸馏,LCM的生成图像在语义匹配、细节丰富度上与教师模型差异小于5%(人类主观评分);

- 资源友好:轻量化模型可在消费级GPU(如RTX 3060)甚至移动端运行,无需依赖高端集群。

这些特性使其在多个场景中具有不可替代的价值:

- 实时交互设计:设计师可在软件中实时输入文本,LCM秒级生成参考图,提升创作效率;

- 移动端AIGC应用:手机端AI绘图APP无需等待,即时生成用户所需图像;

- 大规模批量生成:电商平台用LCM批量生成商品图,成本降低90%以上。

五、挑战与未来方向

尽管表现出色,LCM仍存在局限:

- 复杂场景质量损失:在高分辨率(如1024x1024)或细节密集(如复杂纹理、多人物)场景中,少步生成可能导致细节模糊;

- 依赖教师模型:LCM的性能受限于教师模型,若教师模型本身存在缺陷(如手部生成失真),LCM会继承这些问题。

未来,LCM的发展方向可能包括:

- 多模态扩展:将一致性蒸馏应用于"文生视频""图文跨模态生成"等任务,解决多模态大模型的效率问题;

- 自蒸馏技术:让模型自我迭代优化,摆脱对教师模型的依赖;

- 动态步数调整:根据生成内容的复杂度自动选择步数(简单场景2步,复杂场景4-8步),平衡速度与质量。

结语

LCM的出现,打破了"高质量生成必须慢"的固有认知。通过"一致性蒸馏"这一巧妙设计,它让扩散模型在保持质量的同时实现了"量级提速",为AI图像生成的工业化落地扫清了效率障碍。从技术本质看,LCM的成功不仅是算法的胜利,更体现了"抓住问题核心(一致性)、简化冗余步骤"的工程思维------这种思路或许能为更广泛的AI模型轻量化提供借鉴。

随着技术的迭代,我们有理由相信,"又快又好"的AIGC体验将成为常态,而LCM正是这一进程中的关键一步。