近来,世界模型(World Model)很火。多个 AI 实验室纷纷展示出令人惊艳的 Demo:仅凭一张图片甚至一段文字,就能生成一个可交互、可探索的 3D 世界。这些演示当然很是炫酷,它们展现了 AI 强大的生成能力。

但一个关键问题随之而来:这些由 AI 生成的世界中,绝大部分事物都是模型想象和虚构的。

如果我们不满足于「创造」一个虚拟世界,而是想把我们当下生活的这个真实世界(比如我们的家、办公室、工厂和城市)完整地变成一个可交互、可计算的 3D 世界呢?

这正是如视(Realsee)想要解答的问题。11 月 13 日,如视,这家数字空间及空间智能综合解决方案引领者,正式发布了其空间大模型 Argus 1.0,这也是全球首个(目前也是唯一一个)支持全景图输入,推测空间深度的大模型。它所代表的正是与虚拟生成截然不同的另一条路径:真实复刻。而这背后,正是「空间智能」相关技术不断演进的结果。

Argus 1.0 的目标不是「虚构」世界,而是「还原」真实的世界。它能够以毫秒级的速度,从一个场景下的单张或多张全景/普通图像中,推理出所有图像带绝对尺度的相机位姿、深度图和点图。

体验地址:h5.realsee.cn/argus?UTM=a...

从想象到测量,从虚拟到真实,Argus 1.0 的出现为 2D 图像通向 3D 真实空间架起了一座高速桥梁。这一技术突破意味着什么?它背后是如视怎样的技术积累与战略布局?

带着这些问题,我们与如视副总裁、首席科学家潘慈辉博士进行了深入对话,试图解码 Argus 模型的技术特性,及其在如视「空间智能」版图中的关键角色。

Argus 1.0 诞生的基石

如视的「数字空间-算法-行业应用」飞轮

任何强大模型的诞生都不是空中楼阁,Argus 1.0 也不例外。它根植于如视自 2017 年成立以来,围绕空间数字化所构建的深厚壁垒。在与潘慈辉博士的交流中,他提到了一个核心概念:「数字空间-算法-行业应用」的飞轮循环。而这个飞轮的核心驱动力,正是如视引以为傲的「真实空间数据库」。

核心资产:全球最大的三维空间数据库

作为最初脱胎于贝壳找房的事业部,如视从房产交易这一刚需场景切入,开启了大规模空间数字化的进程。截至 2025 年 9 月,如视已在全球范围内积累了突破 5300 万套的数字空间数据,覆盖面积超过 44 亿平方米。

潘慈辉解释道:「这个全球最大的真实空间数据库,是如视算法能力迭代的驱动器。」

海量数据的积累,持续驱动着空间智能 AI 算法的提升;而更强的系统能力,又为房产租售、家装家居、商业零售、工业园区等九大行业提供了高质量的解决方案;这些解决方案的落地,反过来又让如视得以触达更多元化的空间场景数据。

高质量空间数据:高精度、完备且一致

如果说 5300 万的量构筑了护城河的宽度,那么数据的质则决定了护城河的深度。潘慈辉强调,Argus 1.0 最大的技术突破,正得益于如视坚持自研硬件与算法的技术路线,这为其带来了「完备且一致」的高质量数据。

潘慈辉说:「我们的数据最大的特色,是在硬件设计和标定阶段就保证了最终采集的图像数据和激光点云数据是完备的,并且做到了像素级精度的对齐。」

不同于业内一些只有图像数据(缺乏绝对尺度)或只有激光数据(缺乏纹理)的方案,如视通过自研的伽罗华(Galois)系列 3D 激光扫描仪(其 P4 型号可直出 3 亿像素超高清全景图,图像与点云平均匹配误差小于 2 个像素),确保了每一份数据都是「所见即所得」的高精度数据对。这种在源头就严格标定、高度一致的真实数据,是 Argus 1.0 能够学习到准确深度和绝对尺度的前提,也是其远超其他算法的养料。

伽罗华 Galois P4 亮点概览

应用导向的底层创新

强大的数据飞轮背后,是一支由如视副总裁、首席科学家潘慈辉博士带领的研发团队。据潘博士介绍,如视从创立之初就坚持应用导向的底层技术创新,平均每年的研发投入都在 2 亿人民币以上。这份坚决的技术投入,造就了如视的技术实力和底气。

持续的耕耘也为如视带来了国际上的权威认可。在学术上,如视团队的科研成果近年来多次入选 ICCV、CVPR 等国际顶会;在产品设计上,旗下的伽罗华 3D 激光扫描仪、REALSEE G1 手机云台和庞加莱手持实景扫描仪接连斩获 2021、2022 及 2023 年德国红点产品设计大奖。如今,这些技术和产品已服务于 9 大行业超过 3000+ 品牌客户,团队也已积累了 600 余项国内外授权专利。

正是这个由海量高质数据、软硬一体化和持续研发投入共同驱动的飞轮,为 Argus 1.0 的诞生奠定了基础。

Argus 1.0

从「单眼」到「百眼」的空间智能突破

如视算法团队喜欢用希腊神话人物为产品命名。潘慈辉在采访中分享道,单目图像深度估计算法 Cyclops(希腊神话中的独眼巨人),寓意着从单张图像、单一视角就能推测世界的深度。

而此次发布的 Argus 1.0,名称则源自希腊神话中的「百眼巨人」。这一命名极富象征意义,它预示着如视的重建技术正从「单视」推测跨越到「多视」全局一致性的新阶段。

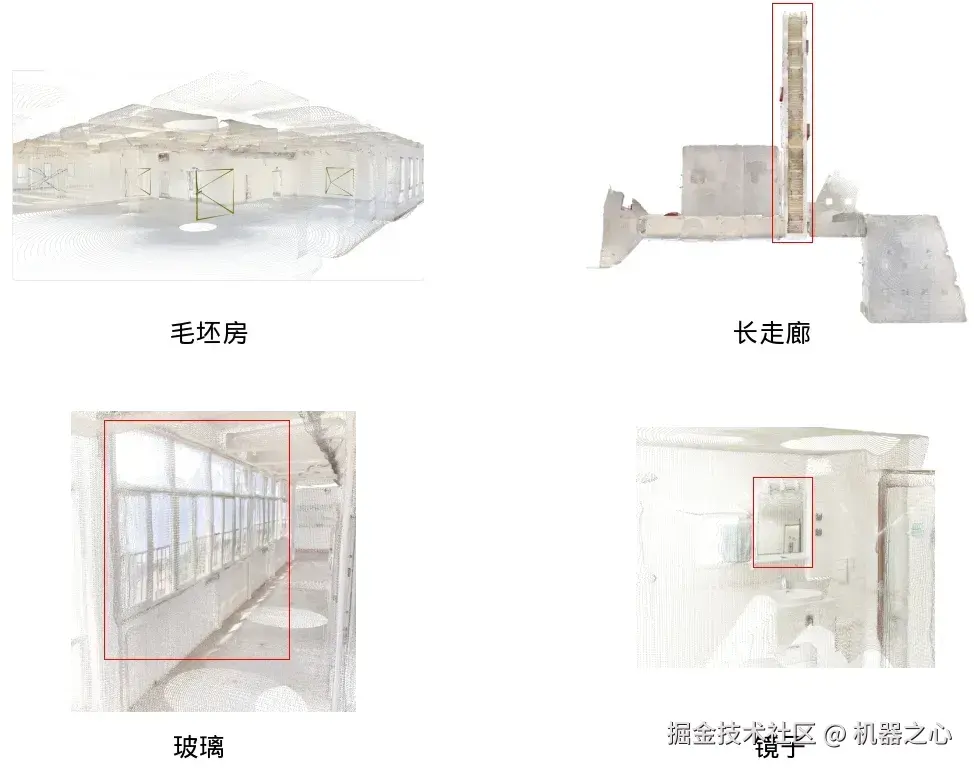

具体技术上,Argus 1.0 基于 Transformer 架构构建,是一个前馈式神经网络模型。该模型基于如视累积的 近百万套真实高清空间数据(包含对玻璃、镜面等难题的处理)进行训练。得益于 Transformer 架构的通用性及其与大规模 3D 数据训练的协同效应,Argus 1.0 实现了兼容性、实时性与生成质量三大维度的行业突破。

兼容性:业界首个支持全景图输入的推测大模型

首先是输入端的巨大突破。Argus 1.0 是目前业界已知首个、也是唯一一个支持全景图作为输入的深度推测大模型。

Argus 1.0 甚至可以将 AI 生成的全景图转换成点云

同时,它还广泛兼容单张 / 多张普通照片乃至 AI 生成的图片,具备极强的多源适应能力。

Argus 1.0 也支持普通图转点云

全景图推测深度的能力之所以重要,在于它直指 VR 内容生产的核心痛点。潘慈辉表示,Argus 1.0 能够「显著降低搭建全景图到 VR 的处理流程的门槛,极大提高处理效率」,让低成本、高效率的 3D 空间复刻成为可能。

实时性与一致性:毫秒级的全局重建

如果说 Cyclops 时代还是两步走,即先用算法推测单张全景图的深度,再通过额外的算法模块计算位姿、进行拼接;那么 Argus 1.0 则实现了一步到位。

潘慈辉向我们揭示了 Argus 1.0 的核心架构创新:「此次 Argus 的能力,是将之前 Cyclops 的深度推测能力和后续的位姿计算能力,融合到了一个算法模块中。」

通过将深度推测和位姿计算进行联合训练,模型得以更好地挖掘多视图之间的关联性,从而在全局尺度上实现更高的点云一致性和位姿精度。这一增量式到全局式的转变,带来了效率的质变。如视的官方报告显示,Argus 1.0 的推理效率达到毫秒级,是首个实时的全景图全局重建系统,真正实现了「全流程无感知响应」。

高质量:源自真实数据的稳健性

Argus 1.0 的高生成质量,则要归功于前文提到的如视独有的高精度、带尺度、像素级对齐的真实数据库。

在 3D 重建领域,玻璃、镜面、毛坯房、长走廊等场景一直是行业公认的难题。潘慈辉指出,其根源在于「一般的激光设备对玻璃镜子的测距能力不足,导致大家在学习过程中没有较好的监督数据」。

而如视的解决方案是其多年技术的自然结果:「我们的业务场景中会有专门的工具对玻璃镜子进行标注,根据这些标注,我们修正原始的有问题的激光点云。使用修正后的激光数据进行训练就能很好地解决这一难题。」

正是得益于海量、多样化且经过精细业务标注的养料,Argus 1.0 充分学习并掌握了这些困难场景的特征,使其在面对传统重建难题时依然表现稳定,生成的 3D 空间显著优于其他缺乏真实尺度和对齐能力的方案。

如视的版图

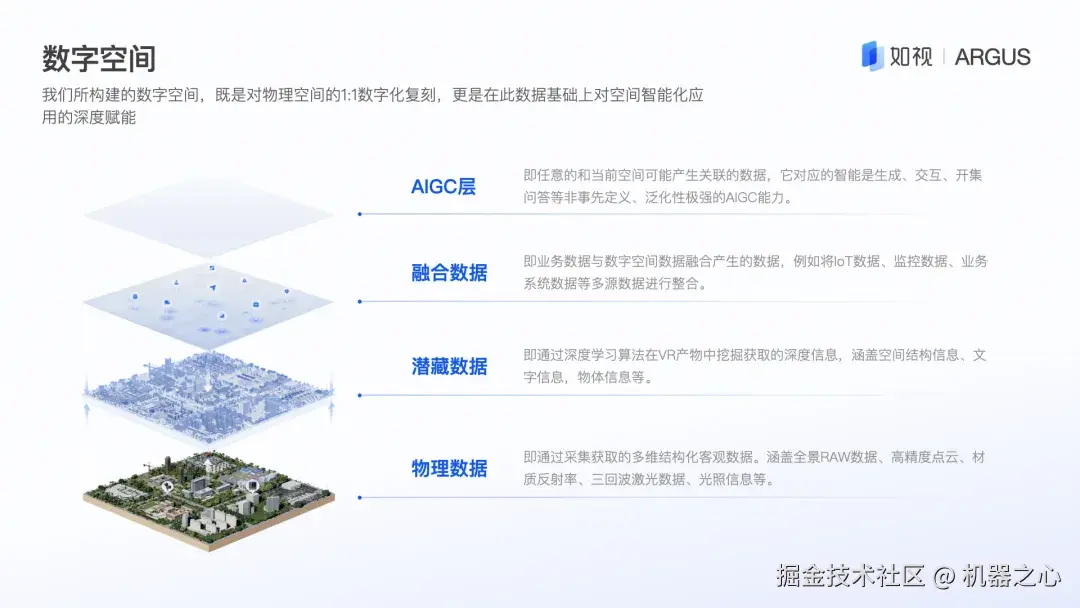

空间智能「四层理论」与 AIGC 终局

Argus 1.0 的发布,不仅是一款工具的升级,更是如视「空间智能」版图中的一块关键拼图。潘慈辉在采访中详细阐述了团队的研发脉络:一个结合自身实践总结出的「空间智能四层理论」。

这四层理论清晰地定义了从数字化到智能化的演进路径:

-

第一层:物理数据(重建):即 1:1 复刻;

-

第二层:潜藏数据(感知推理):理解空间结构、语义;

-

第三层:融合数据(业务):结合 CAD、IoT 等业务数据;

-

第四层:AIGC(生成交互):解决开集问题,实现泛化交互。

在这个框架下,Argus 1.0 是第一层(重建)的集大成者。它打通的 2D 到 3D 能力已经可以赋能诸多应用场景。例如,它可以用于生成时下流行的动态锁屏空间壁纸;潘慈辉在采访中提到:「Argus 模型推测的深度精度更高,分辨率更高,且深度带有绝对尺度信息」,效果优于苹果披露使用的深度推测算法。

更进一步,如视透露,预计于明年初发布的 Argus 2.0 及后续版本可进一步用于实时渲染的 3DGS 模型和精细 Mesh 模型,为空间漫游提供沉浸式数字基底。通过与如视自研的空间智能算法结合,它还能驱动空间 CAD 自动生成、高精度语义分割及白模构建等高阶应用,实现从物理世界到数字空间,再赋能现实应用的闭环。

潘慈辉也明确指出,团队的下一个重点难题,正是攻克第四层:AIGC 层。他认为,许多应用的答案不在空间本身,而在于链接「空间之外的信息」,如行业规范、人类偏好等。他总结道:「我们希望当 AIGC 这一层实现后,利用其空间之外的信息能力,我们能更加快速、低成本地对接更多的行业,输出解决方案。」

开放生态

为空间智能行业铺路

在实现自身技术闭环的同时,如视也发挥自身优势,为整个空间智能行业的基础设施「铺路」。

长期以来,空间智能领域的研究与应用面临着一个瓶颈问题:空间智能的「基石」------ 高质量的空间数据,存在巨大缺口。而如视一直以来的技术成果,恰好为解决这一问题打开了一扇窗。

因此,为了加速整个空间智能应用领域的研究演进,如视计划于今年年底开放 10000 套的室内房屋数据集(其中 1000 套新房数据、9000 套 AI 设计数据),这同时也是目前最大规模的空间三维数据集。这种开放生态,让更多人能站在如视积累的真实数据之上进行创新,从而整个行业的发展。

迈向空间智能的 AIGC 终局

从最初服务于房产交易的 VR 看房,到如今赋能九大行业的空间智能;从打磨软硬一体的采集闭环,到发布毫秒级的深度推测大模型 Argus,如视的路径清晰地展现了其「数字空间 - 算法 - 行业应用」飞轮的强大势能。

Argus 1.0 的发布,不仅是如视的飞轮势能的一次集中爆发,它也是一个空间信息解码器,为 3D 视觉领域带来了一个低门槛、高效率、高质量的基础工具。它向行业证明了一条核心路径:海量、高精度、高一致性的真实世界数据是训练空间基础大模型的决定性优势。

这标志着空间智能领域一个新纪元的开始:以真实数据为基石,从底层重建走向顶层 AIGC 应用的路径被正式打通。

随着如视这样的空间数据巨头不断推动技术演进和生态开放,一个万物可计算、虚实深度融合的未来,正加速向我们走来。