目录

- [0 论文基本信息](#0 论文基本信息)

- [1 内容摘要](#1 内容摘要)

- [2 核心研究](#2 核心研究)

-

- [2.1 主要解决问题](#2.1 主要解决问题)

- [2.2 主要使用方法](#2.2 主要使用方法)

- [2.3 主要实验手段](#2.3 主要实验手段)

- [3 分析与思考](#3 分析与思考)

-

- [3.1 评判式思考](#3.1 评判式思考)

- [3.2 创造性思考](#3.2 创造性思考)

0 论文基本信息

| 项目 | 内容 |

|---|---|

| 论文名称 | 《Federated learning with hierarchical clustering of local updates to improve training on non-IID data》 |

| 作者 | Christopher Briggs,基尔大学计算与数学学院,c.briggs@keele.ac.uk Zhong Fan, 基尔大学计算与数学学院,z.fan@keele.ac.uk Peter Andras,基尔大学计算与数学学院,p.andras@keele.ac.uk |

| 发表会议 | 【CCF-C】2020 International Joint Conference on Neural Networks (IJCNN) |

| 发表时间 | 2020 年 |

| DOI | 10.1109/IJCNN48605.2020.9207469 |

1 内容摘要

在联邦学习(FL)中引入层次聚类(HC)形成 FL+HC 方法,通过客户端局部模型更新的相似度聚类,为不同聚类训练专属模型。同时给出了适用于未知非IID数据的默认超参数配置。

论文贡献

- 提出 FL+HC 方法,通过单次层次聚类实现专属模型训练,兼顾准确率与通信效率。

- 系统刻画了层次聚类在不同IID/非IID场景下的影响,验证了方法通用性。

- 实证分析超参数影响,给出未知非IID数据的默认超参数(L1距离+全链接)。

2 核心研究

2.1 主要解决问题

解决联邦学习(FL)在非 IID 数据上的性能下降问题,提高模型在异构数据分布下的准确率,同时降低通信成本。

2.2 主要使用方法

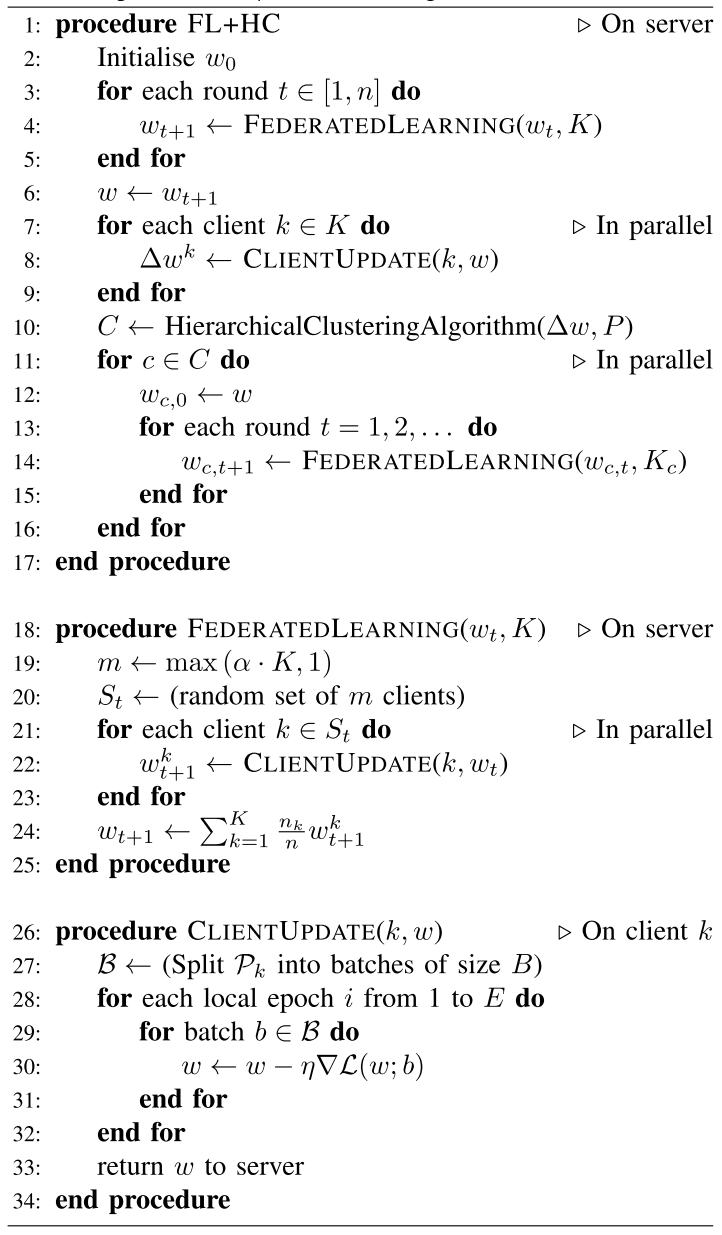

下图展示了算法流程,首先用标准联邦学习(FedAvg)进行 n n n 轮训练,然后根据第 n n n 轮所有客户端的局部模型更新根据相似度进行凝聚式层次聚类: 初始每个客户端为独立聚类,迭代合并相似度最高的聚类,直到聚类间距离超过阈值 T T T。聚类停止后,每个聚类独立并行训练专属模型,初始参数为之前第 n n n 轮后的全局模型参数。

2.3 主要实验手段

📚数据集与任务:

| 数据集名称 | 任务 | 数据划分方案 | 划分细节 |

|---|---|---|---|

| MNIST | 手写数字图像分类 | IID | 将所有数据打乱,并将其平均分配给100个客户端,每个客户端含 600 张样本。 |

| MNIST | 手写数字图像分类 | 非 IID-1(Pathological) | 100 个客户端,每个客户端仅分配 2 类数字标签的样本,每个客户端含 600 张样本。 |

| MNIST | 手写数字图像分类 | 非 IID-2(Label-swapped) | 1. 先随机打乱所有训练数据,划分为 4 个数据组; 2. 每组内交换 2 个数字的标签); 3. 每个组分配给 25 个客户端,共 100 个客户端,每个客户端 600 张样本。 |

| FEMNIST | 手写字符图像分类 | 非 IID-3(User-partitioned) | 1. 从原始 3500 个书写者中随机选择 367 个,每个书写者作为 1 个客户端; 2. 客户端样本量不均:每个客户端含 12-386 张样本(因不同书写者的字符数量不同); 3. 样本特征因书写风格差异呈现自然分布差异。 |

其中,非 IID-1(Pathological)用来研究 label distribution skew 情况,非 IID-2(Label-swapped)用来研究 Concept shift (same features, different label) 情况,非 IID-3(User-partitioned)用来研究 Feature distribution skew 情况。

🏃♀️基线与模型配置

- 基线:经典 FederatedAveraging 算法。

- 模型:简单 CNN(2 个卷积层 + 池化层 + 全连接层)。

- 训练参数:客户端批次大小10、局部迭代3轮、学习率0.1,总训练轮次50。

🔢实验变量

- 聚类前训练轮次 n n n(1/3/5/10)。

- 客户端参与比例 c f cf cf(0.1/0.2/0.5/1.0)。

- 层次聚类超参数(距离度量、链接方式、阈值 T T T)。

✏️ 度量指标

- 平均测试准确率:所有客户端在测试集上的平均分类准确率。

- 达到目标准确率的客户端百分比:MNIST目标为99%,FEMNIST为80%。

- 收敛速度:达到特定准确率所需的通信轮数。

🔍 实验结果

(一) 不同客户端比例 c f cf cf 和聚类前训练轮次 n n n 的影响

| 数据设置 | 最佳 c f cf cf / n n n | 关键发现 |

|---|---|---|

| IID | 任意 c f cf cf, n > 1 n > 1 n>1 | FL+HC 不分裂,表现与 FL 一致; n = 1 n=1 n=1 时略差(随机性干扰) |

| Pathological 非IID | c f < 1.0 cf < 1.0 cf<1.0, n = 1 n = 1 n=1 | 聚类后立即提升 1.3x--1.9x 准确率;最终准确率相同,但收敛更快;更多客户端达到目标准确率 |

| Label-swapped 非IID | 任意 c f cf cf, n = 10 n = 10 n=10 | FL 上限 80%;FL+HC 接近 IID 性能(~99%);80% 客户端达到 99% 目标准确率 |

| FEMNIST 非IID | c f = 1.0 cf = 1.0 cf=1.0, n = 10 n = 10 n=10 | FL+HC 提升有限,有时略差于 FL;更多训练轮次和更高 c f cf cf 有助于提升性能 |

📌 结论:

- FL+HC 在明确聚类结构的非IID数据中表现最佳。

- 聚类前训练轮次 n n n 对聚类质量至关重要 , n n n 太小则噪声大, n n n 太大则可能模型已收敛,聚类意义下降。

(二)层次聚类超参数的影响

| 数据设置 | 最佳距离度量 | 最佳链接方式 | 关键发现 |

|---|---|---|---|

| IID | 欧式 / 余弦 | 任意 | 不分裂,性能与 FL 一致;曼哈顿距离错误分裂,性能下降 |

| Pathological 非IID | 曼哈顿 | 任意 | 聚类后第10轮准确率 > FL 第50轮(IID),通信轮次减少 >5x |

| Label-swapped 非IID | 余弦 | 任意 | 方向相似性 > 幅度相似性;FL+HC 接近 IID 性能 |

| FEMNIST 非IID | 欧式 / 曼哈顿 | 全链接 | 提升有限;曼哈顿+全链接使更多客户端达到目标准确率(+1.1x) |

📌 结论:

- 曼哈顿距离适用于高维稀疏更新向量(如Pathological)。

- 余弦距离适用于方向一致性更重要的场景(如Label-swapped)。

- 链接方式影响较小 ,但全链接通常更稳定。

默认超参数建议

当非IID类型未知时,推荐使用:

- 距离度量:曼哈顿(L1)

- 链接方式:全链接

- 聚类前训练轮次 n n n:10

- 客户端比例 C f C_f Cf:0.2

3 分析与思考

3.1 评判式思考

| 优势 | 劣势 |

|---|---|

| ✅ 无需先验知识:仅依赖模型更新,不依赖客户端元数据(如时区) | ❌ 对某些非IID类型敏感:如FEMNIST中提升有限 |

| ✅ 单次聚类:计算负担低,适合大规模部署 | ❌ 超参数调优依赖 :阈值 T T T、距离度量等需经验或调优 |

| ✅ 提升收敛速度:在某些非IID设置下通信轮次减少 >5x | ❌ IID 场景无效:甚至可能因错误分裂而略降性能 |

| ✅ 提升客户端参与度:更多客户端达到高准确率 | ❌ 隐私与噪声敏感:未测试在差分隐私或压缩下的表现 |

3.2 创造性思考

| 方向 | 内容 |

|---|---|

| 动态聚类机制 | 是否可以在训练过程中多次聚类,以适应数据分布的变化? |

| 自适应超参数 | 能否根据客户端更新分布自动选择距离度量或阈值? |

| 联邦聚类 | 能否在保护隐私的前提下,在客户端本地进行聚类? |

| 恶意客户端检测 | 利用聚类识别异常更新,提升联邦学习的安全性 |

| 跨模态/任务扩展 | 是否适用于跨模态联邦学习 或多任务学习场景? |

| 与个性化联邦学习结合 | 将 FL+HC 与 FedAvg+Fine-tuning 或 Meta-Learning 结合 |