全文目录:

-

- 开篇语

- 摘要

- [一、为什么是 Kurator,而不是再造一个"自研多集群平台"?](#一、为什么是 Kurator,而不是再造一个“自研多集群平台”?)

- [二、Kurator 的技术栈与架构:一栈统一的"舰队中枢"](#二、Kurator 的技术栈与架构:一栈统一的“舰队中枢”)

-

- [2.1 技术栈全景:站在巨人的肩膀上](#2.1 技术栈全景:站在巨人的肩膀上)

- [2.2 舰队管理:从"集群拼盘"到"舰队视图"](#2.2 舰队管理:从“集群拼盘”到“舰队视图”)

- [三、从 0 到 1:Kurator 分布式云原生环境搭建实践](#三、从 0 到 1:Kurator 分布式云原生环境搭建实践)

-

- [3.1 环境规划:先想清楚"你要管几类集群"](#3.1 环境规划:先想清楚“你要管几类集群”)

- [3.2 安装前准备:几个容易忽略的小点](#3.2 安装前准备:几个容易忽略的小点)

- [3.3 安装 Kurator:从 Cluster Operator 到舰队](#3.3 安装 Kurator:从 Cluster Operator 到舰队)

- [3.4 安装过程中的典型"小问题"与解决思路](#3.4 安装过程中的典型“小问题”与解决思路)

- [四、Kurator 核心功能实战:把"统一"二字落到地上](#四、Kurator 核心功能实战:把“统一”二字落到地上)

-

- [4.1 统一集群生命周期治理:从"手工创建"到"声明式舰队管理"](#4.1 统一集群生命周期治理:从“手工创建”到“声明式舰队管理”)

- [4.2 统一应用分发:GitOps + 多集群编排的组合拳](#4.2 统一应用分发:GitOps + 多集群编排的组合拳)

- [4.3 统一流量治理:跨集群服务网格的实践体验](#4.3 统一流量治理:跨集群服务网格的实践体验)

- [4.4 统一监控:从"图表大杂烩"到"按舰队与场景切片"](#4.4 统一监控:从“图表大杂烩”到“按舰队与场景切片”)

- [4.5 统一策略管理:用 Kyverno 守住"基线"](#4.5 统一策略管理:用 Kyverno 守住“基线”)

- 五、企业级落地案例:两个典型场景的组合实践

-

- [5.1 案例一:多云 SaaS 平台的舰队化管理](#5.1 案例一:多云 SaaS 平台的舰队化管理)

-

- [5.1.1 背景与痛点](#5.1.1 背景与痛点)

- [5.1.2 Kurator 落地步骤](#5.1.2 Kurator 落地步骤)

- [5.1.3 收益与反思](#5.1.3 收益与反思)

- [5.2 案例二:边缘 AI 推理的云边协同实践](#5.2 案例二:边缘 AI 推理的云边协同实践)

-

- [5.2.1 背景与需求](#5.2.1 背景与需求)

- [5.2.2 Kurator 在其中扮演的角色](#5.2.2 Kurator 在其中扮演的角色)

- [5.2.3 实际效果](#5.2.3 实际效果)

- [六、Kurator 与开源社区:贡献与协同的双向奔赴](#六、Kurator 与开源社区:贡献与协同的双向奔赴)

- [七、Kurator 前瞻创想:分布式云原生的下一步](#七、Kurator 前瞻创想:分布式云原生的下一步)

-

- [7.1 更智能的多集群调度与成本优化](#7.1 更智能的多集群调度与成本优化)

- [7.2 云原生 AI 运维(AIOps)的进一步融合](#7.2 云原生 AI 运维(AIOps)的进一步融合)

- [7.3 更开放的插件与生态体系](#7.3 更开放的插件与生态体系)

- [八、给 Kurator 的几点"用户建议"](#八、给 Kurator 的几点“用户建议”)

- [九、总结:从"会用 Kubernetes"到"驾驭分布式云原生舰队"](#九、总结:从“会用 Kubernetes”到“驾驭分布式云原生舰队”)

- 文末

开篇语

今天我要给大家分享一些自己日常学习到的一些知识点,并以文字的形式跟大家一起交流,互相学习,一个人虽可以走的更快,但一群人可以走的更远。

我是一名后端开发爱好者,工作日常接触到最多的就是Java语言啦,所以我都尽量抽业余时间把自己所学到所会的,通过文章的形式进行输出,希望以这种方式帮助到更多的初学者或者想入门的小伙伴们,同时也能对自己的技术进行沉淀,加以复盘,查缺补漏。

小伙伴们在批阅的过程中,如果觉得文章不错,欢迎点赞、收藏、关注哦。三连即是对作者我写作道路上最好的鼓励与支持!

摘要

站在在多云、多集群、跨云跨边成为主旋律的今天,单集群视角的 Kubernetes 平台已经难以承载企业业务的复杂性。Kurator 作为华为云开源的一栈式分布式云原生套件,通过整合 Kubernetes、Istio、Prometheus、FluxCD、KubeEdge、Volcano、Karmada、Kyverno 等主流技术栈,在其之上构建"舰队管理 + 统一治理能力",为企业提供了从基础设施到应用运维的全栈分布式云原生解决方案。

这篇文章将从一名云原生平台工程师的视角,系统梳理我从 0 到 1 体验 Kurator 的过程,包括:

- 环境搭建与安装中遇到的真实"小坑"与绕坑经验;

- 围绕"集群生命周期治理、统一应用分发、统一流量治理、统一监控与统一策略管理"五大能力的实战使用;

- 结合两个典型场景(多云 SaaS 平台与边缘 AI 推理),构建一个相对完整的落地案例;

- 在此基础上,对 Kurator 所依托的 Karmada、KubeEdge、Volcano 等社区项目做前瞻性分析,并提出个人对分布式云原生发展方向的一些思考与建议。

希望通过这篇"偏实战 + 偏架构 + 偏前瞻"的长文,给正在考虑或已经在使用 Kurator 的同学一些体系化参考,也希望能为 Kurator 社区的发展贡献一点"用户侧视角"的声音。🙂

一、为什么是 Kurator,而不是再造一个"自研多集群平台"?

在真正落地 Kurator 之前,我们其实经历过一段"自研多集群控制平面"的迷惘期------脚本、Operator、GitOps、服务网格拼拼凑凑也能搭出一套"勉强好用"的多集群管理方案,但越走越感觉几个明显的痛点:

-

多集群视图碎片化

- IaaS 层:云厂商控制台各自一套;

- K8s 层:自研控制面 + 各集群的 kubeconfig;

- 运维能力:监控、日志、告警、策略分散在不同系统里;

结果就是:人肉做"脑内聚合层",排障成本极高。

-

多技术栈的集成与升级巨贵

为了实现多集群应用分发、服务治理和监控告警,我们陆续引入了:

- Karmada / Federation 方案尝试多集群调度;

- Istio / ASM 实现流量治理;

- Prometheus + Thanos + Loki + Grafana 做可观测性;

- Kyverno / OPA 做策略管理。

真正难的不是"能不能集成",而是"能不能稳定地长期维护"。

-

跨云跨边需求越来越强

- SaaS 客户要求:支持"客户私有云部署 + 公有云托管混合模式";

- 边缘侧越来越多 AI 推理节点、IoT 网关,需要 KubeEdge 这类边缘框架来管理。

如果没有一个统一的"舰队视图",很难支撑这种业务扩张。

正是在这样的背景下,我们开始认真调研 Kurator:

- 官方定位是"分布式云原生开源套件",目标就是帮助用户构建自己的分布式云原生基础设施;

- 官方文档与社区信息显示,Kurator 不是重新造轮子,而是站在现有主流项目之上做一栈整合与统一治理------这一点很戳我们。

简单说:Kurator 提供的价值,是把我们原本"自研 + 拼装"的那一堆东西,用更一致的架构、统一的 API 和统一的多集群视图帮你"做了一遍系统化设计"。

于是,一个实践项目就这样被拉起来了:用 Kurator 把现有多云、多集群、边缘节点统一接管,并在新业务上优先采用 Kurator 的统一治理能力。

二、Kurator 的技术栈与架构:一栈统一的"舰队中枢"

2.1 技术栈全景:站在巨人的肩膀上

从 Kurator 官方代码与文档可以看到,它并不是一个"从零写起的独立平台",而是明确地站在了多个成熟社区项目之上:

-

底座层

- Kubernetes:核心编排与调度平台;

- Cluster API / Kubespray:在不同基础设施上管理集群生命周期。

-

基础能力集成层

- Istio:统一服务治理与流量控制;

- Prometheus / Alertmanager / Grafana:统一监控与告警;

- FluxCD / GitOps 体系:统一应用分发与持续交付;

- Kyverno / 其他策略引擎:统一策略管理与安全合规。

-

分布式与边缘场景支撑

- Karmada:多云、多集群资源编排与调度;

- KubeEdge:云边协同与边缘节点管理;

- Volcano:面向 AI / 批任务的高性能调度器。

-

Kurator 增值层能力

- Cluster Operator:统一的集群生命周期治理组件,支持本地数据中心集群、云上自建集群(如 AWS)。

- Fleet(舰队)管理:在 cluster 之上抽象出"舰队"概念,把物理集群组织为逻辑集群组,便于统一编排、流量治理和监控运维。

简单概括:Kurator 把"分布式云原生"拆解为若干能力域,然后在每个能力域选择成熟开源项目作为"积木",再用自己的控制器和 API 做一个统一抽象与编排层。

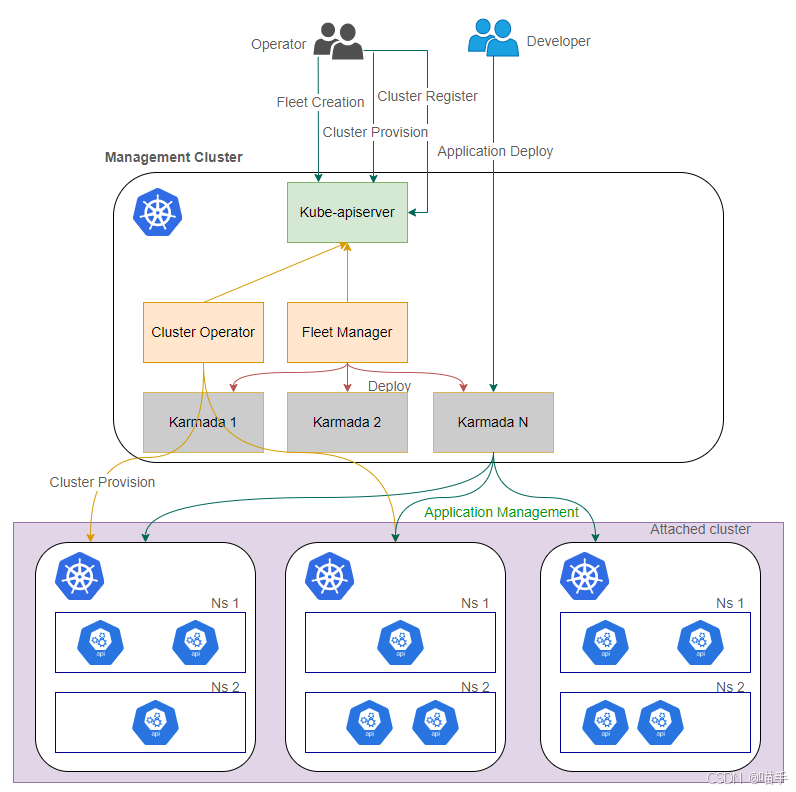

2.2 舰队管理:从"集群拼盘"到"舰队视图"

在 Kurator v0.3.0 的版本介绍中,"舰队"是一个关键概念:

-

每个舰队代表一组物理集群;

-

Kurator 通过舰队实现统一视图、统一编排和统一治理;

-

在舰队之上,你可以做:

- 一次性的多集群应用分发;

- 按舰队维度做流量灰度、全链路监控;

- 按舰队维度做策略统一下发与审计。

对我们这样的多云/多 Region 场景非常友好:

-

一个典型的划分是:按业务域或租户划舰队,例如:

- fleet-saas-cn:国内 SaaS 集群;

- fleet-saas-oversea:海外 SaaS 集群;

- fleet-ai-edge:边缘 AI 集群;

-

也可以按"环境属性"划分:

- fleet-dev、fleet-staging、fleet-prod。

之前我们是"集群列表拼在一起",在 Kurator 里则变成 更贴近业务认知的舰队视图,这对运维组织方式、权限模型与责任边界都有很大帮助。

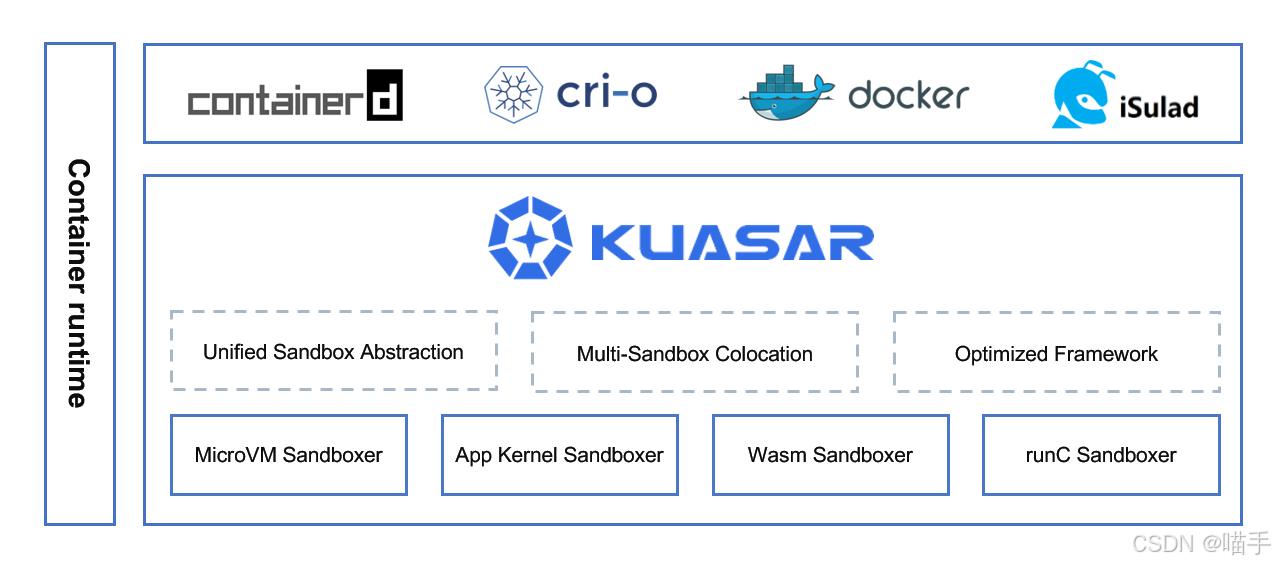

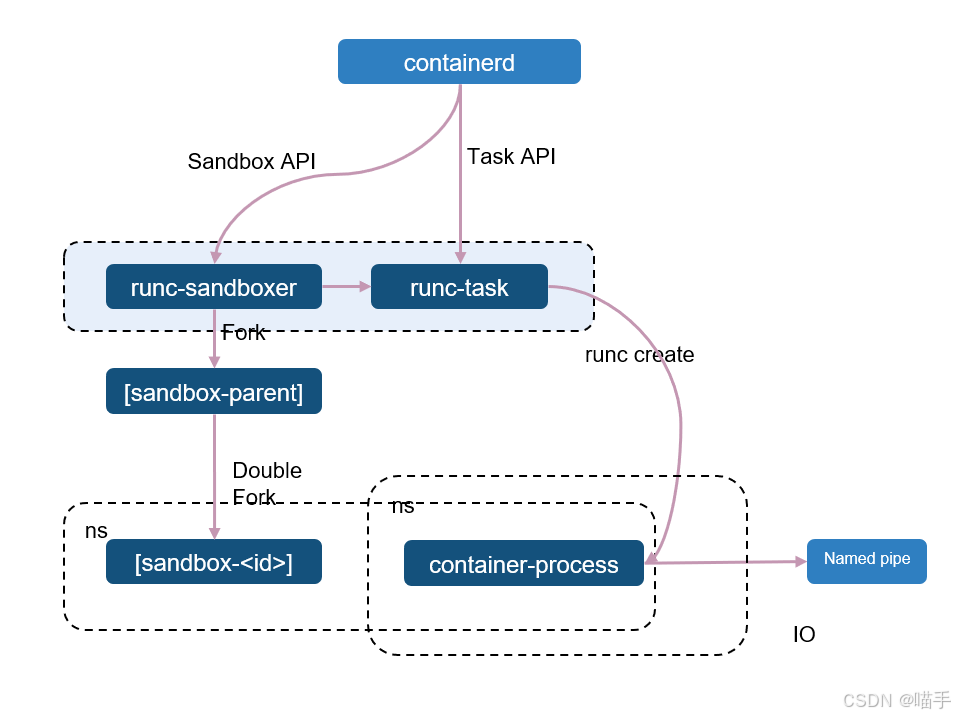

Kuasar Architecture相关架构图如下所示:

三、从 0 到 1:Kurator 分布式云原生环境搭建实践

下面进入"真刀真枪"的部分:我按自己的实践路径,把 Kurator 的入门搭建过程拆成几个阶段。

说明:以下环境和命令示例是基于官方文档 + 自身经验的综合总结,并做了简化和抽象,重点是思路而非逐行教程。

3.1 环境规划:先想清楚"你要管几类集群"

我们真正开始部署之前,先画了一张简单的集群拓扑规划图:

-

Kurator 控制面集群

- 运行 Kurator 本身的控制器组件(Cluster Operator、舰队管理等);

- 这里也可以同时作为一个业务集群,但实践中我更建议控制面与核心业务适度解耦。

-

多云业务集群

- 本地数据中心集群:基于裸机 + Kubespray 构建;

- 公有云自建集群:如 AWS、华为云等,通过 Kurator 接管;

-

边缘集群

- 以 KubeEdge 为主,在边缘节点上运行 AI 推理、IoT 数据汇聚等场景。

-

多集群编排与监控系统

- Karmada 控制面(可与 Kurator 控制面合并或独立部署);

- 统一监控栈(Prometheus/Thanos/Grafana)。

Kurator 的角色:站在这些集群之上,负责统一生命周期治理、舰队管理和能力编排。

3.2 安装前准备:几个容易忽略的小点

在实际安装 Kurator 的过程中,有几个容易踩坑的点值得提前提醒一下:

-

基础 Kubernetes 版本统一

- 虽然 Karmada、KubeEdge 等组件对 Kubernetes 版本的兼容性较好,但不同云厂商、不同集群创建方式产生的版本差异会放大问题;

- 实战建议:尽量将所有纳入 Kurator 管理的集群统一到一个主线版本(例如 v1.28),至少大版本保持一致。

-

云厂商 Credential 管理

- 在接管 AWS 自建集群时,Kurator 会帮你做很多 IAM 相关工作(例如自动校验凭据、自动关联 IAM 与 Pod 身份等),但前提是你的凭据本身是正确的;

- 建议为 Kurator 准备一套专用的最小权限账号,并严格限制使用范围。

-

DNS 与网络连通性

- 控制面集群到各业务集群的 API Server 必须网络可达;

- 内网专线 + 公网混合时,最好提前梳理好"哪个连接走哪条链路",否则排查起来很麻烦。

3.3 安装 Kurator:从 Cluster Operator 到舰队

实际安装过程中,大体步骤可以抽象为:

-

在控制面集群安装 Kurator 基础组件

- 安装方式可选择 helm 或 manifest;

- 关键是把 Cluster Operator、Fleet 管理等核心 CRD 与控制器跑起来。

-

注册业务集群

-

本地数据中心集群:

- Kurator 基于 Kubespray 做了声明式封装,可以通过一个 Cluster CR 描述目标集群规模、节点配置等;

- Cluster Operator 负责真正的创建、扩缩容和清理。

-

AWS 自建集群:

- 通过 Kurator 提供的 Cluster API 封装,声明好 Region、VPC、子网、节点池等信息即可;

-

-

创建舰队并把集群纳入舰队

- 对应的 Fleet CR 中指定包含哪些 Cluster;

- 从运维视角看,Fleet 更像是一个"多集群命名空间",你可以对它做策略、流量、监控等的统一配置。

3.4 安装过程中的典型"小问题"与解决思路

在整个过程里,我遇到的一些代表性问题:

-

Cluster CR 校验失败

- 一开始写的 Cluster CR 中,部分字段名和版本与当前 Kurator 版本不匹配;

- 解决方式:强烈建议跟着当前版本文档中的示例 YAML 走,再根据自己需求修改,而不是自己"想象着写"。

-

本地数据中心裸机节点 SSH 失败

-

Kurator 在基于 Kubespray 管理本地集群时,需要能够 SSH 到各节点;

-

一开始没留意到跳板机和内网节点的互信问题,导致任务中途失败;

-

最终通过:

- 使用专用部署节点作为跳板机;

- 统一配置无密码 SSH;

- 将该部署节点的网段加入防火墙白名单。

-

-

多集群 kubeconfig 管理混乱

-

早期我们是通过手动切换 kubeconfig 的方式接入各集群,很容易搞混;

-

Kurator 接管之后,建议:

- 明确"控制面 kubeconfig"与"成员集群 kubeconfig"的使用场景;

- 所有对成员集群的操作,尽量通过 Kurator 提供的 CR / API / GitOps 路径,而不是"直接 kubectl 进去改"。

-

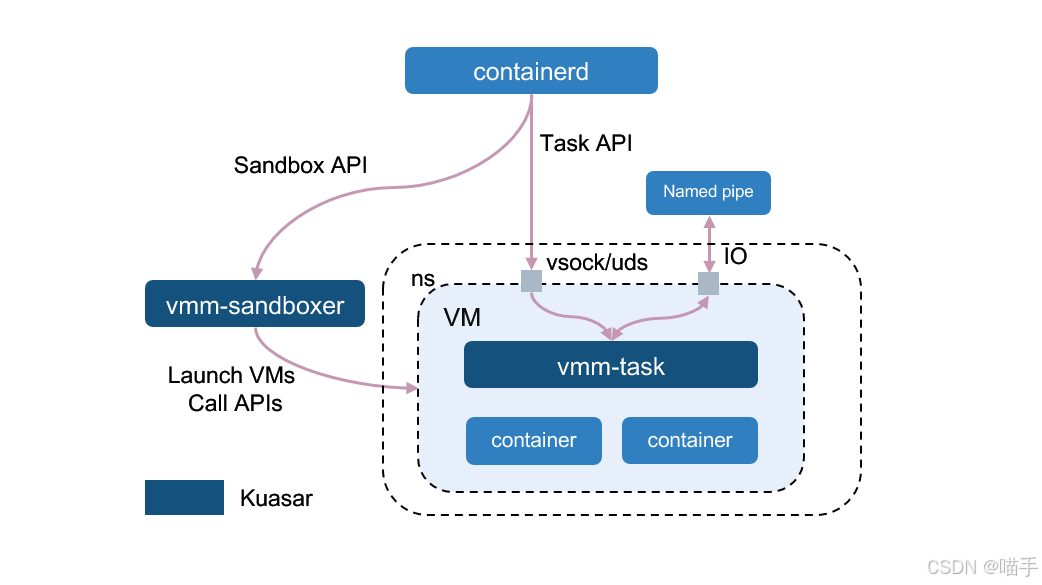

MicroVM Sandboxer流程图示意如下:

四、Kurator 核心功能实战:把"统一"二字落到地上

Kurator 官方在介绍中强调了"五个统一":统一集群生命周期、统一应用分发、统一流量治理、统一监控、统一策略管理。

下面我按日常工作中最常用的几个能力,逐一拆解。

4.1 统一集群生命周期治理:从"手工创建"到"声明式舰队管理"

在没有 Kurator 之前,集群生命周期大致是这样的:

- 新需求来了 → 找云厂商控制台或 Terraform → 手动/脚本创建集群;

- 需要升级 → 每个集群各自按云厂商/脚本流程执行升级;

- 要扩容 → 不同集群分别操作。

使用 Kurator 之后,职责有了比较清晰的分层:

-

Cluster CR 负责描述期望状态

- 包含:Kubernetes 版本、节点池信息、网络配置、高可用策略等;

- 对运维同学来说,日常主要工作就是维护这些 CR。

-

Cluster Operator 负责实现状态收敛

- 负责创建、扩缩容、升级和删除实际集群;

- 提供批量节点扩缩容、版本升级、增强控制面高可用等能力。

-

舰队视角的集群管理

- 对于成批的集群,可以通过舰队做更高层面的抽象和统一操作。

使用体验上的改变:

-

以前:

-

"我要新建一个集群",意味着:

- 找对应云厂商;

- 调整参数;

- 把各种插件再装一遍。

-

-

现在:

-

"我要新建一个集群",更多是:

- 拷贝一份已有 Cluster CR 模板;

- 修改少量参数;

- 提交到 Git 仓库或直接 apply。

-

流程变得更像是在写代码,而不是"点控制台"。

4.2 统一应用分发:GitOps + 多集群编排的组合拳

在应用分发这一块,Kurator 的思路基本是:

- 利用 FluxCD / GitOps 工具实现配置即代码;

- 通过 Karmada 等多集群编排能力,把一次声明分发到多个集群。

典型实践是这样的:

-

在 Git 仓库中维护应用部署清单(HelmRelease、Kustomization 等);

-

在 Kurator 中配置好某个舰队或一组选定集群与对应 Git 仓库的关联;

-

配置多集群调度策略:

- 例如使用 Karmada 的 PropagationPolicy 决定哪些应用下发到哪些集群;

- 再配合 OverridePolicy 做差异化配置(如不同 Region 用不同镜像仓库、存储类等)。

使用后的明显变化:

-

以前是"按集群部署",现在是"按舰队/策略部署";

-

以前发布流程里经常出现"某个 region 忘记更新"的低级错误,现在通过 GitOps + 多集群编排,大多可以避免;

-

灰度发布更顺滑:

- 可以先在一个舰队内部的少量集群上线;

- 平稳后再扩展到整个舰队甚至其他舰队。

4.3 统一流量治理:跨集群服务网格的实践体验

Kurator 利用 Istio 等服务网格组件提供统一流量治理能力,主要价值体现在:

-

统一的东西:

- 微服务之间的访问控制(mTLS、流量策略);

- 灰度发布 / 金丝雀发布 / 分阶段流量切换;

- 针对某些关键路径的熔断、限流与重试策略。

在多集群场景下,流量治理的复杂度会显著提升:

-

单集群 Istio:多是 namespace / service 粒度的流量控制;

-

多集群 Istio:

- 需要考虑 trust domain、跨集群 service 发现、网关/入口统一管理等。

借助 Kurator 的舰队抽象,我们把流量治理策略划分为两层:

-

舰队级流量策略

- 比如 fleet-prod-saas 内所有服务之间默认开启 mTLS;

- 某些租户级服务之间需要严格的访问白名单。

-

应用级流量策略

- 针对某个重要服务(如结算服务),配置更严苛的熔断和限流策略;

- 灰度发布时,以舰队为单位进行"灰度集群"划分,逐步放量。

在实际使用中,一个明显感受是:

当你有了舰队抽象后,多集群服务网格"可理解性"大幅提升,不再只是一堆分散的 Istio CRD。

4.4 统一监控:从"图表大杂烩"到"按舰队与场景切片"

监控体系是另一个 Kurator 发挥"统一视图"价值的地方。

Kurator 集成的监控方案重心仍然是 Prometheus + Alertmanager + Grafana 等组件,结合多集群聚合(如 Thanos/Loki 等),但关键在于:

- 在 Kurator 层面,我们可以按舰队、按业务域、按集群标签来切片;

- 对于运维同学,可以用"舰队 + 业务"的视角进入监控大盘,而不是"集群 + 命名空间"的纯技术视角。

实践中的一些做法:

-

为每个舰队建立一套"标准大盘模板":

- 资源维度:CPU、内存、磁盘、网络等;

- K8s 维度:Pod/Deployment/Node 健康;

- 业务维度:核心服务的 QPS / RT / 错误率。

-

对告警做"舰队维度路由":

- 例如 fleet-saas-cn 的告警推送到中国区 oncall 群组;

- fleet-ai-edge 的告警推送到负责边缘节点的专门团队。

这让告警的归属关系非常清晰,也更符合企业组织结构。

4.5 统一策略管理:用 Kyverno 守住"基线"

在策略管理方面,Kurator 通常会集成 Kyverno 等策略引擎,以实现:

- 安全基线约束(如必须开启资源限制、必须开启 livenessProbe 等);

- 多租户隔离策略;

- 镜像仓库与签名校验策略;

- 按环境/舰队差异化的策略。

Kurator 的价值在于:

- 可以在舰队维度下发策略,保证同一舰队内部的策略一致性;

- 可以对策略生效范围做精细控制(集群/命名空间/标签等)。

实际落地时,我们把策略分成三个层级:

-

平台强制策略

- 所有舰队必须执行,比如 CPU/内存必须设置 limit、禁止使用特定镜像仓库等。

-

环境级策略

- 开发、测试环境相对宽松;

- 生产环境对特权容器、HostPath 等做严格限制。

-

业务定制策略

- 特定业务对日志采集、审计、挂载等有特殊要求时增加。

这套分层在 Kurator + Kyverno 体系下实现起来相对自然,也便于日后演进与审计。

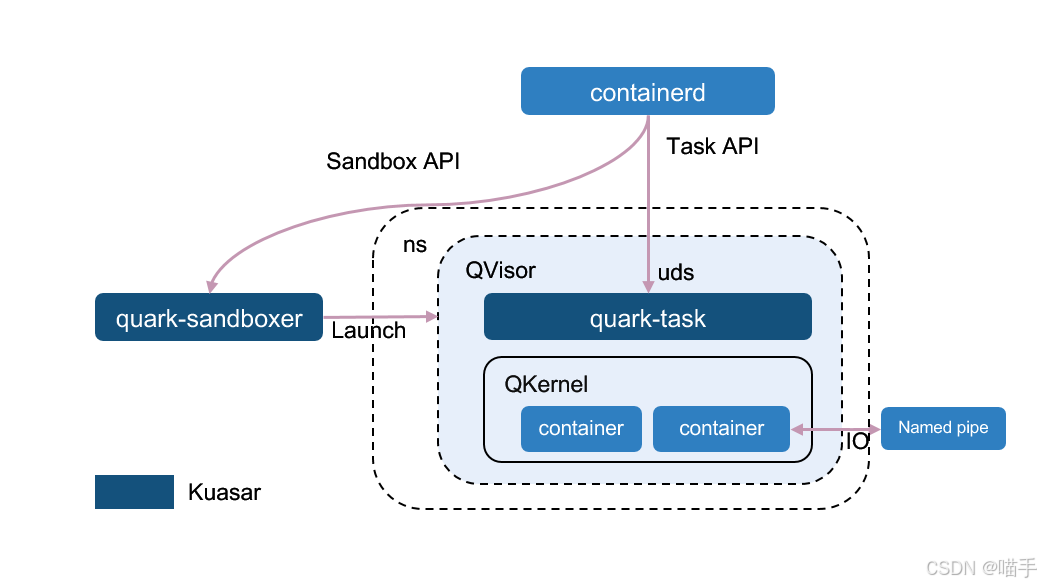

App Kernel Sandboxer:

五、企业级落地案例:两个典型场景的组合实践

为了更具体地展示 Kurator 在企业中的价值,这里以"虚构但真实可行"的方式,构造两个典型场景案例:

- 案例一:多云 SaaS 平台的统一管理实践;

- 案例二:边缘 AI 推理场景中的云边协同实践。

5.1 案例一:多云 SaaS 平台的舰队化管理

5.1.1 背景与痛点

某 SaaS 公司,主营 B2B 协同办公平台,典型特征:

- 客户覆盖多国,要求"就近部署 + 数据就地存储";

- 部分大客户要求在私有云 / 本地数据中心部署;

- 公司希望在统一的 DevOps 与运维体系下管理所有集群。

原有问题:

- 多云、多集群完全依赖自研脚本 + 手工操作;

- 监控、流量治理、策略都不统一;

- 灰度/回滚流程在不同 Region 有不同做法。

5.1.2 Kurator 落地步骤

-

构建 Kurator 控制面与核心舰队划分

-

在一个稳定的公有云 Region 部署 Kurator 控制面;

-

定义三个核心舰队:

- fleet-saas-cn(国内)

- fleet-saas-eu(欧洲)

- fleet-saas-private(私有云/本地部署)

-

-

接管存量集群

- 将原有 Kubernetes 集群通过 Kurator 的 Cluster 注册能力纳入管理;

- 对新集群统一通过 Cluster CR + Cluster Operator 创建。

-

建立统一 GitOps + 多集群分发体系

-

按照"平台组件 / 公共服务 / 业务服务"拆分 Git 仓库结构;

-

使用 Kurator + Karmada 制定多集群分发策略:

- 公共组件(监控、日志、网关)按舰队分发;

- 业务服务根据租户与地域策略分发。

-

-

统一流量治理方案

-

在每个舰队内部构建 Istio 服务网格,并通过 Kurator 做统一纳管;

-

灰度发布时:

- 先在 fleet-saas-cn 的部分集群灰度;

- 稳定后再推广到 fleet-saas-eu;

- 最后由大客户自愿选择是否在 fleet-saas-private 中升级。

-

-

统一监控与告警体系

- 通过多集群 Prometheus + Thanos 做指标聚合;

- 在 Kurator 舰队层面设置大盘模板和告警路由。

5.1.3 收益与反思

落地后,团队反馈最明显的收益有三点:

-

多集群运维工作量显著下降

- 新集群创建、扩缩容、升级等重复操作基本变成了"写 CR + 提 MR";

- 运维更多关注"策略与架构设计",而不是日常巡检。

-

故障处理效率提升

- 监控告警以舰队维度呈现,责任边界清晰;

- 通过统一流量治理和发布策略,使得回滚和限流手段高度标准化。

-

SaaS 产品交付模式更灵活

- 面对新客户,可以按需求很快创建一个专属舰队或集群组;

- "多云 + 多形态部署"成为一件"可重复、可预测"的事情。

从架构演进角度看,Kurator 帮这个团队做的事情,是把"多云多集群"从一种"复杂度负担"转变为一种"可控的体系能力"。

5.2 案例二:边缘 AI 推理的云边协同实践

5.2.1 背景与需求

某工业互联网项目,需要在工厂现场部署大量边缘节点用于:

- 设备数据采集与预处理;

- 边缘侧 AI 模型推理(如异常检测、质量识别等);

- 将部分汇总结果上传云端做进一步分析与训练。

在技术选型中,最终确定采用 KubeEdge + Volcano + Kurator 的组合:

- KubeEdge:管理成百上千个边缘节点,提供云边通信与元数据同步;

- Volcano:对 AI 推理任务做更细粒度的资源调度与队列管理;

- Kurator:统一管理云端控制面、边缘集群与多集群应用分发。

5.2.2 Kurator 在其中扮演的角色

-

统一纳管 KubeEdge 边缘集群

-

将多个工厂现场的 KubeEdge 集群作为 Kurator 的成员集群接入;

-

通过舰队划分不同工厂/区域,例如:

- fleet-edge-north

- fleet-edge-south

-

-

统一下发边缘应用与 AI 模型

- 通过 GitOps + Kurator 多集群分发,将数据采集服务和 AI 推理服务统一下发;

- 对不同工厂可以通过 OverridePolicy 配置不同模型版本或参数。

-

统一监控与策略管理

- 将边缘节点与边缘应用的指标统一汇总至云端;

- 用策略引擎约束边缘侧的权限和资源使用,避免边缘节点被误用为"通用计算资源"。

5.2.3 实际效果

-

边缘节点生命周期更可控:

- 新工厂上线时,只需要在 Kurator 中申明新的边缘集群与节点信息;

- 所有通用能力(监控、日志、基础应用)可以复用已有模板。

-

AI 模型迭代节奏更快:

- 模型作为容器镜像或挂载资源随应用一起多集群分发;

- 可以先在某个舰队进行 A/B 测试,再逐步推广到其他舰队。

-

整体运维视图更加统一:

-

运维同学能够从 Kurator 的视角一眼看到:

- 哪些舰队/工厂当前运行的模型版本是最新的;

- 哪些边缘集群资源利用率异常,需要扩容或优化调度。

-

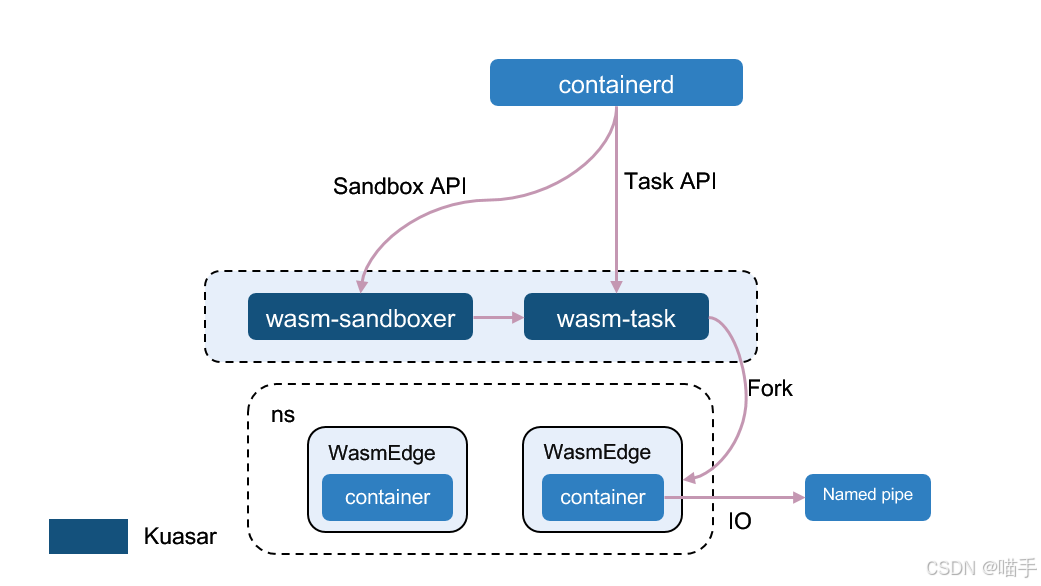

Wasm Sandboxer:

六、Kurator 与开源社区:贡献与协同的双向奔赴

虽然本文主要是"探索实战"视角,但 Kurator 的定位决定了它与上游开源社区的关系非常紧密,包括:

- Karmada、KubeEdge、Volcano 等项目都已获得中国信通院"可信开源社区"先进级认证,在社区运营、治理与开发能力方面得到认可;

- 这些项目本身也有各自的活跃社区和贡献体系。

从一名平台工程师的角度,我认为 使用 Kurator 本身,就是参与这些社区的起点:

-

在使用中发现问题并反馈 Issue

- 无论是 Kurator 自身的问题,还是集成的上游项目中的兼容性问题,及时在对应仓库提 Issue,都是一种非常有价值的贡献;

-

将企业实践抽象为文档 / 示例贡献回社区

- 比如本文中提到的多云 SaaS 场景、边缘 AI 场景,其实都可以通过"官方示例"或"最佳实践文档"的形式贡献出去;

- 对社区来说,一手的落地经验非常珍贵。

-

向上游项目反向贡献

- 在使用 Kurator 的过程中,如果发现 Karmada、KubeEdge、Volcano 等项目在某些场景下存在改进空间,也可以直接向上游提交 PR 或改进建议;

- Kurator 作为"整合层",其发展离不开上游项目的演进。

如果从征文活动的角度来看,这一块就非常适合写成【贡献经历】类文章:

"使用 Kurator 之后,我是如何逐步从用户变成社区贡献者的"。

Runc Sandboxer:

七、Kurator 前瞻创想:分布式云原生的下一步

在深入使用 Kurator 的过程中,我也不时在想:

当"多云、多集群、云边协同"逐渐成为基础设施的标配之后,Kurator 这样的分布式云原生套件,下一阶段的价值会体现在哪些方面?

结合自身经验与对社区项目路线图的理解,我有几个个人的前瞻设想。

7.1 更智能的多集群调度与成本优化

Karmada 已经为多集群调度提供了丰富的能力:多集群 API、调度策略、差异化策略等。

但从企业实践的角度看,未来可以在 Kurator 层面进一步演进:

-

基于业务 SLO 的调度

- 不只是根据资源和拓扑分布,而是结合应用的 SLO(延迟、可用性、成本)做智能调度。

-

跨云成本感知调度

- 不同云厂商、不同 Region 的资源价格差异很大;

- 如果 Kurator 能结合成本信息,配合 Karmada 做"成本感知调度",会极大提升企业在多云场景下的性价比。

-

与批任务调度器的深度融合

- Volcano 在 AI/批任务调度方面已经非常成熟;

- 如果 Kurator 能将"多集群资源调度 + 批任务调度"统一起来,对大规模 AI 训练和推理场景会非常有价值。

7.2 云原生 AI 运维(AIOps)的进一步融合

当前的监控体系更多还是"指标 + 日志 + 告警"的经典三件套,在大规模多集群环境下,单纯靠人去分析和排障成本很高。

Kurator 在这一层可以做的事情包括:

-

舰队级异常模式识别

- 利用机器学习/统计分析,从海量指标中自动识别异常模式;

- 比如识别出某个舰队中多个集群都出现某类异常,自动关联到某次发布或某个全局配置变更。

-

自动化修复建议与操作模板

- 对于常见问题(节点 NotReady、Pod CrashLoopBackOff、磁盘告警等),给出自动化修复建议,甚至通过预定义 Playbook 一键处理;

- 在舰队维度做批量修复。

-

与日志/链路追踪系统深度打通

- 在 Kurator 的统一视图中,把 metrics、logs、traces 做更深层的关联与可视化,而不是简单地把几个 Grafana / Kibana Page 并列摆放。

7.3 更开放的插件与生态体系

作为"一栈式"平台,Kurator 在设计之初就选择了"整合主流开源项目"的路径,这为其构建生态提供了天然优势。未来我期待:

-

更标准化的插件模型

- 类似 Kubernetes 的 CSI / CNI / CRI 标准,Kurator 在舰队管理、策略治理、监控等方面也可以定义更清晰的扩展点;

- 让第三方厂商或内部团队可以更方便地开发"Kurator 插件"。

-

与云厂商原生能力更深度融合

- 每家云厂商都在安全、网络、数据库、消息队列等领域有大量托管服务;

- Kurator 可以在抽象层面为这些服务提供统一的资源模型和治理方式,让"上云 + 多云"更加一致。

-

多语言、多环境的开发者体验优化

-

对于前线业务研发同学来说,他们可能更关心:

- "我怎样在 Kurator 管理的多集群环境中,以最少心智负担发布和调试我的服务?"

-

这就涉及 CLI、Portal、IDE 插件等更多"开发者体验"层面的优化。

-

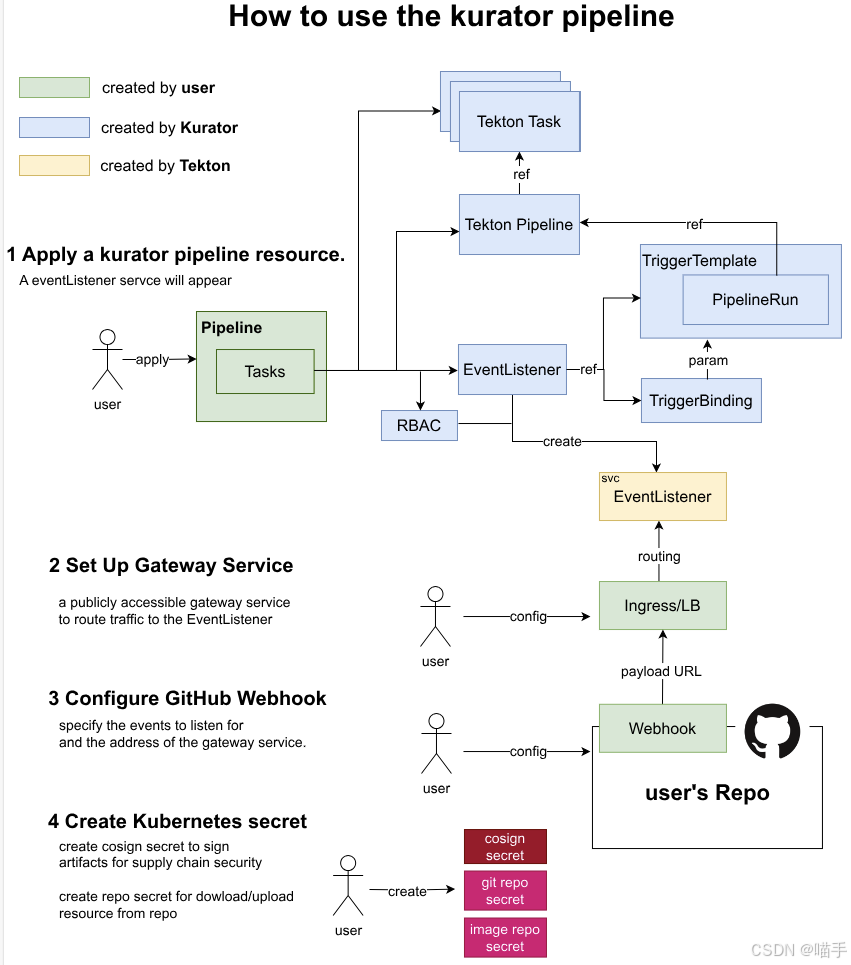

相关流程图示意如下:

八、给 Kurator 的几点"用户建议"

结合这段时间的实践,我也想从一个普通用户的视角,对 Kurator 提出几条不成熟的建议:

-

文档和示例场景可以更贴近"典型企业架构"

- 当前文档已经比较完善,但如果能有更多针对"多云 SaaS"、"边缘 AI"、"混合云政企"等典型架构的完整样例,会更容易推广到更多企业场景。

-

可视化运维控制台可以更上一层

- 虽然命令行和 CR 已经足够强大,但对于复杂多集群环境,让运维同学有一个清晰直观的可视化界面,会非常加分;

- 尤其是在舰队视角下查看拓扑、健康状态和版本分布。

-

与上游社区的路线图联动可再加强"透明度"

- 由于 Kurator 集成了众多上游项目,普通用户有时会困惑:"我用的某个功能到底来自哪个项目?"

- 如果在文档或 Roadmap 中能更清晰地表达"哪些能力来自上游,哪些能力由 Kurator 增强,并分别的演进计划是怎样的",对于企业做中长期技术规划很有帮助。

Kurator Fleet Manager:云原生舰队管理

九、总结:从"会用 Kubernetes"到"驾驭分布式云原生舰队"

回到文章一开始的问题:

为什么需要 Kurator 这样的分布式云原生套件?

在完成从 0 到 1 的部署实践、功能实战和企业级场景落地之后,我的答案是:

- Kubernetes 解决的是"单集群的自动化问题";

- Kurator 试图解决的是"多集群、多云、云边协同的系统性问题"。

通过整合 Karmada、KubeEdge、Volcano、Istio、Prometheus 等一系列成熟开源项目,并在其之上提供统一的舰队视图与治理能力,Kurator 帮我们从"集群运维者"逐步走向"分布式云原生舰队的指挥者"。

当然,Kurator 仍然在快速演进中,许多能力还在不断打磨。但就像所有成功的云原生项目一样,它已经展现出了几个非常关键的特质:

- 技术路线站在社区主流之上,而不是重新造轮子;

- 关注的是企业真实痛点,而不仅仅是"技术炫技";

- 通过开放的社区协作模式,让"用户--贡献者--维护者"实现循环。

作为一名云原生平台工程师,我相信:

在未来的分布式云原生世界里,像 Kurator 这样的"一栈式舰队中枢",会越来越成为企业基础设施的"必选项"之一。

... ...

文末

好啦,以上就是我这期的全部内容,如果有任何疑问,欢迎下方留言哦,咱们下期见。

... ...

学习不分先后,知识不分多少;事无巨细,当以虚心求教;三人行,必有我师焉!!!

wished for you successed !!!

⭐️若喜欢我,就请关注我叭。

⭐️若对您有用,就请点赞叭。

⭐️若有疑问,就请评论留言告诉我叭。

版权声明:本文由作者原创,转载请注明出处,谢谢支持!