您好!我是ID: 熊猫钓鱼。

技术生涯如长河垂钓,我深信卓越的开发之道,在于既要有纵览技术生态的「水域」格局,也要有洞察问题本质的「鱼汛」直觉。从架构设计到性能调优,从技术选型到团队协作------我始终专注于在恰当的时机,以最契合的技术,从容钓起那些简洁而有力的解决方案。

愿与你在代码的深水区相遇,共钓一片从容与洞见。

摘要

在当今数据驱动的时代,实时数据处理已成为企业竞争的核心能力。本文从数据工程的角度,深度剖析了现代大数据处理架构中的关键组件,特别是Kafka、Flink和Spark Streaming等技术在构建7x24小时稳定运行的数据管道中的应用。作者结合多年实战经验,探讨了数据处理的核心挑战、解决方案以及架构演进路径,为数据工程师和架构师提供了宝贵的技术参考。

目录

- 一、引言:数据的价值与挑战

- 二、Kafka:实时数据流的基础设施

- [2.1 Kafka内部原理与架构设计](#2.1 Kafka内部原理与架构设计)

- [2.2 Kafka生产环境最佳实践](#2.2 Kafka生产环境最佳实践)

- 三、实时流处理平台对比

- [3.1 Apache Flink:状态管理的艺术](#3.1 Apache Flink:状态管理的艺术)

- [3.2 Spark Streaming:批处理思维的流处理实现](#3.2 Spark Streaming:批处理思维的流处理实现)

- [3.3 技术选型的关键考量](#3.3 技术选型的关键考量)

- 四、构建7x24小时稳定的数据管道

- 五、数据处理的核心挑战与解决方案

- 六、数据管道搭建与维护的专业见解

- [6.1 数据工程师的核心素养](#6.1 数据工程师的核心素养)

- [6.2 数据管道的生命周期管理](#6.2 数据管道的生命周期管理)

- [6.3 性能优化的方法论](#6.3 性能优化的方法论)

- [6.4 数据治理与合规性](#6.4 数据治理与合规性)

- 七、结语:数据工程的未来展望

引言:数据的价值与挑战

在当今数字化时代,数据已成为企业最宝贵的资产之一。正如一位业内专家所言:"百分之九十都埋藏在数据和特征里,而不是那个模型结构本身"。这句话深刻揭示了数据处理在人工智能时代的核心地位。

我们的应用程序每时每刻都在产生海量的用户行为数据:点击、浏览、加购、评论、分享...这些数据以日志的形式,如同洪水般涌来。如何高效地捕捉、清洗、聚合和分析这些数据,成为了构建智能系统的关键挑战。

"数据处理管道的质量决定了AI模型的上限。一个优秀的数据工程师远比十个机器学习工程师更有价值。" --- 某顶级科技公司CTO

Kafka:实时数据流的基础设施

Kafka内部原理与架构设计

Apache Kafka作为分布式流处理平台的核心组件,其设计理念体现了现代分布式系统的精髓。Kafka采用发布-订阅模式,通过主题(Topic)、分区(Partition)和副本(Replica)的多层次架构,实现了高吞吐、高可用的数据传输。

Kafka的核心优势在于其分布式架构。每个主题可以分为多个分区,每个分区可以有多个副本,这种设计使得Kafka能够水平扩展以处理海量数据流。同时,Kafka采用顺序写盘的方式,充分利用了现代操作系统的页缓存机制,极大地提高了写入性能。

// Kafka生产者配置示例

Properties props = new Properties();

props.put("bootstrap.servers", "kafka1:9092,kafka2:9092,kafka3:9092");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("acks", "all"); // 最高可靠性配置

props.put("retries", 3); // 失败重试次数

props.put("batch.size", 16384); // 批处理大小

props.put("linger.ms", 10); // 延迟发送时间

props.put("buffer.memory", 33554432); // 缓冲区大小Kafka生产环境最佳实践

在生产环境中部署Kafka集群需要考虑诸多因素。首先是集群规模的规划:根据业务流量估算分区数量、副本因子和集群节点数。一般来说,每个broker承载的分区数不宜超过2000,每个主题的分区数需要根据消费者组的规模和处理能力来确定。

其次是存储配置。Kafka对磁盘I/O要求较高,建议使用SSD存储以获得更好的性能。同时,需要合理设置日志保留策略,避免磁盘空间溢出。在网络配置方面,建议为Kafka集群配置专用的网络接口,以确保数据传输的稳定性。

监控和运维是保证Kafka集群稳定运行的关键。我们需要密切关注broker的CPU、内存、磁盘使用率,以及请求延迟、网络吞吐量等指标。常见的监控工具包括Prometheus+Grafana、Kafka Manager等。

实时流处理平台对比

Apache Flink:状态管理的艺术

Apache Flink是一个开源的分布式流处理框架,其最大的特点是原生支持流处理,同时兼顾批处理。Flink的核心概念是数据流(DataStream)和状态(State),它提供了丰富的状态管理机制,支持Exactly-Once语义保证。

Flink的状态管理是其最强大的特性之一。它支持多种状态后端,包括内存、文件系统和RocksDB等。对于大规模状态应用,RocksDB状态后端是首选,它通过内存映射文件的方式,在保证性能的同时支持更大的状态规模。

// Flink流处理示例代码

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 启用检查点以支持状态恢复

env.enableCheckpointing(5000);

// 设置状态后端为RocksDB

env.setStateBackend(new RocksDBStateBackend("hdfs://namenode:9000/flink/checkpoints"));

// 从Kafka读取数据

DataStream stream = env.addSource(new FlinkKafkaConsumer<>(

"user-behaviors",

new SimpleStringSchema(),

kafkaProperties

));

// 处理数据并维护状态

stream

.map(new JsonDeserializer())

.keyBy(behavior -> behavior.getUserId())

.window(TumblingProcessingTimeWindows.of(Time.minutes(5)))

.aggregate(new UserBehaviorAggregator());Flink的另一个优势是其丰富的时间语义支持,包括处理时间(Processing Time)、事件时间(Event Time)和摄取时间(Ingestion Time)。事件时间语义对于处理乱序数据尤为重要,它能够保证结果的正确性,即使数据到达的顺序与产生的顺序不一致。

Spark Streaming:批处理思维的流处理实现

Spark Streaming是Apache Spark生态系统中的流处理组件,它采用微批处理(Micro-batch)的方式来处理流数据。本质上,Spark Streaming将连续的数据流切分为一系列小的批处理作业,从而实现近实时的数据处理。

Spark Streaming的最大优势在于它与Spark批处理和机器学习库的无缝集成。对于已经采用Spark生态系统的企业来说,可以复用现有的技术栈和人才,降低学习和维护成本。Spark Streaming支持多种数据源,包括Kafka、Flume、HDFS等,并且提供了丰富的转换操作。

// Spark Streaming示例代码

val sparkConf = new SparkConf().setAppName("UserBehaviorAnalysis")

val ssc = new StreamingContext(sparkConf, Seconds(10)) // 10秒微批处理

// 从Kafka读取数据

val kafkaParams = Map[String, Object](

"bootstrap.servers" -> "kafka1:9092,kafka2:9092",

"key.deserializer" -> classOf[StringDeserializer],

"value.deserializer" -> classOf[StringDeserializer],

"group.id" -> "spark-streaming-group",

"auto.offset.reset" -> "latest",

"enable.auto.commit" -> (false: java.lang.Boolean)

)

val topics = Array("user-behaviors")

val stream = KafkaUtils.createDirectStream[String, String](

ssc,

PreferConsistent,

Subscribe[String, String](topics, kafkaParams)

)

// 处理数据

stream.map(record => (record.key, record.value))

.foreachRDD { rdd =>

// 使用Spark SQL进行处理

val spark = SparkSession.builder.config(rdd.sparkContext.getConf).getOrCreate()

import spark.implicits._

val behaviorDF = rdd.map(_._2).toDF("json")

// 进一步处理...

}

ssc.start()

ssc.awaitTermination()然而,Spark Streaming的微批处理模型也带来了一些局限性。由于它本质上是批处理,因此在低延迟场景下的表现不如Flink等原生流处理框架。典型的端到端延迟在秒级,而Flink可以达到毫秒级。此外,在处理乱序数据和维护精确一次语义方面,Spark Streaming的实现也相对复杂。

技术选型的关键考量

在选择实时流处理技术时,需要综合考虑多个因素。首先是业务需求的延迟要求:如果延迟要求在毫秒级,Flink可能是更好的选择;如果可以接受秒级延迟,Spark Streaming也是一个不错的选择。其次是状态规模和复杂度:对于需要维护大规模状态的应用,Flink的RocksDB状态后端提供了更好的支持。

生态系统的成熟度和社区活跃度也是重要考量。Spark生态系统更加成熟,拥有更多的工具和库;而Flink作为后起之秀,其社区发展迅速,特别是在流处理领域的功能不断完善。此外,团队的技术栈和经验也会影响技术选型的决策。

"没有最好的技术,只有最适合特定场景的技术。技术选型应当基于业务需求、团队能力和长期发展规划的综合考量。" --- 数据工程领域资深架构师

构建7x24小时稳定的数据管道

构建一个能够7x24小时稳定运行的数据处理管道,是每一个数据工程师的终极目标。这不仅需要选择合适的技术栈,还需要考虑系统设计、监控告警、容错恢复等多个方面。

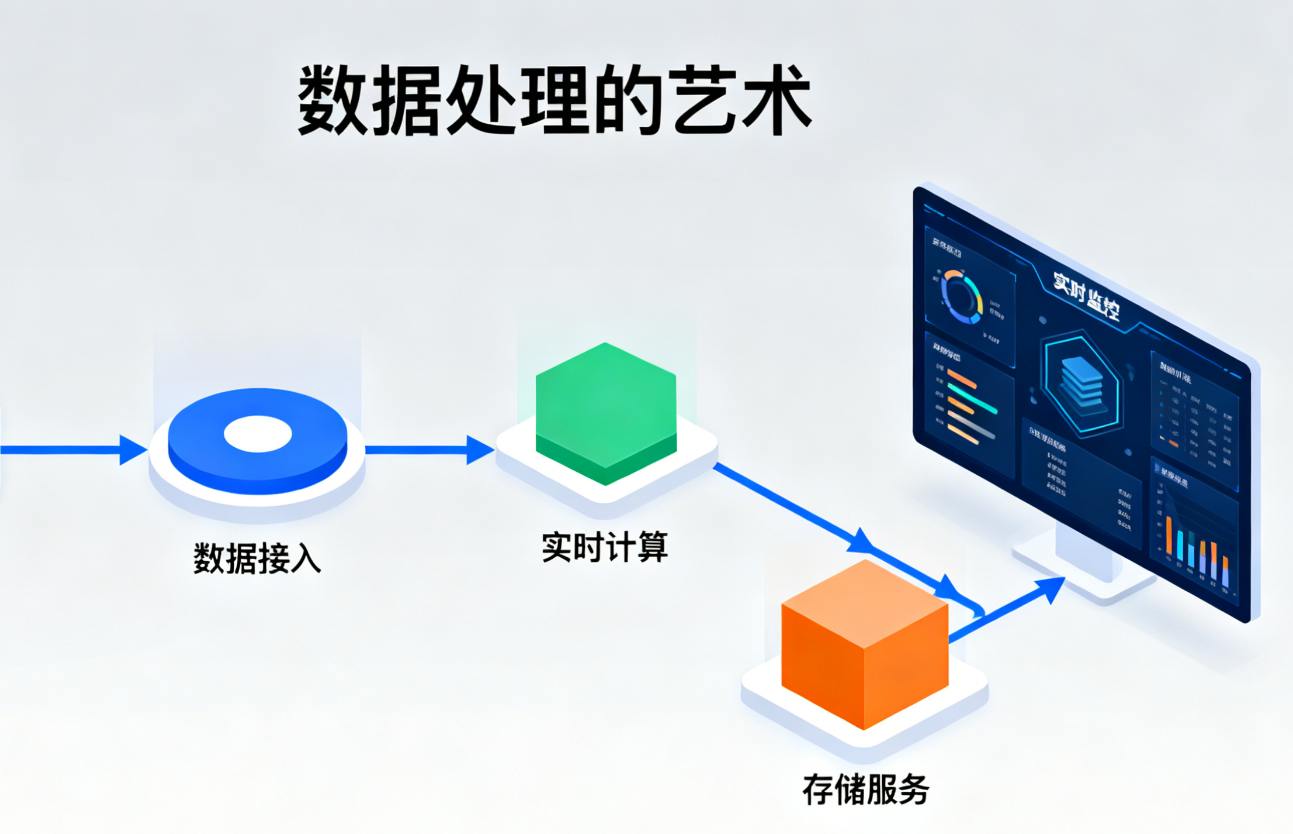

首先,数据管道的设计应当采用分层架构。通常可以分为数据采集层、数据传输层、数据处理层、数据存储层和数据服务层。每一层都有明确的职责边界,通过标准化的接口进行交互。这种模块化的设计使得系统更容易维护和扩展。

其次,容错机制是保证系统稳定性的关键。在数据处理的各个环节,都需要考虑失败的情况。例如,Kafka的副本机制、Flink的检查点机制、数据存储的冗余备份等。此外,还需要设计完善的重试策略和降级方案,以应对各种异常情况。

监控和告警系统是运维的眼睛。我们需要监控数据管道的各个指标,包括数据流量、处理延迟、错误率、资源使用率等。当指标超出阈值时,及时触发告警,以便运维人员快速响应。常见的监控工具包括Prometheus、Grafana、ELK等。

数据处理的核心挑战与解决方案

在实际的数据处理实践中,我们面临着诸多挑战。第一个挑战是数据质量问题。原始数据往往存在缺失、错误、重复等问题,需要通过数据清洗、数据验证等手段来保证数据质量。第二个挑战是系统扩展性。随着业务的发展,数据量可能呈指数级增长,系统需要能够水平扩展以应对挑战。

第三个挑战是成本控制。大规模数据处理需要大量的计算资源,如何在保证性能的同时降低成本,是一个需要持续优化的问题。可以考虑的方案包括资源弹性伸缩、数据生命周期管理、计算结果缓存等。第四个挑战是安全合规。数据处理过程中需要保护敏感信息,遵守相关法律法规,如GDPR、CCPA等。

针对这些挑战,我们需要采取系统性的解决方案。首先,建立数据治理体系,包括数据标准、数据质量监控、数据血缘管理等。其次,采用云原生技术,如容器化、微服务等,提高系统的弹性和可扩展性。此外,还需要持续优化数据处理算法和架构,提高处理效率,降低资源消耗。

数据管道搭建与维护的专业见解

作为一名在大数据领域深耕多年的专家,我想分享一些关于数据管道搭建和维护的专业见解。这些经验来自于实际项目中的成功案例和失败教训,希望能够对正在构建数据基础设施的团队有所启发。

数据工程师的核心素养

一个优秀的数据工程师需要具备多方面的能力。首先是技术能力,包括分布式系统原理、编程语言、数据库、云计算等。其次是系统设计能力,能够设计出可扩展、高可用、高性能的数据处理系统。此外,还需要具备问题排查能力和持续学习能力,以应对不断变化的技术挑战。

"研究生不会帮你从零搭建和维护一套7x24小时稳定运行的数据管道,因为这需要的不仅仅是理论知识,更需要丰富的实战经验和系统思维。" --- 一位资深数据工程负责人

数据管道的生命周期管理

数据管道的管理是一个持续的过程,包括规划、设计、开发、测试、部署、监控、维护和优化等多个阶段。在每个阶段,都需要有明确的目标和质量标准。例如,在规划阶段,需要明确业务需求和技术约束;在设计阶段,需要考虑系统架构和技术选型;在开发阶段,需要遵循编码规范和最佳实践。

文档是数据管道管理的重要组成部分。完整的文档包括架构设计文档、API文档、运维手册、故障处理流程等。这些文档不仅有助于团队成员理解系统,也为后续的维护和升级提供了参考。

性能优化的方法论

性能优化是数据工程师的日常工作之一。在进行性能优化时,需要遵循一定的方法论。首先,需要通过监控工具收集性能指标,识别性能瓶颈。然后,针对瓶颈进行分析,找出根本原因。最后,提出优化方案并进行验证。

常见的性能优化手段包括:资源优化(增加计算资源、优化资源分配)、算法优化(选择更高效的算法、优化数据结构)、并行化处理、数据压缩、缓存机制等。需要注意的是,优化往往需要权衡,例如,增加并行度可能会提高吞吐量,但也会增加资源消耗和系统复杂度。

数据治理与合规性

随着数据隐私法规的日益严格,数据治理和合规性变得越来越重要。数据治理包括数据质量、数据安全、数据生命周期管理等多个方面。在数据处理的各个环节,都需要考虑数据安全和隐私保护。

常见的数据安全措施包括:数据加密(传输加密和存储加密)、访问控制、审计日志、数据脱敏等。此外,还需要建立数据分类分级制度,对不同敏感级别的数据采取相应的保护措施。

结语:数据工程的未来展望

随着人工智能和大数据技术的不断发展,数据处理领域也在持续演进。未来,我们将看到更多的技术创新,如实时数据仓库、流批一体、智能数据处理等。同时,数据工程的角色也在发生变化,从单纯的数据处理者转变为数据价值的挖掘者和推动者。

作为数据工程师,我们需要不断学习和适应新技术,同时保持对业务的深入理解。只有将技术与业务紧密结合,才能真正发挥数据的价值。

希望每位志同道合的朋友与我共同分享横跨编程开发、分布式架构、云原生、人工智能应用及大数据处理等领域的技术视野,在这里我们分享的不仅是代码实现,更是十余年沉淀的工程思维与实践哲学------每一个方案都经过真实项目的淬炼,每一个观点都源自深度思考的沉淀。

若你认同这种务实的技术价值观:

👁️ 【关注】与我共同潜入技术深海,探寻更多隐藏的宝藏

👍 【点赞】为实用经验喝彩,鼓励更多干货浮出水面

🔖 【收藏】将收获收入行囊,随时温习垂钓的秘诀

💬 【评论】抛出你的疑问与见解,让交流激荡出新的涟漪

🗳️ 【投票】用你的选择助力技术社区聚焦优质方向

技术之路,贵在沉心静气。让我们在代码的深水中,钓起属于自己的那份从容与洞见。🛠️ 更多实战笔记、私密技术思考,欢迎进入我的主页探索!

扩展阅读:

最方便的应用构建------利用云原生快速搭建本地deepseek知识仓库

https://blog.csdn.net/ailuloo/article/details/148876116?spm=1001.2014.3001.5502

解决Web游戏Canvas内容在服务器部署时的显示问题

https://blog.csdn.net/ailuloo/article/details/154918298?spm=1001.2014.3001.5502