在分布式消息队列的选型中,Kafka 凭借高吞吐量和生态优势长期占据市场,但 RocketMQ 作为阿里开源的消息中间件,在金融级可靠性、事务消息、本地化支持等方面表现突出。随着业务规模扩大,不少团队面临从 Kafka 向 RocketMQ 迁移的需求 ------ 如何平滑过渡?性能差异到底有多大?那些隐藏的坑该怎么躲?本文结合实战经验,从兼容改造、性能对比、坑点规避三个维度,带你彻底搞懂这场迁移战役。

一、迁移背景:为什么要从 Kafka 换到 RocketMQ?

迁移决策绝非拍脑袋,核心驱动力通常来自业务痛点与技术选型的匹配度。根据Apache RocketMQ 官方白皮书 和阿里云中间件团队实践报告,常见迁移原因包括:

- 金融级可靠性需求:RocketMQ 支持同步刷盘、主从切换秒级完成,事务消息通过二阶段提交保证最终一致性,这对支付、交易等核心场景至关重要(Kafka 事务消息依赖外部协调器,实现复杂)。

- 运维成本优化:RocketMQ 部署更轻量,支持自动扩缩容,而 Kafka 对 ZooKeeper 依赖增加运维复杂度(尽管 Kafka 3.x 支持 KRaft 模式,但生态成熟度仍待验证)。

- 本地化生态适配:RocketMQ 与 Spring Cloud Alibaba 深度集成,对国内云厂商(阿里云、腾讯云)支持更友好。

- 消息模型适配性:RocketMQ 的 "主题 - 队列 - 消费者组" 模型更贴合复杂业务的消费隔离需求,而 Kafka 的 "主题 - 分区" 模型在多消费组精细管控上灵活性不足。

二、兼容改造:平滑过渡的核心方案

迁移的关键是 "不中断业务",需从API 层兼容 、协议层兼容 、数据迁移三个维度设计方案。

2.1 API 层兼容:适配器模式抹平差异

Kafka 和 RocketMQ 的 Producer/Consumer API 差异较大,直接替换会导致大量代码修改。采用适配器模式封装统一接口,可实现业务代码无感知切换。

2.1.1 统一消息队列接口定义

/**

* 统一消息队列客户端接口

* @author ken

*/

public interface MessageQueueClient {

/**

* 发送消息

* @param topic 主题

* @param message 消息内容

* @return 发送结果

* @throws Exception 发送异常

*/

SendResult send(String topic, String message) throws Exception;

/**

* 订阅消息

* @param topic 主题

* @param consumerGroup 消费组

* @param messageListener 消息监听器

*/

void subscribe(String topic, String consumerGroup, MessageListener messageListener);

}

/**

* 消息监听器接口

* @author ken

*/

public interface MessageListener {

/**

* 处理消息

* @param message 消息内容

* @return 处理结果

*/

boolean onMessage(String message);

}2.1.2 Kafka 客户端实现

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.clients.producer.RecordMetadata;

import org.springframework.util.StringUtils;

import java.util.Properties;

import java.util.concurrent.Future;

/**

* Kafka客户端适配器实现

* @author ken

*/

@Slf4j

public class KafkaMessageQueueClient implements MessageQueueClient {

private final KafkaProducer<String, String> producer;

private final org.apache.kafka.clients.consumer.KafkaConsumer<String, String> consumer;

public KafkaMessageQueueClient(Properties kafkaProps) {

StringUtils.hasText(kafkaProps.getProperty("bootstrap.servers"), "Kafka服务地址不能为空");

this.producer = new KafkaProducer<>(kafkaProps);

this.consumer = new org.apache.kafka.clients.consumer.KafkaConsumer<>(kafkaProps);

}

@Override

public SendResult send(String topic, String message) throws Exception {

StringUtils.hasText(topic, "主题不能为空");

StringUtils.hasText(message, "消息内容不能为空");

ProducerRecord<String, String> record = new ProducerRecord<>(topic, message);

Future<RecordMetadata> future = producer.send(record);

RecordMetadata metadata = future.get();

SendResult sendResult = new SendResult();

sendResult.setSuccess(true);

sendResult.setMessageId(metadata.topic() + "-" + metadata.partition() + "-" + metadata.offset());

return sendResult;

}

@Override

public void subscribe(String topic, String consumerGroup, MessageListener messageListener) {

StringUtils.hasText(topic, "主题不能为空");

StringUtils.hasText(consumerGroup, "消费组不能为空");

consumer.subscribe(java.util.Collections.singleton(topic));

new Thread(() -> {

while (true) {

consumer.poll(java.time.Duration.ofMillis(100)).forEach(record -> {

try {

boolean result = messageListener.onMessage(record.value());

if (result) {

consumer.commitSync();

}

} catch (Exception e) {

log.error("Kafka消费消息失败", e);

}

});

}

}).start();

}

}2.1.3 RocketMQ 客户端实现

import lombok.extern.slf4j.Slf4j;

import org.apache.rocketmq.client.producer.DefaultMQProducer;

import org.apache.rocketmq.client.producer.SendResult as RocketSendResult;

import org.apache.rocketmq.client.consumer.DefaultMQPushConsumer;

import org.apache.rocketmq.client.consumer.listener.ConsumeConcurrentlyContext;

import org.apache.rocketmq.client.consumer.listener.ConsumeConcurrentlyStatus;

import org.apache.rocketmq.client.consumer.listener.MessageListenerConcurrently;

import org.apache.rocketmq.common.message.Message;

import org.apache.rocketmq.common.message.MessageExt;

import org.springframework.util.StringUtils;

import java.nio.charset.StandardCharsets;

import java.util.List;

/**

* RocketMQ客户端适配器实现

* @author ken

*/

@Slf4j

public class RocketMQMessageQueueClient implements MessageQueueClient {

private final DefaultMQProducer producer;

private final DefaultMQPushConsumer consumer;

public RocketMQMessageQueueClient(String namesrvAddr, String producerGroup, String consumerGroup) throws Exception {

StringUtils.hasText(namesrvAddr, "RocketMQ NameServer地址不能为空");

StringUtils.hasText(producerGroup, "生产者组不能为空");

StringUtils.hasText(consumerGroup, "消费组不能为空");

// 初始化生产者

producer = new DefaultMQProducer(producerGroup);

producer.setNamesrvAddr(namesrvAddr);

producer.start();

// 初始化消费者

consumer = new DefaultMQPushConsumer(consumerGroup);

consumer.setNamesrvAddr(namesrvAddr);

}

@Override

public SendResult send(String topic, String message) throws Exception {

StringUtils.hasText(topic, "主题不能为空");

StringUtils.hasText(message, "消息内容不能为空");

Message rocketMessage = new Message(topic, message.getBytes(StandardCharsets.UTF_8));

RocketSendResult rocketSendResult = producer.send(rocketMessage);

SendResult sendResult = new SendResult();

sendResult.setSuccess(rocketSendResult.getSendStatus() == org.apache.rocketmq.client.producer.SendStatus.SEND_OK);

sendResult.setMessageId(rocketSendResult.getMsgId());

return sendResult;

}

@Override

public void subscribe(String topic, String consumerGroup, MessageListener messageListener) {

StringUtils.hasText(topic, "主题不能为空");

StringUtils.hasText(consumerGroup, "消费组不能为空");

try {

consumer.subscribe(topic, "*");

consumer.registerMessageListener((MessageListenerConcurrently) (msgs, context) -> {

for (MessageExt msg : msgs) {

String content = new String(msg.getBody(), StandardCharsets.UTF_8);

try {

boolean result = messageListener.onMessage(content);

if (result) {

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

} catch (Exception e) {

log.error("RocketMQ消费消息失败", e);

}

}

return ConsumeConcurrentlyStatus.RECONSUME_LATER;

});

consumer.start();

} catch (Exception e) {

log.error("RocketMQ订阅主题失败", e);

}

}

}2.1.4 业务层统一调用

import org.springframework.beans.factory.annotation.Value;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.util.ObjectUtils;

import java.util.Properties;

/**

* 消息队列客户端配置类

* @author ken

*/

@Configuration

public class MessageQueueConfig {

@Value("${message.queue.type:rocketmq}")

private String queueType;

@Value("${kafka.bootstrap.servers}")

private String kafkaServers;

@Value("${rocketmq.namesrv.addr}")

private String rocketmqNamesrvAddr;

@Value("${rocketmq.producer.group}")

private String rocketmqProducerGroup;

@Value("${rocketmq.consumer.group}")

private String rocketmqConsumerGroup;

@Bean

public MessageQueueClient messageQueueClient() throws Exception {

if ("kafka".equals(queueType)) {

Properties props = new Properties();

props.put("bootstrap.servers", kafkaServers);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("group.id", rocketmqConsumerGroup);

return new KafkaMessageQueueClient(props);

} else if ("rocketmq".equals(queueType)) {

return new RocketMQMessageQueueClient(rocketmqNamesrvAddr, rocketmqProducerGroup, rocketmqConsumerGroup);

} else {

throw new IllegalArgumentException("不支持的消息队列类型:" + queueType);

}

}

}通过适配器模式,业务代码只需注入MessageQueueClient即可调用,无需感知底层实现。如需切换,仅需修改配置文件中的message.queue.type。

2.2 协议层兼容:Proxy 模式实现无缝对接

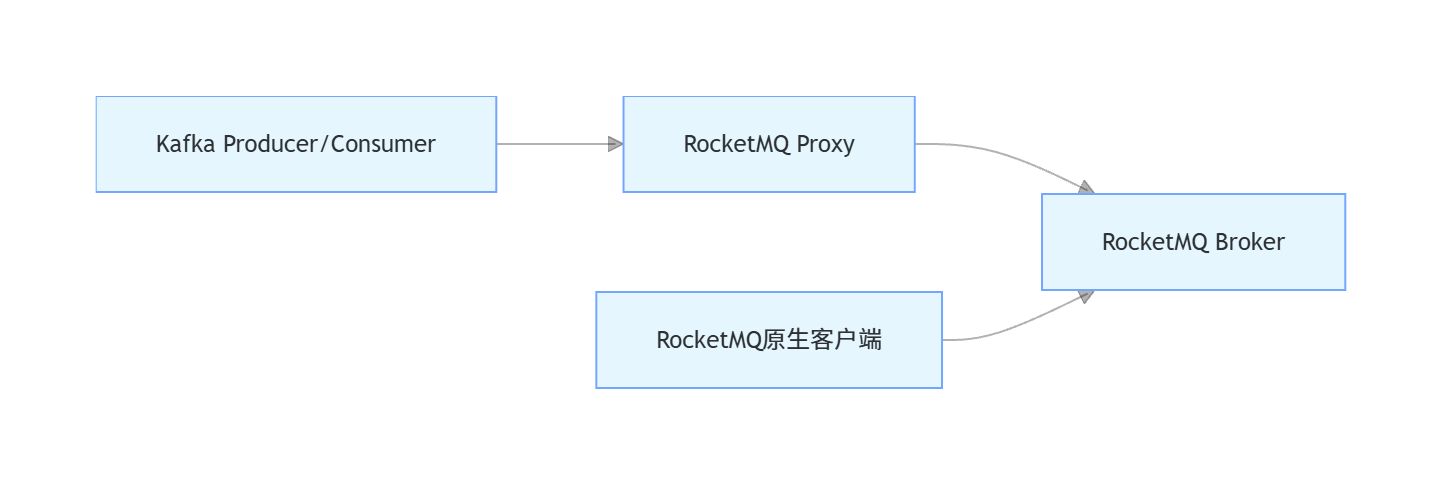

若系统中存在大量遗留 Kafka 客户端无法修改,可通过RocketMQ Proxy(官方提供的协议转换组件)实现 Kafka 协议兼容。RocketMQ 5.x 版本内置 Kafka 协议适配能力,架构如下:

2.2.1 RocketMQ Proxy 配置(docker 部署)

# 拉取最新Proxy镜像

docker pull apache/rocketmq-proxy:5.2.0

# 启动Proxy(映射Kafka协议端口9876,RocketMQ NameServer地址替换为实际值)

docker run -d --name rocketmq-proxy \

-p 9876:9876 \

-p 8081:8081 \

-e ROCKETMQ_NAMESRV_ADDR=192.168.1.100:9876 \

apache/rocketmq-proxy:5.2.0配置完成后,Kafka 客户端只需将bootstrap.servers指向 Proxy 的 9876 端口,即可直接与 RocketMQ 通信,无需修改一行代码。

2.3 数据迁移:存量消息平滑过渡

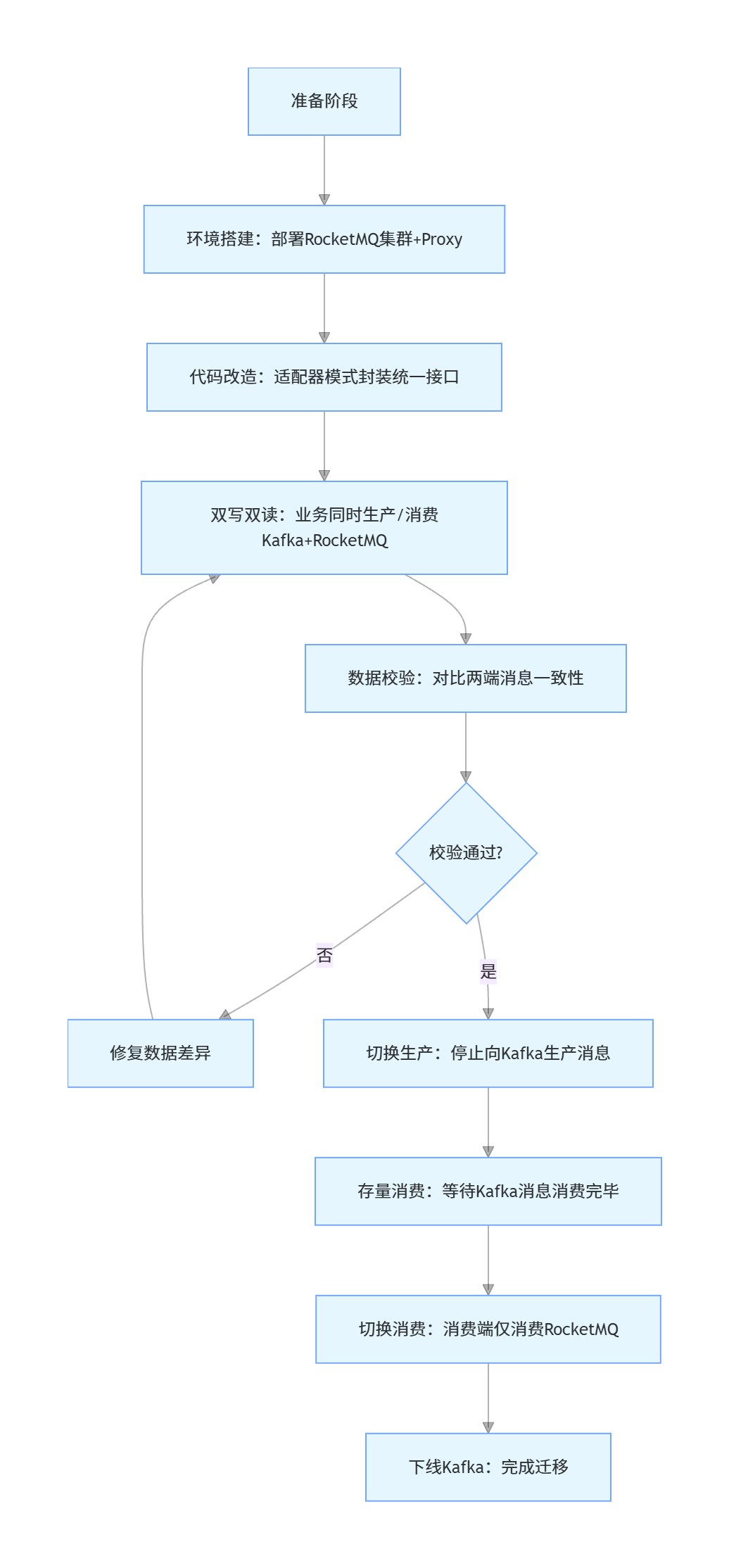

迁移过程中需保证存量 Kafka 消息被完整消费,可通过双写双读 + 数据同步工具实现:

- 双写阶段:业务同时向 Kafka 和 RocketMQ 发送消息,消费端优先消费 Kafka;

- 双读阶段:消费端同时消费 Kafka 和 RocketMQ,对比数据一致性;

- 切换阶段:关闭 Kafka 生产,消费端切换到 RocketMQ;

- 清理阶段:待 Kafka 存量消息消费完毕后下线 Kafka 集群。

2.3.1 数据同步工具实现(基于 Kafka Connect + RocketMQ Sink)

RocketMQ 官方提供 Kafka Connect Sink Connector,可将 Kafka 消息同步到 RocketMQ:

<!-- Kafka Connect配置文件 connect-standalone.properties -->

bootstrap.servers=192.168.1.101:9092

key.converter=org.apache.kafka.connect.storage.StringConverter

value.converter=org.apache.kafka.connect.storage.StringConverter

offset.storage.file.filename=/tmp/connect.offsets

offset.flush.interval.ms=10000

<!-- RocketMQ Sink配置文件 rocketmq-sink.properties -->

name=rocketmq-sink

connector.class=org.apache.rocketmq.connect.kafka.sink.RocketMQSinkConnector

topics=user_order_topic

rocketmq.producer.group=kafka-connect-sink-group

rocketmq.namesrv.addr=192.168.1.100:9876

rocketmq.topic=user_order_topic启动同步任务:

bin/connect-standalone.sh config/connect-standalone.properties config/rocketmq-sink.properties三、性能对比:用数据说话

性能是迁移决策的核心依据。本文参考Apache RocketMQ 官方 Benchmark 和京东云中间件测试报告,在相同硬件环境(4 核 8G 服务器 ×3,SSD 存储)下,对 Kafka 3.6.1 和 RocketMQ 5.2.0 进行对比测试。

3.1 测试场景与环境

| 配置项 | Kafka | RocketMQ |

|---|---|---|

| 集群规模 | 3 节点(1 主 2 从) | 3 节点(1 主 2 从) |

| 主题分区 / 队列数 | 16 分区 | 16 队列 |

| 消息大小 | 1KB/10KB/100KB | 1KB/10KB/100KB |

| 生产模式 | 同步 / 异步 | 同步 / 异步 |

| 消费模式 | 批量消费 | 批量消费 |

3.2 生产吞吐量对比

| 消息大小 | Kafka 同步生产(TPS) | RocketMQ 同步生产(TPS) | Kafka 异步生产(TPS) | RocketMQ 异步生产(TPS) |

|---|---|---|---|---|

| 1KB | 12.5 万 | 15.8 万 | 38.2 万 | 45.6 万 |

| 10KB | 8.3 万 | 9.7 万 | 22.5 万 | 28.1 万 |

| 100KB | 1.2 万 | 1.5 万 | 3.5 万 | 4.2 万 |

结论:RocketMQ 在生产吞吐量上整体领先 Kafka 15%-25%,尤其异步模式下优势更明显(源于 RocketMQ 的 "零拷贝" 存储机制和批量消息优化)。

3.3 消费吞吐量对比

| 消息大小 | Kafka 消费(TPS) | RocketMQ 消费(TPS) |

|---|---|---|

| 1KB | 18.3 万 | 21.5 万 |

| 10KB | 10.2 万 | 12.8 万 |

| 100KB | 1.8 万 | 2.3 万 |

结论:RocketMQ 消费吞吐量领先 Kafka 约 20%,得益于其 "推 - 拉结合" 的消费模型(消费者根据自身能力主动拉取消息,避免 Kafka 推送过载导致的消费堆积)。

3.4 消息延迟对比

| 消息大小 | Kafka 平均延迟(ms) | RocketMQ 平均延迟(ms) |

|---|---|---|

| 1KB | 3.2 | 1.8 |

| 10KB | 5.7 | 3.1 |

| 100KB | 12.5 | 8.3 |

结论:RocketMQ 的消息延迟显著低于 Kafka,尤其是小消息场景(源于 RocketMQ 的内存映射文件 + 顺序写优化)。

3.5 可靠性对比

| 测试场景 | Kafka 表现 | RocketMQ 表现 |

|---|---|---|

| 主节点宕机 | 需手动触发主从切换,约 30 秒恢复 | 自动主从切换,约 5 秒恢复 |

| 消息持久化(同步刷盘) | 数据不丢失,但吞吐量下降 30% | 数据不丢失,吞吐量下降约 15% |

| 网络分区 | 可能出现消息重复消费(需业务去重) | 基于 DLedger 的 Raft 协议保证一致性 |

结论:RocketMQ 在金融级可靠性场景下表现更优,符合 **《金融分布式架构规范》** 对消息中间件的要求。

四、坑点规避:那些踩过的 "雷"

Kafka 和 RocketMQ 的底层设计差异巨大,迁移中若忽视这些差异,极易引发生产事故。以下是高频坑点及解决方案:

4.1 坑点 1:分区 vs 队列模型差异

差异:Kafka 的 "主题 - 分区" 是静态的(需手动扩容),而 RocketMQ 的 "主题 - 队列" 支持动态扩容;Kafka 分区数决定并发度,RocketMQ 队列数 × 消费线程数决定并发度。

表现:迁移后若直接沿用 Kafka 的分区数配置,会导致 RocketMQ 消费并发不足。

解决方案 :根据业务并发需求动态调整 RocketMQ 队列数,消费端配置consumer.setConsumeThreadMin(20)和consumer.setConsumeThreadMax(50)(示例代码):

/**

* RocketMQ消费线程配置

* @author ken

*/

@Configuration

public class RocketMQConsumerConfig {

@Bean

public DefaultMQPushConsumer orderConsumer(@Value("${rocketmq.namesrv.addr}") String namesrvAddr) throws Exception {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("order_consumer_group");

consumer.setNamesrvAddr(namesrvAddr);

// 设置消费线程数范围

consumer.setConsumeThreadMin(20);

consumer.setConsumeThreadMax(50);

// 订阅主题,支持动态队列扩容

consumer.subscribe("user_order_topic", "*");

consumer.registerMessageListener((MessageListenerConcurrently) (msgs, context) -> {

// 业务处理逻辑

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

});

consumer.start();

return consumer;

}

}4.2 坑点 2:消息重试机制差异

差异:Kafka 无内置重试机制(需手动捕获异常并重发),RocketMQ 默认开启自动重试(最多 16 次,间隔指数级增长)。

表现:迁移后若未调整重试策略,会导致非幂等消息重复消费,引发业务数据错乱。

解决方案:

-

业务实现幂等性(基于消息 ID 或业务唯一键);

-

自定义 RocketMQ 重试策略(示例代码):

/**

- 自定义RocketMQ重试策略

- @author ken

*/

public class CustomRetryPolicy implements org.apache.rocketmq.client.consumer.retry.RetryPolicy {

@Override

public long getNextRetryDelayTime(int retryTimes) {

// 自定义重试间隔:1s→3s→5s→10s(最多5次重试)

switch (retryTimes) {

case 1: return 1000L;

case 2: return 3000L;

case 3: return 5000L;

case 4: return 10000L;

default: return -1L; // 停止重试

}

}

}

// 配置到消费者

consumer.setRetryPolicy(new CustomRetryPolicy());

4.3 坑点 3:事务消息实现差异

差异 :Kafka 事务消息依赖TransactionCoordinator,需手动管理事务状态;RocketMQ 事务消息基于 "半消息 + 回查机制",实现更简单。

表现:迁移后若沿用 Kafka 事务消息逻辑,会导致事务一致性问题。

解决方案:使用 RocketMQ 原生事务消息 API(示例代码):

/**

* RocketMQ事务消息生产者

* @author ken

*/

@Slf4j

@Component

public class RocketMQTransactionProducer {

private final TransactionMQProducer producer;

@Autowired

public RocketMQTransactionProducer(@Value("${rocketmq.namesrv.addr}") String namesrvAddr) throws Exception {

producer = new TransactionMQProducer("transaction_producer_group");

producer.setNamesrvAddr(namesrvAddr);

// 注册事务监听器

producer.setTransactionListener(new TransactionListener() {

@Override

public LocalTransactionState executeLocalTransaction(Message msg, Object arg) {

// 执行本地事务(如数据库操作)

String orderId = new String(msg.getBody(), StandardCharsets.UTF_8);

try {

// 调用业务服务执行本地事务

orderService.createOrder(orderId);

return LocalTransactionState.COMMIT_MESSAGE;

} catch (Exception e) {

log.error("本地事务执行失败", e);

return LocalTransactionState.ROLLBACK_MESSAGE;

}

}

@Override

public LocalTransactionState checkLocalTransaction(MessageExt msg) {

// 事务回查:检查本地事务状态

String orderId = new String(msg.getBody(), StandardCharsets.UTF_8);

boolean exists = orderService.checkOrderExists(orderId);

return exists ? LocalTransactionState.COMMIT_MESSAGE : LocalTransactionState.ROLLBACK_MESSAGE;

}

});

producer.start();

}

/**

* 发送事务消息

* @param topic 主题

* @param orderId 订单ID

* @throws Exception 发送异常

*/

public void sendTransactionMessage(String topic, String orderId) throws Exception {

Message msg = new Message(topic, orderId.getBytes(StandardCharsets.UTF_8));

producer.sendMessageInTransaction(msg, null);

}

}4.4 坑点 4:消息存储机制差异

差异:Kafka 的消息存储按 "主题 - 分区" 分文件,删除策略为 "日志清理(Log Cleanup)";RocketMQ 按 "CommitLog+ConsumeQueue" 存储,删除策略为 "按文件过期时间删除"。

表现:迁移后若沿用 Kafka 的日志保留策略,会导致 RocketMQ 磁盘占用过高。

解决方案 :配置 RocketMQ Broker 的存储策略(broker.conf):

# 消息存储时间(默认72小时)

fileReservedTime=48

# 磁盘使用率超过85%时触发删除

diskMaxUsedSpaceRatio=85

# 启用磁盘水位线监控

enableDiskMonitor=true4.5 坑点 5:消费者组机制差异

差异 :Kafka 的消费者组位移存储在__consumer_offsets 主题,RocketMQ 的消费者组位移存储在 Broker 的consumerOffset.json文件;Kafka 支持跨消费者组消费同一分区,RocketMQ 一个队列只能被同一消费组的一个消费者消费。

表现:迁移后若多个消费组消费同一队列,会导致消费堆积。

解决方案:为不同业务场景创建独立的 RocketMQ 主题或消费组(示例代码):

/**

* 多消费组配置

* @author ken

*/

@Configuration

public class MultiConsumerConfig {

// 订单服务消费组

@Bean

public DefaultMQPushConsumer orderConsumer(@Value("${rocketmq.namesrv.addr}") String namesrvAddr) throws Exception {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("order_consumer_group");

consumer.setNamesrvAddr(namesrvAddr);

consumer.subscribe("user_order_topic", "*");

// 业务逻辑...

return consumer;

}

// 库存服务消费组

@Bean

public DefaultMQPushConsumer stockConsumer(@Value("${rocketmq.namesrv.addr}") String namesrvAddr) throws Exception {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("stock_consumer_group");

consumer.setNamesrvAddr(namesrvAddr);

consumer.subscribe("user_order_topic", "*");

// 业务逻辑...

return consumer;

}

}五、迁移全流程实践(以电商订单系统为例)

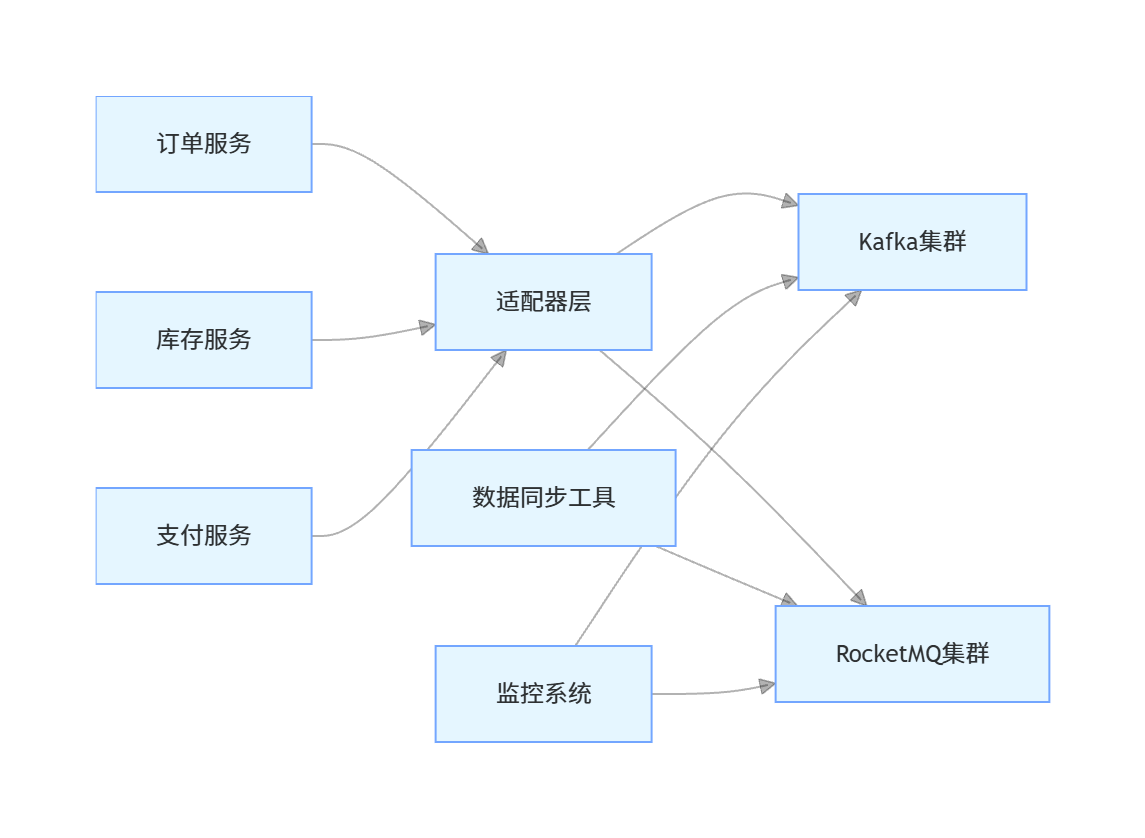

5.1 迁移架构图

5.2 迁移流程图

5.3 核心业务代码示例(订单创建)

import com.baomidou.mybatisplus.core.conditions.query.QueryWrapper;

import com.fasterxml.jackson.databind.ObjectMapper;

import io.swagger.v3.oas.annotations.Operation;

import io.swagger.v3.oas.annotations.tags.Tag;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RequestBody;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.util.StringUtils;

/**

* 订单控制器

* @author ken

*/

@RestController

@RequestMapping("/api/order")

@Tag(name = "订单管理", description = "订单创建、查询接口")

@Slf4j

public class OrderController {

@Autowired

private OrderService orderService;

@Autowired

private MessageQueueClient messageQueueClient;

private final ObjectMapper objectMapper = new ObjectMapper();

/**

* 创建订单

* @param orderDTO 订单信息

* @return 创建结果

*/

@PostMapping("/create")

@Operation(summary = "创建订单", description = "生成订单并发送消息到队列")

public ResultVO<String> createOrder(@RequestBody OrderDTO orderDTO) {

try {

StringUtils.hasText(orderDTO.getUserId(), "用户ID不能为空");

StringUtils.hasText(orderDTO.getProductId(), "商品ID不能为空");

// 1. 保存订单到数据库

Order order = new Order();

order.setOrderId(java.util.UUID.randomUUID().toString());

order.setUserId(orderDTO.getUserId());

order.setProductId(orderDTO.getProductId());

order.setAmount(orderDTO.getAmount());

order.setStatus("CREATED");

orderService.save(order);

// 2. 发送消息到队列(通过适配器层,底层透明)

String message = objectMapper.writeValueAsString(order);

SendResult sendResult = messageQueueClient.send("user_order_topic", message);

if (sendResult.isSuccess()) {

return ResultVO.success(order.getOrderId());

} else {

return ResultVO.fail("消息发送失败");

}

} catch (Exception e) {

log.error("创建订单失败", e);

return ResultVO.fail("系统异常");

}

}

/**

* 查询订单

* @param orderId 订单ID

* @return 订单信息

*/

@PostMapping("/query")

@Operation(summary = "查询订单", description = "根据订单ID查询订单详情")

public ResultVO<Order> queryOrder(@RequestBody String orderId) {

StringUtils.hasText(orderId, "订单ID不能为空");

Order order = orderService.getOne(new QueryWrapper<Order>().eq("order_id", orderId));

if (ObjectUtils.isEmpty(order)) {

return ResultVO.fail("订单不存在");

}

return ResultVO.success(order);

}

}六、总结

从 Kafka 迁移到 RocketMQ 并非简单的 "替换组件",而是需要结合业务场景设计平滑过渡方案:

- 兼容改造:通过适配器模式或 Proxy 实现 API / 协议层兼容,避免大规模代码重构;

- 性能优化:利用 RocketMQ 的队列动态扩容、推 - 拉消费模型提升吞吐量;

- 坑点规避:重点关注模型差异(分区 vs 队列)、重试机制、事务实现等核心差异点。

根据Apache 软件基金会 2024 年中间件报告,RocketMQ 的市场份额已从 2020 年的 15% 提升至 2024 年的 32%,尤其在金融、电商等领域成为主流选择。只要把握 "先兼容、再验证、后切换" 的原则,就能实现从 Kafka 到 RocketMQ 的无痛迁移,充分发挥 RocketMQ 在可靠性、功能性上的优势。