摘要

随着大规模语言模型(LLMs)的参数规模从数十亿向数万亿迈进,其训练和推理的计算成本、内存需求及能源消耗呈现出难以持续的增长趋势。混合专家模型(Mixture of Experts, MoE)作为一种创新的稀疏激活神经网络架构,为解决这一 scalability(可扩展性)瓶颈提供了关键路径。本文旨在深入剖析 MoE 的核心工作机制,阐释其如何通过"条件计算"与"稀疏激活"原理,在保持模型总参数规模巨大的同时,显著降低每个输入样本所需的实际计算量。文章将详细讨论 MoE 的核心组件,如路由器(Router)与专家网络(Experts),分析其相较于稠密模型在训练效率与推理速度上的优势,并探讨其面临的主要挑战(如训练不稳定性、负载不均衡)及相应的解决方案(如负载均衡损失、路由器 Z-loss 等)。最后,本文将展望 MoE 技术的未来发展方向及其在推动下一代超大规模人工智能模型发展中的核心作用。

1. 引言

近年来,以 Transformer 架构为核心的预训练大模型在自然语言处理、计算机视觉等多领域取得了革命性成功。一个被广泛观察到的经验规律是:模型的性能随着参数量的增加和训练数据的扩大而显著提升(即 Scaling Law)。然而,这种"规模红利"的背后是惊人的计算代价。训练一个拥有千亿级参数的稠密模型,不仅需要庞大的算力集群,还面临着内存墙、能耗过高和推理延迟等一系列严峻挑战。在传统的稠密模型中,每一个输入样本都会激活整个网络的所有参数,导致计算成本与模型规模呈线性甚至更快的增长关系。

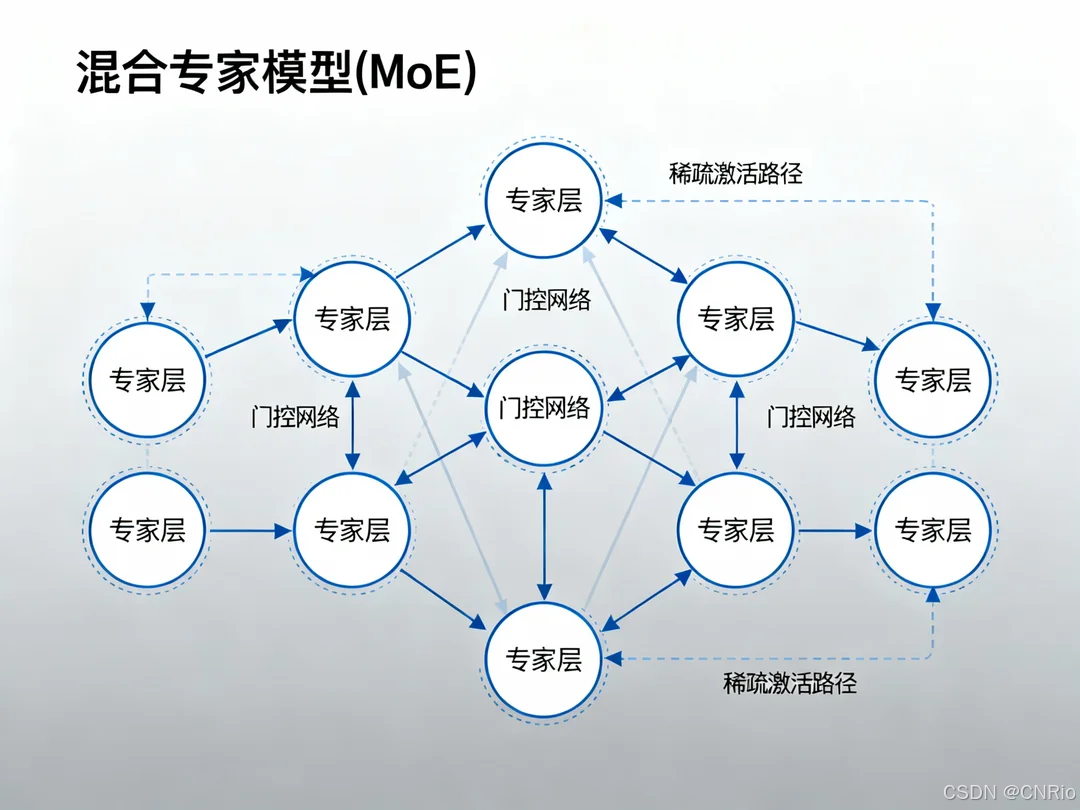

为了打破这一僵局,研究者们将目光投向了条件计算(Conditional Computation)的思想,即让模型根据输入数据的不同,动态地选择网络中的一部分进行计算。混合专家模型(MoE)正是这一思想的杰出代表。其核心思想是:用多个"专家"(Expert)子网络替代单一的稠密前馈网络(FFN),并引入一个"路由器"(Router)机制,为每个输入令牌(Token)智能地选择最相关的少数几个专家进行激活。 这样,模型的总参数量可以变得极其庞大(以提升模型容量和知识储备),但处理每个令牌的实际计算量却保持不变(仅激活少数专家),从而实现了计算效率与模型规模的有效解耦。

本文后续结构如下:第二章将深入解析 MoE 的核心架构与工作机制;第三章将系统分析 MoE 在大模型训练中的效率优势;第四章将探讨 MoE 实践中的挑战与解决方案;第五章将介绍其代表性应用与未来展望;第六章为总结。

2. MoE 的核心架构与工作机制

MoE 层通常被用来替换 Transformer 架构中的标准前馈网络层。一个典型的 MoE 系统由以下两个核心组件构成:

2.1 专家网络(Experts)

每个"专家"本身是一个独立的神经网络,通常是结构相同但参数不同的前馈网络(FFN)。设专家数量为 ( N )。在一个标准的稠密 Transformer 中,每个 FFN 层的参数量是固定的。而在 MoE 中,我们用 ( N ) 个这样的 FFN 并行排列,构成专家池。模型的总参数量因此近似变为稠密模型的 ( N ) 倍,但这并不意味着计算量同比例增加。

2.2 路由器(Router)

路由器是一个轻量级的可学习网络(通常是一个简单的线性层),其功能是根据输入的令牌 ( x ) 计算出一个与所有专家对应的权重分数(Logits)。其过程可以形式化如下:

- 计算门控值:( g(x) = \text{Softmax}(W_{router} \cdot x + b) ),其中 ( g(x) ) 是一个 ( N ) 维向量。

- 选择 Top-k 专家:路由器并非选择所有专家,而是仅选择权重分数最高的 ( k ) 个专家(通常 ( k ) 是一个非常小的值,如 1, 2, 或 4)。这被称为 稀疏激活。

- 设定门限:对于未入选的专家,其激活权重直接置零,该专家在此次前向传播中完全不被执行。

2.3 前向传播过程

对于一个输入令牌 ( x ),MoE 层的前向传播过程为:

- 令牌 ( x ) 输入路由器,得到路由权重 ( g(x) )。

- 根据 ( g(x) ) 选出 top-k 专家 ( {e_1, e_2, ..., e_k} ) 及其对应的权重 ( {g_1, g_2, ..., g_k} )。

- 将令牌 ( x ) 分别送入这 ( k ) 个被选中的专家网络,得到各自的输出 ( {E_1(x), E_2(x), ..., E_k(x)} )。

- 将各专家输出进行加权求和,得到 MoE 层的最终输出:( y = \sum_{i=1}^{k} g_i \cdot E_i(x) )。

通过这一机制,尽管模型拥有 ( N ) 个专家的总参数,但每个令牌仅消耗了约 ( k ) 个专家的计算量。当 ( N ) 很大而 ( k ) 很小时,计算效率的提升是巨大的。

3. MoE 在大模型高效训练中的优势

3.1 计算效率的飞跃

MoE 最直接的优势在于显著降低了训练和推理的浮点运算数(FLOPs)。对于一个拥有 ( E ) 个专家的 MoE 层,其计算成本仅约为等效参数规模稠密模型的 ( k/E ) 倍。这使得研究者能够以可承受的计算成本,构建和训练参数量高达万亿级别甚至更大的模型。

3.2 模型容量的指数级扩展

MoE 允许模型总参数数量在不显著增加计算开销的情况下实现近乎线性的增长。这意味着模型可以具备更强的记忆能力和知识存储容量,从而在处理复杂任务、理解细微语义差别和覆盖更多领域知识方面表现出巨大潜力。

3.3 与现有基础设施的兼容性

MoE 架构可以无缝集成到现有的深度学习框架和训练流水线中。更重要的是,它可以自然地与模型并行、数据并行等分布式训练策略相结合。通过将不同的专家放置在不同的计算设备上(专家并行),可以有效地解决超大型模型的内存分布问题。

4. 挑战与解决方案

尽管优势明显,MoE 模型也引入了一系列新的挑战。

4.1 训练不稳定性

MoE 模型的训练过程往往比稠密模型更加不稳定。路由器决策的离散性会导致梯度估计存在噪声,并且路由策略的微小变化可能会引发专家使用情况的剧烈波动。解决方案包括:

- 精细的损失函数设计: 引入辅助损失函数,如 负载均衡损失(Load Balancing Loss),鼓励所有专家获得大致相等的训练样本,避免"赢家通吃"。

- 路由器 Z-Loss: 对路由器输出的 logits 的 L2 范数进行约束,稳定训练过程。

- 逐步激活策略: 在训练初期使用较高的 ( k ) 值或引入随机性,随着训练进行逐渐收紧路由策略。

4.2 专家负载不均衡

这是训练不稳定的一个具体表现。如果路由器倾向于将大多数输入都路由到少数几个"热门"专家,那么大部分专家将得不到充分训练,导致模型容量浪费。负载均衡损失正是为了解决这一问题而设计的。

4.3 推理时的通信开销与内存占用

在分布式推理场景下,即使一个令牌只激活 ( k ) 个专家,系统也可能需要在所有设备间进行通信来收集这些专家的输出。此外,虽然激活的内存占用小,但存储所有专家参数需要巨大的静态内存。解决方案包括模型压缩、专家缓存以及更智能的调度策略。

4.4 过拟合风险

由于每个批次中每个专家只看到一部分数据,MoE 模型在较小数据集上更容易出现过拟合。需要采用更强有力的正则化技术。

5. 代表性应用与未来展望

MoE 已成为构建尖端大模型的关键技术之一。

- GShard 和 Switch Transformer 是谷歌早期将 MoE 成功推向极大规模的代表性工作,证明了在万亿参数量级上高效训练的可行性。

- GPT-4 据信也采用了 MoE 架构,这进一步印证了该技术在产业界顶尖模型中的核心地位。

- Mixtral 8x7B 是 Mistral AI 发布的开源 MoE 模型,其性能在多个基准测试中超越了参数量更大的稠密模型(如 Llama 2 70B),展现了 MoE 卓越的性能效率比。

未来,MoE 技术的发展方向可能包括:

- 更高效的路由算法: 研究基于哈希、基于聚类或具有更好理论性质的路由机制。

- 细粒度 MoE: 将 MoE 思想应用到更细粒度的层面,如神经元级别或注意力头级别。

- 多模态 MoE: 设计能够处理和理解不同模态数据(文本、图像、音频)的专家系统。

- 动态专家结构: 探索专家数量或结构能够根据任务需求动态调整的自适应 MoE。

6. 结论

混合专家模型通过其稀疏激活的核心机制,巧妙地解决了大模型时代计算成本与模型规模之间的尖锐矛盾。它将条件计算的思想付诸实践,在维持巨大模型容量的同时,将计算资源动态且高效地分配给最相关的输入。尽管在训练稳定性、负载均衡等方面仍存在挑战,但通过持续的研究与工程优化,这些难题正在被逐一攻克。作为支撑当今万亿参数级别大模型的关键技术支柱,MoE 无疑将继续在推动人工智能向更大规模、更高性能、更高效率发展的道路上扮演不可或缺的角色。

参考文献

1\] Shazeer, N., et al. (2017). Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer. *ICLR* . \[2\] Lepikhin, D., et al. (2021). GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding. *ICLR* . \[3\] Fedus, W., et al. (2022). Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity. *JMLR* . \[4\] Jiang, A. Q., et al. (2024). Mixtral of Experts. *arXiv preprint arXiv:2401.04088*.