目录

写在前面

今天看一篇关于知识蒸馏(Knowledge Distillation, KD)的全面综述,知识蒸馏可以想象成一位"学霸"老师把自己的解题思路和秘诀传授给"学弟学妹"学生的过程,目的是让小巧高效的"学生"模型也能拥有接近庞大"老师"模型的强大能力。这在人工智能领域非常重要,能让我们在手机、摄像头等计算资源有限的设备上也能运行强大的AI模型。

这篇文章系统性地梳理了知识蒸馏这个领域,就像一本厚厚的"武功秘籍大全",详细讲解了各种不同的"传授功力"的方法。下面我梳理一下最重要的内容。

论文地址:https://arxiv.org/pdf/2503.12067

一、知识从哪里来?

这就像是问,老师要教给学生什么?文章总结了三大类"知识宝库":

1.答案本身(基于Logit的蒸馏):老师直接告诉学生这道题选A的概率是80%,选B的概率是20%。学生不光要学正确答案,还要学老师这种"不确定性的感觉"。这是最经典、最直接的方法。

2.解题思路和中间步骤(基于特征的蒸馏):老师不光给答案,还把关键的解题步骤、画的辅助线(即模型中间层提取的特征)也展示给学生看。学生模仿这些中间步骤,能学得更深、更好。

3.知识点之间的联系(基于相似性的蒸馏):老师会教学生,题目1和题目2很像,解题思路是相通的;而题目1和题目3差别很大。学生学会了这种"举一反三"的能力,泛化性就更强。

二、知识蒸馏的传授方案

这指的是老师和学生之间的教学安排模式。

1.离线教学(离线蒸馏):这是最常用的模式。老师(大模型)已经学成毕业了,知识渊博且固定不变。学生(小模型)在学习时,随时可以向这位固定的老师请教。这种方法简单有效,但学生的高度受限于这位老师。

2.在线教学(在线蒸馏):老师和学生是同学,一起学习、共同进步。他们可以互相切磋,或者一群学生互相作为老师。这样更灵活,不需要一个预先练好的"大师傅"。

3.自学成才(自蒸馏):没有外部老师,自己教自己。比如,用自己模型之前学到的知识来指导现在训练,或者让模型的深层部分教浅层部分。这种方法在数据没有标签(自监督学习)时特别有用。

三、知识蒸馏的核心算法

增强教学效果的"教学法"有很多:

1.注意力引导法(基于注意力的蒸馏):老师告诉学生,看图片时要重点关注这里、那里(关键区域),别被无关信息干扰。这能让学生学得更精准。

2.对抗训练法(对抗蒸馏):有点像"故意出难题考学生"。生成一些迷惑性的题目(对抗样本),训练学生即使在干扰下也能做出和老师一样的判断,让模型更鲁棒。

3.名师团教学(多教师蒸馏):不止一位老师,而是请好几位各有所长的老师来教一个学生,博采众长,让学生学到的知识更全面。

4.跨学科教学(跨模态蒸馏):让一种"专业"的老师(比如精通图像的老师)去教另一种"专业"的学生(比如处理文本的学生)。比如,让一个既懂图像又懂文字的模型,把两种知识融合起来教给一个只处理图像的小模型。

5.关系图谱教学(基于图的蒸馏):把知识组织成一张关系网来教,让学生理解知识点之间的复杂关联,而不仅仅是单个知识点。

6.因材施教法(自适应蒸馏):不是一成不变地教,而是动态调整。比如,发现老师某部分讲得不好,就少听点;或者根据学生的学习进度,动态调整教学重点。

7.对比学习法(对比蒸馏):通过比较"相似"和"不相似"的样本来教学。让学生明白,和老师对于相似样本的反应应该靠近,对于不同样本的反应应该远离。

四、知识蒸馏的应用领域

这篇文章花了很大篇幅介绍知识蒸馏在各种AI任务中的应用,简直无处不在:

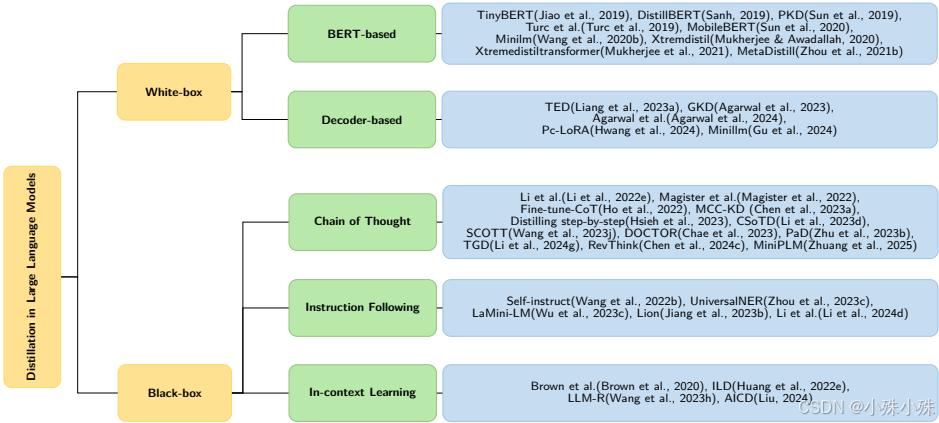

1.大型语言模型(LLMs)的"瘦身":像GPT、BERT这样的巨无霸模型,通过知识蒸馏可以压缩成小巧精干的版本,让你在手机上也能运行强大的聊天机器人。

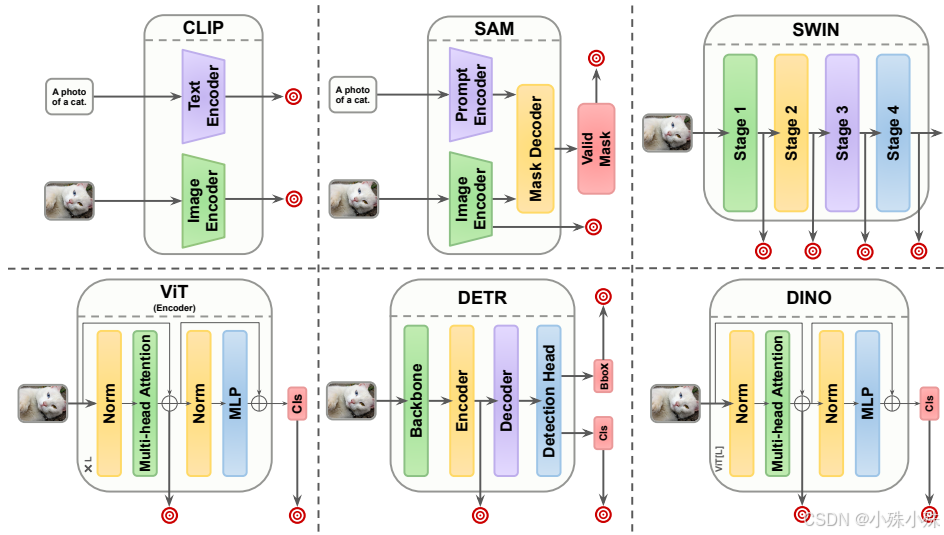

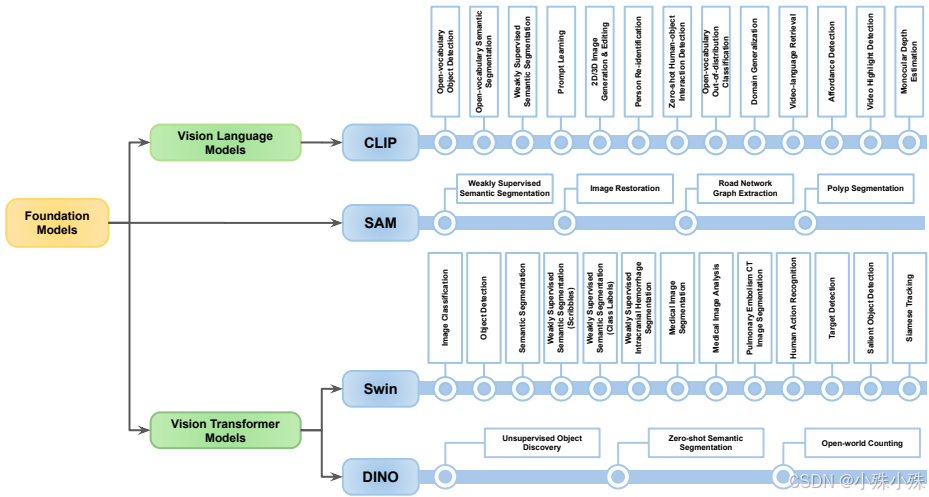

2.基础模型的"下放":将CLIP(能同时理解图像和文字)、SAM(能分割万物)等超强模型的能力,蒸馏到小模型上,让小模型也拥有"火眼金睛"。

3.自监督学习的"核心":很多不需要人工标注数据的学习方法(如SimCLR, DINO),其本质就是一种"自蒸馏",自己和自己学。

4.扩散模型的"加速":像Stable Diffusion这样的AI绘画模型,生成一张图需要很多步,很慢。通过蒸馏,可以大幅减少步骤,实现快速高质量生成。

5.视觉识别任务的"提效":在图像分类、物体检测、语义分割等所有常见的视觉任务中,知识蒸馏都被广泛用于打造又快又好的小模型。

总结一下,这篇综述就像一份超级详细的"知识蒸馏"使用说明书和百科全书。它告诉你:

(1)知识有哪些形式(答案、思路、关系)。

(2)教学有哪些模式(离线、在线、自学)。

(3)有哪些高效的教学方法(注意力、对抗、多教师等)。

(4)以及这些方法在AI的各个热门领域(大语言模型、基础模型、图像生成、视觉识别等)是如何具体应用的。

最终目的就是:把大模型的"智慧",高效、无损地"注入"到小模型里,让强大的AI能力变得无处不在、触手可及。

关注不迷路(*^▽^*),暴富入口==》 https://bbs.csdn.net/topics/619691583