在分布式系统中,定时任务是核心基础设施之一 ------ 电商平台的订单超时关闭、金融系统的利息结算、物流系统的路径优化等场景,都依赖可靠的任务调度能力。传统单机定时任务(如@Scheduled)存在 "单点故障""负载不均""任务重复执行" 等问题,无法满足分布式场景需求。基于SpringBoot、Quartz与Redis构建的分布式任务调度系统,可实现 "高可用、高并发、可扩展" 的任务管理,支持每秒千级任务调度,故障自动转移,任务执行状态全链路追踪。本文将从架构设计到生产落地,拆解这套系统的全流程实践。

Part.01 系统架构设计:分布式调度的分层模型

分布式任务调度的核心诉求是 "任务不重复、节点可容错、负载能均衡",因此采用 "三层调度模型":接入层负责任务管理,调度层负责任务分发,执行层负责任务运行,通过中间件解耦各层,实现水平扩展。

1.1 架构分层与核心组件

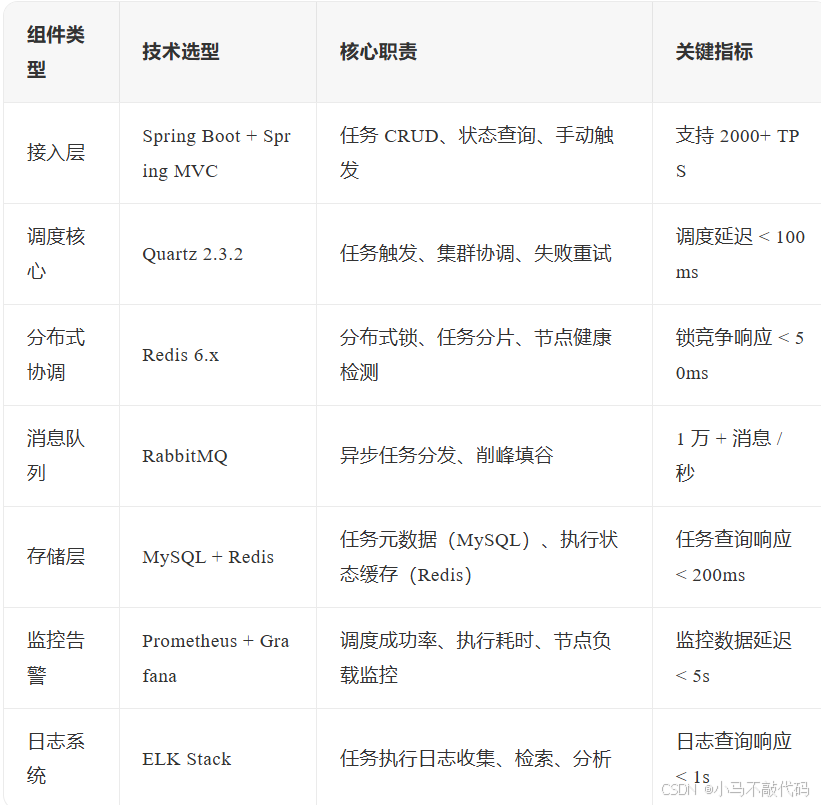

系统从下到上分为 "基础设施层、核心调度层、应用接入层",各层组件及职责如下:

1.2 核心数据流:从任务创建到执行的全链路

任务调度的全流程遵循 "创建→存储→调度→执行→反馈" 的闭环,关键步骤如下:

1、任务创建

用户通过管理后台调用POST /task接口,提交任务配置(如 CRON 表达式0 0 * * * ?、执行器地址、参数);

2、元数据存储

任务信息(ID、CRON、状态)存入 MySQL,同时缓存到 Redis(task:{taskId}),避免频繁查库;

3、调度触发

Quartz 集群节点通过竞争 Redis 锁获取调度权,根据 CRON 表达式计算下次触发时间,触发时生成任务实例;

4、任务分发

调度节点将任务实例推送到 RabbitMQ 的 "task-exchange",根据执行器负载(CPU 使用率)路由到对应队列;

5、任务执行

执行器监听队列,获取任务后通过线程池异步执行,执行过程中实时更新 Redis 中的状态(running/success/failed);

6、结果反馈

执行完成后,执行器将结果(耗时、日志 ID)写入 MySQL,同时通过 WebSocket 推送至管理后台;

7、失败处理

若执行失败,Quartz 根据重试策略(如最多 3 次,间隔 5 分钟)重新调度,超过重试次数则触发告警。

Part.02 SpringBoot 框架实现:整合调度核心与分布式能力

SpringBoot 作为基础框架,负责整合 Quartz、Redis 与消息队列,通过自动配置简化开发,同时利用 Spring 的依赖注入与事务管理保证系统稳定性。

2.1 核心依赖与自动配置

通过 Maven 引入关键依赖,实现 Quartz 与 Redis 的无缝整合:

java

<dependencies>

<!-- SpringBoot核心 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<!-- Quartz调度框架 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-quartz</artifactId>

</dependency>

<!-- Redis客户端 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

<!-- 消息队列 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-amqp</artifactId>

</dependency>

<!-- 数据库 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-jdbc</artifactId>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

</dependency>

</dependencies>自定义 Quartz 配置,使用 MySQL 存储调度信息(替代默认内存存储),实现集群化:

java

@Configuration

public class QuartzConfig {

@Autowired

private DataSource dataSource;

// 配置Quartz数据源,支持集群

@Bean

public SchedulerFactoryBean schedulerFactoryBean() {

SchedulerFactoryBean factory = new SchedulerFactoryBean();

factory.setDataSource(dataSource);

// 集群实例ID自动生成(避免节点ID冲突)

factory.setInstanceIdGenerator(new SystemPropertyInstanceIdGenerator());

// 覆盖已存在的任务(部署新版本时更新任务配置)

factory.setOverwriteExistingJobs(true);

// 延迟启动(避免应用未就绪时调度任务)

factory.setStartupDelay(10);

return factory;

}

// 暴露Scheduler供业务调用

@Bean

public Scheduler scheduler() throws SchedulerException {

return schedulerFactoryBean().getScheduler();

}

}2.2 任务管理服务:动态 CRUD 与状态控制

封装任务管理接口,支持动态创建、更新、暂停、恢复任务,核心逻辑如下:

java

@Service

@Transactional

public class TaskManagerService {

@Autowired

private Scheduler scheduler;

@Autowired

private RedisTemplate<String, Object> redisTemplate;

@Autowired

private TaskRepository taskRepository;

// 创建定时任务

public String createTask(TaskDTO taskDTO) {

String taskId = UUID.randomUUID().toString();

try {

// 1. 构建Quartz JobDetail

JobDetail jobDetail = JobBuilder.newJob(TaskExecuteJob.class)

.withIdentity(taskId)

.usingJobData("param", JSON.toJSONString(taskDTO.getParam())) // 任务参数

.storeDurably()

.build();

// 2. 构建Trigger(CRON表达式)

Trigger trigger = TriggerBuilder.newTrigger()

.withIdentity("trigger_" + taskId)

.forJob(jobDetail)

.withSchedule(CronScheduleBuilder.cronSchedule(taskDTO.getCron()))

.startNow()

.build();

// 3. 注册任务到Quartz

scheduler.scheduleJob(jobDetail, trigger);

// 4. 保存任务元数据到数据库

TaskPO taskPO = new TaskPO();

taskPO.setTaskId(taskId);

taskPO.setCron(taskDTO.getCron());

taskPO.setStatus(TaskStatus.RUNNING);

taskRepository.save(taskPO);

// 5. 缓存任务配置到Redis

redisTemplate.opsForValue().set("task:" + taskId, taskPO, 24, TimeUnit.HOURS);

return taskId;

} catch (SchedulerException e) {

throw new TaskException("创建任务失败", e);

}

}

// 暂停任务

public void pauseTask(String taskId) {

try {

scheduler.pauseJob(JobKey.jobKey(taskId));

// 更新数据库与缓存状态

taskRepository.updateStatus(taskId, TaskStatus.PAUSED);

redisTemplate.opsForValue().set("task:" + taskId,

taskRepository.findByTaskId(taskId), 24, TimeUnit.HOURS);

} catch (SchedulerException e) {

throw new TaskException("暂停任务失败", e);

}

}

// 其他方法:resumeTask(恢复)、updateTask(更新)、deleteTask(删除)

}2.3 分布式锁实现:避免任务重复调度

在 Quartz 集群中,多个节点可能同时触发同一任务,导致重复执行。通过 Redis 分布式锁保证同一任务在同一时间仅被一个节点调度:

java

@Component

public class RedisDistributedLock {

@Autowired

private StringRedisTemplate redisTemplate;

// 获取锁:超时自动释放,防止死锁

public boolean tryLock(String lockKey, long expireSeconds) {

String lockValue = UUID.randomUUID().toString();

// SET NX PX:不存在则设置,过期时间毫秒

Boolean success = redisTemplate.opsForValue().setIfAbsent(

"lock:" + lockKey,

lockValue,

expireSeconds,

TimeUnit.SECONDS

);

return Boolean.TRUE.equals(success);

}

// 释放锁:防止误删其他节点的锁(用Lua脚本保证原子性)

public void releaseLock(String lockKey, String lockValue) {

String script = "if redis.call('get', KEYS[1]) == ARGV[1] then return redis.call('del', KEYS[1]) else return 0 end";

redisTemplate.execute(

new DefaultRedisScript<>(script, Integer.class),

Collections.singletonList("lock:" + lockKey),

lockValue

);

}

}在 Quartz Job 中使用分布式锁控制调度:

java

public class TaskExecuteJob implements Job {

@Autowired

private RedisDistributedLock lock;

@Autowired

private RabbitTemplate rabbitTemplate;

@Override

public void execute(JobExecutionContext context) throws JobExecutionException {

String taskId = context.getJobDetail().getKey().getName();

String lockValue = UUID.randomUUID().toString();

try {

// 尝试获取锁,10秒过期(确保任务执行超时后自动释放)

if (lock.tryLock(taskId, 10)) {

// 锁获取成功,分发任务到执行器

TaskInstance instance = new TaskInstance();

instance.setTaskId(taskId);

instance.setInstanceId(UUID.randomUUID().toString());

instance.setTriggerTime(new Date());

rabbitTemplate.convertAndSend("task-exchange", "task.route", instance);

} else {

// 锁获取失败,说明其他节点已调度

log.info("任务{}已被其他节点调度,当前节点跳过", taskId);

}

} finally {

// 释放锁

lock.releaseLock(taskId, lockValue);

}

}

}Part.03 核心技术优化:解决分布式调度痛点

分布式任务调度面临 "负载不均""大任务拆分""失败重试" 等挑战,需通过针对性优化提升系统可靠性与效率。

3.1 动态负载均衡:任务分发更合理

传统 Quartz 集群采用 "随机节点触发" 策略,可能导致部分节点负载过高。通过 "执行器健康度检测 + 动态权重分配" 优化任务分发:

执行器健康度采集

执行器定期(30 秒)向 Redis 上报自身状态(CPU 使用率、内存占用、当前任务数),存储在executor:status:{executorId};

权重计算

调度节点根据执行器状态计算权重(CPU 使用率 <70% 权重为 1,70%-85% 为 0.5,>85% 为 0);

任务路由

RabbitMQ 交换机根据执行器权重路由任务,权重高的节点接收更多任务。

java

@Component

public class TaskRouter implements RabbitTemplate.ReturnCallback {

@Autowired

private StringRedisTemplate redisTemplate;

// 计算执行器权重,返回最合适的执行器ID

public String routeTask() {

// 1. 获取所有在线执行器

Set<String> executorIds = redisTemplate.keys("executor:status:*");

if (CollectionUtils.isEmpty(executorIds)) {

throw new NoExecutorAvailableException("无可用执行器");

}

// 2. 计算每个执行器的权重

Map<String, Double> weightMap = new HashMap<>();

for (String key : executorIds) {

String executorId = key.split(":")[2];

String statusJson = redisTemplate.opsForValue().get(key);

ExecutorStatus status = JSON.parseObject(statusJson, ExecutorStatus.class);

// 权重 = (1 - CPU使用率) * 0.6 + (1 - 内存使用率) * 0.3 + (1 - 任务饱和度) * 0.1

double cpuWeight = Math.max(0, 1 - status.getCpuUsage());

double memoryWeight = Math.max(0, 1 - status.getMemoryUsage());

double taskWeight = Math.max(0, 1 - status.getTaskSaturation());

double weight = cpuWeight * 0.6 + memoryWeight * 0.3 + taskWeight * 0.1;

weightMap.put(executorId, weight);

}

// 3. 按权重随机选择执行器(权重高的概率大)

return selectByWeight(weightMap);

}

// 按权重随机选择

private String selectByWeight(Map<String, Double> weightMap) {

List<String> executorIds = new ArrayList<>();

for (Map.Entry<String, Double> entry : weightMap.entrySet()) {

int count = (int) (entry.getValue() * 100); // 放大100倍转为次数

for (int i = 0; i < count; i++) {

executorIds.add(entry.getKey());

}

}

if (executorIds.isEmpty()) {

return weightMap.keySet().iterator().next(); // 权重全为0时随机选一个

}

return executorIds.get(new Random().nextInt(executorIds.size()));

}

}3.2 任务分片:处理大数据量任务

对于 "全量数据同步" 等大任务,单节点执行耗时过长,需拆分为多个子任务并行处理。基于 Redis 实现分片协调:

1、分片策略

按数据 ID 范围分片(如用户 ID%10=0~9 分为 10 片);

2、分片抢占

执行器启动时通过 Redis 的RPOP命令抢占分片;

3、进度跟踪

每个分片完成后更新 Redis 中的进度(task:shard:{taskId}:{shardIndex})。

java

@Service

public class ShardingTaskService {

@Autowired

private RedisTemplate<String, Object> redisTemplate;

// 初始化分片(任务创建时调用)

public void initShards(String taskId, int shardCount) {

String shardKey = "task:shards:" + taskId;

// 向Redis List中添加所有分片索引

for (int i = 0; i < shardCount; i++) {

redisTemplate.opsForList().rightPush(shardKey, i);

}

// 设置分片总数

redisTemplate.opsForValue().set("task:shard:total:" + taskId, shardCount);

}

// 执行器抢占分片

public Integer acquireShard(String taskId) {

String shardKey = "task:shards:" + taskId;

// RPOP:原子性获取一个分片(避免多个执行器抢同一分片)

return (Integer) redisTemplate.opsForList().rightPop(shardKey);

}

// 更新分片进度

public void updateShardProgress(String taskId, int shardIndex, boolean success) {

String progressKey = "task:shard:" + taskId + ":" + shardIndex;

redisTemplate.opsForValue().set(progressKey, success ? "success" : "failed");

// 递增已完成分片数

redisTemplate.opsForValue().increment("task:shard:completed:" + taskId, 1);

}

// 检查是否所有分片完成

public boolean isAllShardsCompleted(String taskId) {

Integer total = (Integer) redisTemplate.opsForValue().get("task:shard:total:" + taskId);

Integer completed = (Integer) redisTemplate.opsForValue().get("task:shard:completed:" + taskId);

return total != null && completed != null && completed.equals(total);

}

}3.3 智能重试:失败任务的精准处理

任务执行失败后,盲目重试可能加重系统负担(如依赖服务宕机时)。设计 "阶梯式重试 + 依赖检查" 机制:

重试间隔随次数递增(1 次:5 分钟,2 次:15 分钟,3 次:30 分钟);

重试前检测依赖服务是否可用(如数据库连接、API 响应);

连续失败 10 次后触发熔断,暂停任务并告警。

java

@Component

public class RetryStrategy {

@Autowired

private DependencyChecker dependencyChecker;

@Autowired

private TaskRepository taskRepository;

// 计算下次重试时间

public Date calculateNextRetryTime(int retryCount) {

long delayMinutes;

switch (retryCount) {

case 1: delayMinutes = 5; break;

case 2: delayMinutes = 15; break;

case 3: delayMinutes = 30; break;

default: delayMinutes = 60; // 超过3次后固定1小时

}

return new Date(System.currentTimeMillis() + delayMinutes * 60 * 1000);

}

// 检查是否允许重试

public boolean allowRetry(String taskId, int retryCount, String dependencyService) {

// 1. 检查重试次数是否超限(最多5次)

if (retryCount >= 5) {

return false;

}

// 2. 检查依赖服务是否可用

if (!dependencyChecker.isServiceAvailable(dependencyService)) {

log.warn("任务{}依赖服务{}不可用,暂缓重试", taskId, dependencyService);

return false;

}

// 3. 检查是否触发熔断

Integer consecutiveFails = taskRepository.countConsecutiveFails(taskId);

if (consecutiveFails >= 10) {

taskRepository.updateStatus(taskId, TaskStatus.FUSED); // 熔断状态

return false;

}

return true;

}

}Part.04 功能模块实现:从调度到监控的全链路支撑

系统需提供 "任务管理、执行监控、告警通知" 三大核心功能,满足用户对任务全生命周期的管控需求。

4.1 任务管理模块:可视化配置与操作

基于 Spring MVC 实现 RESTful 接口,支持任务的创建、查询、更新、删除,配合 Vue 前端实现可视化操作:

java

@RestController

@RequestMapping("/api/v1/tasks")

public class TaskController {

@Autowired

private TaskManagerService taskManagerService;

@Autowired

private TaskQueryService taskQueryService;

// 创建任务

@PostMapping

public ResponseEntity<String> createTask(@RequestBody @Valid TaskDTO taskDTO) {

String taskId = taskManagerService.createTask(taskDTO);

return ResponseEntity.status(HttpStatus.CREATED).body(taskId);

}

// 查询任务详情

@GetMapping("/{taskId}")

public ResponseEntity<TaskVO> getTask(@PathVariable String taskId) {

TaskVO taskVO = taskQueryService.getTaskDetail(taskId);

return ResponseEntity.ok(taskVO);

}

// 分页查询任务列表

@GetMapping

public ResponseEntity<Page<TaskVO>> listTasks(

@RequestParam(required = false) String taskName,

@RequestParam(required = false) TaskStatus status,

@RequestParam(defaultValue = "1") int pageNum,

@RequestParam(defaultValue = "10") int pageSize) {

Page<TaskVO> page = taskQueryService.listTasks(taskName, status, pageNum, pageSize);

return ResponseEntity.ok(page);

}

// 手动触发任务

@PostMapping("/{taskId}/trigger")

public ResponseEntity<Void> triggerTask(@PathVariable String taskId) {

taskManagerService.triggerManual(taskId);

return ResponseEntity.accepted().build();

}

}4.2 执行监控模块:实时追踪任务状态

通过 Redis 实时存储任务执行状态,结合 WebSocket 推送实时数据到前端,实现任务执行过程的可视化监控:

java

@Service

public class TaskMonitorService {

@Autowired

private RedisTemplate<String, Object> redisTemplate;

@Autowired

private SimpMessagingTemplate messagingTemplate; // WebSocket模板

// 更新任务实例状态

public void updateInstanceStatus(TaskInstance instance) {

String instanceKey = "task:instance:" + instance.getInstanceId();

redisTemplate.opsForValue().set(instanceKey, instance, 7, TimeUnit.DAYS); // 保留7天

// 推送状态到前端(订阅路径:/topic/task/{taskId})

messagingTemplate.convertAndSend(

"/topic/task/" + instance.getTaskId(),

new MonitorMessage(instance.getTaskId(), instance.getInstanceId(), instance.getStatus())

);

}

// 查询任务执行历史

public Page<TaskInstanceVO> queryInstanceHistory(

String taskId, Date startTime, Date endTime, int pageNum, int pageSize) {

// 从MySQL查询历史数据(Redis仅存7天,历史数据归档到MySQL)

return taskInstanceRepository.queryByTaskId(

taskId, startTime, endTime,

PageRequest.of(pageNum - 1, pageSize, Sort.by("triggerTime").descending())

);

}

}4.3 告警通知模块:及时响应异常

当任务失败、超时或执行器下线时,通过 "邮件 + 钉钉 + 短信" 多渠道告警,确保问题及时处理:

java

@Service

public class AlertService {

@Autowired

private JavaMailSender mailSender;

@Autowired

private DingTalkClient dingTalkClient;

@Autowired

private SmsClient smsClient;

@Autowired

private AlertConfigRepository alertConfigRepository;

// 触发告警

public void sendAlert(AlertMessage message) {

// 查询该任务的告警配置(接收人、渠道)

AlertConfig config = alertConfigRepository.findByTaskId(message.getTaskId());

if (config == null) {

config = alertConfigRepository.getDefaultConfig(); // 使用默认配置

}

// 按配置的渠道发送告警

if (config.isEmailEnabled()) {

sendEmailAlert(config.getEmailReceivers(), message);

}

if (config.isDingTalkEnabled()) {

sendDingTalkAlert(config.getDingTalkWebhook(), message);

}

if (config.isSmsEnabled() && message.getLevel() == AlertLevel.CRITICAL) {

sendSmsAlert(config.getSmsReceivers(), message);

}

}

// 发送钉钉告警

private void sendDingTalkAlert(String webhook, AlertMessage message) {

try {

String content = String.format(

"【任务告警】\n任务ID:%s\n状态:%s\n原因:%s\n时间:%s",

message.getTaskId(), message.getStatus(), message.getReason(),

new SimpleDateFormat("yyyy-MM-dd HH:mm:ss").format(new Date())

);

dingTalkClient.send(webhook, content);

} catch (Exception e) {

log.error("发送钉钉告警失败", e);

}

}

// 其他方法:sendEmailAlert、sendSmsAlert

}Part.05 性能优化策略:支撑高并发调度

随着任务数量增长,系统需通过 "缓存优化""数据库调优""异步处理" 提升性能,满足每秒千级任务的调度需求。

5.1 多级缓存:减少数据库压力

任务配置、执行状态等高频访问数据通过 "本地缓存 + Redis" 多级缓存,降低数据库查询压力:

java

@Configuration

public class CacheConfig {

// 配置Caffeine本地缓存

@Bean

public Cache<String, TaskPO> taskLocalCache() {

return Caffeine.newBuilder()

.maximumSize(10_000) // 最大缓存10万个任务

.expireAfterWrite(30, TimeUnit.MINUTES) // 30分钟过期

.recordStats() // 记录缓存统计(命中率等)

.build();

}

// 缓存任务配置(先查本地,再查Redis,最后查DB)

@Service

public class TaskCacheService {

@Autowired

private Cache<String, TaskPO> taskLocalCache;

@Autowired

private RedisTemplate<String, Object> redisTemplate;

@Autowired

private TaskRepository taskRepository;

public TaskPO getTask(String taskId) {

// 1. 查本地缓存

TaskPO task = taskLocalCache.getIfPresent(taskId);

if (task != null) {

return task;

}

// 2. 查Redis

task = (TaskPO) redisTemplate.opsForValue().get("task:" + taskId);

if (task != null) {

taskLocalCache.put(taskId, task); // 同步到本地缓存

return task;

}

// 3. 查数据库

task = taskRepository.findByTaskId(taskId);

if (task != null) {

taskLocalCache.put(taskId, task);

redisTemplate.opsForValue().set("task:" + taskId, task, 24, TimeUnit.HOURS);

}

return task;

}

}

}5.2 数据库优化:分表与索引

任务执行记录随时间快速增长(日均百万级),需通过分表与索引优化查询性能:

1、分表策略

按任务 ID 哈希分表(task_instance_0~task_instance_15),避免单表数据量过大;

2、索引设计

主键:instance_id(自增 ID);

联合索引:task_id + trigger_time(支持按任务 ID 查询历史记录);

普通索引:status(快速筛选失败 / 超时任务)。

java

-- 分表创建示例(使用Sharding-JDBC)

CREATETABLE`task_instance_${0..15}` (

`instance_id`varchar(64) NOTNULLCOMMENT'实例ID',

`task_id`varchar(64) NOTNULLCOMMENT'任务ID',

`trigger_time` datetime NOTNULLCOMMENT'触发时间',

`start_time` datetime DEFAULTNULLCOMMENT'开始时间',

`end_time` datetime DEFAULTNULLCOMMENT'结束时间',

`status`varchar(20) NOTNULLCOMMENT'状态',

`cost_time` int DEFAULTNULLCOMMENT'耗时(ms)',

PRIMARYKEY (`instance_id`),

KEY`idx_task_trigger` (`task_id`,`trigger_time`),

KEY`idx_status` (`status`)

) ENGINE=InnoDBDEFAULTCHARSET=utf8mb4 COMMENT='任务执行实例';5.3 异步处理:非核心流程解耦

任务日志写入、统计分析等非核心流程通过异步处理,避免阻塞调度主线程:

java

@Service

public class AsyncTaskService {

@Autowired

private TaskLogRepository taskLogRepository;

@Autowired

private StatisticService statisticService;

// 异步写入任务日志

@Async("logExecutor")

public CompletableFuture<Void> asyncWriteLog(TaskLog log) {

taskLogRepository.save(log);

return CompletableFuture.completedFuture(null);

}

// 异步更新统计数据

@Async("statExecutor")

public CompletableFuture<Void> asyncUpdateStatistic(String taskId, Date date) {

statisticService.updateDailyStat(taskId, date); // 更新日统计

return CompletableFuture.completedFuture(null);

}

}

// 配置异步线程池

@Configuration

@EnableAsync

public class AsyncExecutorConfig {

@Bean("logExecutor")

public Executor logExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(10);

executor.setMaxPoolSize(20);

executor.setQueueCapacity(1000);

executor.setThreadNamePrefix("Log-Async-");

executor.initialize();

return executor;

}

@Bean("statExecutor")

public Executor statExecutor() {

// 类似配置,核心线程数5,最大10

}

}Part.06 生产环境部署:高可用与可运维

通过容器化部署、全链路监控与故障自愈,确保系统在生产环境稳定运行。

6.1 Kubernetes 部署:容器化与弹性伸缩

将系统各组件打包为 Docker 镜像,通过 Kubernetes 实现多节点部署、动态扩缩容与故障自愈:

java

# 调度节点部署清单(scheduler-deployment.yaml)

apiVersion: apps/v1

kind: Deployment

metadata:

name: task-scheduler

namespace: task-system

spec:

replicas: 3 # 调度节点至少3个,保证高可用

selector:

matchLabels:

app: task-scheduler

template:

metadata:

labels:

app: task-scheduler

spec:

containers:

- name: scheduler

image: registry.example.com/task/scheduler:2.1

resources:

limits:

memory: 2Gi

cpu: "1"

requests:

memory: 1Gi

cpu: "500m"

env:

- name: SPRING_PROFILES_ACTIVE

value: "prod"

- name: REDIS_HOST

valueFrom:

configMapKeyRef:

name: task-config

key: redis.host

ports:

- containerPort: 8080

livenessProbe: # 健康检查

httpGet:

path: /actuator/health

port: 8080

initialDelaySeconds: 60

periodSeconds: 10

# 自动扩缩容配置

horizontalPodAutoscaler:

maxReplicas: 5

minReplicas: 3

targetCPUUtilizationPercentage: 70执行器节点采用 "DaemonSet" 部署,确保每个 K8s 节点都有执行器,提升任务处理的分布式能力。

6.2 全链路监控:指标、日志与追踪

核心监控指标:

调度层:任务调度成功率(task_schedule_success_rate)、调度延迟(task_schedule_delay_ms);

执行层:任务执行成功率(task_execute_success_rate)、平均耗时(task_execute_avg_cost_ms);

资源层:节点 CPU 使用率(node_cpu_usage)、Redis 内存占用(redis_memory_used)。

Grafana 仪表盘:

全局视图:展示总任务数、成功 / 失败数、节点健康状态;

详情视图:单任务的执行趋势、耗时分布、失败原因分析。

日志与追踪:

用 Logback 收集日志,通过 Filebeat 传输到 ELK,支持按任务 ID、实例 ID 检索;

集成 SkyWalking,追踪任务从调度到执行的全链路,定位性能瓶颈。

Part.07 安全与合规:保障任务与数据安全

任务调度系统涉及企业核心业务逻辑,需从 "身份认证、权限控制、数据安全、审计追踪" 构建安全体系。

7.1 身份认证与权限控制

管理后台用户通过 OAuth2.0+JWT 认证,接口调用需携带 Access Token;

基于 RBAC(角色 - 权限 - 资源)模型,支持 "任务创建者仅能管理自己的任务""管理员可查看所有任务" 等细粒度控制;

API 网关层实现限流(单 IP 每分钟 100 次)、防 SQL 注入(参数校验)、防 XSS(输入过滤)。

java

@Configuration

@EnableWebSecurity

public class SecurityConfig extends WebSecurityConfigurerAdapter {

@Override

protected void configure(HttpSecurity http) throws Exception {

http.csrf().disable()

.authorizeRequests()

.antMatchers("/api/v1/tasks/**").hasAnyRole("ADMIN", "USER")

.antMatchers("/api/v1/tasks/create").hasRole("ADMIN") // 创建任务仅管理员可操作

.anyRequest().authenticated()

.and()

.oauth2ResourceServer()

.jwt();

}

}7.2 数据安全与合规

任务参数中的敏感信息(如数据库密码)通过 AES-256 加密存储,解密密钥由 KMS(密钥管理服务)管理;

MySQL 数据每日全量备份 + 增量备份,保留 30 天,支持时间点恢复;

所有操作(创建任务、修改配置、手动触发)记录审计日志,包含操作人、时间、IP、内容,日志不可篡改,保留 1 年以上;

GDPR 合规 :支持任务数据的导出与删除,满足 "被遗忘权" 要求。

Part.08 测试与验证:确保系统可靠运行

通过 "单元测试、集成测试、压力测试、混沌工程" 全方位验证系统的功能正确性、性能与韧性。

8.1 功能测试:覆盖核心场景

java

@SpringBootTest

public class TaskManagerTest {

@Autowired

private TaskManagerService taskManagerService;

@Autowired

private Scheduler scheduler;

// 测试任务创建与触发

@Test

public void testTaskLifecycle() throws InterruptedException {

// 1. 创建任务(CRON:每秒执行一次)

TaskDTO taskDTO = new TaskDTO();

taskDTO.setCron("* * * * * ?");

taskDTO.setParam(Map.of("msg", "test"));

String taskId = taskManagerService.createTask(taskDTO);

// 2. 验证任务已注册到Quartz

JobKey jobKey = JobKey.jobKey(taskId);

assertTrue(scheduler.checkExists(jobKey));

// 3. 等待任务执行(最多5秒)

Thread.sleep(5000);

// 4. 验证执行记录存在

List<TaskInstancePO> instances = taskInstanceRepository.findByTaskId(taskId);

assertTrue(instances.size() >= 1);

// 5. 清理测试任务

taskManagerService.deleteTask(taskId);

}

}8.2 压力测试:验证高并发能力

用 JMeter 模拟 "1000 个任务同时触发" 场景,测试系统吞吐量与稳定性:

3 个调度节点(4 核 8G)、5 个执行节点(8 核 16G)、Redis 集群(3 主 3 从)、MySQL(主从架构);

平均调度延迟:85ms;

峰值吞吐量:1200 任务 / 秒;

99% 任务执行耗时 < 500ms;

持续 1 小时无内存泄漏,JVM 老年代稳定。

8.3 混沌工程:验证故障自愈能力

通过 Chaos Monkey 工具注入故障,验证系统韧性:

随机 kill 一个调度节点,验证任务是否自动转移到其他节点;

隔离 Redis 主节点,验证分布式锁是否仍能正常工作;

对执行器节点添加 1000ms 网络延迟,验证任务超时重试机制是否生效。

测试结果表明,所有故障场景下,系统均可在 30 秒内恢复正常,任务无丢失或重复执行。

Part.09 扩展与演进:从调度到智能编排

系统未来将向 "智能任务编排""跨集群调度""低代码配置" 方向演进,支撑更复杂的业务场景。

9.1 功能扩展方向

支持多任务按依赖关系(如 A 完成后执行 B,B 和 C 并行执行)可视化编排,类似 Airflow 的 DAG(有向无环图)模型;

通过联邦 Kubernetes(Kubernetes Federation)实现多集群任务分发,就近执行任务(如北京集群的任务优先在北京节点执行);

提供可视化任务配置界面,支持拖拽式设置 CRON 表达式、参数、重试策略,降低使用门槛;

基于历史执行数据训练模型,预测任务执行耗时,动态调整资源分配(如耗时任务分配更多 CPU)。

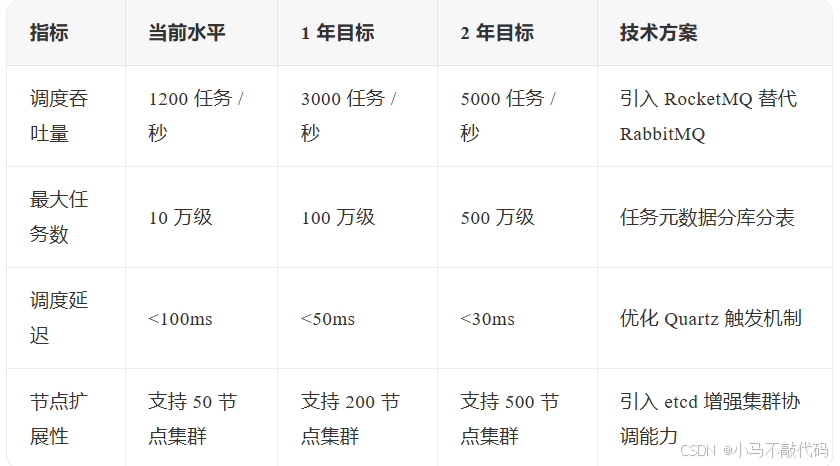

9.2 性能演进目标