立个flag,这是未来一段时间打算做的Python教程,敬请关注。

1 数据及应用领域

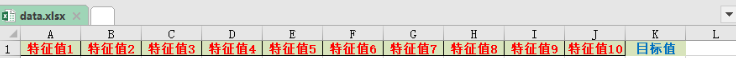

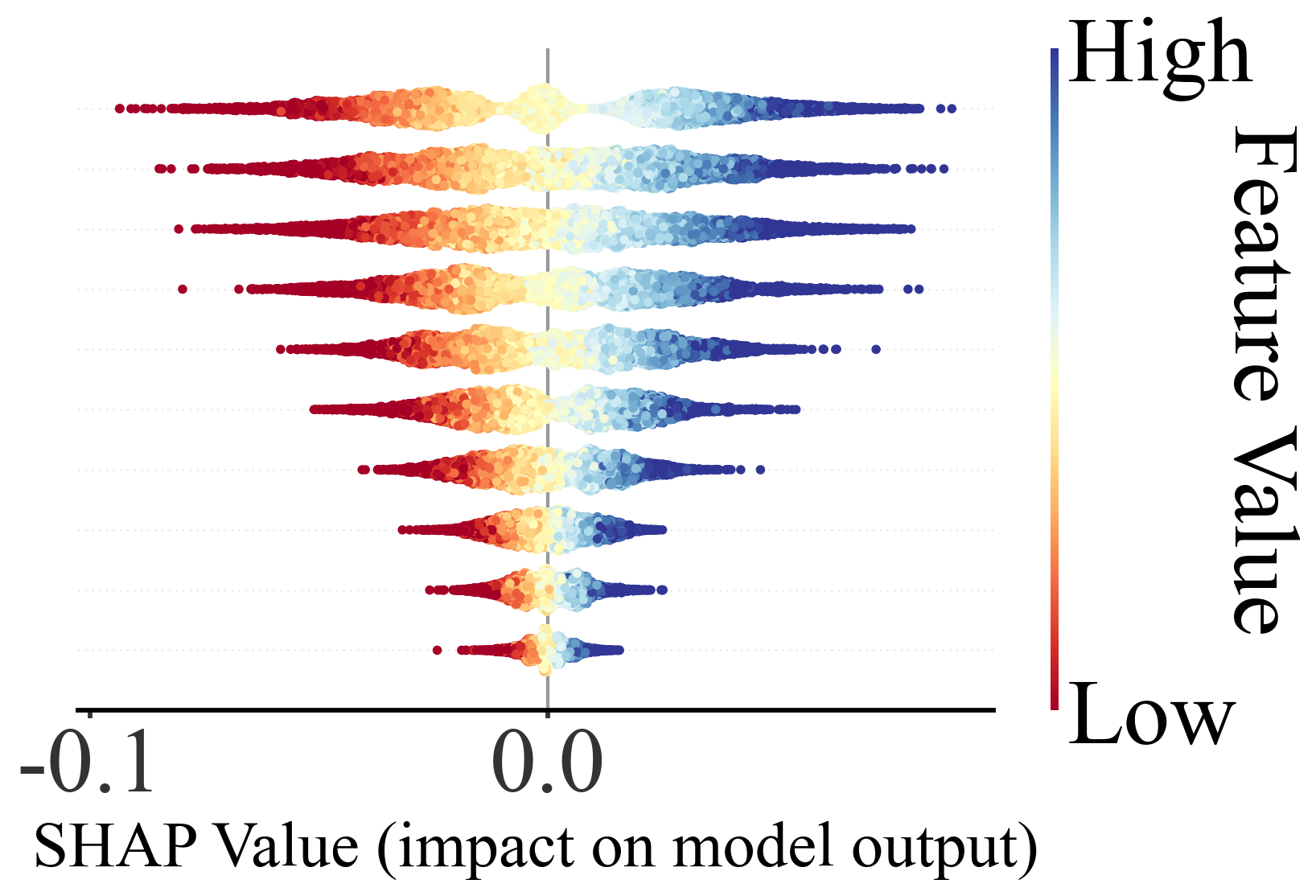

我的程序中给出数据data.xlsx(代码及数据见文末),10 列特征值,1 个目标值,适用于各行各业回归预测算法的需求,其中出图及数据自动保存在当前目录,设置的训练集与预测集的比例为 80%:20%。

一、地球科学与环境科学

-

遥感反演:利用多源遥感数据预测水体深度、土壤湿度、植被指数、叶面积指数等。

-

气象与气候研究:预测降水量、气温、风速、风向等连续气象变量。

-

水文与水资源管理:河流流量、地下水位、径流量预测。

-

环境污染监测:空气质量指数、PM2.5/PM10浓度、重金属污染水平预测。

-

地质与矿业:预测矿区地表沉降、地裂缝发展趋势,或矿产储量评估。

二、生物学与医学**

-

生态学:预测物种分布密度、群落生物量或生态环境因子变化。

-

公共卫生:基于环境、生活方式或基因组数据预测疾病风险或血液生化指标。

-

医学影像分析:预测器官或病灶体积、组织属性、功能指标。

三、工程与物理科学**

-

材料科学:预测材料性能,如强度、硬度、导热性、弹性模量

-

土木与结构工程:预测建筑物或桥梁的应力、位移、寿命周期。

-

控制系统与信号处理:连续控制变量预测、信号功率或系统状态预测。

四、经济与社会科学**

-

经济预测:股价、GDP、通货膨胀率、消费指数预测。

-

市场分析:销售额、客户需求、产品价格预测。

-

社会行为:人口增长、流动性、社会指标预测。

五、数据科学与机器学习方向**

-

时间序列预测:股票价格、气象指标、传感器数据。

-

多变量因果建模:分析各特征对连续目标变量的影响。

-

特征重要性解释:结合SHAP、LIME等方法揭示变量贡献。

2 算法理论基础

🌟 一、LightGBM 的基本思路

LightGBM 属于梯度提升框架,即通过一系列连续的树模型不断迭代、不断修正误差,让最终模型具备强大的表达能力。它的整体逻辑仍然是传统 GBDT 的流程:每一轮都学习上一轮的残差,让模型在不断"纠错"中收敛到更优的预测结果。

与一般树模型相同,它通过寻找特征分裂点来划分样本,并逐步构建一棵棵提升树。每次分裂的目标都是让损失下降得更快,让模型对当前误差更敏感。

🌟 二、LightGBM 做的事情:更快、更省、更大规模

虽然理论框架与 GBDT 一致,但 LightGBM 的重点在于对训练过程进行了大量工程层面的优化,使得它在面对大规模数据、高维特征以及复杂任务时仍能保持高速训练和稳定表现。

LightGBM 的训练方式使得模型在特征较多、样本很多时,仍能快速定位潜在有效的分裂点,并高效构建树结构。训练过程中,它会优先关注信息量大的位置,并避免不必要的扫描,从而让建模过程更加"经济"。

同时,它能最大程度降低数据在存储和计算上的成本,让模型在有限内存和限算力环境下依然能跑得动,这也是它名字里带 "Light" 的原因。

🌟 三、LightGBM 如何在建树时变得"更聪明"?

LightGBM 的树结构构建方式具有高度的适应性,它会尽可能根据当前模型误差的变化,优先分裂最能带来损失下降的区域。这使得模型能够更快地提升性能,即使树的层数不多,也能学习到复杂的规律。

在训练过程中,它不仅关注特征的重要性,还能自动适应数据的稀疏性结构,让模型更容易处理稀疏矩阵、缺失值或高维编码等情况。这让 LightGBM 在文本、遥感、多源特征融合等任务中表现特别出色。

🌟 四、LightGBM 为什么能处理更大的数据?

LightGBM 的设计初衷之一就是"让大数据也能轻松训练树模型"。它在底层对数据结构进行了多层次优化,使得训练过程的内存利用率更高、计算更轻量。无论是百万样本还是上千维特征,LightGBM 都能高效处理,并在多数场景中保持流畅训练。

此外,它在并行化、线程调度、数据读取方式上也进行了深度的系统设计,使模型能充分利用 CPU 或 GPU 的计算资源。对于中大型项目,它往往比传统实现更加稳定和节约时间。

3 SHAP理论基础

🌟 一、SHAP 是什么?一句话概括

"

SHAP 是一套用"合作博弈论"思维解释模型的方法,用来回答:每个特征到底对预测结果贡献了多少?

如果你想知道:

-

哪些特征最重要?

-

每个特征是"推高"还是"压低"预测?

-

不同样本吸收特征影响的方向是否一致?

-

模型是怎么得出这个数的?

那 SHAP 就是最好的答案。

🧠 二、为什么要 SHAP?传统特征重要性有什么问题?

很多人都用过 XGBoost、Random Forest 的 "特征重要性",但这些方法有明显缺陷:

❌ 1. 只能告诉你"重要",不能告诉你"怎么重要"

例如: 某参数重要,但它是推高风速,还是降低风速?不知道。

❌ 2. 不能解释"单一样本"

模型给某一个点预测为 3.2 m/s,到底是由 NDVI 推上去的?还是由降水拉下来的?也不知道。

❌ 3. 依赖模型结构,不通用

不同模型指标不同,难对齐。

SHAP 完美解决了这些痛点。

🎲 三、SHAP 的核心思想:特征是"一起干活的队友"

想象一个团队比赛:

-

每个队员(特征)都可能对团队成绩有贡献

-

但是不同的队伍组合,贡献可能不一样

-

那一个队员的"真实贡献"该怎么算?

SHAP 的思想就是:

"

让特征像"队员"一样参加所有组合队伍,再统计每个特征平均能让模型表现提高多少。

这就得到每个特征的贡献值(Shapley value)。它是一个"公平分配功劳"的方案。

🧩 四、SHAP 优秀的地方在哪里?

✔ 1. 公平性强

SHAP 的分配方式满足一系列"公平原则":

-

谁都没贡献 → 得分为 0

-

特征越能独立提升模型效果 → 得分越大

-

同样作用的特征贡献相同

这是其他方法做不到的。

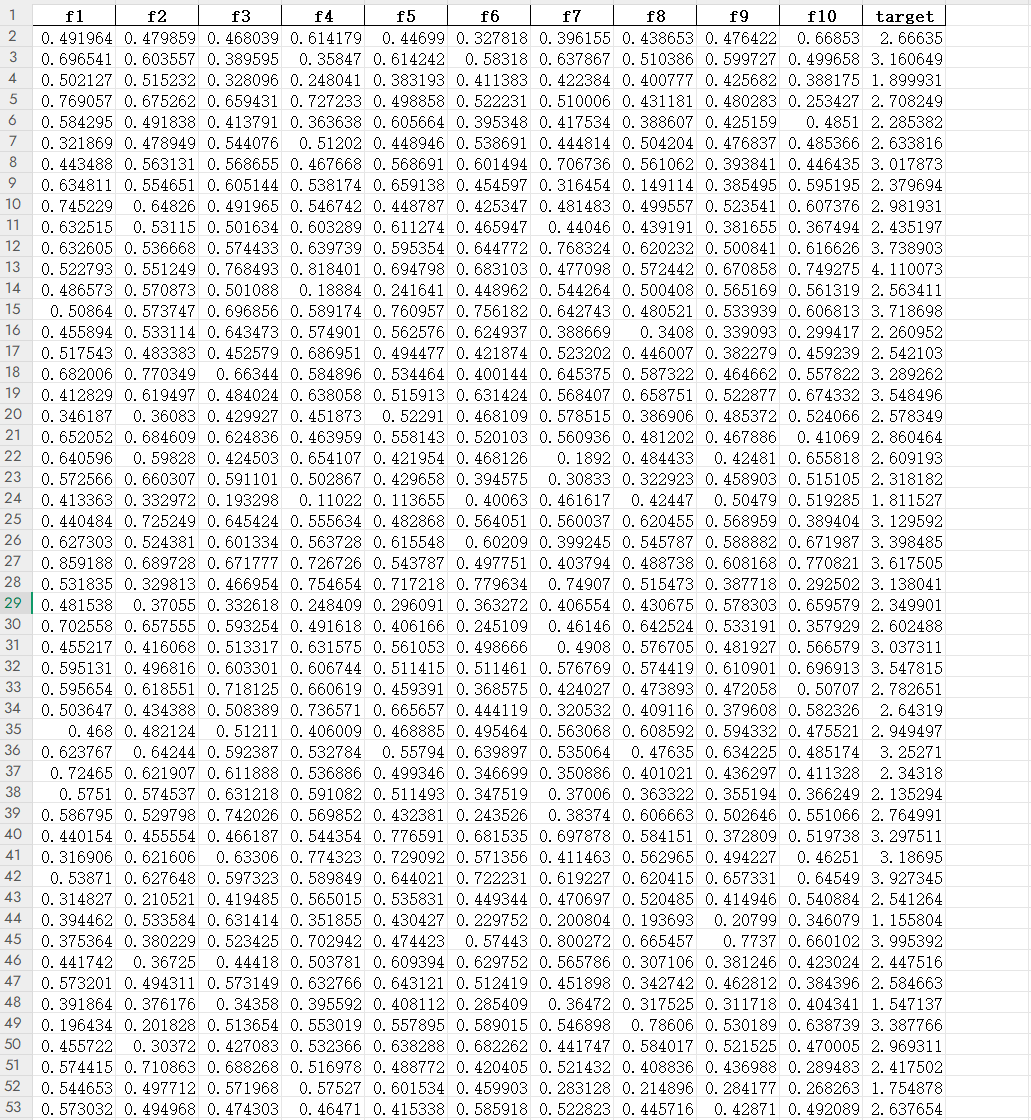

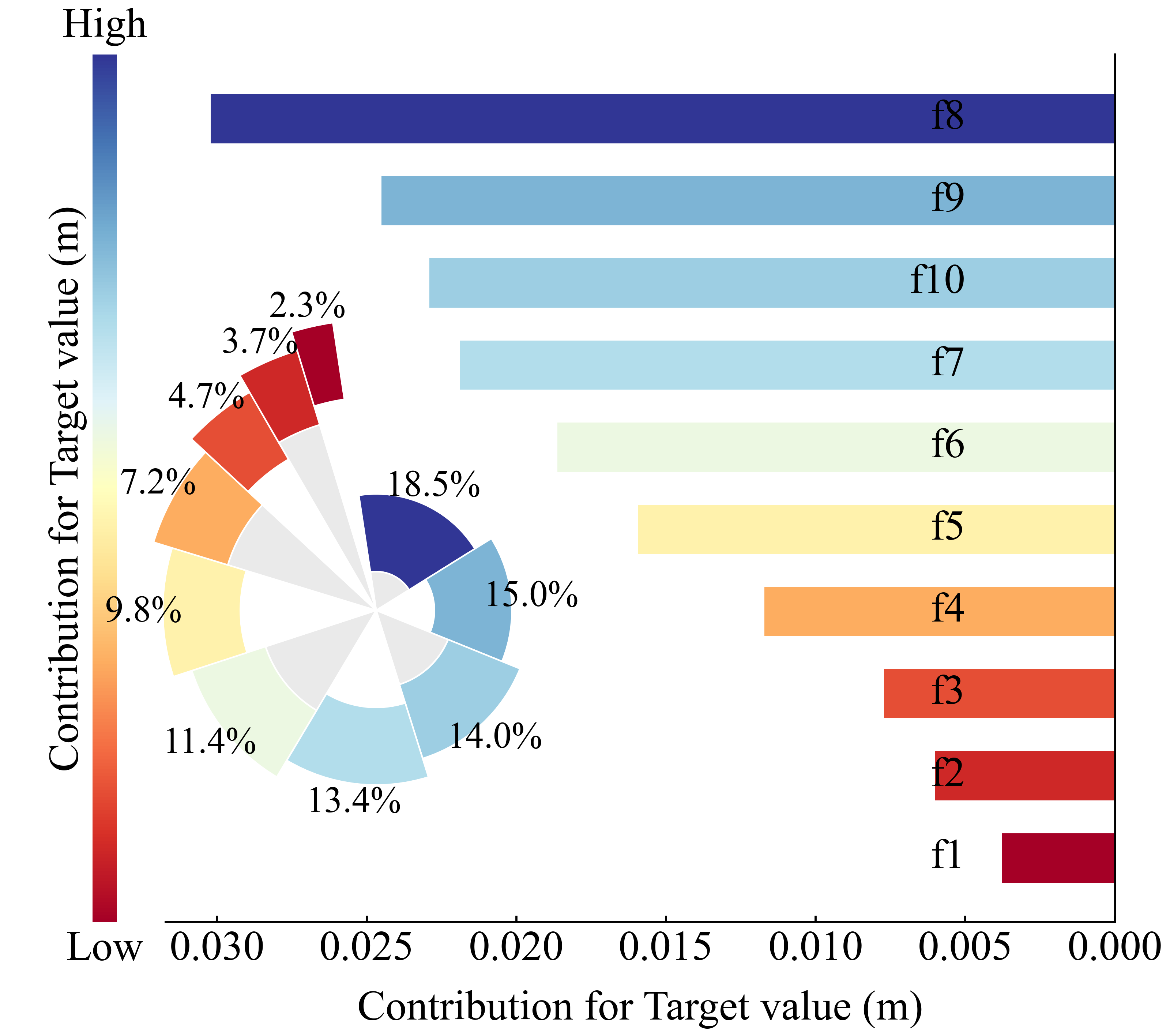

✔ 2. 能画非常直观的可视化

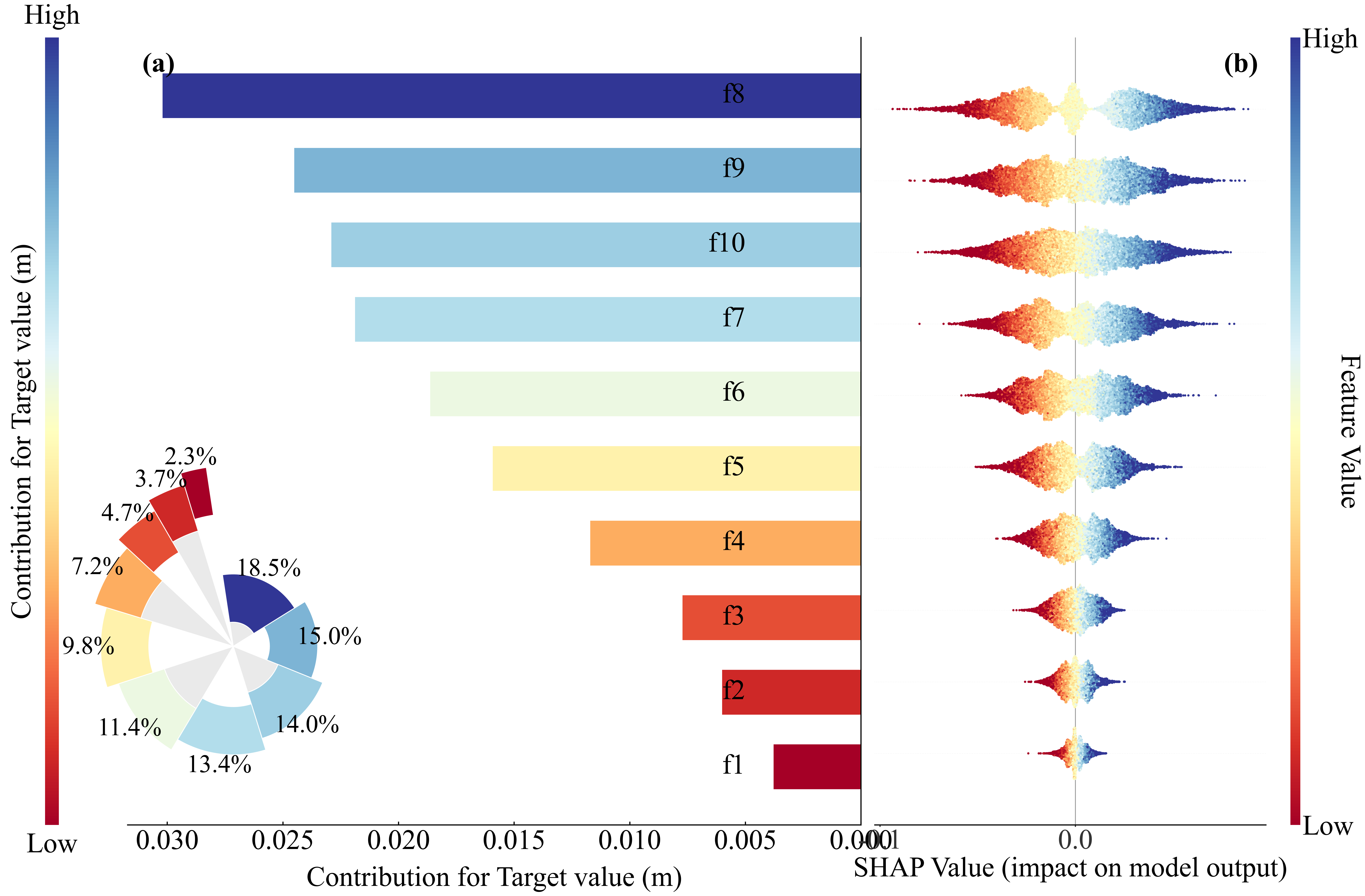

本程序SHAP带的图包括:

这些图都是发论文神器。

论文价值:可解释性直接提升一档

SCI 论文里 reviewer 最爱问:

-

"模型的物理解释是什么?"

-

"为什么这个特征如此重要?"

-

"模型是不是只是黑盒?"

你用 SHAP,一张 beeswarm plot 就能回答所有问题。

✔ 3. 模型无关、模型无偏见

无论你是:

-

XGBoost

-

CatBoost

-

LightGBM

-

Random Forest

-

Gradient Boosting

-

NGBoost

-

决策树

SHAP 都能解释。

4 其他图示

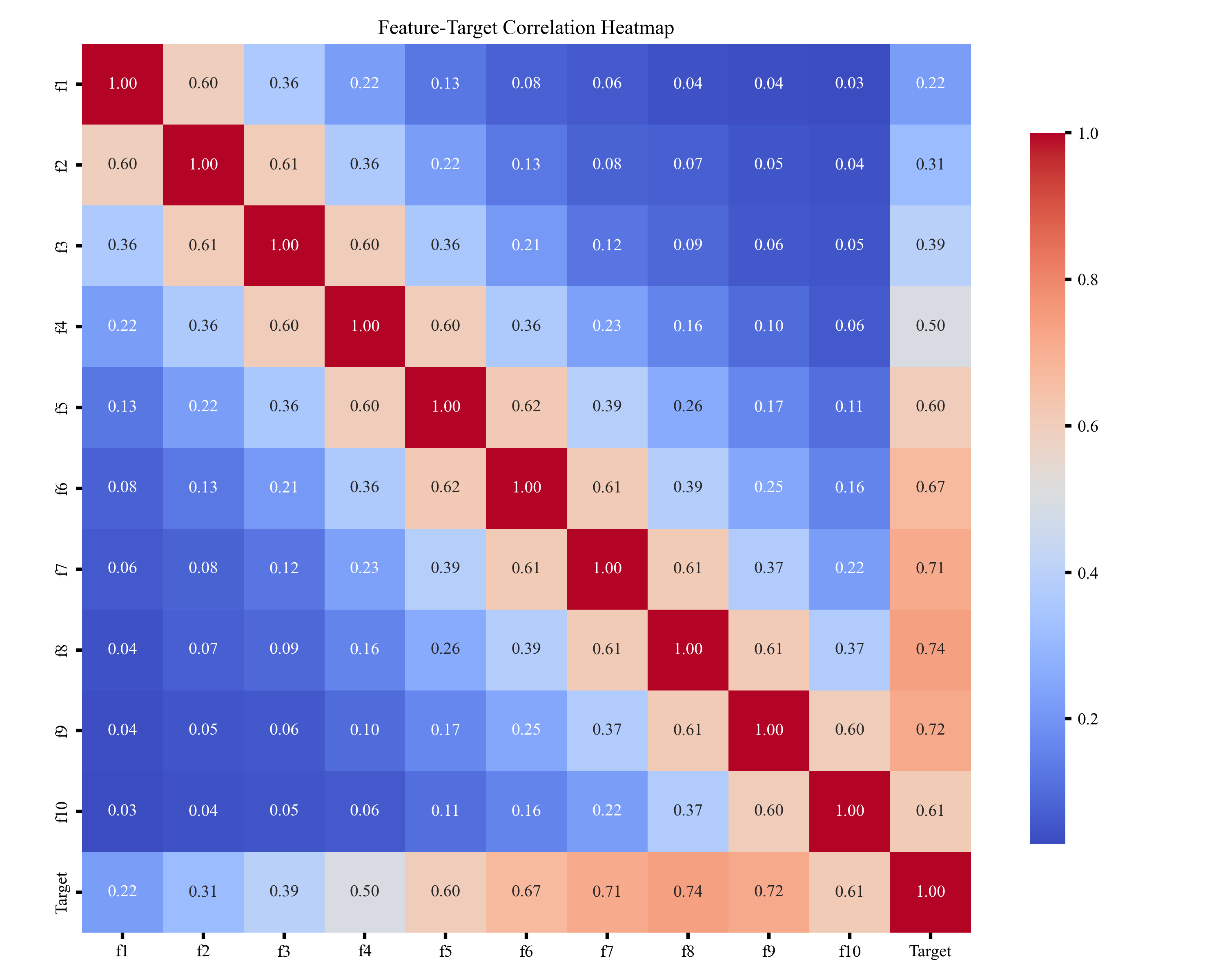

🎲 一、特征值相关性热图

特征值相关性热图用于展示各特征之间的相关强弱,通过颜色深浅体现正负相关关系,帮助快速识别冗余特征、强相关特征及可能影响模型稳定性的变量,为后续特征选择和建模提供参考。

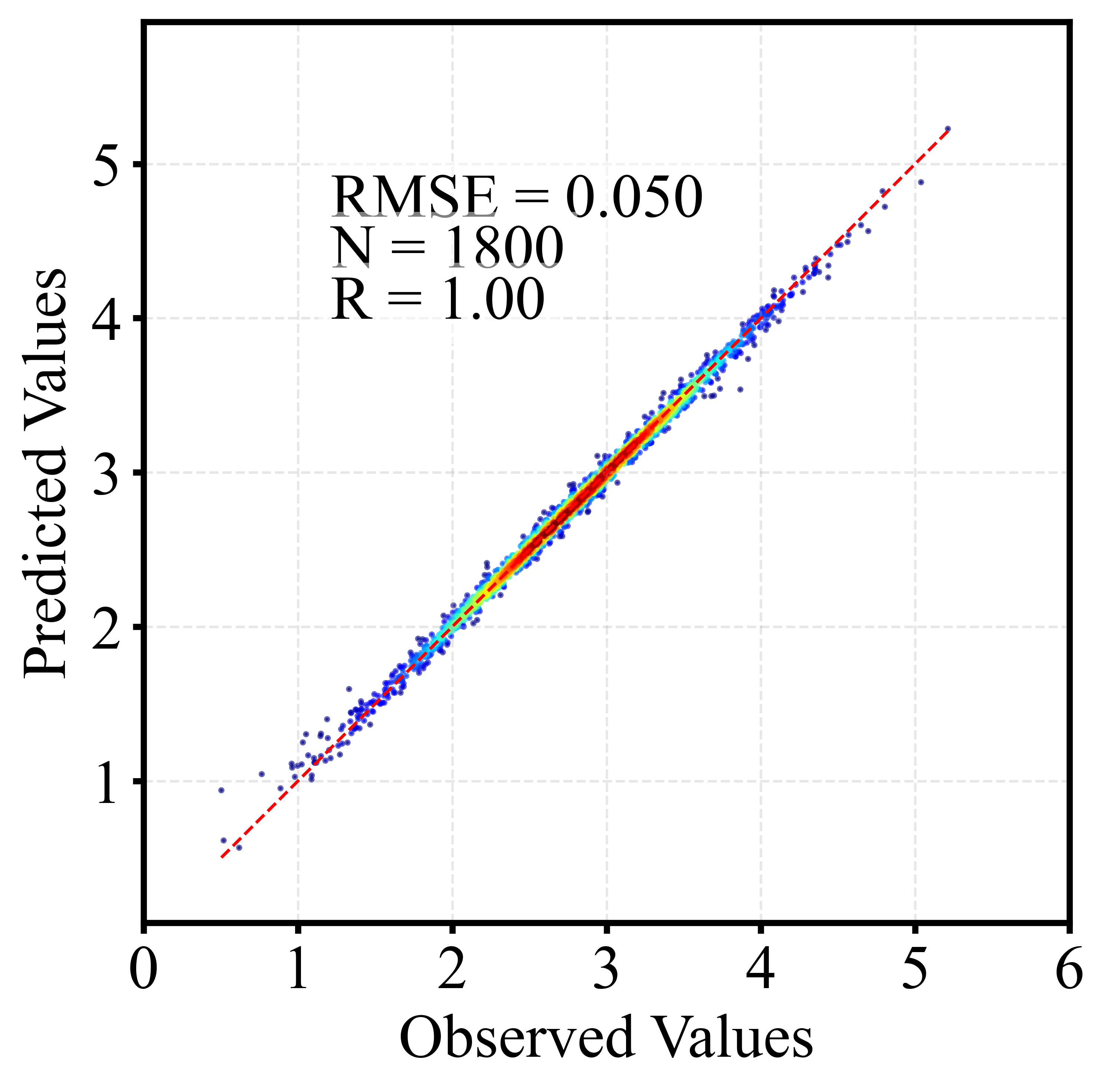

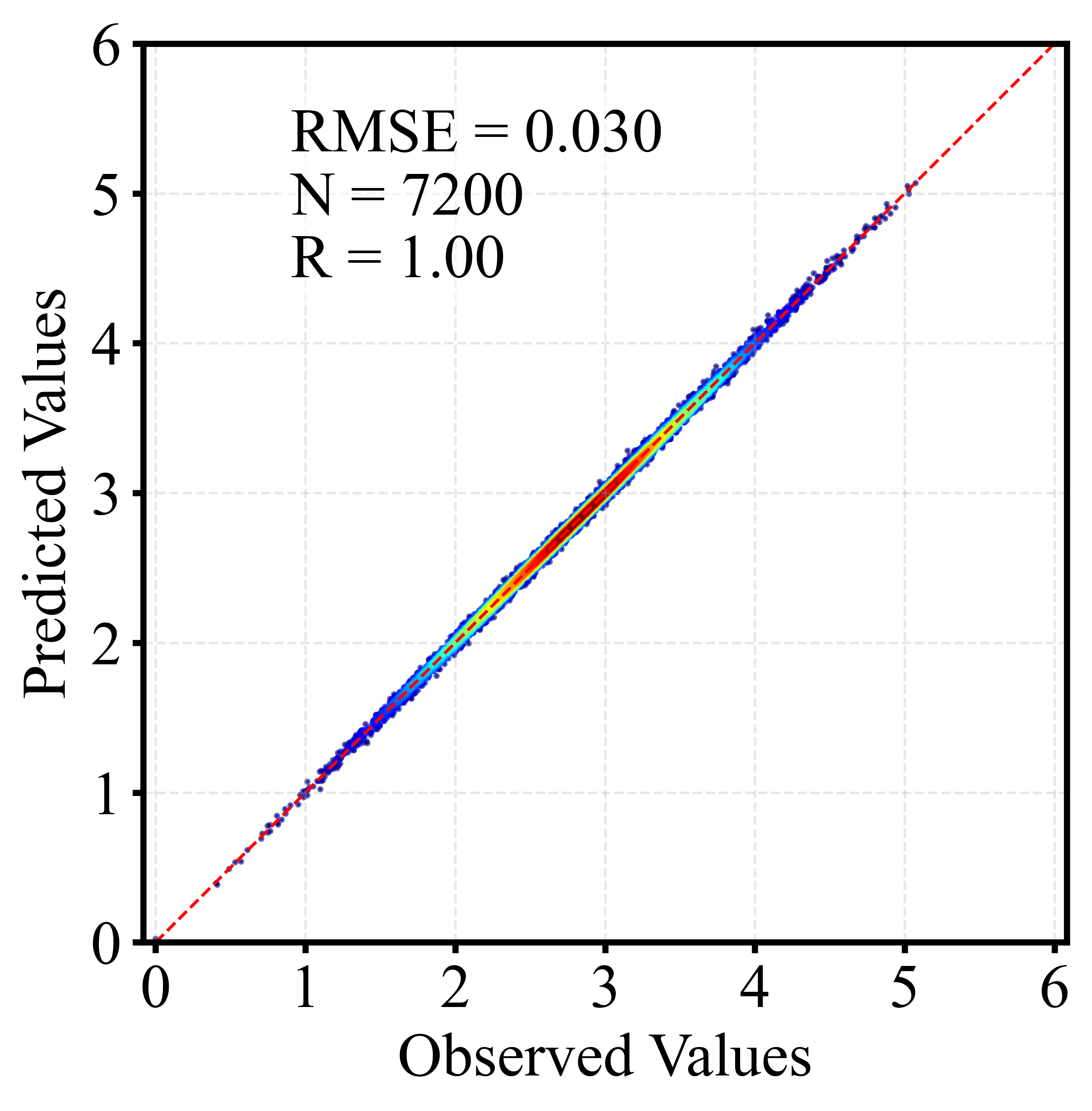

🎲 二、散点密度图

散点密度图通过颜色或亮度反映点的聚集程度,用于展示大量样本的分布特征。相比普通散点图,它能更直观地呈现高密度区域、异常点及整体趋势,常用于回归分析与模型评估。以下为训练集和测试集出图效果。

5 代码包含具体内容一览

并将训练集和测试集的精度评估指标保存到 metrics. Mat 矩阵中。共两行,第一行代表训练集的,第二行代表测试集的;共 7 个精度评估指标,分别代表 R, R2, ME, MAE, MAPE, RMSE 以及样本数量。

保存的regression_result.mat数据中分别保存了名字为Y_train、y_pred_train、y_test、y_pred_test的矩阵向量。

同样的针对大家各自的数据训练出的模型结构也保存在model.json中,方便再一次调用。

调用的程序我在程序中注释了,如下

# 加载模型

# model.load_model("model.json") 主程序如下,其中从1-10,每一步都有详细的注释,要获取完整程序,请转下文代码获取

# =========================================================

# 主程序

# =========================================================

def main():

print("=== 1. 读取数据 ===")

data = pd.read_excel("data.xlsx")

X = data.iloc[:, :10].values

y = data.iloc[:, 10].values

feature_names = list(data.columns[:10])

print("=== 2. 划分训练与测试 ===")

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=0.2, random_state=42

)

print("=== 3. 归一化 ===")

scaler_X = MinMaxScaler()

scaler_y = MinMaxScaler()

X_train_norm = scaler_X.fit_transform(X_train)

X_test_norm = scaler_X.transform(X_test)

y_train_norm = scaler_y.fit_transform(y_train.reshape(-1, 1)).ravel()

print("=== 4. 模型训练 ===")

model = train_model(X_train_norm, y_train_norm)

print("=== 5. 预测(反归一化到原始尺度) ===")

y_pred_train_norm = model.predict(X_train_norm)

y_pred_test_norm = model.predict(X_test_norm)

y_pred_train = scaler_y.inverse_transform(

y_pred_train_norm.reshape(-1, 1)

).ravel()

y_pred_test = scaler_y.inverse_transform(

y_pred_test_norm.reshape(-1, 1)

).ravel()

print("=== 6. 模型评估 ===")

metrics_train = evaluate_model(y_train, y_pred_train)

metrics_test = evaluate_model(y_test, y_pred_test)

print("\n训练集评估指标:")

for k, v in metrics_train.items():

print(f" {k}: {v:.4f}" if isinstance(v, float) else f" {k}: {v}")

print("\n测试集评估指标:")

for k, v in metrics_test.items():

print(f" {k}: {v:.4f}" if isinstance(v, float) else f" {k}: {v}")

print("=== 7. 保存结果到 MAT 文件 ===")

result_dict = {

"y_train": y_train.astype(float),

"y_pred_train": y_pred_train.astype(float),

"y_test": y_test.astype(float),

"y_pred_test": y_pred_test.astype(float),

}

savemat("regression_result.mat", result_dict)

print("已保存 regression_result.mat")

# 按指标顺序排列

metrics_matrix = np.array([

[metrics_train['R'], metrics_test['R']],

[metrics_train['R2'], metrics_test['R2']],

[metrics_train['ME'], metrics_test['ME']],

[metrics_train['MAE'], metrics_test['MAE']],

[metrics_train['MAPE'], metrics_test['MAPE']],

[metrics_train['RMSE'], metrics_test['RMSE']],

[metrics_train['样本数'], metrics_test['样本数']]

], dtype=float)

savemat("metrics.mat", {"metrics": metrics_matrix})

print("已保存 metrics.mat(矩阵大小 7×2)")

print("=== 8. SHAP 分析 ===")

X_combined = np.vstack([X_train_norm, X_test_norm])

X_df = pd.DataFrame(X_combined, columns=feature_names)

# shap_results = shap_analysis(model, X_combined, feature_names)

plot_shap_dependence(model, X_combined, feature_names, X_df)

print("=== 9. 密度散点图 ===")

plot_density_scatter(

y_test, y_pred_test, save_path="scatter_density_test.png"

)

plot_density_scatter(

y_train, y_pred_train, save_path="scatter_density_train.png"

)

print("=== 10. 相关性热图 ===")

correlation_heatmap(data, feature_names)

print("=== 完成!===")

if __name__ == "__main__":

main()6 代码获取

Python | LGBM+SHAP可解释性分析回归预测及可视化算法

新手小白/python 初学者请先根据如下链接教程配置环境,只需要根据我的教程即可,不需要安装 Python 及 pycharm 等软件。如有其他问题可加微信沟通。

Anaconda 安装教程(保姆级超详解)【附安装包+环境玩转指南】