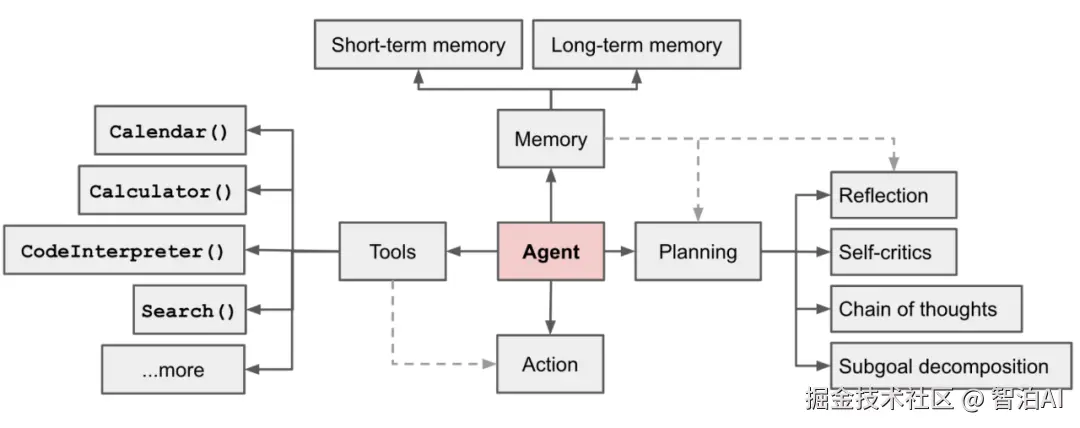

1、Al Agent(智能体)

OpenAl对Al Agent的定义是: 以大语言模型为核心驱动,具备自主感知需求、拆解任务、记忆信息、调用工具能力,能端到端完成复杂目标的智能系统。

如果用现实场景类比,它就像一位"全能虚拟助理"--比如在电商运营中,AlAgent能自动读取用户消费数据、分析需求偏好、生成个性化推荐文案,甚至联动CRM系统发送营销消息,全程无需人工干预,既不会疲劳,也能精准贴合业务目标。

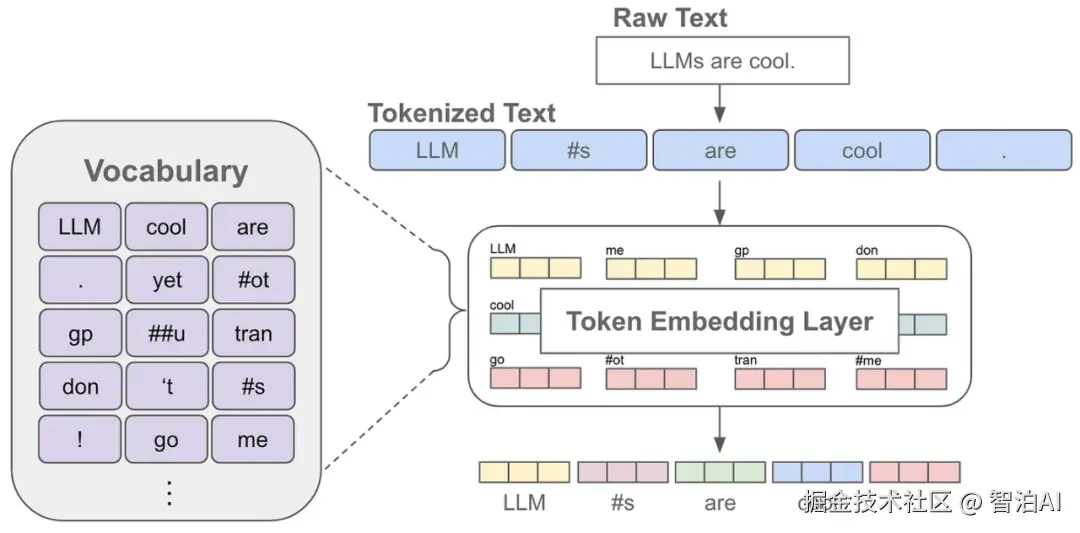

2、Token (tokens)

Token是大语言模型(LLM)处理自然语言的"最小单位",可以理解为AI眼中的"字或词",但并非完全对应人类语言的字词一比如"人工智能"可能被拆成1个Token,而"unbelievable"可能被拆成"un_""believe""-able"3个Token。

对产品经理来说,理解Token的核心价值在于"控制成本与效果"比如调用GPT-4 API时,输入和输出都会消耗Token,且不同模型的Token上限不同(如GPT-4o的上下文窗口为128kToken),这直接影响产品的功能设计(如是否支持超长文档处理)和成本预算。

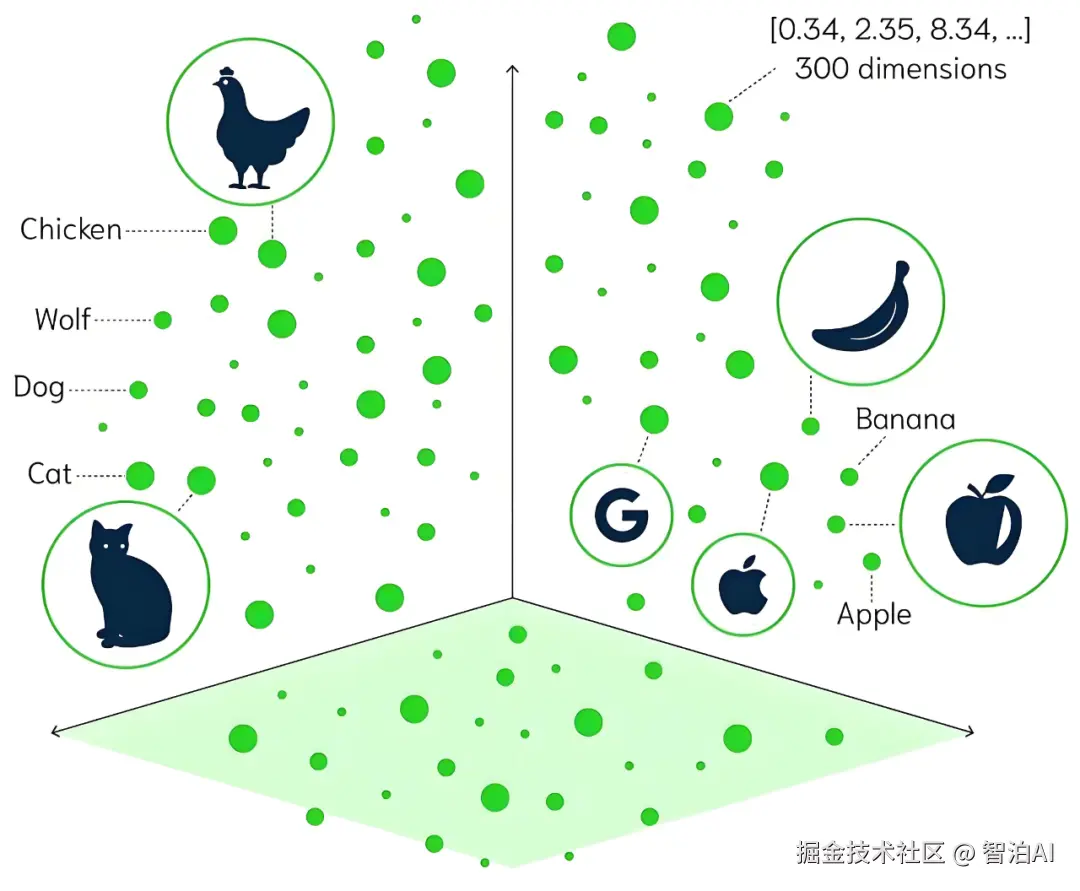

3、嵌入模型(Embedding Model)

嵌入模型的核心作用,是将文本、图片、音频等非结构化数据转化为一串能被计算机理解的"数值向量"(向量维度通常为几百到几千),且向量的"距离"能反映数据的"语义相似度"--比如"猫"和"狗"的向量距离,会比"猫"和"汽车"更近。

在实际产品中,嵌入模型是很多功能的"隐形支柱":比如文档问答产品的"内容检索",就是通过嵌入模型将用户问题和文档内容转化为向量,再快速匹配最相关的片段;电商平台的"相似商品推荐"也是基于商品描述的向量相似度来实现的。

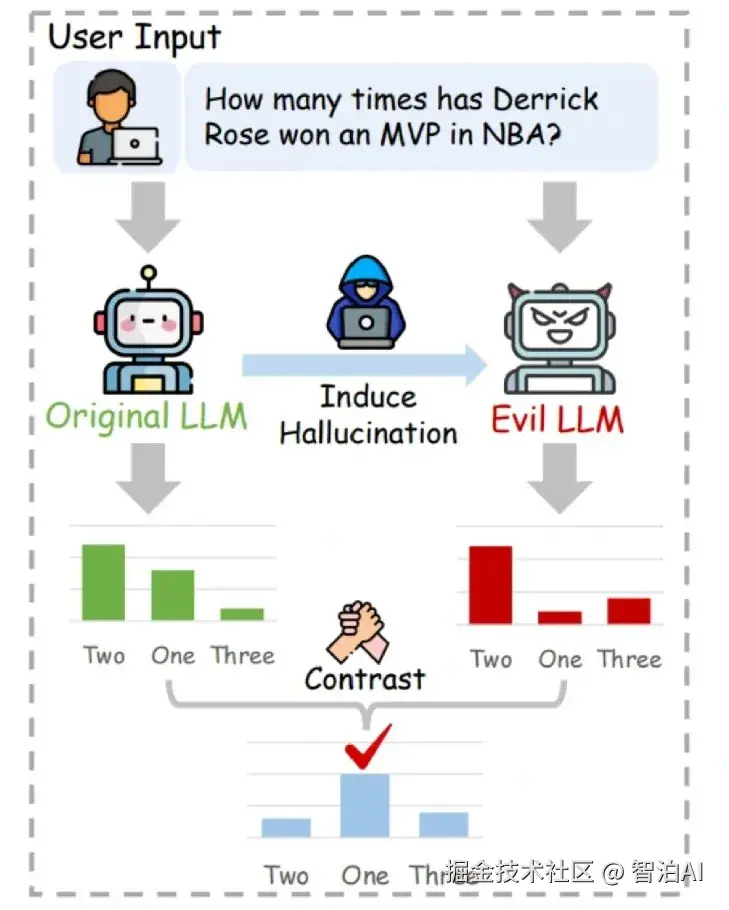

4、大模型幻觉(Hallucination)

大模型幻觉是指AI在生成内容时,自信地输出错误、虚构或不存在的信息(比如编造虚假的文献引用、错误的历史事件),但它并非"故意说谎",而是因为模型在训练中学习的是"语言概率分布"而非"事实真实性"--当遇到知识盲区时,会基于已有模式"合理推测",最终导致输出偏离事实。

对产品经理而言,解决幻觉是AI产品落地的关键:比如在医疗咨询类产品中,需通过"引入权威知识库(如RAG)+输出内容溯源"来降低幻觉风险;在法律文书生成场景中,要增加"人工审核环节",避免因AI幻觉导致法律纠纷。

5、对齐(Alignment)

对齐的核心目标,是让AI系统的行为、目标与人类的价值观、需求保持一致--不仅要让A1"听懂指令",还要"理解指令背后的真实意图",避免出现"机械执行却偏离需求"的情况(比如用户说"帮我找一篇短一点的文章",AI不会故意找一篇超长文章,也不会找内容无关的短文)。

工程师实现对齐的常见手段包括:通过"人类反馈强化学习(RLHF)"让AI学习人类偏好,通过"价值观注入训练"规避有害内容(如暴力、歧视),通过"多轮对话纠错"让AI动态调整行为。

对产品经理来说,对齐程度直接影响用户体验--比如智能客服若无法对齐用户的真实需求,会导致用户反复沟通却无法解决问题。

6、大模型(Large Model)

大模型本质是"参数规模超大的深度学习模型",通常拥有数十亿到数万亿个参数(参数可类比为人类大脑中的"神经元连接")(如全网文本、图片、代码),具备理解、生成、通过学习海量数据推理等复杂能力。

与传统AI模型相比,大模型的核心优势是"泛化能力强""--比如传统模型可能只能做"文本分类",而大模型(如GPT-4、文心一言)既能写文案、做翻译,也能解数学题、生成代码,甚至辅助设计产品方案。

对产品经理而言,大模型的"多能力集成"特性,让"一站式AI产品"成为可能(如集成问答、创作、数据分析的办公助手)。

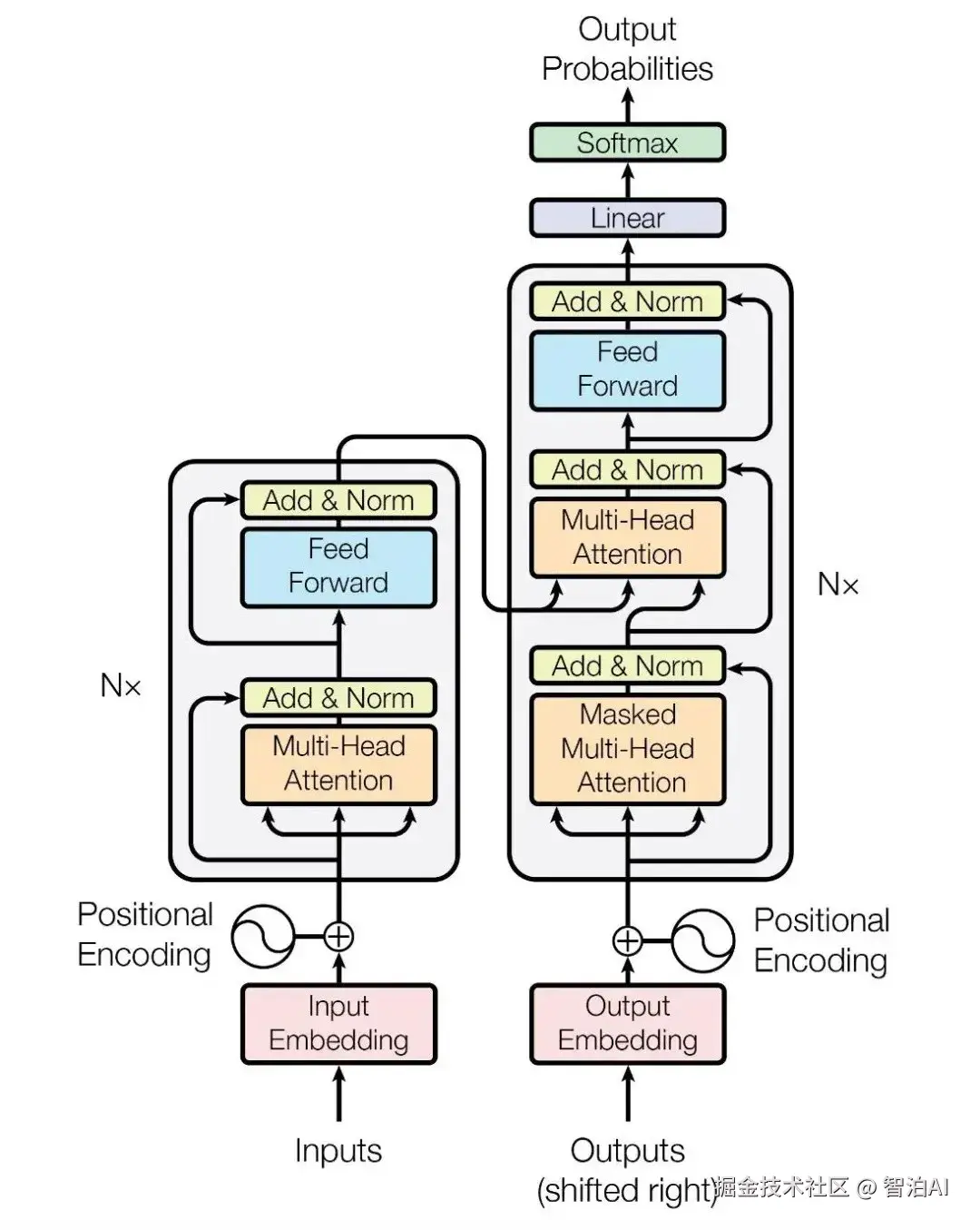

7、Transformer(转换器)

如果把AI模型比作"智能手机",那么Transformer就是"芯片"------它不直接负责"拍照""聊天"等具体功能,而是提供"高效处理信息"的核心能力,是目前主流大模型(如GPT系列、LLaMA系列)的基础架构。

Transformer的核心优势来自"注意力机制(Attention)":它能像人类阅读一样,重点关注文本中"关联性强的部分"(比如读"小明给小红送了一本书"时,会关注"小明""小红""书"的关系)同时支持"并行计算"(比传统架构处理速度快数倍)。

对产品经理来说,基于Transformer的模型意味着"更快的响应速度"和"更精准的语义理解",这是设计AI产品时的重要技术前提。

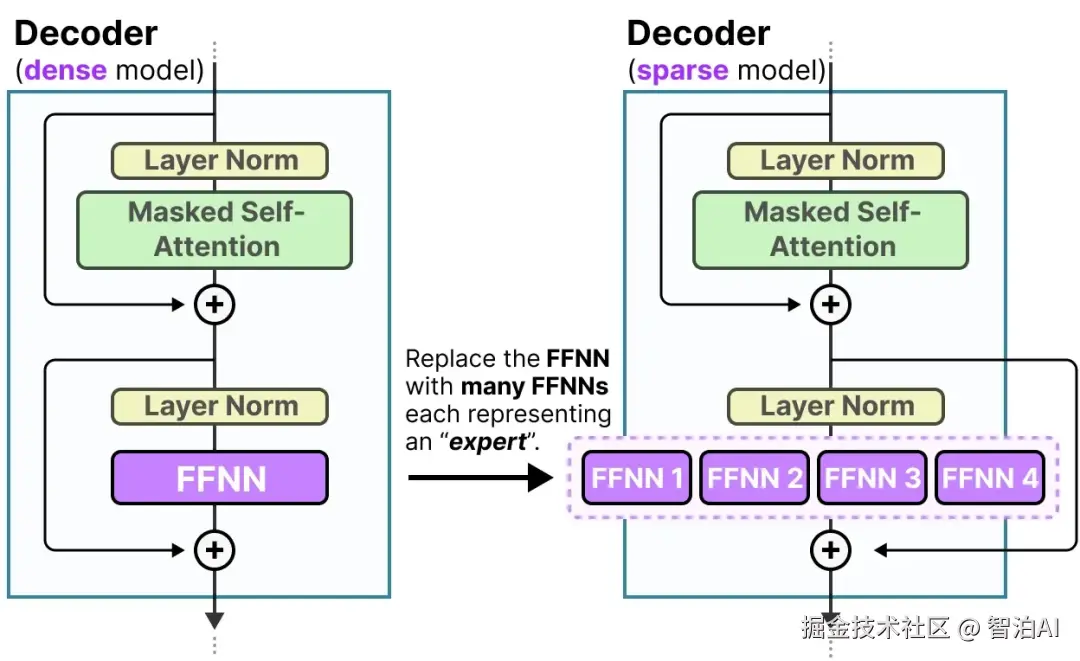

8、MOE(混合专家模型)

MOE(Mixture of Experts,混合专家模型)是一种"分而治之"的模型架构:它将大模型拆分为多个"子模型(专家)"',每个专家专注处理某一类任务或数据(比如有的专家擅长"代码生成",有的擅长"文本翻译",有的擅长"逻辑推理"),再通过一个"门控网络",根据输入内容选择合适的专家组合来完成任务。

MOE的核心价值是"平衡性能与成本":比如要让模型同时支持"代码""文案""数据分析"多种任务,若用单一模型需超大参数规模(成本高),而MOE只需让不同专家各司其职,既能保证任务精度,又能降低计算资源消耗。

目前GPT-4、PaLM 2等模型都采用了MOE架构,是未来大模型"轻量化落地"的重要方向。

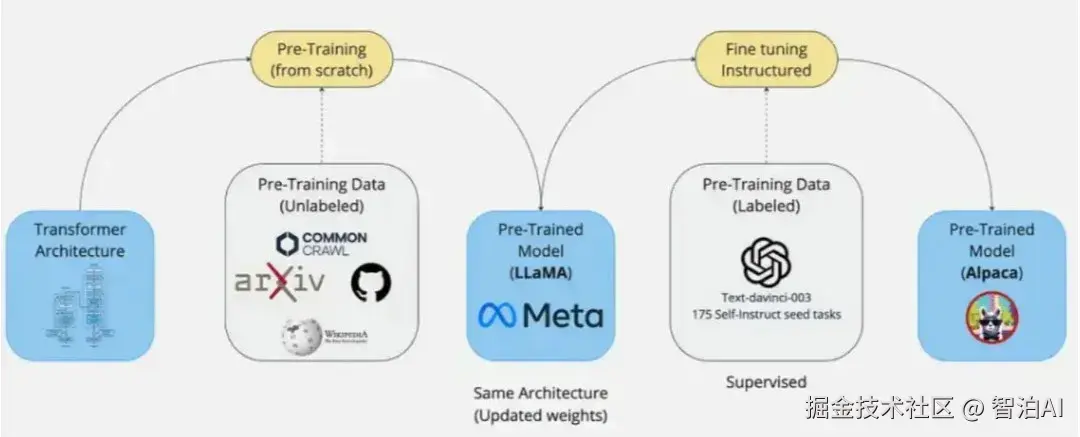

9、预训练(Pre-training)

预训练是大模型的"基础学习阶段":在这个阶段,模型会在海量无标注数据(如全网公开的文本、书籍、代码)上进行训练,目标是学习"通用知识和语言规律"--就像学生在学校学习"语文、数学、英语"等基础学科,不针对某一特定职业,而是构建广博的知识基础。

预训练的核心特点是"无监督/弱监督"(无需人工标注数据类别),训练周期长、资源消耗大(通常需要数千张GPU卡运行数周),但能为模型打下"通用能力"基础。

目前市面上的开源大模型(如LLaMA3、Qwen)大多提供"预训练权重",企业可基于此进行后续优化,大幅降低研发成本。

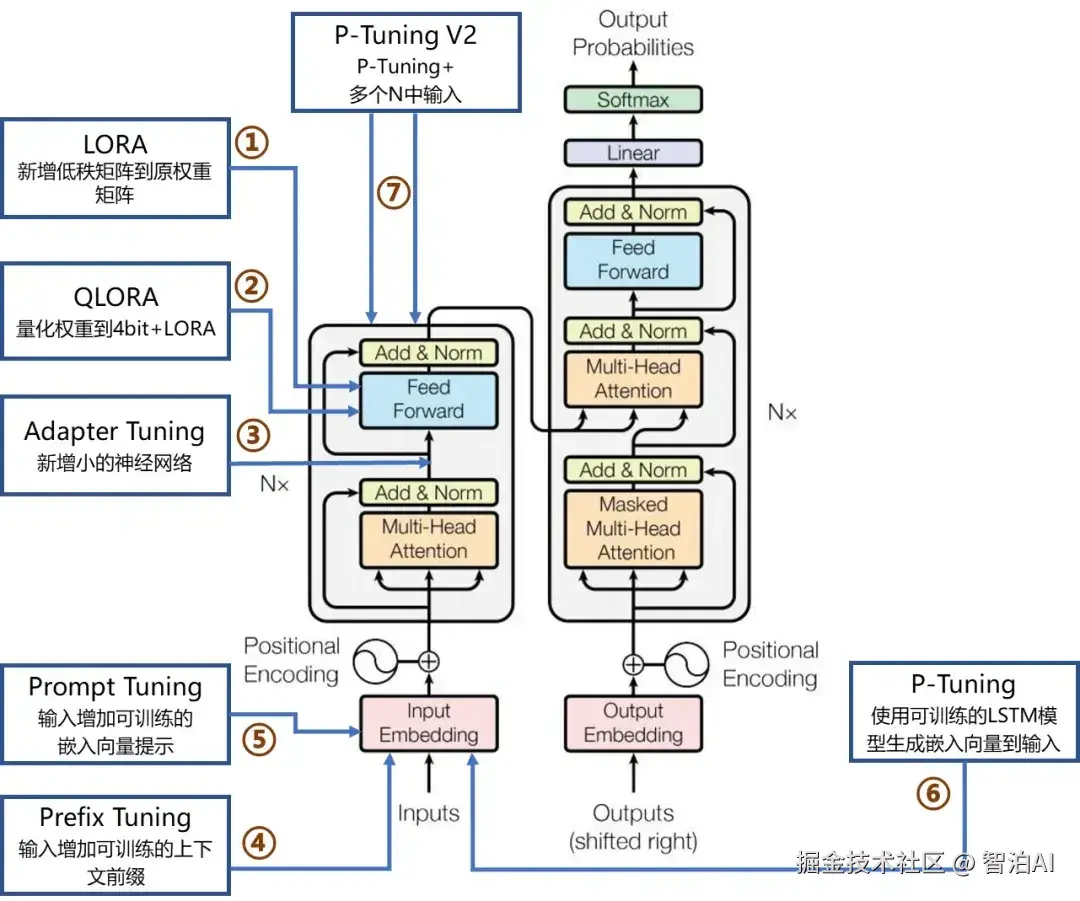

10、微调(Fine-tuning)

微调是在"预训练基础上的定向优化": 通过给预训练模型输入"特定领域的有标注数据"(如医疗领域的病历、法律领域的法条),让模型专注学习某一领域的知识和任务逻辑-一就像学生在大学选择"医学专业",通过针对性学习成为医疗领域的专家。

微调分为"全参数微调"(调整模型所有参数,效果好但成本高)和"高效微调"(如LORA、OLORA,仅调整部分参数,成本低、速度快)。

对产品经理而言,微调是实现"AI产品领域化"的关键:比如要做一款"法律AI助手",就需用法律文书数据微调通用大模型,让其能精准理解法律术语、生成合规文书。

11、提示工程(Prompt Engineering)

提示工程是"通过优化输入给模型的'提示词',让模型生成更符合需求的输出"的技术--简单来说,就是"用更精准的语言'指挥'AI干活"。

比如想让AI写一篇"手机测评文案",若只说"写一篇手机测评",输出可能杂乱无章;但如果提示"以'年轻人性价比之选'为主题,从性能、续航、外观三个维度写手机测评,每部分100字左右,语言活泼",输出会更精准。

提示工程的核心技巧包括:明确任务目标、提供上下文信息、设定输出格式、加入示例(少样本提示)。

对产品经理而言,优秀的提示工程能"在不修改模型的情况下提升产品效果"--比如智能客服产品,通过优化用户问题的"提示词模板",能让AI更快速地定位用户问题,减少无效回复。

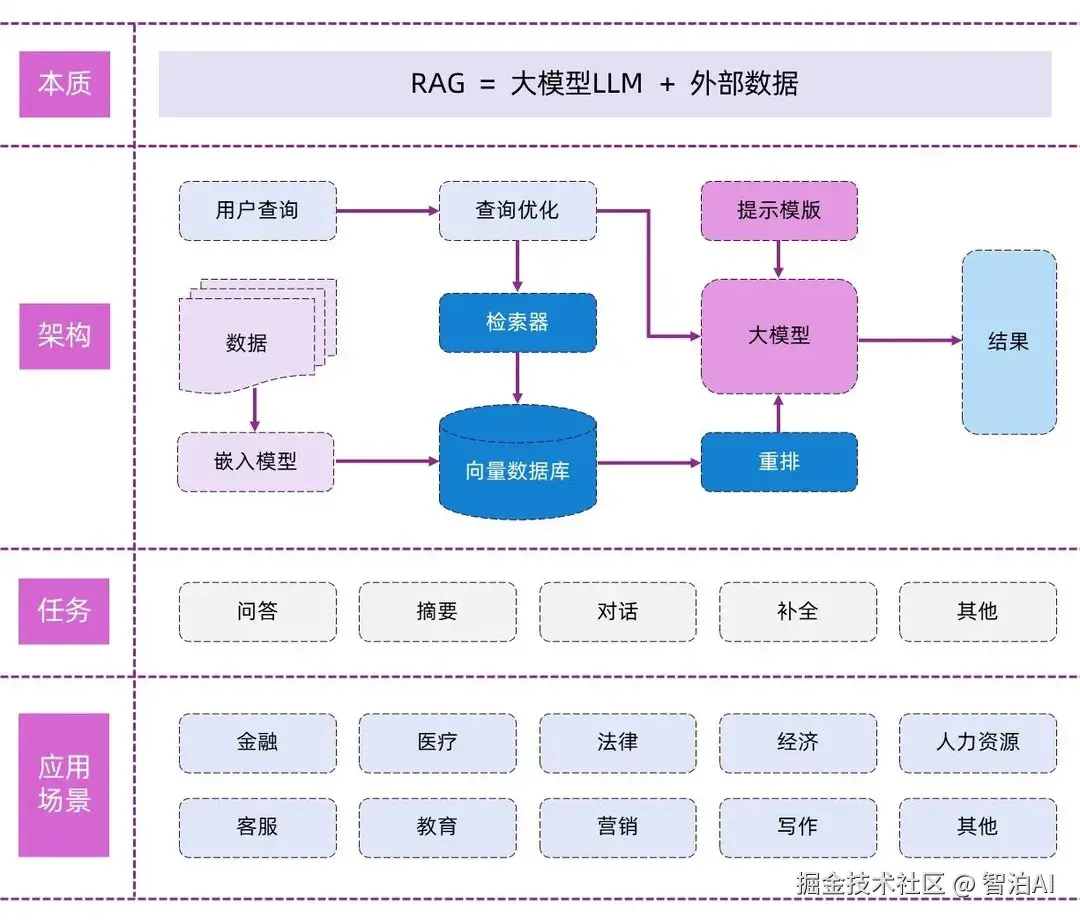

12、RAG(检索增强生成)

RAG(Retrieval-Augmented Generation,检索增强生成)是一种"让AI'先查资料再回答'"的技术: 它的工作流程分为三步:

① 用户提出问题后,系统先从"外部知识库"(如文档库、数据库、网页)中检索与问题相关的信息;

②将检索到的信息与用户问题整合为"上下文+提示词";

③ 让大模型基于这些信息生成回答。

RAG的核心优势是"提升回答的准确性和可溯源性":比如传统大模型回答"某公司2024年营收"时,可能因知识过时生成错误数据,而RAG会先检索该公司2024年的财报,再基于财报内容生成准确回答,且能标注数据来源。

目前RAG已广泛应用于"企业知识库问答""法律文书生成""学术论文辅助写作"等场景。

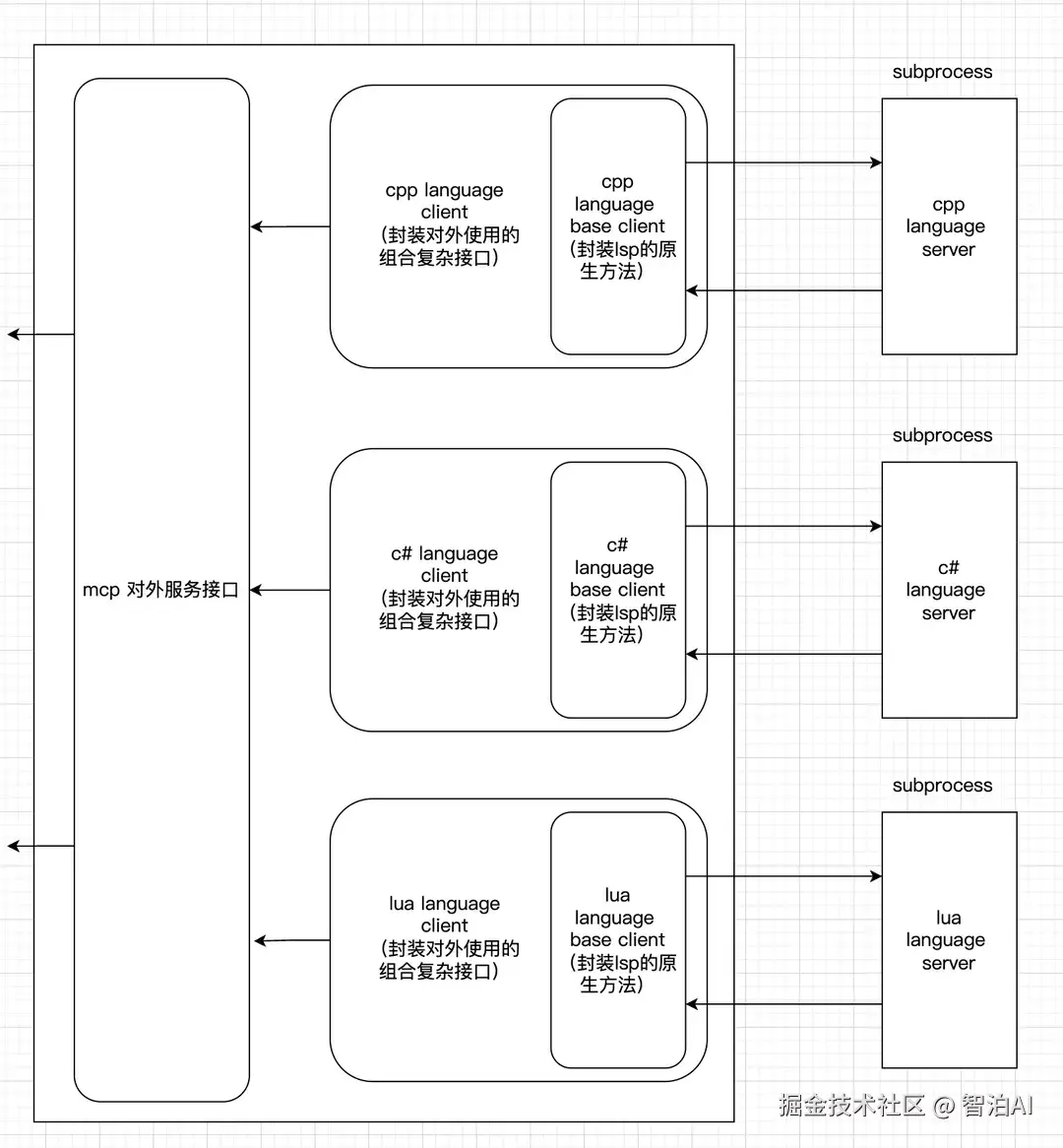

13、MCP(模型上下文协议)

MCP(ModelContextProtocol,模型上下文协议)是Anthropic在2024年11月推出的"开放标准",核心作用是"统一大模型与外部工具、数据源的'通信语言'"。

在此之前,不同工具(如数据库、API、第三方服务)与大模型的交互方式各不相同,开发人员需要为每个工具单独写适配代码。

而MCP通过定义统一的"上下文格式"和"交互规则",让大模型能像"用同一门语言和不同人对话一样,无缝对接数千种外部工具。

MCP对产品经理的价值在于"加速AI产品的'工具集成'能力": 比如想做一款"AI办公助手",需要集成"文档处理、日程管理、邮件发送"等工具,基于MCP标准,无需重复开发适配逻辑,能快速实现工具对接,缩短产品上线周期。

未来MCP有望成为行业通用标准,进一步降低AI产品的开发门槛。

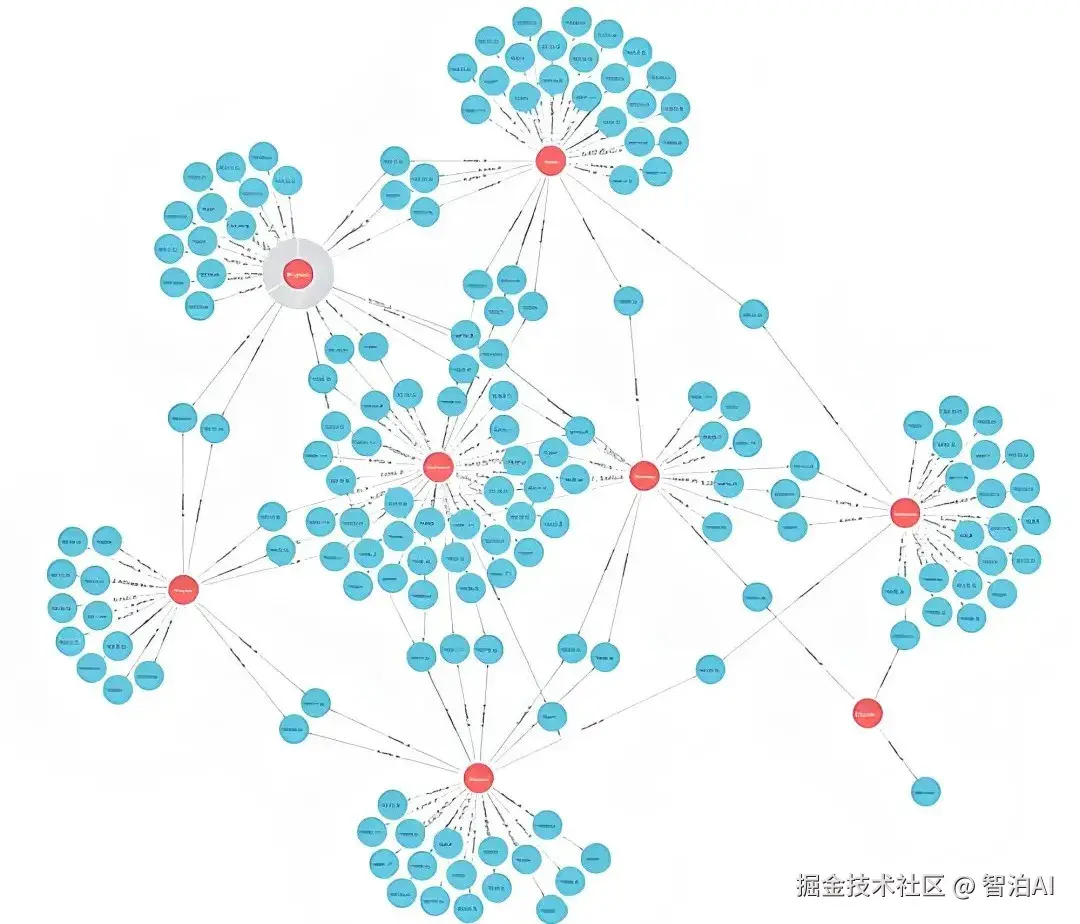

14、知识图谱(Knowledge Graph)

知识图谱是"用图形化方式表示实体、关系和属性的结构化知识库"--它不像传统数据库那样"机械存储数据",而是将知识组织成"节点(实体,如'苹果''乔布斯')+边(关系,如'乔布斯创立了苹果')"的网络,让计算机能清晰理解"事物之间的关联"

知识图谱在AI产品中的应用非常广泛:比如在"智能搜索"中,知识图谱能帮用户快速获取"关联信息"(如搜索"北京"时,不仅显示北京的基本信息,还会关联"故宫""长城"等景点)。

在"金融风控"中,知识图谱能通过分析"企业-法人-关联公司"的关系网络,识别潜在的欺诈风险。

对产品经理而言,知识图谱是提升A1"逻辑推理能力"和"信息组织能力"的关键技术,尤其适合需要"深度关联分析"的场景。

更多AI大模型学习视频及资源,都在智泊AI。