Anthropic 机械可解释性学习路线

机械可解释性(Mechanistic Interpretability, MI)是一个门槛较高的领域,因为它不仅涉及代码,还涉及独特的数学直觉。本计划采用**"自顶向下"(先看效果,再啃原理)** 的策略,帮助你从看热闹的"吃瓜群众"进阶为硬核研究者。

📅 学习路线总览

| 阶段 | 主题 | 核心目标 | 预计耗时 | 难度 |

|---|---|---|---|---|

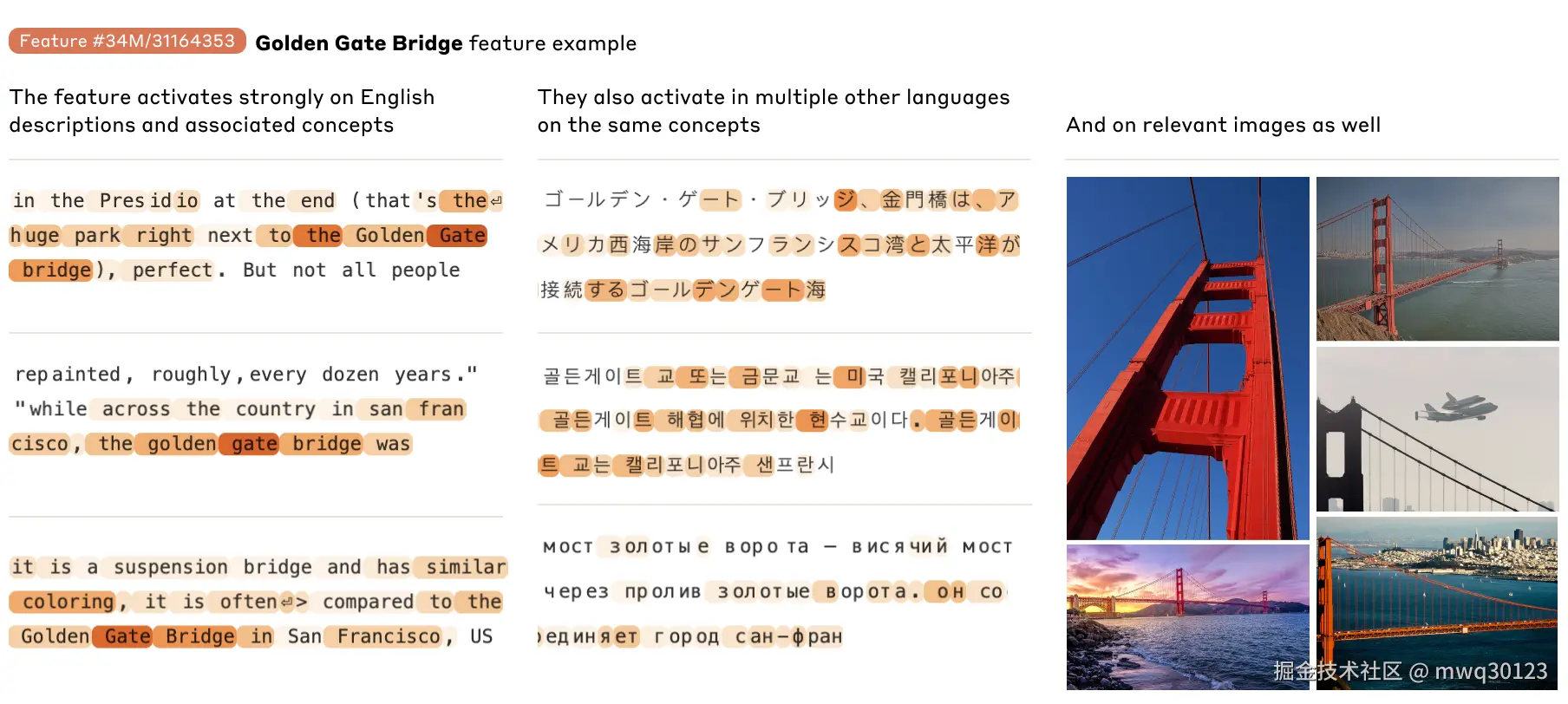

| P1 | 感性认知与宏观图景 | 理解"我们在做什么"以及"金门大桥"实验的震撼。 | 1 周 | ⭐ |

| P2 | 微观基础:电路与注意力 | 理解 Transformer 是如何搬运信息的(归纳头)。 | 2 周 | ⭐⭐⭐ |

| P3 | 核心难点:叠加态与多义性 | 理解为什么模型难以解释(Toy Models)。这是最难的一关。 | 3 周 | ⭐⭐⭐⭐⭐ |

| P4 | 现代解法:SAE 与大模型 | 学习 Anthropic 如何用 SAE 解决上述难题。 | 2 周 | ⭐⭐⭐⭐ |

| P5 | 实战演练 | 动手写代码,解剖小模型。 | 持续进行 | ⭐⭐⭐⭐ |

🚀 第一阶段:感性认知(The "Hook")

目标: 不看公式,先看疗效。建立对"特征提取"和"模型控制"的直观理解。

-

阅读材料(中文优先):

- 必读: 机器之心或类似媒体关于《Anthropic 破解 Claude 3 大脑》的通俗解读。搜索关键词:"Claude 3 金门大桥 特征 解释性"。

- 辅助: 逛逛知乎上的相关讨论,搜索"机械可解释性"话题,看看大家对这个领域的评价和争议。

-

核心思考题:

- 什么是"黑盒"?

- 如果我们能找到"欺骗"特征,对 AI 安全意味着什么?

-

产出: 能用大白话向朋友解释清楚 Anthropic 对 Claude 3 做了什么(即:把混乱的神经元解离成了清晰的概念)。

🔬 第二阶段:微观基础(Circuits & Induction Heads)

目标: 深入 Transformer 内部。不要把模型看作矩阵乘法,要把它看作信息的搬运工。

-

核心论文:

- A Mathematical Framework for Transformer Circuits (2021)

-

学习路径:

-

先看视频(英文+中文字幕): B 站搜索 Neel Nanda 的 "A Whirlwind Tour of Mechanistic Interpretability" 。这是最好的入门课。

-

概念攻克: 重点理解 "归纳头"(Induction Heads) 。

- 它是如何让模型学会"复制粘贴"的?(例如:看到

[Harry] [Potter] ... [Harry]预测出[Potter])。 - 这是大模型"上下文学习"(In-context Learning)的机械原理。

- 它是如何让模型学会"复制粘贴"的?(例如:看到

-

-

中文辅助:

- 在知乎搜索"Induction Heads 详解"或"Transformer Circuits 翻译"。配合原文看图表。

🧠 第三阶段:核心难点(Superposition)

目标: 面对最大的拦路虎------叠加态(Superposition) 。这是这一学派的理论皇冠。

-

核心论文:

- Toy Models of Superposition (2022)

-

为什么难?

- 它解释了数学上的反直觉现象:为什么 5 个神经元可以无损地存储 100 个概念?(利用高维空间的正交/近正交性)。

-

学习方法:

-

不要只读文字! 这篇论文的精髓在于交互式图表 。去 Transformer Circuits 官网 拖动那些滑块。

-

关键概念:

- Polysemanticity(多义性): 一个神经元干多件事。

- Interference(干扰): 概念之间会打架,模型如何处理?

-

-

中文辅助:

- 搜索"Toy Models of Superposition 解读"。你需要找那种带有几何图解的文章,理解"特征作为向量方向"的概念。

🛠️ 第四阶段:现代解法(Sparse Autoencoders)

目标: 理解 Anthropic 现在的杀手锏------SAE。这是连接理论与工业级大模型的桥梁。

-

核心论文:

- Towards Monosemanticity (2023) - 小模型验证。

- Scaling Monosemanticity (2024) - Claude 3 实战(金门大桥文)。

-

学习重点:

- SAE 原理: 把它想象成一个"显微镜"。输入是模型中间层混乱的激活值,输出是稀疏的、清晰的特征。

- 字典学习(Dictionary Learning): 这是一个经典的机器学习概念,在这里被"文艺复兴"了。

-

动手玩:

- 访问 Anthropic 发布的 Feature Browser。亲自搜索一下特征(比如搜索 "code" 或 "emotion"),看看激活这个特征的文本长什么样。

💻 第五阶段:实战演练(Hands-on)

目标: 纸上得来终觉浅。用 Python 亲自解剖一个微型模型。

-

工具库:

- TransformerLens (由 Neel Nanda 开发)。它是 MI 领域的"手术刀"。

-

实战教程:

- Neel Nanda 的 Colab 教程: Main Demo.ipynb。

- 任务: 加载一个

gpt2-small,尝试复现"归纳头"的发现过程。

-

社区参与:

- 关注 Alignment Forum (英文) 的最新讨论。

- 如果是学生,可以尝试参加一些 ML Safety 的黑客松。

💡 给中文读者的特别建议

-

克服语言障碍:

-

这个领域的中文资料相对滞后且碎片化。建议强迫自己阅读英文原文,配合翻译插件。

-

术语对照表:

- Mechanistic Interpretability -> 机械可解释性 / 机理可解释性

- Superposition -> 叠加态

- Polysemantic -> 多义的

- Monosemantic -> 单义的

- Sparse Autoencoder (SAE) -> 稀疏自编码器

- Induction Heads -> 归纳头

- Residual Stream -> 残差流 (这是 Transformer 的信息高速公路)

-

-

不要陷入数学细节:

- 初期不要纠结于具体的矩阵推导。先看图,理解数据流向(形状变化),理解特征是如何在不同层之间流动的。

-

心态建设:

- 这是一门"显微镜科学"。你不会像训练大模型那样看到 Loss 曲线下降的快感,你的快乐来自于"哇,我终于知道为什么模型在这个词上输出错了!"的顿悟。