1、该定理是 KAN 的理论基础:任何多元连续函数可分解为一元函数的组合

2、 已有研究(如 SplineCNN)将样条函数用于卷积层,增强网络捕捉非线性特征的能力,尤其适用于几何深度学习(处理非欧数据);

3 架构核心

传统 MLP 在 "节点" 使用固定激活函数,而 KAN 在 "网络边" 使用可学习激活函数(关键创新),实现从 "静态节点函数" 到 "动态边函数" 的转变,模型更灵活。

4

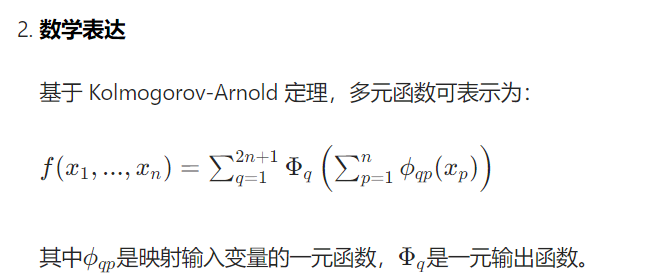

5 定理是 KAN 的理论依据:任何多元连续函数可分解为一元函数的组合;

KAN 基于此定理,将传统 MLP 的 "线性权重矩阵" 替换为 "可学习样条函数",从而减少参数、提升泛化能力。

一、KANConv

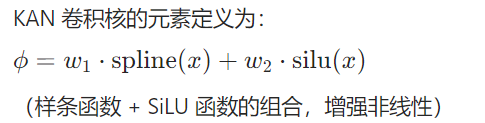

1、将线性权重矩阵替换为,可学习样条函数,降低参数表达能力提升,

2、该定理是 KAN 的理论基础:任何多元连续函数可分解为一元函数的组合

3、核心优势:相比其他架构,KAN 卷积层所需参数显著减少,且能通过 B 样条函数 "平滑表示任意激活函数",这是 ReLU 等固定激活函数无法实现的。

4、Kolmogorov-Arnold 网络(Convolutional KANs),这种架构旨在将 Kolmogorov-Arnold 网络(KANs)的非线性 激活函数 整合到卷积层中,从而替代传统卷积神经网络(CNNs)的线性变换

二、数学表达

三、核心

卷积 KAN 的核心创新是用 "可学习样条函数构成的卷积核" 替代 "固定权重卷积核",既保留了 CNN 的空间特征提取能力,又继承了 KAN"参数少

1、些案例体现了 KAN 卷积的核心优势 ------将复杂的多步骤操作压缩到单次卷积中完成