「【新智元导读】OpenAI,亟需一场翻身仗!今天,全网最大的爆料:GPT-5 基石实为 GPT-4o。自 4o 发布之后,内部预训练屡屡受挫,几乎沦为「弃子」。」

OpenAI 核心预训练,接连翻车?

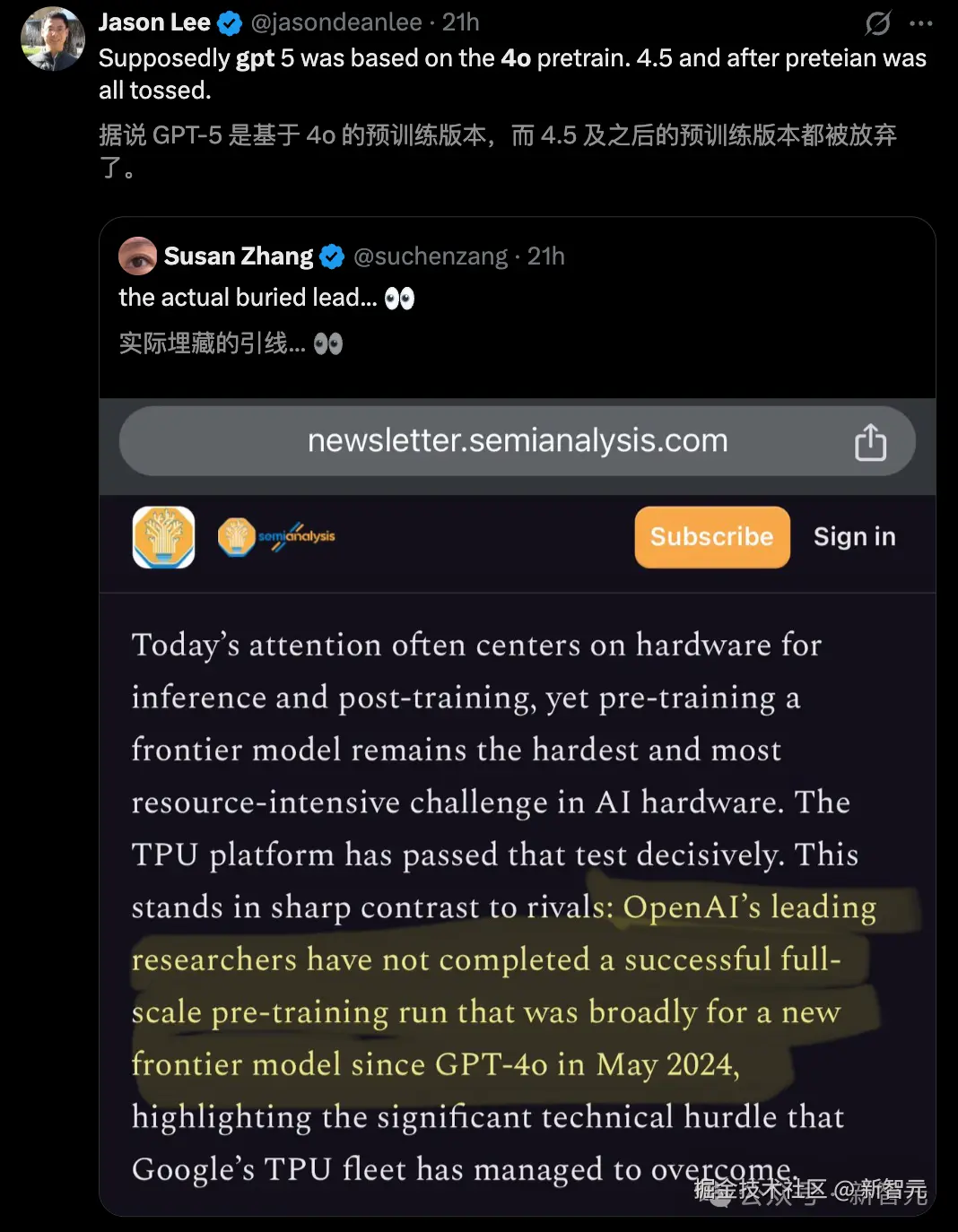

传言称,GPT-5 的基石仍是 GPT-4o,且 GPT-4.5 之后的预训练版本,都被 OpenAI 放弃了!

这么说并非空穴来风,核心爆料恰恰来自权威 SemiAnalysis 的最新一文------

OpenAI 顶尖团队自 GPT-4o 发布之后,迄今尚未完成一次完整的,为下一代前沿模型设计的大规模预训练。

文章中,高级分析师强调:谷歌正手持 TPUv7 这把利剑,向英伟达王座发起冲锋,或将终结 CUDA 护城河。

众所周知,OpenAI 全栈模型是在纯英伟达 GPU 上炼出的。

然而,圈内人的焦点,大都放在了大模型「推理」和「后训练」的硬件之上。

殊不知,没有前沿模型的预训练,一切皆是「无米之炊」。恰恰这一环节,成为了 AI 硬件里最难、最耗资源的一关。

如今,一个不为人知的内幕爆出了:

事实证明,谷歌 TPU 彻底经受住了这一考验;

相较之下,自 2024 年 5 月 GPT-4o 诞生之后,OpenAI 的预训练却毫无进展.....

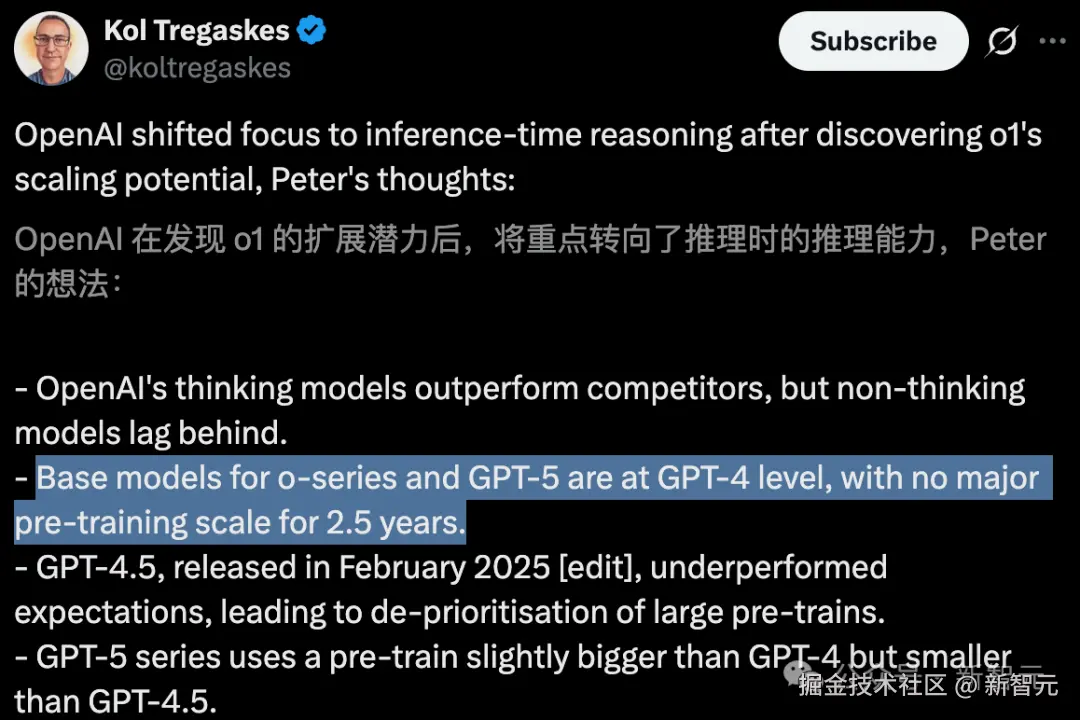

过去,两年半的时间,OpenAI 没有真正 Scaling 预训练的规模。

GPT 的预训练,或许在 GPT-4o 之后触及了天花板,由此也解释了 GPT-5 性能未达业界预期的关键原因。

有网友表示,那不正是 Ilya 离开的时候吗.....

恰在昨天,Ilya 最新发文称,Scaling 不会停,但某个重要的东西仍然会缺失。

「OpenAI 预训练,大溃败」

还记得去年底,那场铺天盖地的「Orion」传闻吗?

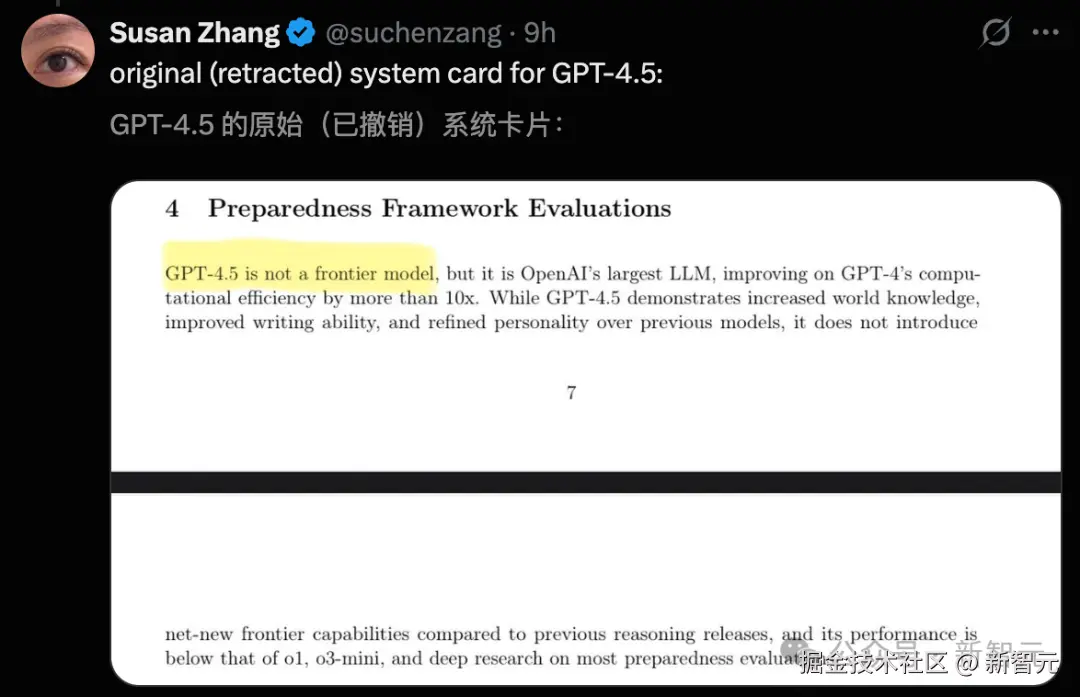

这一秘密项目,原定以 GPT-5 面世,但因训练未达预期,最终被降级为 GPT-4.5 发布。

在前沿模型预训练上,OpenAI 的研发似乎陷入了僵局------

如今第五代旗舰模型 GPT-5,包括最新 GPT-5.1,其「技术根基」本质或仍未突破 GPT-4o 的范畴。

SemiAnalysis 去年底一篇文章,曾对外公开了 Orion 训练的困境。

当前,算法的进步使得模型每年所需的物理计算量减少约三分之一,因此,训练运行时间很少超过 3 个月。

甚至,行业中大多数预训练通常仅需要 1-2 个月。

然而,OpenAI 的 Orion 大规模预训练,却打破了这一常规,其训练时间超过了 3 个月。

另据 Information 同一时间爆出,Orion 不会像前代实现巨大的飞跃,相较于从 GPT-3 到 GPT-4 的迭代,改进幅度要小得多。

不仅如此,Orion 性能提升也基本局限在------语言能力上,其代码能力甚至不如旧模型,且成本更高。

如今再回看 2 月,GPT-4.5 的诞生,基于代号 Orion 的模型,OpenAI 追求的是:

更强的语言能力 + 更稳的对话体验 + 更大知识库

情商,成为了 GPT-4.5 的关键词。代码虽有提升,但并非主菜。

这一切的一切,从侧面印证了,此前外媒关于「Orion 遇挫」爆料的准确性------

「LLM 有提升,但不大。」

「 」

」

「GPT-4o,成 Scaling 主线?」

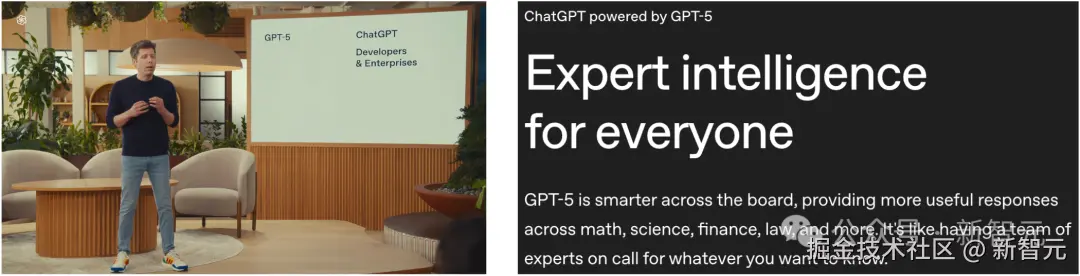

今年 8 月,GPT-5 的那场发布,奥特曼将其定调为「博士级 AI,是通往 AGI 又一里程碑」。

实则,业界对于 GPT-5 的反响,唏嘘一片。

大家原本以为,GPT-5 会是全面超越前代的一次飞跃,但实际发布后,更像是 GPT-4.5 的进一步优化版,不是「颠覆版」。

但至于 GPT-5 真正基于哪一款 GPT 打造,还有待证实。

正如之前传闻的猜测,有可能是 GPT-4o,还有 Reddit 网友称是 GPT-4.1....

但不论是哪一款,都证明了 GPT-5,没有在全新前沿模型的大规模预训练上淬炼。

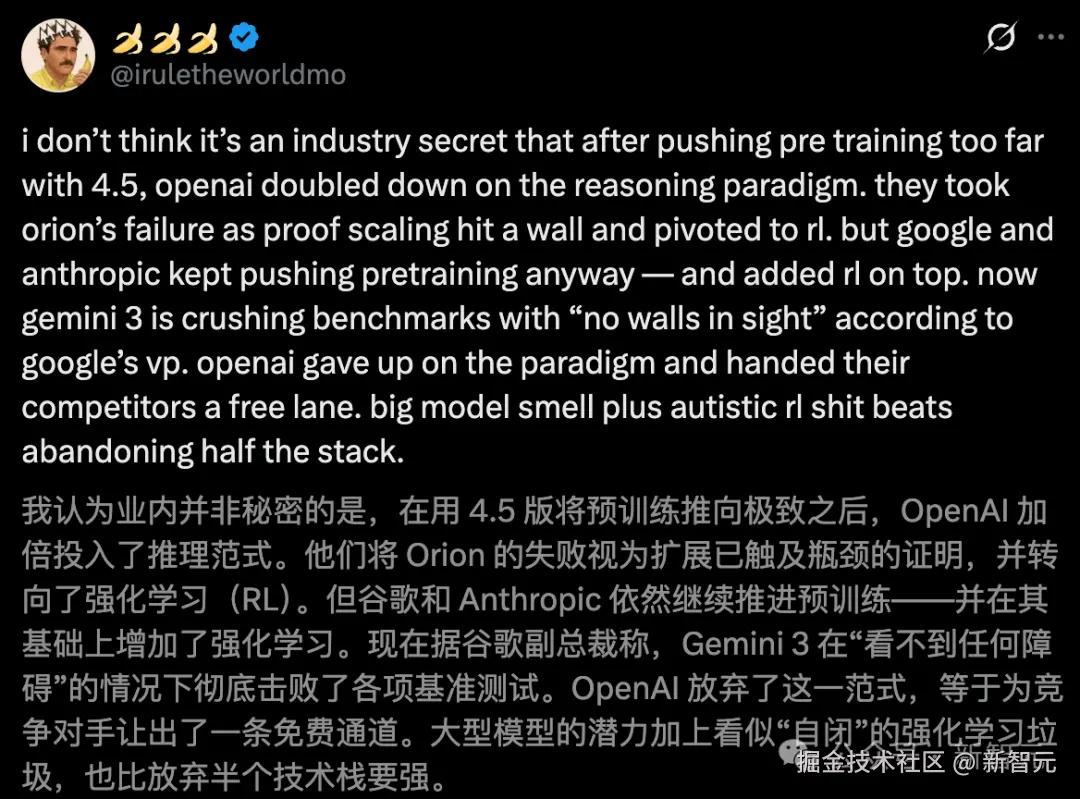

搞笑的,那个曾将 OpenAI 三颗🍓🍓🍓「焊在」名字中的大佬,如今改成了三个🍌🍌🍌。

他表示,这已经不是什么秘密了------

GPT-4.5 将预训练推向极致之后,OpenAI 加倍投入了推理范式,主打 o 系列 + RL。

不同的是,谷歌和 Anthropic 仍在 Scaling 预训练,并增强了强化学习。

OpenAI 主动放弃了这一范式,为劲敌让出了一条速通道。

「奥特曼:这事儿瞒不住了!」

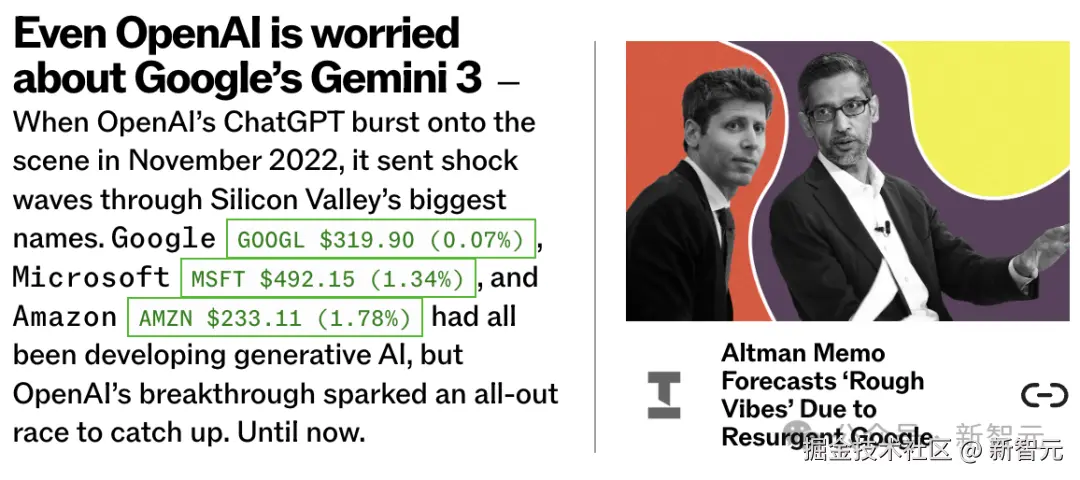

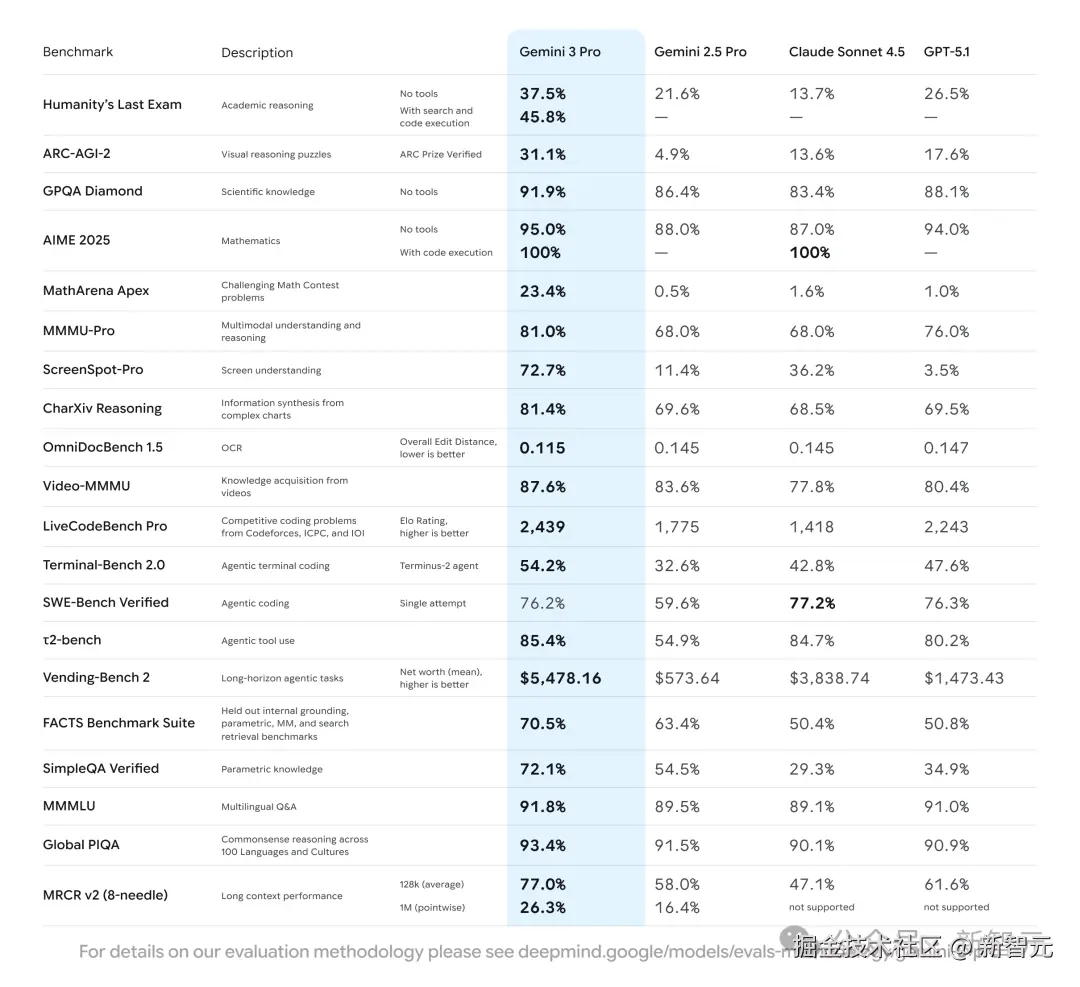

Gemini 3 发布后,谷歌和 OpenAI 攻守之势易形------

Gemini 3 来势汹汹,而 OpenAI 这次终于坐不住了!

据泄露的内部备忘录,奥特曼坦言:「近期, 从各方面来看,谷歌在大语言模型表现出色」,特别是预训练。

这番表态标志 OpenAI 的重大转变------它终于承认,一个重新崛起的竞争对手与逐渐降温的企业需求,已彻底打破了其「天下无敌」的光环。

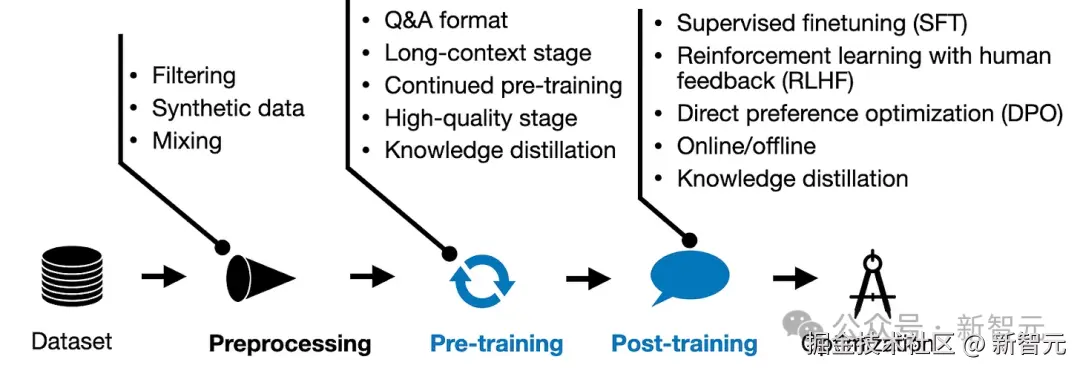

所谓预训练,是训练生成式 AI 模型(无论是文本还是图像)过程中的第一阶段。在这一阶段,研究人员会用网页等大量数据「投喂」模型,让它掌握数据之间的各种关联。

大语言模型(LLM)开发与训练流程概述:预训练和后训练是关键

在预训练领域,谷歌取得了新突破,给 Gemini 3 带来了空前的推理深度。

这让不少 AI 研究者颇感意外------

毕竟,OpenAI 去年曾屡屡碰壁,而谷歌自己过去也曾陷入瓶颈。

正因如此,在一段时间内,OpenAI 选择将更多精力转向另一种新型 AI 架构------「推理模型」,这种模型虽然计算量更大,但有望输出更优质的回答。

在推出 GPT-5 之前,OpenAI 团队曾尝试对预训练阶段做出一系列调整,这些方法在小模型上有效,一旦模型变大就失效了。

GPT-5 发布第二天,西班牙与波兰 Talan 公司 AI 应用负责人 Javier Alba de Alba 表示:

(GPT-5)整体观感颇为失望:

这是个优秀的模型------响应迅捷、价格亲民、能力全面,但远非人们基于 OpenAI 过往发布会所预期的代际飞跃。

GPT-5 带来了不少提升------

编程能力显著提升、推理能力进阶、幻觉现象减少、医疗领域表现优化,甚至免费用户也享有更长的默认使用时长。此外命名体系全面简化:GPT-4o/4.1/turbo/mini 等繁杂名称悉数消失,统一更名为 GPT-5。

不过,Javier Alba de Alba 提醒:「千万不要被名称迷惑:GPT-5 并非新一代产品。」他解释道:

技术层面而言,它更像是 GPT-4o 的功能增强版,即便命名为 GPT-4.2 也毫不违和。

OpenAI 此举虽完成了必要的名称统一,但整场发布会未能达到预期,让技术社区颇感失落。

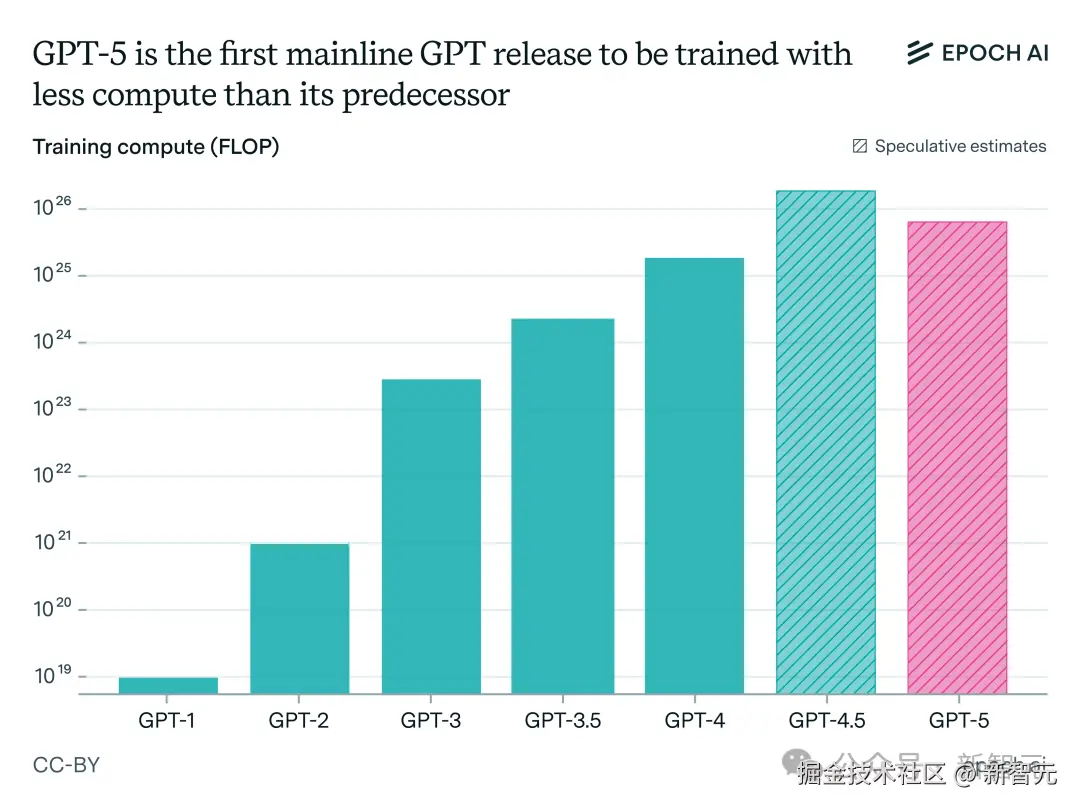

GPT-5 发布后,Epoch AI 也发现了其中的异常:

相比前代 GPT-4.5,GPT-5 很可能消耗了更少的训练算力。

虽然具体数值尚未公开,但 GPT-4.5 使用的训练算力极有可能超过 GPT-5。

预训练并未消亡,它依然是胜负关键。

上下滑动查看

在内部会议中,奥特曼鼓舞士气,称在未来几个月,OpenAI 将重新夺回优势。其中关键举措之一,就是打造一款代号为「Shallotpeat」的新一代大语言模型。

据知情人士透露,该模型的设计目标之一,就是专门修复 OpenAI 在预训练过程中遇到的种种「疑难杂症」。

「OpenAI:内部的风向变了」

GPT-5 发布的实质是什么?

对现有 ChatGPT 用户而言,GPT-5 是个好消息,但这并未开启新时代。

它只是进化历程中的一小步,而非革命性飞跃。

既然更多算力通常意味着更强性能,为何 OpenAI 会反其道而行?这对未来模型发展意味着什么?

在与 a16z 合伙人 Martin Casado 对话中,OpenAI 平台工程负责人 Sherwin Wu,深度拆解了 OpenAI 当前平台架构、定价逻辑与未来方向。

在这次访谈中,他们深入探讨了为何开发者往往会长期依赖某个「值得信赖」的模型系列,信任感是如何建立的,以及为什么行业已经逐步放弃了「一个模型通吃所有任务」的幻想。

Sherwin 还讲解了从提示词工程到上下文设计的演变过程,以及企业如何借助 OpenAI 的微调(fine-tuning)和 RFT API,利用自有数据定制模型行为。

「 」

」

「共识已变」

几年前,OpenAI 内部认为:未来会有一个「统治一切」的超级模型。但现在行业共识已经转变为「模型的专业化和多样化」。

虽然会有强大的通用模型,但也需要针对特定任务(如编程 Codex、视频 Sora)的专用模型。

文本、图像、视频背后的技术堆栈各不同。目前,在后台。这些模型往往是分开优化的独立系统,很难简单地「一锅炖」。

顺便提一句,正是 DALL-E 2 的出现让 Sherwin 决定加入 OpenAI,因为那是他第一次感受到 AI 的魔力。

「而微调(Fine-tuning)也悄然进化------」

早期的微调,主要用于调整「语气」或「指令遵循」。 现在的重头戏,是强化学习微调(Reinforcement Fine-Tuning) 。

这允许企业利用其庞大的专有数据(Data Treasure Troves),将较小的模型在特定领域训练至 SOTA 水平。这是解锁企业数据的关键。

也就是说,企业拥有大量内部数据,但与 ChatGPT「毫无关系」,对企业专属 AI 而言却是黄金。

他们多次提到 AI 代码编辑器 Cursor 作为建立在 OpenAI API 之上的成功产品案例,证明了:

即使 OpenAI 自己有竞品,开发者依然可以建立伟大的垂直应用。

「 」

」

「Agent 开发模式」

从第一天起,奥特曼和 Greg Brockman 就确立了「App+ API」的双轨战略。

这样做是为了尽可能广泛地分发 AGI 的利益------

如果只做 API,你就无法触达普通消费者;如果只做应用,你就无法赋能各行各业的开发者。

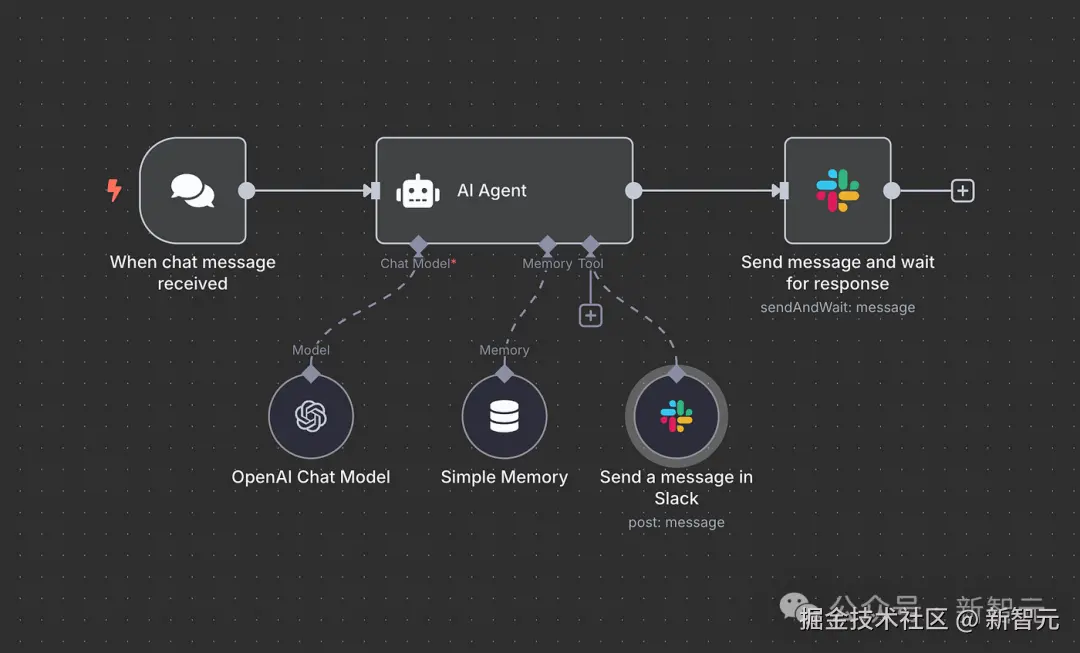

在这次对话中,他们重点谈论了智能体开发工具「Agent Builder」。

Sherwin 认为,智能体(Agent)并非一种全新的模态,而是 AI 的一种新使用方式。

本质上,智能体是一个能够代表用户、在**「较长的时间跨度」**(Long Time Horizons)内执行一系列操作并完成任务的 AI 系统。

OpenAI 曾推出了可视化的「Agent Builder」(节点式构建),但发现对于开发者而言,这种方式可能过于受限。

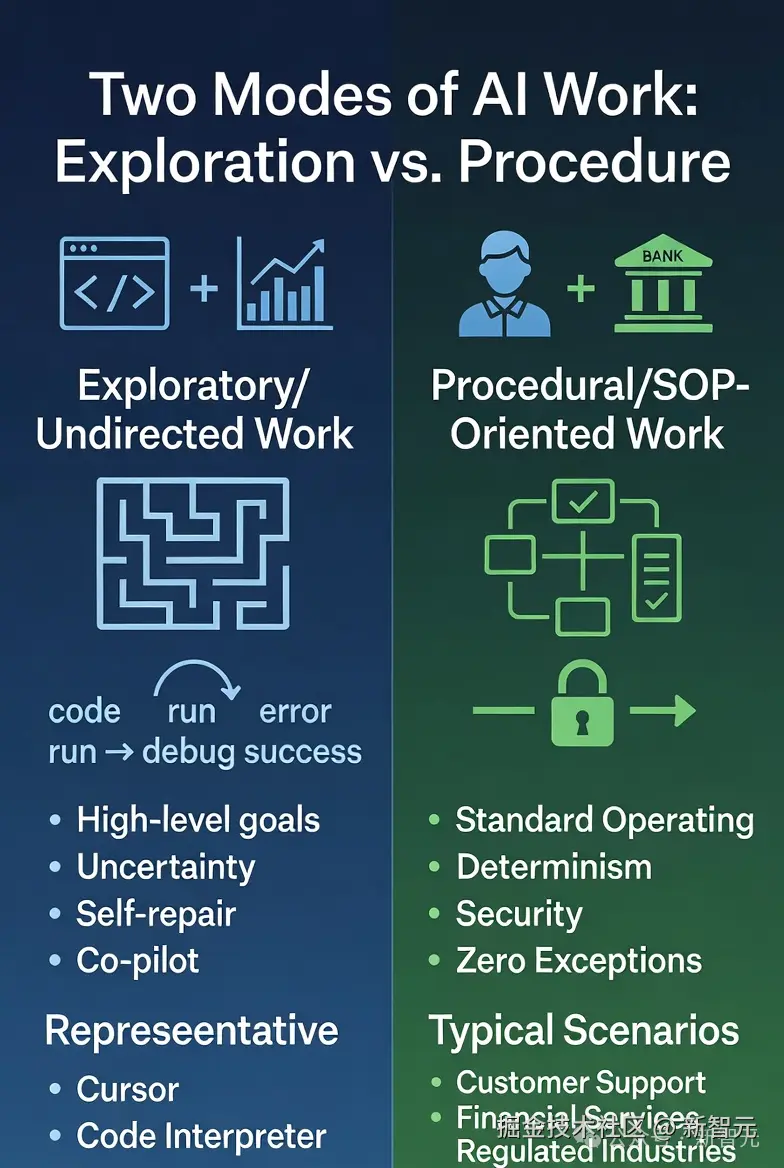

访谈中,Sherwin 和 Martin 将智能体清晰地划分为两类,这解释了为什么目前市面上的 Agent 产品形态各异------

- 探索型 / 非定向工作 (Undirected/Exploratory Work)

- 流程型 / SOP 导向工作 (Procedural/SOP-oriented Work)

「在对话中,第二类」 Agent 开发可能更像传统的软件工程或游戏开发中的 「NPC」****( 「「非玩家角色」 」)逻辑。

与其让模型完全自由发挥,不如通过代码给予它明确的逻辑框架和标准操作程序(SOP),特别是在受监管的行业(如客户支持、金融)。

也就是说,「逻辑必须写死在代码里,而不是提示词里。」

这就是 Agent Builder 想要解决的问题:为那些必须控制智能体行为的行业和场景,提供一个简单、清晰、可验证的解决方案。

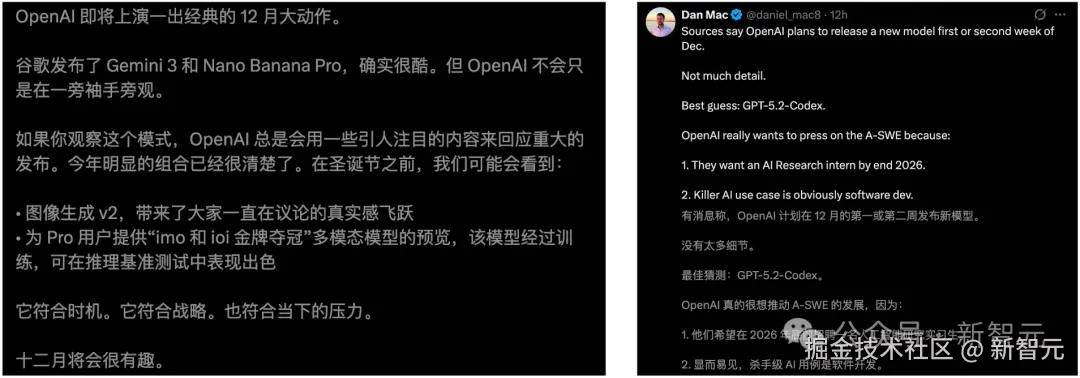

「One More Thing」

2025 年度压轴大戏,谷歌 Gemini 3 Pro 无疑打了一场胜仗,但 OpenAI 不会袖手旁观。

内部已确认,圣诞节前夕,一连串发布连番轰炸。

据传,一系列新模型,在路上了------

Image Gen v2

IMO 和 IOI 金牌多模态模型

GPT-5.2 Codex

12 月,AI 圈一定非常热闹。

参考资料:

www.newsbreak.com/winbuzzer-c...