作为一名每天都在和各种AI模型"斗智斗勇"的内容创作者,我不得不承认,视频生成这块骨头一直是最难啃的。我们要么在不同工具间反复横跳,要么对着生成的视频里乱飞的五官叹气。

但最近,快手旗下的可灵AI发布了全新的"可灵O1"模型,并且已经在LiblibAI上线。上手体验了一番后,我那种"终于等到你"的感觉非常强烈。它不是简单的画质升级,而是改变了玩视频的逻辑。

为什么叫O1?不仅仅是名字好听

O1代表的是Omni,也就是"全能"。

以前我们做AI视频是怎样的?先用Midjourney出图,再用Runway或者Luma让图动起来,如果想改个细节?对不起,重抽卡吧。

可灵O1最大的突破在于它是一个"统一多模态架构"。别被这几个技术名词吓跑,说人话就是:它把文生视频、图生视频、视频编辑全部揉进了一个引擎里。你不需要切换工具,在一个对话框里就能搞定所有事情。这就像是你从带着一堆螺丝刀、锤子、扳手出门,变成只带了一把瑞士军刀。

能听懂人话的"剪辑师"

这个模型最让我惊喜的是它的理解能力。它引入了MVL(多模态视觉语言)交互架构和Chain-of-thought(思维链)技术。

这意味着什么?意味着它真的能听懂你在说什么,并且具备一定的物理常识。

举个例子,如果我上传一段夏天的视频,对它说"把夏天变成冬天",它不仅仅是把画面调冷,它可能会给树加上积雪,给人物加上哈气。或者你觉得画面里那个路人碍眼,直接输入"删除路人",它就能像PS里的内容识别填充一样,把人抹掉并自动补全背景。

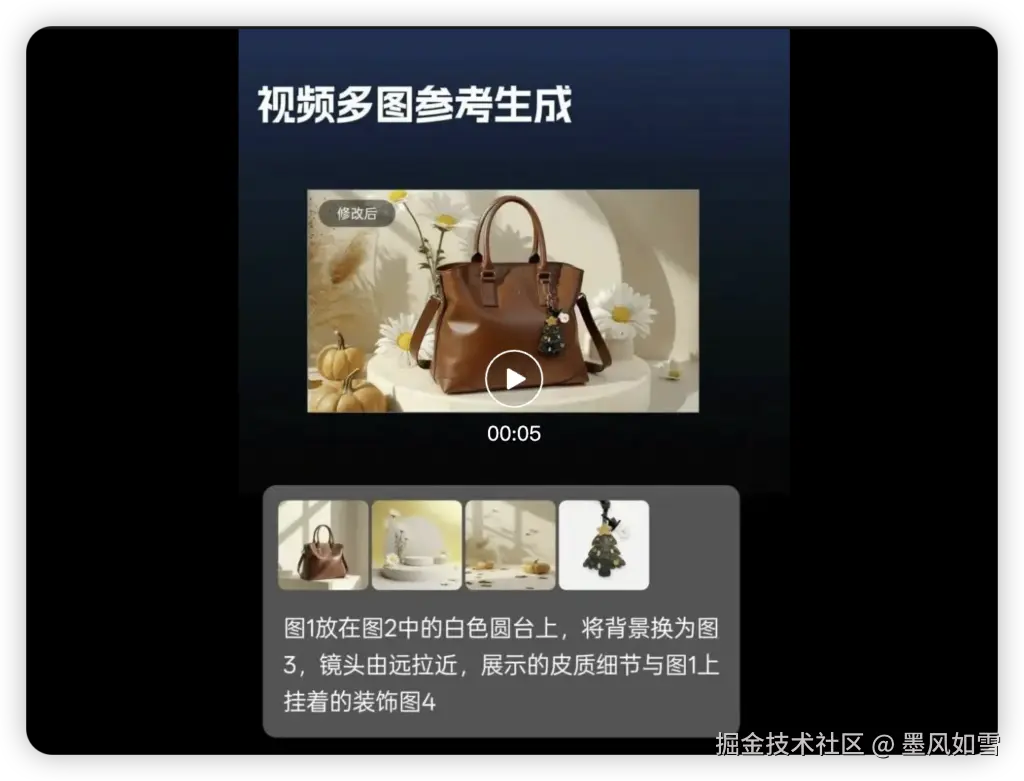

它甚至支持像"@某张图片 + @某个视频 + 生成下一个镜头"这样的组合指令。这种"指哪打哪"的像素级语义重构,才是创作者真正需要的生产力。

告别"变脸",角色终于稳了

做连续剧情短片最大的噩梦就是角色一致性。往往第一个镜头主角是吴彦祖,下一个镜头就变成了吴孟达。

可灵O1在这个痛点上下了狠功夫。它支持最多7张参考图输入,并且有一个专门的主体库。在实测中,即使镜头发生大幅度的运镜或者场景切换,主角的脸部特征、衣服细节依然能保持高度稳定。

对于那些想做AI电影或者连载短剧的朋友来说,这绝对是个杀手锏。

实诚的测评:优点突出,但也别神化

虽然吹了这么多,但作为一名客观的测评者,我得泼点冷水,让大家有个合理的预期。

首先,它是刚发布的一代模型。目前生成的视频分辨率最高是1080p,还没到4K级别。如果你是追求极致画质的"数毛党",可能在人物特写时会发现面部细节还不够完美。

其次,它目前是个"哑巴"。虽然视频生成很强,但它不支持生成音效或对白,声音部分还得靠你自己后期合成。

再者,它对特别复杂的动词指令,比如"蹑手蹑脚地潜行"这种带有微妙情绪和姿态的词,理解上偶尔还会差点意思。

在哪里能玩到?

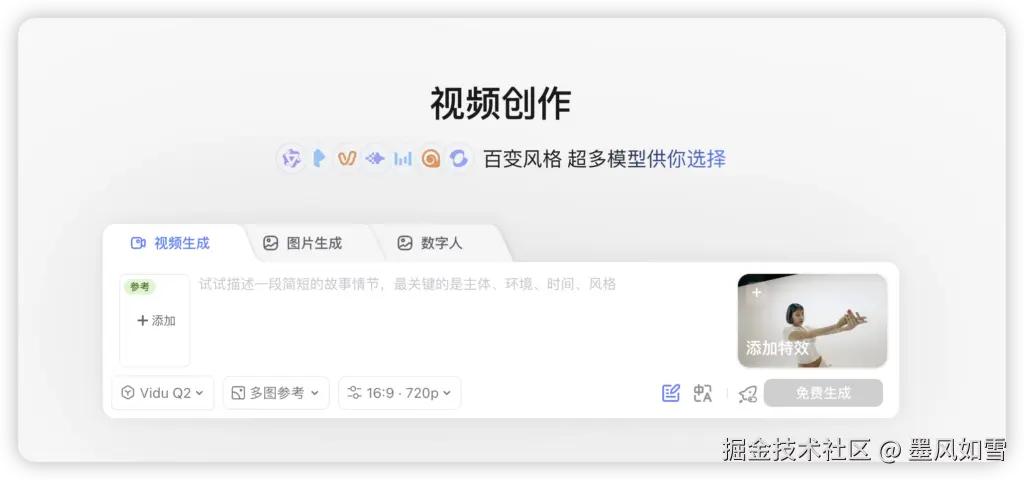

目前体验这个模型最方便的渠道是LiblibAI平台,作为首发合作方,入口很显眼。当然,你也可以去可灵AI的官网或App。

总结一下

可灵O1不是那种只会在参数上卷数字的模型,它是奔着解决实际工作流问题去的。虽然它还不完美,但它展示了一种可能性:未来的视频创作,真的可以像现在P图一样简单、直观、随心所欲。

对于我们这些创作者来说,工具的门槛越低,留给创意的空间就越大。这就够了。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站