使用场景

公司的办公环境是内网,不和互联网相连(保密单位,别问为啥这样),要更新个项目依赖啥的,很麻烦,要使用U盘来回拷贝文件,这是前提,我现在要在内网环境部署大模型,也是一波三折,以下是我的探索之路

- 在外网使用docker 运行 ollama 镜像,由于我本地电脑是mac电脑,服务是linux,因为是要把容器导出为镜像文件拿到内网使用,所以拉取镜像的时候要指定宿主机架构,不然的话,导出的镜像文件在服务器无法运行

bash

docker pull --flatform=linux/amd64 ollama/ollama:latest

css

docker run -d --name ollama-test -p 11434:11434 ollama/ollama:latest- 运行一个ollama容器,然后进入到该容器内部,用ollama指令安装指定大模型

arduino

docker exec -it ollama-test bash

//这里以deepseek-r1:1.5b 为例子

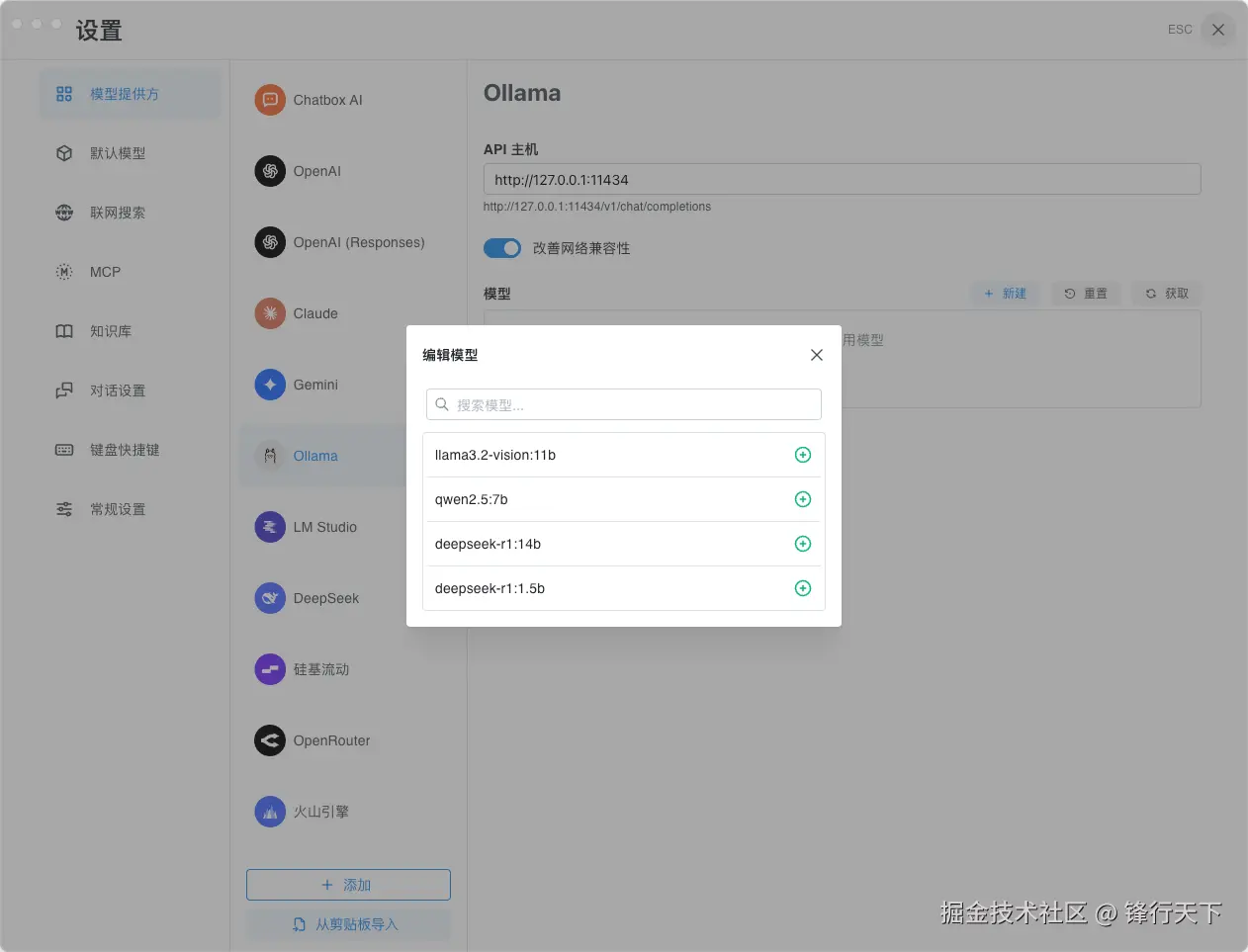

ollama run deepseek-r1:1.5b- 这时候是可以在本机使用chatbox链接使用容器内的大模型的,具体步骤不在这里细说

4. 把运行中的容器提交为本地镜像,这样你的镜像里就带上了你安装的大模型

4. 把运行中的容器提交为本地镜像,这样你的镜像里就带上了你安装的大模型

arduino

docker commit xxx yyy:latest

// xxx 为容器名或者id yyy:latest 是你自定义的镜像名和版本号- 把本地自定义镜像导出为镜像文件

xml

docker save -o <filename>.tar <image_name>- 把镜像文件拷到内网,使用docker加载你的镜像文件,前提条件是内网必须有docker环境

css

docker load -i /path/to/your/image.tar到此为止,你的内网就有携带大模型的ollama镜像了,你把容器运行起来,你再把chatbox安装包也拷到内网,就可以愉快的玩耍了

如何新增其他大模型到内网

现在的大模型有很多,功能各不相同,你可以多安装几个大模型,再导出镜像文件,拿到内网使用,安装了大模型的镜像文件会很大,我也就安装了上图的几个小模型,文件的体积就已经达到了30G以上,但是这不失为一种笨方法。大力出奇迹,但是作为一个程序员,我们总是要探索更省时省力的办法,以下是我个人探索的方法。

- 重新运行一个空白的ollama容器,把你要新增的大模型安装上

- 使用docker cp指令把容器内的模型文件拷贝出来,拿到内网,放到指定的位置即可,主要有两类文件需要拷贝,模型配置文件和模型数据文件,这两类文件的目录分别是

ruby

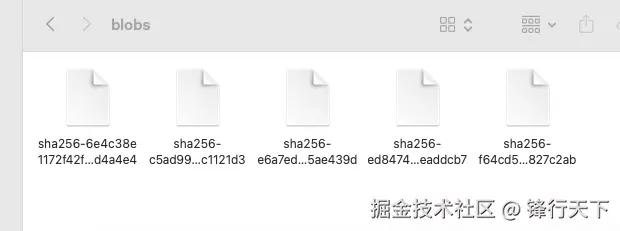

// 模型数据文件在 /root/.ollama/models/blobs

docker cp bff31133b939:/root/.ollama/models/blobs/. ./blobs

// 我这个指令的意思是 把 容器内的数据文件拷贝到 本机的当前目录的blobs文件夹下,你也可以使用绝对路径

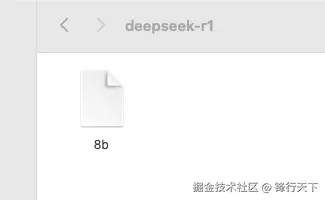

docker cp bff31133b939:/root/.ollama/models/manifests/registry.ollama.ai/library/. ./

// 这个指令的意思是把这个模型的配置文件拷贝当当前目录下,你也可以使用绝对路径以下是我拷贝出来的deepseek-r1:8b的配置文件和数据文件截图

- 把这两个文件拷贝到内网,放到以前的容器里对应的目录下,这样你内网的容器就新增了你这次导入的模型