2025年12月8日,智谱AI没有预告,直接甩出了一张王炸:GLM-4.6V系列多模态大模型正式上线并全量开源。

如果你还在关注那些只会"看图说话"的模型,那这次你可能要刷新一下认知了。智谱这次的更新,不是简单的参数堆叠,而是试图解决多模态领域一个最尴尬的痛点------大模型不仅要有眼睛,还得有手。

从"解说员"进化为"操作员"

过去我们用视觉模型(VLM),流程通常是这样的:扔一张图给模型,问它"这是什么",模型回答"这是一个网页报错"。然后呢?然后就没有然后了。你得自己去写代码修复。

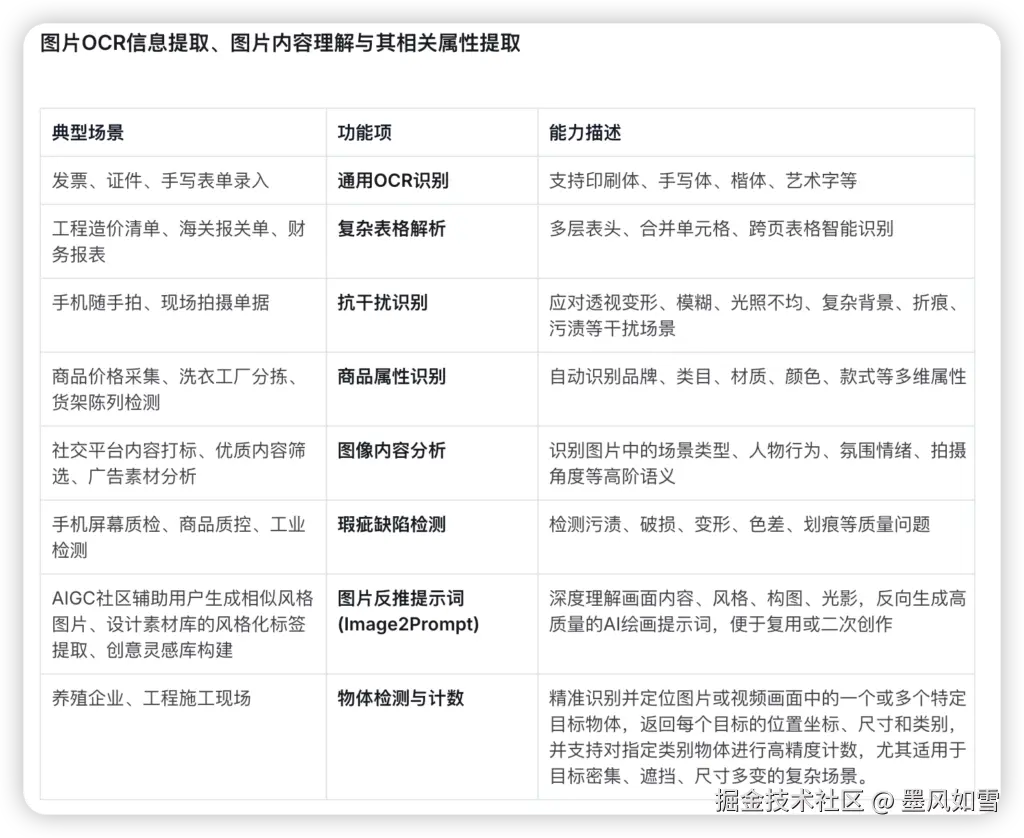

GLM-4.6V的核心突破在于"原生多模态工具调用"。这是什么概念?意味着图像、视频不再仅仅是需要被"翻译"成文字的累赘,它们直接成为了函数调用的参数。

模型可以直接读取你的屏幕截图,理解UI布局,然后调用工具去点击、输入、甚至直接生成前端代码并进行视觉修正。它不再是一个站在旁边指指点点的解说员,而是一个能真正下场干活的操作员。对于想做多模态Agent(智能体)的开发者来说,这简直是梦寐以求的基础设施。

两款模型,丰俭由人

这次智谱的刀法依旧精准,推出了两款定位截然不同的模型:

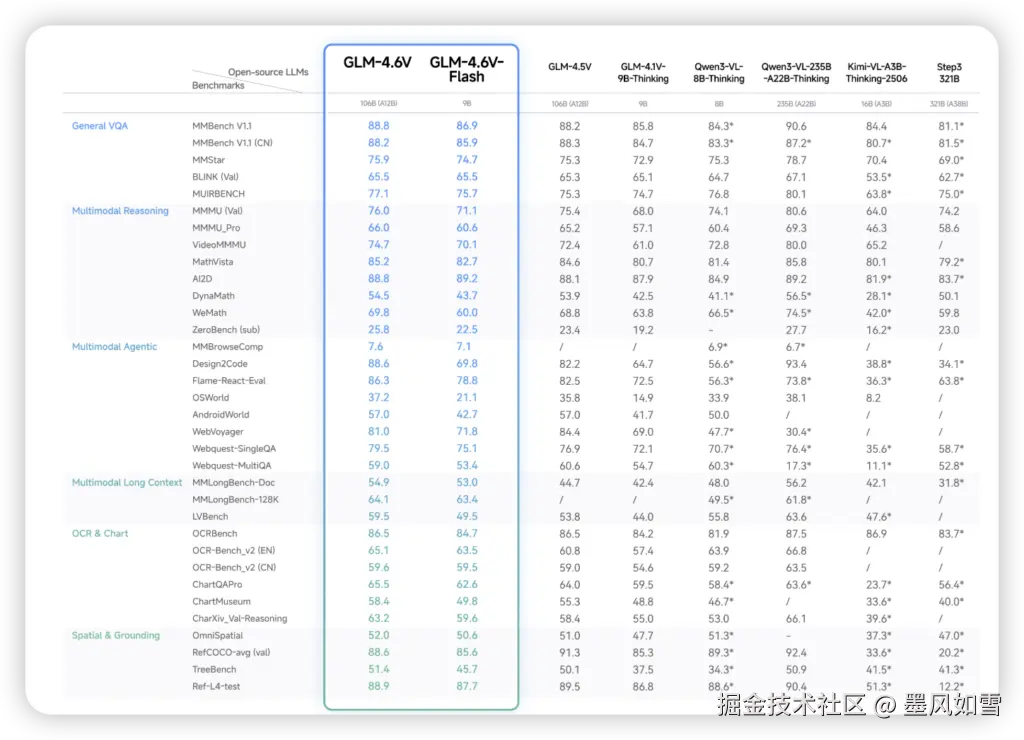

GLM-4.6V (106B):这是给追求极致性能的玩家准备的。虽然参数量高达106B,但激活参数控制在12B(MoE架构),在云端高性能集群上,它能处理复杂的长文档和深度推理任务。根据官方数据,它的表现直接对标行业顶尖闭源模型。

GLM-4.6V-Flash (9B):这是给务实派准备的惊喜。9B的体量意味着它可以轻松部署在本地,甚至是一些端侧设备上。虽然是轻量版,但它在OCR、视频理解等高频场景下的表现并不含糊,甚至在这个尺寸下击败了Qwen3-VL-8B等竞品。

更重要的是,全系模型支持128k的超长上下文。什么概念?你可以一次性扔给它一本150页的技术文档,或者一段1小时的视频,它不仅能读完,还能在里面精准地找到你需要的细节。

价格屠夫与开源诚意

技术再好,用不起也是白搭。智谱这次显然是想快速抢占市场。

相比上一代GLM-4.5V,新版API的价格直接腰斩了50%。输入1元/百万tokens,输出3元/百万tokens。而那个可以在本地跑得飞起的Flash版本,智谱直接宣布:免费。

在开源策略上,智谱也没有藏着掖着。权重、推理代码、示例工程全部推上了GitHub和Hugging Face。MIT协议,允许商业使用。这意味着,明天你可能就会看到一大波基于GLM-4.6V的垂直应用如雨后春笋般冒出来。

写在最后

在2025年这个节点,单纯比拼OCR准确率或者识图能力的时代已经过去了。GLM-4.6V的出现,标志着多模态模型开始向"行动派"转型。

对于开发者而言,现在最大的问题不再是"模型能不能看懂这张图",而是"既然它能看懂也能操作,我们能用它创造出什么样的新物种?"

大模型的下半场,拼的是落地,而GLM-4.6V,显然已经把梯子架好了。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站