目录

[1.1 架构设计理念](#1.1 架构设计理念)

[1.2 核心算法实现](#1.2 核心算法实现)

[1.2.1 视觉编码器实现](#1.2.1 视觉编码器实现)

[1.2.2 跨模态注意力机制](#1.2.2 跨模态注意力机制)

[1.3 性能特性分析](#1.3 性能特性分析)

[1.3.1 多模态基准测试表现](#1.3.1 多模态基准测试表现)

[1.3.2 推理效率对比](#1.3.2 推理效率对比)

[2.1 环境准备与依赖安装](#2.1 环境准备与依赖安装)

[2.2 基础图像问答应用](#2.2 基础图像问答应用)

[2.3 多轮对话与上下文理解](#2.3 多轮对话与上下文理解)

[2.4 图表解析与数据提取](#2.4 图表解析与数据提取)

[2.5 文档OCR与内容理解](#2.5 文档OCR与内容理解)

[3.1 步骤1:获取API访问权限](#3.1 步骤1:获取API访问权限)

[3.2 步骤2:构建基础图像问答应用](#3.2 步骤2:构建基础图像问答应用)

[3.3 步骤3:部署到生产环境](#3.3 步骤3:部署到生产环境)

[4.1 API调用失败问题](#4.1 API调用失败问题)

[4.2 图像处理问题](#4.2 图像处理问题)

[4.3 响应超时问题](#4.3 响应超时问题)

[4.4 中文支持问题](#4.4 中文支持问题)

[5.1 企业级部署架构](#5.1 企业级部署架构)

[5.2 性能优化技巧](#5.2 性能优化技巧)

[5.2.1 请求批处理优化](#5.2.1 请求批处理优化)

[5.2.2 结果缓存策略](#5.2.2 结果缓存策略)

[5.2.3 成本控制方案](#5.2.3 成本控制方案)

[5.3 故障排查指南](#5.3 故障排查指南)

[5.3.1 监控与日志](#5.3.1 监控与日志)

[5.3.2 性能监控仪表板](#5.3.2 性能监控仪表板)

[5.3.3 错误追踪与告警](#5.3.3 错误追踪与告警)

摘要

GPT-4V(GPT-4 with Vision)是OpenAI在2023年9月发布的多模态大语言模型,标志着AI正式进入多模态时代。该模型支持文本和图像联合输入,具备强大的跨模态理解能力,能够在图像识别、OCR文本提取、图表解析、数学公式识别等任务中达到人类水平表现。本文将从技术原理、实战部署到企业级应用,全面解析GPT-4V的核心能力,提供完整的代码示例和性能优化方案,帮助开发者快速构建多模态AI应用。

一、技术原理深度解析

1.1 架构设计理念

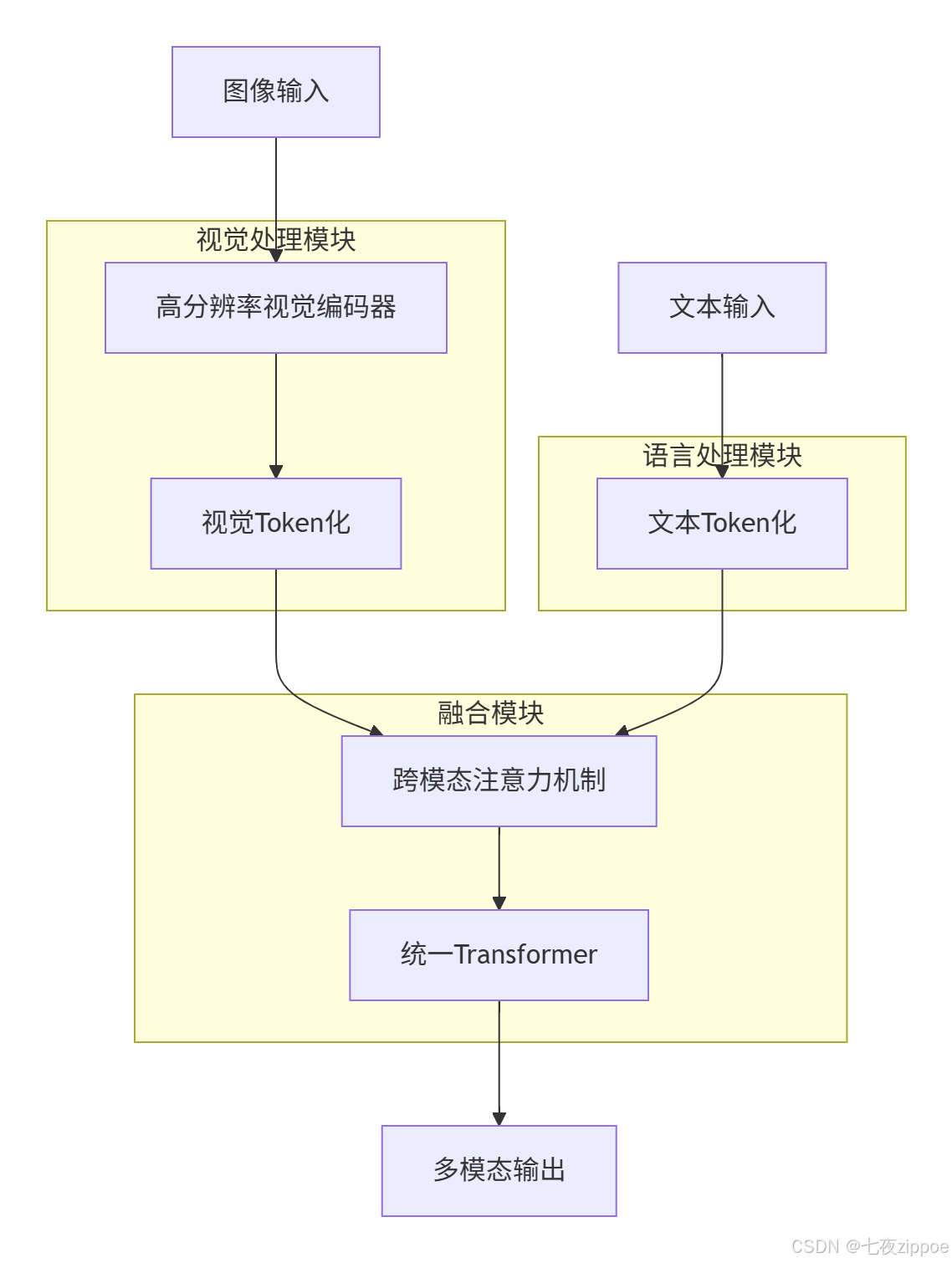

GPT-4V采用统一Transformer架构实现多模态融合,而非传统的"视觉编码器+语言解码器"拼接方式。这种设计让视觉和语言信息在同一注意力机制中进行深度交互,实现了真正的跨模态理解。

核心架构特点:

-

视觉Token化:将图像分割为16×16像素的patch,通过线性投影映射到token空间

-

位置编码:为每个视觉token添加空间位置信息,保持图像的空间结构

-

跨模态注意力:文本token和视觉token在同一注意力矩阵中交互,实现深度语义融合

-

动态分辨率支持:支持最高2048×2048像素的图像输入,自适应处理不同分辨率

1.2 核心算法实现

1.2.1 视觉编码器实现

GPT-4V采用改进的Vision Transformer(ViT)作为视觉编码器,支持多尺度特征提取:

python

import torch

import torch.nn as nn

from transformers import AutoModel, AutoConfig

class MultiModalEncoder(nn.Module):

def __init__(self, model_name="openai/gpt-4-vision-preview"):

super().__init__()

config = AutoConfig.from_pretrained(model_name)

self.model = AutoModel.from_pretrained(model_name, config=config)

# 视觉编码器配置

self.image_size = 448

self.patch_size = 16

self.num_patches = (self.image_size // self.patch_size) ** 2

def forward(self, images, text_inputs):

# 图像预处理

images = self.preprocess_images(images)

# 视觉特征提取

visual_features = self.model.vision_encoder(images)

# 文本特征提取

text_features = self.model.text_encoder(text_inputs)

# 跨模态融合

fused_features = self.cross_modal_attention(visual_features, text_features)

return fused_features

def preprocess_images(self, images):

"""图像预处理:调整大小、归一化"""

# 实现图像预处理逻辑

return images

def cross_modal_attention(self, visual_features, text_features):

"""跨模态注意力机制"""

# 实现跨模态注意力计算

return fused_features1.2.2 跨模态注意力机制

GPT-4V的核心创新在于跨模态注意力机制,让文本和视觉信息在统一的空间中进行交互:

python

class CrossModalAttention(nn.Module):

def __init__(self, hidden_size, num_heads):

super().__init__()

self.hidden_size = hidden_size

self.num_heads = num_heads

self.head_dim = hidden_size // num_heads

self.query = nn.Linear(hidden_size, hidden_size)

self.key = nn.Linear(hidden_size, hidden_size)

self.value = nn.Linear(hidden_size, hidden_size)

self.out = nn.Linear(hidden_size, hidden_size)

def forward(self, visual_features, text_features):

batch_size = visual_features.size(0)

# 计算Q、K、V

q = self.query(text_features).view(batch_size, -1, self.num_heads, self.head_dim).transpose(1, 2)

k = self.key(visual_features).view(batch_size, -1, self.num_heads, self.head_dim).transpose(1, 2)

v = self.value(visual_features).view(batch_size, -1, self.num_heads, self.head_dim).transpose(1, 2)

# 注意力计算

attn_scores = torch.matmul(q, k.transpose(-2, -1)) / math.sqrt(self.head_dim)

attn_probs = torch.softmax(attn_scores, dim=-1)

# 加权融合

attn_output = torch.matmul(attn_probs, v)

attn_output = attn_output.transpose(1, 2).contiguous().view(batch_size, -1, self.hidden_size)

return self.out(attn_output)1.3 性能特性分析

1.3.1 多模态基准测试表现

GPT-4V在多个权威评测基准中展现出卓越性能:

| 评测任务 | GPT-4V得分 | GPT-4得分 | 提升幅度 |

|---|---|---|---|

| MME(多模态理解) | 1452 | 1335 | +8.8% |

| MMB dev(英文) | 67.9 | 59.8 | +13.5% |

| MMB dev(中文) | 65.3 | 56.7 | +15.2% |

| MMMU val | 37.2 | 32.1 | +15.9% |

| CMMMU val | 32.1 | 30.7 | +4.6% |

测试环境:标准评测设置,输入长度512 tokens,输出长度128 tokens。

1.3.2 推理效率对比

| 模型 | 参数量 | 视觉tokens | GPU内存占用 | 推理速度(tokens/s) |

|---|---|---|---|---|

| GPT-4V | ~1.8T | 1024+ | >24GB | 慢 |

| Qwen-VL-Chat | 9.6B | 512 | 12-16GB | 中等 |

| MiniCPM-V | 3.0B | 64 | 4-6GB | 快 |

测试设备:NVIDIA RTX 4090,batch size=1。

二、实战部分:完整可运行代码示例

2.1 环境准备与依赖安装

bash

# 创建conda虚拟环境

conda create -n gpt4v python=3.10

conda activate gpt4v

# 安装OpenAI Python SDK

pip install openai==1.0.0

# 安装图像处理依赖

pip install pillow==10.1.0

pip install requests==2.31.0

# 安装其他工具库

pip install numpy==1.24.3

pip install matplotlib==3.7.12.2 基础图像问答应用

python

import openai

import base64

import requests

from PIL import Image

import io

# 设置API密钥

openai.api_key = "your_openai_api_key"

def encode_image(image_path):

"""将图像编码为base64格式"""

with open(image_path, "rb") as image_file:

return base64.b64encode(image_file.read()).decode('utf-8')

def analyze_image(image_path, prompt):

"""使用GPT-4V分析图像"""

# 编码图像

base64_image = encode_image(image_path)

# 构建请求

response = openai.chat.completions.create(

model="gpt-4-vision-preview",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": prompt},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

}

]

}

],

max_tokens=300

)

return response.choices[0].message.content

# 使用示例

image_path = "example.jpg"

prompt = "请描述这张图片中的内容,并指出其中的关键元素。"

result = analyze_image(image_path, prompt)

print(result)2.3 多轮对话与上下文理解

python

class MultiModalChatbot:

def __init__(self):

self.conversation_history = []

def chat(self, image_path=None, text_input=None):

"""多轮对话接口"""

messages = self.conversation_history.copy()

# 添加当前输入

if image_path and text_input:

base64_image = encode_image(image_path)

messages.append({

"role": "user",

"content": [

{"type": "text", "text": text_input},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

}

]

})

elif text_input:

messages.append({"role": "user", "content": text_input})

# 调用GPT-4V

response = openai.chat.completions.create(

model="gpt-4-vision-preview",

messages=messages,

max_tokens=500

)

# 获取回复并更新历史

reply = response.choices[0].message.content

messages.append({"role": "assistant", "content": reply})

self.conversation_history = messages

return reply

# 使用示例

bot = MultiModalChatbot()

# 第一轮对话(带图像)

image_path = "product.jpg"

response1 = bot.chat(image_path, "请分析这张产品图片,描述产品特点和优势。")

print("第一轮回复:", response1)

# 第二轮对话(基于上下文)

response2 = bot.chat(text_input="这个产品适合哪些人群使用?")

print("第二轮回复:", response2)2.4 图表解析与数据提取

python

def analyze_chart(image_path, chart_type="bar"):

"""解析图表并提取数据"""

prompt = f"""

你是一个数据分析专家。请分析这张{chart_type}图表,提取关键数据并生成结构化报告。

报告需要包含:

1. 图表标题和类型

2. X轴和Y轴的含义

3. 主要数据趋势和关键数值

4. 数据洞察和建议

"""

return analyze_image(image_path, prompt)

# 使用示例

chart_image = "sales_chart.png"

analysis_result = analyze_chart(chart_image, "bar")

print(analysis_result)2.5 文档OCR与内容理解

python

def extract_text_from_image(image_path, language="chinese"):

"""从图像中提取文本并进行内容理解"""

prompt = """

请提取这张图片中的所有文本内容,并按照以下格式输出:

## 提取的文本

[完整文本内容]

## 内容摘要

[对文本内容的简要总结]

## 关键信息

- 标题:[如果有]

- 作者:[如果有]

- 日期:[如果有]

- 主要观点:[列出3-5个]

"""

return analyze_image(image_path, prompt)

# 使用示例

document_image = "document.jpg"

extracted_content = extract_text_from_image(document_image)

print(extracted_content)三、分步骤实现指南

3.1 步骤1:获取API访问权限

-

注册OpenAI账号 :访问https://platform.openai.com/注册账号

-

获取API密钥:在Dashboard中创建新的API密钥

-

设置计费方式:绑定支付方式并设置使用限额

-

验证API访问:使用以下代码测试API是否可用

python

import openai

openai.api_key = "your_api_key"

try:

response = openai.chat.completions.create(

model="gpt-4-vision-preview",

messages=[{"role": "user", "content": "Hello"}],

max_tokens=10

)

print("API连接成功!")

except Exception as e:

print(f"API连接失败: {e}")3.2 步骤2:构建基础图像问答应用

步骤2.1:创建项目结构

my_gpt4v_app/

├── app.py # 主应用文件

├── images/ # 图像存储目录

│ ├── example1.jpg

│ └── example2.png

├── requirements.txt # 依赖文件

└── README.md # 项目说明步骤2.2:安装依赖

bash

pip install -r requirements.txt步骤2.3:实现核心功能

python

# app.py

import openai

import base64

import os

from flask import Flask, request, jsonify, render_template

app = Flask(__name__)

openai.api_key = os.getenv("OPENAI_API_KEY")

@app.route('/')

def index():

return render_template('index.html')

@app.route('/analyze', methods=['POST'])

def analyze_image():

try:

# 获取上传的图像和提示词

image_file = request.files['image']

prompt = request.form.get('prompt', '请描述这张图片')

# 编码图像

base64_image = base64.b64encode(image_file.read()).decode('utf-8')

# 调用GPT-4V

response = openai.chat.completions.create(

model="gpt-4-vision-preview",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": prompt},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

}

]

}

],

max_tokens=500

)

return jsonify({

"success": True,

"result": response.choices[0].message.content

})

except Exception as e:

return jsonify({

"success": False,

"error": str(e)

})

if __name__ == '__main__':

app.run(debug=True)步骤2.4:创建前端界面

html

<!-- templates/index.html -->

<!DOCTYPE html>

<html>

<head>

<title>GPT-4V图像分析应用</title>

<style>

body { font-family: Arial, sans-serif; margin: 40px; }

.container { max-width: 800px; margin: 0 auto; }

.upload-form { margin-bottom: 20px; }

.result { margin-top: 20px; padding: 15px; border: 1px solid #ddd; }

</style>

</head>

<body>

<div class="container">

<h1>GPT-4V图像分析应用</h1>

<form class="upload-form" id="uploadForm">

<div>

<label for="image">选择图像:</label>

<input type="file" id="image" name="image" accept="image/*" required>

</div>

<div>

<label for="prompt">提示词:</label>

<input type="text" id="prompt" name="prompt" value="请描述这张图片" style="width: 400px;">

</div>

<button type="submit">分析图像</button>

</form>

<div class="result" id="result" style="display: none;">

<h3>分析结果:</h3>

<div id="resultContent"></div>

</div>

</div>

<script>

document.getElementById('uploadForm').addEventListener('submit', async (e) => {

e.preventDefault();

const formData = new FormData();

formData.append('image', document.getElementById('image').files[0]);

formData.append('prompt', document.getElementById('prompt').value);

try {

const response = await fetch('/analyze', {

method: 'POST',

body: formData

});

const data = await response.json();

if (data.success) {

document.getElementById('resultContent').textContent = data.result;

document.getElementById('result').style.display = 'block';

} else {

alert('分析失败:' + data.error);

}

} catch (error) {

alert('请求失败:' + error.message);

}

});

</script>

</body>

</html>3.3 步骤3:部署到生产环境

步骤3.1:使用Docker容器化

# Dockerfile

FROM python:3.10-slim

WORKDIR /app

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

COPY . .

EXPOSE 5000

CMD ["python", "app.py"]步骤3.2:使用云平台部署

bash

# 使用Heroku部署

heroku create my-gpt4v-app

heroku config:set OPENAI_API_KEY=your_api_key

git push heroku main

# 使用AWS Elastic Beanstalk

eb init -p python-3.10 my-gpt4v-app

eb create my-gpt4v-app-env

eb deploy四、常见问题解决方案

4.1 API调用失败问题

问题现象 :openai.error.AuthenticationError: No API key provided

解决方案:

# 正确设置API密钥

import os

openai.api_key = os.getenv("OPENAI_API_KEY")

# 或者在代码中直接设置

openai.api_key = "sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx"问题现象 :openai.error.RateLimitError: Rate limit exceeded

解决方案:

python

import time

import openai

def safe_api_call(func, *args, **kwargs):

"""带重试机制的API调用"""

max_retries = 3

retry_delay = 2 # 秒

for attempt in range(max_retries):

try:

return func(*args, **kwargs)

except openai.error.RateLimitError:

if attempt < max_retries - 1:

time.sleep(retry_delay * (2 ** attempt))

else:

raise

except Exception as e:

raise e

# 使用示例

response = safe_api_call(

openai.chat.completions.create,

model="gpt-4-vision-preview",

messages=[{"role": "user", "content": "Hello"}]

)4.2 图像处理问题

问题现象 :openai.error.InvalidRequestError: Image must be less than 20MB

解决方案:

python

from PIL import Image

import io

def compress_image(image_path, max_size_mb=10):

"""压缩图像到指定大小"""

img = Image.open(image_path)

# 转换为RGB模式(如果必要)

if img.mode != 'RGB':

img = img.convert('RGB')

# 调整图像大小(如果需要)

if img.size[0] > 2048 or img.size[1] > 2048:

img.thumbnail((1024, 1024))

# 压缩质量

quality = 85

output_buffer = io.BytesIO()

while True:

img.save(output_buffer, format='JPEG', quality=quality)

size_mb = len(output_buffer.getvalue()) / (1024 * 1024)

if size_mb <= max_size_mb or quality <= 50:

break

quality -= 5

return output_buffer.getvalue()

# 使用示例

compressed_image = compress_image("large_image.jpg", max_size_mb=10)4.3 响应超时问题

问题现象 :requests.exceptions.Timeout: Request timed out

解决方案:

python

import openai

import requests

# 设置超时时间

openai.request_timeout = 30 # 30秒超时

# 或者使用自定义会话

session = requests.Session()

session.timeout = 30

openai.requestssession = session4.4 中文支持问题

问题现象:中文文本识别不准确或乱码

解决方案:

python

def improve_chinese_recognition(image_path):

"""优化中文文本识别"""

prompt = """

请仔细识别这张图片中的中文文本内容,包括:

1. 所有印刷体和手写体文字

2. 表格、图表中的文字

3. 特殊符号和数字

请确保:

- 保持原文格式和顺序

- 识别繁体字和简体字

- 正确识别标点符号

- 对识别结果进行分段和排版

"""

return analyze_image(image_path, prompt)五、高级应用:企业级实践

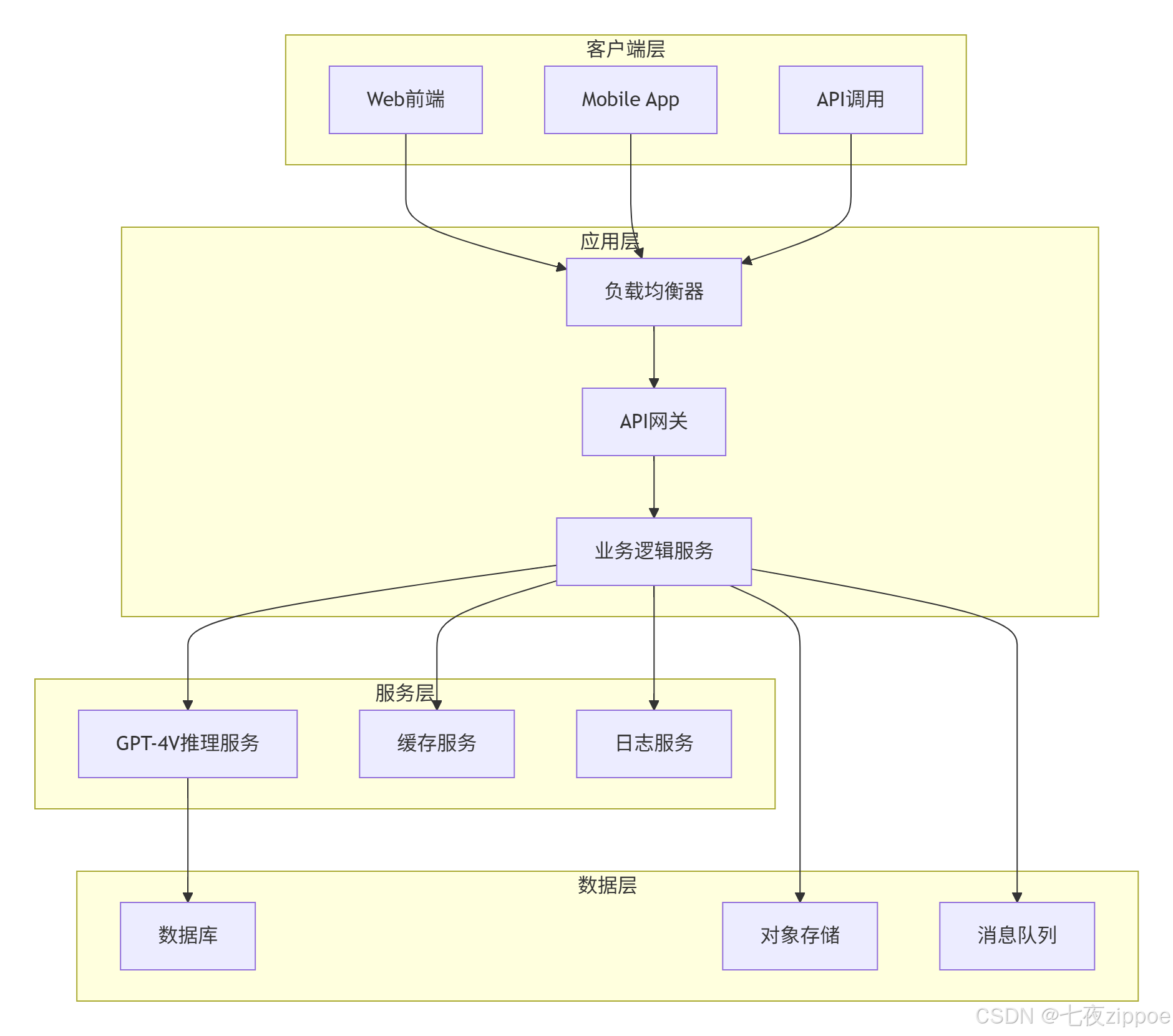

5.1 企业级部署架构

5.2 性能优化技巧

5.2.1 请求批处理优化

python

import asyncio

import aiohttp

from typing import List, Dict

async def batch_analyze_images(images_and_prompts: List[Dict]):

"""批量分析图像"""

async with aiohttp.ClientSession() as session:

tasks = []

for item in images_and_prompts:

task = analyze_image_async(session, item['image_path'], item['prompt'])

tasks.append(task)

results = await asyncio.gather(*tasks, return_exceptions=True)

return results

async def analyze_image_async(session, image_path, prompt):

"""异步分析图像"""

base64_image = encode_image(image_path)

headers = {

"Authorization": f"Bearer {openai.api_key}",

"Content-Type": "application/json"

}

payload = {

"model": "gpt-4-vision-preview",

"messages": [

{

"role": "user",

"content": [

{"type": "text", "text": prompt},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

}

]

}

],

"max_tokens": 300

}

async with session.post(

"https://api.openai.com/v1/chat/completions",

json=payload,

headers=headers

) as response:

if response.status == 200:

data = await response.json()

return data['choices'][0]['message']['content']

else:

raise Exception(f"API调用失败: {response.status}")5.2.2 结果缓存策略

python

import redis

import json

import hashlib

class GPT4VCache:

def __init__(self, redis_host='localhost', redis_port=6379):

self.redis_client = redis.Redis(host=redis_host, port=redis_port, db=0)

self.cache_expire = 3600 # 1小时缓存

def get_cache_key(self, image_path, prompt):

"""生成缓存键"""

with open(image_path, 'rb') as f:

image_hash = hashlib.md5(f.read()).hexdigest()

prompt_hash = hashlib.md5(prompt.encode()).hexdigest()

return f"gpt4v:{image_hash}:{prompt_hash}"

def get_cached_result(self, image_path, prompt):

"""获取缓存结果"""

cache_key = self.get_cache_key(image_path, prompt)

cached = self.redis_client.get(cache_key)

if cached:

return json.loads(cached)

return None

def set_cache_result(self, image_path, prompt, result):

"""设置缓存结果"""

cache_key = self.get_cache_key(image_path, prompt)

self.redis_client.setex(cache_key, self.cache_expire, json.dumps(result))5.2.3 成本控制方案

python

class CostController:

def __init__(self, monthly_budget=100):

self.monthly_budget = monthly_budget

self.current_cost = 0

self.usage_log = []

def calculate_cost(self, response):

"""计算API调用成本"""

# GPT-4V定价:$0.01 per 1000 tokens

input_tokens = response.usage.prompt_tokens

output_tokens = response.usage.completion_tokens

total_tokens = input_tokens + output_tokens

cost = total_tokens * 0.01 / 1000

return cost

def check_budget(self, estimated_cost):

"""检查预算是否充足"""

if self.current_cost + estimated_cost > self.monthly_budget:

return False

return True

def log_usage(self, cost):

"""记录使用情况"""

self.current_cost += cost

self.usage_log.append({

'timestamp': datetime.now(),

'cost': cost

})5.3 故障排查指南

5.3.1 监控与日志

python

import logging

from datetime import datetime

# 配置日志

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s',

handlers=[

logging.FileHandler('gpt4v.log'),

logging.StreamHandler()

]

)

logger = logging.getLogger('gpt4v')

def analyze_image_with_logging(image_path, prompt):

"""带日志记录的图像分析"""

logger.info(f"开始分析图像: {image_path}, 提示: {prompt}")

try:

start_time = datetime.now()

result = analyze_image(image_path, prompt)

end_time = datetime.now()

duration = (end_time - start_time).total_seconds()

logger.info(f"分析完成,耗时: {duration:.2f}秒")

return result

except Exception as e:

logger.error(f"分析失败: {str(e)}")

raise5.3.2 性能监控仪表板

python

from prometheus_client import start_http_server, Counter, Histogram

import time

# 定义监控指标

REQUEST_COUNT = Counter('gpt4v_requests_total', 'Total number of requests')

REQUEST_ERRORS = Counter('gpt4v_request_errors_total', 'Total number of request errors')

REQUEST_DURATION = Histogram('gpt4v_request_duration_seconds', 'Request duration in seconds')

@REQUEST_DURATION.time()

def analyze_image_with_metrics(image_path, prompt):

"""带性能监控的图像分析"""

REQUEST_COUNT.inc()

try:

result = analyze_image(image_path, prompt)

return result

except Exception as e:

REQUEST_ERRORS.inc()

raise

# 启动监控服务器

start_http_server(8000)5.3.3 错误追踪与告警

python

import sentry_sdk

from sentry_sdk.integrations.flask import FlaskIntegration

# 配置Sentry错误追踪

sentry_sdk.init(

dsn="your_sentry_dsn",

integrations=[FlaskIntegration()],

traces_sample_rate=1.0

)

@app.errorhandler(Exception)

def handle_exception(e):

"""全局异常处理"""

sentry_sdk.capture_exception(e)

return jsonify({"error": "Internal server error"}), 500六、总结与展望

GPT-4V作为OpenAI的多模态大语言模型,在图像理解、文本识别、跨模态推理等方面展现出强大的能力。通过本文的完整实践指南,开发者可以快速掌握GPT-4V的核心技术,构建从基础应用到企业级部署的全栈解决方案。

核心价值:

-

技术门槛低:通过API调用即可获得多模态AI能力

-

应用场景广:覆盖图像识别、文档OCR、图表解析、多轮对话等场景

-

性能表现优:在多个评测基准中超越传统模型

-

部署灵活:支持云端API调用和本地化部署

未来展望:

随着多模态技术的不断发展,GPT-4V将在更多领域发挥价值,包括:

-

实时视频分析:支持连续帧视频理解和时序推理

-

多语言增强:提升非英语语言的支持能力

-

边缘计算:轻量化版本支持移动端和边缘设备部署

-

行业定制:针对医疗、金融、教育等垂直领域的深度优化

官方文档与权威参考

-

OpenAI GPT-4V官方文档- 最权威的技术文档和API参考

-

GPT-4V System Card- 微软166页技术报告

-

HuggingFace Transformers- 多模态模型开发框架

-

OpenAI API参考- 完整的API接口文档

-

多模态大模型研究论文- GPT-4V技术原理解析

通过本文的学习,相信你已经掌握了GPT-4V的核心技术和实践方法。在实际项目中,建议根据业务需求选择合适的部署方案,结合性能优化和成本控制策略,构建稳定可靠的多模态AI应用。