1.安装**llm-export**

这里为了方便改动其中出现的问题,通过源码安装

git clone https://github.com/wangzhaode/llm-export

cd llm-export

pip install -e .2.模型导出

下载qwen2.5-0.5B模型:

modelscope download Qwen/Qwen2.5-0.5B-Instruct --local_dir Qwen2.5-0.5B-Instruct测试模型效果:

llmexport --path Qwen2.5-0.5B-Instruct --test "你好,请介绍一下你自己"模型导出:

# 导出为 ONNX 格式

llmexport --path Qwen2.5-0.5B-Instruct --export onnx

# 导出为 MNN 格式(默认 4bit 量化)

llmexport --path Qwen2.5-0.5B-Instruct --export mnn

# 自定义量化参数

llmexport --path Qwen2.5-0.5B-Instruct --export mnn --quant_bit 8 --quant_block 1283.编译mnn-llm

下载代码然后编译代码

git clone --recurse-submodules https://github.com/wangzhaode/mnn-llm.git

cd mnn-llm

# linux

./script/build.sh

# android

./script/android_build.sh

# android apk

./script/android_app_build.sh

一些编译宏:

BUILD_FOR_ANDROID: 编译到Android设备;

LLM_SUPPORT_VISION: 是否支持视觉处理能力;

DUMP_PROFILE_INFO: 每次对话后dump出性能数据到命令行中;

默认使用CPU,如果使用其他后端或能力,可以在编译MNN时添加MNN编译宏

cuda: -DMNN_CUDA=ON

opencl: -DMNN_OPENCL=ON

metal: -DMNN_METAL=ON4.测试

通过这个库运行llmexport导出的模型一直报错,暂时不知道什么问题,github评论区很多都在说

Can't open file:./mnn_cachefile.bin

Load Cache file error.

load tokenizer

tokenizer_type = 3

load tokenizer Done

load ../../model/llm.mnn ... 3 tensor [ logits_index ] is input but not found

Load Module Done!

Clone Decode Module Done!

Q: who

A: Segmentation fault5. 编译MNN

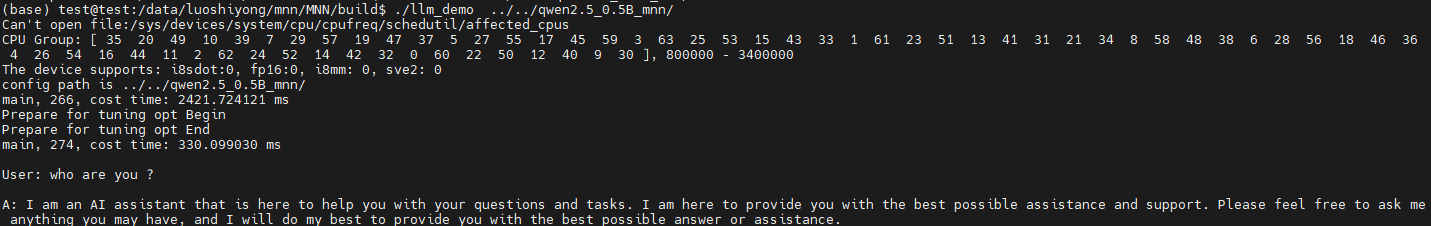

看到MNN-llm库说已经merge到MNN了,想着是不是前者不维护了,试一下MNN,没想到反而可以

// 下载代码

git clone https://github.com/alibaba/MNN.git

cd MNN&& mkdir build

//编译x86 cmake

cmake .. -DLLM_SUPPORT_VISION=ON -DMNN_BUILD_OPENCV=ON -DMNN_IMGCODECS=ON -DLLM_SUPPORT_AUDIO=ON -DMNN_BUILD_AUDIO=ON -DMNN_LOW_MEMORY=true -DMNN_CPU_WEIGHT_DEQUANT_GEMM=true -DMNN_BUILD_LLM=true -DMNN_SUPPORT_TRANSFORMER_FUSE=truemake -DMNN_AVX512=ON && make -j4

./llm_demo ../../qwen2.5_0.5B_mnn/ //运行demo