就在几天前,科技圈里悄悄发生了一件大事。

如果你经常关注开源社区,大概率已经被面壁智能(OpenBMB)刷屏了。2025年12月10日,他们正式把自己压箱底的宝贝------语音生成基础模型 VoxCPM 更新到了 1.5 版本,并且直接开源。

为什么要专门聊它?因为在很长一段时间里,开源界的TTS(文本转语音)模型总让人觉得差点意思:要么音质像个没有感情的朗读机器,要么生成速度慢到让你怀疑人生。但这次 VoxCPM 1.5 的出现,似乎就是为了打破这个僵局而来的。

实话说,这次升级有点猛,咱们拆开来看看它到底强在哪儿。

听觉的"高清重制版"

首先最直观的感受就是"耳朵怀孕"。以前的 TTS 模型,很多采样率都停留在 16kHz 甚至更低,听起来总有一种对着电话筒说话的朦胧感,高频细节丢失严重。

VoxCPM 1.5 把底层的 AudioVAE 采样率直接拉升到了 44.1kHz。这是什么概念?这就是CD级音质的标准。这意味着生成的语音不再是干巴巴的念稿子,你能听到更丰富的细节,比如呼吸的气口、语气的微弱起伏,甚至是那种难以言传的"空气感"。在这个版本里,声音的解析力上了一个大台阶,那种恼人的电子味和伪影(artifacts)少了很多。

快,而且是加倍的快

对于开发者或者想在本地跑模型的人来说,光好听没用,还得跑得动。

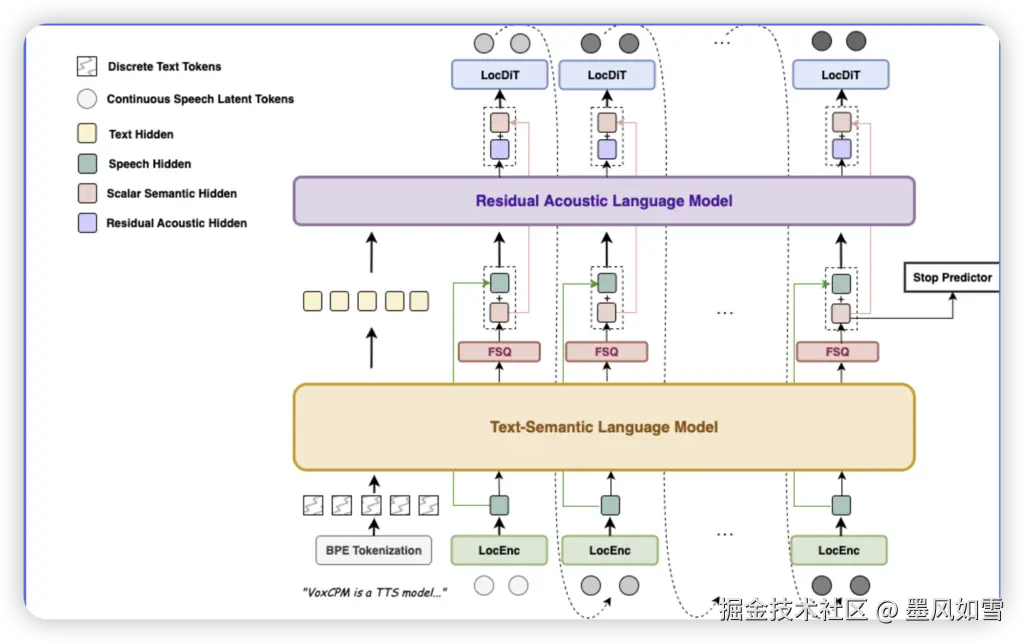

上一代模型虽然也好用,但这一代简直是开了倍速挂。官方数据显示,生成效率直接翻倍。以前生成1秒的音频需要处理12.5个token,现在只需要6.25个。

这背后的技术逻辑其实很有趣。它没有使用传统的语音分词器(Tokenizer),而是直接在连续的语音表示空间里"冲浪"。这种做法不仅让生成速度起飞,还避免了因为把声音强行切碎而导致的信息丢失。这对于想要在普通家用电脑甚至某些端侧设备上部署的人来说,绝对是个福音。

属于创作者的"捏脸"时刻

如果你是做自媒体的,或者是搞二次元二创的,这一点你绝对会喜欢:它的可玩性变强了。

VoxCPM 1.5 新增了 LoRA 和全量微调脚本。稍微懂点炼丹的朋友都知道这意味着什么。以前你想克隆一个声音,可能需要海量的数据和昂贵的算力。现在,你只需要少量的目标人声数据(只要几分钟),就能用极低的成本"捏"出一个专属的音色模型。

不管是想复刻某个经典角色的声线,还是想训练一个属于自己的数字分身,门槛都被大大降低了。而且因为它参数量只有 5亿(0.5B),这在当今动辄千亿参数的大模型时代,简直就是"小而美"的典范,一张中端显卡就能玩得转。

写在最后

目前,VoxCPM 1.5 的代码和权重已经全部上传到了 GitHub 和 Hugging Face。虽然社区里也有些反馈说目前的版本在某些极端配置下还有点小Bug,但这毕竟是开源项目的常态------一边用,一边修。

总的来说,面壁智能这次交出的答卷相当有诚意。它不是那种高高在上、只能在实验室里跑的巨无霸,而是一个真正能让开发者拿来用、拿来改、拿来创造价值的实用工具。

如果你受够了那些听起来像机器人的配音,不妨去下载这个 1.5 版本试试。毕竟,在这个AI飞速进化的时代,能找到一个既好听又听话的"嘴替",确实不容易。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站