目录

- [Apache ShardingSphere实战](#Apache ShardingSphere实战)

- 1.数据库架构演变与分库分表介绍

-

- [1.1 海量数据存储问题及解决方案](#1.1 海量数据存储问题及解决方案)

- [1.2 项目架构的演进](#1.2 项目架构的演进)

-

- [1.2.1 理财平台 - V1.0](#1.2.1 理财平台 - V1.0)

- [1.2.2 理财平台 - V1.x](#1.2.2 理财平台 - V1.x)

- [1.2.3 理财平台-V2.0 版本](#1.2.3 理财平台-V2.0 版本)

- [1.2.4 理财平台-V2.x 版本](#1.2.4 理财平台-V2.x 版本)

- [1.5 分库分表](#1.5 分库分表)

-

- [1.5.1 什么是分库分表](#1.5.1 什么是分库分表)

- [1.5.2 分库分表的方式](#1.5.2 分库分表的方式)

-

- [1.5.2.1 垂直分库](#1.5.2.1 垂直分库)

- [1.5.2.2 垂直分表](#1.5.2.2 垂直分表)

- [1.5.2.3 水平分库](#1.5.2.3 水平分库)

- [1.5.2.4 水平分表](#1.5.2.4 水平分表)

- [1.5.3 分库分表的规则](#1.5.3 分库分表的规则)

- [1.5.4 分库分表带来的问题及解决方案](#1.5.4 分库分表带来的问题及解决方案)

- 2.ShardingSphere实战

-

- [2.1 什么是ShardingSphere](#2.1 什么是ShardingSphere)

- [2.2 Sharding-JDBC介绍](#2.2 Sharding-JDBC介绍)

- [2.3 数据分片详解与实战](#2.3 数据分片详解与实战)

-

- [2.3.1 核心概念](#2.3.1 核心概念)

-

- [2.3.1.1 表概念](#2.3.1.1 表概念)

- [2.3.1.2 分片键](#2.3.1.2 分片键)

- [2.3.1.3 分片算法](#2.3.1.3 分片算法)

- [2.3.1.4 分片策略](#2.3.1.4 分片策略)

- [2.3.1.5 分布式主键](#2.3.1.5 分布式主键)

- [2.3.2 搭建基础环境](#2.3.2 搭建基础环境)

-

- [2.3.2.1 安装环境](#2.3.2.1 安装环境)

- [2.3.2.2 创建数据库和表](#2.3.2.2 创建数据库和表)

- [2.3.2.3 创建SpringBoot程序](#2.3.2.3 创建SpringBoot程序)

-

- 2) 引入依赖 引入依赖)

- 3) 创建实体类 创建实体类)

- 4) 创建Mapper 创建Mapper)

- [2.3.3 实现垂直分库](#2.3.3 实现垂直分库)

-

- [2.3.3.1 配置文件](#2.3.3.1 配置文件)

- [2.3.3.2 垂直分库测试](#2.3.3.2 垂直分库测试)

- [2.3.4 实现水平分表](#2.3.4 实现水平分表)

-

- [2.3.4.1 数据准备](#2.3.4.1 数据准备)

- [2.3.4.2 配置文件](#2.3.4.2 配置文件)

- [2.3.4.3 测试](#2.3.4.3 测试)

- [2.3.4.4 行表达式](#2.3.4.4 行表达式)

- [2.3.4.5 配置分片策略](#2.3.4.5 配置分片策略)

- [2.3.4.6 分布式序列算法](#2.3.4.6 分布式序列算法)

- [2.3.5 实现水平分库](#2.3.5 实现水平分库)

-

- [2.3.5.1 数据准备](#2.3.5.1 数据准备)

- [2.3.5.2 配置文件](#2.3.5.2 配置文件)

- [2.3.5.3 水平分库测试](#2.3.5.3 水平分库测试)

- [2.3.5.4 水平分库查询](#2.3.5.4 水平分库查询)

- [2.3.5.5 分片算法HASH_MOD和MOD](#2.3.5.5 分片算法HASH_MOD和MOD)

- [2.3.5.6 水平分库总结](#2.3.5.6 水平分库总结)

- [2.3.6 实现绑定表](#2.3.6 实现绑定表)

-

- [2.3.6.1 数据准备](#2.3.6.1 数据准备)

- [2.3.6.2 创建实体类](#2.3.6.2 创建实体类)

- [2.3.6.3 创建mapper](#2.3.6.3 创建mapper)

- [2.3.6.4 配置多表关联](#2.3.6.4 配置多表关联)

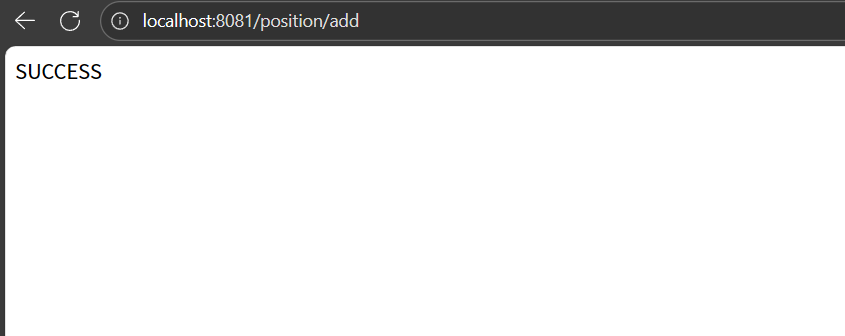

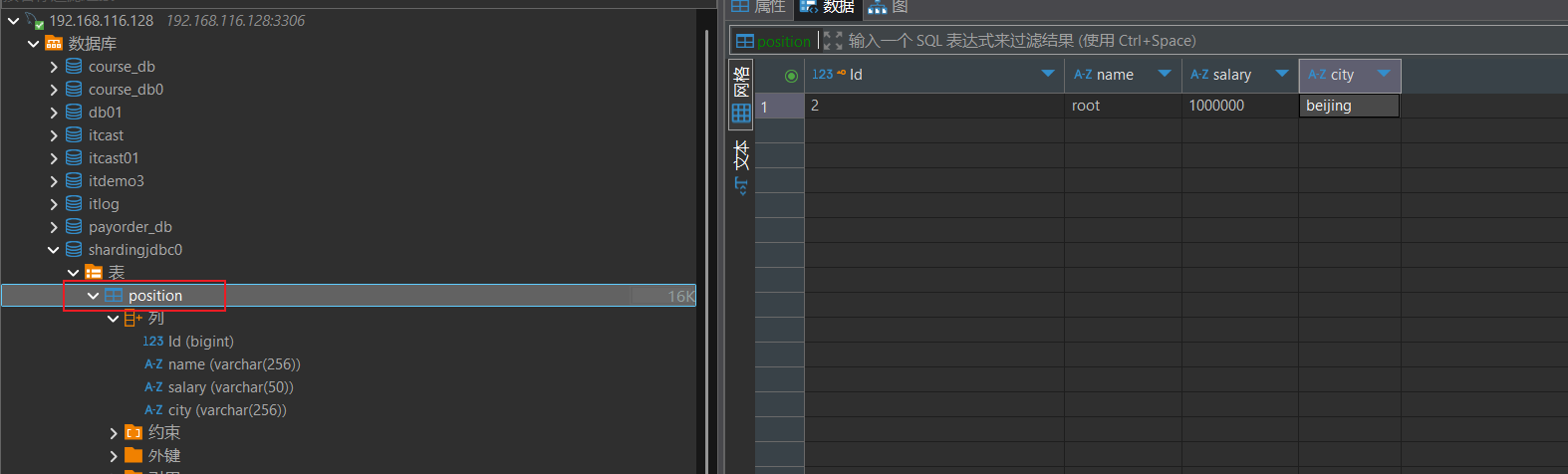

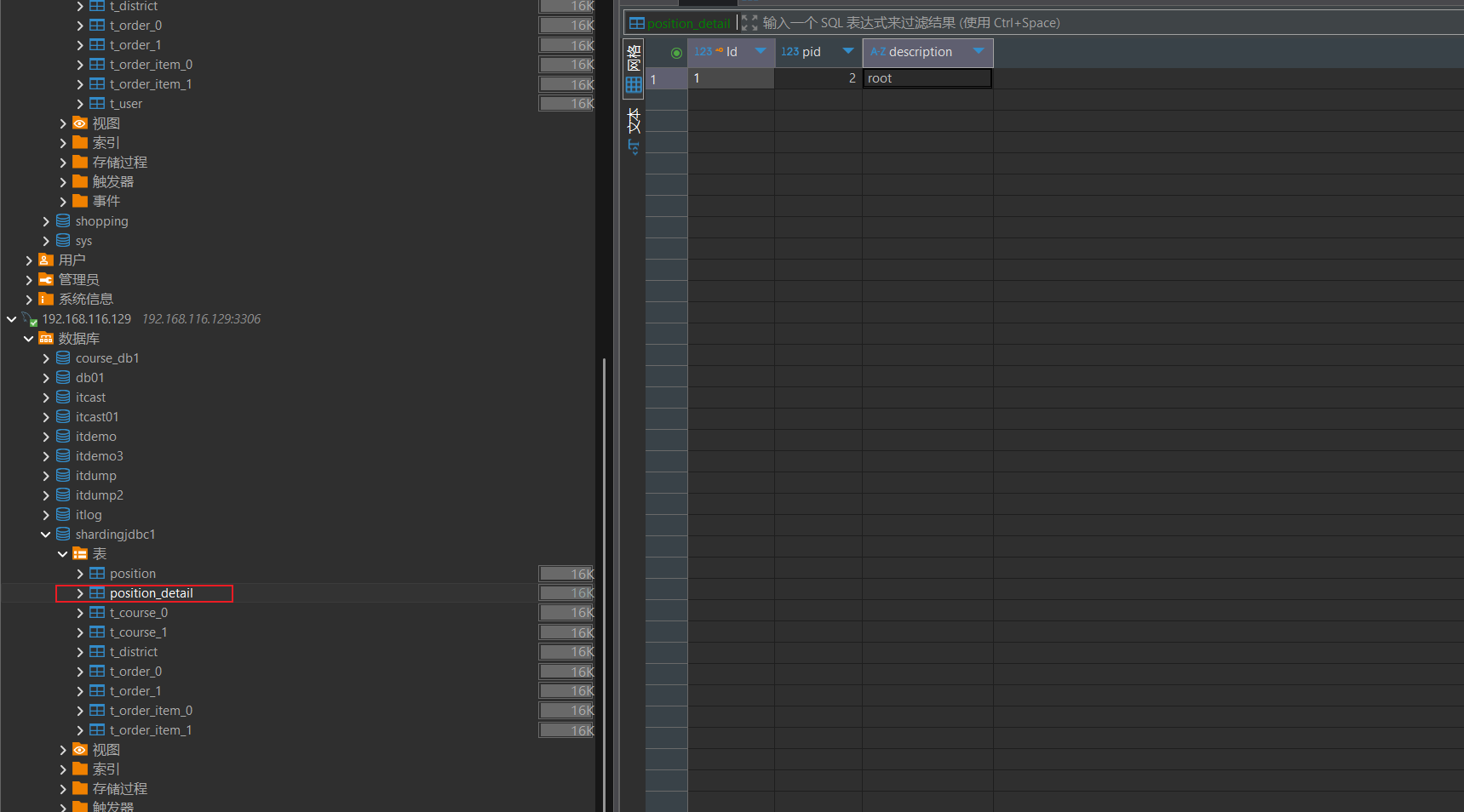

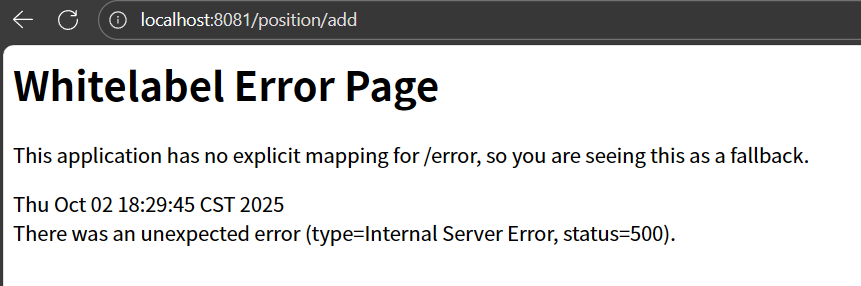

- [2.3.6.5 测试插入数据](#2.3.6.5 测试插入数据)

- [2.3.6.6 配置绑定表](#2.3.6.6 配置绑定表)

- [2.3.6.7 总结](#2.3.6.7 总结)

- [2.3.7 实现广播表(公共表)](#2.3.7 实现广播表(公共表))

-

- [2.3.7.1 公共表介绍](#2.3.7.1 公共表介绍)

- [2.3.7.2 代码编写](#2.3.7.2 代码编写)

- [2.3.7.3 广播表配置](#2.3.7.3 广播表配置)

- [2.3.7.4 测试广播表](#2.3.7.4 测试广播表)

- [2.3.7.5 总结](#2.3.7.5 总结)

- [2.4 读写分离详解与实战](#2.4 读写分离详解与实战)

-

- [2.4.1 读写分离架构介绍](#2.4.1 读写分离架构介绍)

-

- [2.4.1.1 读写分离原理](#2.4.1.1 读写分离原理)

- [2.4.1.2 读写分离应用方案](#2.4.1.2 读写分离应用方案)

- [2.4.2 CAP 理论](#2.4.2 CAP 理论)

-

- [2.4.2.1 CAP理论介绍](#2.4.2.1 CAP理论介绍)

- [2.4.2.2 CAP理论特点](#2.4.2.2 CAP理论特点)

- [2.4.2.3 分布式数据库对于CAP理论的实践](#2.4.2.3 分布式数据库对于CAP理论的实践)

- [2.4.3 MySQL主从同步](#2.4.3 MySQL主从同步)

-

- [2.4.3.1 主从同步原理](#2.4.3.1 主从同步原理)

- [2.4.3.2 一主一从架构搭建](#2.4.3.2 一主一从架构搭建)

- [2.4.4 Sharding-JDBC实现读写分离](#2.4.4 Sharding-JDBC实现读写分离)

-

- [2.4.4.1 数据准备](#2.4.4.1 数据准备)

- [2.4.4.2 环境准备](#2.4.4.2 环境准备)

-

- 1) 创建实体类 创建实体类)

- 2) 创建Mapper 创建Mapper)

- [2.4.4.3 配置读写分离](#2.4.4.3 配置读写分离)

- [2.4.4.4 读写分离测试](#2.4.4.4 读写分离测试)

- [2.4.4.5 事务读写分离测试](#2.4.4.5 事务读写分离测试)

- [2.4.5 负载均衡算法](#2.4.5 负载均衡算法)

-

- [2.4.5.1 一主两从架构](#2.4.5.1 一主两从架构)

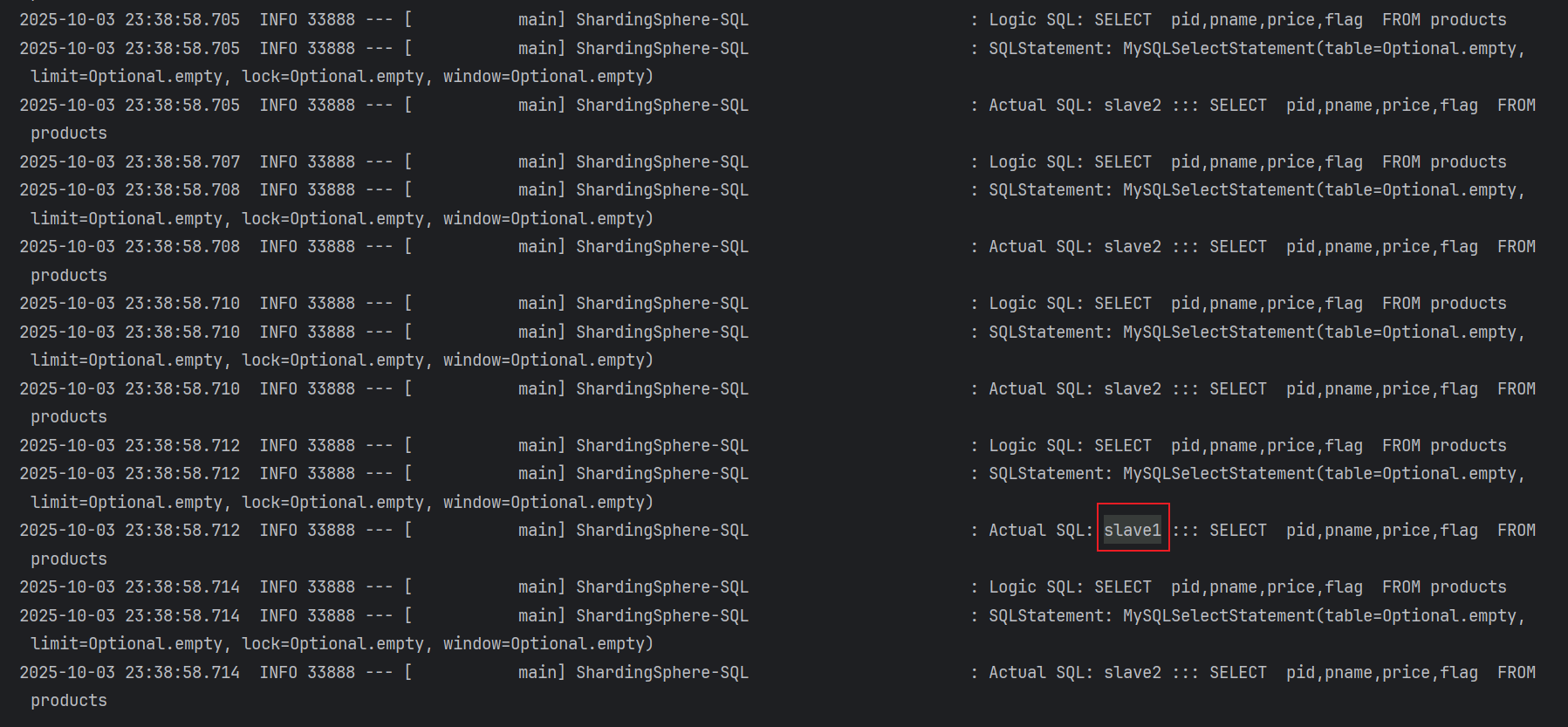

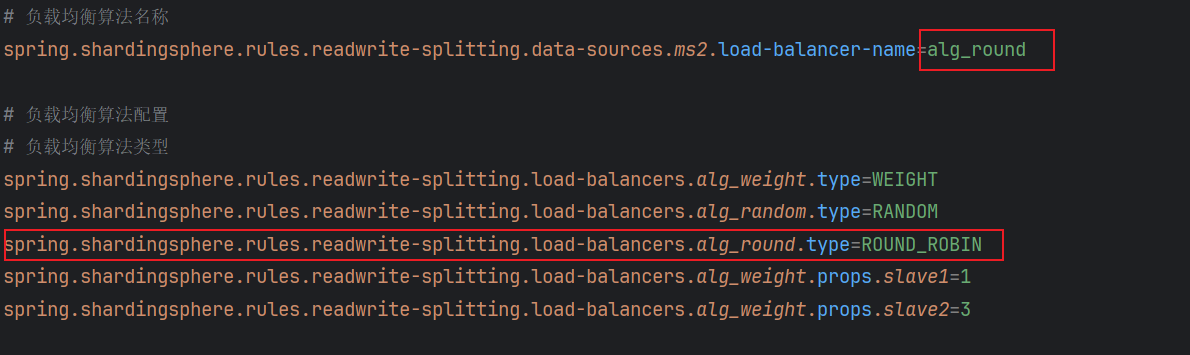

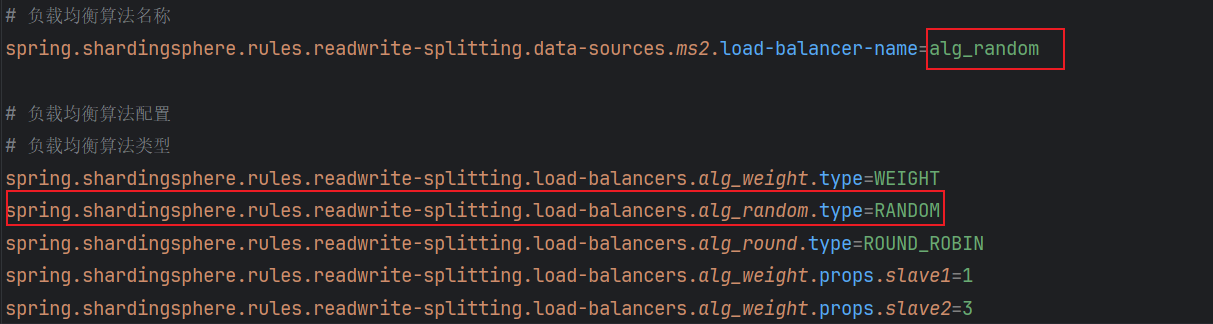

- [2.4.5.2 负载均衡测试](#2.4.5.2 负载均衡测试)

- [2.5 强制路由详解与实战](#2.5 强制路由详解与实战)

-

- [2.5.1 强制路由介绍](#2.5.1 强制路由介绍)

- [2.5.2 强制路由的使用](#2.5.2 强制路由的使用)

-

- [2.5.2.1 环境准备](#2.5.2.1 环境准备)

- [2.5.2.2 代码编写](#2.5.2.2 代码编写)

- [2.5.2.3 配置文件](#2.5.2.3 配置文件)

- [2.5.2.4 强制路由到库到表测试](#2.5.2.4 强制路由到库到表测试)

- [2.5.2.5 强制路由到库到表查询测试](#2.5.2.5 强制路由到库到表查询测试)

- [2.5.2.6 强制路由走主库查询测试](#2.5.2.6 强制路由走主库查询测试)

- [2.5.2.7 SQL执行流程剖析](#2.5.2.7 SQL执行流程剖析)

- [2.6 数据加密详解与实战](#2.6 数据加密详解与实战)

-

- [2.6.1 数据加密介绍](#2.6.1 数据加密介绍)

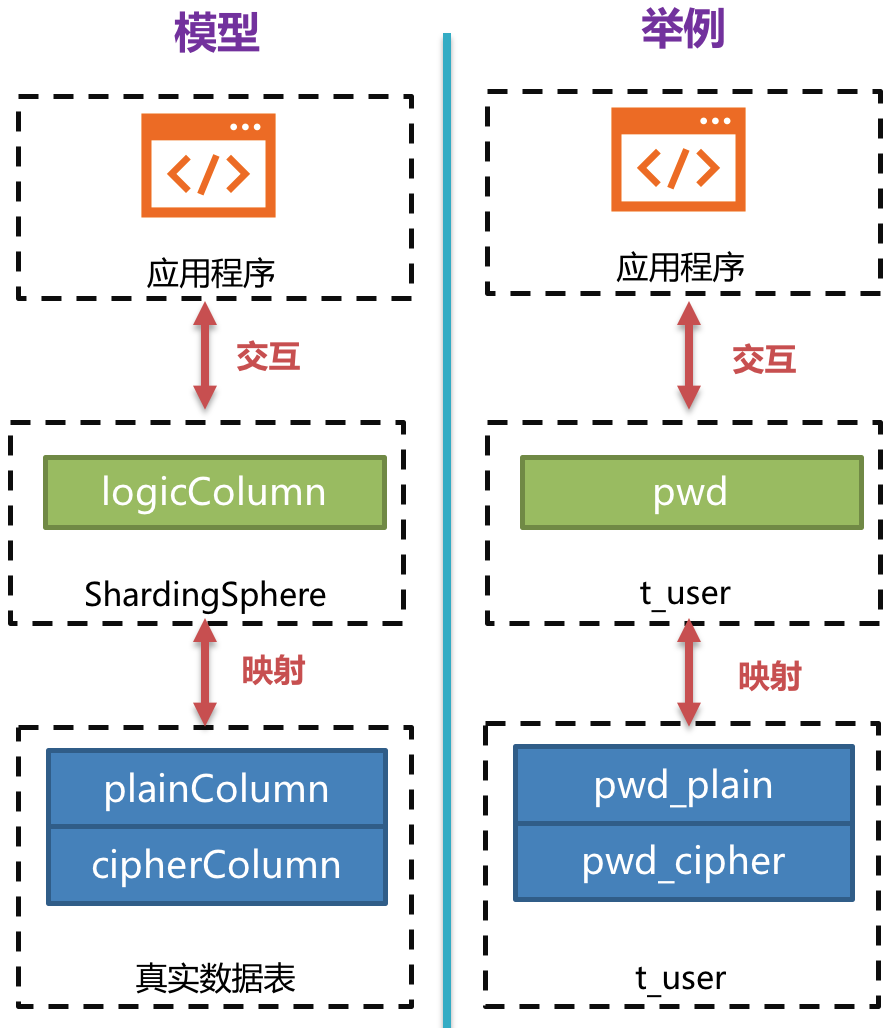

- [2.6.2 整体架构](#2.6.2 整体架构)

- [2.6.3 加密规则](#2.6.3 加密规则)

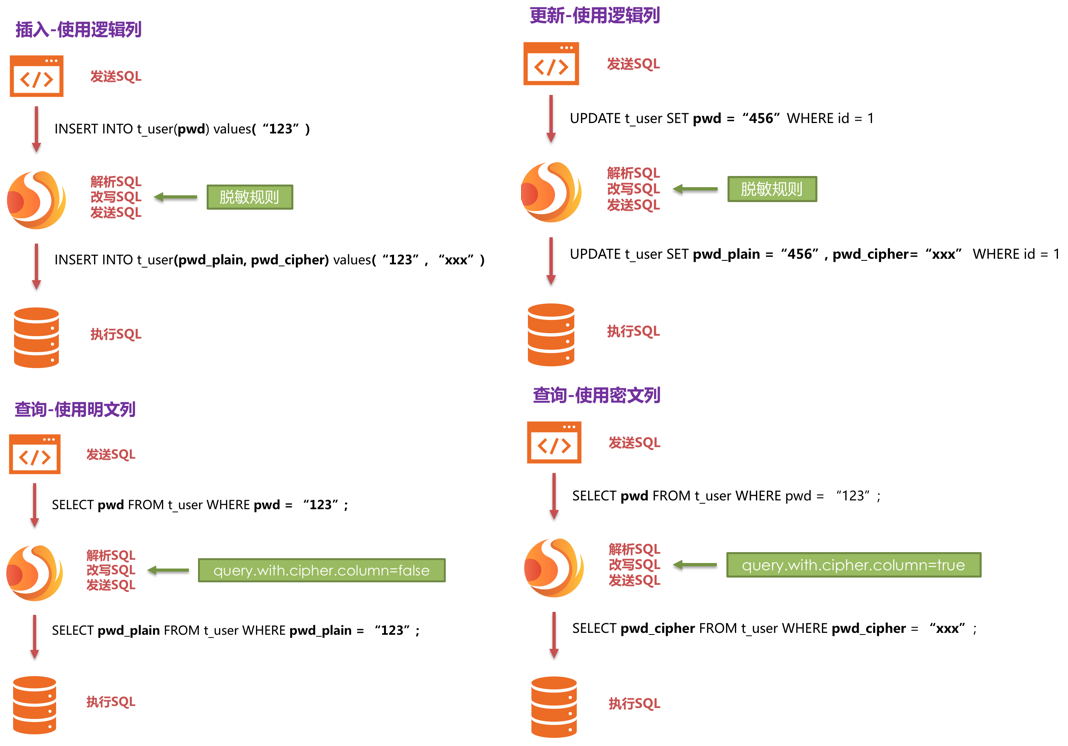

- [2.6.4 脱敏处理流程](#2.6.4 脱敏处理流程)

- [2.6.5 数据加密实战](#2.6.5 数据加密实战)

-

- [2.6.5.1 环境搭建](#2.6.5.1 环境搭建)

- [2.6.5.2 加密策略解析](#2.6.5.2 加密策略解析)

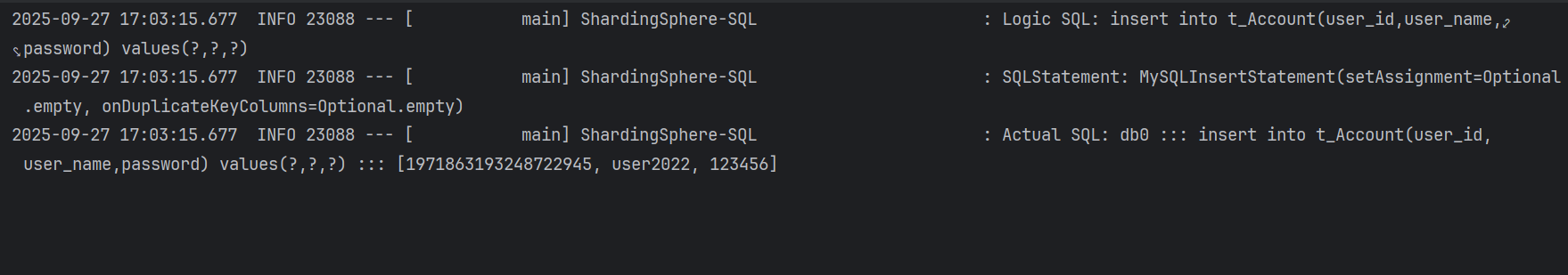

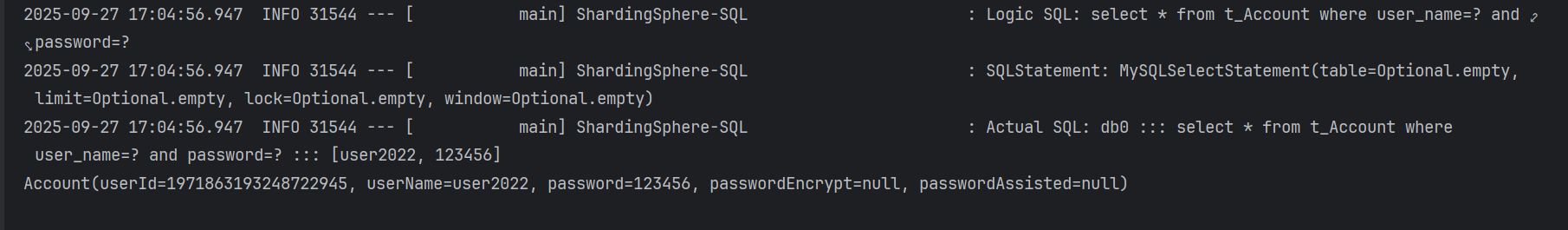

- [2.6.5.3 默认AES加密算法实现](#2.6.5.3 默认AES加密算法实现)

- [2.6.5.4 MD5加密算法实现](#2.6.5.4 MD5加密算法实现)

- [2.7 分布式事务详解与实战](#2.7 分布式事务详解与实战)

-

- [2.7.1 什么是分布式事务](#2.7.1 什么是分布式事务)

-

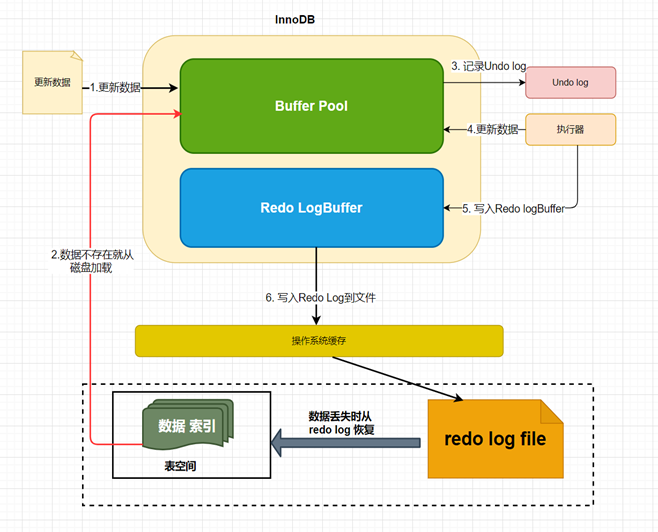

- [2.7.1.1 本地事务介绍](#2.7.1.1 本地事务介绍)

- [2.7.1.2 事务日志undo和redo](#2.7.1.2 事务日志undo和redo)

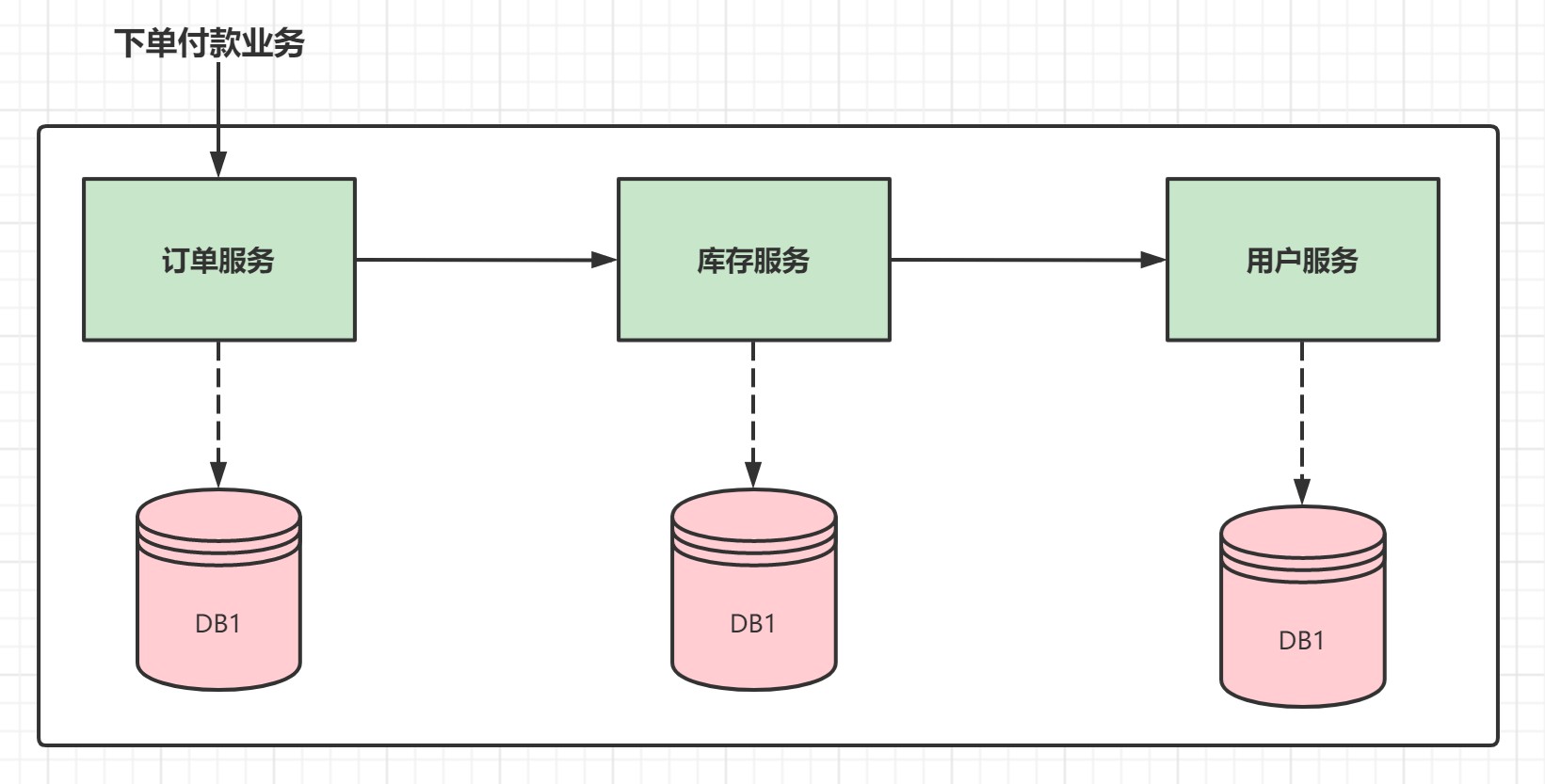

- [2.7.1.3 分布式事务介绍](#2.7.1.3 分布式事务介绍)

- [2.7.2 分布式事务理论](#2.7.2 分布式事务理论)

-

- [2.7.2.1 CAP (强一致性)](#2.7.2.1 CAP (强一致性))

- [2.7.2.2 BASE(最终一致性)](#2.7.2.2 BASE(最终一致性))

- [2.7.3 分布式事务模式(大概了解)](#2.7.3 分布式事务模式(大概了解))

-

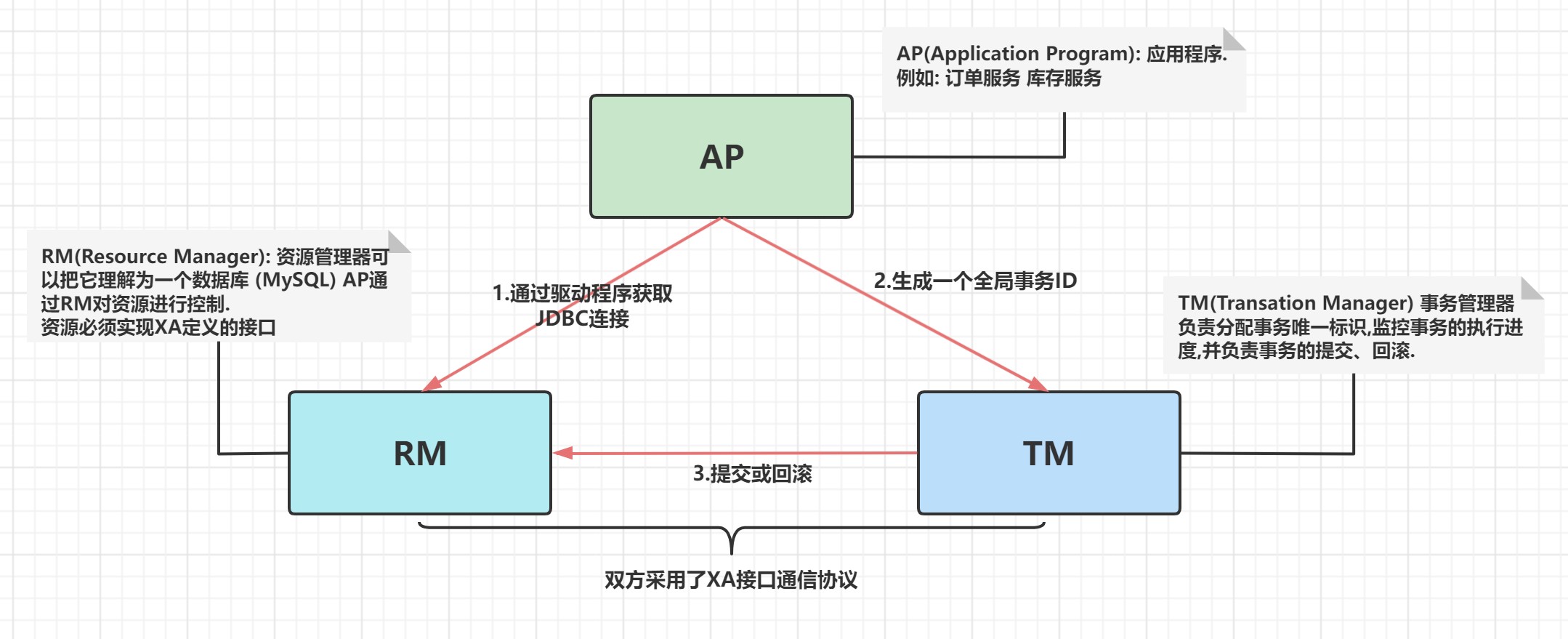

- [2.7.3.1 DTP模型与XA协议](#2.7.3.1 DTP模型与XA协议)

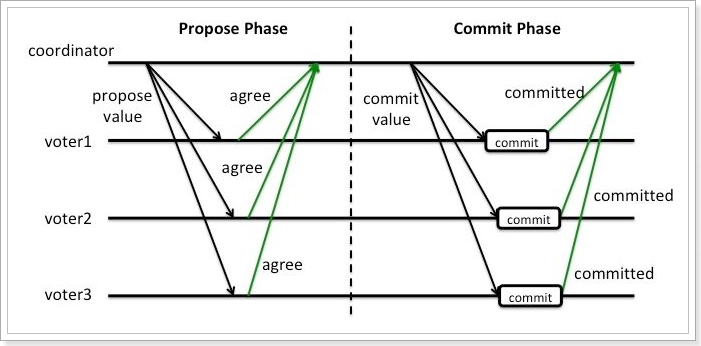

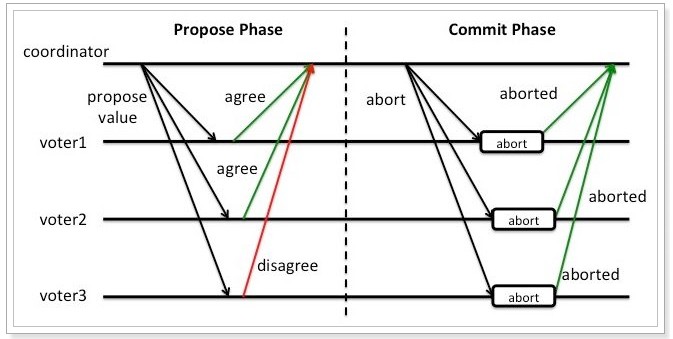

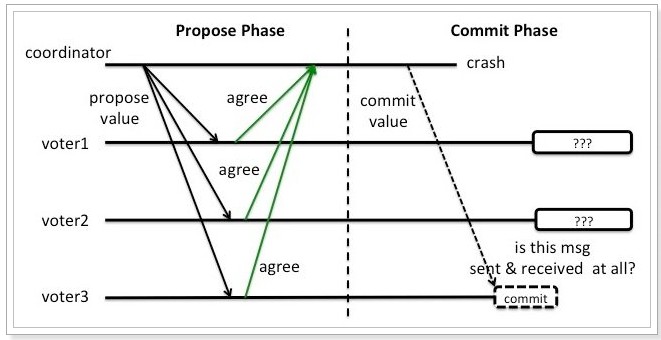

- [2.7.3.2 2PC模式 (强一致性)](#2.7.3.2 2PC模式 (强一致性))

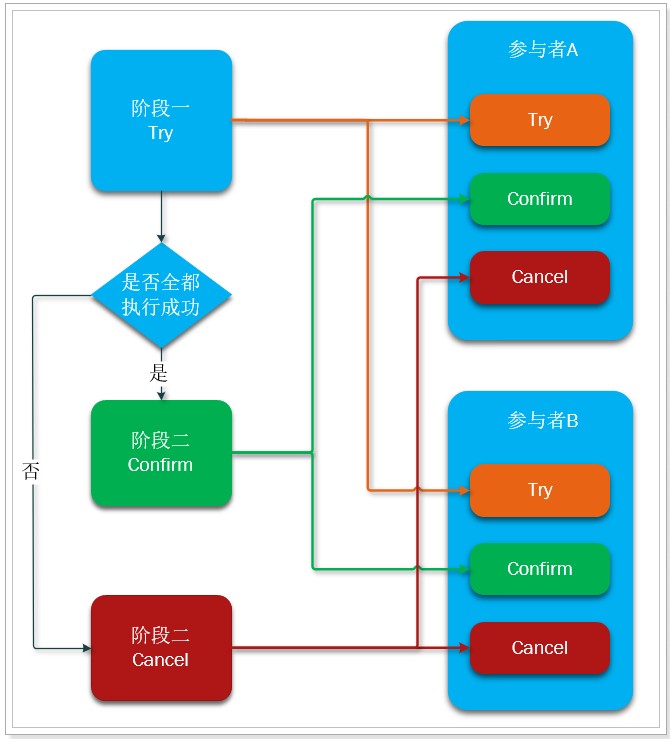

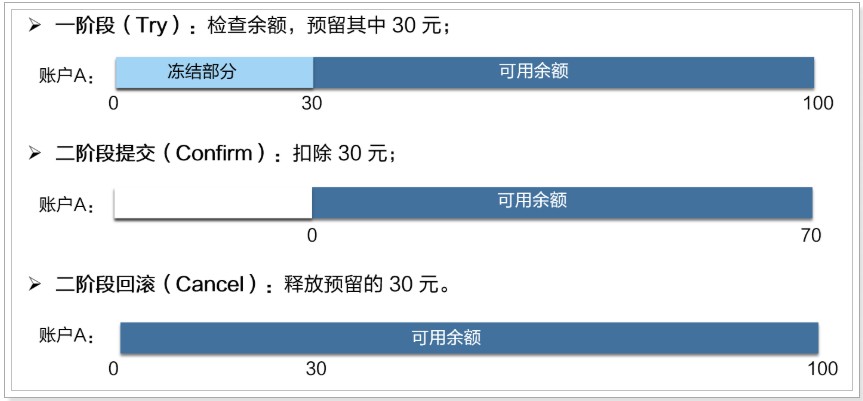

- [2.7.3.3 TCC模式 (最终一致性)](#2.7.3.3 TCC模式 (最终一致性))

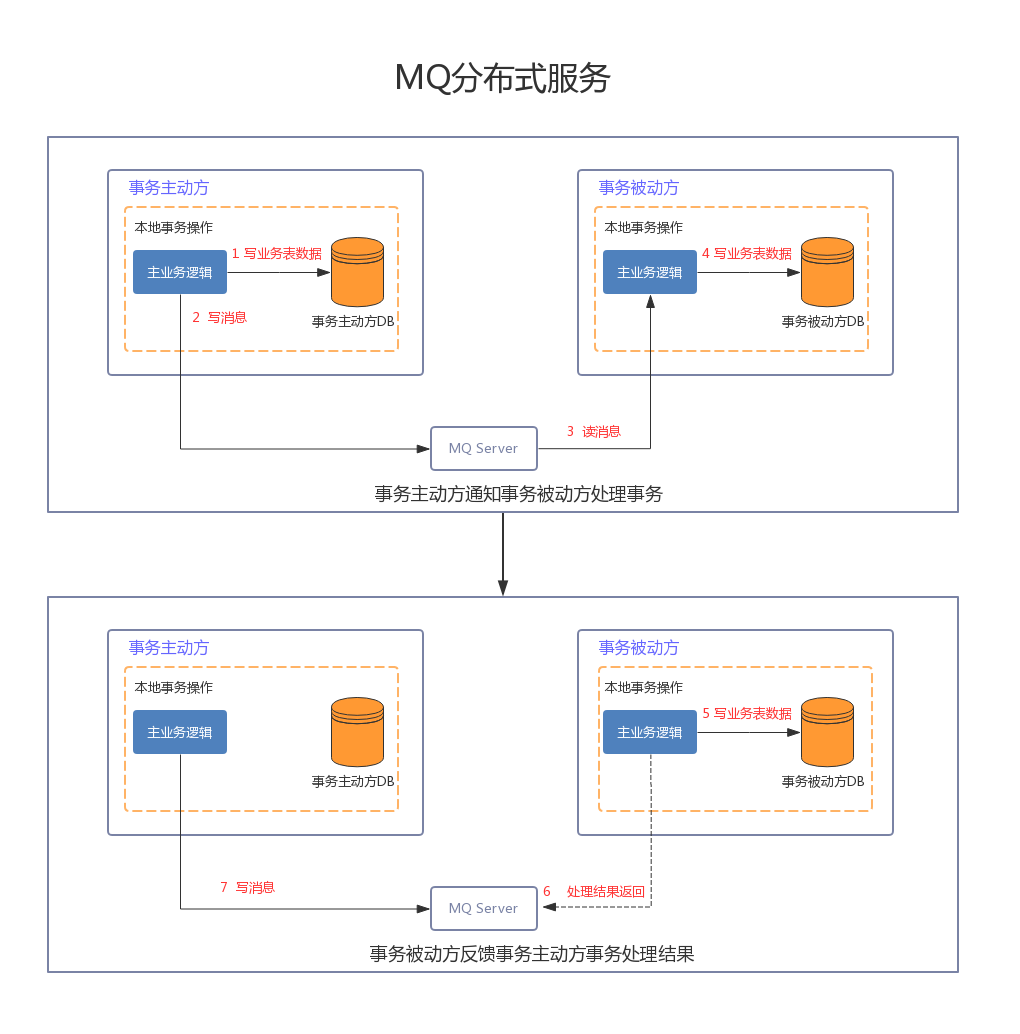

- [2.7.3.4 消息队列模式(最终一致性)](#2.7.3.4 消息队列模式(最终一致性))

- [2.7.3.5 AT模式 (最终一致性)](#2.7.3.5 AT模式 (最终一致性))

- [2.7.3.6 Saga模式(最终一致性)](#2.7.3.6 Saga模式(最终一致性))

- [2.7.4 Sharding-JDBC分布式事务实战](#2.7.4 Sharding-JDBC分布式事务实战)

-

- [2.7.4.1 Sharding-JDBC分布式事务介绍](#2.7.4.1 Sharding-JDBC分布式事务介绍)

- [2.7.4.2 环境准备](#2.7.4.2 环境准备)

- [2.7.4.3 案例实现](#2.7.4.3 案例实现)

- [2.7.4.4 案例测试](#2.7.4.4 案例测试)

- [2.8 ShardingProxy实战](#2.8 ShardingProxy实战)

-

- [2.8.1 使用二进制发布包安装ShardingSphere-Proxy](#2.8.1 使用二进制发布包安装ShardingSphere-Proxy)

- [2.8.2 proxy实现读写分离](#2.8.2 proxy实现读写分离)

- [2.8.3 使用应用程序连接proxy](#2.8.3 使用应用程序连接proxy)

- [2.8.4 Proxy实现垂直分片](#2.8.4 Proxy实现垂直分片)

- [2.8.5 Proxy实现水平分片](#2.8.5 Proxy实现水平分片)

- [2.8.6 Proxy实现广播表](#2.8.6 Proxy实现广播表)

- [2.8.7 Proxy实现绑定表](#2.8.7 Proxy实现绑定表)

- [2.8.8 总结](#2.8.8 总结)

Apache ShardingSphere实战

1.数据库架构演变与分库分表介绍

1.1 海量数据存储问题及解决方案

如今随着互联网的发展,数据的量级也是成指数的增长,从GB到TB到PB。对数据的各种操作也是愈加的困难,传统单体的关系性数据库已经无法满足快速查询与插入数据的需求。

阿里数据中心内景( 阿里、百度、腾讯这样的互联网巨头,数据量据说已经接近EB级)

事务安全性,NOSQL数据库对事务的支持不完善. MySQL不可替代.

遇到的问题

- 用户请求量大

- 单库的数据量过大

- 单表的数据量过大

解决方案

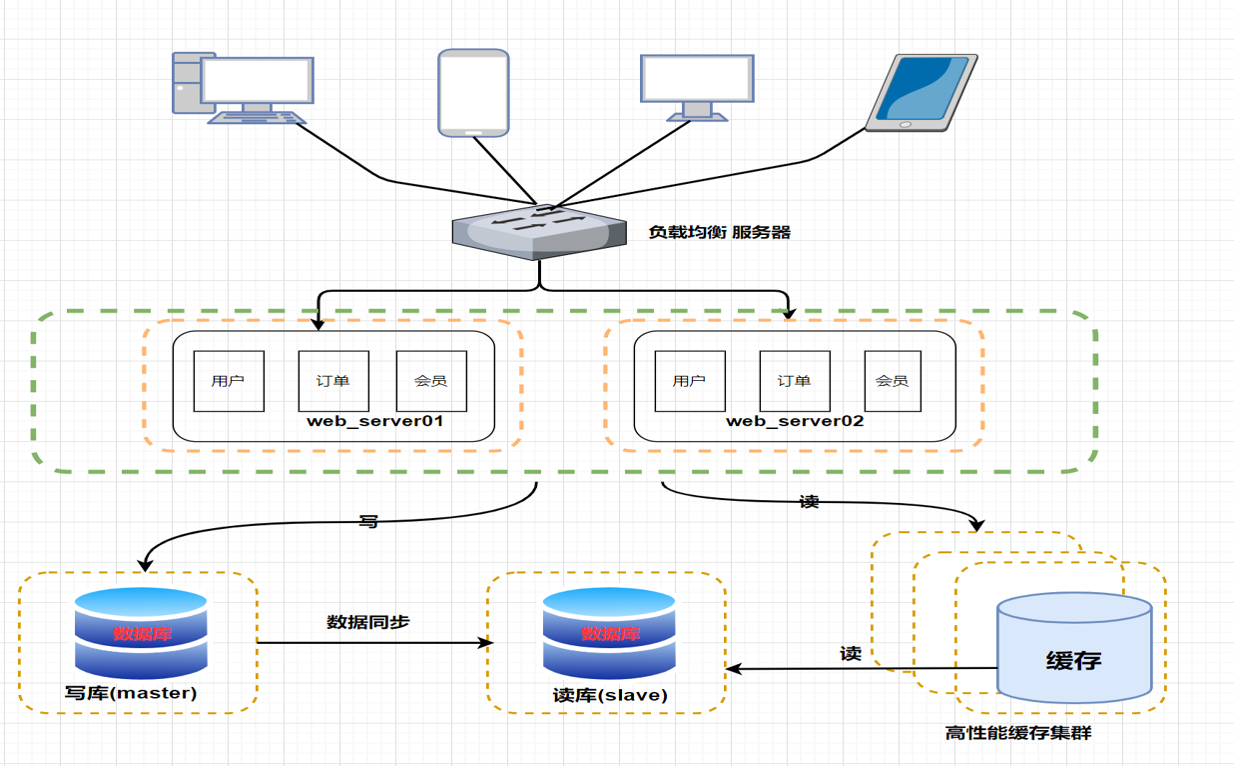

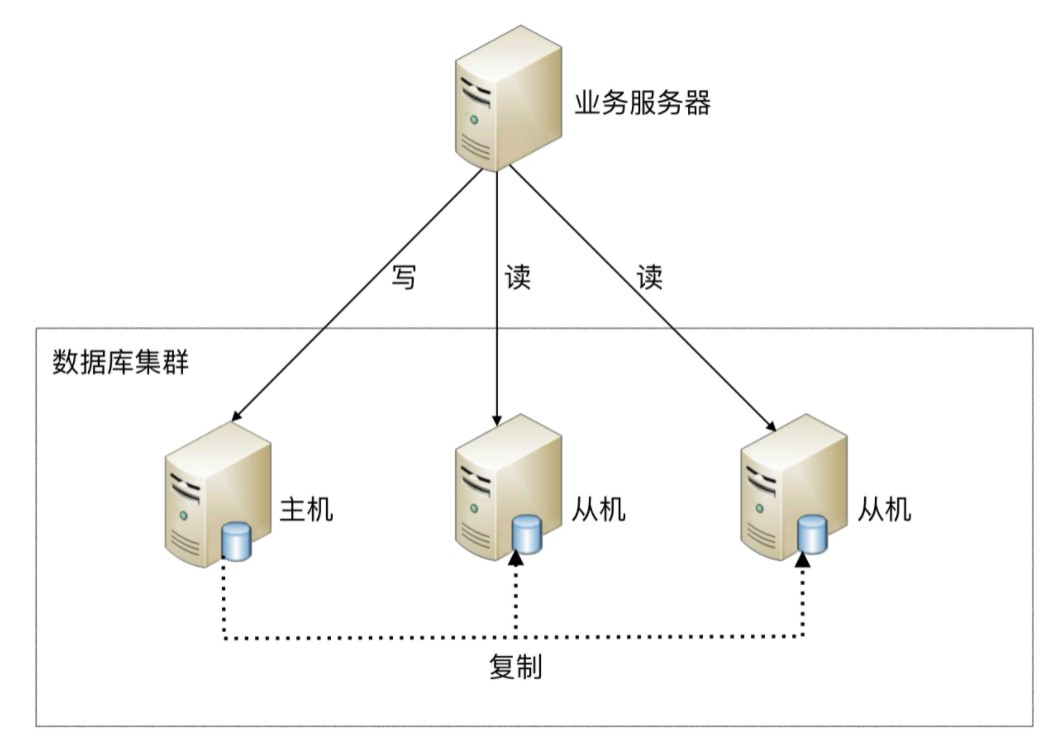

- 单机数据库 --> 主从架构 ---> 分库分表

1.2 项目架构的演进

1.2.1 理财平台 - V1.0

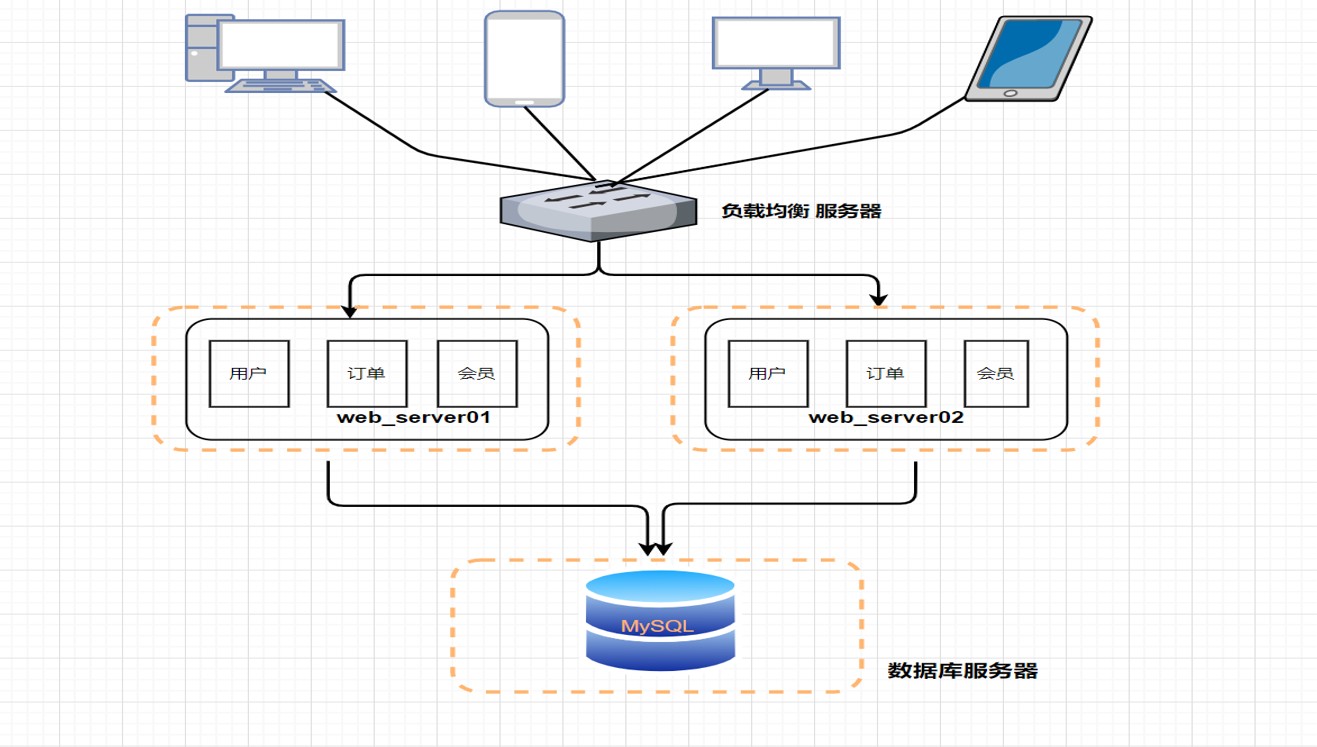

此时项目是一个单体应用架构 (一个归档包(可以是JAR、WAR、EAR或其它归档格式)包含所有功能的应用程序,通常称为单体应用)

这个阶段是公司发展的早期阶段,系统架构如上图所示。我们经常会在单台服务器上运行我们所有的程序和软件。

在项目运行初期,User表、Order表、等等各种表都在同一个数据库中,每个表都包含了大量的字段。在用户量比较少,访问量也比较少的时候,单库单表不存在问题。

这个阶段一般是属于业务规模不是很大的公司使用,因为机器都是单台的话,随着我们业务规模的增长,慢慢的我们的网站就会出现一些瓶颈和隐患问题

1.2.2 理财平台 - V1.x

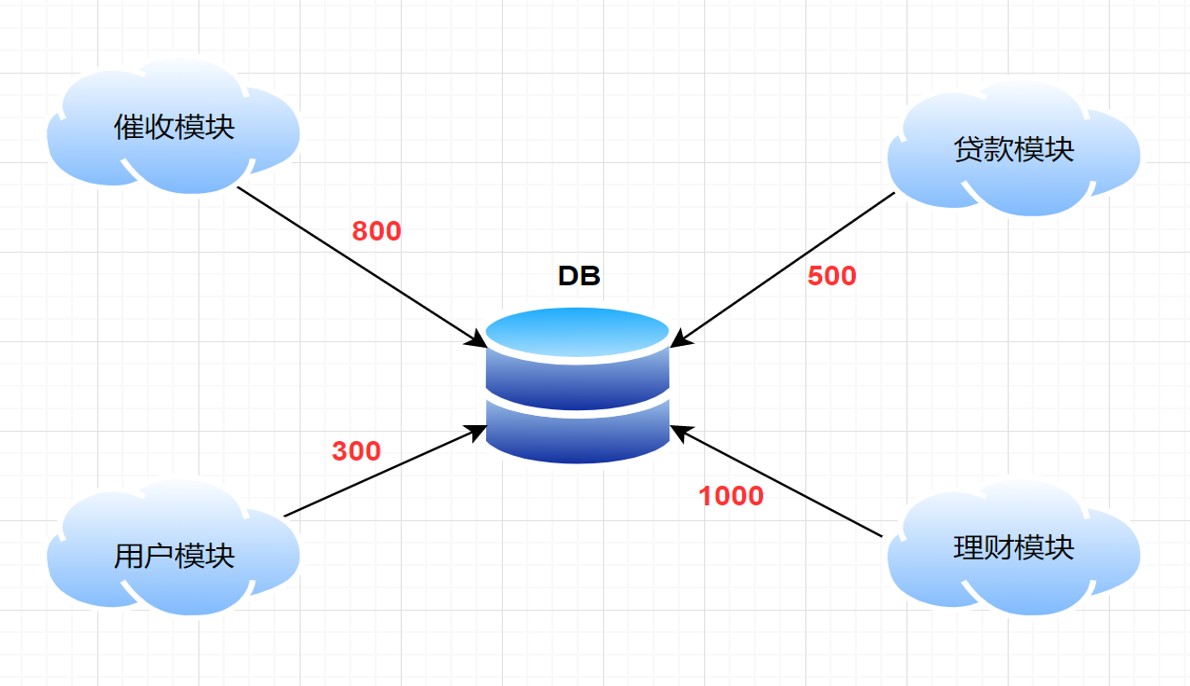

随着访问量的继续不断增加,单台应用服务器已经无法满足我们的需求。所以我们通过增 加应用服务器的方式来将服务器集群化。

存在的问题

采用了应用服务器高可用集群的架构之后,应用层的性能被我们拉上来了,但是数据库的负载也在增加,随着访问量的提高,所有的压力都将集中在数据库这一层.

1.2.3 理财平台-V2.0 版本

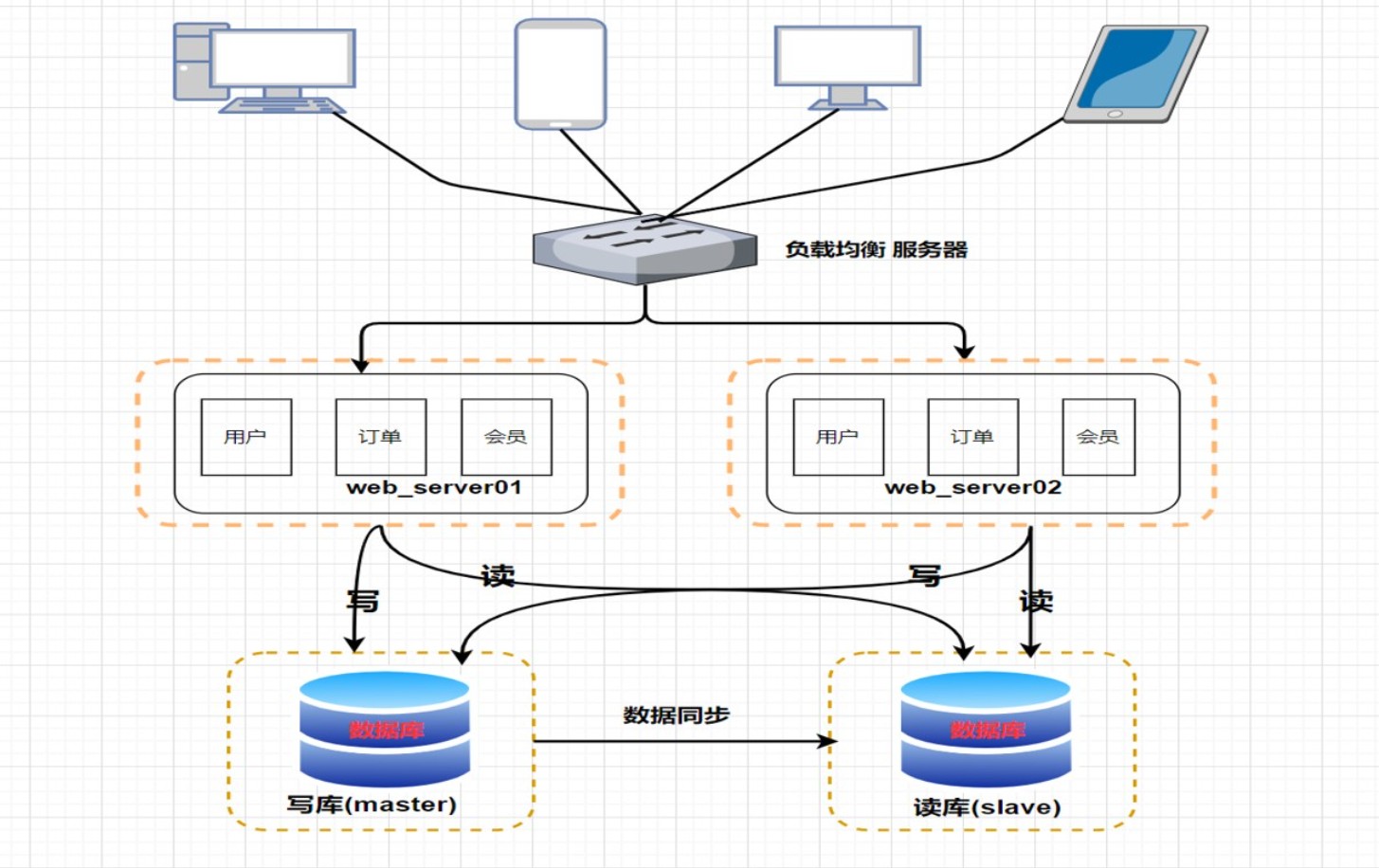

应用层的性能被我们拉上来了,但数据库的负载也在逐渐增大,那如何去提高数据库层面的性能呢?

- 数据库主从复制、读写分离

写10000 -> 3分钟, 读10000->5秒, 读操作占整体操作8成,写操作2成

读写分离的数据节点中的数据内容是一致。

使用主从复制+读写分离一定程度上可以解决问题,但是随着用户量的增加、访问量的增加、数据量的增加依然会带来大量的问题.

1.2.4 理财平台-V2.x 版本

随着访问量的持续不断增加,慢慢的我们的系统项目会出现许多用户访问同一内容的情况,比如秒杀活动,抢购活动等。

那么对于这些热点数据的访问,没必要每次都从数据库重读取,这时我们可以使用到缓存技术,比如 redis、memcache 来作为我们应用层的缓存。

- 数据库主从复制、读写分离 +缓存技术

存在的问题

- 缓存只能缓解读取压力,数据库的写入压力还是很大

- 且随着数据量的继续增大,性能还是很缓慢

我们的系统架构从单机演变到这个阶,所有的数据都还在同一个数据库中,尽管采取了增加缓存,主从、读写分离的方式,但是随着数据库的压力持续增加,数据库的瓶颈仍然是个最大的问题。因此我们可以考虑对数据的垂直拆分和水平拆分。就是今天所讲的主题,分库分表。

1.5 分库分表

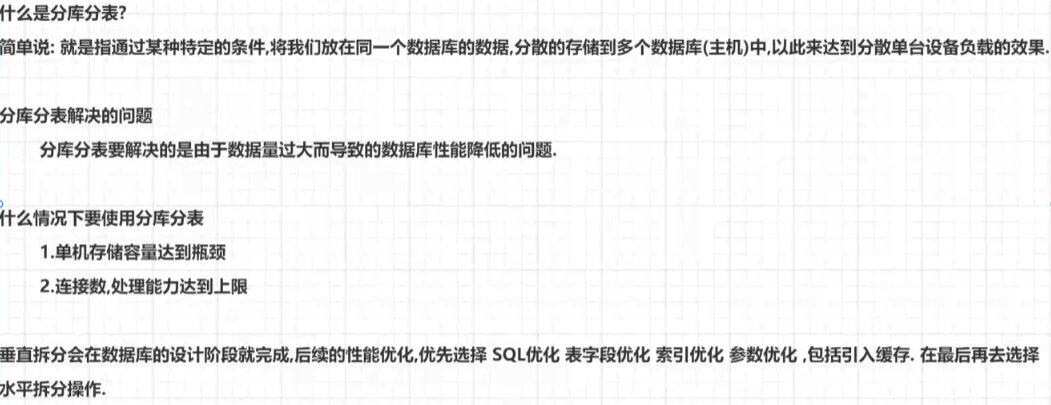

1.5.1 什么是分库分表

简单来说,就是指通过某种特定的条件,将我们存放在同一个数据库中的数据分散存放到多个数据库(主机)上面,以达到分散单台设备负载的效果。

-

分库分表解决的问题 ?

-

什么情况下需要分库分表

1.5.2 分库分表的方式

分库分表包括: 垂直分库、垂直分表、水平分库、水平分表 四种方式。

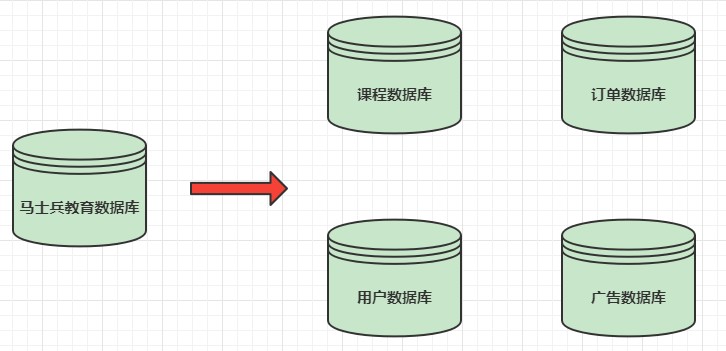

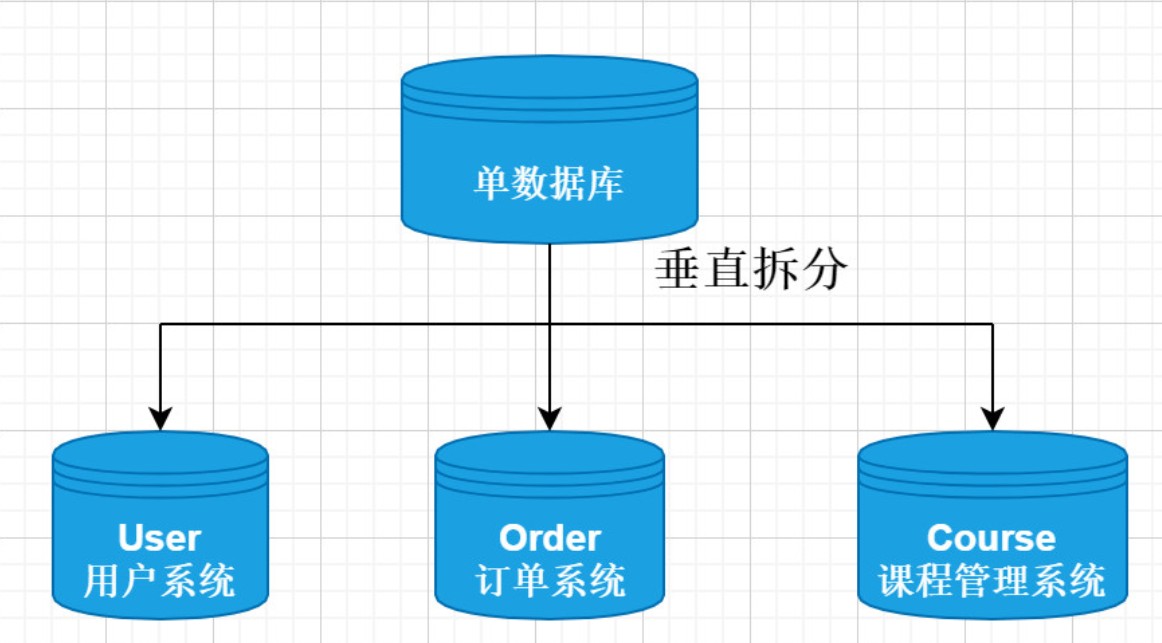

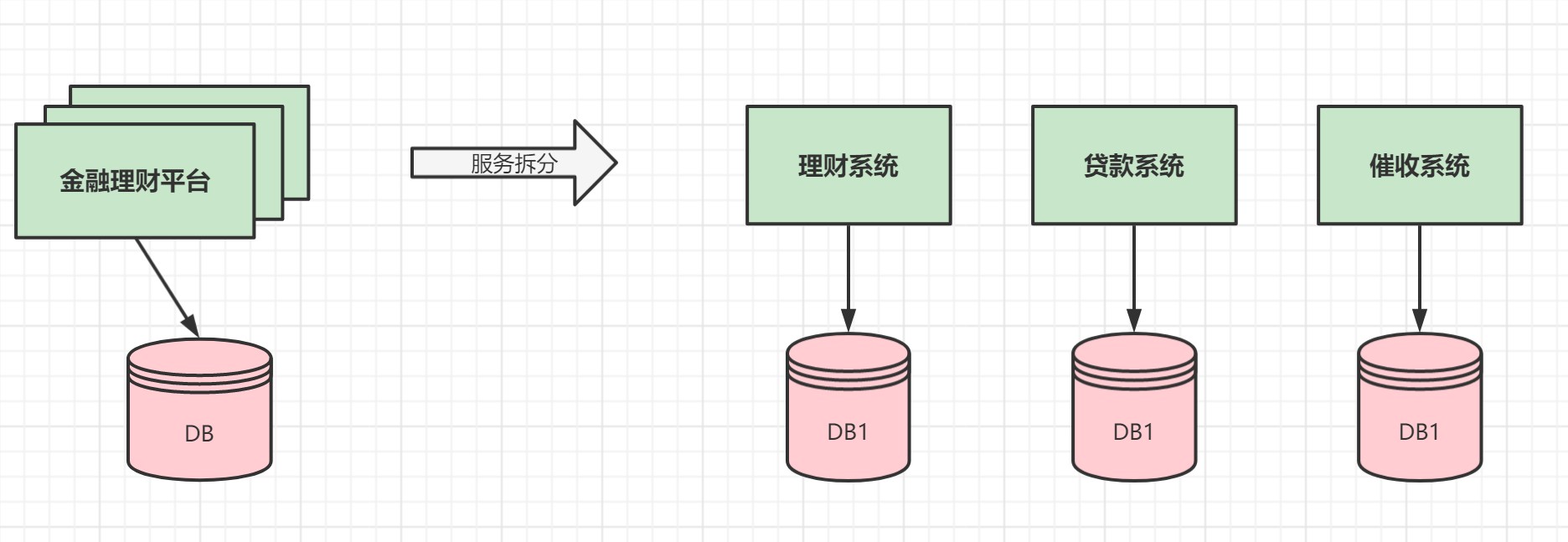

1.5.2.1 垂直分库

- 数据库中不同的表对应着不同的业务,垂直切分是指按照业务的不同将表进行分类,分布到不同的数据库上面

-

将数据库部署在不同服务器上,从而达到多个服务器共同分摊压力的效果

-

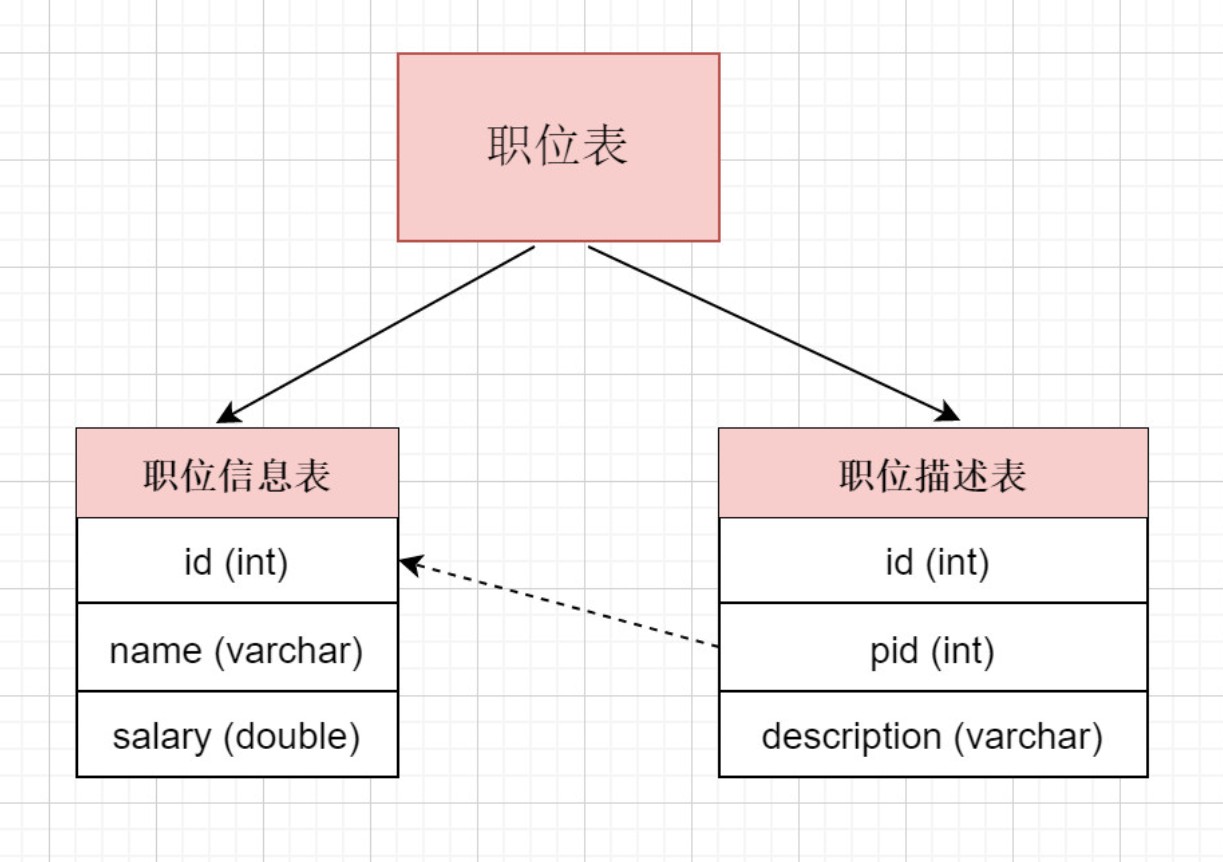

1.5.2.2 垂直分表

表中字段太多且包含大字段的时候,在查询时对数据库的IO、内存会受到影响,同时更新数据时,产生的binlog文件会很大,MySQL在主从同步时也会有延迟的风险

-

将一个表按照字段分成多表,每个表存储其中一部分字段。

-

对职位表进行垂直拆分, 将职位基本信息放在一张表, 将职位描述信息存放在另一张表

-

垂直拆分带来的一些提升

- 解决业务层面的耦合,业务清晰

- 能对不同业务的数据进行分级管理、维护、监控、扩展等

- 高并发场景下,垂直分库一定程度的提高访问性能

-

垂直拆分没有彻底解决单表数据量过大的问题

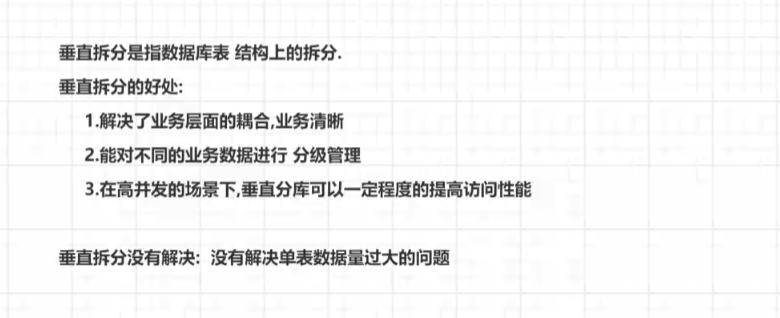

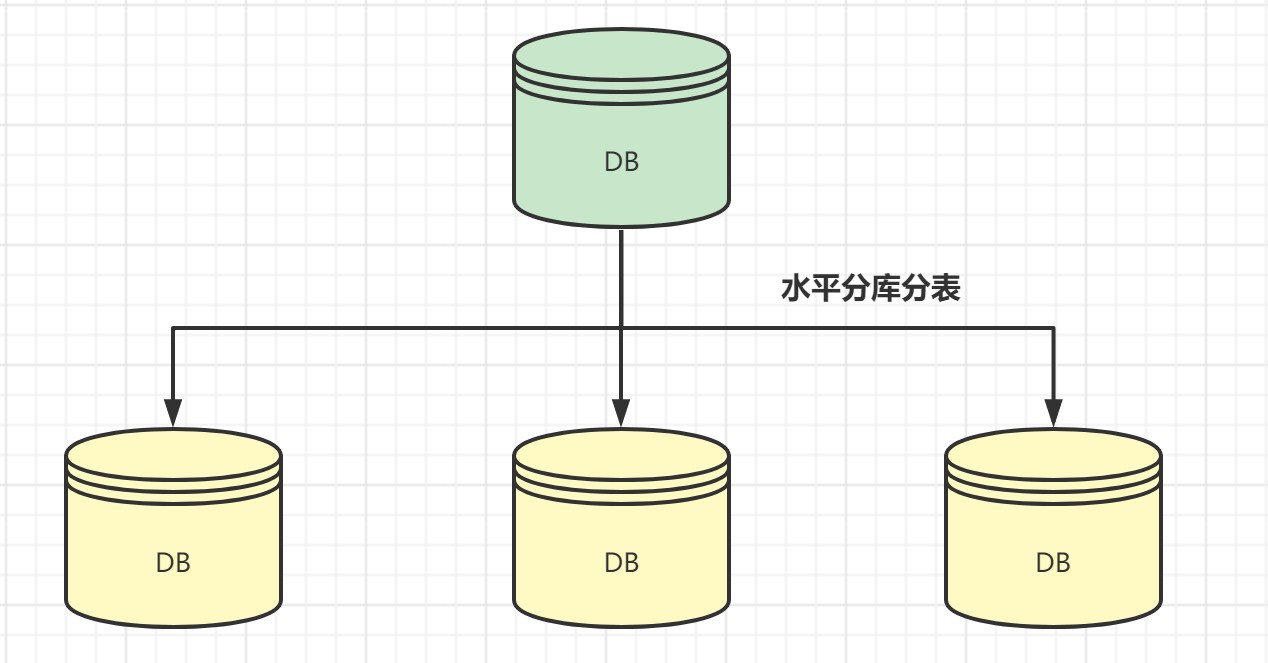

1.5.2.3 水平分库

- 将单张表的数据切分到多个服务器上去,每个服务器具有相应的库与表,只是表中数据集合不同。 水平分库分表能够有效的缓解单机和单库的性能瓶颈和压力,突破IO、连接数、硬件资源等的瓶颈.

- 简单讲就是根据表中的数据的逻辑关系,将同一个表中的数据按照某种条件拆分到多台数据库(主机)上面, 例如将订单表 按照id是奇数还是偶数, 分别存储在不同的库中。

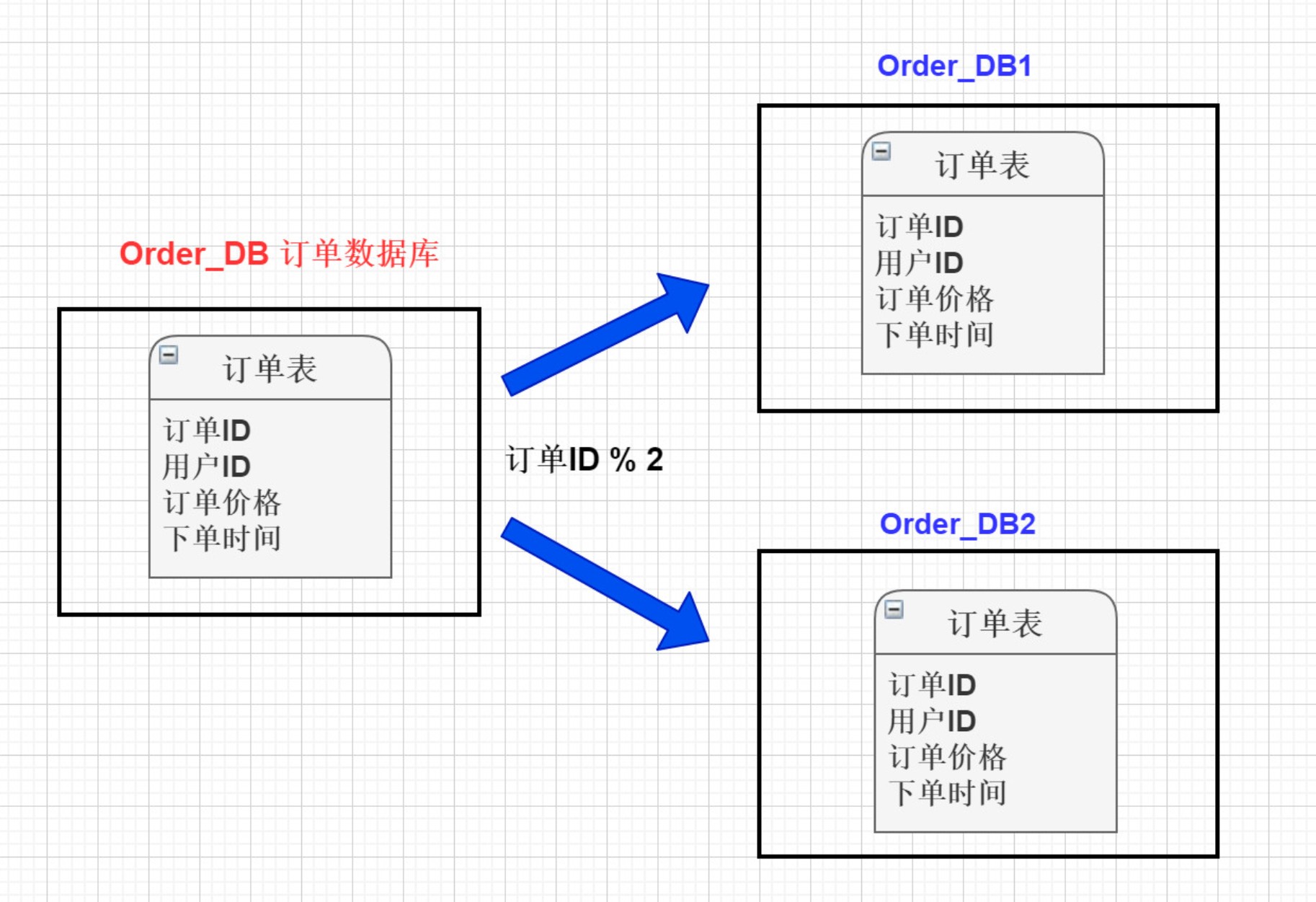

1.5.2.4 水平分表

- 针对数据量巨大的单张表(比如订单表),按照规则把一张表的数据切分到多张表里面去。 但是这些表还是在同一个库中,所以库级别的数据库操作还是有IO瓶颈。

- 总结

水平根据数据进行拆分

- **垂直分表**: 将一个表按照字段分成多表,每个表存储其中一部分字段。

- **垂直分库**: 根据表的业务不同,分别存放在不同的库中,这些库分别部署在不同的服务器.

- **水平分库**: 把一张表的数据按照一定规则,分配到**不同的数据库**,每一个库只有这张表的部分数据.

- **水平分表**: 把一张表的数据按照一定规则,分配到**同一个数据库的多张表中**,每个表只有这个表的部分数据.1.5.3 分库分表的规则

1) 水平分库规则

- 不跨库、不跨表,保证同一类的数据都在同一个服务器上面。

- 数据在切分之前,需要考虑如何高效的进行数据获取,如果每次查询都要跨越多个节点,就需要谨慎使用。

2) 水平分表规则

- RANGE

- 时间:按照年、月、日去切分。

- 地域:按照省或市去切分。

- 大小:从0到1000000一个表。

- HASH

- 用户ID取模

3) 不同的业务使用的切分规则是不一样,就上面提到的切分规则,举例如下:

- 用户表

- 范围法:以用户ID为划分依据,将数据水平切分到两个数据库实例,如:1到1000W在一张表,1000W到2000W在一张表,这种情况会出现单表的负载较高

- 按照用户ID HASH尽量保证用户数据均衡分到数据库中

- 流水表

- 时间维度:可以根据每天新增的流水来判断,选择按照年份分库,还是按照月份分库,甚至也可以按照日期分库

1.5.4 分库分表带来的问题及解决方案

关系型数据库在单机单库的情况下,比较容易出现性能瓶颈问题,分库分表可以有效的解决这方面的问题,但是同时也会产生一些 比较棘手的问题.

1) 事务一致性问题

- 当我们需要更新的内容同时分布在不同的库时, 不可避免的会产生跨库的事务问题. 原来在一个数据库操作, 本地事务就可以进行控制, 分库之后 一个请求可能要访问多个数据库,如何保证事务的一致性,目前还没有简单的解决方案.

2) 跨节点关联的问题

- 在分库之后, 原来在一个库中的一些表,被分散到多个库,并且这些数据库可能还不在一台服务器,无法关联查询.解决这种关联查询,需要我们在代码层面进行控制,将关联查询拆开执行,然后再将获取到的结果进行拼装.

3) 分页排序查询的问题

- 分库并行查询时,如果用到了分页 每个库返回的结果集本身是无序的, 只有将多个库中的数据先查出来,然后再根据排序字段在内存中进行排序,如果查询结果过大也是十分消耗资源的.

4) 主键避重问题

- 在分库分表的环境中,表中的数据存储在不同的数据库, 主键自增无法保证ID不重复, 需要单独设计全局主键.

5) 公共表的问题

- 不同的数据库,都需要从公共表中获取数据. 某一个数据库更新看公共表其他数据库的公共表数据需要进行同步.

上面我们说了分库分表后可能会遇到的一些问题, 接下来带着这些问题,我们就来一起来学习一下Apache ShardingSphere !

2.ShardingSphere实战

2.1 什么是ShardingSphere

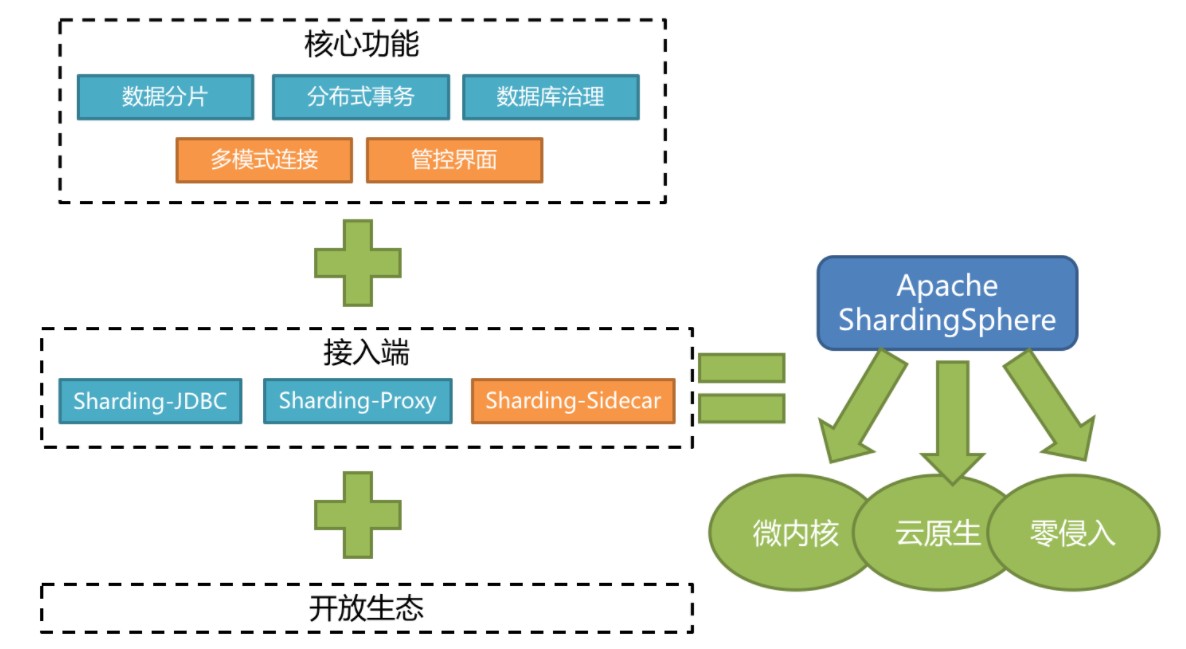

Apache ShardingSphere 是一款分布式的数据库生态系统, 可以将任意数据库转换为分布式数据库,并通过数据分片、弹性伸缩、加密等能力对原有数据库进行增强。

官网: https://shardingsphere.apache.org/document/current/cn/overview/

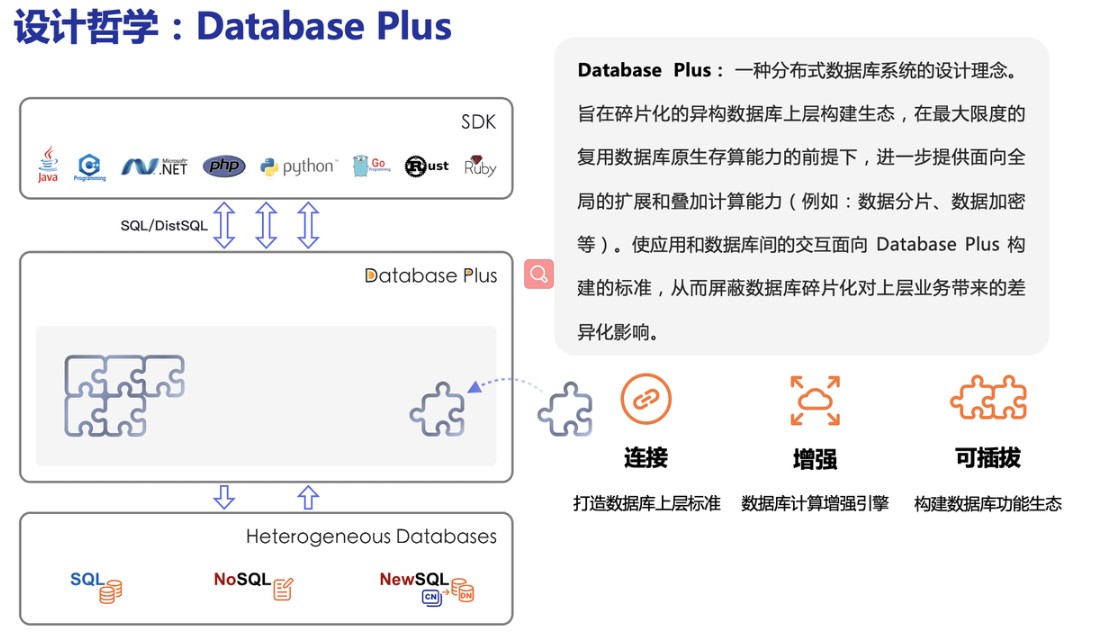

Apache ShardingSphere 设计哲学为 Database Plus,旨在构建异构数据库上层的标准和生态。 它关注如何充分合理地利用数据库的计算和存储能力,而并非实现一个全新的数据库。 它站在数据库的上层视角,关注它们之间的协作多于数据库自身。

Apache ShardingSphere它由Sharding-JDBC、Sharding-Proxy和Sharding-Sidecar(规划中)这3款相互独立的产品组成。 他们均提供标准化的数据分片、分布式事务和数据库治理功能,可适用于如Java同构、异构语言、容器、云原生等各种多样化的应用场景。

-

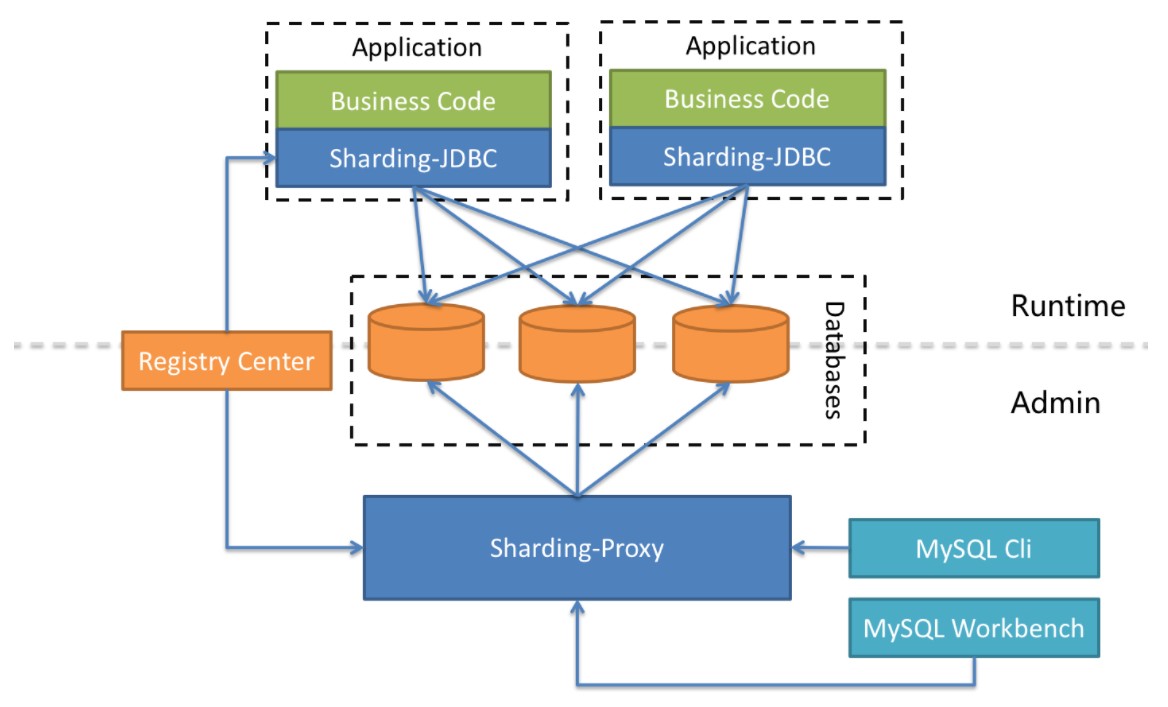

Sharding-JDBC:被定位为轻量级Java框架,在Java的JDBC层提供的额外服务,以jar包形式使用。

-

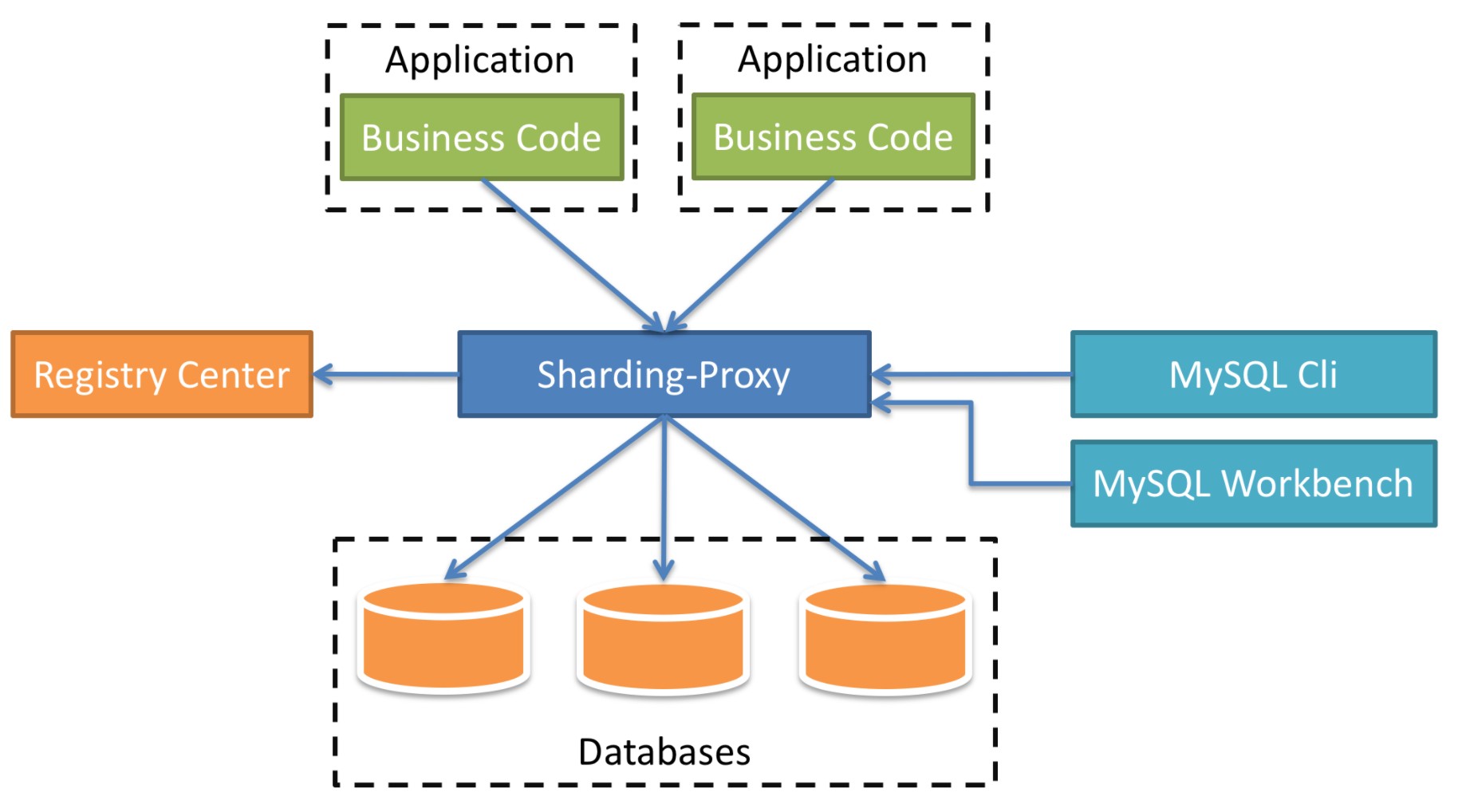

Sharding-Proxy:被定位为透明化的数据库代理端,向应用程序完全透明,可直接当做 MySQL 使用;

-

Sharding-Sidecar:被定位为Kubernetes(K8S)的云原生数据库代理,以守护进程的形式代理所有对数据库的访问(只是计划在未来做)。

Sharding-JDBC、Sharding-Proxy之间的区别如下:

| Sharding-JDBC | Sharding-Proxy | |

|---|---|---|

| 数据库 | 任意 | MySQL/PostgreSQL |

| 连接消耗数 | 高 | 低 |

| 异构语言 | 仅Java | 任意 |

| 性能 | 损耗低 | 损耗略高 |

| 无中心化 | 是 | 否 |

| 静态入口 | 无 | 有 |

异构是继面向对象编程思想又一种较新的编程思想,面向服务编程,不用顾虑语言的差别,提供规范的服务接口,我们无论使用什么语言,就都可以访问使用了,大大提高了程序的复用率。

Sharding-Proxy的优势在于对异构语言的支持,以及为DBA提供可操作入口。它可以屏蔽底层分库分表的复杂度,运维及开发人员仅面向proxy操作,像操作单个数据库一样操作复杂的底层MySQL实例

很显然ShardingJDBC只是客户端的一个工具包,可以理解为一个特殊的JDBC驱动包,所有分库分表逻辑均有业务方自己控制,所以他的功能相对灵活,支持的 数据库也非常多,但是对业务侵入大,需要业务方自己定义所有的分库分表逻辑.

而ShardingProxy是一个独立部署的服务,对业务方无侵入,业务方可以像用一个普通的MySQL服务一样进行数据交互,基本上感觉不到后端分库分表逻辑的存在,但是这也意味着功能会比较固定,能够支持的数据库也比较少,两者各有优劣.

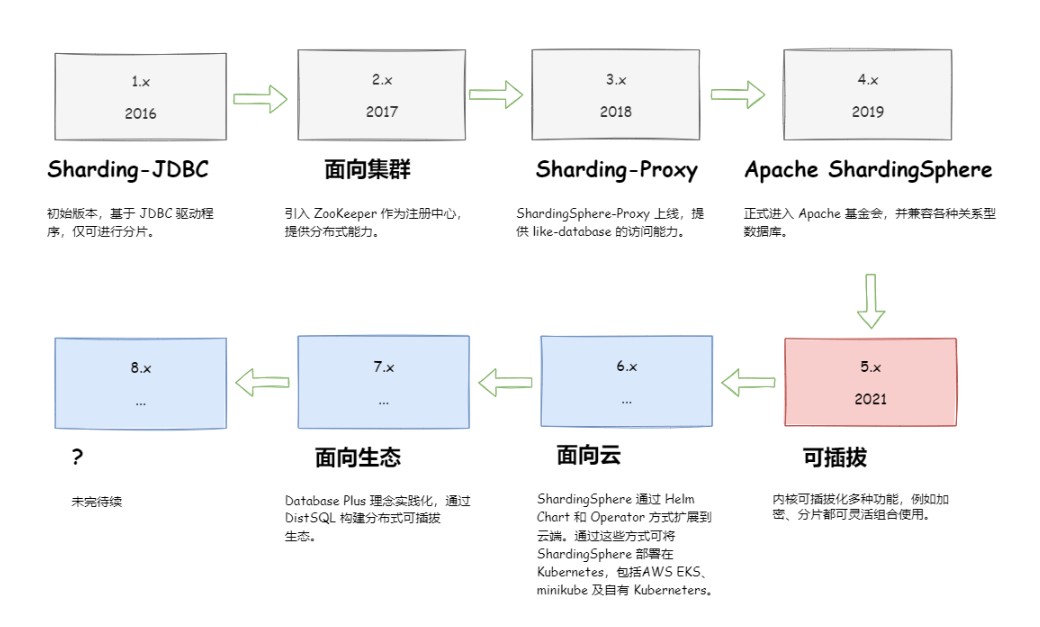

ShardingSphere项目状态如下:

ShardingSphere定位为关系型数据库中间件,旨在充分合理地在分布式的场景下利用关系型数据库的计算和存储能力,而并非实现一个全新的关系型数据库。

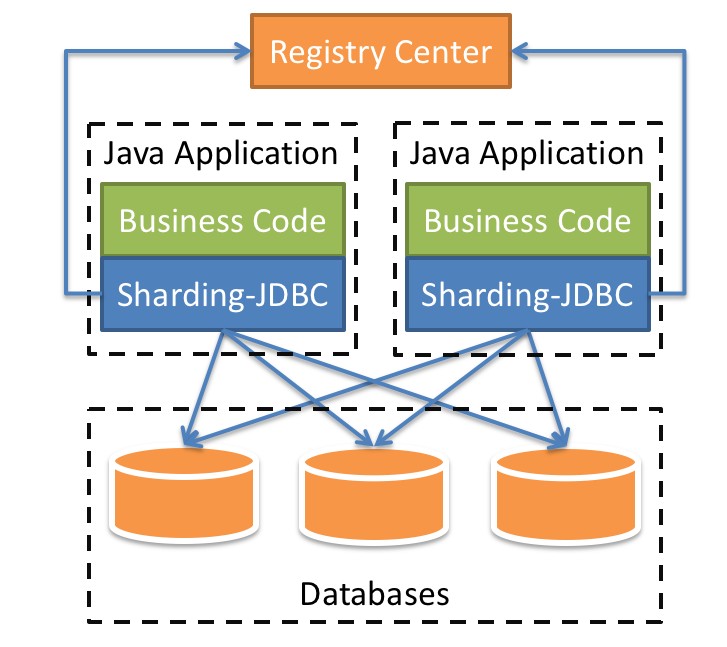

2.2 Sharding-JDBC介绍

Sharding-JDBC定位为轻量级Java框架,在Java的JDBC层提供的额外服务。 它使用客户端直连数据库,以jar包形式提供服务,无需额外部署和依赖,可理解为增强版的JDBC驱动,完全兼容JDBC和各种ORM框架的使用。

-

适用于任何基于Java的ORM框架,如:JPA, Hibernate, Mybatis, Spring JDBC Template或直接使用JDBC。

-

基于任何第三方的数据库连接池,如:DBCP, C3P0, Druid, HikariCP等。

-

支持任意实现JDBC规范的数据库。目前支持MySQL,Oracle,SQLServer和PostgreSQL。

Sharding-JDBC主要功能:

- 数据分片

- 分库分表

- 读写分离

- 分片策略

- 分布式主键

- 分布式事务

- 标准化事务接口

- XA强一致性事务

- 柔性事务

- 数据库治理

- 配置动态化

- 编排治理

- 数据脱敏

- 可视化链路追踪

Sharding-JDBC 内部结构:

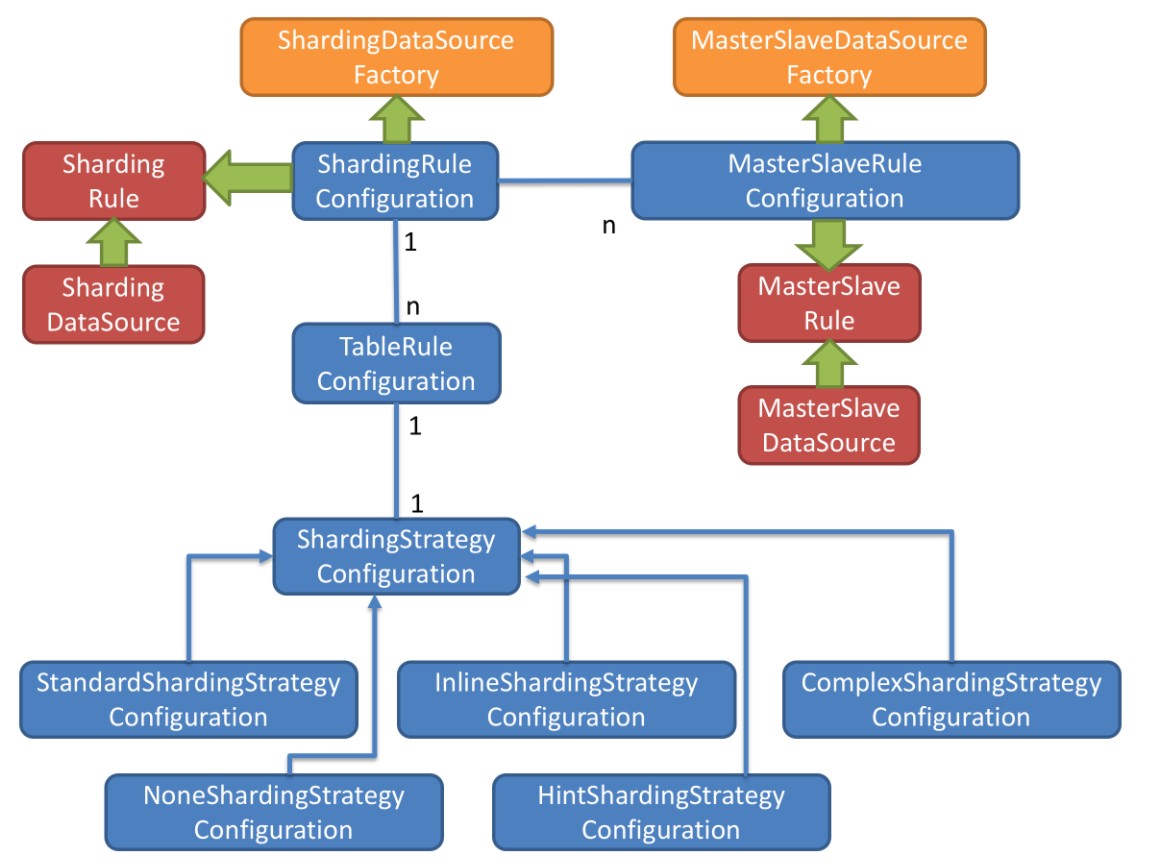

- 图中黄色部分表示的是Sharding-JDBC的入口API,采用工厂方法的形式提供。 目前有ShardingDataSourceFactory和MasterSlaveDataSourceFactory两个工厂类。

- ShardingDataSourceFactory支持分库分表、读写分离操作

- MasterSlaveDataSourceFactory支持读写分离操作

- 图中蓝色部分表示的是Sharding-JDBC的配置对象,提供灵活多变的配置方式。 ShardingRuleConfiguration是分库分表配置的核心和入口,它可以包含多个TableRuleConfiguration和MasterSlaveRuleConfiguration。

- TableRuleConfiguration封装的是表的分片配置信息,有5种配置形式对应不同的Configuration类型。

- MasterSlaveRuleConfiguration封装的是读写分离配置信息。

- 图中红色部分表示的是内部对象,由Sharding-JDBC内部使用,应用开发者无需关注。Sharding-JDBC通过ShardingRuleConfiguration和MasterSlaveRuleConfiguration生成真正供ShardingDataSource和MasterSlaveDataSource使用的规则对象。ShardingDataSource和MasterSlaveDataSource实现了DataSource接口,是JDBC的完整实现方案。

2.3 数据分片详解与实战

2.3.1 核心概念

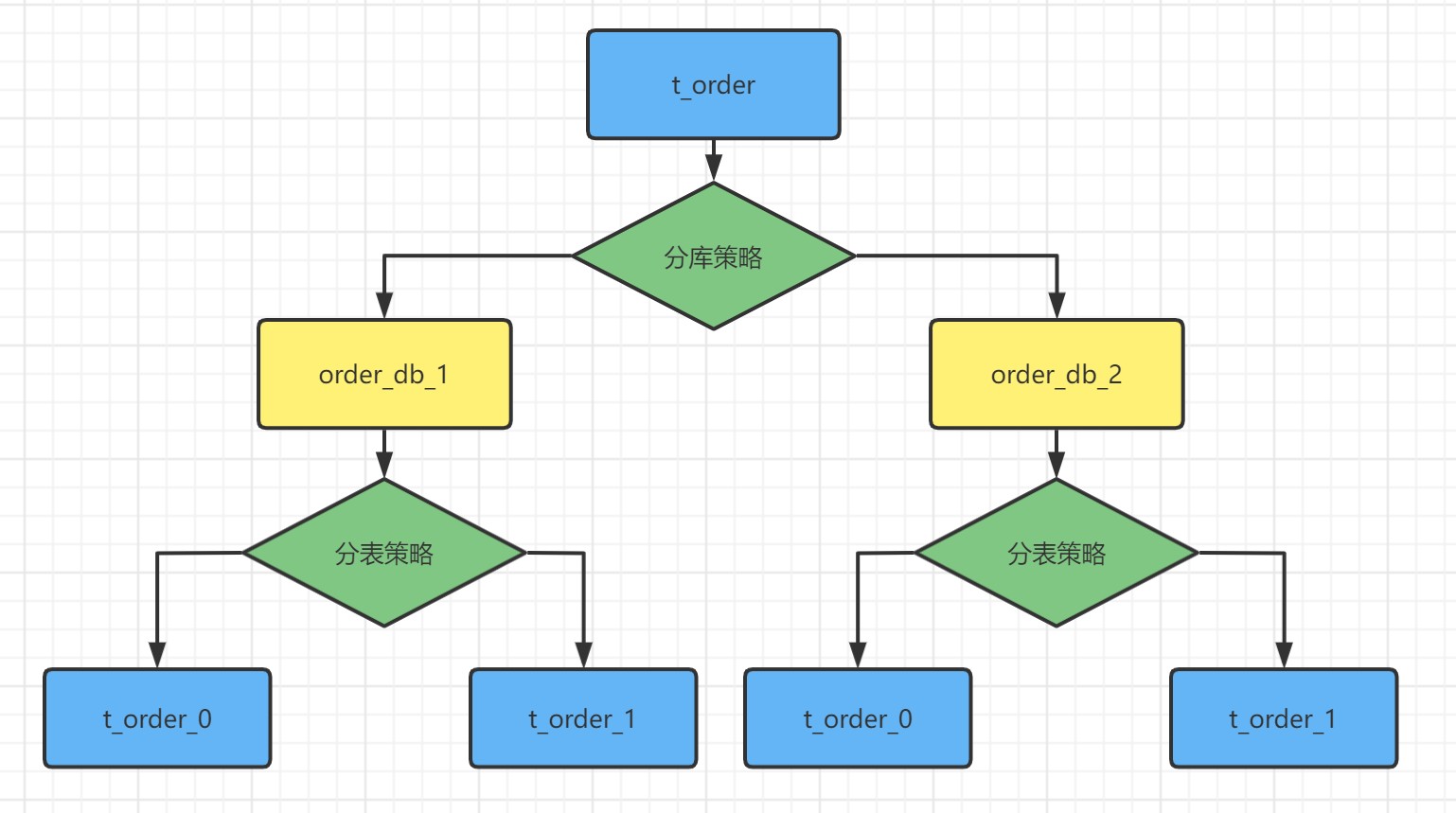

对于数据库的垂直拆分一般都是在数据库设计初期就会完成,因为垂直拆分与业务直接相关,而我们提到的分库分表一般是指的水平拆分,数据分片就是将原本一张数据量较大的表t_order拆分生成数个表结构完全一致的小数据量表t_order_0、t_order_1...,每张表只保存原表的部分数据.

2.3.1.1 表概念

- 逻辑表水平拆分的数据库(表)的相同逻辑和数据结构表的总称。 比如的订单表 t_order ---> t_order_0 ...t_order _9.拆分后t_order表 已经不存在了,这个时候t_order表就是上面拆分的表单的逻辑表.

- 真实表数据库中真实存在的物理表。 t_order_0 ...t_order _9

- 数据节点在分片之后,由数据源和数据表组成。比如: t_order_db1.t_order_0

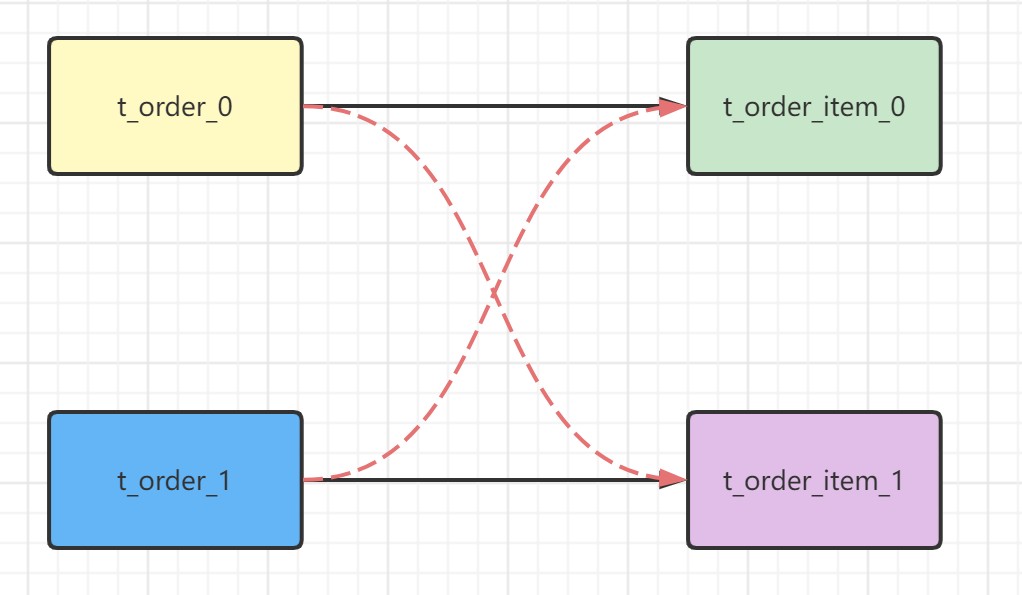

- 绑定表绑定表是指具有相同分片规则的一组关联表(如主表与子表),例如

t_order与t_order_item均按order_id进行分片。当这些表中order_id相同的数据落在相同的分片上时,它们即构成绑定表关系。绑定表之间的多表关联查询不会产生笛卡尔积,从而显著提升查询效率。

sql

# t_order:t_order0、t_order1

# t_order_item:t_order_item0、t_order_item1

select * from t_order o join t_order_item i on o.order_id=i.order_id where o.order_id in (10,11);由于分库分表以后这些表被拆分成N多个子表。如果不配置绑定表关系,会出现笛卡尔积关联查询,将产生如下四条SQL。

sql

select * from t_order0 o join t_order_item0 i on o.order_id=i.order_id

where o.order_id in (10,11);

select * from t_order0 o join t_order_item1 i on o.order_id=i.order_id

where o.order_id in (10,11);

select * from t_order1 o join t_order_item0 i on o.order_id=i.order_id

where o.order_id in (10,11);

select * from t_order1 o join t_order_item1 i on o.order_id=i.order_id

where o.order_id in (10,11); 如果配置绑定表关系后再进行关联查询时,只要对应表分片规则一致产生的数据就会落到同一个库中,那么只需 t_order_0和 t_order_item_0 表关联即可。

如果配置绑定表关系后再进行关联查询时,只要对应表分片规则一致产生的数据就会落到同一个库中,那么只需 t_order_0和 t_order_item_0 表关联即可。

sql

select * from t_order0 o join t_order_item0 i on o.order_id=i.order_id

where o.order_id in (10,11);

select * from t_order1 o join t_order_item1 i on o.order_id=i.order_id

where o.order_id in (10,11);

- 广播表在使用中,有些表没必要做分片,例如字典表、省份信息等,因为他们数据量不大,而且这种表可能需要与海量数据的表进行关联查询。广播表会在不同的数据节点上进行存储,存储的表结构和数据完全相同。

- 单表指所有的分片数据源中只存在唯一一张的表。适用于数据量不大且不需要做任何分片操作的场景。

2.3.1.2 分片键

用于分片的数据库字段,是将数据库(表)水平拆分的关键字段。

例:将订单表中的订单主键取模分片,则订单主键为分片字段。 SQL 中如果无分片字段,将执行全路由(去查询所有的真实表),性能较差。 除了对单分片字段的支持,Apache ShardingSphere 也支持根据多个字段进行分片。

2.3.1.3 分片算法

由于分片算法(ShardingAlgorithm) 和业务实现紧密相关,因此并未提供内置分片算法,而是通过分片策略将各种场景提炼出来,提供更高层级的抽象,并提供接口让应用开发者自行实现分片算法。目前提供4种分片算法。

- 精确分片算法

用于处理使用单一键作为分片键的=与IN进行分片的场景。

- 范围分片算法

用于处理使用单一键作为分片键的BETWEEN AND、>、<、>=、<=进行分片的场景。

- 复合分片算法

用于处理使用多键作为分片键进行分片的场景,多个分片键的逻辑较复杂,需要应用开发者自行处理其中的复杂度。

- Hint分片算法

Hint 分片算法适用于分片键无法从 SQL 语句中直接获取,而需依赖外部上下文(如用户身份、会话信息等)动态确定的场景。当数据库表结构中不包含实际用于分片的字段时,可通过 SQL Hint 在执行时显式传递分片值,从而实现精确的数据路由。

典型应用场景包括:内部系统按员工登录 ID 进行分库,但业务表中并未存储该字段。此时,借助 Hint 机制,可在不修改表结构的前提下完成分片逻辑。

2.3.1.4 分片策略

分片策略(ShardingStrategy) 包含分片键和分片算法,真正可用于分片操作的是分片键 + 分片算法,也就是分片策略。目前提供5种分片策略。

- 标准分片策略 StandardShardingStrategy

只支持单分片键,提供对SQL语句中的=, >, <, >=, <=, IN和BETWEEN AND的分片操作支持。提供PreciseShardingAlgorithm和RangeShardingAlgorithm两个分片算法。

PreciseShardingAlgorithm是必选的,RangeShardingAlgorithm是可选的。但是SQL中使用了范围操作,如果不配置RangeShardingAlgorithm会采用全库路由扫描,效率低。

- 复合分片策略 ComplexShardingStrategy

支持多分片键。提供对SQL语句中的=, >, <, >=, <=, IN和BETWEEN AND的分片操作支持。由于多分片键之间的关系复杂,因此并未进行过多的封装,而是直接将分片键值组合以及分片操作符透传至分片算法,完全由应用开发者实现,提供最大的灵活度。

- 行表达式分片策略 InlineShardingStrategy

只支持单分片键。使用Groovy的表达式,提供对SQL语句中的=和IN的分片操作支持,对于简单的分片算法,可以通过简单的配置使用,从而避免繁琐的Java代码开发。如: t_user_$->{u_id % 8} 表示t_user表根据u_id模8,而分成8张表,表名称为t_user_0到t_user_7。

- Hint分片策略HintShardingStrategy

通过Hint指定分片值而非从SQL中提取分片值的方式进行分片的策略。

- 不分片策略NoneShardingStrategy

不分片的策略。

2.3.1.5 分布式主键

数据分片后,不同数据节点生成全局唯一主键是非常棘手的问题,同一个逻辑表(t_order)内的不同真实表(t_order_n)之间的自增键由于无法互相感知而产生重复主键。

尽管可通过设置自增主键初始值和步长的方式避免ID碰撞,但这样会使维护成本加大,缺乏完整性和可扩展性。如果后期需要增加分片表的数量,要逐一修改分片表的步长,运维成本非常高,所以不建议这种方式。

ShardingSphere不仅提供了内置的分布式主键生成器,例如UUID、SNOWFLAKE,还抽离出分布式主键生成器的接口,方便用户自行实现自定义的自增主键生成器。

内置主键生成器:

- UUID采用UUID.randomUUID()的方式产生分布式主键。

- SNOWFLAKE在分片规则配置模块可配置每个表的主键生成策略,默认使用雪花算法,生成64bit的长整型数据。

2.3.2 搭建基础环境

2.3.2.1 安装环境

- jdk: 要求jdk必须是1.8版本及以上

- MySQL: 推荐mysql5.7版本

- 搭建两台MySQL服务器

plain

mysql-server1 192.168.116.128

mysql-server2 192.168.116.1292.3.2.2 创建数据库和表

- 在mysql01服务器上, 创建数据库 payorder_db,并创建表pay_order

sql

CREATE DATABASE payorder_db CHARACTER SET 'utf8';

CREATE TABLE `pay_order` (

`order_id` bigint(20) NOT NULL AUTO_INCREMENT,

`user_id` int(11) DEFAULT NULL,

`product_name` varchar(128) DEFAULT NULL,

`COUNT` int(11) DEFAULT NULL,

PRIMARY KEY (`order_id`)

) ENGINE=InnoDB AUTO_INCREMENT=12345679 DEFAULT CHARSET=utf8- 在mysql02服务器上, 创建数据库 user_db,并创建表users

sql

CREATE DATABASE user_db CHARACTER SET 'utf8';

CREATE TABLE `users` (

`id` int(11) NOT NULL,

`username` varchar(255) NOT NULL COMMENT '用户昵称',

`phone` varchar(255) NOT NULL COMMENT '注册手机',

`PASSWORD` varchar(255) DEFAULT NULL COMMENT '用户密码',

PRIMARY KEY (`id`)

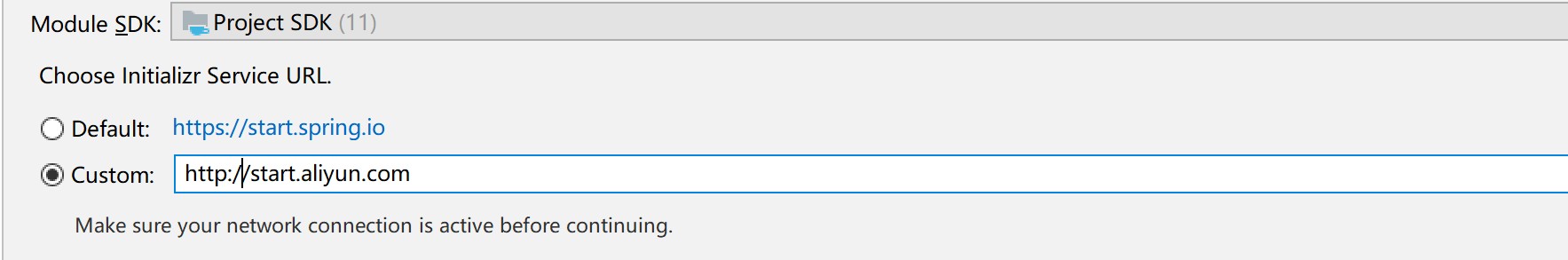

) ENGINE=InnoDB DEFAULT CHARSET=utf8 COMMENT='用户表'2.3.2.3 创建SpringBoot程序

1) 创建项目

环境说明:

SpringBoot2.3.7+MyBatisPlus+ShardingSphere-JDBC 5.1+Hikari+MySQL 5.7

Spring脚手架: http://start.aliyun.com

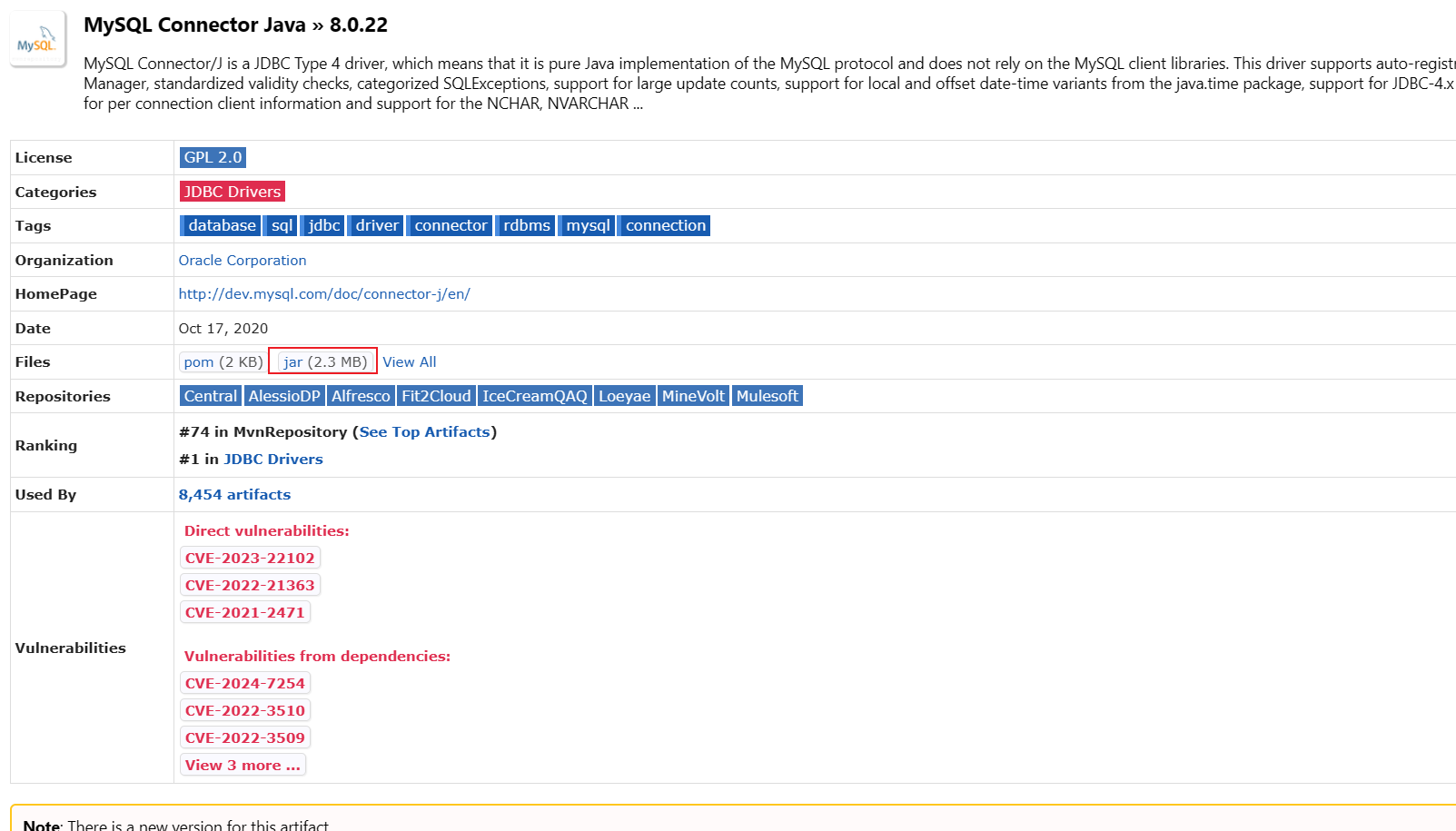

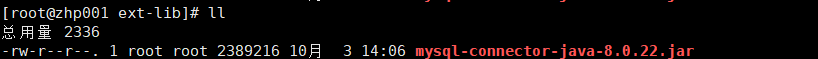

2) 引入依赖

xml

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.3.7.RELEASE</version>

<relativePath/>

</parent>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.apache.shardingsphere</groupId>

<artifactId>shardingsphere-jdbc-core-spring-boot-starter</artifactId>

<version>5.1.1</version>

</dependency>

<dependency>

<groupId>com.baomidou</groupId>

<artifactId>mybatis-plus-boot-starter</artifactId>

<version>3.3.1</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<scope>runtime</scope>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

<exclusions>

<exclusion>

<groupId>org.junit.vintage</groupId>

<artifactId>junit-vintage-engine</artifactId>

</exclusion>

</exclusions>

</dependency>

</dependencies>3) 创建实体类

java

@TableName("pay_order") //逻辑表名

@Data

@ToString

public class PayOrder {

@TableId

private long order_id;

private long user_id;

private String product_name;

private int count;

}

@TableName("users")

@Data

@ToString

public class User {

@TableId

private long id;

private String username;

private String phone;

private String password;

}4) 创建Mapper

java

@Mapper

public interface PayOrderMapper extends BaseMapper<PayOrder> {

}

@Mapper

public interface UserMapper extends BaseMapper<User> {

}2.3.3 实现垂直分库

2.3.3.1 配置文件

使用sharding-jdbc 对数据库中水平拆分的表进行操作,通过sharding-jdbc对分库分表的规则进行配置,配置内容包括:数据源、主键生成策略、分片策略等。

application.properties

- 基础配置

properties

# 应用名称

spring.application.name=shardingsphere-jdbc-table- 数据源

properties

# 应用名称

spring.application.name=shardingsphere-jdbc-table

# 定义多个数据源

spring.shardingsphere.datasource.names = db1,db2

#数据源1

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.128:3306/payorder_db?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 123456

#数据源2

spring.shardingsphere.datasource.db2.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db2.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db2.url = jdbc:mysql://192.168.116.129:3306/user_db?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db2.username = root

spring.shardingsphere.datasource.db2.password = 123456

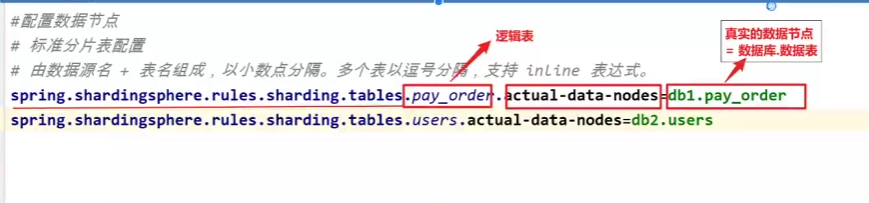

#配置数据节点

# 标准分片表配置

# 由数据源名 + 表名组成,以小数点分隔。多个表以逗号分隔,支持 inline 表达式。

spring.shardingsphere.rules.sharding.tables.pay_order.actual-data-nodes=db1.pay_order

spring.shardingsphere.rules.sharding.tables.users.actual-data-nodes=db2.users

mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl- 配置数据节点

properties

# 标准分片表配置

# 由数据源名 + 表名组成,以小数点分隔。多个表以逗号分隔,支持 inline 表达式。

spring.shardingsphere.rules.sharding.tables.pay_order.actual-data-nodes=db1.pay_order

spring.shardingsphere.rules.sharding.tables.users.actual-data-nodes=db2.users- 打开sql输出日志

properties

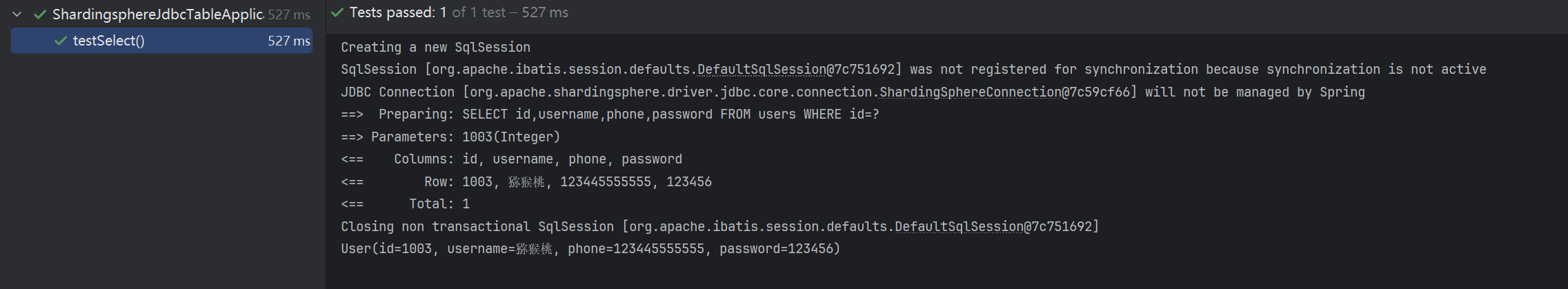

mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl2.3.3.2 垂直分库测试

java

@SpringBootTest

class ShardingJdbcApplicationTests {

@Autowired

private UserMapper userMapper;

@Autowired

private PayOrderMapper payOrderMapper;

@Test

public void testInsert(){

User user = new User();

user.setId(1002);

user.setUsername("大远哥");

user.setPhone("15612344321");

user.setPassword("123456");

userMapper.insert(user);

PayOrder payOrder = new PayOrder();

payOrder.setOrder_id(12345679);

payOrder.setProduct_name("猕猴桃");

payOrder.setUser_id(user.getId());

payOrder.setCount(2);

payOrderMapper.insert(payOrder);

}

@Test

public void testSelect(){

User user = userMapper.selectById(1001);

System.out.println(user);

PayOrder payOrder = payOrderMapper.selectById(12345678);

System.out.println(payOrder);

}

}

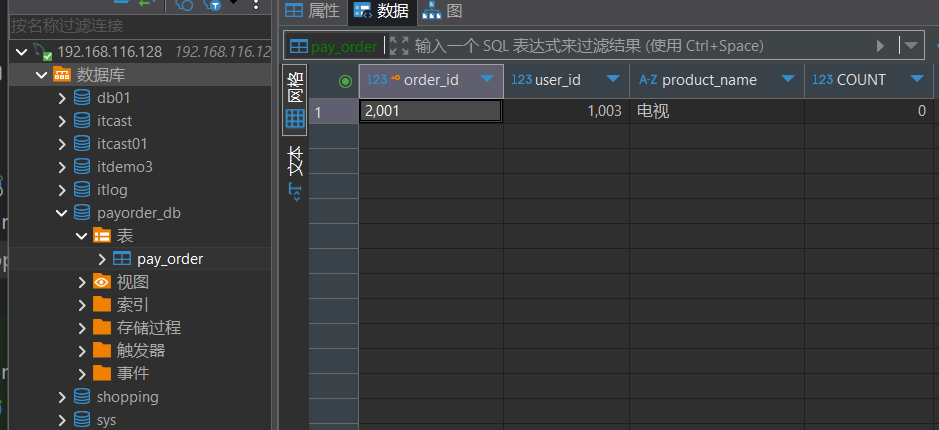

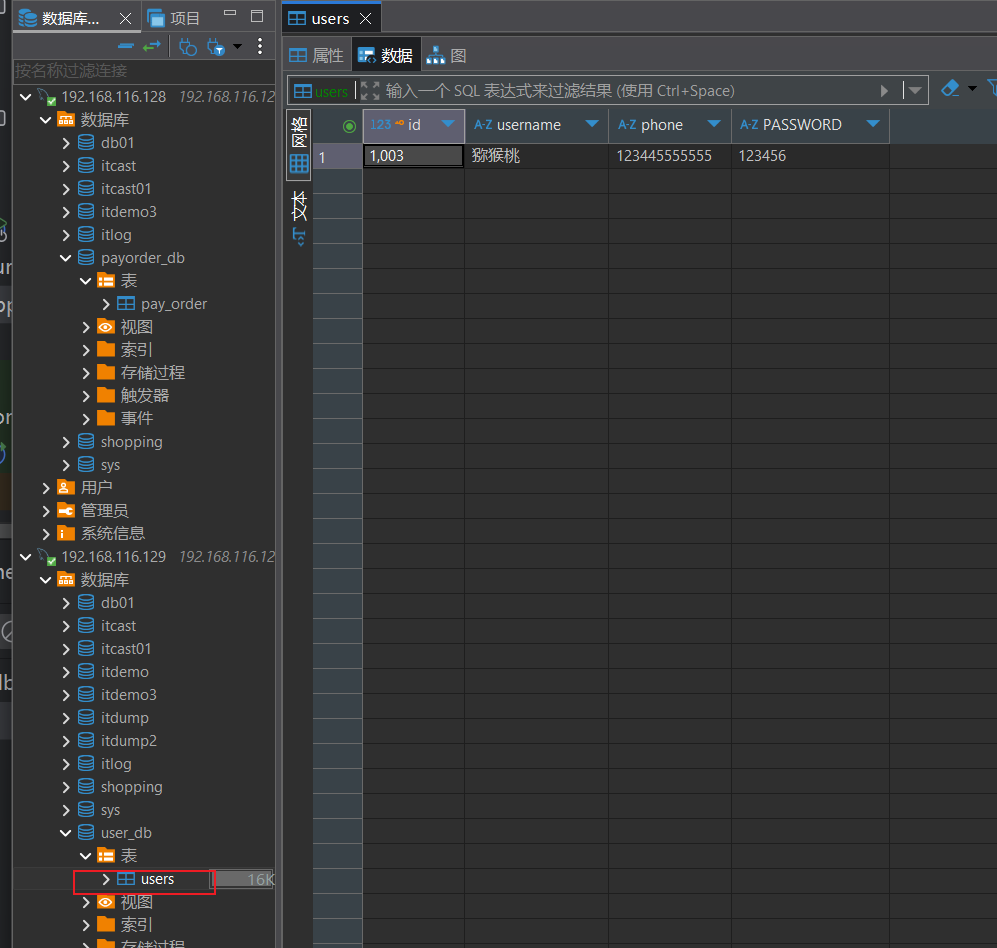

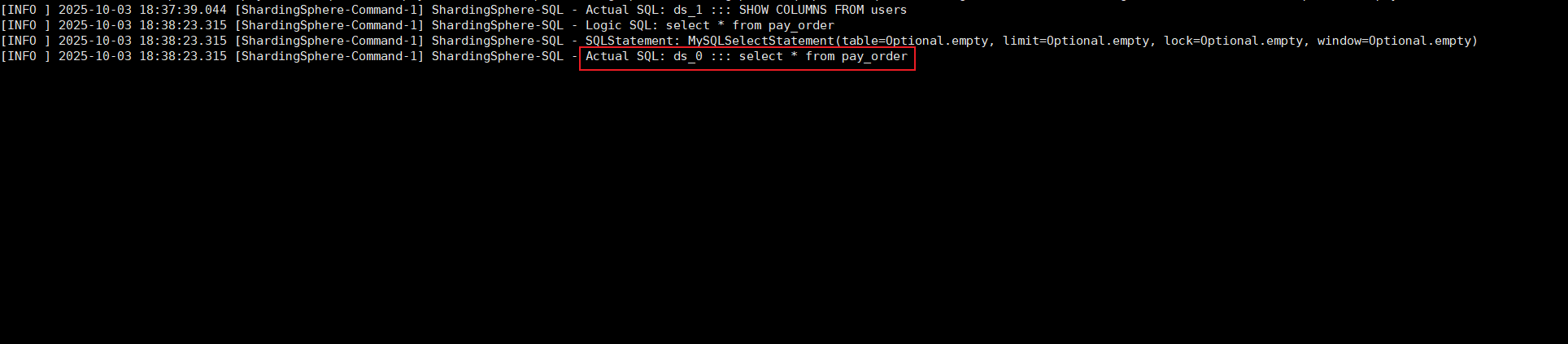

数据插入情况:

可以看到User数据就插入到了129的服务器,PayOrder数据就插入到了128服务器。这就实现了一个简单的垂直分库的情况,不同的表分布在不同的服务器上

2.3.4 实现水平分表

2.3.4.1 数据准备

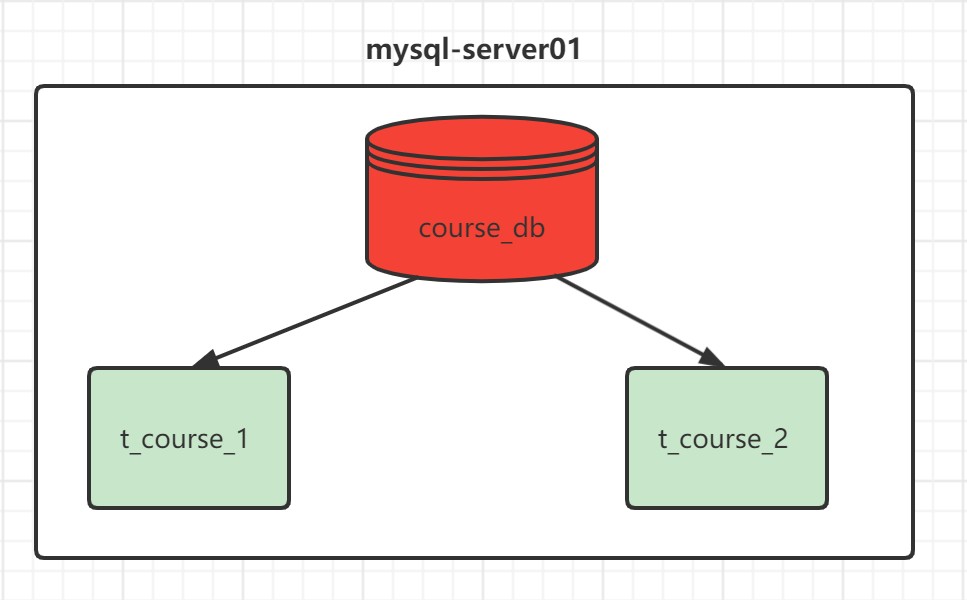

需求说明:

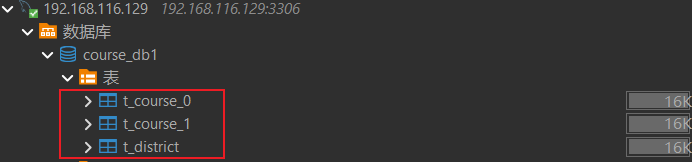

- 在mysql-server01服务器上, 创建数据库 course_db

- 创建表 t_course_1 、 t_course_2

- 约定规则:如果添加的课程 id 为偶数添加到 t_course_1 中,奇数添加到 t_course_2 中。

水平分片的id需要在业务层实现,不能依赖数据库的主键自增

sql

CREATE TABLE t_course_1 (

`cid` BIGINT(20) NOT NULL,

`user_id` BIGINT(20) DEFAULT NULL,

`cname` VARCHAR(50) DEFAULT NULL,

`brief` VARCHAR(50) DEFAULT NULL,

`price` DOUBLE DEFAULT NULL,

`status` INT(11) DEFAULT NULL,

PRIMARY KEY (`cid`)

) ENGINE=INNODB DEFAULT CHARSET=utf8

CREATE TABLE t_course_2 (

`cid` BIGINT(20) NOT NULL,

`user_id` BIGINT(20) DEFAULT NULL,

`cname` VARCHAR(50) DEFAULT NULL,

`brief` VARCHAR(50) DEFAULT NULL,

`price` DOUBLE DEFAULT NULL,

`status` INT(11) DEFAULT NULL,

PRIMARY KEY (`cid`)

) ENGINE=INNODB DEFAULT CHARSET=utf82.3.4.2 配置文件

1) 基础配置

properties

# 应用名称

spring.application.name=sharding-jdbc

# 打印SQl

spring.shardingsphere.props.sql-show=true2) 数据源配置

properties

#===============数据源配置

#配置真实的数据源

spring.shardingsphere.datasource.names=db1

#数据源1

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.128:3306/course_db?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 1234563) 数据节点配置

先指定t_course_1表试试

properties

#1.配置数据节点

#指定course表的分布情况(配置表在哪个数据库,表名是什么)

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db1.t_course_1 4) 完整配置文件

properties

# 应用名称

spring.application.name=shardingsphere-jdbc-table

# 打印SQl

spring.shardingsphere.props.sql-show=true

# 定义多个数据源

spring.shardingsphere.datasource.names = db1

#数据源1

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.128:3306/course_db?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 123456

#配置数据节点

# 标准分片表配置

# 由数据源名 + 表名组成,以小数点分隔。多个表以逗号分隔,支持 inline 表达式。

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db1.t_course_1

mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl2.3.4.3 测试

- course类

java

@TableName("t_course")

@Data

@ToString

public class Course implements Serializable {

@TableId

private Long cid;

private Long userId;

private String cname;

private String brief;

private double price;

private int status;

}- CourseMapper

java

@Mapper

public interface CourseMapper extends BaseMapper<Course> {

}

java

//水平分表测试

@Autowired

private CourseMapper courseMapper;

@Test

public void testInsertCourse(){

for (int i = 0; i < 3; i++) {

Course course = new Course();

course.setCid(10086L+i);

course.setUserId(1L+i);

course.setCname("Java经典面试题讲解");

course.setBrief("课程涵盖目前最容易被问到的10000道Java面试题");

course.setPrice(100.0);

course.setStatus(1);

courseMapper.insert(course);

}

}

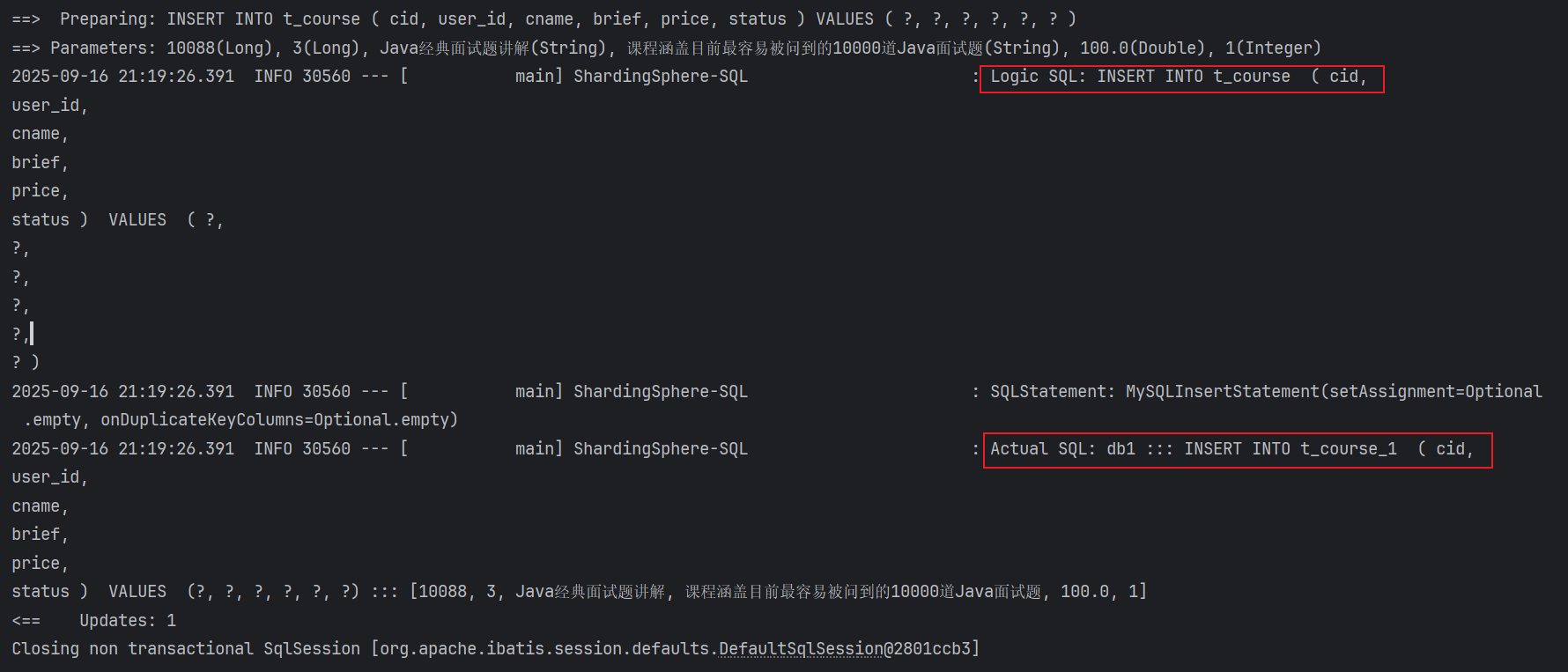

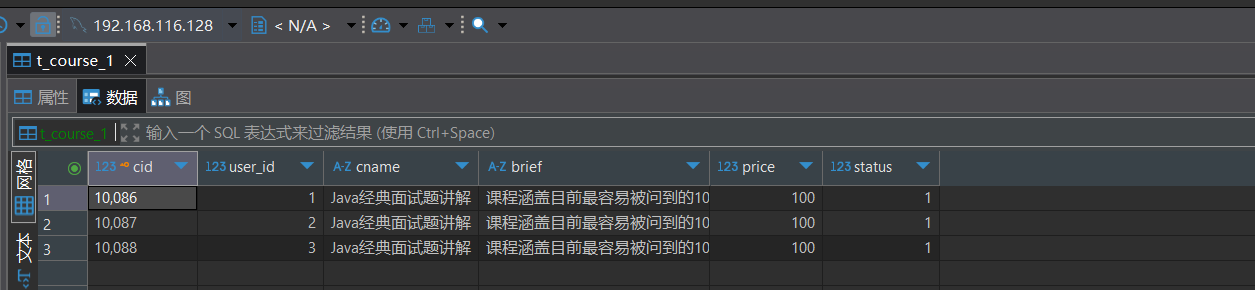

插入数据情况

2.3.4.4 行表达式

对上面的配置操作进行修改, 使用inline表达式,灵活配置数据节点

行表达式的使用: https://shardingsphere.apache.org/document/5.1.1/cn/features/sharding/concept/inline-expression/)

properties

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db1.t_course_$->{1..2}表达式 db1.t_course_$->{1..2}

$ 会被 大括号中的 `{1..2}` 所替换, ` ${begin..end}` 表示范围区间

会有两种选择: **db1.t_course_1** 和 **db1.t_course_2**2.3.4.5 配置分片策略

分片策略包括分片键和分片算法.

分片规则,约定cid值为偶数时,添加到t_course_1表,如果cid是奇数则添加到t_course_2表

- 配置分片策略

properties

#1.配置数据节点

#指定course表的分布情况(配置表在哪个数据库,表名是什么)

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db1.t_course_$->{1..2}

##2.配置分片策略(分片策略包括分片键和分片算法)

#2.1 分片键名称: cid

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-column=cid

#2.2 分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-algorithm-name=table-inline

#2.3 分片算法类型: 行表达式分片算法(标准分片算法下包含->行表达式分片算法)

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.type=INLINE

#2.4 分片算法属性配置

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.props.algorithm-expression=t_course_$->{cid % 2 + 1}测试:

完整配置文件

properties

# 应用名称

spring.application.name=shardingsphere-jdbc-table

# 打印SQl

spring.shardingsphere.props.sql-show=true

# 定义多个数据源

spring.shardingsphere.datasource.names = db1

#数据源1

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.128:3306/course_db?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 123456

#1.配置数据节点

#指定course表的分布情况(配置表在哪个数据库,表名是什么)

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db1.t_course_$->{1..2}

##2.配置分片策略(分片策略包括分片键和分片算法)

#2.1 分片键名称: cid

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-column=cid

#2.2 分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-algorithm-name=table-inline

#2.3 分片算法类型: 行表达式分片算法(标准分片算法下包含->行表达式分片算法)

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.type=INLINE

#2.4 分片算法属性配置

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.props.algorithm-expression=t_course_$->{cid % 2 + 1}

mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl

java

@Test

public void testInsertCourse(){

for (int i = 0; i < 20; i++) {

Course course = new Course();

course.setCid(10086L+i);

course.setUserId(1L+i);

course.setCname("Java经典面试题讲解");

course.setBrief("课程涵盖目前最容易被问到的10000道Java面试题");

course.setPrice(100.0);

course.setStatus(1);

courseMapper.insert(course);

}

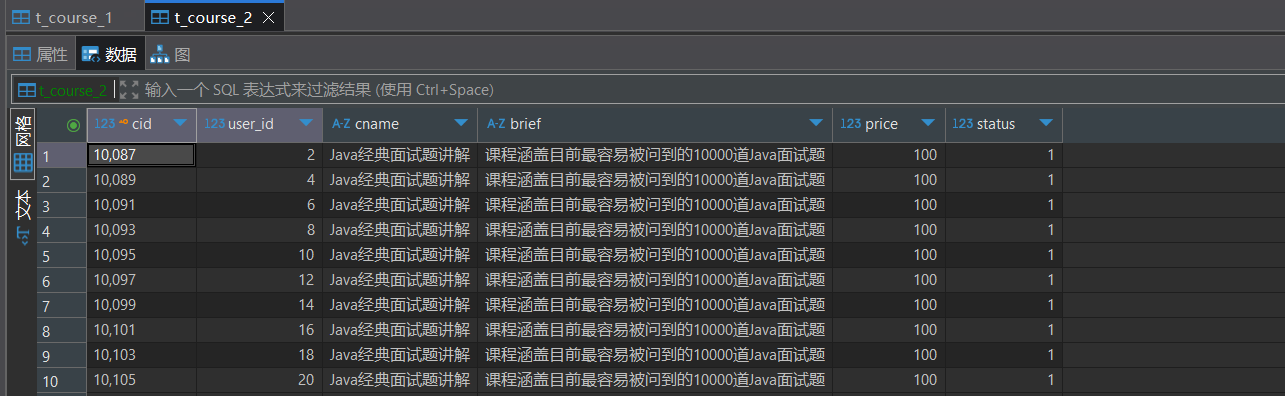

}数据分布情况:

2.3.4.6 分布式序列算法

在水平分表中由于数据会存储到多个表中,每个表有独立的主键,也就是说有可能会发生主键重复的情况,所以就不能使用MySQL默认的主键自增应该使用分布式ID作为主键值,确保每个主键都是唯一的

雪花算法:

https://shardingsphere.apache.org/document/5.1.1/cn/features/sharding/concept/key-generator/

水平分片需要关注全局序列,因为不能简单的使用基于数据库的主键自增。

这里有两种方案:一种是基于MyBatisPlus的id策略;一种是ShardingSphere-JDBC的全局序列配置。

- 基于MyBatisPlus的id策略:将Course类的id设置成如下形式

java

@TableName("t_course")

@Data

@ToString

public class Course imp {

@TableId(value = "cid",type = IdType.ASSIGN_ID)

private Long cid;

private Long userId;

private String cname;

private String brief;

private double price;

private int status;

}- 基于ShardingSphere-JDBC的全局序列配置:和前面的MyBatisPlus的策略二选一

properties

#3.分布式序列配置

#3.1 分布式序列-列名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.column=cid

#3.2 分布式序列-算法名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.key-generator-name=alg_snowflake

#3.3 分布式序列-算法类型

spring.shardingsphere.rules.sharding.key-generators.alg_snowflake.type=SNOWFLAKE

# 分布式序列算法属性配置,可以先不配置

#spring.shardingsphere.rules.sharding.key-generators.alg_snowflake.props.xxx=此时,需要将实体类中的id策略修改成以下形式:

java

//当配置了shardingsphere-jdbc的分布式序列时,自动使用shardingsphere-jdbc的分布式序列

//当没有配置shardingsphere-jdbc的分布式序列时,自动依赖数据库的主键自增策略

@TableId(type = IdType.AUTO)测试:

java

@Test

public void testInsertCourse(){

for (int i = 0; i < 20; i++) {

Course course = new Course();

course.setUserId(1L+i);

course.setCname("Java经典面试题讲解");

course.setBrief("课程涵盖目前最容易被问到的10000道Java面试题");

course.setPrice(100.0);

course.setStatus(1);

courseMapper.insert(course);

}

}

2.3.5 实现水平分库

水平分库是把同一个表的数据按一定规则拆到不同的数据库中,每个库可以放在不同的服务器上。接下来看一下如何使用Sharding-JDBC实现水平分库

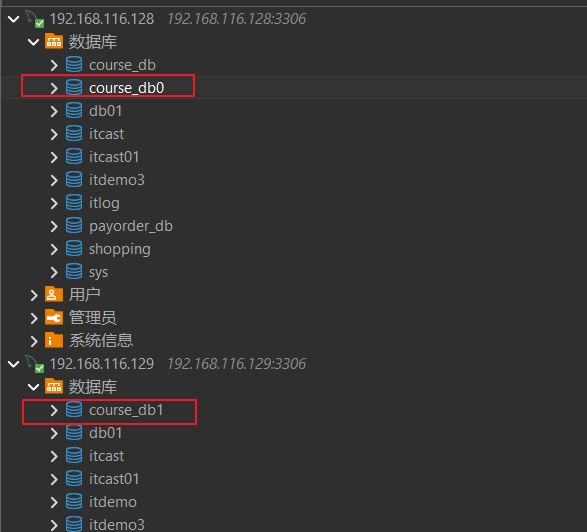

2.3.5.1 数据准备

-

创建数据库

在mysql-server01服务器上, 创建数据库 course_db0, 在mysql-server02服务器上, 创建数据库 course_db1

- 分别在course_db0和course_db1中创建表t_course_0

sql

CREATE TABLE `t_course_0` (

`cid` bigint(20) NOT NULL,

`user_id` bigint(20) DEFAULT NULL,

`corder_no` bigint(20) DEFAULT NULL,

`cname` varchar(50) DEFAULT NULL,

`brief` varchar(50) DEFAULT NULL,

`price` double DEFAULT NULL,

`status` int(11) DEFAULT NULL,

PRIMARY KEY (`cid`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8- 实体类原有的Course类添加一个

corder_no即可.

如果使用了ShardingJDBC的分布式序列,ShardingJDBC会自动生成id,如果没有配置就自动依赖mybatisplus设置的主键自增IdType.AUTO

java

@TableName("t_course")

@Data

@ToString

public class Course implements Serializable {

@TableId(value = "cid",type = IdType.AUTO)

private Long cid;

private Long userId;

private Long corderNo;

private String cname;

private String brief;

private double price;

private int status;

}2.3.5.2 配置文件

1) 数据源配置

properties

# 定义多个数据源

spring.shardingsphere.datasource.names = db0,db1

#数据源1

spring.shardingsphere.datasource.db0.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db0.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db0.url = jdbc:mysql://192.168.116.128:3306/course_db0?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db0.username = root

spring.shardingsphere.datasource.db0.password = 123456

#数据源2

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.129:3306/course_db1?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 1234562) 数据节点配置

先测试水平分库, 数据节点中数据源是动态的, 数据表固定为t_course_0, 方便测试

- db$->{0...1}.t_course_0,表示数据库是动态的,db由db0、db1组成,表就是t_course_0一个表

properties

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db$->{0..1}.t_course_03) 水平分库之分库策略配置

分库策略: 以user_id为分片键,分片策略为user_id % 2,user_id为偶数操作db0数据源,否则操作db1数据源。

properties

#===============水平分库-分库策略==============

##2.配置分片策略(分片策略包括分片键和分片算法)

#2.1 分片键名称: user_id

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-column=user_id

#2.2 分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-algorithm-name=table-inline

#2.3 分片算法类型: 行表达式分片算法(标准分片算法下包含->行表达式分片算法)

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.type=INLINE

#2.4 分片算法属性配置

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.props.algorithm-expression=db$->{user_id % 2}4) 分布式主键自增

properties

#3.分布式序列配置

#3.1 分布式序列-列名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.column=cid

#3.2 分布式序列-算法名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.key-generator-name=alg_snowflake

#3.3 分布式序列-算法类型

spring.shardingsphere.rules.sharding.key-generators.alg_snowflake.type=SNOWFLAKE5) 测试

完成配置文件

properties

# 应用名称

spring.application.name=shardingsphere-jdbc-table

# 打印SQl

spring.shardingsphere.props.sql-show=true

# 定义多个数据源

spring.shardingsphere.datasource.names = db0,db1

#数据源1

spring.shardingsphere.datasource.db0.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db0.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db0.url = jdbc:mysql://192.168.116.128:3306/course_db0?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db0.username = root

spring.shardingsphere.datasource.db0.password = 123456

#数据源2

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.129:3306/course_db1?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 123456

#1.配置数据节点

#指定course表的分布情况(配置表在哪个数据库,表名是什么)

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db$->{0..1}.t_course_0

##2.配置分片策略(分片策略包括分片键和分片算法)

#2.1 分片键名称: user_id

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-column=user_id

#2.2 分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-algorithm-name=table-inline

#2.3 分片算法类型: 行表达式分片算法(标准分片算法下包含->行表达式分片算法)

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.type=INLINE

#2.4 分片算法属性配置

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.props.algorithm-expression=db$->{user_id % 2}

#3.分布式序列配置

#3.1 分布式序列-列名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.column=cid

#3.2 分布式序列-算法名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.key-generator-name=alg_snowflake

#3.3 分布式序列-算法类型

spring.shardingsphere.rules.sharding.key-generators.alg_snowflake.type=SNOWFLAKE

mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl

java

/**

* 水平分库 --> 分库插入数据

*/

@Test

public void testInsertCourseDB(){

for (int i = 0; i < 10; i++) {

Course course = new Course();

course.setUserId(1001L+i);

course.setCname("Java经典面试题讲解");

course.setBrief("课程涵盖目前最容易被问到的10000道Java面试题");

course.setPrice(100.0);

course.setStatus(1);

courseMapper.insert(course);

}

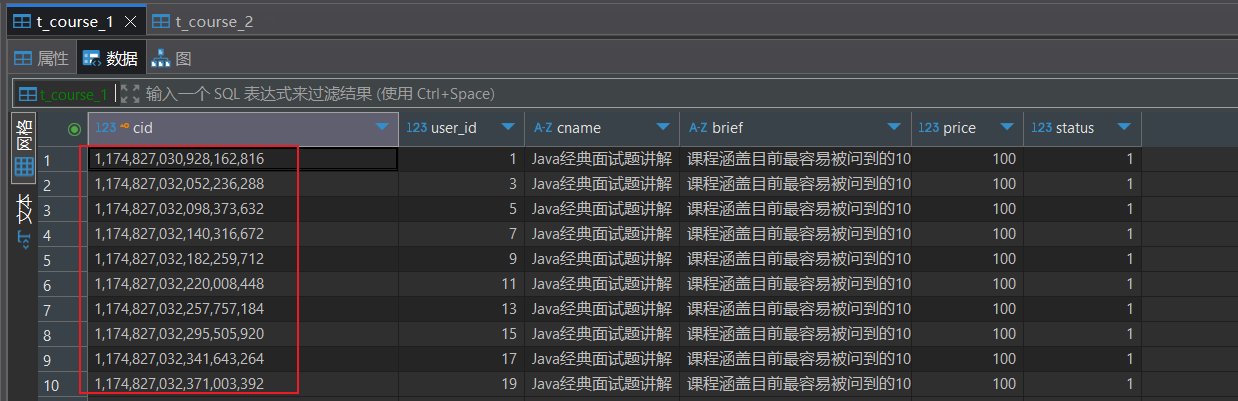

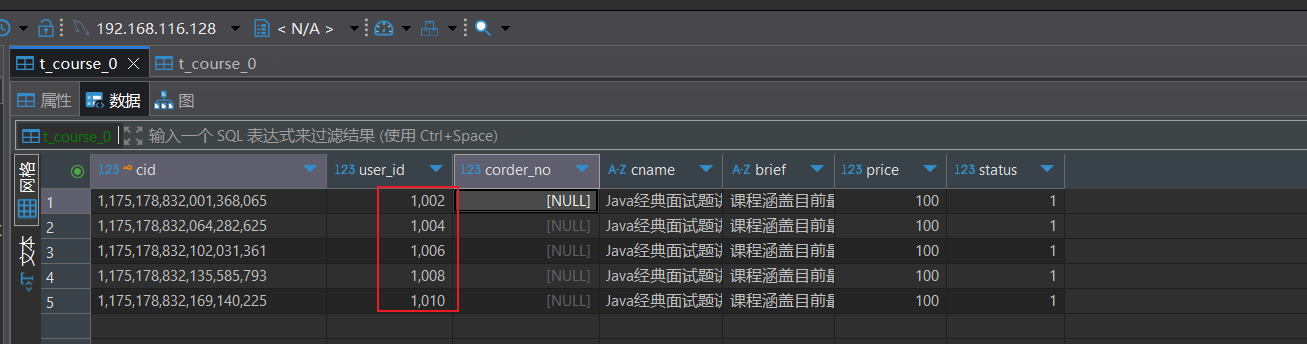

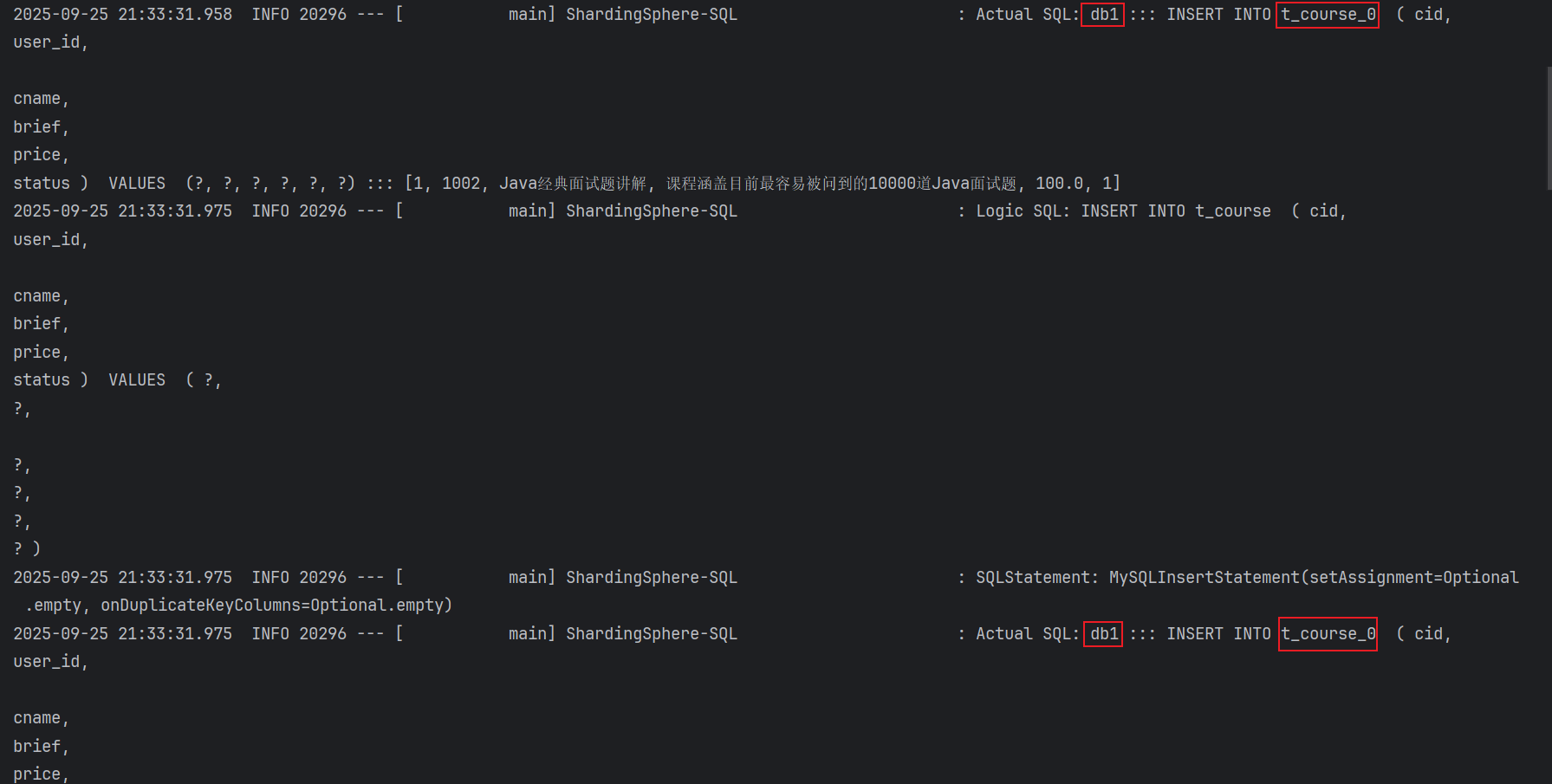

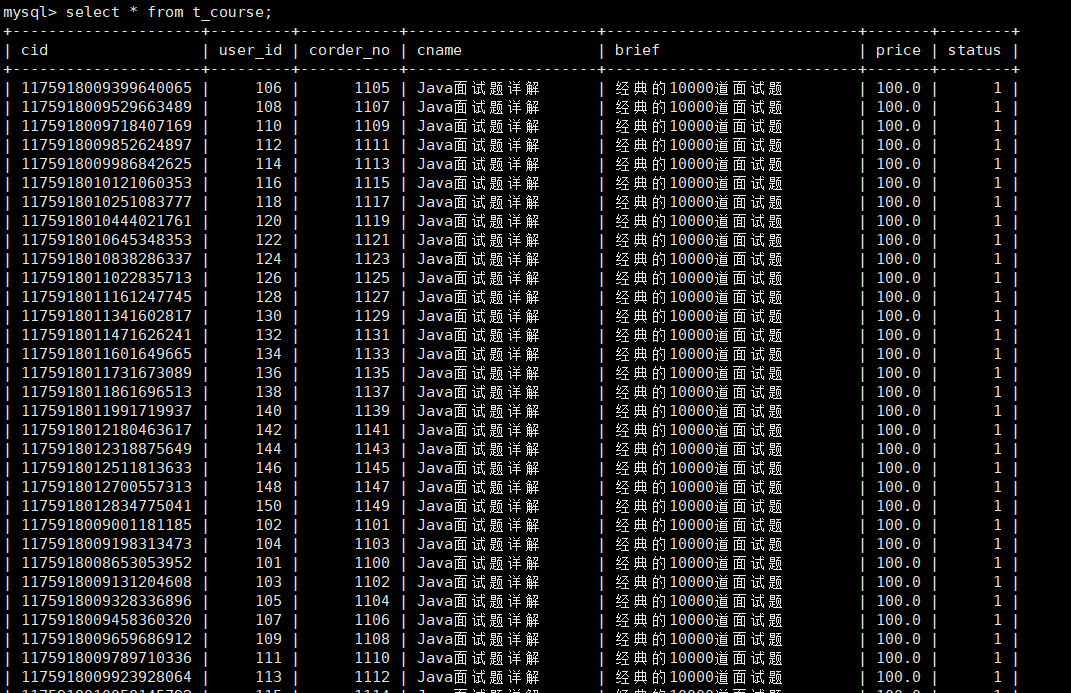

}数据分布情况:可以看到偶数都分布到了course_db0上

6) 水平分库之分表策略配置

可以分库和分表的分片策略同时设置

分库规则:以user_id为分片键,分片策略为user_id % 2,user_id为偶数操作db0数据源,否则操作db1数据源。

分表规则:t_course 表中 cid 的哈希值为偶数时,数据插入对应服务器的t_course_0表,cid 的哈希值为奇数时,数据插入对应服务器的t_course_1。

- 修改数据节点配置,数据落地到dn0或db1数据源的 t_course_0表 或者 t_course_1表.

properties

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db$->{0..1}.t_course_$->{0..1}- 分别在两个库中再创建一个t_course_1表

sql

CREATE TABLE `t_course_1` (

`cid` bigint(20) NOT NULL,

`user_id` bigint(20) DEFAULT NULL,

`corder_no` bigint(20) DEFAULT NULL,

`cname` varchar(50) DEFAULT NULL,

`brief` varchar(50) DEFAULT NULL,

`price` double DEFAULT NULL,

`status` int(11) DEFAULT NULL,

PRIMARY KEY (`cid`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8- 分表策略配置 (对id进行哈希取模)

properties

#===============水平分库-分表策略==============

#----分片列名称----

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-column=cid

##----分片算法配置----

##分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-algorithm-name=inline-hash-mod

#分片算法类型

spring.shardingsphere.rules.sharding.sharding-algorithms.inline-hash-mod.type=INLINE

#分片算法属性配置

spring.shardingsphere.rules.sharding.sharding-algorithms.inline-hash-mod.props.algorithm-expression=t_course_$->{Math.abs(cid.hashCode()) % 2}完整配置文件

properties

# 应用名称

spring.application.name=shardingsphere-jdbc-table

# 打印SQl

spring.shardingsphere.props.sql-show=true

# 定义多个数据源

spring.shardingsphere.datasource.names = db0,db1

#数据源1

spring.shardingsphere.datasource.db0.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db0.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db0.url = jdbc:mysql://192.168.116.128:3306/course_db0?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db0.username = root

spring.shardingsphere.datasource.db0.password = 123456

#数据源2

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.129:3306/course_db1?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 123456

#1.配置数据节点

#指定course表的分布情况(配置表在哪个数据库,表名是什么)

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db$->{0..1}.t_course_$->{0..1}

##2.配置分片策略(分片策略包括分片键和分片算法)

#2.1 分片键名称: user_id

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-column=user_id

#2.2 分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-algorithm-name=table-inline

#2.3 分片算法类型: 行表达式分片算法(标准分片算法下包含->行表达式分片算法)

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.type=INLINE

#2.4 分片算法属性配置

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.props.algorithm-expression=db$->{user_id % 2}

#3.分布式序列配置

#3.1 分布式序列-列名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.column=cid

#3.2 分布式序列-算法名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.key-generator-name=alg_snowflake

#3.3 分布式序列-算法类型

spring.shardingsphere.rules.sharding.key-generators.alg_snowflake.type=SNOWFLAKE

#4===============水平分库-分表策略==============

#4.1----分片列名称----

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-column=cid

##----分片算法配置----

##4.2分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-algorithm-name=inline-hash-mod

#4.3分片算法类型

spring.shardingsphere.rules.sharding.sharding-algorithms.inline-hash-mod.type=INLINE

#4.4分片算法属性配置

spring.shardingsphere.rules.sharding.sharding-algorithms.inline-hash-mod.props.algorithm-expression=t_course_$->{Math.abs(cid.hashCode()) % 2}

mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl官方提供分片算法配置

https://shardingsphere.apache.org/document/current/cn/dev-manual/sharding/

properties

#----分片列名称----

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-column=cid

#----分片算法配置----

#分片算法名称 -> 取模分片算法

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-algorithm-name=table-hash-mod

#分片算法类型

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.type=HASH_MOD

#分片算法属性配置-分片数量,有两个表值设置为2

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.props.sharding-count=22.3.5.3 水平分库测试

- 测试插入数据

java

//水平分库 --> 分表策略

@Test

public void testInsertCourseTable(){

for (int i = 100; i < 150; i++) {

Course course = new Course();

course.setUserId(1L+i);

course.setCname("Java面试题详解");

course.setCorderNo(1000L+i);

course.setBrief("经典的10000道面试题");

course.setPrice(100.00);

course.setStatus(1);

courseMapper.insert(course);

}

}

@Test

public void testHashMod(){

//cid的hash值为偶数时,插入对应数据库的t_course_0表,为奇数插入对应数据库的t_course_1

Long cid = 1175196313105465345L; //获取到cid

int hash = cid.hashCode();

System.out.println(hash);

System.out.println("===========" + Math.abs(hash % 2) ); //获取针对cid进行hash取模后的值

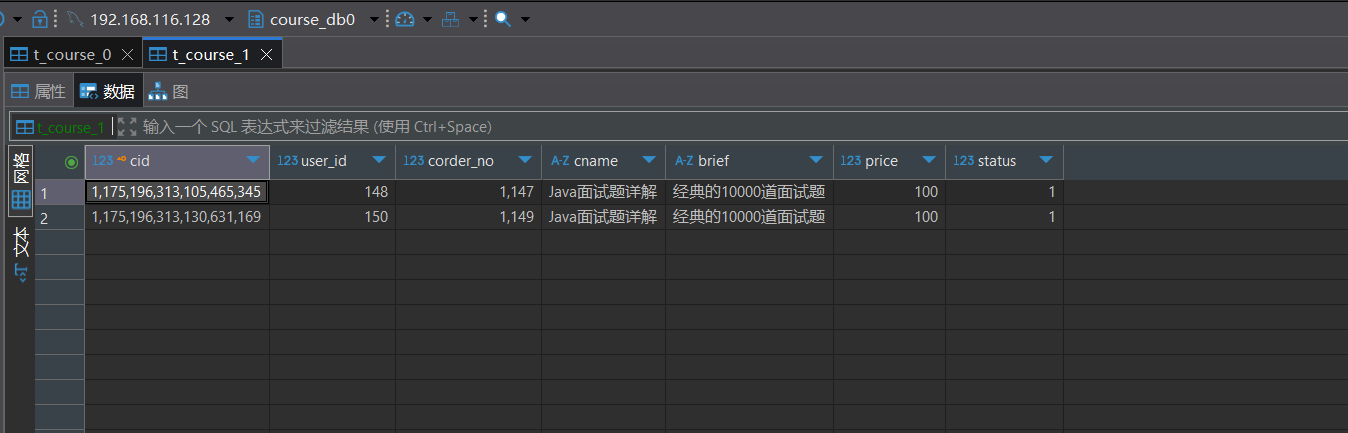

}两台服务器中的两个表都已经有数据

2.3.5.4 水平分库查询

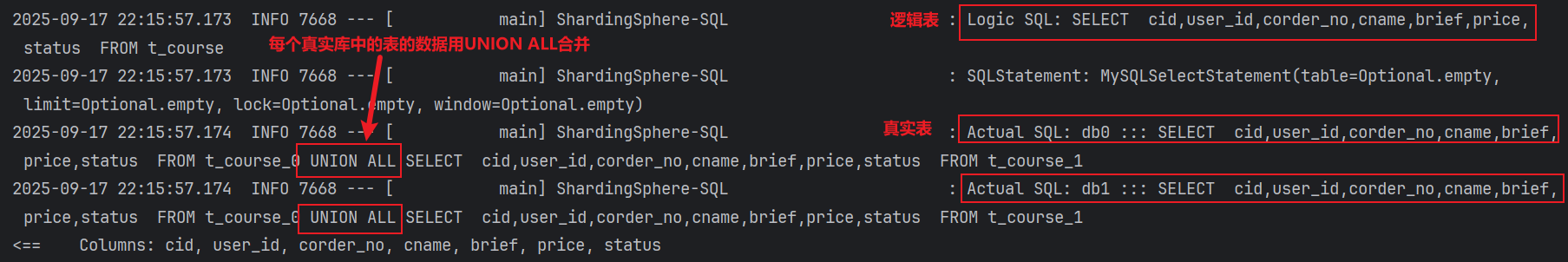

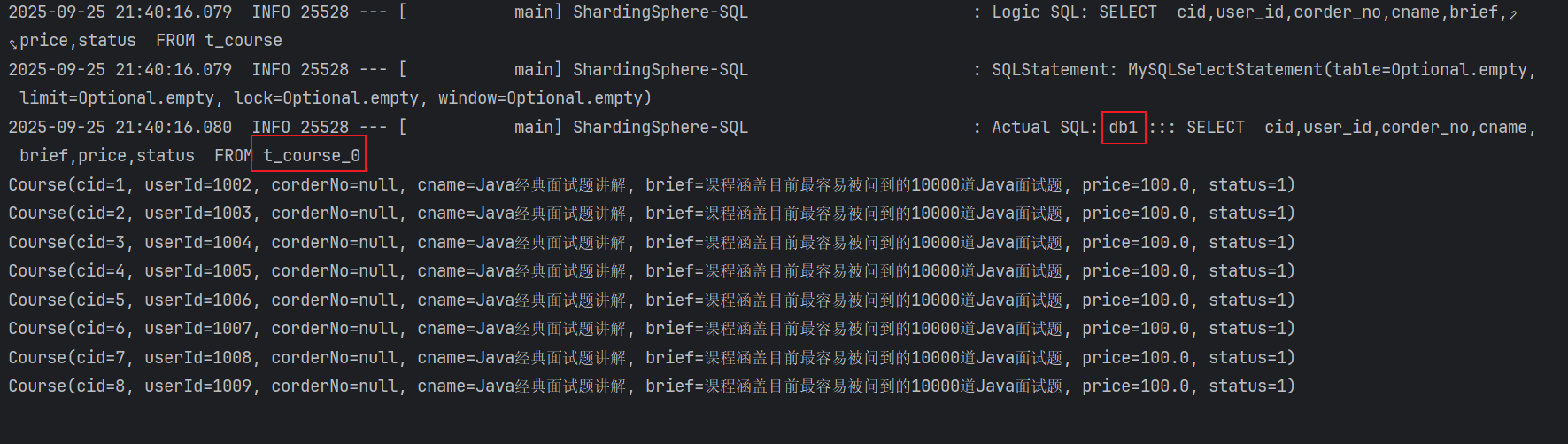

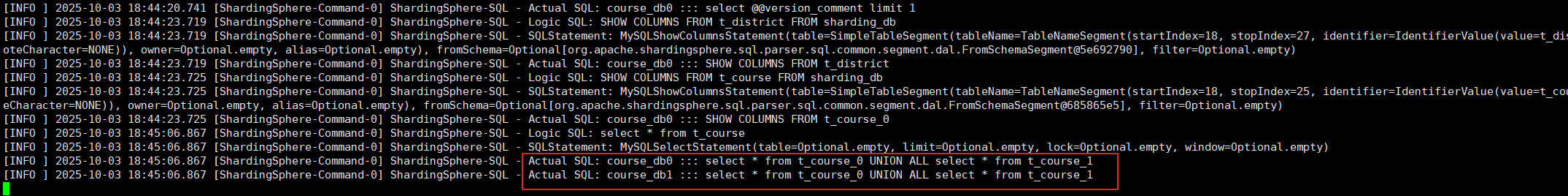

下边来测试查询,看看shardingjdbc是怎么把多个表的数据汇总查询出来的

java

//查询所有记录

@Test

public void testShardingSelectAll(){

List<Course> courseList = courseMapper.selectList(null);

courseList.forEach(System.out::println);

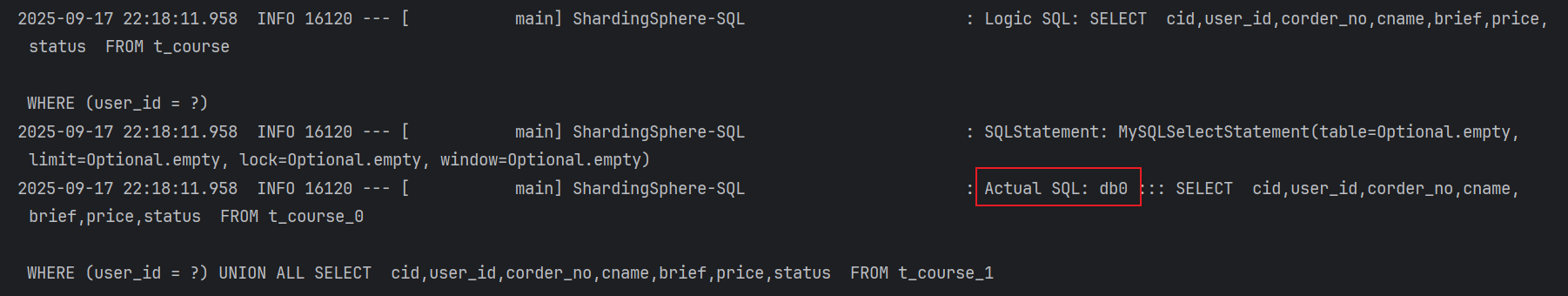

}- 查看日志: 查询了两个数据源,每个数据源中使用UNION ALL连接两个表

java

//根据user_id进行查询

@Test

public void testSelectByUserId(){

QueryWrapper<Course> courseQueryWrapper = new QueryWrapper<>();

courseQueryWrapper.eq("user_id",2L);

List<Course> courses = courseMapper.selectList(courseQueryWrapper);

courses.forEach(System.out::println);

}- 查看日志: 查询了一个数据源,使用UNION ALL连接数据源中的两个表

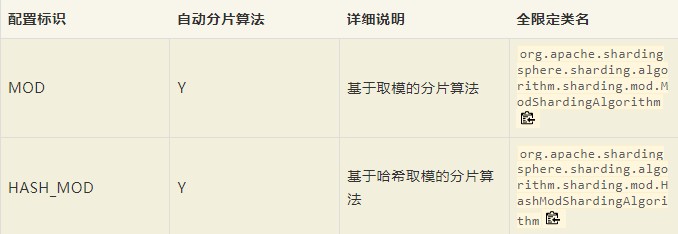

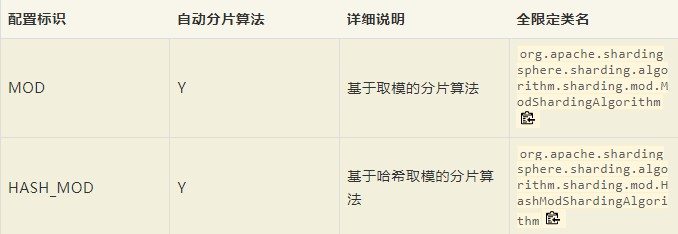

2.3.5.5 分片算法HASH_MOD和MOD

HASH_MOD和MOD是shardingjdbc中自带的分片算法

上边水平分库使用的是**t_course_ -\>{Math.abs(cid.hashCode()) % 2}\*\*取cid的hash值取模进行分库,shardingjdbc有个集成的分片规律HASH_MOD,就和t_course_ ->{Math.abs(cid.hashCode()) % 2}分片规律差不多

分表的策略db$->{user_id % 2}可以用shardingjdbc中的MOD来替代,效果都是一样

HASH_MOD配置文件内容:

properties

#----分片列名称----

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-column=cid

#----分片算法配置----

#分片算法名称 -> 取模分片算法

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-algorithm-name=table-hash-mod

#分片算法类型

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.type=HASH_MOD

#分片算法属性配置-分片数量,有两个表值设置为2

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.props.sharding-count=2MOD配置文件内容:

properties

###2.配置分片策略(分片策略包括分片键和分片算法)

##2.1 分片键名称: user_id

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-column=user_id

##2.2 分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-algorithm-name=table-mod

#2.3 --分片算法

spring.shardingsphere.rules.sharding.sharding-algorithms.table-mod.type=MOD

spring.shardingsphere.rules.sharding.sharding-algorithms.table-mod.props.sharding-count=2完整配置文件内容:

properties

# 应用名称

spring.application.name=shardingsphere-jdbc-table

# 打印SQl

spring.shardingsphere.props.sql-show=true

# 定义多个数据源

spring.shardingsphere.datasource.names = db0,db1

#数据源1

spring.shardingsphere.datasource.db0.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db0.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db0.url = jdbc:mysql://192.168.116.128:3306/course_db0?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db0.username = root

spring.shardingsphere.datasource.db0.password = 123456

#数据源2

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.129:3306/course_db1?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 123456

#1.配置数据节点

#指定course表的分布情况(配置表在哪个数据库,表名是什么)

spring.shardingsphere.rules.sharding.tables.t_course.actual-data-nodes=db$->{0..1}.t_course_$->{0..1}

###2.配置分片策略(分片策略包括分片键和分片算法)

##2.1 分片键名称: user_id

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-column=user_id

##2.2 分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-algorithm-name=table-mod

#2.3 --分片算法

spring.shardingsphere.rules.sharding.sharding-algorithms.table-mod.type=MOD

spring.shardingsphere.rules.sharding.sharding-algorithms.table-mod.props.sharding-count=2

#3.分布式序列配置

#3.1 分布式序列-列名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.column=cid

#3.2 分布式序列-算法名称

spring.shardingsphere.rules.sharding.tables.t_course.key-generate-strategy.key-generator-name=alg_snowflake

#3.3 分布式序列-算法类型

spring.shardingsphere.rules.sharding.key-generators.alg_snowflake.type=SNOWFLAKE

#----分片列名称----

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-column=cid

#4===============水平分库-分表策略==============

#4.1----分片列名称----

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-algorithm-name=table-hash-mod

###----分片算法配置----

#4.2分片算法类型

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.type=HASH_MOD

#4.3分片算法属性配置-分片数量,有两个表值设置为2

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.props.sharding-count=2

mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl测试:

java

@Test

public void testInsertCourseTable() throws InterruptedException {

for (int i = 100; i < 150; i++) {

Thread.sleep(10);

Course course = new Course();

course.setUserId(1L+i);

course.setCname("Java面试题详解");

course.setCorderNo(1000L+i);

course.setBrief("经典的10000道面试题");

course.setPrice(100.00);

course.setStatus(1);

courseMapper.insert(course);

}

}2.3.5.6 水平分库总结

水平分库包含了分库策略和分表策略.

- 分库策略 ,目的是将一个逻辑表 , 映射到多个数据源

properties

#===============水平分库-分库策略==============

#----分片列名称----

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-column=user_id

#----分片算法配置----

#分片算法名称 -> 行表达式分片算法

spring.shardingsphere.rules.sharding.tables.t_course.database-strategy.standard.sharding-algorithm-name=table-inline

#分片算法类型

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.type=INLINE

#分片算法属性配置

spring.shardingsphere.rules.sharding.sharding-algorithms.table-inline.props.algorithm-expression=db$->{user_id % 2}- 分表策略, 如何将一个逻辑表 , 映射为多个 实际表

properties

#===============水平分库-分表策略==============

#----分片列名称----

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-column=cid

##----分片算法配置----

#分片算法名称

spring.shardingsphere.rules.sharding.tables.t_course.table-strategy.standard.sharding-algorithm-name=inline-hash-mod

#分片算法类型

spring.shardingsphere.rules.sharding.sharding-algorithms.inline-hash-mod.type=INLINE

#分片算法属性配置

spring.shardingsphere.rules.sharding.sharding-algorithms.inline-hash-mod.props.algorithm-expression=t_course_$->{Math.abs(cid.hashCode()) % 2}2.3.6 实现绑定表

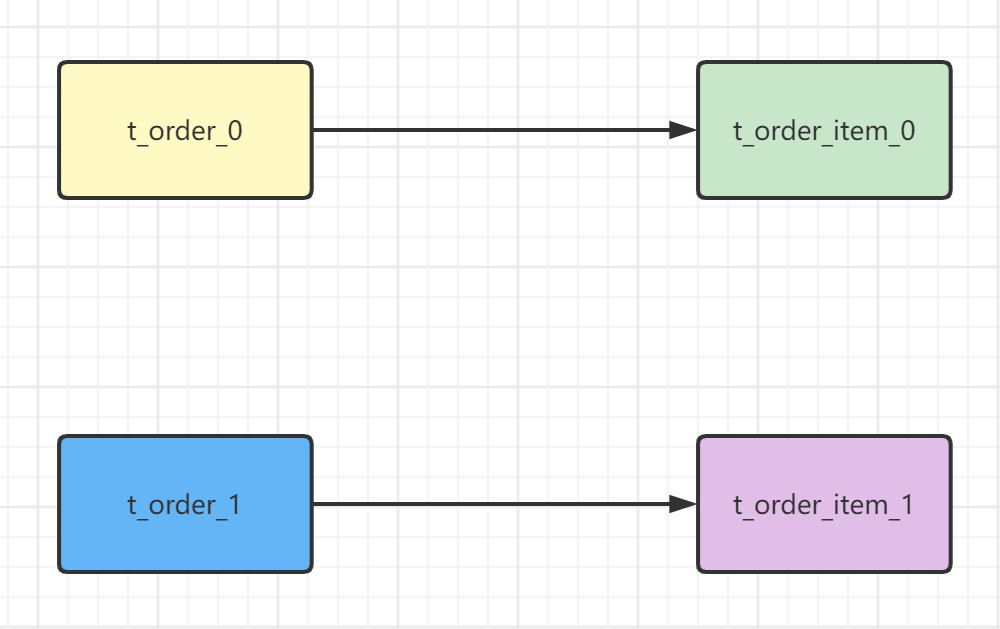

先来回顾一下绑定表的概念: 指的是分片规则一致的关系表(主表、子表),例如t_order和t_order_item,均按照order_id分片,则此两个表互为绑定表关系。绑定表之间的多表关联查询不会出现笛卡尔积关联,可以提升关联查询效率。

注: 绑定表是建立在多表关联的基础上的.所以我们先来完成多表关联的配置

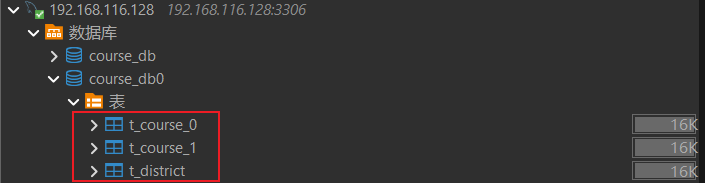

2.3.6.1 数据准备

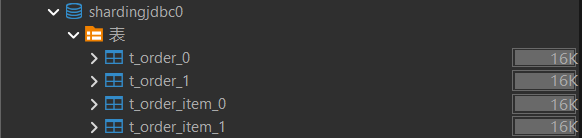

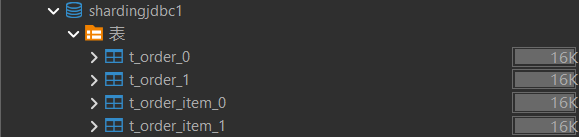

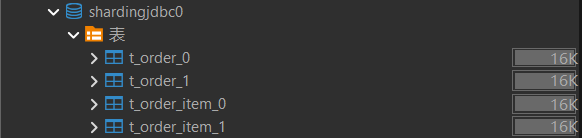

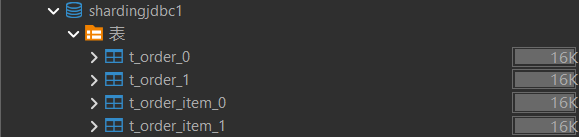

先在两个服务器中分别创建shardingjdbc这个数据库,具体库和表如下

server01:

server02:

- 创建表在

server01服务器上的shardingjdbc0数据库 和server02服务器上的shardingjdbc1数据库分别创建t_order和t_order_item表 ,表结构如下:

sql

CREATE TABLE `t_order_0` (

`order_id` bigint NOT NULL COMMENT '订单ID',

`user_id` int NOT NULL COMMENT '用户ID',

`product_name` varchar(255) NOT NULL COMMENT '商品名称',

`total_price` decimal(10,2) NOT NULL COMMENT '总价',

`status` varchar(50) DEFAULT 'CREATED' COMMENT '订单状态',

`create_time` datetime DEFAULT CURRENT_TIMESTAMP,

PRIMARY KEY (`order_id`)

);

CREATE TABLE `t_order_1` (

`order_id` bigint NOT NULL COMMENT '订单ID',

`user_id` int NOT NULL COMMENT '用户ID',

`product_name` varchar(255) NOT NULL COMMENT '商品名称',

`total_price` decimal(10,2) NOT NULL COMMENT '总价',

`status` varchar(50) DEFAULT 'CREATED' COMMENT '订单状态',

`create_time` datetime DEFAULT CURRENT_TIMESTAMP,

PRIMARY KEY (`order_id`)

);

CREATE TABLE `t_order_item_0` (

`item_id` bigint NOT NULL COMMENT '订单项ID',

`order_id` bigint NOT NULL COMMENT '订单ID',

`product_name` varchar(255) NOT NULL COMMENT '商品名称',

`price` decimal(10,2) NOT NULL COMMENT '单价',

`user_id` int NOT NULL COMMENT '用户ID',

`quantity` int NOT NULL COMMENT '数量',

`total_price` decimal(10,2) NOT NULL COMMENT '小计',

`create_time` datetime DEFAULT CURRENT_TIMESTAMP,

PRIMARY KEY (`item_id`)

);

CREATE TABLE `t_order_item_1` (

`item_id` bigint NOT NULL COMMENT '订单项ID',

`order_id` bigint NOT NULL COMMENT '订单ID',

`product_name` varchar(255) NOT NULL COMMENT '商品名称',

`price` decimal(10,2) NOT NULL COMMENT '单价',

`user_id` int NOT NULL COMMENT '用户ID',

`quantity` int NOT NULL COMMENT '数量',

`total_price` decimal(10,2) NOT NULL COMMENT '小计',

`create_time` datetime DEFAULT CURRENT_TIMESTAMP,

PRIMARY KEY (`item_id`)

);2.3.6.2 创建实体类

java

@TableName("t_order")

@Data

@ToString

public class TOrder {

@TableId

private Long orderId;

private Integer userId;

private String productName;

private BigDecimal totalPrice;

private String status;

private LocalDateTime createTime;

}

java

@TableName("t_order_item")

@Data

@ToString

public class TOrderItem {

@TableId

private Long itemId;

private Long orderId;

private String productName;

private BigDecimal price;

private Integer quantity;

private Integer userId;

private BigDecimal totalPrice;

private LocalDateTime createTime;

}2.3.6.3 创建mapper

java

@Mapper

public interface TOrderMapper extends BaseMapper<TOrder> {

}

java

@Mapper

public interface TOrderItemMapper extends BaseMapper<TOrderItem> {

}2.3.6.4 配置多表关联

t_order的分片表、分片策略、分布式序列策略和t_order_item保持一致

- 数据源

properties

# 定义多个数据源

spring.shardingsphere.datasource.names = db0,db1

#数据源1

spring.shardingsphere.datasource.db0.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db0.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db0.url = jdbc:mysql://192.168.116.128:3306/shardingjdbc0?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db0.username = root

spring.shardingsphere.datasource.db0.password = 123456

#数据源2

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.129:3306/shardingjdbc1?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 123456- 数据节点

properties

#1.配置数据节点

#指定course表的分布情况(配置表在哪个数据库,表名是什么)

spring.shardingsphere.rules.sharding.tables.t_order.actual-data-nodes=db$->{0..1}.t_order_$->{0..1}

spring.shardingsphere.rules.sharding.tables.t_order_item.actual-data-nodes=db$->{0..1}.t_order_item_$->{0..1}- 分库策略

properties

#2.=========水平分库-分库策略========

## t_order 分库策略

spring.shardingsphere.rules.sharding.tables.t_order.database-strategy.standard.sharding-column=user_Id

spring.shardingsphere.rules.sharding.tables.t_order.database-strategy.standard.sharding-algorithm-name=table-mod

# ----t_course_section分库策略

spring.shardingsphere.rules.sharding.tables.t_order_item.database-strategy.standard.sharding-column=user_Id

spring.shardingsphere.rules.sharding.tables.t_order_item.database-strategy.standard.sharding-algorithm-name=table-mod- 分表策略

properties

#================水平分库-分表策略

## t_order 分表策略

spring.shardingsphere.rules.sharding.tables.t_order.table-strategy.standard.sharding-column=order_Id

spring.shardingsphere.rules.sharding.tables.t_order.table-strategy.standard.sharding-algorithm-name=table-hash-mod

## t_order_item 分表策略

spring.shardingsphere.rules.sharding.tables.t_order_item.table-strategy.standard.sharding-column=order_Id

spring.shardingsphere.rules.sharding.tables.t_order_item.table-strategy.standard.sharding-algorithm-name=table-hash-mod- 分片算法

properties

#3.=========分片算法========

spring.shardingsphere.rules.sharding.sharding-algorithms.table-mod.type=MOD

spring.shardingsphere.rules.sharding.sharding-algorithms.table-mod.props.sharding-count=2

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.type=HASH_MOD

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.props.sharding-count=2完整配置文件

properties

# 应用名称

spring.application.name=shardingsphere-jdbc-table

# 打印SQl

spring.shardingsphere.props.sql-show=true

# 定义多个数据源

spring.shardingsphere.datasource.names = db0,db1

#数据源1

spring.shardingsphere.datasource.db0.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db0.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db0.url = jdbc:mysql://192.168.116.128:3306/shardingjdbc0?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db0.username = root

spring.shardingsphere.datasource.db0.password = 123456

#数据源2

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.129:3306/shardingjdbc1?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 123456

#1.配置数据节点

#指定course表的分布情况(配置表在哪个数据库,表名是什么)

spring.shardingsphere.rules.sharding.tables.t_order.actual-data-nodes=db$->{0..1}.t_order_$->{0..1}

spring.shardingsphere.rules.sharding.tables.t_order_item.actual-data-nodes=db$->{0..1}.t_order_item_$->{0..1}

#2.=========水平分库-分库策略========

## t_order 分库策略

spring.shardingsphere.rules.sharding.tables.t_order.database-strategy.standard.sharding-column=user_Id

spring.shardingsphere.rules.sharding.tables.t_order.database-strategy.standard.sharding-algorithm-name=table-mod

# ----t_course_section分库策略

spring.shardingsphere.rules.sharding.tables.t_order_item.database-strategy.standard.sharding-column=user_Id

spring.shardingsphere.rules.sharding.tables.t_order_item.database-strategy.standard.sharding-algorithm-name=table-mod

#================水平分库-分表策略

## t_order 分表策略

spring.shardingsphere.rules.sharding.tables.t_order.table-strategy.standard.sharding-column=order_Id

spring.shardingsphere.rules.sharding.tables.t_order.table-strategy.standard.sharding-algorithm-name=table-hash-mod

## t_order_item 分表策略

spring.shardingsphere.rules.sharding.tables.t_order_item.table-strategy.standard.sharding-column=order_Id

spring.shardingsphere.rules.sharding.tables.t_order_item.table-strategy.standard.sharding-algorithm-name=table-hash-mod

#3.=========分片算法========

spring.shardingsphere.rules.sharding.sharding-algorithms.table-mod.type=MOD

spring.shardingsphere.rules.sharding.sharding-algorithms.table-mod.props.sharding-count=2

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.type=HASH_MOD

spring.shardingsphere.rules.sharding.sharding-algorithms.table-hash-mod.props.sharding-count=2

#3.分布式序列配置

#3.1 分布式序列-列名称

spring.shardingsphere.rules.sharding.tables.t_order.key-generate-strategy.column=cid

#3.2 分布式序列-算法名称

spring.shardingsphere.rules.sharding.tables.t_order.key-generate-strategy.key-generator-name=alg_snowflake

#3.分布式序列配置

#3.1 分布式序列-列名称

spring.shardingsphere.rules.sharding.tables.t_order_item.key-generate-strategy.column=item_id

#3.2 分布式序列-算法名称

spring.shardingsphere.rules.sharding.tables.t_order_item.key-generate-strategy.key-generator-name=alg_snowflake_item

#3.3 分布式序列-算法类型

spring.shardingsphere.rules.sharding.key-generators.alg_snowflake.type=SNOWFLAKE

mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl

spring.shardingsphere.rules.sharding.binding-tables[0]=t_order,t_order_item2.3.6.5 测试插入数据

java

@Test

public void createOrderAndItems() {

for (int j = 0; j < 10; j++) {

// 1. 创建订单主表记录

TOrder order = new TOrder();

order.setUserId(1+j);

order.setProductName("iPhone 15 Pro");

order.setTotalPrice(new BigDecimal("8999.00"));

order.setStatus("CREATED");

order.setCreateTime(LocalDateTime.now());

// 插入主表

orderMapper.insert(order);

System.out.println("主单已插入: " + order);

// 2. 创建订单项(多个商品)

for (int i = 1; i <= 2; i++) {

TOrderItem item = new TOrderItem();

item.setOrderId(order.getOrderId());

item.setProductName("配件" + i);

item.setPrice(new BigDecimal("99.00"));

item.setQuantity(1);

item.setUserId(order.getUserId());

item.setTotalPrice(new BigDecimal("99.00"));

item.setCreateTime(LocalDateTime.now());

orderItemMapper.insert(item);

System.out.println("订单项已插入: " + item);

}

}

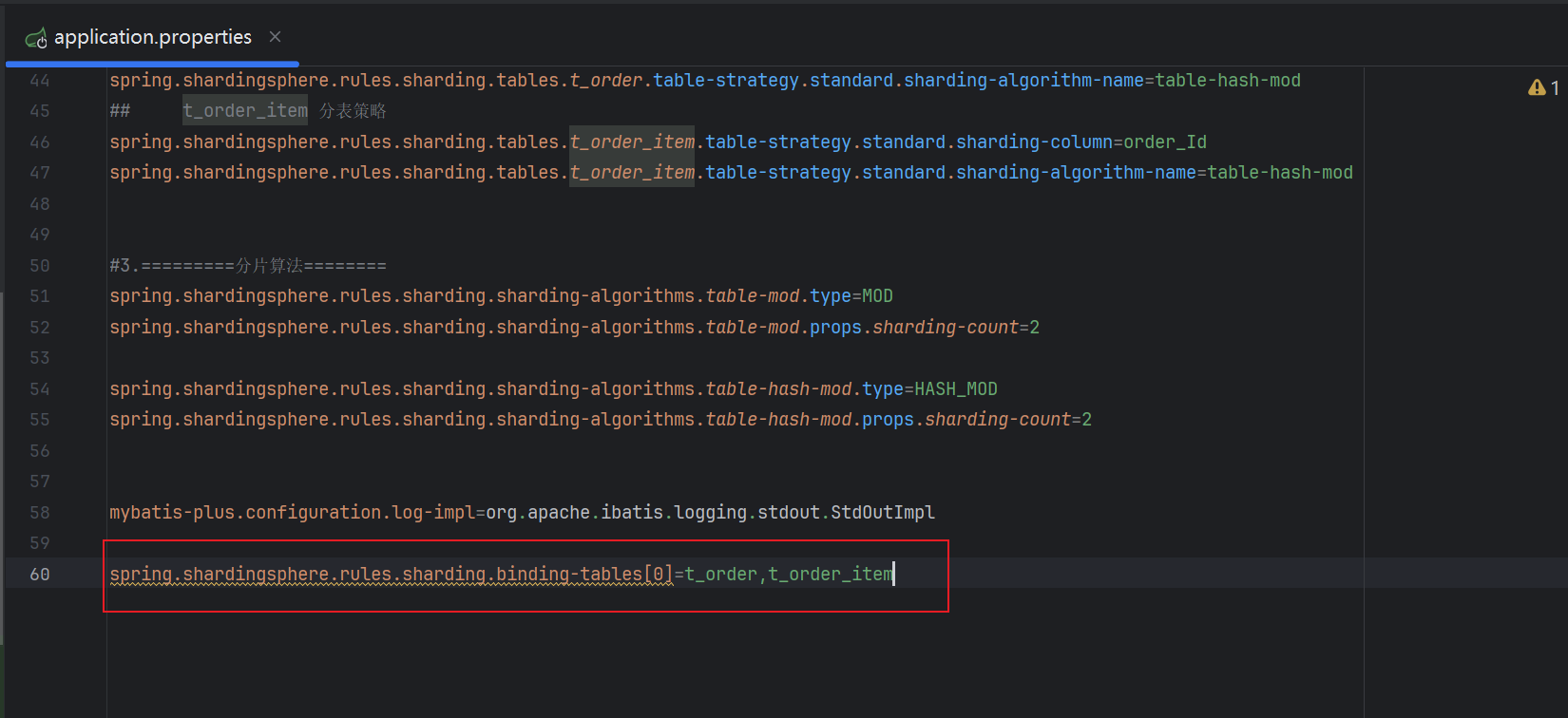

}2.3.6.6 配置绑定表

需求说明: 查询每个订单的订单号和订单名称和购买数量

- 根据需求编写SQL

sql

SELECT t_order.order_Id,t_order.product_name,t_order_item.quantity FROM t_order INNER join t_order_item on t_order.order_Id = t_order_item.order_Id- 创建DTO类

java

@Data

public class TOrderDTO {

@TableId

private Long orderId;

private String productName;

private Integer quantity;

}- 添加Mapper方法

java

@Mapper

public interface TOrderMapper extends BaseMapper<TOrder> {

@Select("SELECT t_order.order_Id,t_order.product_name,t_order_item.quantity FROM t_order INNER join t_order_item on t_order.order_Id = t_order_item.order_Id ")

List<TOrderDTO> findItemNamesByOrderId();

}- 进行关联查询

java

@Test

public void findItemNamesByOrderId(){

List<TOrderDTO> tOrderDTOS = orderMapper.findItemNamesByOrderId();

tOrderDTOS.forEach(System.out::println);

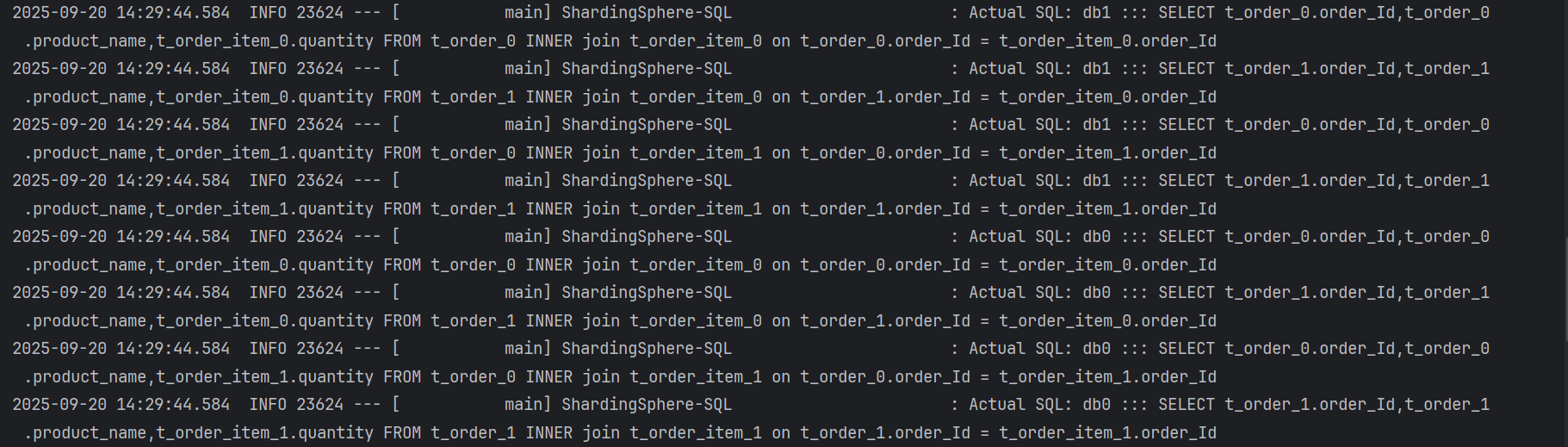

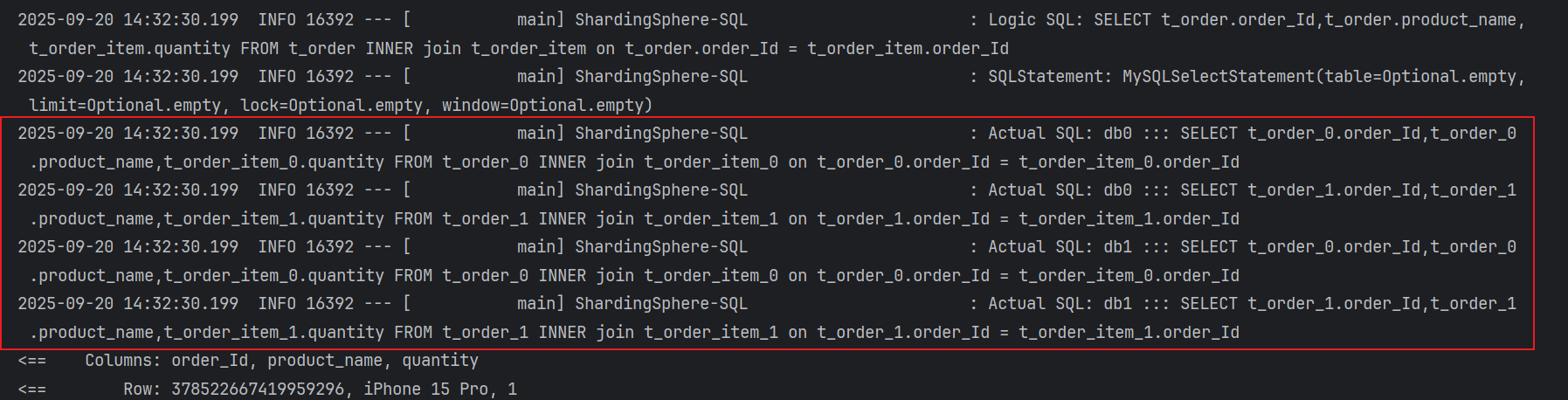

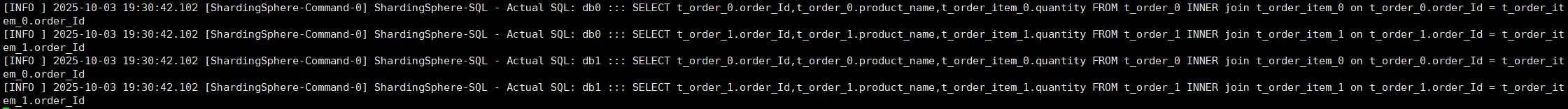

}- **如果不配置绑定表:测试的结果为8个SQL。**多表关联查询会出现笛卡尔积关联。

- 配置绑定表

properties

#======================绑定表

spring.shardingsphere.rules.sharding.binding-tables[0]=t_course,t_course_section- 如果配置绑定表:测试的结果为4个SQL。 多表关联查询不会出现笛卡尔积关联,关联查询效率将大大提升。

2.3.6.7 总结

以 order 表和 order_item 表为例,它们在每个数据库中都存在多个分片表。如果两者的分片策略完全一致(即使用相同的分片键和分片算法),必须将它们配置为绑定表(Binding Tables)。否则,在执行多表 JOIN 查询时,ShardingSphere-JDBC 无法确定哪些具体的分片表之间存在对应关系,只能对所有分片组合进行笛卡尔积式的关联,导致查询性能急剧下降,甚至引发不必要的全节点扫描。

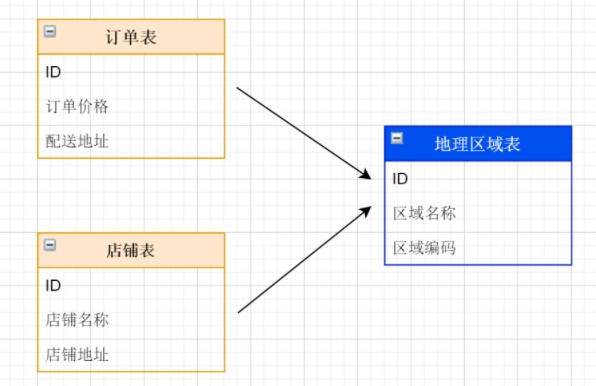

2.3.7 实现广播表(公共表)

2.3.7.1 公共表介绍

公共表属于系统中数据量较小,变动少,而且属于高频联合查询的依赖表。参数表、数据字典表等属于此类型。

可以将这类表在每个数据库都保存一份,所有更新操作都同时发送到所有分库执行。接下来看一下如何使用Sharding-JDBC实现公共表的数据维护。

2.3.7.2 代码编写

1) 创建表

分别在 msb_course_db0 , msb_course_db1 ,msb_user_db 都创建 t_district表

sql

-- 区域表

CREATE TABLE t_district (

id BIGINT(20) PRIMARY KEY COMMENT '区域ID',

district_name VARCHAR(100) COMMENT '区域名称',

LEVEL INT COMMENT '等级'

);2) 创建实体类

java

@TableName("t_district")

@Data

public class District {

@TableId(type = IdType.ASSIGN_ID)

private Long id;

private String districtName;

private int level;

}3) 创建mapper

java

@Mapper

public interface DistrictMapper extends BaseMapper<District> {

}2.3.7.3 广播表配置

- 数据源

properties

# 应用名称

spring.application.name=shardingsphere-jdbc-table

# 打印SQl

spring.shardingsphere.props.sql-show=true

# 定义多个数据源

spring.shardingsphere.datasource.names = db0,db1

#数据源1

spring.shardingsphere.datasource.db0.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db0.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db0.url = jdbc:mysql://192.168.116.128:3306/shardingjdbc0?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db0.username = root

spring.shardingsphere.datasource.db0.password = 123456

#数据源2

spring.shardingsphere.datasource.db1.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.db1.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.db1.url = jdbc:mysql://192.168.116.129:3306/shardingjdbc1?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.db1.username = root

spring.shardingsphere.datasource.db1.password = 123456

#数据节点可不配置,默认情况下,向所有数据源广播

spring.shardingsphere.rules.sharding.tables.t_district.actual-data-nodes=db$->{0..1}.t_district

mybatis-plus.configuration.log-impl=org.apache.ibatis.logging.stdout.StdOutImpl- 广播表配置

properties

#------------------------广播表配置

# 广播表规则列表

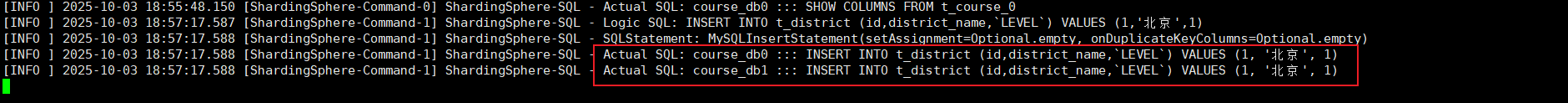

spring.shardingsphere.rules.sharding.broadcast-tables[0]=t_district2.3.7.4 测试广播表

java

//广播表: 插入数据 两个数据源中都会插入

@Test

public void testBroadcast(){

District district = new District();

district.setDistrictName("昌平区");

district.setLevel(1);

districtMapper.insert(district);

}

//查询操作,只从一个节点获取数据, 随机负载均衡规则

@Test

public void testSelectBroadcast(){

List<District> districtList = districtMapper.selectList(null);

districtList.forEach(System.out::println);

}2.3.7.5 总结

由于 ShardingSphere-JDBC 不支持跨数据库实例(即跨数据源)的 JOIN 操作 ,所有关联查询必须在同一个数据库节点内完成。当 SQL 中涉及分片表与非分片表(如字典表)的 JOIN 时,若该非分片表未被配置为 广播表(Broadcast Table) ,ShardingSphere 将无法确定其所在的数据节点,导致路由失败并抛出异常。因此,此类公共表必须显式配置为广播表,使其在每个数据库实例中都存在完整副本,从而确保 JOIN 查询能在单个节点内正确执行。

2.4 读写分离详解与实战

2.4.1 读写分离架构介绍

2.4.1.1 读写分离原理

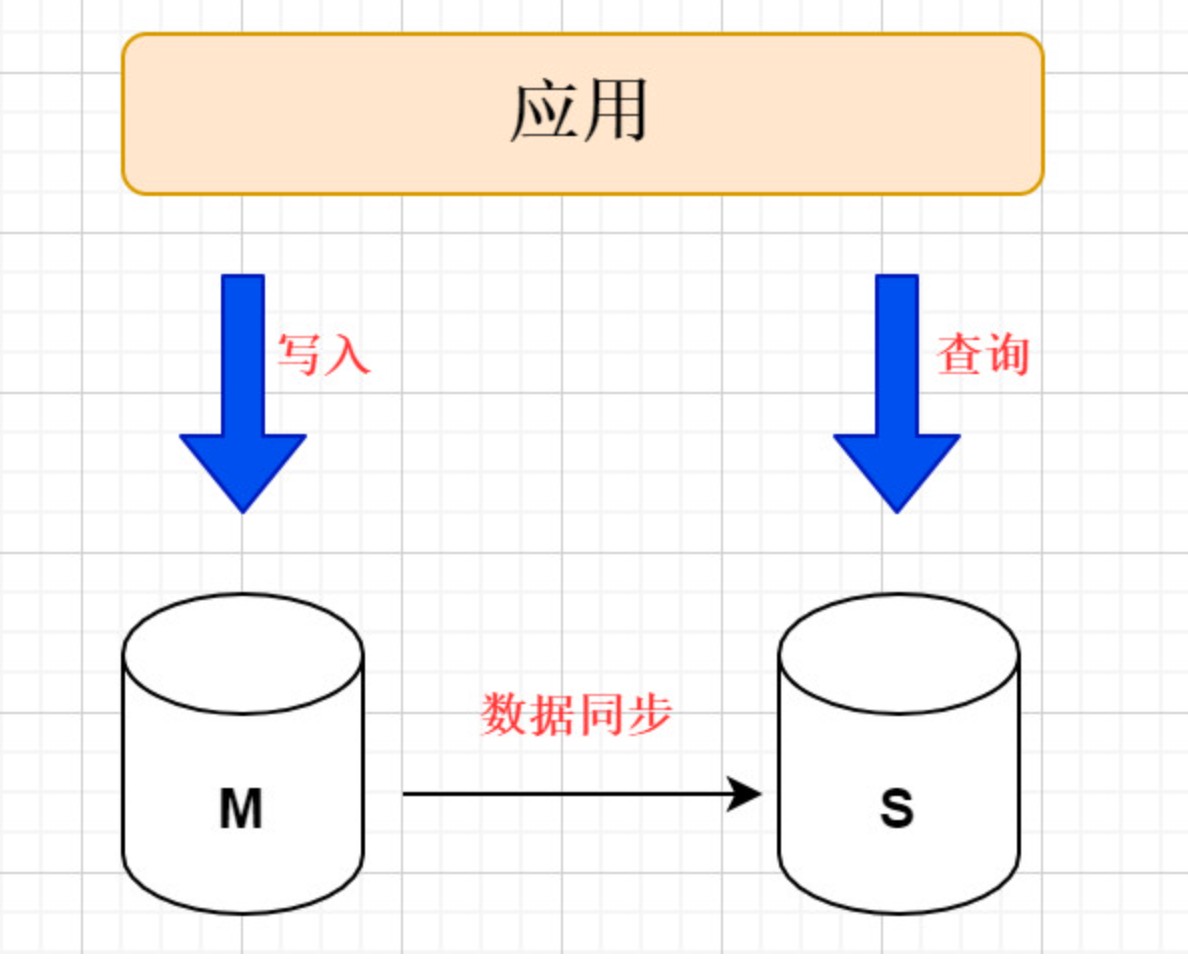

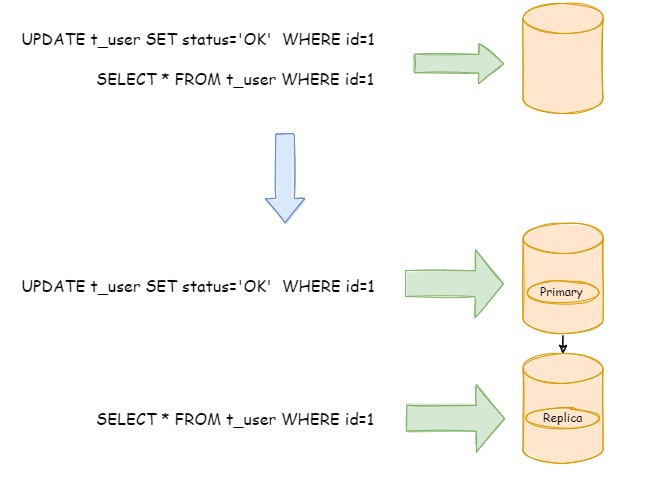

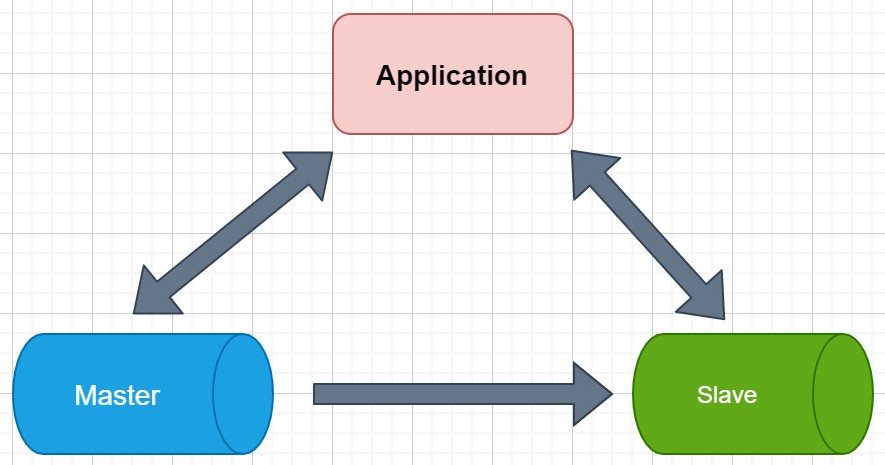

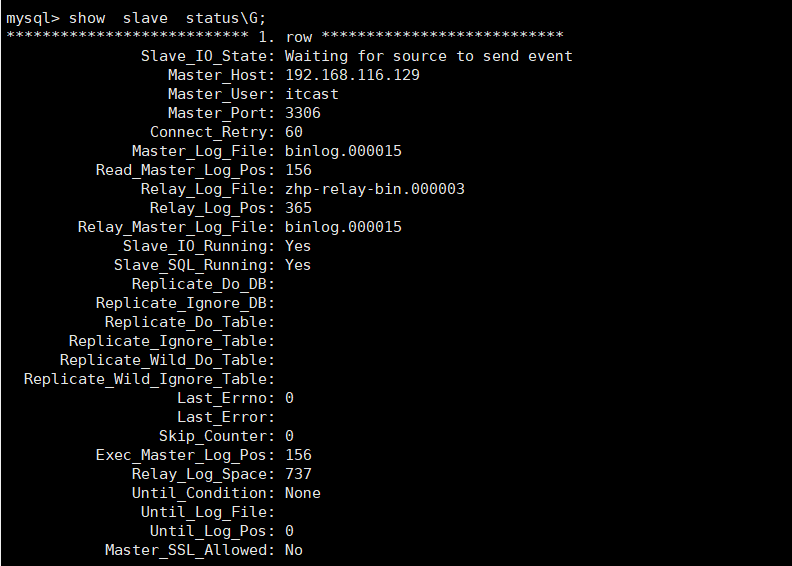

**读写分离原理:**读写分离就是让主库处理事务性操作,从库处理select查询。数据库复制被用来把事务性查询导致的数据变更同步到从库,同时主库也可以select查询。

注意: 读写分离的数据节点中的数据内容是一致。

读写分离的基本实现:

- 主库负责处理事务性的增删改操作,从库负责处理查询操作,能够有效的避免由数据更新导致的行锁,使得整个系统的查询性能得到极大的改善。

- 读写分离是根据 SQL 语义的分析

,将读操作和写操作分别路由至主库与从库。 - 通过一主多从的配置方式,可以将查询请求均匀的分散到多个数据副本,能够进一步的提升系统的处理能力。

- 使用多主多从的方式,不但能够提升系统的吞吐量,还能够提升系统的可用性,可以达到在任何一个数据库宕机,甚至磁盘物理损坏的情况下仍然不影响系统的正常运行

将用户表的写操作和读操路由到不同的数据库

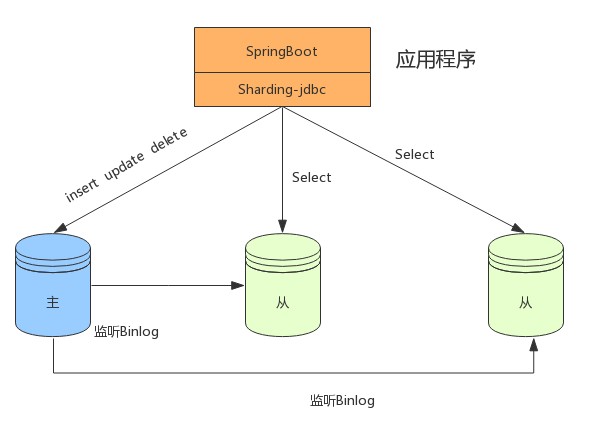

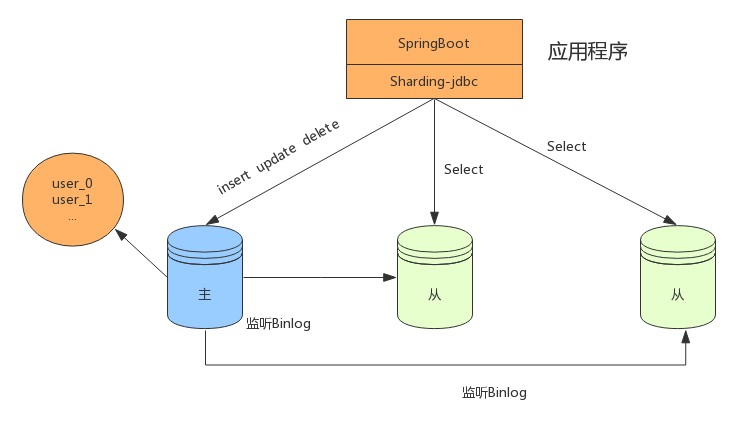

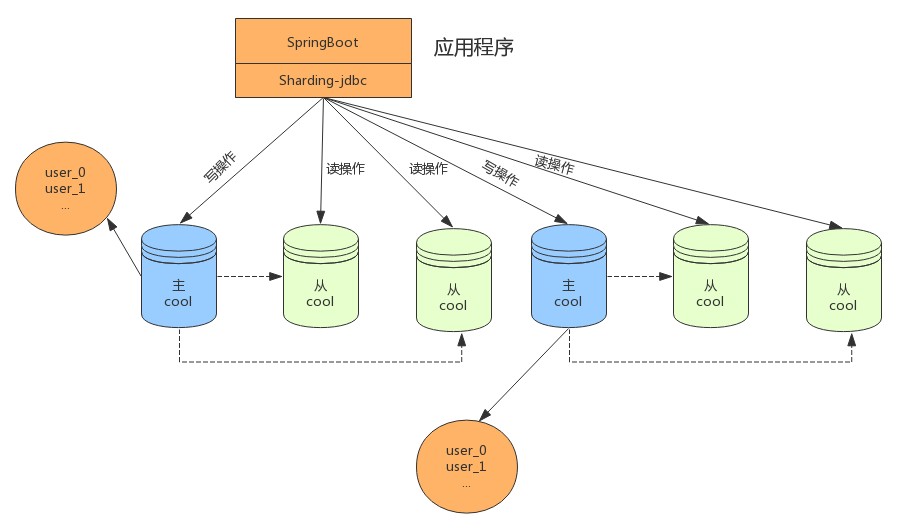

2.4.1.2 读写分离应用方案

在数据量不是很多的情况下,我们可以将数据库进行读写分离,以应对高并发的需求,通过水平扩展从库,来缓解查询的压力。如下:

分表+读写分离

在数据量达到500万的时候,这时数据量预估千万级别,我们可以将数据进行分表存储。

分库分表+读写分离

在数据量继续扩大,这时可以考虑分库分表,将数据存储在不同数据库的不同表中,如下:

读写分离虽然可以提升系统的吞吐量和可用性,但同时也带来了数据不一致的问题,包括多个主库之间的数据一致性,以及主库与从库之间的数据一致性的问题。 并且,读写分离也带来了与数据分片同样的问题,它同样会使得应用开发和运维人员对数据库的操作和运维变得更加复杂。

透明化读写分离所带来的影响,让使用方尽量像使用一个数据库一样使用主从数据库集群,是ShardingSphere读写分离模块的主要设计目标。

主库、从库、主从同步、负载均衡

- 核心功能

- 提供一主多从的读写分离配置。仅支持单主库,可以支持独立使用,也可以配合分库分表使用

- 独立使用读写分离,支持SQL透传。不需要SQL改写流程

- 同一线程且同一数据库连接内,能保证数据一致性。如果有写入操作,后续的读操作均从主库读取。

- 基于Hint的强制主库路由。可以强制路由走主库查询实时数据,避免主从同步数据延迟。

- 不支持项

- 主库和从库的数据同步

- 主库和从库的数据同步延迟

- 主库双写或多写

- 跨主库和从库之间的事务的数据不一致。建议在主从架构中,事务中的读写均用主库操作。

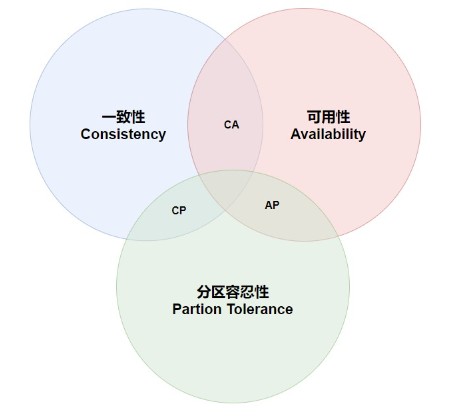

2.4.2 CAP 理论

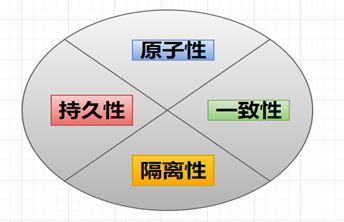

2.4.2.1 CAP理论介绍

CAP 定理(CAP theorem)又被称作布鲁尔定理(Brewer's theorem),是加州大学伯克利分校的计算机科学家埃里克·布鲁尔(Eric Brewer)在 2000 年的 ACM PODC 上提出的一个猜想。对于设计分布式系统的架构师来说,CAP 是必须掌握的理论。

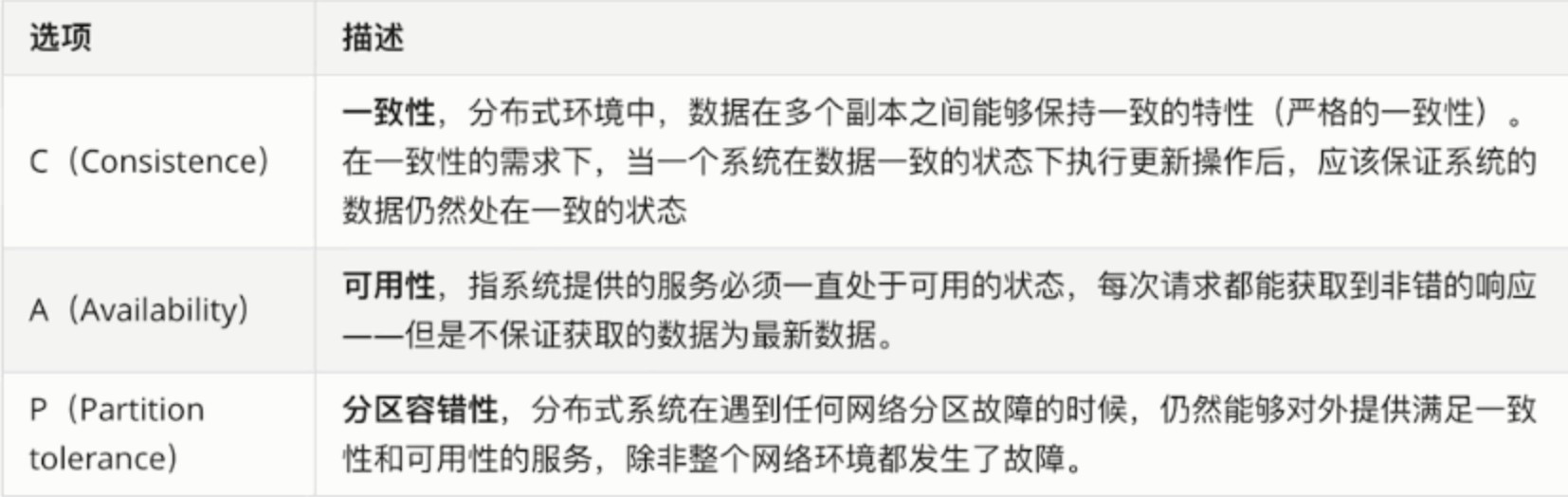

在一个分布式系统中,当涉及读写操作时,只能保证一致性(Consistence)、可用性(Availability)、分区容错性(Partition Tolerance)三者中的两个,另外一个必须被牺牲。

- C 一致性(Consistency):等同于所有节点访问同一份最新的数据副本

在分布式环境中,数据在多个副本之间能够保持一致的特性,也就是所有的数据节点里面的数据要是一致的

- A 可用性(Availability):每次请求都能够获取到非错的响应(不是错误和超时的响应) , 但是不能够保证获取的数据为最新的数据.

意思是只要收到用户的请求,服务器就必须给出一个成功的回应. 不要求数据是否是最新的.

- P 分区容错性(Partition Tolerance):以实际效果而言,分区相当于对通信的时限要求. 系统如果不能在时限内达成数据一致性,就意味着发生了分区的情况 , 必须对当前操作在C和A之间作出选择.

更简单的理解就是: 大多数分布式系统都分布在多个子网络。每个子网络就叫做一个区(partition)。分区容错的意思是,区间通信可能失败(可能是丢包,也可能是连接中断,还可能是拥塞) ,但是系统能够继续"履行职责" 正常运行.

一般来说,分布式系统,分区容错无法避免,因此可以认为 CAP 的 P 总是成立。根据CAP 定理,剩下的 C 和 A 无法同时做到。

2.4.2.2 CAP理论特点

CAP如何取舍

- CAP理论的C也就是一致性,不等于事务ACID中的C(数据的一致性), CAP理论中的C可以理解为副本的一致性.即所有的副本的结果都是有一致的.

- 在没有网络分区的单机系统中可以选择保证CA, 但是在分布式系统中存在网络通信环节,网络通信在多机中是不可靠的,P是必须要选择的,为了 保证P就需要在C和A之间作出选择

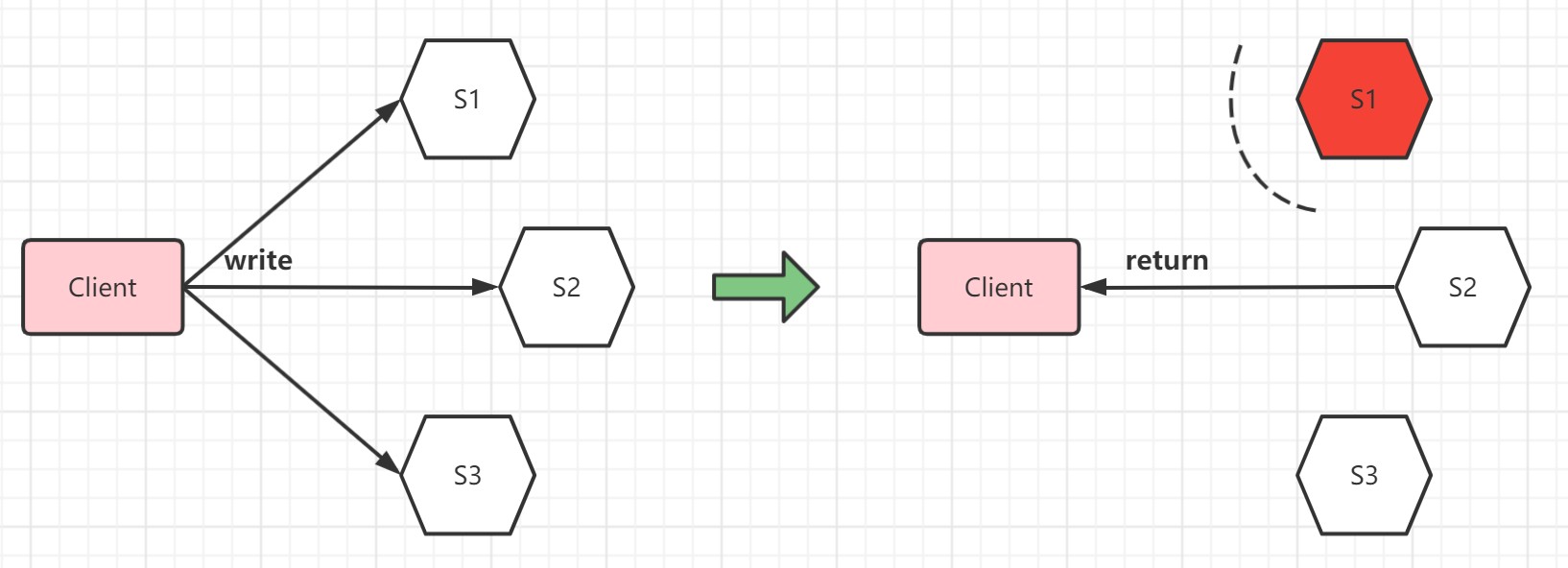

假设有三个副本,写入时有下面两个方案

方案一: W=1, 一写,向三个副本写入,只要一个副本写入成功,即认为成功

一写的情况下,只要写入一个副本成功即可返回写入成功,出现网络分区后,三台机器的数据就有可能出现不一致, 无法保证C. (比如server1与其他节点的网络中断了,那S1与S2 S3 就不一致的了), 但是因为可以正常返回写入成功,A依旧可以保证.

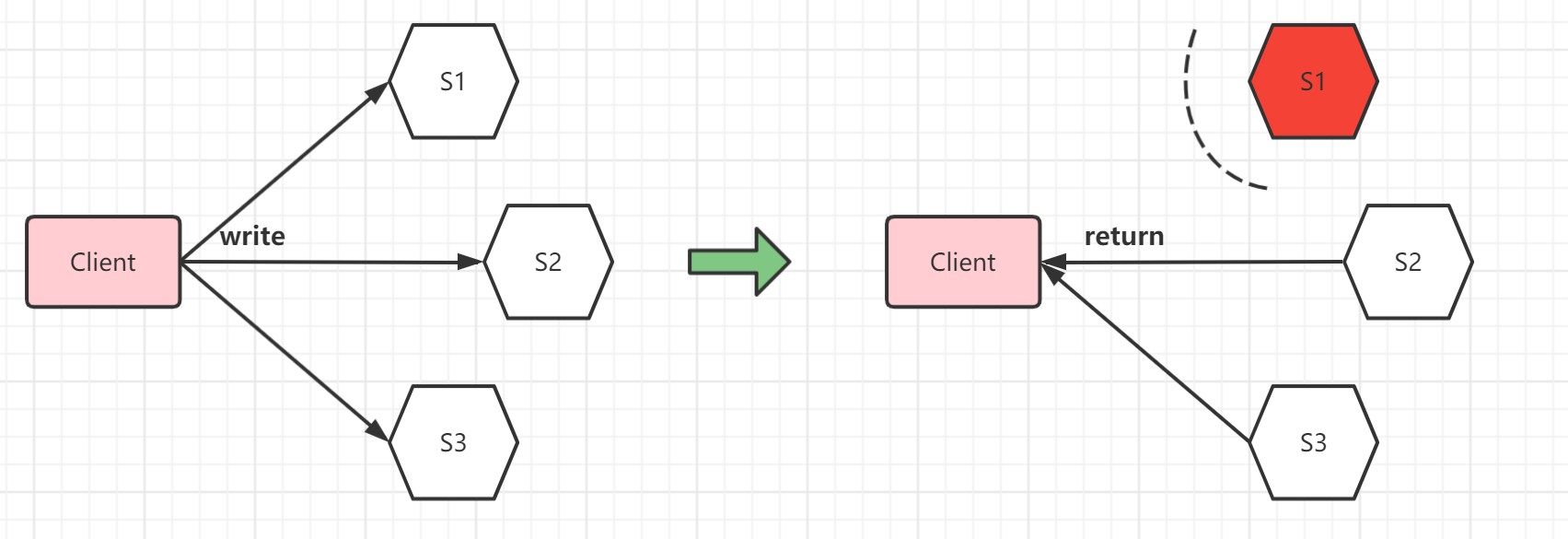

方案二: W=2, 三写,向三个副本写入,三个副本写入成功,才认为是成功

在三写的情况下,要三个副本都写入成功,才可以返回成功,出现网络分区后,无法实现这一点,最终会返回报错,所以没有保证A,但是保证了C.

2.4.2.3 分布式数据库对于CAP理论的实践

从上面的分析我们可以总结出来: 在分布式环境中,P是一定存在的,一旦出现了网络分区,那么一致性和可用性就一定要抛弃一个.

- 对于NoSQL数据库,更加注重可用性,所以会是一个AP系统.

- 对于分布式关系型数据库,必须要保证一致性,所以会是一个CP系统.

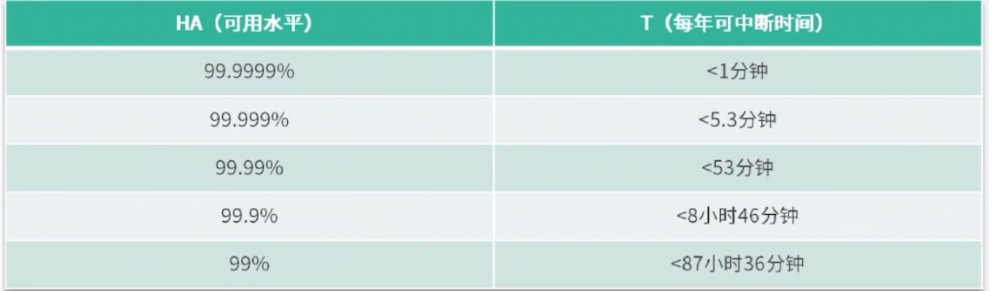

分布式关系型数据库仍有高可用性需求,虽然达不到CAP理论中的100%可用性,单一般都具备五个9(99.999%) 以上的高可用.

-

**计算公式: A表示可用性; MTBF表示平均故障间隔; MTTR表示平均恢复时间 **

-

高可用有一个标准,9越多代表越容错, 可用性越高.

假设系统一直能够提供服务,我们说系统的可用性是100%。如果系统每运行100个时间单位,会有1个时间单位无法提供服务,我们说系统的可用性是99%。很多公司的高可用目标是4个9,也就是99.99%

我们可以将分布式关系型数据库看做是CP+HA的系统.由此也产生了两个广泛的应用指标.

- **RPO(Recovery PointObjective): ** 恢复点目标,指数据库在灾难发生后会丢失多长时间的数据.分布式关系型数据库RPO=0.

- RTO(Recovery Time Objective): 恢复时间目标,指数据库在灾难发生后到整个系统恢复正常所需要的时间.分布式关系型数据库RTO < 几分钟(因为有主备切换,所以一般恢复时间就是几分钟).

总结一下: CAP理论并不是让我们选择C或者选择A就完全抛弃另外一个, 这样极端显然是不对的,实际上在设计一个分布式系统时,P是必须的,所以要在AC中取舍一个"降级"。根据不同场景来取舍A或者C.

2.4.3 MySQL主从同步

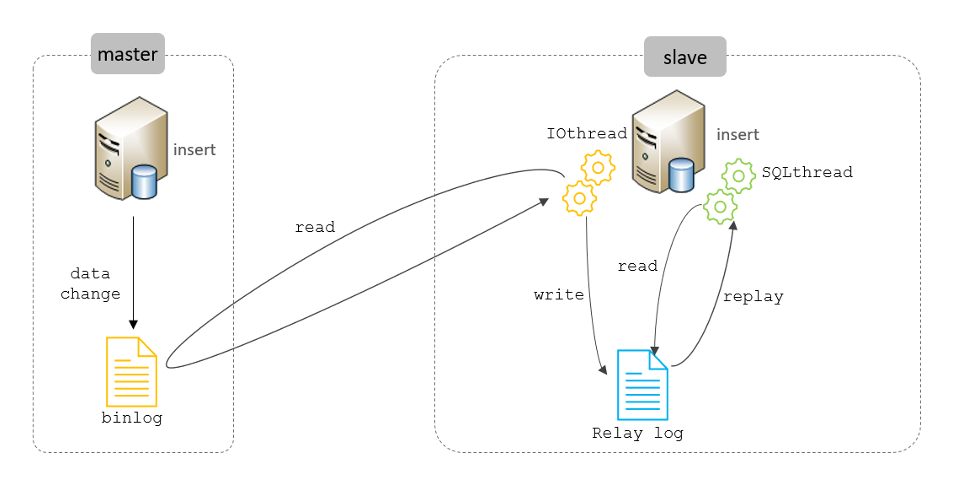

2.4.3.1 主从同步原理

读写分离是建立在MySQL主从复制基础之上实现的,所以必须先搭建MySQL的主从复制架构。

主从复制的用途

- 实时灾备,用于故障切换

- 读写分离,提供查询服务

- 备份,避免影响业务

主从部署必要条件

- 主库开启binlog日志(设置log-bin参数)

- 主从server-id不同

- 从库服务器能连通主库

主从复制的原理

- Mysql 中有一种日志叫做 binlog日志(二进制日志)。这个日志会记录下所有修改了数据库的SQL 语句(insert,update,delete,create/alter/drop table, grant 等等)。

- 主从复制的原理其实就是把主服务器上的 binlog日志复制到从服务器上执行一遍,这样从服务器上的数据就和主服务器上的数据相同了。

- 主库db的更新事件(update、insert、delete)被写到binlog

- 主库创建一个binlog dump thread,把binlog的内容发送到从库

- 从库启动并发起连接,连接到主库

- 从库启动之后,创建一个I/O线程,读取主库传过来的binlog内容并写入到relay log

- 从库启动之后,创建一个SQL线程,从relay log里面读取内容,执行读取到的更新事件,将更新内容写入到slave的db

2.4.3.2 一主一从架构搭建

Mysql的主从复制至少是需要两个Mysql的服务,当然Mysql的服务是可以分布在不同的服务器上,也可以在一台服务器上启动多个服务。

准备:

| 主机 | 角色 | 用户名 | 密码 |

|---|---|---|---|

| 192.168.116.129 | master | root | 123456 |

| 192.168.116.128 | slave | root | 123456 |

第一步 master中和slave创建数据库

sql

-- 创建数据库

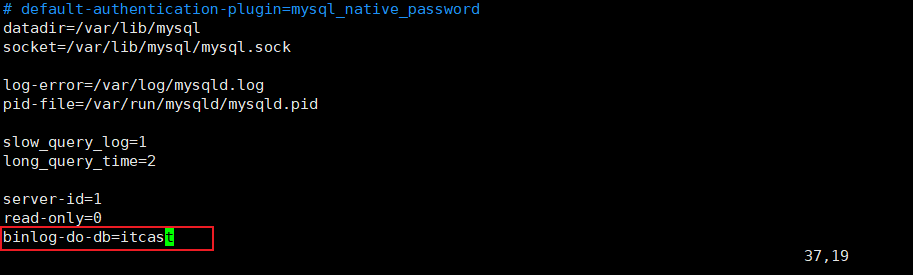

CREATE DATABASE itcast;主库中配置

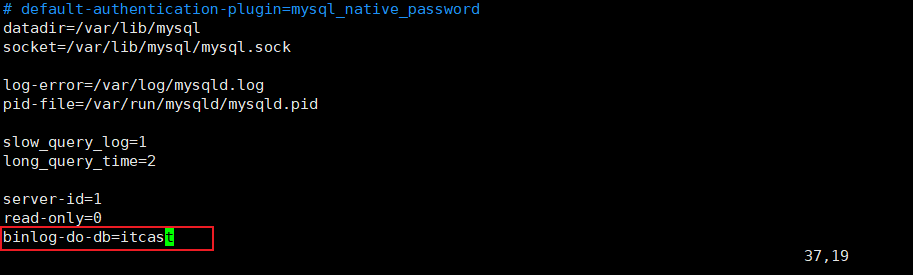

① 修改配置文件 /etc/my.cnf

plain

#mysql 服务ID,保证整个集群环境中唯一,取值范围:1 -- 232-1,默认为1

server-id=1

#是否只读,1 代表只读, 0 代表读写

read-only=0

#指定同步的数据库

binlog-do-db=itcast

② 重启MySQL服务器

plain

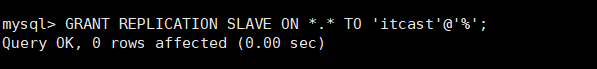

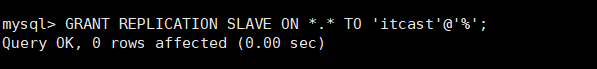

systemctl restart mysqld③ 登录mysql,创建远程连接的账号,并授予主从复制权限

bash

#创建itcast用户,并设置密码,该用户可在任意主机连接该MySQL服务

create user 'itcast'@'%' IDENTIFIED WITH mysql_native_password BY 'Itcast@123456';

#为 'itcast'@'%' 用户分配主从复制权限

GRANT REPLICATION SLAVE ON *.* TO 'itcast'@'%';

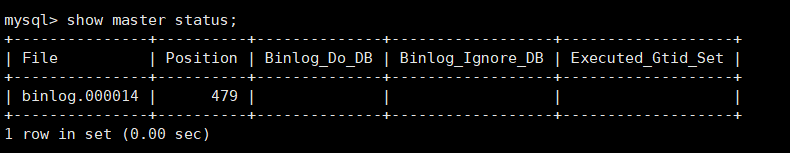

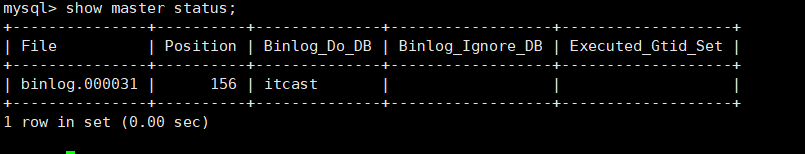

④ 通过指令,查看二进制日志坐标

sql

show master status;

字段含义说明:

- file : 从哪个日志文件开始推送日志文件

- position : 从哪个位置开始推送日志

- binlog_ignore_db : 指定不需要同步的数据库

从库配置

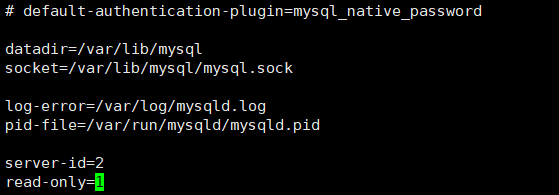

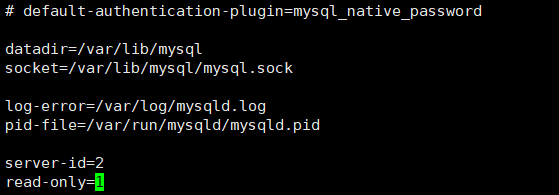

① 修改配置文件 /etc/my.cnf

bash

#mysql 服务ID,保证整个集群环境中唯一,取值范围:1 -- 2^32-1,和主库不一样即可

server-id=2

#是否只读,1 代表只读, 0 代表读写

read-only=1

② 重新启动MySQL服务

sql

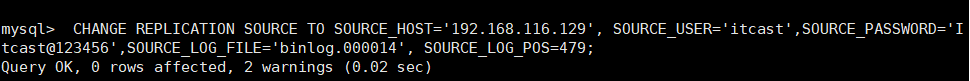

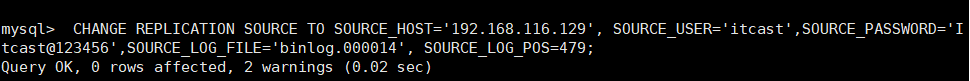

systemctl restart mysqld③ 登录mysql,设置主库配置

SOURCE_LOG_FILE和SOURCE_LOG_POS设置的是主库中刚才查询出来的

sql

CHANGE REPLICATION SOURCE TO SOURCE_HOST='192.168.116.129', SOURCE_USER='itcast',SOURCE_PASSWORD='Itcast@123456',SOURCE_LOG_FILE='binlog.000014', SOURCE_LOG_POS=479;

上述是8.0.23中的语法。如果mysql是 8.0.23 之前的版本,执行如下SQL:

sql

CHANGE MASTER TO MASTER_HOST='192.168.116.129', MASTER_USER='itcast',

MASTER_PASSWORD='Itcast@123456', MASTER_LOG_FILE='binlog.000014',

MASTER_LOG_POS=479;| 参数名 | 含义 | 8.0.23之前 |

|---|---|---|

| SOURCE_HOST | 主库IP地址 | MASTER_HOST |

| SOURCE_USER | 连接主库的用户名 | MASTER_USER |

| SOURCE_PASSWORD | 连接主库的密码 | MASTER_PASSWORD |

| SOURCE_LOG_FILE | binlog日志文件名 | MASTER_LOG_FILE |

| SOURCE_LOG_POS | binlog日志文件位置 | MASTER_LOG_POS |

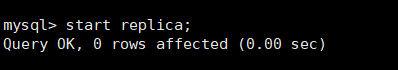

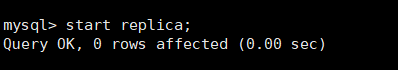

④ 开启同步操作

sql

start replica ; #8.0.22之后

start slave ; #8.0.22之前

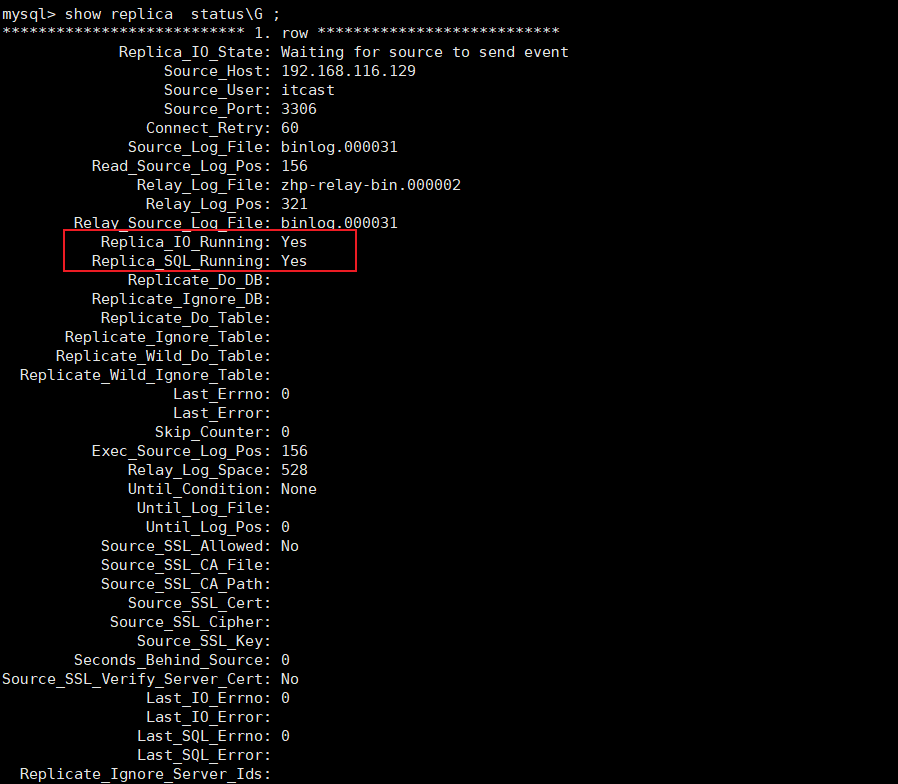

⑤ 查看主从同步状态

sql

show replica status ; #8.0.22之后

show slave status ; #8.0.22之前

Replica_IO_Running: Yes和Replica_SQL_Running: Yes说明配置成功

测试:

在主库中itcast数据库中执行如下:

sql

-- 创建表

CREATE TABLE users (

id INT(11) PRIMARY KEY AUTO_INCREMENT,

NAME VARCHAR(20) DEFAULT NULL,

age INT(11) DEFAULT NULL

);

-- 插入数据

INSERT INTO users VALUES(NULL,'user1',20);

INSERT INTO users VALUES(NULL,'user2',21);

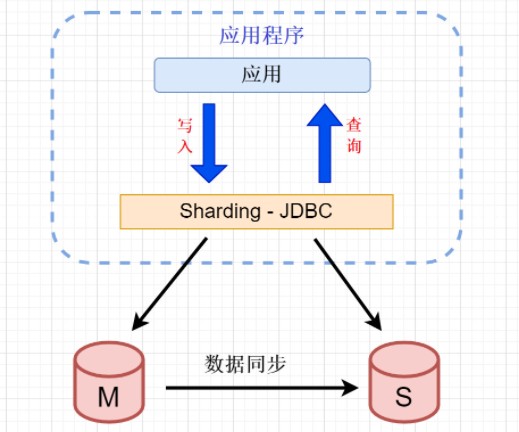

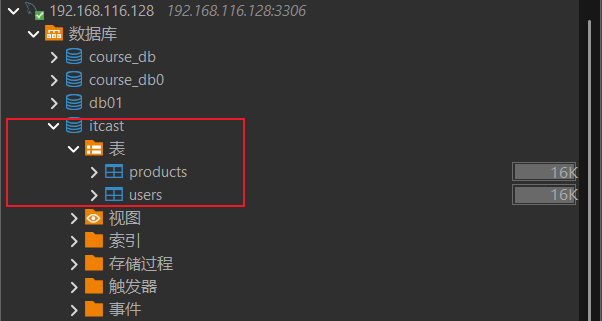

INSERT INTO users VALUES(NULL,'user3',22);查看从库是否已经将users表和数据同步过来

2.4.4 Sharding-JDBC实现读写分离

Sharding-JDBC读写分离则是根据SQL语义的分析,将读操作和写操作分别路由至主库与从库。它提供透明化读写分离,让使用方尽量像使用一个数据库一样使用主从数据库集群。

2.4.4.1 数据准备

为了实现Sharding-JDBC的读写分离,首先,要进行mysql的主从同步配置。在上面的课程中我们已经配置完成了.

- 在主服务器中的 itcast数据库 创建商品表

sql

CREATE TABLE `products` (

`pid` bigint(32) NOT NULL AUTO_INCREMENT,

`pname` varchar(50) DEFAULT NULL,

`price` int(11) DEFAULT NULL,

`flag` varchar(2) DEFAULT NULL,

PRIMARY KEY (`pid`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8- 主库新建表之后,从库会根据binlog日志,同步创建.

主库:

从库:

2.4.4.2 环境准备

1) 创建实体类

java

@TableName("products")

@Data

public class Products {

@TableId(value = "pid",type = IdType.AUTO)

private Long pid;

private String pname;

private int price;

private String flag;

}2) 创建Mapper

java

@Mapper

public interface ProductsMapper extends BaseMapper<Products> {

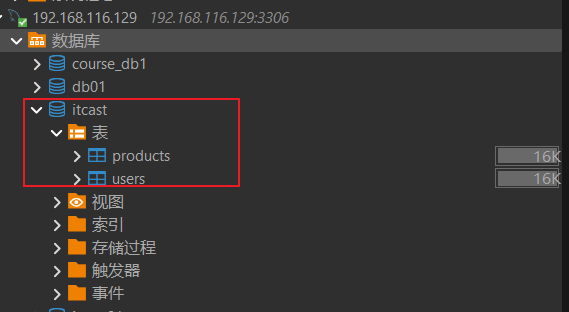

}2.4.4.3 配置读写分离

application.properties:

properties

# 应用名称

spring.application.name=shardingjdbc-table-write-read

#===============数据源配置

# 配置真实数据源

spring.shardingsphere.datasource.names=master,slave

#数据源1

spring.shardingsphere.datasource.slave.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.slave.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.slave.url = jdbc:mysql://192.168.116.128:3306/itcast?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.slave.username = root

spring.shardingsphere.datasource.slave.password = 123456

#数据源2

spring.shardingsphere.datasource.master.type = com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.master.driver-class-name = com.mysql.jdbc.Driver

spring.shardingsphere.datasource.master.url = jdbc:mysql://192.168.116.129:3306/itcast?characterEncoding=UTF-8&useSSL=false

spring.shardingsphere.datasource.master.username = root

spring.shardingsphere.datasource.master.password = 123456

# 读写分离类型,如: Static,Dynamic, ms1 包含了 m1 和 s1

spring.shardingsphere.rules.readwrite-splitting.data-sources.ms1.type=Static

# 写数据源名称

spring.shardingsphere.rules.readwrite-splitting.data-sources.ms1.props.write-data-source-name=master

# 读数据源名称,多个从数据源用逗号分隔

spring.shardingsphere.rules.readwrite-splitting.data-sources.ms1.props.read-data-source-names=slave

# 打印SQl

spring.shardingsphere.props.sql-show=true负载均衡相关配置

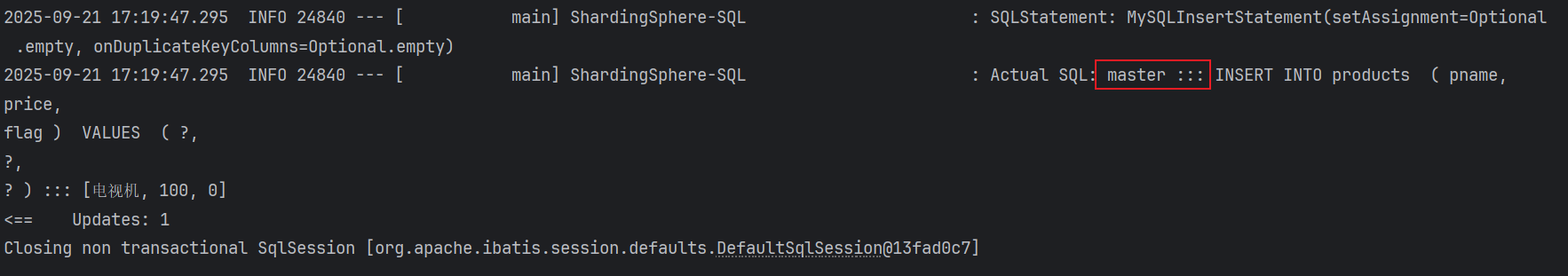

2.4.4.4 读写分离测试

java

//插入测试

@Test

public void testInsertProducts(){

Products products = new Products();

products.setPname("电视机");

products.setPrice(100);

products.setFlag("0");

productsMapper.insert(products);

}

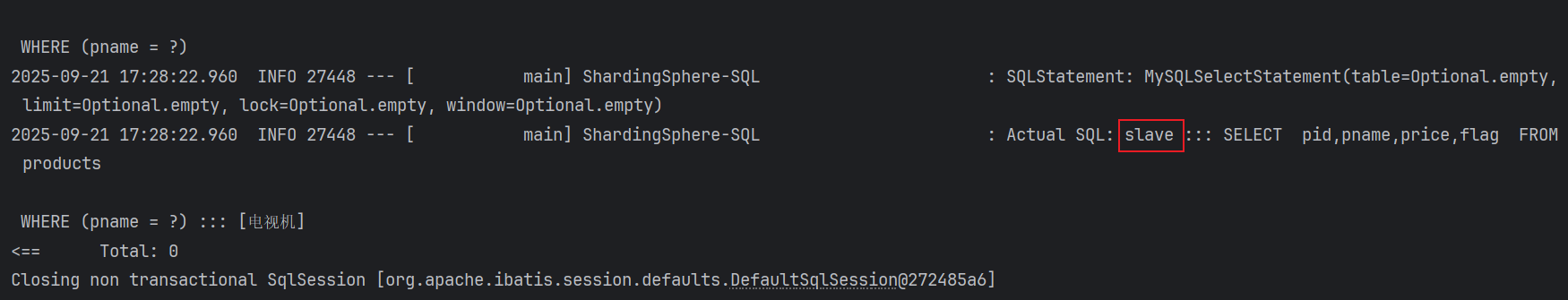

java

@Test

public void testSelectProducts(){

QueryWrapper<Products> queryWrapper = new QueryWrapper<>();

queryWrapper.eq("pname","电视机");

List<Products> products = productsMapper.selectList(queryWrapper);

products.forEach(System.out::println);

}

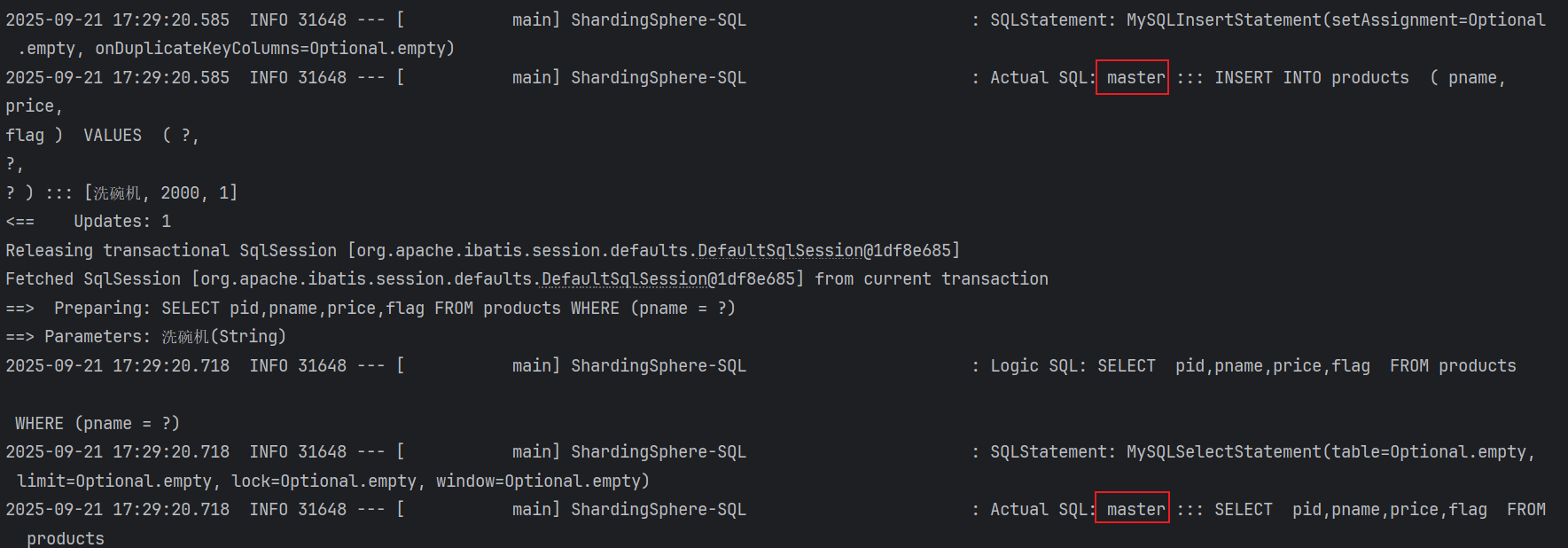

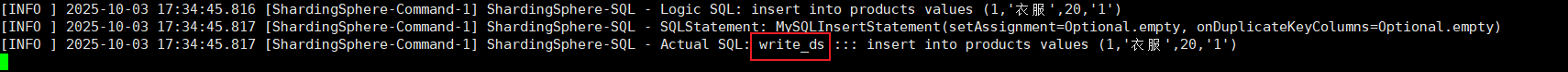

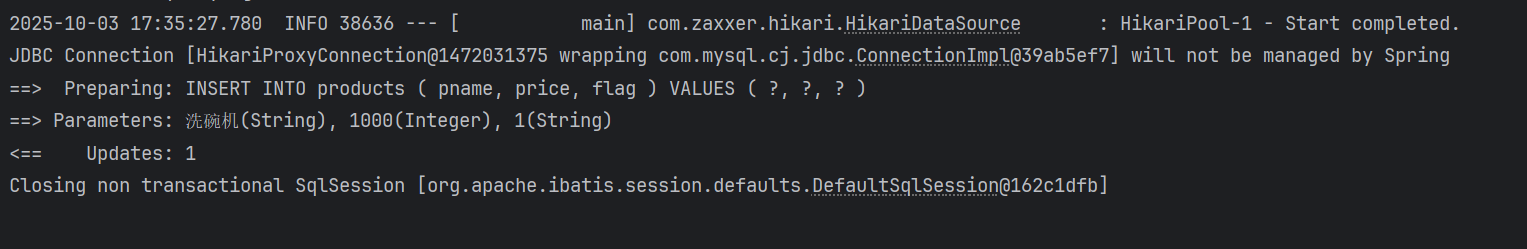

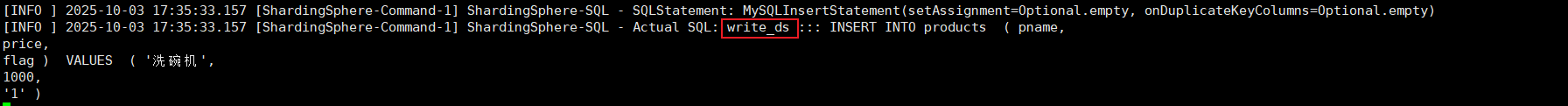

2.4.4.5 事务读写分离测试

为了保证主从库间的事务一致性,避免跨服务的分布式事务,ShardingSphere-JDBC的主从模型中,事务中的数据读写均用主库。

- 不添加@Transactional:insert对主库操作,select对从库操作

- 添加@Transactional:则insert和select均对主库操作

- **注意:**在JUnit环境下的@Transactional注解,默认情况下就会对事务进行回滚(即使在没加注解@Rollback,也会对事务回滚)

java

//事务测试

@Transactional //开启事务

@Test

public void testTrans(){

Products products = new Products();

products.setPname("洗碗机");

products.setPrice(2000);

products.setFlag("1");

productsMapper.insert(products);

QueryWrapper<Products> queryWrapper = new QueryWrapper<>();

queryWrapper.eq("pname","洗碗机");

List<Products> list = productsMapper.selectList(queryWrapper);

list.forEach(System.out::println);

}

2.4.5 负载均衡算法

2.4.5.1 一主两从架构

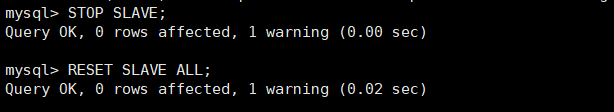

上边再搭建一主一从时用到过129和128两个服务器,再操作之前先还原两个服务器的主从架构,分别在两个服务器上执行下边的sql

sql

STOP SLAVE;

RESET SLAVE ALL;

准备:

| 主机 | 角色 | 用户名 | 密码 |

|---|---|---|---|

| 192.168.116.129 | master | root | 123456 |

| 192.168.116.128 | slave | root | 123456 |

| 192.168.116.130 | slave | root | 123456 |

第一步 master中和slave创建数据库

sql

-- 创建数据库

CREATE DATABASE itcast;主库中配置

① 修改配置文件 /etc/my.cnf

plain

#mysql 服务ID,保证整个集群环境中唯一,取值范围:1 -- 232-1,默认为1

server-id=1

#是否只读,1 代表只读, 0 代表读写

read-only=0

#指定同步的数据库

binlog-do-db=itcast

② 重启MySQL服务器

plain

systemctl restart mysqld③ 登录mysql,创建远程连接的账号,并授予主从复制权限

bash

#创建itcast用户,并设置密码,该用户可在任意主机连接该MySQL服务

create user 'itcast'@'%' IDENTIFIED WITH mysql_native_password BY 'Itcast@123456';

#为 'itcast'@'%' 用户分配主从复制权限

GRANT REPLICATION SLAVE ON *.* TO 'itcast'@'%';

④ 通过指令,查看二进制日志坐标

sql

show master status;

字段含义说明:

- file : 从哪个日志文件开始推送日志文件

- position : 从哪个位置开始推送日志

- binlog_ignore_db : 指定不需要同步的数据库

从库192.168.116.128配置

① 修改配置文件 /etc/my.cnf

bash

#mysql 服务ID,保证整个集群环境中唯一,取值范围:1 -- 2^32-1,和主库不一样即可

server-id=2

#是否只读,1 代表只读, 0 代表读写

read-only=1

② 重新启动MySQL服务

sql

systemctl restart mysqld③ 登录mysql,设置主库配置

SOURCE_LOG_FILE和SOURCE_LOG_POS设置的是主库中刚才查询出来的

sql

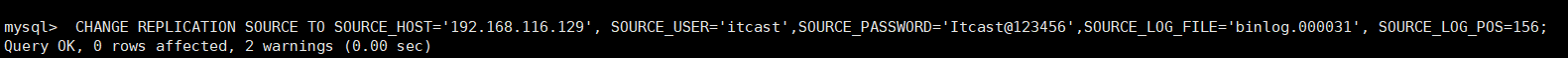

CHANGE REPLICATION SOURCE TO SOURCE_HOST='192.168.116.129', SOURCE_USER='itcast',SOURCE_PASSWORD='Itcast@123456',SOURCE_LOG_FILE='binlog.000031', SOURCE_LOG_POS=156;

上述是8.0.23中的语法。如果mysql是 8.0.23 之前的版本,执行如下SQL:

sql

CHANGE MASTER TO MASTER_HOST='192.168.116.129', MASTER_USER='itcast',

MASTER_PASSWORD='Itcast@123456', MASTER_LOG_FILE='binlog.000031',

MASTER_LOG_POS=156;| 参数名 | 含义 | 8.0.23之前 |

|---|---|---|

| SOURCE_HOST | 主库IP地址 | MASTER_HOST |

| SOURCE_USER | 连接主库的用户名 | MASTER_USER |

| SOURCE_PASSWORD | 连接主库的密码 | MASTER_PASSWORD |

| SOURCE_LOG_FILE | binlog日志文件名 | MASTER_LOG_FILE |

| SOURCE_LOG_POS | binlog日志文件位置 | MASTER_LOG_POS |

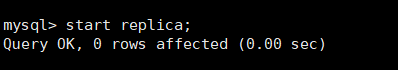

④ 开启同步操作

sql

start replica ; #8.0.22之后

start slave ; #8.0.22之前

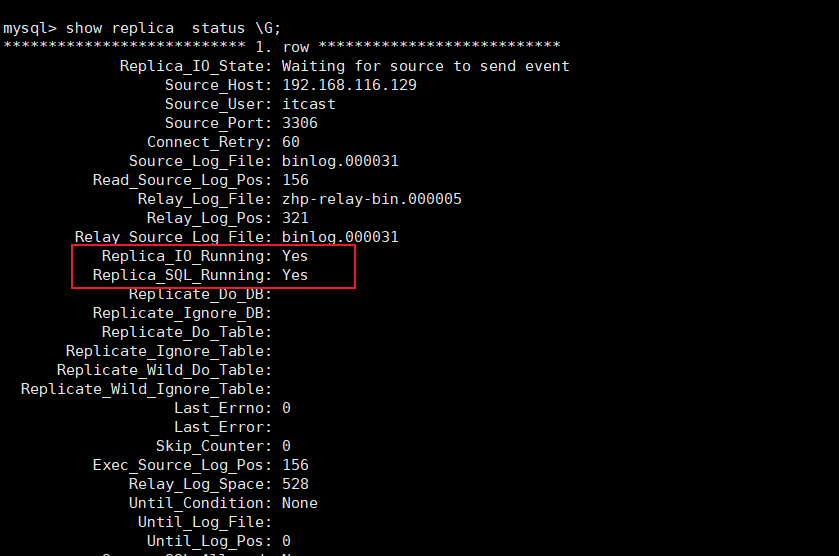

⑤ 查看主从同步状态

sql

show replica status ; #8.0.22之后

show slave status ; #8.0.22之前

Replica_IO_Running: Yes和Replica_SQL_Running: Yes说明配置成功

从库192.168.116.130配置

① 修改配置文件 /etc/my.cnf

bash

#mysql 服务ID,保证整个集群环境中唯一,取值范围:1 -- 2^32-1,和主库不一样即可

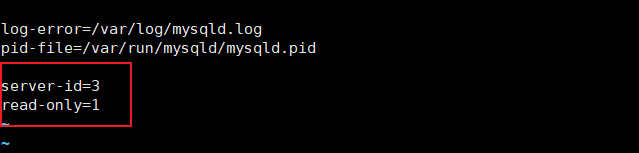

server-id=3

#是否只读,1 代表只读, 0 代表读写

read-only=1

② 重新启动MySQL服务

sql

systemctl restart mysqld③ 登录mysql,设置主库配置

SOURCE_LOG_FILE和SOURCE_LOG_POS设置的是主库中刚才查询出来的

sql

CHANGE REPLICATION SOURCE TO SOURCE_HOST='192.168.116.129', SOURCE_USER='itcast',SOURCE_PASSWORD='Itcast@123456',SOURCE_LOG_FILE='binlog.000031', SOURCE_LOG_POS=156;

上述是8.0.23中的语法。如果mysql是 8.0.23 之前的版本,执行如下SQL:

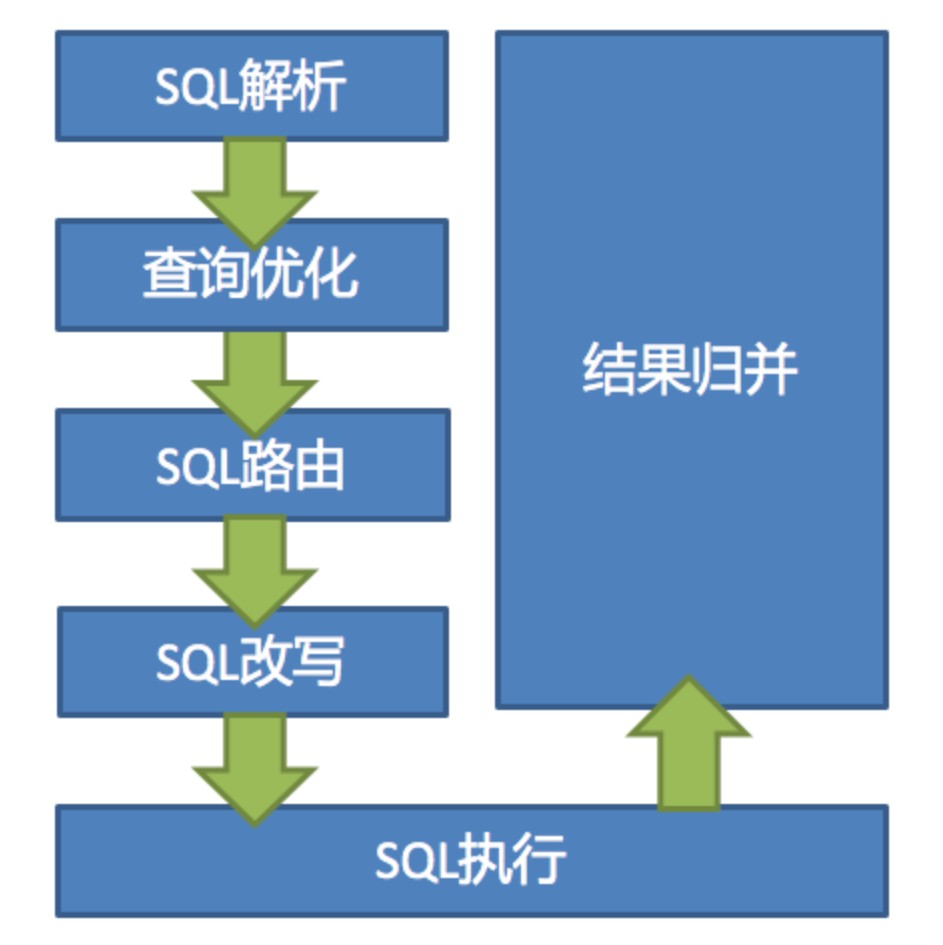

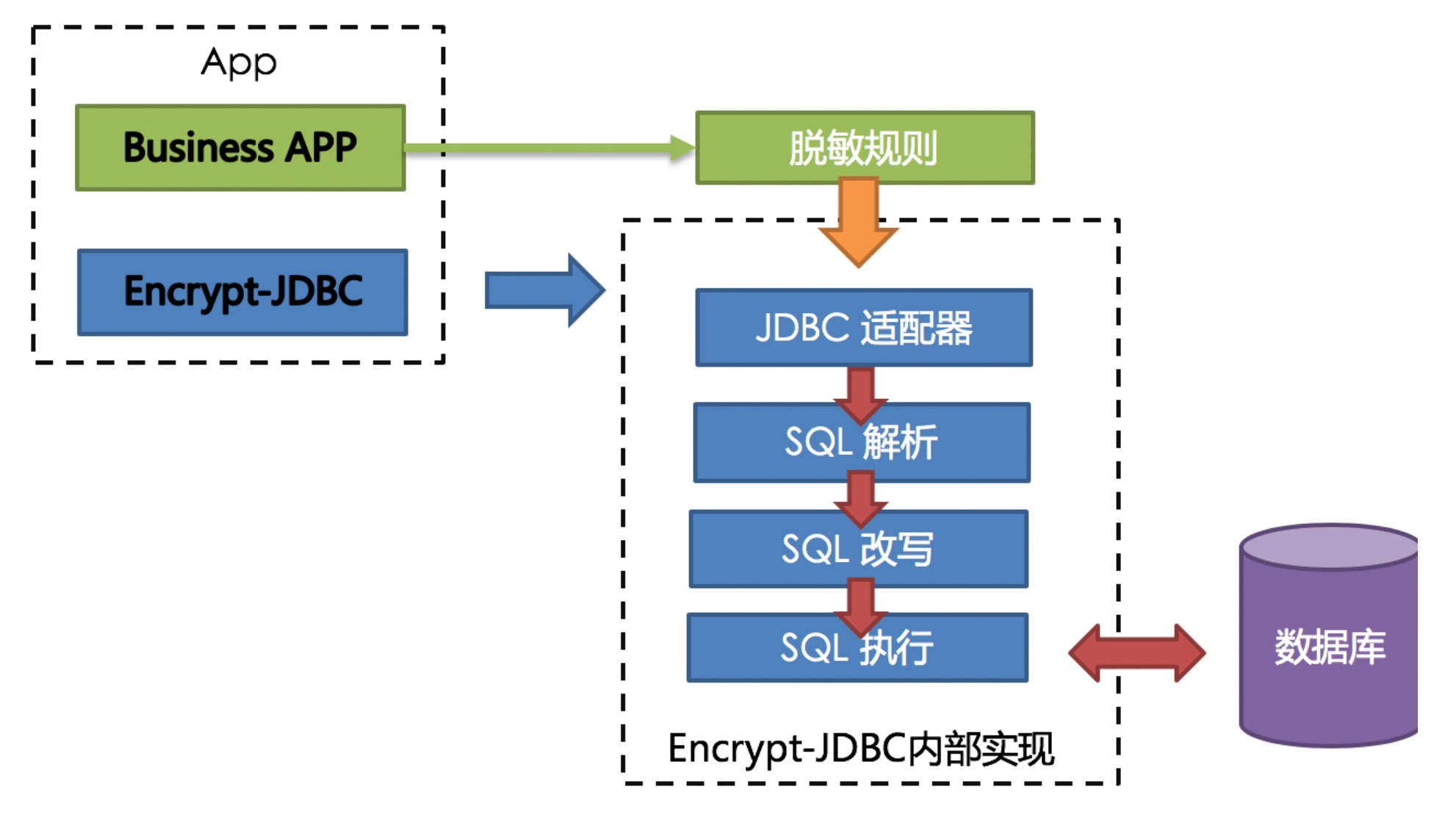

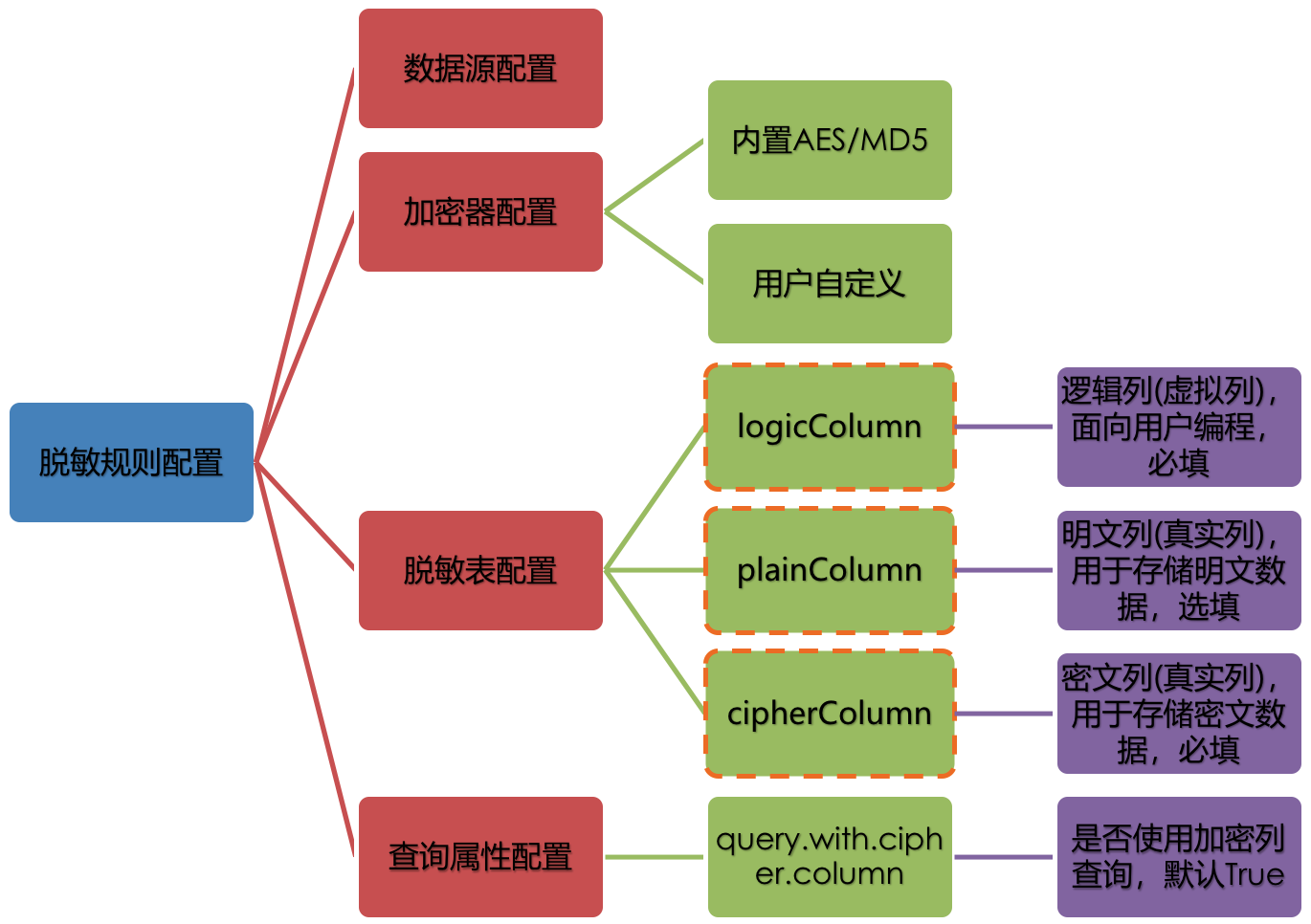

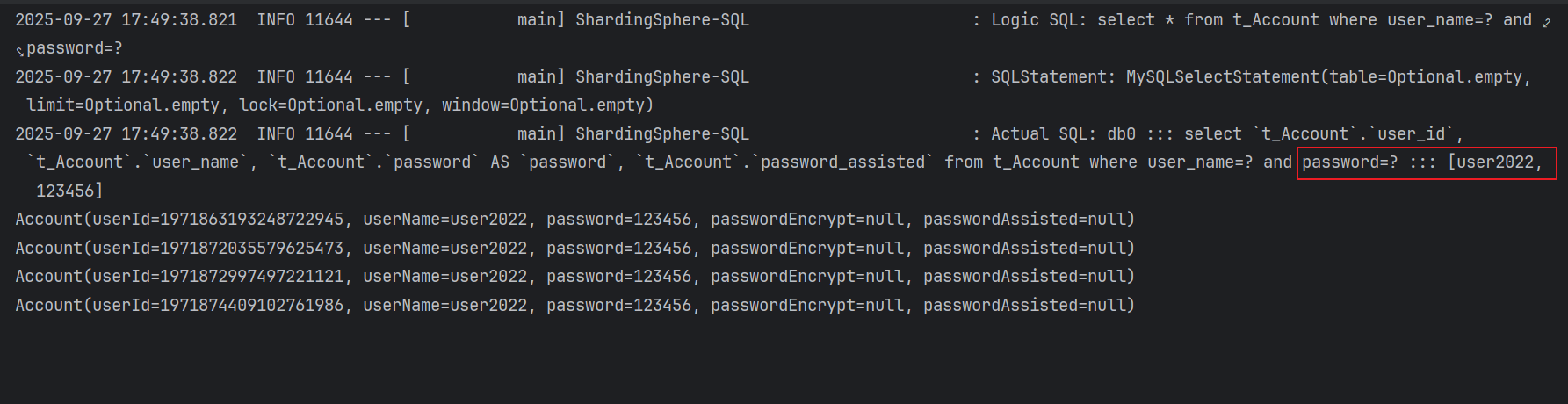

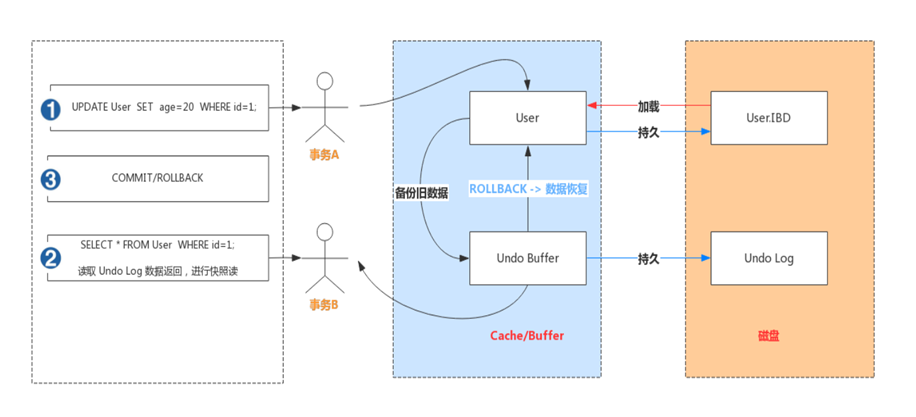

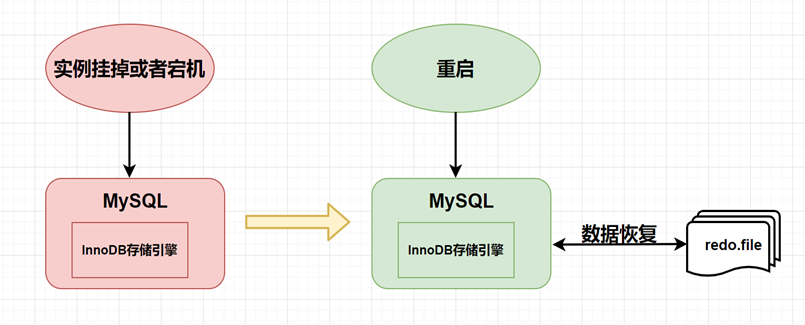

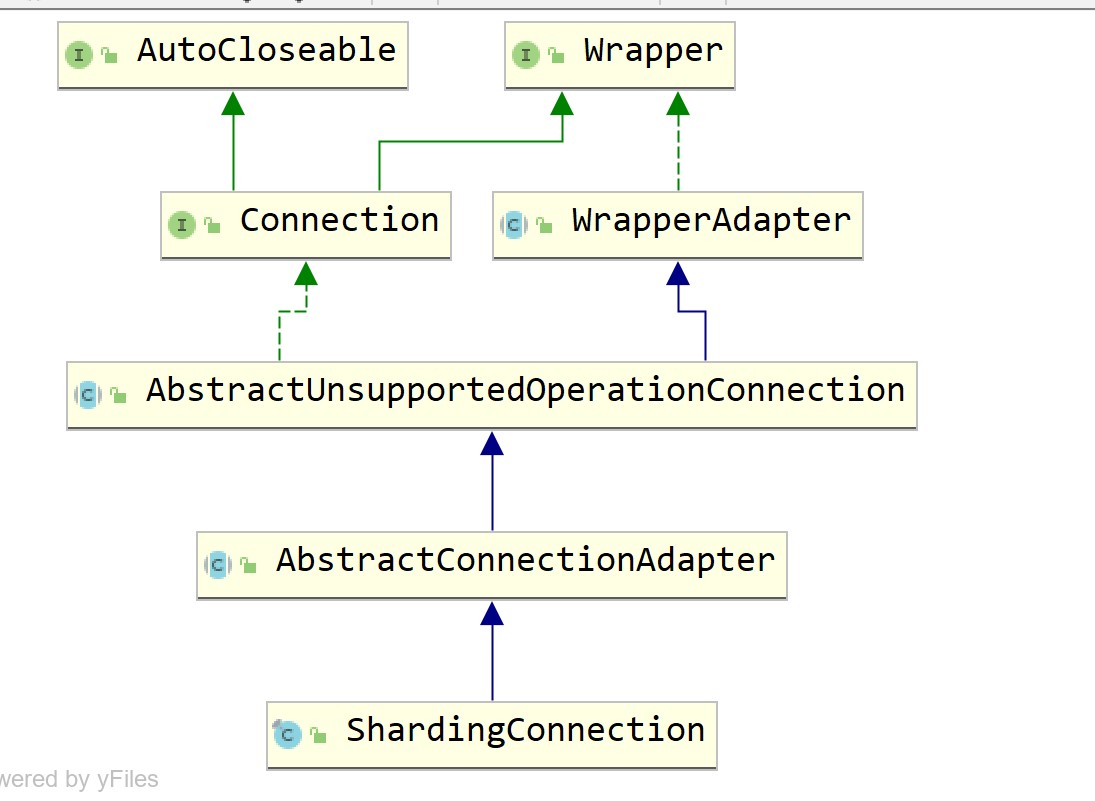

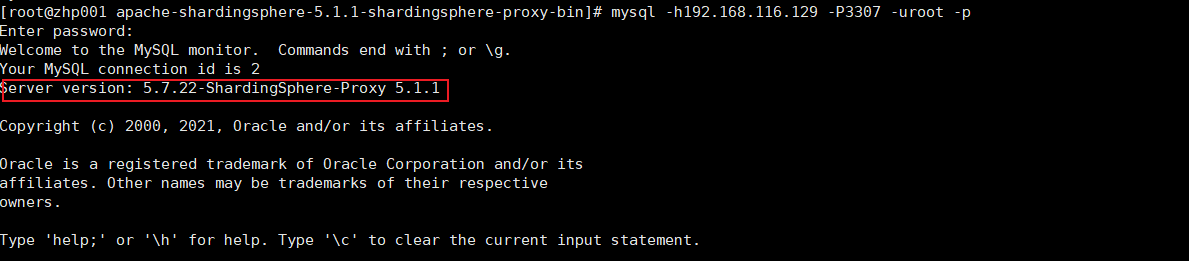

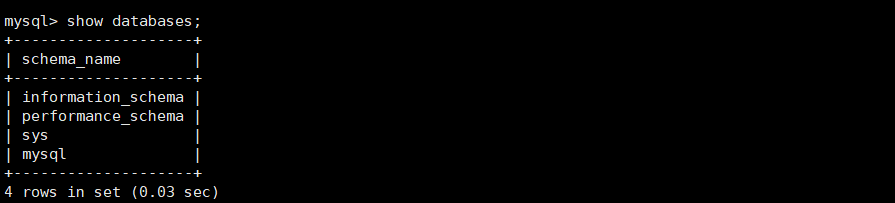

sql