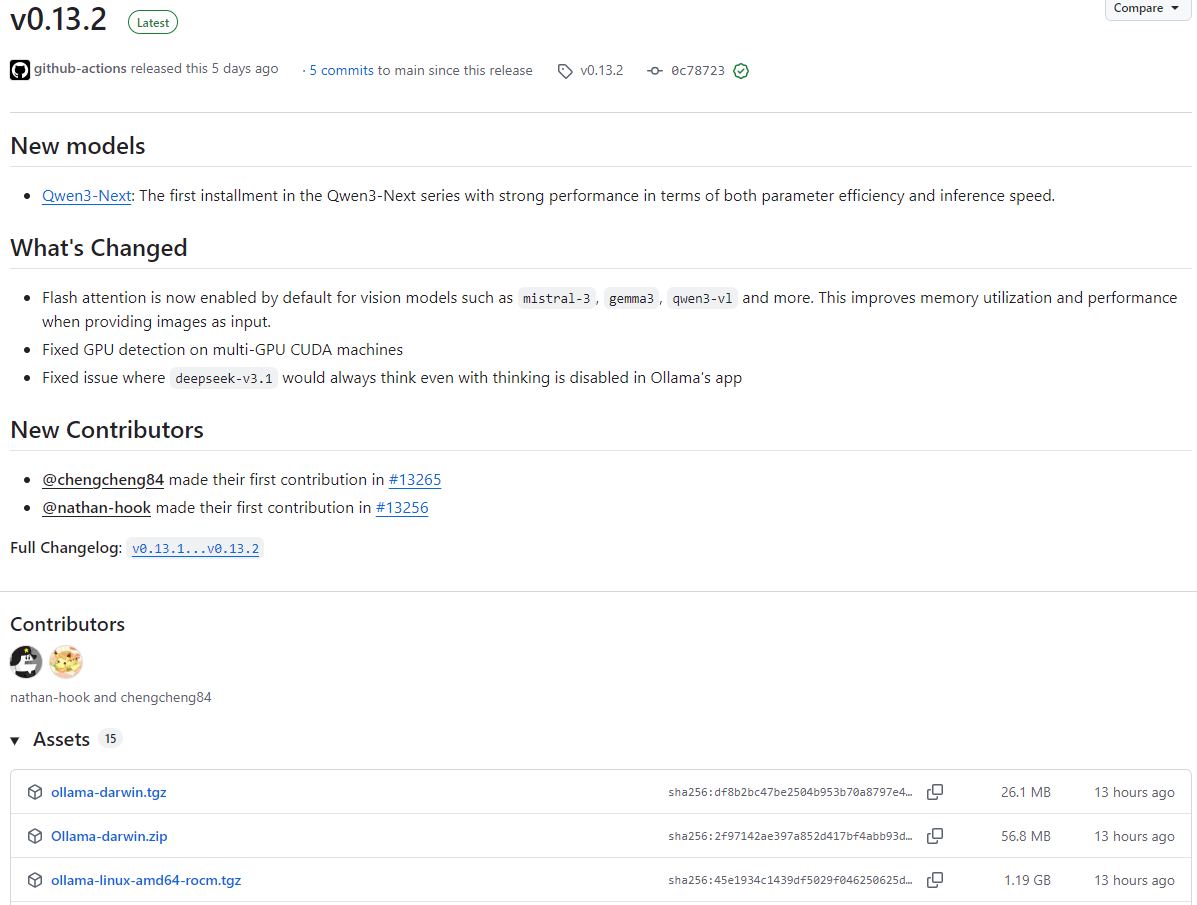

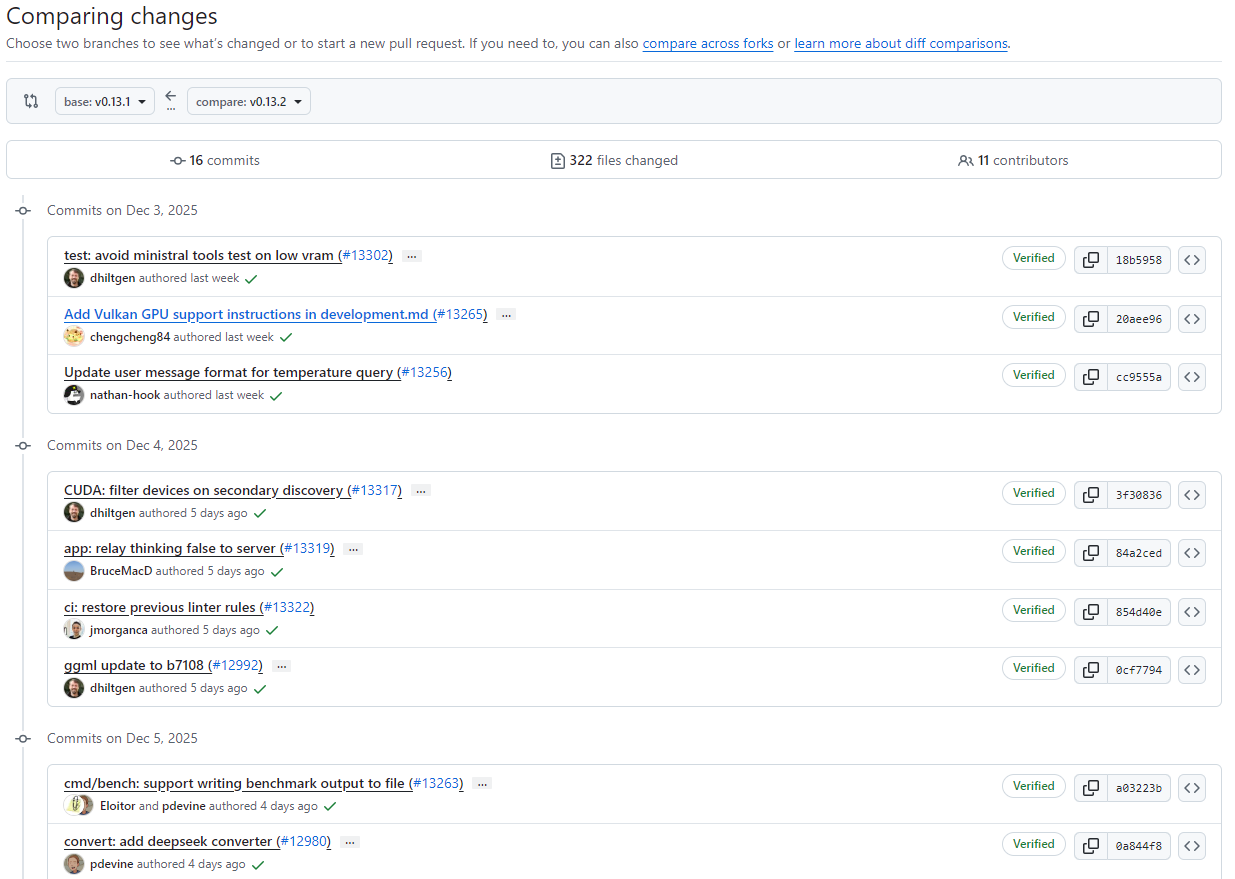

2025年12月4日,ollama v0.13.2版本迎来预发布,并于2025年12月9日正式发布。本次更新在模型能力、性能优化和问题修复方面都有重要提升。

1. 新增模型

- Qwen3-Next

Qwen3-Next是Qwen3-Next系列的首个版本,在参数效率和推理速度方面表现优秀。该系列的引入旨在为用户提供更高效的推理过程,同时保持较低的资源占用。

2. 性能优化

- 启用Flash Attention(适用于视觉模型)

对包括mistral-3、gemma3、qwen3-vl在内的视觉模型,Flash Attention功能现已默认开启。这一优化提升了在提供图片作为输入时的显存利用率和整体性能,让视觉模型在处理图像任务时更加高效稳定。

3. 问题修复

- 多GPU CUDA机器的GPU检测修复

修复了在多GPU CUDA环境下的GPU检测问题,保证了部署时对硬件资源的正确识别与调用。 - deepseek-v3.1思考状态问题修复

修复了deepseek-v3.1在Ollama应用中,即使关闭"思考"功能仍然持续进行思考的问题,使其在应用场景中更符合用户的预期设置。

版本概述

v0.13.2是一次兼顾功能拓展、性能优化和稳定性提升的更新,特别是首发的Qwen3-Next模型,以及Flash Attention在视觉模型中的默认启用,将为开发者和用户带来更顺畅的使用体验。