Dubbo的负载均衡实现相当精巧,它是在客户端(服务消费者) 实现的,通过智能的算法在多个服务提供者中选择最合适的实例。以下是其核心原理的详细分析:

🎯 核心设计思想

Dubbo的负载均衡是 "客户端负载均衡" ,与服务端负载均衡(如Nginx)有本质区别:

java

// Dubbo客户端负载均衡流程

Consumer App

├── @DubboReference

├── 获取服务提供者列表 (从注册中心)

├── 负载均衡算法选择 (4种内置策略)

└── 发起RPC调用到选中的Provider📊 4种内置负载均衡策略

1. Random LoadBalance(随机) - 默认策略

java

// 原理:按权重随机选择

// 假设有3个Provider,权重分别为:A=10, B=20, C=30

总权重 = 10 + 20 + 30 = 60

随机数在 [0, 60) 之间:

- [0, 10) → 选择A

- [10, 30) → 选择B

- [30, 60) → 选择C

// 优点:简单高效,权重越大被选中概率越高

// 适用场景:大多数常规场景2. RoundRobin LoadBalance(加权轮询)

java

// 原理:按权重轮询,但非简单轮流

// 算法:平滑加权轮询 (Nginx同款算法)

初始权重:{A:10, B:20, C:30}

当前权重:{A:10, B:20, C:30} // 初始=权重

第1次选择:

1. 选当前权重最大的 C(30)

2. C权重减去总权重:30-60=-30

3. 更新当前权重:{A:20, B:40, C:-30} // 每个加自身权重

第2次选择:选B(40),更新...

// 效果:在多次调用中,调用比例符合权重分配3. LeastActive LoadBalance(最少活跃调用)

java

// 原理:选择并发调用数最少的Provider

// 算法步骤:

1. 遍历所有Provider,找出最小活跃数(minActive)

2. 如果有多个Provider活跃数=minActive,按权重随机选

// 示例场景:

Provider A: 活跃调用数=5, 权重=10

Provider B: 活跃调用数=2, 权重=20 ← 选中(活跃数最小)

Provider C: 活跃调用数=2, 权重=30 ← 与B活跃数相同,但权重更高

// 优点:自动感知服务端压力,实现动态负载

// 适用场景:处理时间差异大的服务4. ConsistentHash LoadBalance(一致性哈希)

java

// 原理:相同参数请求总是路由到同一Provider

// 关键算法:虚拟节点 + 环形哈希空间

虚拟节点数 = 实际节点数 × 160 // 默认每个节点160个虚拟节点

// 查找过程:

1. 对请求参数计算哈希值

2. 在哈希环上顺时针找到第一个虚拟节点

3. 虚拟节点映射到实际Provider

// 示例:用户ID=1001的请求总是路由到Provider B

哈希环: [虚拟节点A1, 虚拟节点B1, 虚拟节点C1, 虚拟节点A2...]

请求哈希值落在B1和C1之间 → 选择C1对应的Provider C

// 优点:会话保持、缓存局部性

// 适用场景:有状态服务、缓存依赖场景🔧 负载均衡触发时机

调用链路的完整流程:

java

public class LoadBalanceInvoker {

// 1. 服务目录维护可用Provider列表

private List<Invoker> invokers = registry.subscribe("com.example.UserService");

// 2. 路由过滤(先于负载均衡)

private List<Invoker> routedInvokers = routerChain.route(invokers, request);

// 3. 负载均衡选择

public Invoker select(Invocation invocation) {

// 获取负载均衡器实例

LoadBalance loadbalance = ExtensionLoader

.getExtensionLoader(LoadBalance.class)

.getExtension("random"); // 根据配置获取

// 执行选择

return loadbalance.select(routedInvokers, url, invocation);

}

// 4. 集群容错(负载均衡失败后的处理)

public Result invoke(Invocation invocation) {

// 失败重试、快速失败等策略

return cluster.join(directory).invoke(invocation);

}

}⚙️ 源码级实现解析

核心接口设计:

java

// 负载均衡器接口

public interface LoadBalance {

// 选择Invoker(Provider的代理)

<T> Invoker<T> select(

List<Invoker<T>> invokers,

URL url,

Invocation invocation

) throws RpcException;

}

// AbstractLoadBalance 抽象类(模板方法)

public abstract class AbstractLoadBalance implements LoadBalance {

// 模板方法:选择前的准备工作

public <T> Invoker<T> select(List<Invoker<T>> invokers,

URL url,

Invocation invocation) {

if (CollectionUtils.isEmpty(invokers)) return null;

// 只有一个Provider,直接返回

if (invokers.size() == 1) return invokers.get(0);

// 调用子类具体算法

return doSelect(invokers, url, invocation);

}

// 子类必须实现的具体算法

protected abstract <T> Invoker<T> doSelect(

List<Invoker<T>> invokers,

URL url,

Invocation invocation

);

// 公共方法:计算权重(考虑预热时间)

protected int getWeight(Invoker<?> invoker, Invocation invocation) {

int weight = invoker.getUrl().getMethodParameter(

invocation.getMethodName(),

WEIGHT_KEY,

DEFAULT_WEIGHT

);

// 服务预热权重计算

if (weight > 0) {

long timestamp = invoker.getUrl().getParameter(TIMESTAMP_KEY, 0L);

if (timestamp > 0L) {

long uptime = System.currentTimeMillis() - timestamp;

if (uptime < 0) return 1;

int warmup = invoker.getUrl().getParameter(WARMUP_KEY, DEFAULT_WARMUP);

if (uptime > 0 && uptime < warmup) {

// 处于预热期,按比例降低权重

weight = calculateWarmupWeight(uptime, warmup, weight);

}

}

}

return weight;

}

}RandomLoadBalance 实现细节:

java

public class RandomLoadBalance extends AbstractLoadBalance {

@Override

protected <T> Invoker<T> doSelect(List<Invoker<T>> invokers,

URL url,

Invocation invocation) {

int length = invokers.size();

// 检查所有权重是否相等

boolean sameWeight = true;

int[] weights = new int[length];

int totalWeight = 0;

// 第一轮循环:计算总权重,检查是否所有权重相等

for (int i = 0; i < length; i++) {

int weight = getWeight(invokers.get(i), invocation);

weights[i] = weight;

totalWeight += weight;

if (sameWeight && i > 0 && weight != weights[i - 1]) {

sameWeight = false;

}

}

// 如果总权重大于0且权重不完全相等

if (totalWeight > 0 && !sameWeight) {

// 获取一个[0, totalWeight)之间的随机数

int offset = ThreadLocalRandom.current().nextInt(totalWeight);

// 根据随机数选择Invoker

for (int i = 0; i < length; i++) {

offset -= weights[i];

if (offset < 0) {

return invokers.get(i);

}

}

}

// 所有权重相等或总权重=0,完全随机选择

return invokers.get(ThreadLocalRandom.current().nextInt(length));

}

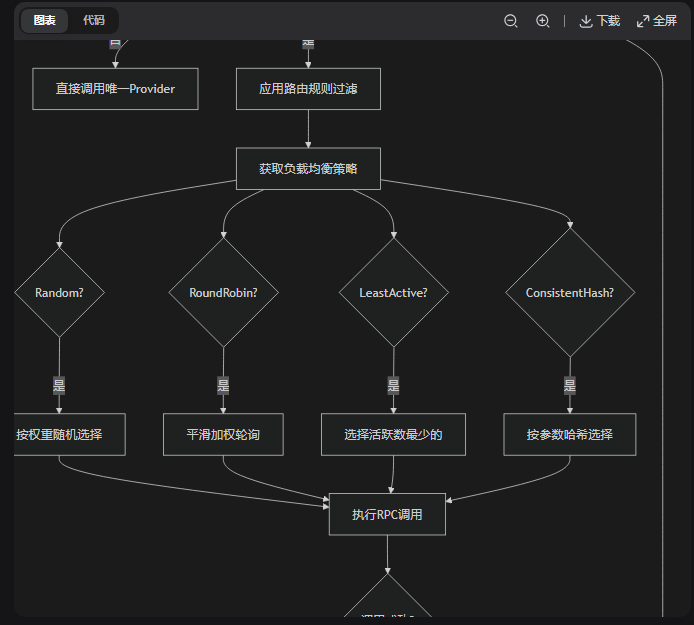

}📈 负载均衡工作流程图解

🔄 与集群容错的协同工作

负载均衡和集群容错是Dubbo高可用的两大支柱:

java

// 典型配置:负载均衡 + 集群容错

@DubboReference(

version = "1.0.0",

loadbalance = "random", // 负载均衡策略

cluster = "failover", // 集群容错策略

retries = 2, // 重试次数(不包含第一次调用)

timeout = 1000 // 超时时间

)

private UserService userService;

// 调用时的协同流程:

1. 负载均衡选择Provider A

2. 调用Provider A超时/失败

3. 集群容错机制触发重试(retries=2)

4. 负载均衡重新选择Provider B

5. 调用Provider B成功🎚️ 高级特性与配置

1. 权重动态调整

yaml

# Provider端配置权重

dubbo:

protocol:

name: dubbo

port: 20880

provider:

weight: 200 # 默认100,值越大承受流量比例越高

# 运行时通过管控台动态调整权重

# 实现灰度发布、流量调度2. 粘滞连接(Sticky)

java

// 启用粘滞连接,同一连接上的多个请求使用相同Provider

@DubboReference(

loadbalance = "random",

sticky = true, // 粘滞连接

cluster = "failover"

)

private OrderService orderService;

// 适用场景:减少连接建立开销,但需注意负载均衡效果3. 自定义负载均衡扩展

java

// 1. 实现自定义LoadBalance

@SPI("random") // 扩展点注解

public class CustomLoadBalance implements LoadBalance {

@Override

public <T> Invoker<T> select(List<Invoker<T>> invokers,

URL url,

Invocation invocation) {

// 自定义算法:基于响应时间选择

return selectByResponseTime(invokers);

}

}

// 2. 在META-INF/dubbo/org.apache.dubbo.rpc.cluster.LoadBalance中添加

custom=com.example.CustomLoadBalance

// 3. 使用自定义策略

@DubboReference(loadbalance = "custom")

private UserService userService;🎯 最佳实践与调优建议

策略选择指南:

| 场景 | 推荐策略 | 配置示例 | 说明 |

|---|---|---|---|

| 常规无状态服务 | Random(默认) | loadbalance="random" |

简单高效,默认选择 |

| Provider性能差异大 | Weighted RoundRobin | loadbalance="roundrobin" |

按性能分配权重 |

| Provider压力不均 | LeastActive | loadbalance="leastactive" |

自动感知压力 |

| 有状态/缓存依赖 | ConsistentHash | loadbalance="consistenthash" |

会话保持 |

| 调试测试环境 | Random | weight=1000给测试机 |

定向流量 |

生产环境配置:

yaml

# application.yml

dubbo:

consumer:

# 全局负载均衡配置

loadbalance: leastactive

# 方法级覆盖

methods:

- name: findUserById

loadbalance: consistenthash # 用户查询用一致性哈希

- name: createOrder

loadbalance: random # 订单创建用随机

# 连接级配置

connections: 5 # 每个Provider最大连接数⚠️ 常见问题与解决方案

问题1:负载不均衡

java

// 症状:某些Provider压力大,某些空闲

// 排查步骤:

1. 检查权重配置:Provider是否设置了不同权重?

2. 检查预热机制:新启动的Provider权重是否较低?

3. 检查健康状态:压力大的Provider是否响应变慢?

// 解决方案:

// 1. 调整权重

@DubboReference(parameters = {"weight", "200"})

// 2. 切换策略

@DubboReference(loadbalance = "leastactive") // 自动感知压力问题2:Hash不均匀

java

// 一致性哈希时,某些节点负载过高

// 解决方案:增加虚拟节点数

@DubboReference(

loadbalance = "consistenthash",

parameters = {"hash.nodes", "320"} // 默认160,增加到320

)问题3:本地调试困难

java

// 方案:使用直连+固定Provider

@DubboReference(

url = "dubbo://localhost:20880", // 直连特定Provider

loadbalance = "random" // 负载均衡仍生效但只有一个Provider

)📊 性能对比数据

| 策略 | 时间复杂度 | 额外开销 | 适用规模 | 效果稳定性 |

|---|---|---|---|---|

| Random | O(n) | 低 | 任意 | 依赖随机质量 |

| RoundRobin | O(n) | 低 | 任意 | 非常稳定 |

| LeastActive | O(n) | 中(需统计活跃数) | 中小 | 动态调整 |

| ConsistentHash | O(log n) | 高(维护哈希环) | 大 | 非常稳定 |

🎪 总结

Dubbo负载均衡的核心特点:

-

客户端实现:在消费者端智能选择,减少服务端压力

-

算法丰富:4种策略覆盖不同业务场景

-

权重感知:支持静态配置和动态预热

-

可扩展性:SPI机制支持自定义算法

-

与容错协同:与集群容错策略无缝配合

选择黄金法则:

-

不知道选什么就用 Random(默认)

-

Provider性能不均就配权重 + RoundRobin

-

想要自动调节就用 LeastActive

-

需要会话保持就用 ConsistentHash

Dubbo的负载均衡是其高性能微服务框架的基石之一,理解其原理有助于更好地设计和调优分布式系统。