YOLOv8 五大核心模型:从检测到分类的介绍

在计算机视觉技术落地的过程中,不同场景需要解决的核心问题差异巨大 ------ 有的需要 "找到物体在哪",有的需要 "看清物体轮廓",有的则需要 "判断物体类别"。YOLOv8 系列通过五大专项模型,精准匹配这些需求,让技术能快速嵌入实际业务。下面我们就按任务类型,逐一拆解每种模型的核心作用,用通俗语言讲清它们 "能做什么""为什么有用"。

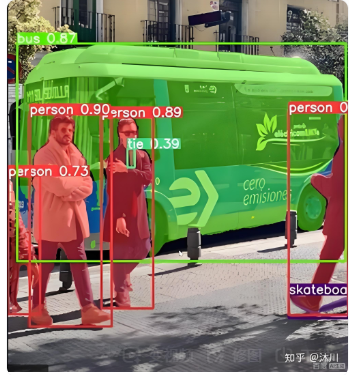

一、目标检测模型(YOLOv8-Detect):"找到物体,标出位置"

核心作用

目标检测模型是计算机视觉的 "基础工具",它的核心能力是在图像或视频中,同时完成 "识别物体类别" 和 "标注物体位置" 两件事。简单说,就是让机器像人眼一样,快速回答 "图里有什么""东西在哪个角落"------ 比如从一张街景图里,找出 "这里有 3 辆汽车、2 个行人",并在每个物体周围画一个矩形框,标明它们的具体位置。

关键优势

相比传统的 "先识别、再定位" 的分步方案,YOLOv8-Detect 的优势在于 "快且准":小版本模型(如 YOLOv8n)在普通电脑上就能实现每秒 30 帧以上的实时检测,且对小物体(如远处的交通标志)的识别率比老版本提升 10% 以上,能满足大多数实时场景的需求。

二、实例分割模型(YOLOv8-Seg):"不止标框,还能描轮廓"

核心作用

如果说目标检测是 "给物体画个矩形框",那实例分割就是 给物体描出精确轮廓------ 它不仅能识别物体类别、定位物体位置,还能逐像素区分 "物体的哪部分是本体"。比如在一张有两只猫的图里,目标检测只能标出两个矩形框,但实例分割能清晰画出每只猫的身体轮廓,甚至区分出 "猫的耳朵、尾巴" 这些细节,让机器知道 "这部分像素属于猫 A,那部分属于猫 B"。

为什么需要它?

当场景需要 "精确区分物体边界" 时,矩形框就不够用了。比如:

-

医学影像分析:医生看肺部 CT 时,需要知道肿瘤的精确形状和大小,实例分割能逐像素标出肿瘤区域,甚至区分肿瘤的 "核心坏死区" 和 "边缘浸润区",帮助医生更准确地判断病情;

-

农业病虫害检测:在农田航拍图中,模型需要区分 "健康叶片" 和 "被虫咬的叶片",实例分割能描出虫咬缺口的精确轮廓,计算出受害面积,进而判断病虫害的严重程度;

-

影视特效制作:直播中的 "虚拟背景替换" 功能,需要精确区分 "人的身体" 和 "背景",如果用矩形框,会出现 "人物边缘有背景残留" 的模糊效果,而实例分割能描出头发丝级的轮廓,让背景替换更自然。

关键优势

过去的分割模型要么 "慢得没法实时用",要么 "精度不够",而 YOLOv8-Seg 做到了 "速度与精度兼顾"------ 小版本模型在普通 GPU 上能实现每秒 20 帧以上的实时分割,且轮廓精度能满足大多数工业场景需求,不需要额外的高性能硬件支持。

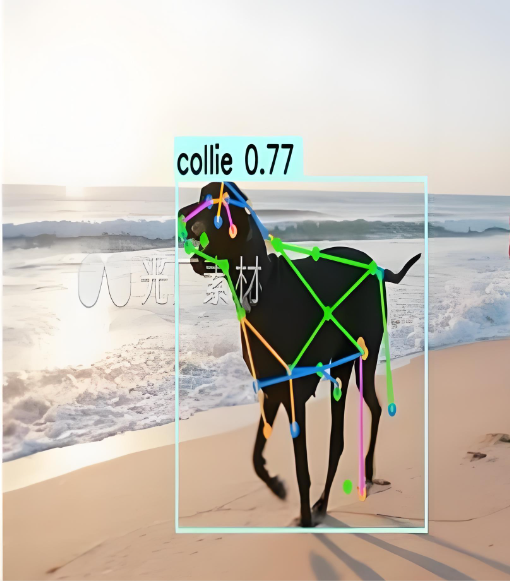

三、姿势 / 关键点检测模型(YOLOv8-Pose):"看懂人体动作,还原骨骼姿态"

核心作用

姿势检测模型是专门针对 "人体" 的专项工具,它的核心能力是识别人体的关键关节点(如头部、肩膀、手腕、膝盖等),并还原出人体的骨骼连接关系。简单说,就是让机器 "看懂人在做什么动作"------ 比如从一张健身图里,标出 "人的左手举到肩膀高度、右腿向后伸展",甚至能实时跟踪视频中人体的动作变化,判断 "这个动作是否标准"。

关键优势

YOLOv8-Pose 的核心优势是 "抗遮挡、多目标"------ 即使画面中有人群遮挡(比如健身房里多人一起锻炼),模型也能准确识别每个人的关键点;而且它的速度很快,在普通 GPU 上能实时跟踪 10 人以上的动作,不会出现 "卡顿" 或 "关键点漂移" 的问题。

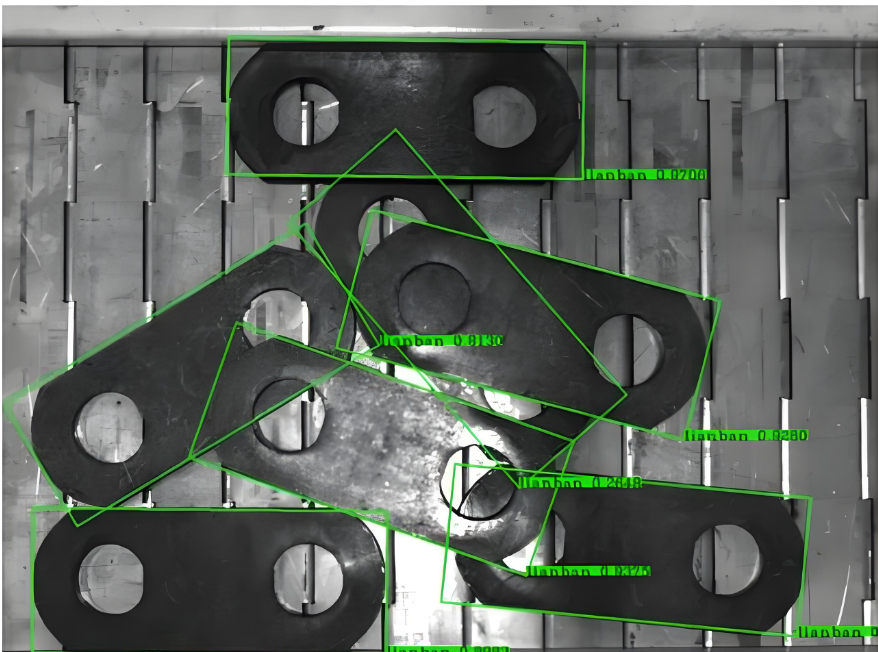

四、旋转框检测模型(YOLOv8-Rotated Detect):"解决倾斜难题,精准定位旋转物体"

核心作用

传统的目标检测模型只能画 "横平竖直的矩形框",但现实中很多物体是倾斜的 ------ 比如航拍图里的房子、文档里的倾斜文字、传送带上随意摆放的零件。旋转框检测模型的核心能力就是给倾斜物体画 "带角度的矩形框",精准匹配物体的实际摆放角度,避免出现 "一个倾斜的零件被框成一个很大的横平矩形,把旁边的零件也框进去" 的问题。

关键优势

YOLOv8-Rotated Detect 解决了传统检测模型的 "角度盲区" 问题,而且它的角度预测精度很高(误差通常小于 2 度),同时保持了和普通目标检测模型相近的速度,不需要为了 "画旋转框" 额外增加大量计算成本,很适合工业场景的落地。

五、图像分类模型(YOLOv8-Classify):"快速判断类别,简化识别任务"

核心作用

图像分类模型是计算机视觉中 "最基础、最简洁" 的工具,它的核心能力就是判断 "一张图像整体属于什么类别"------ 不需要标注物体位置,只需要给出 "这张图是猫""这张图是狗""这张图是风景" 这样的类别结果。简单说,就是让机器 "快速给图像贴标签"。

为什么需要它?

很多场景只需要 "判断类别",不需要 "定位位置",这时用分类模型比检测模型更高效。比如:

关键优势

YOLOv8-Classify 的最大优势是 "轻量、快速、易部署"------ 它的参数量只有检测模型的 1/3 左右,在手机、嵌入式设备上都能流畅运行;而且它的训练门槛低,只需要少量标注数据(比如每种类别 100 张图)就能达到较高的准确率,很适合快速落地简单的分类需求。

总结

YOLOv8 的五大模型没有 "优劣之分",只有 "场景适配之别"。选择时只需要明确两个问题:

-

你需要机器 "做什么核心动作"?------ 是 "找位置"(检测 / 旋转框)、"描轮廓"(分割)、"看动作"(姿势),还是 "贴标签"(分类)?

-

你对 "速度、精度、硬件" 有什么要求?------ 如果是嵌入式设备,优先选 "n/s 版本";如果是高精度场景(如医学影像),优先选 "l/x 版本"。