还记得以前我们怎么挑选大模型吗?我们要么忍受旗舰模型"老牛拉破车"般的推理速度,只为求一个靠谱的答案;要么为了秒回的快感,去忍受轻量级模型偶尔的"胡言乱语"。

在这个2025年的尾巴,谷歌似乎终于要把这道选择题撕掉了。

12月17日,Gemini 3 Flash 正式上线。如果不看发布会,光看名字,你可能会以为这又是一个为了省钱而不得不做出的妥协版。但上手实测并扒开数据一看,这次的情况有点不一样。谷歌不想让你把它当备胎,而是想让它成为你每天都在用的主力。

速度不再是智商的敌人

让我们先聊聊最直观的感受:快。

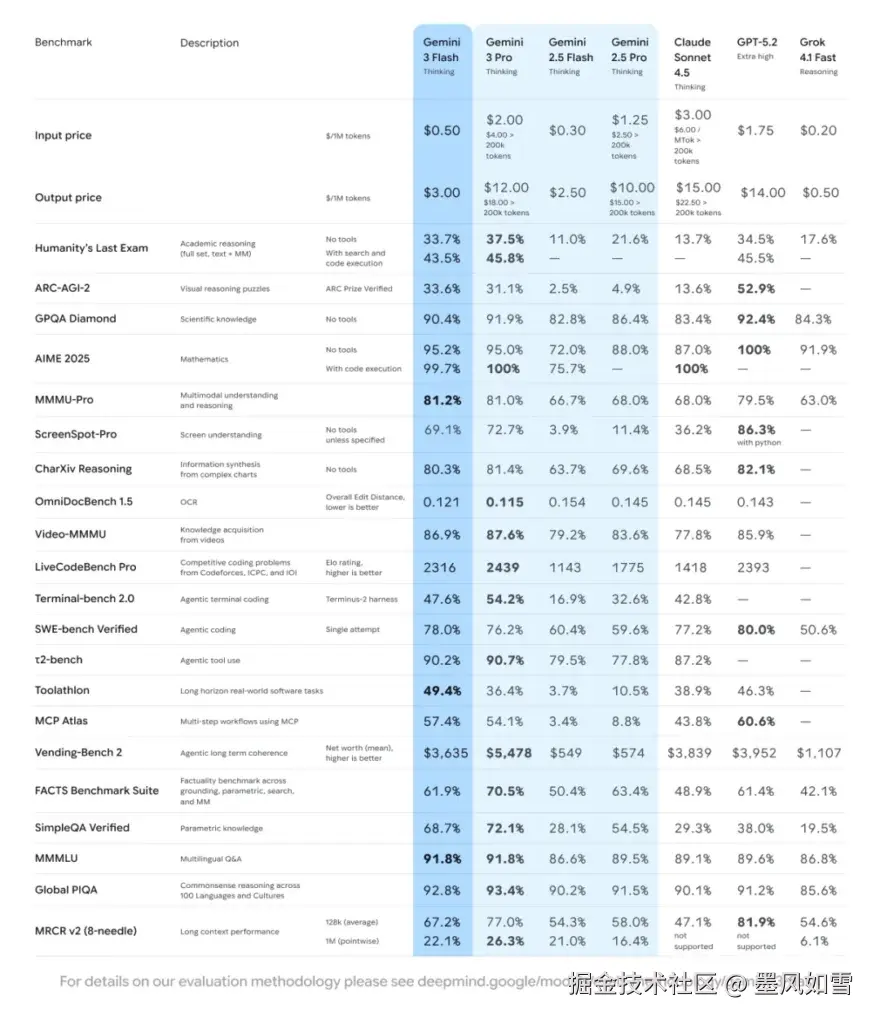

根据官方数据,Gemini 3 Flash 的运行速度是 Gemini 2.5 Pro 的三倍。这是什么概念?如果你是一个开发者,正在用它辅助写代码,以前你可能得切出去喝口水等代码生成,现在你可能刚敲完回车,光标就已经在疯狂跳动了。

更可怕的是它的效率。这模型似乎学会了"长话短说"。平均来看,完成同样的任务,它消耗的 token 比 2.5 Pro 少了 30%。这不仅意味着速度快,更意味着它能更精准地抓住重点,而不是在那儿车轱辘话来回说。

这真是"轻量版"?参数党的惊喜

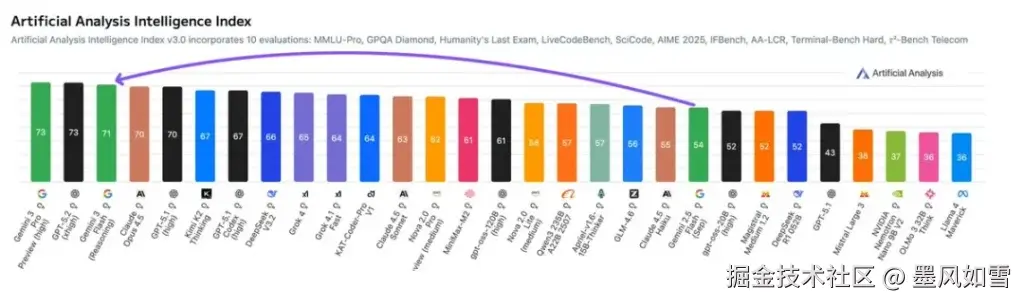

以往的 Flash 系列,大家都默认它在逻辑推理上会弱一截。但 Gemini 3 Flash 这次拿出的成绩单有点吓人。

在那个著名的"博士级科学推理"测试 GPQA Diamond 中,它拿到了 90.4% 的高分。在多模态推理 MMMU-Pro 上,它甚至略微超过了自家大哥 Gemini 3 Pro。

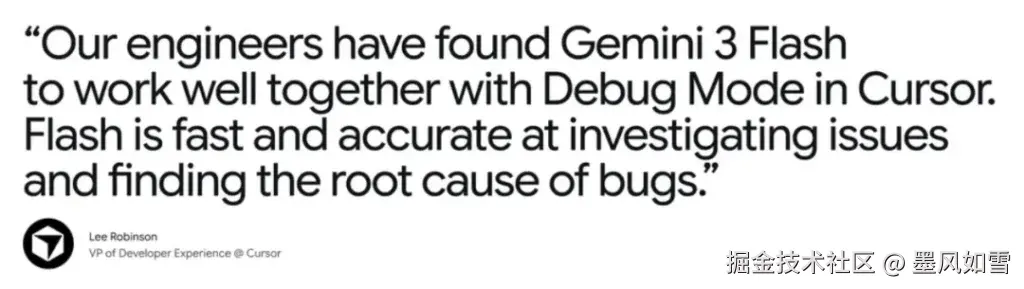

最让程序员兴奋的是 SWE-bench Verified 测试,这是评估 AI 写代码能力的硬指标。Gemini 3 Flash 的解决率达到了 78%,直接反超了 Gemini 3 Pro(76.2%)。

这意味着什么?意味着在绝大多数日常工作中,无论是写复杂的 Python 脚本,还是分析一段长视频,你根本不需要去调用那个昂贵的最强模型。这个所谓的"快版",脑子已经够用了,甚至更灵光。

价格屠夫的自我修养

对于个人用户,这事儿很简单:Gemini App 和谷歌搜索的 AI 模式已经默认切换到了这个模型,免费用,体验升级。

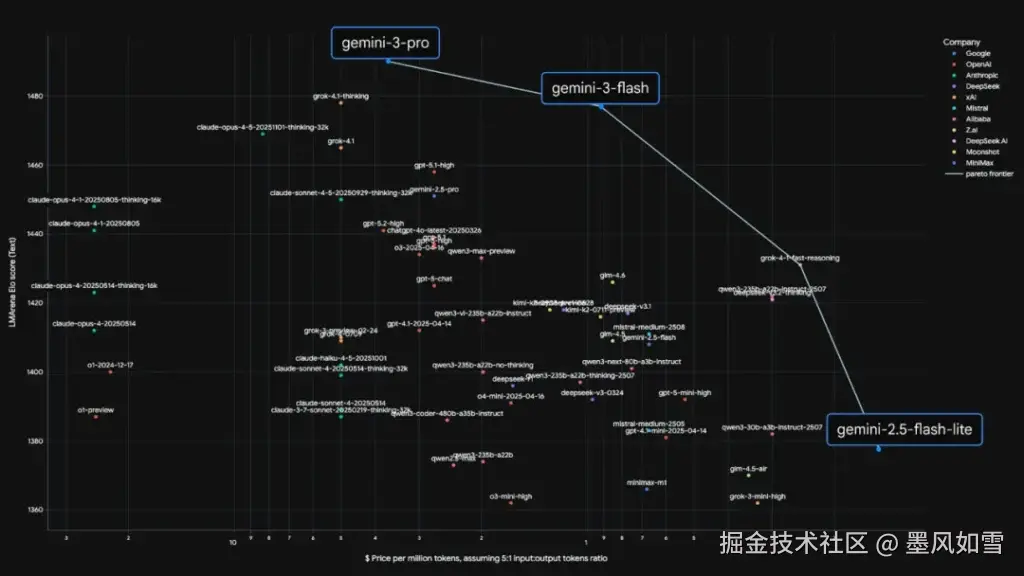

但对于开发者和企业来说,Gemini 3 Flash 的定价简直是在"做慈善"。输入每百万 token 0.5 美元,输出每百万 token 3 美元。这是什么水平?这只有 Gemini 3 Pro 价格的四分之一左右。

配合它那个"标准上下文缓存"功能,如果你是在处理重复的大量背景资料,成本还能再砍掉一大截。谷歌这次不仅是卷性能,还在卷"性价比"这条赛道上踩死了油门。

写在最后

谷歌这次的定位非常精准。他们把 Gemini 3 Flash 定义为"为了速度而生的前沿智能"。

在很长一段时间里,大模型竞赛似乎进入了堆参数的怪圈。但 Gemini 3 Flash 的出现标志着 2026 年的风向变了:我们不再单纯追求那个高不可攀的"最强大脑",而是需要一个随时待命、反应敏捷、且足够聪明的"全能助手"。

从今天起,当你打开 Gemini 问它问题时,那个秒回你的 AI,可能比你半年前顶礼膜拜的旗舰模型还要强大。这,就是技术迭代的残酷与迷人之处。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站