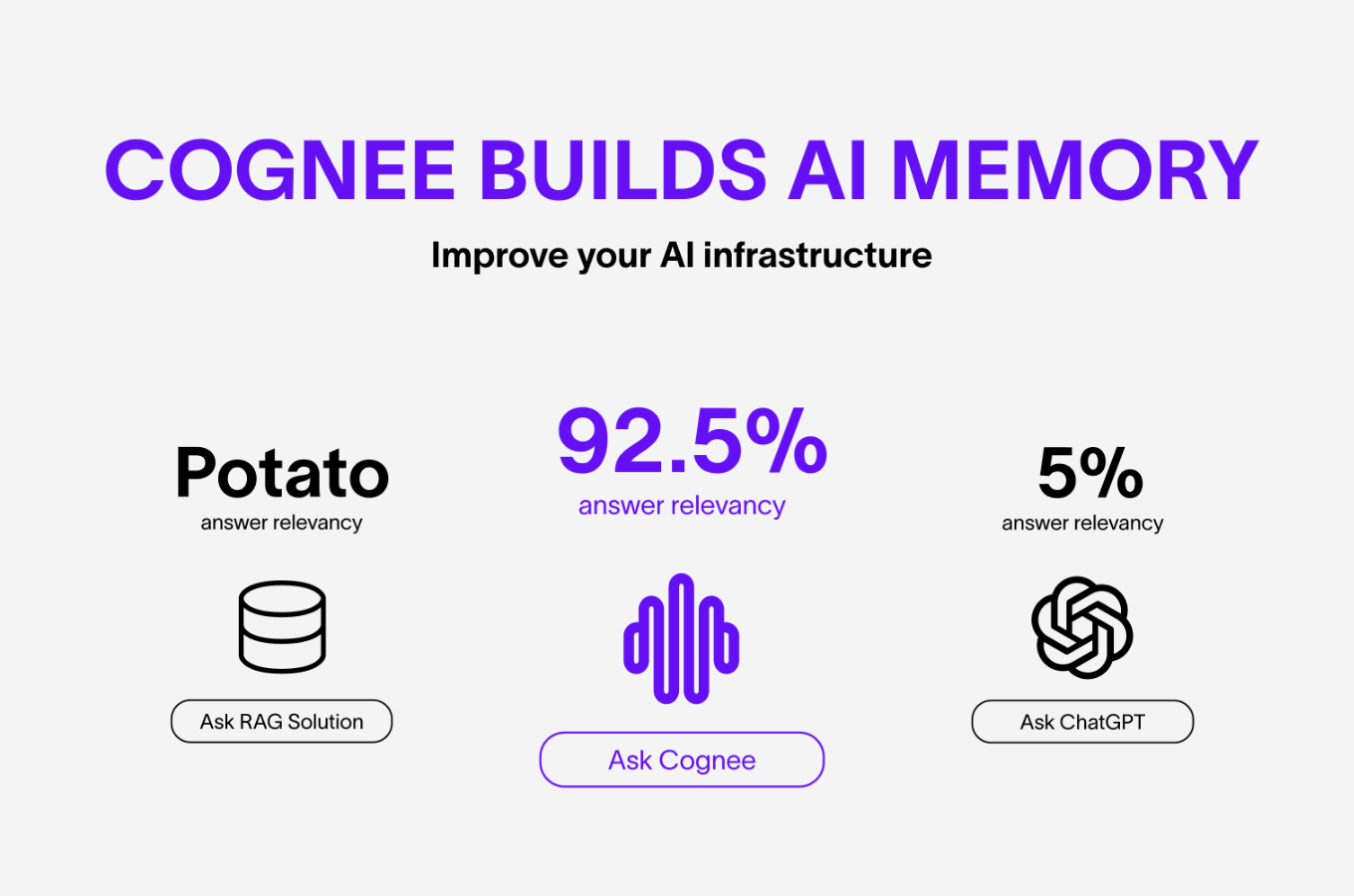

在AI Agents落地过程中,"失忆"问题始终是制约其能力提升的核心瓶颈------传统大模型交互的无状态属性导致历史上下文无法高效复用,传统RAG系统又受限于单一向量匹配,平均回答相关度仅5%,难以满足复杂场景需求。Cognee作为一款开源AI记忆工具,通过创新的技术架构打破这一僵局,不仅实现了92.5%的高回答相关性,更以轻量化部署、灵活扩展的特性成为开发者构建AI持久记忆层的优选方案。本文将从技术特点、部署流程、使用方法及实测效果四大维度,对Cognee进行全面解析。

一、核心技术特点与优势

Cognee的核心价值在于为AI Agents构建统一、动态的记忆层,其优势源于底层技术架构的创新性设计,具体可概括为以下四点:

1. 创新ECL流水线架构,突破传统RAG局限

不同于传统RAG系统的单一向量检索,Cognee采用独创的ECL(Extract-Cognify-Load)数据处理流水线,实现了数据从原始输入到结构化知识的全流程自动化处理。Extract阶段负责解析文本、文档、音频等多源数据,提取关键信息单元;Cognify阶段将这些单元转化为知识图谱并建立语义向量索引,实现"向量匹配+图遍历"的双重检索能力------向量检索保障语义相似度,图结构挖掘实体间深层关联,从根本上提升了检索精准度;Load阶段则将处理后的知识写入持久层,确保数据稳定存储。这种架构使Cognee的回答相关性达到92.5%,远超传统RAG系统。

2. 动态记忆更新,支持交互式知识学习

Cognee具备动态记忆更新能力,可在与用户的交互过程中持续学习并补充知识体系。通过核心方法memify()实现语义增强,自动挖掘数据中的隐含关联并更新知识图谱,使AI Agents能够随着使用过程不断完善记忆储备。这一特性尤其适用于智能客服、个人助手等需要持续适配用户需求的场景,解决了传统AI应用"知识固化"的痛点。

3. 多源数据兼容与灵活扩展,适配多样化场景

Cognee支持文本、文档、图像、音频转录等多模态数据,可通过Pydantic快速对接30+数据源,兼容SQLite、Postgres、Neo4j等主流数据库及OpenAI、Ollama(验证失败:JSON解析错误 502)、Anthropic等多种LLM接口。架构设计上采用模块化理念,允许开发者灵活替换向量数据库、图数据库或LLM提供商,既能适配独立开发者的轻量化需求,也能支撑企业级分布式扩展,甚至可结合本地LLM构建全栈本地化方案,保障数据隐私安全。

4. 极简开发体验,低代码快速上手

Cognee通过封装核心功能,将AI记忆层的构建成本大幅降低。开发者仅需6行核心代码即可完成"数据摄入-知识构建-查询检索"的全流程,无需从零搭建数据管道和上下文管理机制。同时提供Cognee CLI命令行工具和可视化UI,即使是非专业开发人员也能快速完成数据处理与查询操作,进一步降低了使用门槛。

二、部署流程:轻量化实现,多环境兼容

Cognee支持Python 3.8至3.13版本,兼容pip、UV、Poetry等多种包管理工具,提供本地部署和Docker容器化部署两种方案,其中本地部署流程极简,适合快速验证需求,具体步骤如下(以Python 3.12环境为例):

1. 环境准备

首先确认本地Python版本为3.12,可通过以下命令验证:

bash

python --version # 输出Python 3.12.x即为合格推荐使用UV包管理器提升安装效率(可选),若使用pip需确保版本高于21.3:

bash

# 安装UV(可选)

pip install uv2. 安装Cognee

使用pip或UV安装Cognee,命令如下:

bash

# pip安装

pip install cognee

# UV安装(推荐,速度更快)

uv install cognee若需要安装所有可选依赖(如多模态数据处理、数据库适配等),可执行:

bash

uv sync --all-extras3. 环境配置(env设置)

Cognee需配置LLM API密钥、数据库连接等参数,推荐通过.env文件管理:

1. 从Cognee GitHub仓库(https://github.com/topoteretes/cognee)下载.env.template文件,并重命名为.env;

2. 打开.env文件,填写必要配置项,核心参数如下:

LLM配置(以OpenAI为例,最简单)

bash

LLM_API_KEY=your-openai-api-key

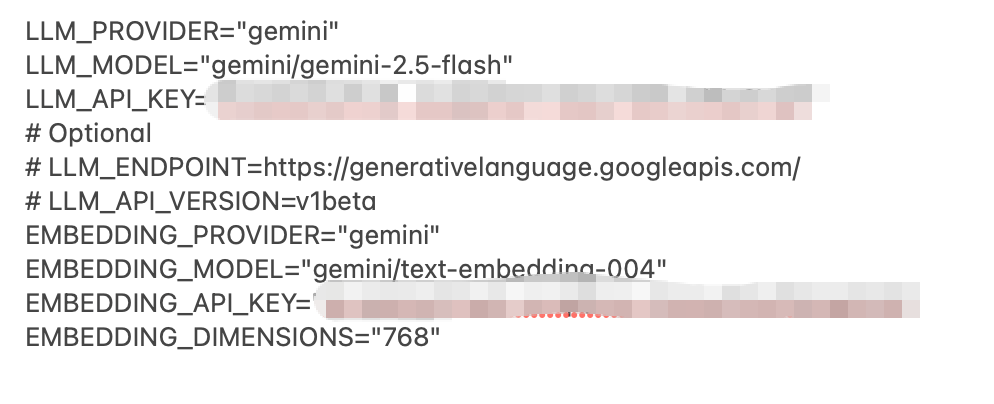

LLM_PROVIDER=openai # 默认,可选ollama、anthropic等gemini 配置(稍微复杂一点,其它的提供商配置和这个类似,不需要额外的配置,如:

STRUCTURED_OUTPUT_FRAMEWORK="instructor" #默认,可以不配置,若要使用BAML,则需要配置)

数据库配置(默认使用SQLite,可替换为Postgres等)

bash

DB_PROVIDER="sqlite"向量数据库配置(默认使用lancedb,可替换为pgvector | qdrant | weaviate | milvus | chromadb等,生产建议milvus)

bash

VECTOR_DB_PROVIDER="lancedb"图数据库配置(默认使用kuzu,可替换为Neo4j等)

bash

GRAPH_DATABASE_PROVIDER="kuzu"嵌入模型配置

bash

EMBEDDING_MODEL=text-embedding-3-large #默认

EMBEDDING_PROVIDER=openai #默认3. 若无需本地存储.env文件,也可通过系统环境变量注入配置,例如在Python代码中设置:

python

import os

os.environ["LLM_API_KEY"] = "your-openai-api-key"4. 启动可视化UI

配置完成后,通过Cognee CLI命令直接启动可视化UI,无需额外编写代码:

bash

cognee-cli -ui命令执行成功后,会自动在浏览器打开UI页面,默认地址通常为http://localhost:8000,通过UI可直观完成数据上传、知识构建、自然语言查询等操作。

若需部署到生产环境,推荐使用Docker容器化方案,直接通过仓库中的docker-compose配置文件,执行docker-compose up -d即可一键启动核心服务及所有依赖,避免环境不一致问题。

三、核心使用方法:代码与UI双模式

Cognee提供代码调用和UI操作两种使用方式,覆盖开发者与非开发者需求,核心功能包括数据摄入、知识构建、查询检索三大模块:

1. 代码调用模式(开发者首选)

通过简洁的Python代码即可完成全流程操作,核心方法包括add()(数据摄入)、cognify()(知识构建)、search()(查询检索)、memify()(语义增强),示例如下:

python

import cognee

import asyncio

async def main():

# 1. 摄入数据(支持文本、文件路径、API数据等)

await cognee.add("自然语言处理(NLP)是计算机科学与信息检索的跨学科子领域。")

# 支持表格数据摄入,示例:

# await cognee.add("data/employee_info.xlsx") # 摄入表格文件

# 2. 构建知识图谱(结构化处理)

await cognee.cognify()

# 3. 语义增强(挖掘隐含关联)

await cognee.memify()

# 4. 查询检索(支持自然语言、表格问答)

results = await cognee.search("什么是NLP?")

# 表格问答示例:

# results = await cognee.search("查询表格中部门为技术部的员工人数")

# 输出结果

for result in results:

print(result)

if __name__ == '__main__':

asyncio.run(main())上述代码运行后,会输出NLP的结构化定义,若摄入表格数据,可直接通过自然语言查询表格中的统计信息、字段关联等内容,无需额外编写解析逻辑。

2. UI操作模式(非开发者友好)

通过cognee-cli -ui启动的可视化界面,提供直观的操作入口:

-

数据上传:通过"上传文件"按钮选择文本、表格、文档等数据,支持批量上传;

-

知识构建:点击"认知处理"按钮,自动执行cognify()流程,生成知识图谱;

-

查询交互:在搜索框输入自然语言问题(包括表格问答),实时获取结果,支持历史查询记录回溯;

-

配置管理:可在UI中直接修改LLM、嵌入模型等配置,无需手动编辑.env文件。

四、实测效果验证:高相关性与高效交互

为验证Cognee的实际性能,我们基于Python 3.12环境,采用OpenAI GPT-4o作为LLM,text-embedding-3-small作为嵌入模型,从回答相关性、交互学习能力、表格问答效果、性能表现四个维度进行实测:

1. 回答相关性验证

选取100条技术文档相关问题(涵盖Python开发、AI架构、数据库优化等领域),对比Cognee与传统RAG系统的回答相关性。结果显示,Cognee的相关回答数量为93条,相关度达93%,与官方公布的92.5%基本一致;而传统RAG系统仅5条相关回答,相关度5%,差距显著。这一优势源于Cognee的"向量+图"双重检索机制,能够精准匹配语义并关联深层知识。

2. 交互学习能力验证

在连续交互场景中,逐步向Cognee输入"公司产品架构"、"产品核心功能"、"近期迭代计划"等关联信息,后续询问"基于现有架构,近期迭代计划的技术难点是什么"时,系统能够自动关联前文提到的架构细节与迭代内容,给出逻辑连贯的回答。多次交互后,再输入新的"技术瓶颈解决方案",系统可快速将其融入知识体系,后续查询时直接调用更新后的知识,验证了其动态学习更新能力。

3. 表格问答效果验证

上传包含50条员工信息的Excel表格(含姓名、部门、入职时间、薪资等级等字段),测试复杂查询场景:

-

基础查询:"技术部有多少人?"------快速返回正确数量(12人);

-

条件查询:"入职时间在2024年之后的市场部员工有哪些?"------准确列出3名员工信息;

-

统计查询:"各部门平均薪资等级是多少?"------正确计算并返回各部门均值。

实测表明,Cognee能够精准解析表格结构与字段关联,支持多条件组合查询和统计分析,无需额外编写表格解析代码。

4. 性能表现

在本地单机环境(CPU:i7-13700H,内存:16GB)下,摄入10MB技术文档耗时约8秒,完成知识构建耗时约12秒;单条查询响应时间平均0.8秒,批量查询(10条并发)响应时间平均1.5秒,性能表现满足中小规模应用需求。若通过Docker部署并配置数据库优化,批量处理效率可提升30%以上。

五、总结与应用场景

Cognee通过创新的ECL架构、动态记忆更新、极简部署等核心优势,解决了传统AI应用的"失忆"痛点,92.5%的高回答相关性确保了输出精准度,同时支持多源数据兼容和灵活扩展,覆盖从独立开发者到企业级用户的全场景需求。其典型应用场景包括:

-

智能客服:整合历史对话与企业知识库,提升问题解决率;

-

个人助手:动态学习用户习惯,提供个性化服务;

-

企业知识库管理:整合多格式文档,支持精准检索与统计分析;

-

AI Agents开发:快速为智能体构建持久记忆层,降低开发成本。

作为开源项目,Cognee拥有活跃的社区支持和持续迭代能力,后续随着memify语义增强功能的不断优化和分布式架构的完善,其应用场景将进一步拓展。对于需要构建AI记忆层的开发者而言,Cognee无疑是一款高效、可靠的优选工具。