本文提出了一种高效、轻量的多任务神经网络 DarkIR ,用于**联合解决夜间或低光照场景下的图像去噪、去模糊与低光照增强(LLIE)**三大问题。核心贡献包括:

-

非对称编码器-解码器架构:

-

编码器在频域利用傅里叶幅度信息快速完成低光照增强;

-

解码器在空间域通过空洞大核注意力(Di-SpAM)去除模糊并恢复细节。

-

-

任务专用模块设计:

-

EBlock(编码器)结合空间注意力与频域MLP;

-

DBlock(解码器)采用空洞深度卷积扩大感受野,参数量与计算量显著降低。

-

-

复合损失函数 :

结合像素L1、感知LPIPS、边缘梯度与低分辨率引导损失,确保高保真与视觉自然。

-

实验结果:

-

在 LOLBlur、LOLv2、Real-LOLBlur 等数据集上PSNR 提升 1 dB 以上 ,参数比 LEDNet 少 55% ,比 Restormer 少 88%;

-

在真实夜间模糊图像上泛化良好,推理速度显著优于现有方法。

-

简言之,DarkIR 以更低的计算成本 实现了夜间图像去噪、去模糊与增强的统一处理 ,为移动端计算摄影提供了新的实用基线。这里是自己的论文阅读记录,感兴趣的话可以参考一下,如果需要阅读原文的话可以看这里,如下所示:

项目地址在这里,如下所示:

摘要

夜间或暗光环境下拍摄的照片通常存在噪声、亮度不足和模糊等问题,这是由于环境昏暗以及普遍采用长曝光所致。尽管去模糊与低光照图像增强(LLIE)在这些条件下密切相关,但现有图像复原方法大多将这两个任务分开处理。本文提出了一种高效且鲁棒的神经网络,用于多任务低光照图像复原。与当前流行的基于 Transformer 的模型不同,我们设计了新的注意力机制,以扩大高效 CNN 的感受野。与先前方法相比,我们的方法在参数量和 MAC 运算量上均显著降低。我们的模型 DarkIR 在 LOLBlur、LOLv2 和 Real-LOLBlur 等主流数据集上取得了新的最先进结果,并能在真实夜间与暗光图像上实现良好的泛化。

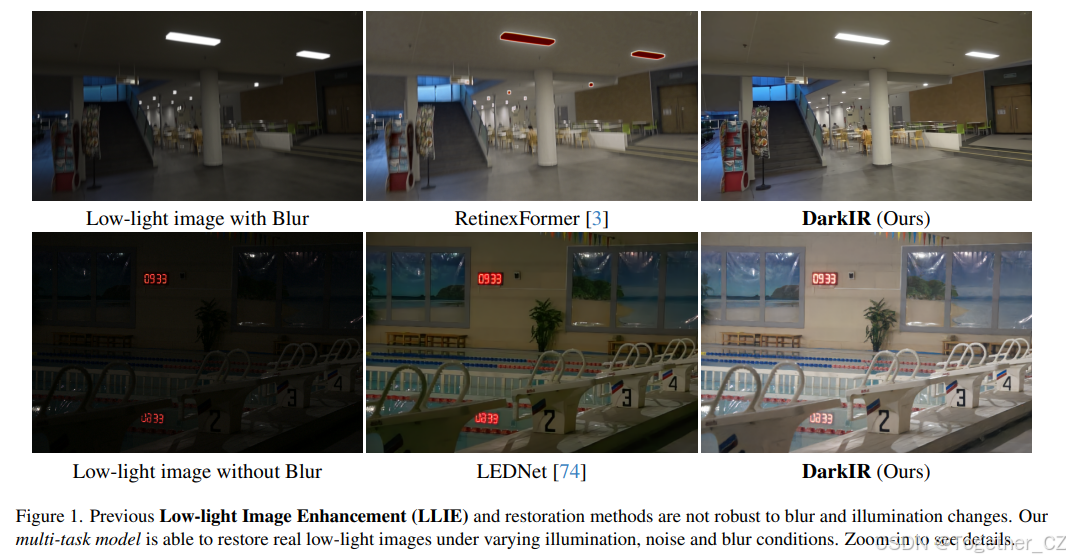

图 1

左侧:低光照图像带模糊;RetinexFormer [3];DarkIR(本文)

右侧:低光照图像无模糊;LEDNet [74];DarkIR(本文)

图注:以往的低光照图像增强(LLIE)与复原方法对模糊和光照变化不鲁棒。我们的多任务模型能够在真实低光照、噪声和模糊条件下复原图像。请放大查看细节。

1. 引言

在夜间或低光照条件下,图像成像过程可表示为:

y=γ(x⊗k)+n,

其中 y 为观测到的暗图像,x 为无扰动的真实场景,k 表示镜头(点扩散函数)模糊核,n 为加性传感器噪声,γ 用于控制动态范围与像素饱和。⊗ 表示卷积算子。

与白天相比,低光照下的噪声(散粒噪声与读出噪声)显著更高。夜间摄影时,相机通常使用长曝光(慢快门)以允许更多光线进入传感器,但这会导致重影与模糊伪影。这些退化在智能手机上尤为明显,因其光圈固定且光学系统受限。因此,联合低光照增强与去模糊对移动计算摄影至关重要 [12, 74]------见图 1。

在任何情况下,拍摄的图像都会存在一定程度的噪声与模糊 [13]。使用三脚架可减少模糊;若再辅以适当照明,则可显著降低噪声 [1]。然而,如今大多数照片由(手持)智能手机拍摄。受限于传感器尺寸与光学系统,智能手机相比无反相机(DSLM)需要更复杂的图像信号处理器(ISP)[10, 12]。尽管智能手机摄影质量仍不及 DSLM,但低层计算机视觉与计算摄影的最新研究正逐步缩小这一差距。低光照图像增强(LLIE)[3, 14, 31, 32, 53, 73]、图像去模糊 [21, 25, 43, 46] 与夜间摄影增强 [48, 74] 已成为热门研究方向。

例如,抑制手抖引起的模糊已在低光照场景中得到广泛研究 [30, 71]。然而,这些任务通常被单独解决:最先进的去模糊方法在夜间图像上泛化性差,而最佳的低光照增强方法又无法有效去除显著模糊。这带来明显局限:需要多个任务专用模型依次微调、存储与部署,限制了其在真实场景中的应用。

据我们所知,极少有工作以端到端方式联合解决去噪、去模糊与 LLIE 这三大任务 [6, 36, 72, 74],其中 LEDNet [74] 最为突出。我们专注于这一研究方向,因为利用退化之间的相关性可在图像重建、可用性与效率方面取得最佳性能。

我们的贡献

我们提出了一种在空间域与频域同时操作的卷积神经网络(CNN)。在空间域,我们通过大感受野空间注意力解决噪声 n 与非均匀模糊 k ;在傅里叶域,借助其全局特性,可轻松增强低光照条件 [29, 51]。我们的贡献总结如下:

-

设计了一种轻量级神经网络,融合频域注意力与大感受野注意力,联合利用空间与频域信息。

-

我们的模型 DarkIR 在 LOLBlur 和 Real-LOLBlur 数据集上取得新的最先进结果,相比 LEDNet [74] PSNR 提升 +1 dB,同时计算量更低。

-

DarkIR 为夜间/暗光多任务图像复原提供了新的基线。

2. 相关工作

图像去模糊

数十年来,研究人员致力于重建清晰场景。去模糊分为盲去模糊与非盲去模糊:非盲方法已知模糊核 k (或 PSF),而盲方法无任何先验。近年来,大量基于深度学习的方法被提出 [25, 43],在盲与非盲场景均超越传统方法。非盲方法仅需模糊-清晰图像对即可训练,无需估计 PSF 或传感器信息,具有传感器无关性,可处理来自不同设备的 sRGB 图像。

如今,多数方法基于卷积神经网络(CNN)[4, 25, 42, 66]。DeblurGAN [25] 使用生成对抗网络(GAN)解决该问题。更近的工作 [24] 实现了基于频域的高效 Transformer 去模糊。此外,还有迭代方法与扩散模型 [36]。

低光照图像增强(LLIE)

早期方法依赖图像统计或先验信息 [2, 18],大多基于著名的 Retinex 理论 [26]。随着深度学习发展,LLIE 方法转向 CNN,如 RetinexNet [56](及其 LOL 数据集)、ZeroDCE [16] 和 SCI [39]。近期方法探索 Transformer 的潜力,如 RetinexFormer [3],或利用傅里叶频域信息增强图像幅度,如 FourLLIE [51]。

低光照模糊增强

尽管图像去模糊与低光照增强均备受关注,但同时解决这两个任务极具挑战,文献中极少涉及 [6, 36, 72, 74]。NBDN [6] 提出非盲网络增强夜间饱和图像,指出以往方法在处理噪声或饱和区域时存在问题。LEDNet [74] 假设图像同时存在低光照与模糊,这一假设符合智能手机在暗光下需长曝光的现实。作者设计了编码器-解码器网络,并发布了 LOLBlur 与 Real-LOLBlur 数据集。

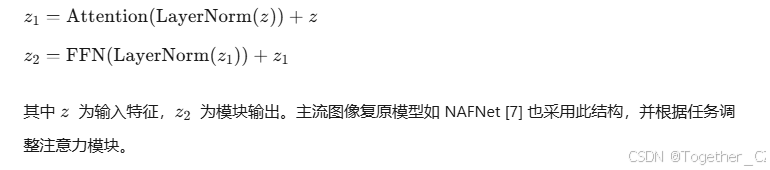

3. 方法

我们遵循 Metaformer [65] 设计神经网络,将 Transformer 架构简化为两个组件:全局注意力(token mixer)与前馈网络(FFN,MLP)。典型模块公式为:

我们针对 LLIE 与去模糊任务改进了 Metaformer 结构。

-

低光照增强 可在频域高效完成。

诸多工作 [29, 51] 证明,低光照条件与图像在傅里叶域的幅度高度相关。因此,仅增强幅度(不改变相位)即可显著校正光照。该性质在不同分辨率均成立 [29],故可在低分辨率估计增强图像并上采样。

-

锐化与去模糊 通常需要大感受野,可通过下采样提取深层特征实现------如 NAFNet [7]。另一种方案是使用大卷积核 [35],但这会增加计算复杂度与内存需求。

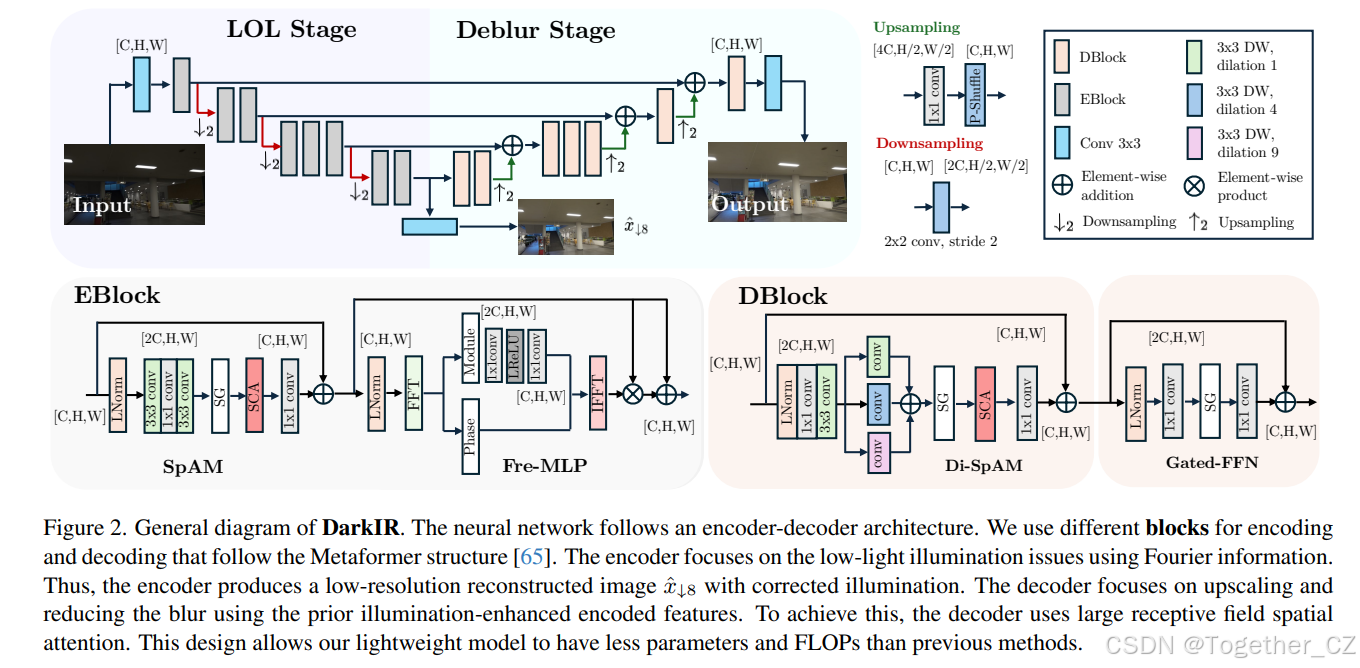

DarkIR 模型

图 2 展示了我们的模型。与多数方法不同,我们在编码器与解码器使用不同模块。此非对称设计的核心思想是:在编码器低分辨率阶段完成低光照增强,在解码器阶段去模糊,类似 LEDNet [74]。解码器利用编码器提供的已增强特征,专注于上采样并提升低分辨率重建 x^↓8 的清晰度。

-

编码器模块 用于恢复低光照,工作在傅里叶域 [29, 51]。

-

解码器模块 专注于空间域,采用空洞卷积扩大感受野。

通过任务专用模块,我们减少了模块数量,显著降低参数量与计算量(MACs/FLOPs)。

为确保编码器执行低光照增强,如图 2 所示,编码特征经线性组合(卷积层)生成中间图像 x^↓8 。我们利用该中间输出增加损失项进行正则化。良好的低分辨率表示可确保频域幅度已正确增强。

3.1 低光照增强编码器

我们设计的编码器模块(EBlock)利用傅里叶信息增强低光照,遵循 Metaformer [65](及 NAFBlock [7])结构。模块包含两部分:空间注意力模块(SpAM)与频域前馈网络(FreMLP)。

-

SpAM 类似 NAFBlock [7],采用倒置残差块与简化通道注意力(SCA)。不使用激活函数,而采用简单门控机制,使模型在频域增强前提取有意义的空间信息。

-

FreMLP 依据 [36, 51],图像光照信息主要存在于频域幅度。我们先做快速傅里叶变换(FFT),仅对幅度操作,再通过逆 FFT(IFFT)回到空间域。FreMLP 在此作为额外注意力机制,相比空间域 MLP(如通道 MLP [65])更具优势。

编码器使用步长卷积下采样特征。每级分辨率减半,因此深层可使用更多编码器模块而不显著增加运算量。

最终,编码器向解码器提供已增强特征,并给出低分辨率清晰图像估计 x^↓8 (分辨率为原图 1/8)。尽管分辨率低,但光照(幅度)跨尺度一致 [29]。

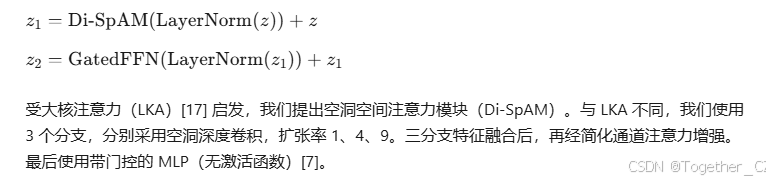

3.2 去模糊解码器

解码器模块(DBlock)专注于空间变换。输入为 x^↓8 的深层表示,因此假设:(1) 解码器需上采样该初始估计;(2) 解码器需减少模糊并提升锐度,因光照已由编码器校正。

模块仍遵循 Metaformer 结构 [65]:

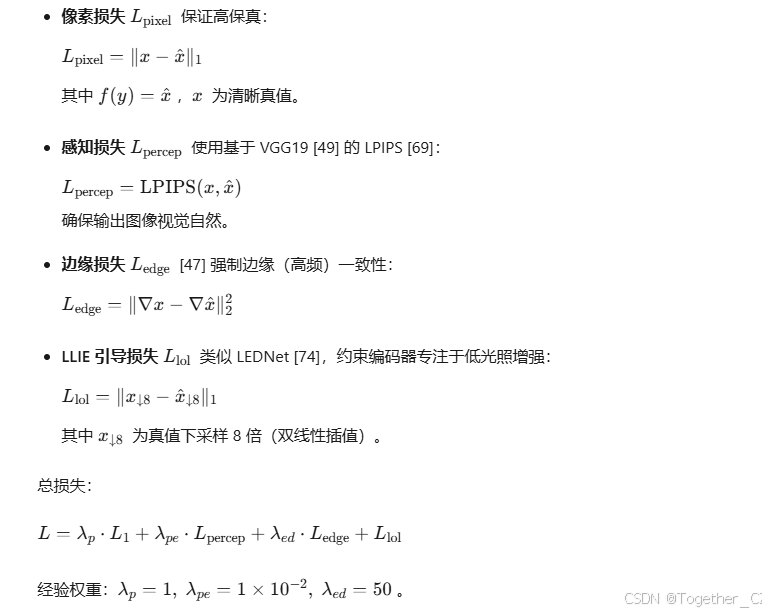

3.3 损失函数

除新模块设计外,损失函数也发挥了关键作用。我们结合失真损失与感知损失优化模型 f 。

4. 实验结果

4.1 数据集

-

LOLBlur [74]:大规模合成数据集,含 10 200 训练对、1 800 测试对。通过帧平均合成模糊,并用 EC-Zero-DCE(Zero-DCE [16] 变体)降低亮度。使用含真实传感器噪声的版本,提升真实场景鲁棒性。

-

Real-LOLBlur [74]:真实世界测试集,482 张夜间模糊图像,选自 RealBlur [46],无真值。

-

LOLv2 (real) [64]:689 对低/高光照图像训练,100 对测试。

LOLv2 (synthetic):900 对训练,100 对验证。 -

LSRW [19]:含 Nikon DSLM 与 Huawei 智能手机图像。

-

LSRW-Nikon:3 150 训练对,20 测试对。

-

LSRW-Huawei:2 450 训练对,30 测试对。

-

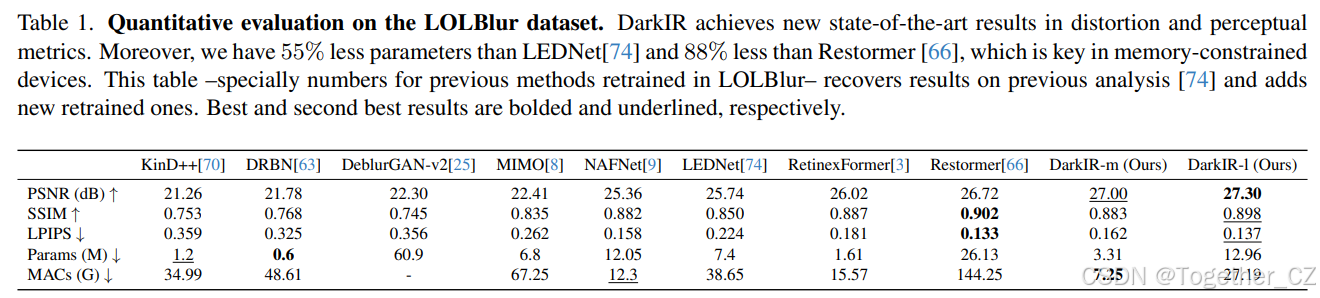

4.2 结果

我们在 LOLBlur 数据集上定量与定性评估 DarkIR。补充材料提供实现细节。我们重新训练了部分通用 SOTA 方法,并与 LEDNet [74] 及本文网络对比。评估分为三类:

-

LLIE → 去模糊:Zero-DCE [16]、RUAS [31]、RetinexFormer [3] → MIMO-UNet [8] 或 NAFNet [7]。

-

去模糊 → LLIE:DeblurGAN-v2 [25](RealBlur)、MIMO-UNet [8] 或 NAFNet [7](GoPro)→ Zero-DCE [16] 或 RetinexFormer [3]。

-

端到端训练:在 LOLBlur 上重新训练的 KinD++ [70]、DRBN [63]、RetinexFormer [3];去模糊网络:DeblurGAN-v2 [25]、NAFNet [9]、MIMO-UNet [8]、Restormer [66]。

-

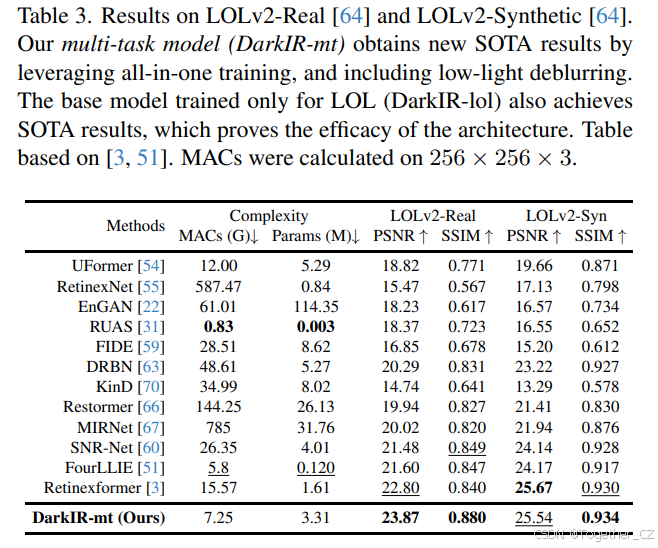

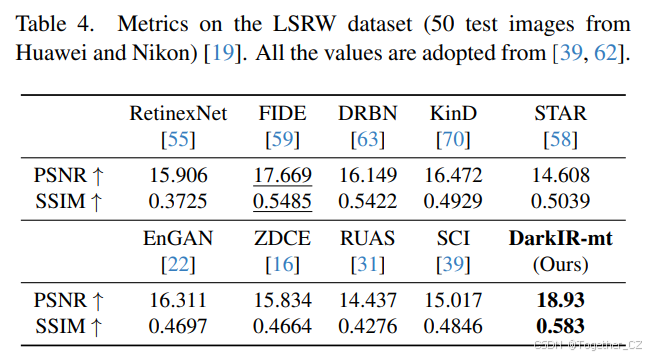

多任务训练:联合 LOLBlur、LOLv2、LSRW 训练(all-in-one 策略 [11, 28, 45, 68])。结果见表 3、4。DarkIR-mt 在保持 LOLBlur 性能(26.62 dB,仅降 0.4 dB)的同时,超越以往仅对光照与噪声鲁棒的 LLIE 方法。

评估指标

-

合成 LOLBlur:PSNR、SSIM(失真指标),LPIPS [69](感知指标)。

-

真实 Real-LOLBlur:无真值,采用 MUSIQ [23]、NRQM [37]、NIQE [41] 等盲质量评估。

定量与定性结果

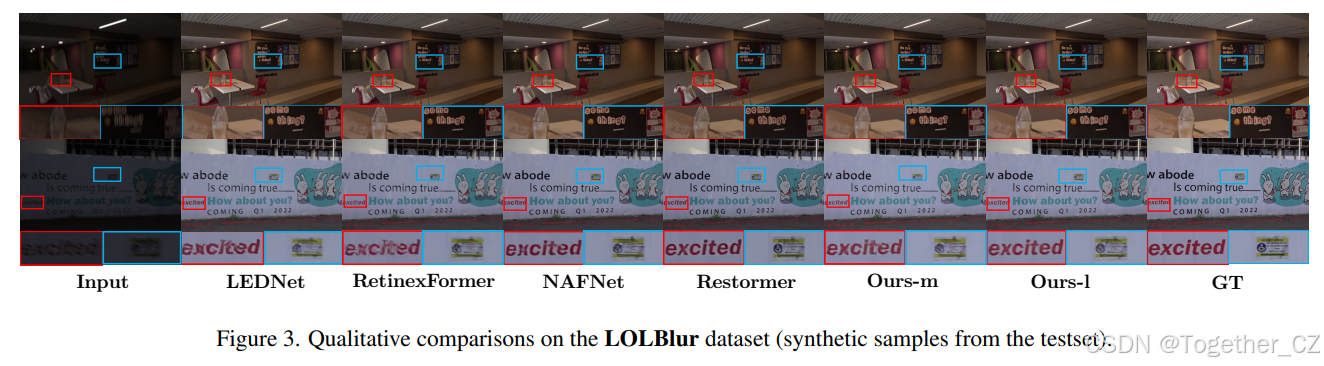

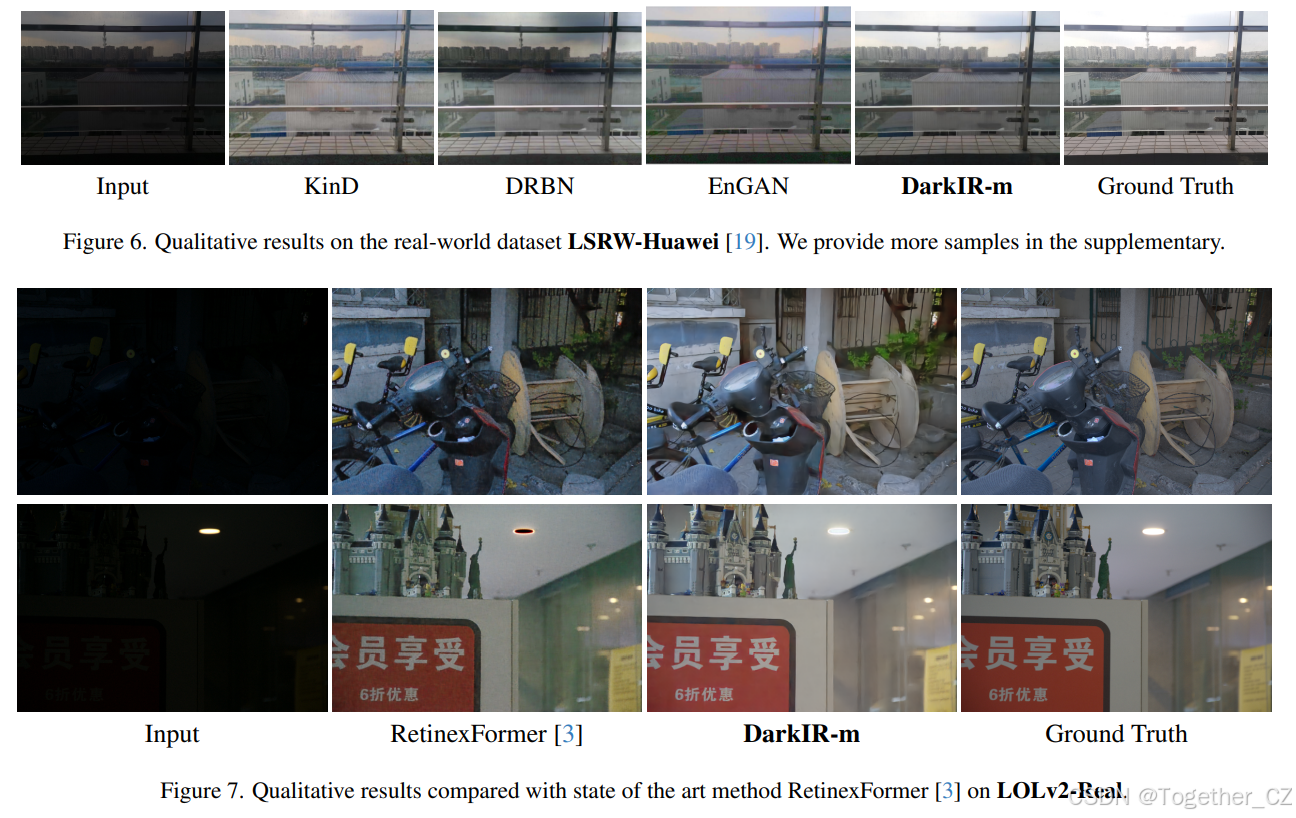

表 1 显示,DarkIR 在 PSNR 上比 LEDNet [74] 提升 +1 dB,LPIPS 降低一半,且参数量与计算量更少。图 3 给出视觉对比。

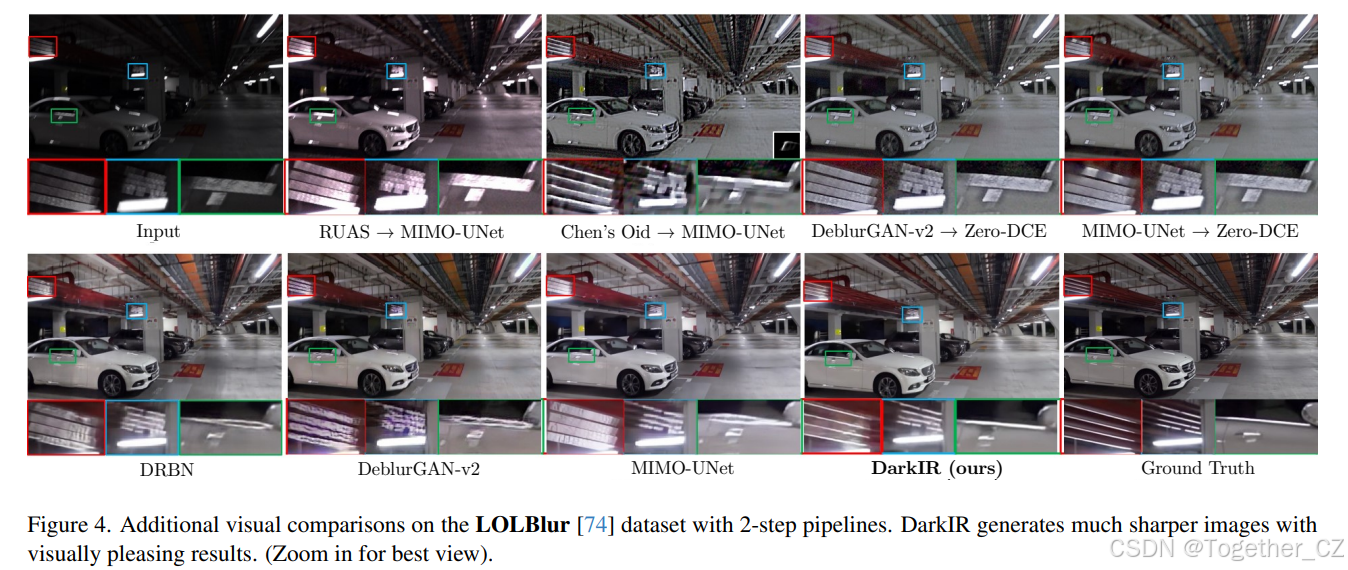

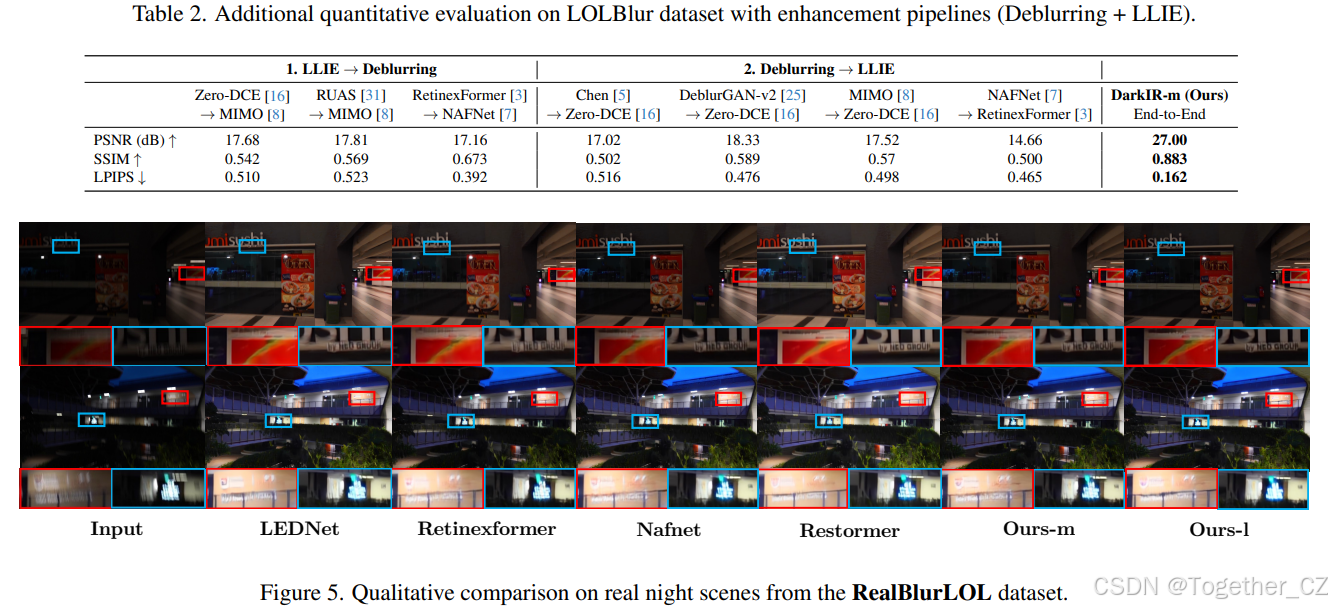

表 2 对比两步流水线,DarkIR 优势明显。图 4 展示更多细节与锐度。

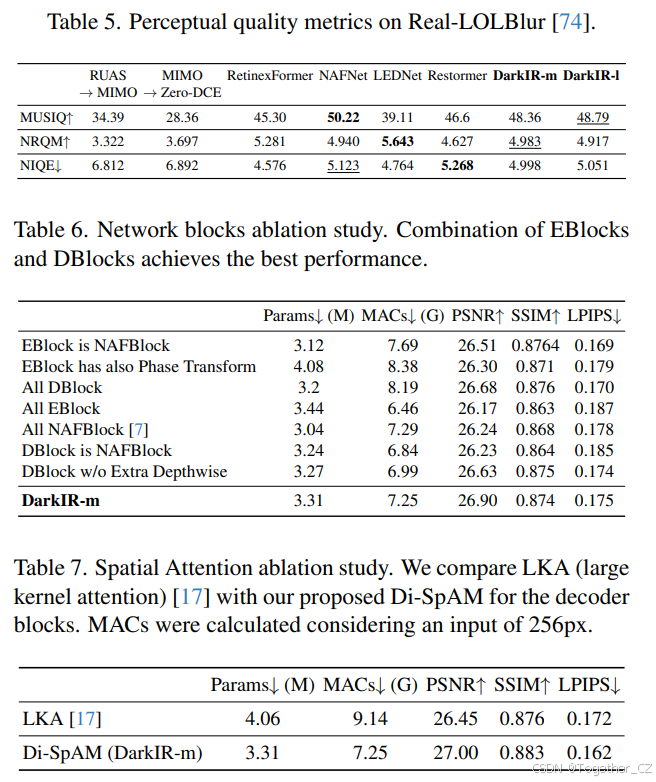

4.3 真实数据评估

在 Real-LOLBlur [74] 上,DarkIR 在 MUSIQ、NRQM、NIQE 上均取得有竞争力的感知分数(表 5)。图 5 展示真实夜间模糊图像的复原效果,可见对运动模糊、传感器噪声、饱和像素与低光照的鲁棒性。

4.4 消融实验

模块配置(表 6)

-

将 EBlock 替换为 NAFBlock:PSNR 26.51 dB。

-

EBlock 加入相位变换:26.30 dB。

-

全部使用 DBlock:26.68 dB。

-

全部使用 EBlock:26.17 dB。

-

全部使用 NAFBlock:26.24 dB。

-

DBlock 替换为 NAFBlock:26.23 dB。

-

DBlock 移除额外深度卷积:26.63 dB。

-

DarkIR-m:26.90 dB(最佳)。

空间注意力对比(表 7)

-

LKA [17]:PSNR 26.45 dB,参数量 4.06 M,MACs 9.14 G。

-

Di-SpAM (DarkIR-m):27.00 dB,3.31 M,7.25 G。

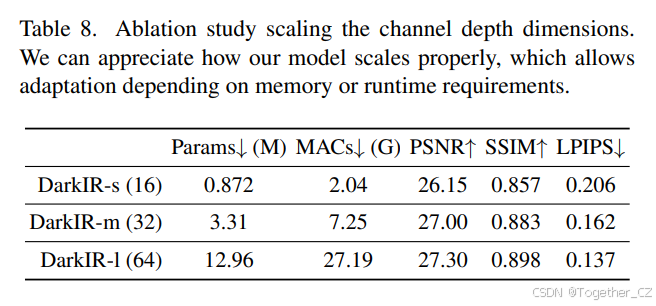

通道维度缩放(表 8)

-

DarkIR-s (16):26.15 dB,0.872 M,2.04 G。

-

DarkIR-m (32):27.00 dB,3.31 M,7.25 G(最佳效率/性能平衡)。

-

DarkIR-l (64):27.30 dB,12.96 M,27.19 G。

4.5 效率讨论

通过 EBlock 与 DBlock,DarkIR 参数量比 LEDNet [74] 减少 55%,比 Restormer [66] 减少 88%。以 256×256 输入为例:

-

LEDNet:33.74 GMACs

-

Restormer:141.24 GMACs

-

DarkIR:7.25 GMACs(4× 少于 LEDNet,近 20× 少于 Restormer)

因此,DarkIR 在保持 SOTA 性能的同时,更轻量,适合低算力设备。

5. 局限性

尽管我们降低了计算需求,但深度卷积在某些 GPU 架构上算术强度不足 [15],导致推理时间未随运算量减少而显著降低。未来工作将探索低计算量与更快推理的结合。

6. 结论

我们提出了一种多任务低光照增强与复原模型 DarkIR。该网络高效鲁棒,可同时去噪、去模糊并增强暗光/夜间图像。DarkIR 在 LOLBlur、LOLv2 和 Real-LOLBlur 数据集上取得新的最先进结果,并在真实夜间模糊图像上表现良好,且比现有方法更高效。