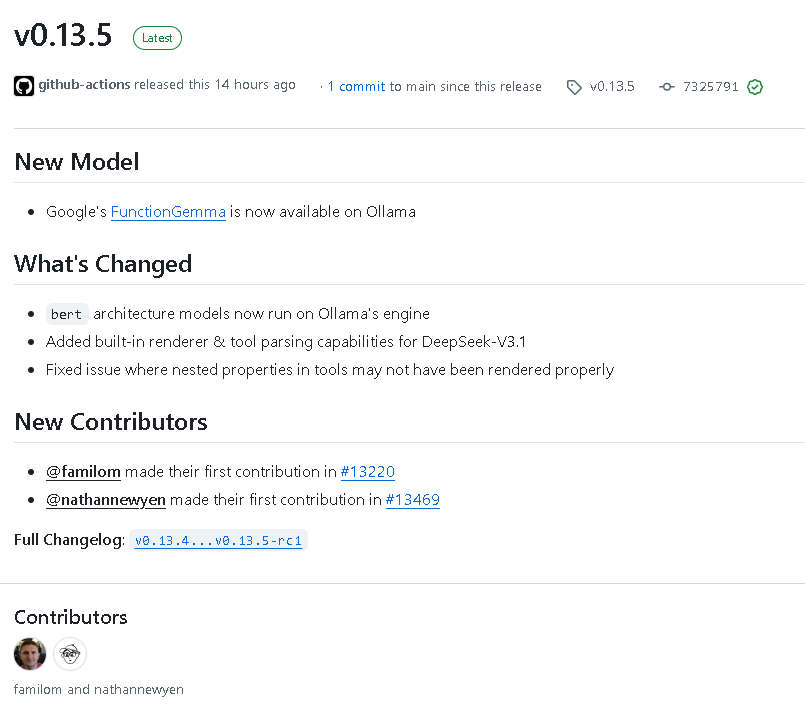

ollama v0.13.5 于 2025 年 12 月 19 日正式发布。本次版本更新规模较大,共合并 10 次提交,涉及约 150 个文件的调整,新增代码 10997 行,删除代码 6838 行。更新内容主要集中在模型支持、引擎能力、工具定义与解析、以及底层推理和运行时优化等方面。

一、新模型支持:FunctionGemma 接入

在 v0.13.5 中,ollama 正式引入了 Google 的 FunctionGemma 模型,并完成了对应的解析器和渲染器支持。这一更新使 FunctionGemma 能够在 ollama 生态中以原生方式运行,并正确处理函数声明、函数调用和函数响应等结构化内容。

同时,SentencePiece 分词解析逻辑也进行了扩展,新增了对多种函数相关控制符号的识别,包括函数声明、函数调用、函数返回以及转义标记等。这保证了 FunctionGemma 在使用 spm 分词器时能够正确区分普通 token 与控制 token。

二、BERT 架构模型全面切换至 Ollama 引擎

本次更新的一个重要变化是:BERT 架构模型开始统一使用 Ollama 自研引擎运行,而不再依赖旧的执行路径。

在架构判定与运行能力上完成了多项调整:

- 将 bert 明确列为需要 Ollama Engine 的架构类型

- 在特性判断中,bert 开始支持 flash attention

- nomic-bert 等相关模型也统一纳入新的引擎判定逻辑

这一变化为 BERT 及相关嵌入模型带来了更一致的执行方式,也为后续功能扩展提供了更稳定的基础。

三、DeepSeek-V3.1 内置渲染与工具解析能力

ollama v0.13.5 针对 DeepSeek-V3.1 增加了内置 renderer 和 tool parsing 能力,使模型在输出结构化结果时可直接由引擎完成解析和渲染。

同时,补充并修复了工具定义中嵌套属性无法正确处理的问题,使 DeepSeek 系列模型在使用复杂工具参数结构时更加可靠。

此外,还新增并完善了 DeepSeekV3 家族的专用解析器逻辑,进一步提升了该系列模型在 ollama 中的可用性与一致性。

四、工具定义系统增强:支持嵌套属性

在 API 类型层面,本次更新扩展了 ToolProperty 结构,新增了对 properties 字段的支持,使工具参数能够表达任意层级的嵌套对象结构。

这一能力不仅支持简单对象嵌套,还支持深层多级嵌套,并通过新增的单元测试覆盖了以下场景:

- 对象属性的嵌套定义

- 多层对象中继续包含对象属性

- JSON 的反序列化与序列化回环校验

这使得 ollama 在函数调用和工具调用场景下,可以完整表达复杂参数定义,提升了与现代大模型工具调用规范的兼容性。

五、GGML 与底层推理逻辑更新

v0.13.5 更新了 GGML 版本引用,并同步调整了相关构建配置文件。Makefile 中的 GGML 上游提交指针发生变更,保证引擎使用最新的底层实现。

在 KV Cache 和因果掩码构建逻辑中,也进行了精简和修复:

- 移除了多余的 MaskBatchPadding 和 MaskDType 默认初始化逻辑

- 简化了掩码构建过程,仅按当前 batch 大小生成 mask

- 修复了 padding mask 计算中的冗余代码

这些调整有助于减少不必要的内存占用,并提升推理阶段的稳定性。

六、llama.cpp 集成与初始化流程整理

在 llama.cpp 对接代码中,本次版本对模型初始化、上下文创建和采样器初始化流程进行了较大幅度的整理:

- 引入了基于 impl 的封装结构来管理模型与上下文生命周期

- 清理了重复的返回路径和无效代码

- 修正了模型加载失败与上下文创建失败时的处理逻辑

- 优化了采样器初始化与 logit bias 注入流程

同时,在模型元信息解析中,采样参数读取逻辑被去重处理,避免重复判断配置标志,提高了代码可读性和一致性。

七、其他杂项与维护性改进

除核心功能外,v0.13.5 还包含一系列维护性更新,例如:

- 清理不再需要的冗余代码

- 调整类型定义,引入 ConfigV2 和 RootFS 相关类型

- 回滚 granite-embedding 相关变更

- 更新同步规则,补充 llama.cpp 中 mtmd 工具和模型源码的同步路径

结语

总体来看,ollama v0.13.5 是一次偏向基础能力增强与架构统一的版本更新。它在模型支持范围、工具系统表达能力以及底层执行稳定性方面都迈出了重要一步。对于使用 BERT、DeepSeek、FunctionGemma 等模型的用户而言,这一版本提供了更完善、更一致的运行体验,也为后续功能扩展奠定了坚实基础。