如果说以前做3D建模是在"雕刻",那么苹果刚刚发布的SHARP模型就是在"复印"。

在计算机视觉圈子里,从2D照片重建3D场景一直是个硬骨头。按照传统路数,你得拿着相机围着物体转几十圈,拍上百张照片,然后交给算法跑上几个小时,才能算出一个像样的模型。这个过程不仅累人,而且对算力要求极高。

但就在最近,苹果发布并开源了SHARP模型,直接把这个规则推倒重来。

这个项目的全称是Sharp Monocular View Synthesis。名字听着挺学术,但核心逻辑非常暴力美学:给它一张普通的2D照片,不到一秒钟,它就能吐出一个带有真实物理尺度的3D场景。

这不是科幻片,代码已经在GitHub上躺着了。

为什么它能快三个数量级?

SHARP之所以能把原本几十分钟的工作压缩到一秒内,是因为它换了一条赛道。

传统方法(比如原本的3D高斯泼溅或NeRF)是在"做题"。面对一组照片,算法需要反复迭代、优化,一点点推算出物体在空间中的位置,这叫"优化"。

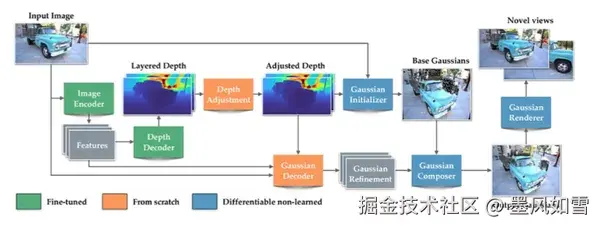

而SHARP是在"猜题"。苹果让神经网络在海量合成数据和真实数据中"阅卷"无数,让AI掌握了通用的深度和几何规律。当它看到一张新照片时,不需要从头计算,而是凭"直觉"直接预测出数百万个3D高斯球的位置、颜色和形状。

从"死算"变成"预测",这就是SHARP实现速度飞跃的根本原因。根据苹果的数据,在标准GPU上,它的处理时间被压缩到了1秒以内,相比传统方案,速度提升了整整三个数量级(约1000倍)。

质量没缩水,反而更强了

通常我们认为"快工出细活"是个伪命题,但在AI领域往往相反。

SHARP并没有因为追求速度而牺牲画质。在LPIPS(感知相似度)和DISTS(纹理相似度)这两个关键指标上,SHARP相比之前的最佳模型,误差分别降低了25%-34%和21%-43%。

换成人话就是:它生成的3D场景,纹理更清晰,结构更合理,不像以前那些快速生成的模型那样有一种"融化"的塑料感。最关键的是,它生成的场景具备真实的物理尺度。这意味着,如果你把这套技术放到VR眼镜里,当你在虚拟场景中移动一步,视觉上的反馈和真实世界移动一步是一致的。

别急,它也有做不到的事

吹完技术,必须得聊聊它的边界。SHARP虽然强,但不是魔法。

它的核心能力是"单目视图合成"。简单说,它最擅长的是让你在那张2D照片的拍摄视角附近,进行小幅度的移动观察,产生逼真的3D视差效果。

由于它只看过物体的一面,它无法凭空变出物体背后的样子。如果你试图绕到物体背面,或者看那些照片里完全被遮挡的死角,模型是无能为力的。它不会像某些生成式AI那样瞎编一个背面给你,它主要保证的是"可视范围内"的绝对真实和立体感。

所以,别指望用一张照片就能立刻3D打印出一个完美的手办,但如果你是想在屏幕上或者VR里获得身临其境的立体观感,它完全够用了。

苹果的阳谋

苹果这次不仅发了论文,还罕见地在GitHub和Hugging Face上开源了完整代码和预训练模型。

这个动作背后的意图很明显。Vision Pro需要内容,而现有的3D内容制作成本太高了。通过开源SHARP,苹果实际上是把一把低门槛的"3D铲子"递给了全球的开发者。

想象一下,未来的电商App,你随手拍张鞋子的照片,瞬间就能在手机上左右晃动查看立体细节;或者在游戏开发中,美术师拍张风景照就能直接生成游戏场景的底座。

SHARP把3D重建的门槛从"摄影棚级"降到了"手机抓拍级"。对于整个空间计算行业来说,这可能才是最值得兴奋的信号。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站