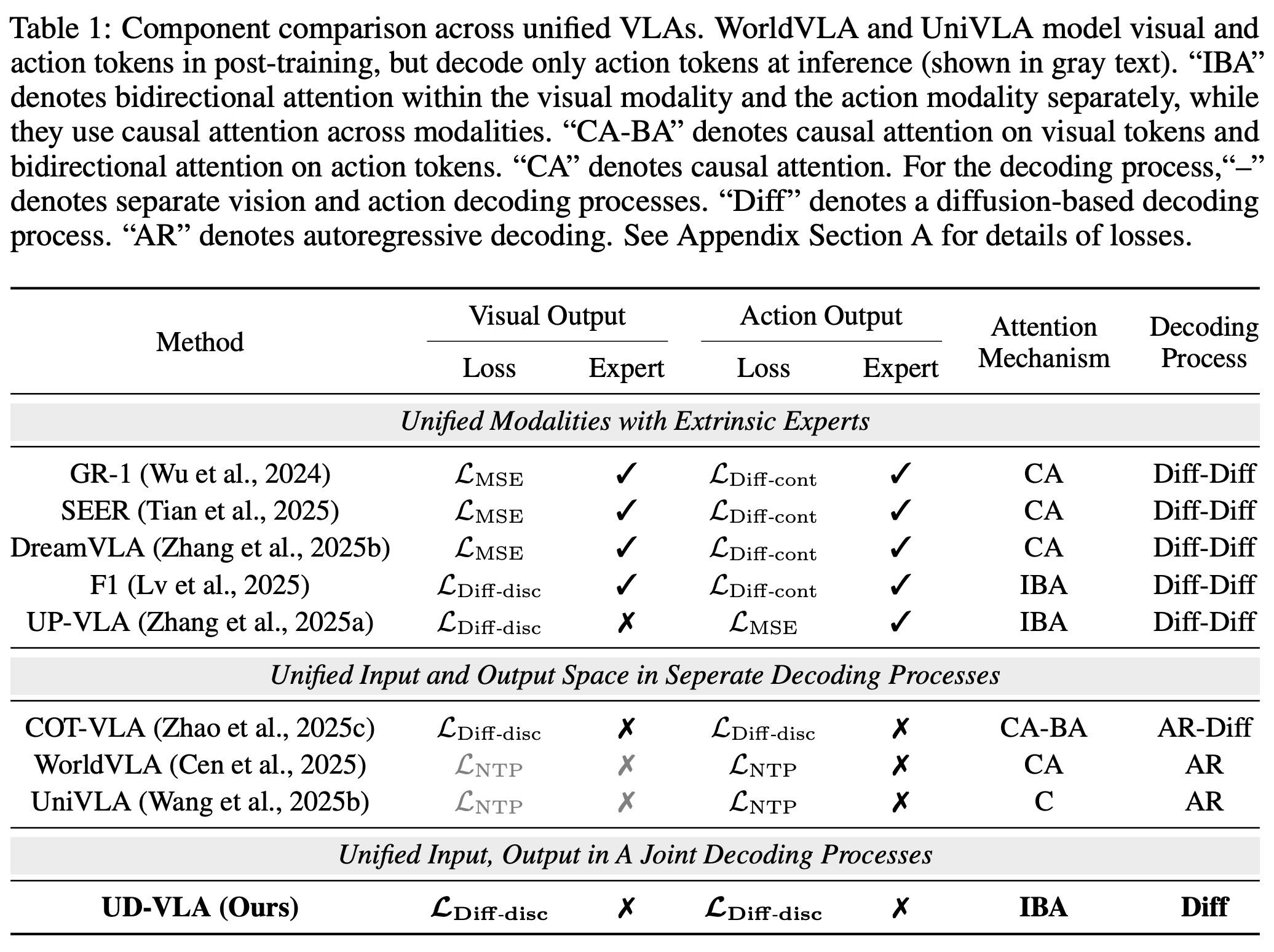

Diffusion Large Language Model (DLLM)是大模型圈近期最火的topic之一,对于VLA来说,我们的motivation是充分利用dllm在生成理解一体化方面天然的优势,将未来帧生成和动作预测统一在一个框架内。

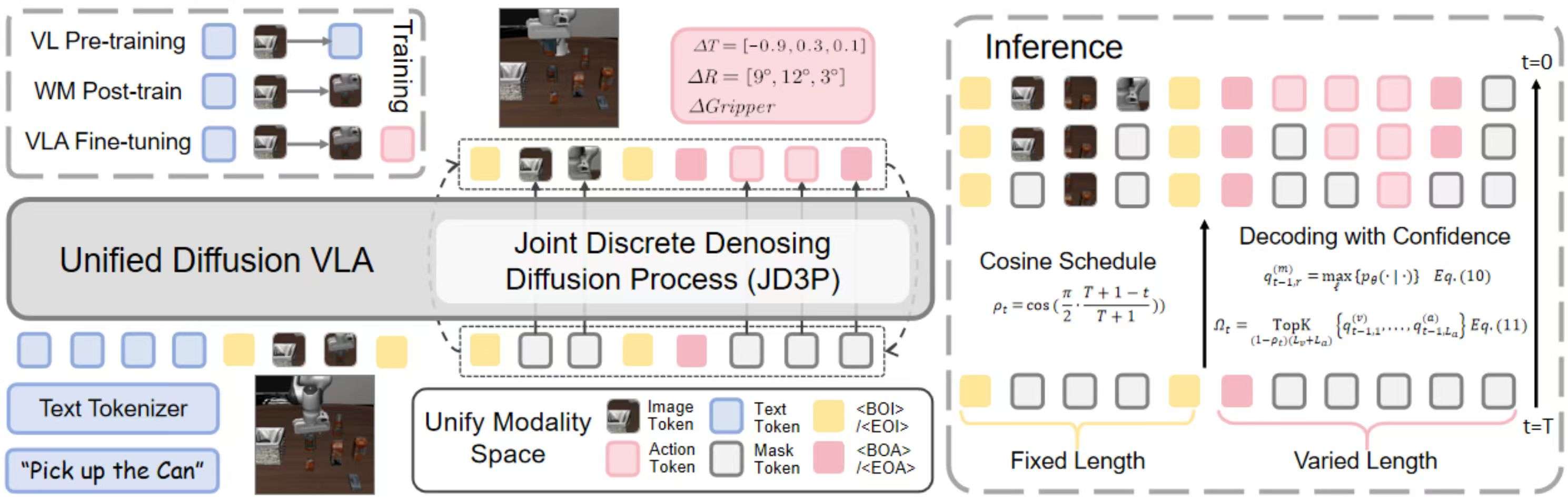

对于生成理解一体化的Unified VLA模型,我们关注的核心问题是如何实现图像生成和动作预测的相互裨益,针对这个问题我们提出了联合离散去噪过程Joint Discrete Denoising Diffusion Process (JD3P),即我们将不同模态的去噪过程统一在同一个去噪轨迹中,通过hybrid attention让动作在去噪过程内持续受益于图像的去噪过程。为了在推理阶段充分发挥dllm的优势,我们设计了前缀KV Cache和基于置信度的decoding机制,在提升推理速度的同时保证动作质量。最后,作为第一个全面开源的Diffusion VLA在达到SOTA-level性能的同时相比自回归模型实现了四倍的加速,我们在主流benchmark (CALVIN, LIBERO, SIMPLER) 上进行了全面的评测提供了完整的训练、测试代码以及模型权重。

UD-VLA架构

1) Unified Tokenization

我们把 text / image / action 用emu3 tokenzier/VQ tokenizer/FAST tokenizer离散化为 tokens,并拼成一条单一多模态序列。并用特殊token/``and``/标记不同模态

序列结构:

text tokens ; current image tokens ; future image tokens ; action tokens

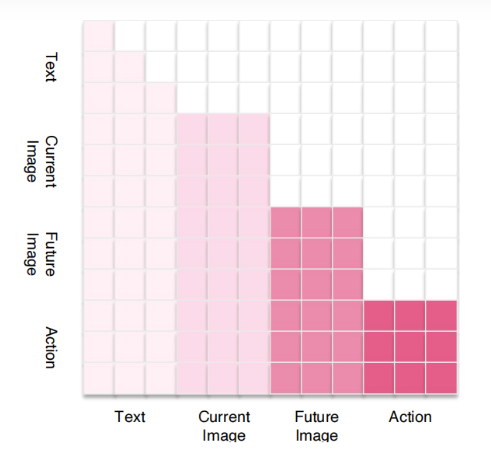

2) Hybrid Attention Mechanism

我们保持不同模态之间和文本模态内因果,视觉模态以及动作模态内保持双向。这样做的目的是让动作在去噪过程内持续受益于图像的去噪过程

3)Joint Discrete Denoising Diffusion Process (JD3P)

动作与图像在同一个去噪步骤中并行生成 。设未来图像 token 为 v 0 \mathbf{v}_0 v0,动作 token 为 a 0 \mathbf{a}_0 a0,其联合序列为:

$$

\mathbf{v}_0,\ \mathbf{a}_0

\bigl(v_{0,1},\dots,v_{0,L_v},\ a_{0,1},\dots,a_{0,L_a}\bigr).

我们加入一个掩码 token M \\mathrm{M} M。在步骤 t t t 的加噪转移为: ##

\mathbf{Q}t,\mathbf{e}{t,r}

(1-\beta_t),\mathbf{e}{t,r}

+

\beta_t,\mathbf{e} {\mathrm{M}}.

去噪过程可分解为:

p θ ( v t − 1 , a t − 1 ∣ v t , a t , c ) = p θ ( v t − 1 ∣ v t , c ) p θ ( a t − 1 ∣ v t , a t , c ) . p_\\theta(\\mathbf{v}_{t-1},\\mathbf{a}_{t-1}\\mid \\mathbf{v}_t,\\mathbf{a}_t,\\mathbf{c}) \\;=\\; p_\\theta(\\mathbf{v}_{t-1}\\mid \\mathbf{v}_t,\\mathbf{c})\\; p_\\theta(\\mathbf{a}_{t-1}\\mid \\mathbf{v}_t,\\mathbf{a}_t,\\mathbf{c}). pθ(vt−1,at−1∣vt,at,c)=pθ(vt−1∣vt,c)pθ(at−1∣vt,at,c).

我们采用 **单步掩码预测** 目标,仅对 **被掩码的位置** 计算交叉熵:

L CE ( θ ) = − β ∑ j L v log p θ ( v ) ( v 0 , j ∣ v t , c ) 1 { v t , j = M } − ∑ i L a log p θ ( a ) ( a 0 , i ∣ v t , a t , c ) 1 { a t , i = M } . \\mathcal{L}_{\\text{CE}}(\\theta) = - \\beta \\sum_{j}\^{L_v} \\log p_\\theta\^{(v)}\\!\\big(v_{0,j}\\mid \\mathbf{v}_t,\\mathbf{c}\\big)\\, \\mathbf{1}\\{v_{t,j}=\\mathrm{M}\\} \\;-\\; \\sum_{i}\^{L_a} \\log p_\\theta\^{(a)}\\!\\big(a_{0,i}\\mid \\mathbf{v}_t,\\mathbf{a}_t,\\mathbf{c}\\big)\\, \\mathbf{1}\\{a_{t,i}=\\mathrm{M}\\}. LCE(θ)=−βj∑Lvlogpθ(v)(v0,j∣vt,c)1{vt,j=M}−i∑Lalogpθ(a)(a0,i∣vt,at,c)1{at,i=M}.

#### 4) 训练 (Training)

1. **阶段 (i).** 在大规模视频数据集上进行后训练,注入未来图像生成能力。

\[ text tokens ; current image tokens ; future image tokens \] . \[\\;\\text{text tokens}\\;;\\;\\text{current image tokens}\\;;\\;\\text{future image tokens}\\;\]. \[text tokens;current image tokens;future image tokens\].

2. **阶段 (ii).** 共同优化图像和动作生成;将自回归解码重构为扩散过程(JD3P),通过移位操作预测下一个 token。

\[ text tokens ; current tokens ; future image tokens action tokens \] . \[\\;\\text{text tokens}\\;;\\;\\text{current tokens}\\;;\\;\\text{future image tokens}\\;\\text{action tokens}\]. \[text tokens;current tokens;future image tokensaction tokens\].

### 推理 (Inference)

**并行解码与自适应掩码**

初始化 v T \\mathbf{v}_T vT 和 a T \\mathbf{a}_T aT 的所有位置为 `