2025年的年底,本以为AI圈的大战会随着节日季的到来暂时偃旗息鼓,没想到智谱AI在这个节点扔下了一枚重磅炸弹。

就在12月23日,他们正式发布并开源了GLM-4.7。这不仅仅是一次常规的版本号迭代,更像是一次针对开发者痛点的精准爆破。如果你还在为开源模型写不出能跑的代码而头疼,或者还在心疼闭源API高昂的账单,那么GLM-4.7可能正是你在等的那个破局者。

这不是参数堆砌,是实打实的"智力"升级

先说最直观的感受。过去我们用开源模型写代码,往往是"一看顿悟,一跑报错"。但这次GLM-4.7在编程能力的提升上有点吓人。

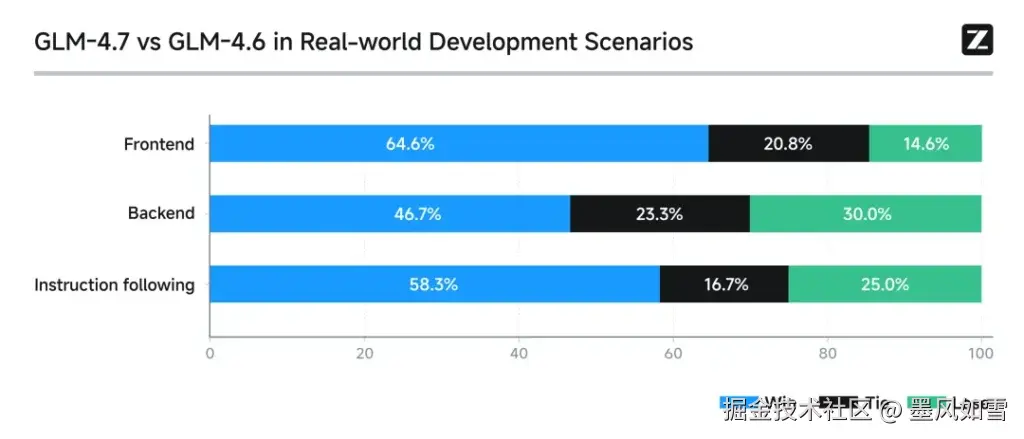

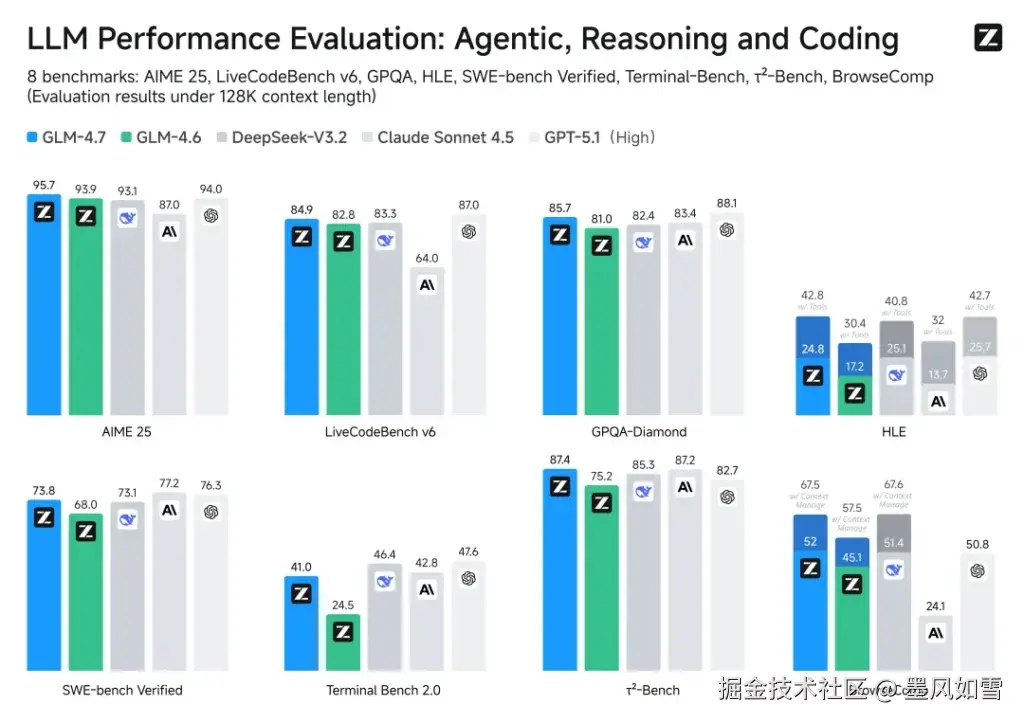

看看硬指标。在目前公认最难啃的SWE-bench Verified榜单上,GLM-4.7拿下了73.8%的成绩。这是什么概念?这是目前开源模型的最高纪录(SOTA),比上一代GLM-4.6提升了整整5.8个百分点。

更更有意思的是LiveCodeBench v6这个榜单,它考察的是模型面对最新编程难题的反应。GLM-4.7跑出了84.9%的分数。在这个维度上,它甚至把闭源的优等生Claude Sonnet 4.5甩在了身后。这意味着,在处理那些教科书里找不到答案的新鲜代码问题时,这个开源模型可能比你花钱买的服务还要灵光。

它学会了像资深工程师那样"思考"

为什么这次提升这么大?扒开技术白皮书,你会发现智谱这次没在堆算力上死磕,而是在"思考机制"上动了脑筋。

GLM-4.7引入了一套很像人类工程师的思维模式。

首先是"交错式思考"。以前的模型是闷头干活,现在的GLM-4.7在调用工具或者敲代码之前,会先停下来琢磨一下逻辑,每拿到一个中间结果,还会再次校准方向。这种走一步看一步的稳健策略,直接治好了模型容易"一条道走到黑"的毛病。

其次是"保留式思考"。这简直是为长对话量身定制的。当你和模型进行多轮Debug时,它不会像金鱼一样只有七秒记忆。它会自动把之前的推理过程打包缓存起来。这不仅让对话更连贯,还能帮你省下大量的Token费用,毕竟不用每次都从头盘逻辑了。

还有一个很人性化的"轮级思考"开关。处理简单问题时,关掉深度思考,秒回;遇到复杂架构设计,开启深度模式,虽然慢点但质量高。这种把控制权交给用户的设计,确实很懂行。

从后端到前端,审美终于在线了

除了写逻辑代码,GLM-4.7在"面子工程"上也下了功夫。

很多后端出身的开发者应该都有过被模型生成的"直男审美"HTML丑哭的经历。这次GLM-4.7生成的UI代码,据测试已经非常有现代感了,组件层级清晰,配色合理。甚至在生成PPT这种视觉物料时,它对16:9宽屏的适配率从以前勉强及格的52%直接飙升到了91%。

官方甚至演示了它从零开始手搓一个《植物大战僵尸》风格的网页游戏,或者1:1复刻iOS主界面。这说明它不仅懂代码,还懂产品,具备了从需求理解到完整交付的端到端能力。

开源,才是最大的诚意

在这个闭源模型越来越封闭的2025年,智谱选择把这样一个358B参数量(MoE架构)的旗舰模型直接开源,确实需要魄力。

目前,权重已经在Hugging Face和ModelScope上架了。如果你不想自己部署,官方API的价格也杀到了地板价,甚至推出了针对开发者的Coding Plan。

总的来说,GLM-4.7给国产大模型在2025年画上了一个极其漂亮的句号。它证明了在代码智能体和复杂逻辑推理这些硬核领域,开源模型不仅能追平闭源巨头,甚至在某些局部战场已经实现了反超。

对于咱们开发者来说,不需要关心那些宏大的商业叙事,只需要知道:手里又多了一把免费且锋利的瑞士军刀。趁着热乎,赶紧去GitHub上拉下来试试吧。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站