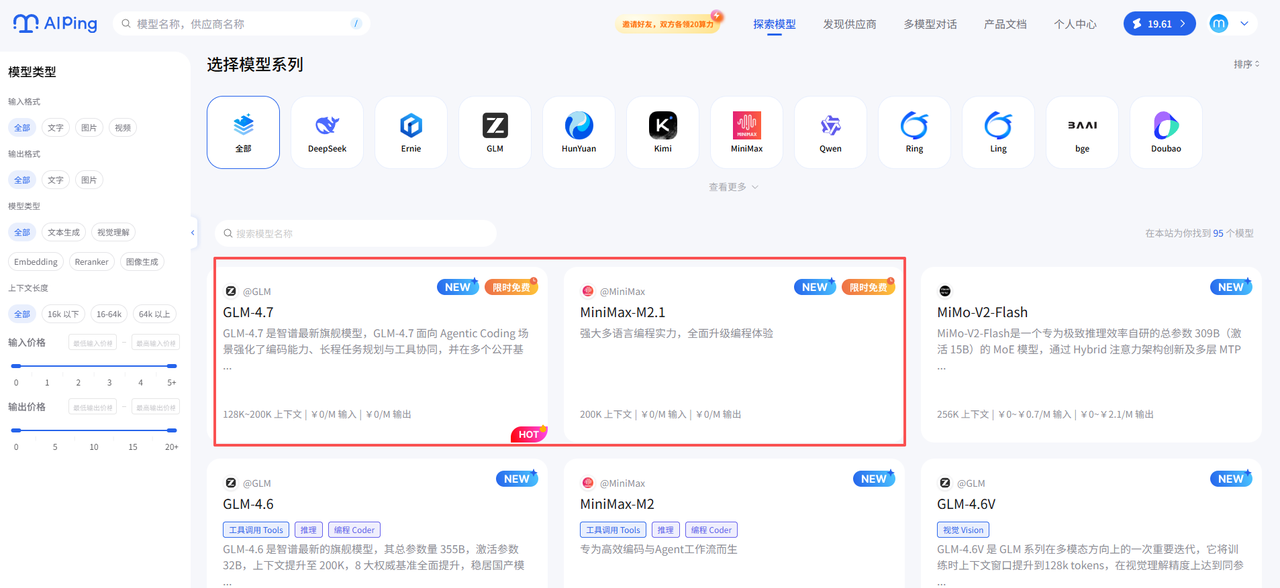

在人工智能从"演示"走向"部署"的关键阶段,开发者亟需的不再是炫技式的单轮对话能力,而是能够在复杂系统中长期稳定运行、高效协同工具、精准完成工程任务的大模型。为此,AI Ping 平台近期正式上线对 GLM-4.7 与 MiniMax M2.1 两款国产旗舰模型的全面支持,并推出限时免费调用活动,助力开发者零成本验证模型在真实业务中的表现。

体验入口:https://aiping.cn/#?channel_partner_code=GQCOZLGJ(注册登录立享30元算力金)

本文将围绕 AI Ping 平台的核心能力,结合两款限免模型的技术特点与调用方式,系统介绍如何借助这一基础设施,高效推进编码自动化、Agent 工作流构建等前沿应用场景。

一、AI Ping:面向生产级 AI 应用的统一调度平台

AI Ping 并非又一个大模型 API 聚合站,而是一个以工程可用性为核心目标的智能调度平台。它通过三大机制解决当前模型落地中的核心痛点:

性能数据透明化

平台每日自动采集并更新各供应商在真实负载下的性能指标,包括:

- 吞吐量(tokens/s)

- 延迟(P90)

- 上下文长度支持

- 输入/输出价格(¥/M tokens)

- 服务可靠性(成功率)

这些数据均基于实际请求日志统计,而非厂商理论值,确保用户决策有据可依。

多供应商统一接口

无论底层调用的是智谱、MiniMax、七牛云还是 PPIO,开发者只需对接一套 OpenAI 兼容的 API 接口。这意味着:

- 无需为每个供应商单独维护 SDK;

- 可在代码中动态切换模型或供应商;

- 支持按性能策略(如最低延迟、最高吞吐)自动选路。

智能路由保障稳定性

在高并发或网络波动场景下,AI Ping 会实时监测各节点状态,自动将流量导向当前最优供应商,避免因单点故障导致服务中断。这种"无感切换"机制极大提升了生产环境的鲁棒性。

正是这些设计,使 AI Ping 成为连接前沿大模型与工业级应用之间的可靠桥梁。

二、GLM-4.7:面向 Agentic Coding 的工程交付专家

GLM-4.7 是智谱 AI 推出的最新一代大语言模型,其核心定位并非通用聊天,而是复杂工程任务的一次性高质量交付。该模型在多个维度进行了针对性优化:

核心能力亮点:

- 强化工具协同:在调用外部 API、数据库或执行代码时,指令遵循更严格,减少幻觉。

- 可控推理机制:支持显式规划步骤(如生成 To-do List),提升多步任务的逻辑连贯性。

- Artifacts 输出优化:生成的前端界面、配置文件等结构化内容更具可用性与美观度。

- 长程任务规划:在涉及数十步操作的 Agent 场景中,能有效维持上下文一致性。

适用场景:

- 自动生成可运行的后端服务(含 Dockerfile、API 路由、错误处理)

- 复杂数据处理流水线设计

- 系统运维脚本编写与调试

- 需要高准确率的工程文档生成

在 AI Ping 平台上,GLM-4.7 已接入智谱官方、PPIO、七牛云、无问芯穹四家供应商,实测吞吐量最高达 50.47 tokens/s ,上下文支持 200K tokens,且全部免费开放。

三、MiniMax M2.1:高效 MoE 架构驱动的多语言编程引擎

如果说 GLM-4.7 侧重"任务完成质量",那么 MiniMax M2.1 则更关注"持续运行效率"。该模型基于稀疏激活的 MoE(Mixture of Experts)架构,在保持高性能的同时显著降低计算开销。

技术优势:

- 多语言深度优化:除 Python 外,对 Rust、Go、Java、C++ 等系统级语言的语法理解与生成能力大幅提升。

- 低激活参数比:仅激活部分专家网络,实现高吞吐与低延迟的平衡。

- 长上下文高效处理 :在 200K 上下文下仍保持 99.75 tokens/s 的吞吐(七牛云实测),远超同类模型。

- 收敛推理路径:减少冗余思考,在连续编码或循环 Agent 任务中表现更稳定。

典型用途:

- 微服务架构的跨语言重构

- 高性能计算模块的自动生成

- CI/CD 流水线中的自动修复与测试生成

- 长期运行的自主 Agent(如监控机器人、数据爬虫)

目前,MiniMax M2.1 在 AI Ping 上已由 MiniMax 官方与七牛云提供服务,延迟低至 0.54 秒(P90),可靠性达 100%,同样限时免费。

四、快速上手:通过 AI Ping 调用两款限免模型

AI Ping 兼容 OpenAI API 协议,开发者可直接使用 openai Python 包进行调用。以下为两个标准示例:

调用 GLM-4.7(指定供应商策略可选)

from openai import OpenAI

client = OpenAI(

base_url="https://aiping.cn/api/v1",

api_key="YOUR_API_KEY" # 替换为你的实际 API Key

)

response = client.chat.completions.create(

model="GLM-4.7",

stream=True,

messages=[{"role": "user", "content": "写一个用 FastAPI 实现的用户注册接口,包含邮箱验证"}]

)

for chunk in response:

if chunk.choices and (content := chunk.choices[0].delta.content):

print(content, end="", flush=True)调用 MiniMax M2.1(支持多语言生成)

from openai import OpenAI

client = OpenAI(

base_url="https://aiping.cn/api/v1",

api_key="YOUR_API_KEY"

)

response = client.chat.completions.create(

model="MiniMax-M2.1",

stream=True,

messages=[{"role": "user", "content": "用 Go 写一个并发安全的 LRU 缓存,支持 Get 和 Put"}]

)

for chunk in response:

if chunk.choices and (content := chunk.choices[0].delta.content):

print(content, end="", flush=True)五、结语:从"能用"到"好用",AI 正在进入工程时代

GLM-4.7 与 MiniMax M2.1 的出现,标志着国产大模型正从"通用能力竞赛"转向"垂直场景深耕"。而 AI Ping 的价值,正在于将这些前沿能力转化为可测量、可比较、可集成的工程资源。

在限时免费期间,开发者不妨登录 AI Ping,亲自测试两款模型在真实任务中的表现------无论是生成一段高并发 Go 服务,还是规划一个多步骤的自动化运维流程,你都将感受到:AI 不再是玩具,而是真正的生产力工具。

现在行动,让探索成本趋近于零。未来已来,只待你动手验证。