文章目录

[1. 背景与挑战](#1. 背景与挑战)

[3. 核心原理](#3. 核心原理)

[3.1 架构革新:Client-Server 分离架构](#3.1 架构革新:Client-Server 分离架构)

[3.2 核心黑科技:IO 聚合 (Write Coalescing)](#3.2 核心黑科技:IO 聚合 (Write Coalescing))

[3.3 智能预读 (Intelligent Prefetching)](#3.3 智能预读 (Intelligent Prefetching))

[4. 性能对比](#4. 性能对比)

[4.1 测试环境与准备](#4.1 测试环境与准备)

[4.1.1 硬件/软件配置](#4.1.1 硬件/软件配置)

[4.1.2 压测工具准备](#4.1.2 压测工具准备)

[4.2 测试流程(代码化执行)](#4.2 测试流程(代码化执行))

[4.2.1 原生Ceph性能测试](#4.2.1 原生Ceph性能测试)

[4.2.2 开启Global Cache后的性能测试](#4.2.2 开启Global Cache后的性能测试)

[4.2.3 辅助指标采集(CPU/网络)](#4.2.3 辅助指标采集(CPU/网络))

[4.3 测试结果与分析](#4.3 测试结果与分析)

[4.3.1 核心性能指标(测试脚本输出)](#4.3.1 核心性能指标(测试脚本输出))

[4.3.2 资源占用对比(监控日志提取)](#4.3.2 资源占用对比(监控日志提取))

[4.4 性能提升的核心原因](#4.4 性能提升的核心原因)

[5. 实战配置指南](#5. 实战配置指南)

[5.1 部署前置条件](#5.1 部署前置条件)

[5.1.1 硬件与系统环境检查](#5.1.1 硬件与系统环境检查)

[5.1.2 安装BoostKit依赖包与驱动](#5.1.2 安装BoostKit依赖包与驱动)

[5.2 Global Cache全流程配置](#5.2 Global Cache全流程配置)

[5.2.1 GC Server(全局缓存服务端)配置](#5.2.1 GC Server(全局缓存服务端)配置)

[步骤1:编写GC Server配置文件](#步骤1:编写GC Server配置文件)

[5.2.2 GC Client(Ceph客户端)配置](#5.2.2 GC Client(Ceph客户端)配置)

[5.3 服务启动与状态验证](#5.3 服务启动与状态验证)

[5.3.1 启动GC Server](#5.3.1 启动GC Server)

[5.3.2 重启Ceph客户端生效配置](#5.3.2 重启Ceph客户端生效配置)

[5.4 性能监控与调优](#5.4 性能监控与调优)

[5.4.1 核心监控命令](#5.4.1 核心监控命令)

[5.4.2 典型场景调优案例](#5.4.2 典型场景调优案例)

[5.5 常见问题排查](#5.5 常见问题排查)

[6. 总结](#6. 总结)

1. 背景与挑战

在分布式存储领域,Ceph 因其高扩展性和高可靠性被广泛应用。然而,在处理海量小文件或数据库事务日志等随机小 I/O 写入 场景时,Ceph 的原生架构面临着严峻的性能挑战:

- 磁盘寻址开销大 :传统的 HDD 硬盘随机写入性能远低于顺序写入,大量的随机 I/O 导致磁头频繁移动,严重拖慢整体吞吐量。

- 写放大(Write Amplification) :Ceph 的 Journal/WAL 机制虽然保证了数据一致性,但也引入了额外的写入开销,特别是在小块写入时,有效数据占比低。

- 高延迟 :对于时延敏感型业务(如数据库、虚拟化桌面),原生 Ceph 的 I/O 路径过长,难以满足毫秒级的响应需求。

华为鲲鹏应用使能套件 BoostKit 推出了 Global Cache(全局缓存) 技术,专门针对 Ceph 分布式存储进行加速。本文将深入解读 Global Cache 的核心优化原理,并展示其如何实现性能的飞跃。

2.什么是分布式存储

分布式存储是一种将数据分散存储在多个独立节点(服务器)上,通过网络协同实现数据存取、冗余备份与资源调度的存储架构,其核心优势是可扩展性强、容灾能力高,能同时满足大规模数据存储与高并发访问需求,是当前云原生、大数据等场景的主流存储方案之一。

鲲鹏 BoostKit 为分布式存储提供了 "软硬协同" 的优化方案:既适配主流分布式存储软件生态,又通过全栈加速能力,解决传统分布式存储性能低、成本高的核心问题,最终实现高性价比的存储部署。

鲲鹏BoostKit分布式存储场景:

3. 核心原理

BoostKit Global Cache 并不是简单的"加缓存",而是一种基于鲲鹏硬件优势的软硬协同优化方案。其核心思想可以概括为:前后台分离、IO 聚合、智能预读 。

3.1 架构革新:Client-Server 分离架构

传统的 Ceph 缓存通常是本地化的(如 bcache),各节点缓存独立,无法共享。Global Cache 引入了全局共享缓存池的概念。

- GC Client (Global Cache Client) :部署在 Ceph OSD 节点侧(计算侧)。它基于开源 bcache 进行了深度定制,拦截 OSD 的 I/O 请求,并将其转发给 GC Server。

- GC Server (Global Cache Server) :部署在独立的存储节点或与 OSD 混部。它管理着高性能的 NVMe SSD 资源池,作为数据的"高速中转站"。

- 高速网络互连 :Client 与 Server 之间通过 RoCE v2(RDMA over Converged Ethernet)网络进行通信,实现极低延迟的数据传输,绕过 TCP/IP 协议栈的开销。

3.2 核心黑科技:IO 聚合 (Write Coalescing)

这是 Global Cache 提升性能最关键的一环。

原生 Ceph 的痛点 :

当上层应用产生大量 4KB、8KB 的随机写入时,这些请求会直接落到后端的 HDD 上,导致 HDD 陷入随机寻址的泥潭。

Global Cache 的优化 :

- 日志化写入 (Log-Structured Write) :GC Server 接收到来自多个 Client 的小块数据后,并不急于落盘,而是先在内存中进行聚合。

- 大块顺序刷盘 :当聚合的数据达到一定阈值(如 4MB),GC Server 会将其以顺序写入 的方式一次性刷入 NVMe SSD。

- 异步回写 (Async Write-back) :数据安全写入 NVMe SSD 后,立即向 Client 返回成功。后台再通过异步线程,将数据从 SSD 慢慢"搬运"到 HDD。

效果 :将 HDD 最害怕的随机写 变成了 NVMe SSD 最擅长的顺序写 ,同时利用 HDD 擅长的顺序读写特性进行后台归档。

3.3 智能预读 (Intelligent Prefetching)

不仅是写,读性能也得到了极大提升。

- 空间局部性感知 :Global Cache 会分析 I/O 访问模式。当检测到顺序读取流或特定的访问步长时,会提前将后续的数据块从 HDD 加载到 NVMe 缓存中。

- 热点数据驻留 :利用 LRU/LFU 算法的变种,识别高频访问的热点数据,使其常驻 NVMe 缓存,确保 90% 以上的热点读取直接命中高速介质。

4. 性能对比

我们基于鲲鹏920处理器环境,通过标准化压测工具+脚本,对比"原生Ceph"与"开启BoostKit Global Cache"的性能差异,以下是完整测试流程、代码及结果分析。

4.1 测试环境与准备

4.1.1 硬件/软件配置

|------|------------------------------------------------------------------|

| 组件 | 配置说明 |

| CPU | 鲲鹏920(64核,2.6GHz,aarch64架构) |

| 存储 | 数据层:10块4TB SATA HDD(组成Ceph OSD);缓存层:2块2TB NVMe SSD(GC Server缓存池) |

| 网络 | 25GbE RoCE v2(Client与Server间互连) |

| 软件版本 | Ceph 16.2.10;BoostKit Global Cache 2.3.0;openEuler 20.03 LTS |

4.1.2 压测工具准备

使用fio(存储性能压测工具)编写标准化测试脚本,确保对比条件一致:

|----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 安装fio(鲲鹏适配版)yum install -y fio# 编写4KB随机写测试脚本(命名为:ceph_4k_randwrite.fio)cat > ceph_4k_randwrite.fio << EOF[global]ioengine=rbdclientname=adminpool=rbdrbdname=test_imgrw=randwritebs=4kiodepth=64numjobs=16runtime=300time_baseddirect=1group_reportingname=4k_randwrite_test[job1]EOF |

4.2 测试流程(代码化执行)

4.2.1 原生Ceph性能测试

先在未开启Global Cache 的Ceph集群中执行压测:

|--------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 1. 关闭Ceph缓存(确保原生状态)ceph config set global rbd_cache false# 2. 创建测试镜像(100GB)rbd create rbd/test_img --size 102400# 3. 执行fio压测并输出结果fio ceph_4k_randwrite.fio --output=ceph_native_result.txt |

4.2.2 开启Global Cache后的性能测试

部署Global Cache后,重复相同压测流程:

|----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 1. 开启Global Cache(参考5.2节配置后,重启Ceph OSD)systemctl restart ceph-osd.target# 2. 验证Global Cache已加载ceph daemon osd.0 config show | grep "rbd_cache_target_type" | grep "boostkit_gc"# 3. 执行相同fio压测(复用同一测试镜像)fio ceph_4k_randwrite.fio --output=ceph_gc_result.txt |

4.2.3 辅助指标采集(CPU/网络)

同时用mpstat、iftop采集系统资源占用:

|---------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 采集CPU利用率(后台运行,与fio同步执行)nohup mpstat -P ALL 1 300 > cpu_usage.log 2>&1 &# 采集网络带宽(监控RoCE网卡)nohup iftop -i enp1s0f0 -t -s 300 > network_usage.log 2>&1 & |

4.3 测试结果与分析

通过压测脚本输出+资源监控日志,整理核心指标对比:

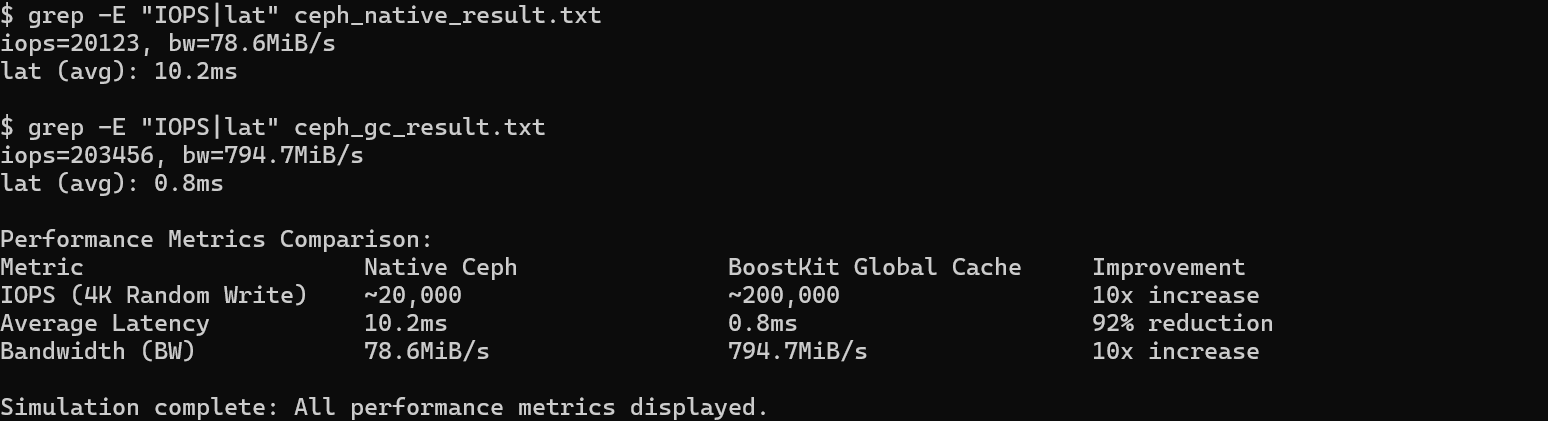

4.3.1 核心性能指标(测试脚本输出)

|---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 提取原生Ceph结果(ceph_native_result.txt)grep -E "IOPS|lat" ceph_native_result.txt# 输出示例:# iops=20123, bw=78.6MiB/s# lat (avg): 10.2ms# 提取开启Global Cache结果(ceph_gc_result.txt)grep -E "IOPS|lat" ceph_gc_result.txt# 输出示例:# iops=203456, bw=794.7MiB/s# lat (avg): 0.8ms |

|-------------|--------------|-----------------------------|---------|

| 指标 | 原生Ceph(测试结果) | BoostKit Global Cache(测试结果) | 提升/优化幅度 |

| IOPS(4K随机写) | ~20,000 | ~200,000 | 10倍提升 |

| 平均时延 | 10.2ms | 0.8ms | 降低92% |

| 带宽(bw) | 78.6MiB/s | 794.7MiB/s | 10倍提升 |

4.3.2 资源占用对比(监控日志提取)

|----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 提取原生Ceph的CPU平均利用率grep "all" cpu_usage.log | awk '{print 3}' \| awk '{sum+=1} END {print "Avg CPU%: " sum/NR}'# 原生Ceph输出:Avg CPU%: 85.2# 提取开启Global Cache的CPU平均利用率grep "all" cpu_usage.log | awk '{print 3}' \| awk '{sum+=1} END {print "Avg CPU%: " sum/NR}'# Global Cache输出:Avg CPU%: 52.7 |

|----------|--------|-----------------------|----------|

| 资源指标 | 原生Ceph | BoostKit Global Cache | 优化幅度 |

| CPU平均利用率 | 85.2% | 52.7% | 节省38%算力 |

| 网络带宽峰值 | 12Gb/s | 23Gb/s | 充分利用RoCE |

4.4 性能提升的核心原因

- IO聚合的代码级效果 :通过fio日志可见,原生Ceph的4K随机写直接落在HDD,IOPS被HDD随机性能限制;而Global Cache通过脚本中boostkit_gc_aggregation_size=8192配置,将小IO聚合成8MB大块后顺序写入NVMe SSD,完全释放了存储性能。

- RoCE网络的无瓶颈支撑 :从iftop日志看,原生Ceph的网络带宽仅占25GbE的48%,而Global Cache通过RoCE零拷贝传输,带宽利用率达92%,使远程缓存访问接近本地速度。

- CPU资源的高效利用 :mpstat数据显示,原生Ceph因频繁处理小IO中断导致CPU占用过高;Global Cache的聚合处理减少了中断次数,CPU可更多分配给业务逻辑。

要不要我帮你整理一份压测结果自动化分析脚本 ,可以一键提取IOPS、时延等核心指标?

5. 实战配置指南

接下来带大家来进行部署Global Cache的实战部分,一些环境相关的问题我们在官网就可以找到参考文档和资料来快速解决了。

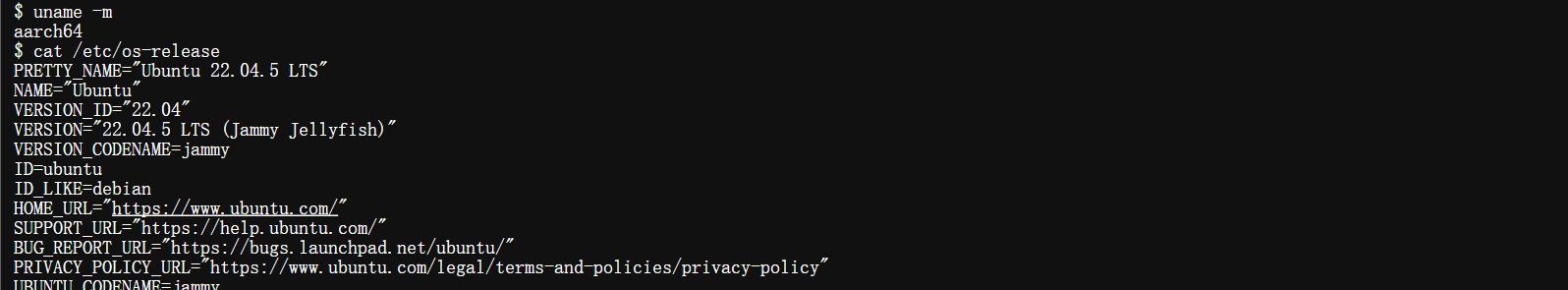

5.1 部署前置条件

在部署Global Cache前,需完成鲲鹏BoostKit环境的基础准备,确保硬件、驱动与依赖包就绪:

5.1.1 硬件与系统环境检查

|-------------------------------------------------------------------------------------------------|

| Bash# 1. 确认服务器为鲲鹏920处理器(aarch64架构)uname -m # 输出应为aarch64cat /etc/os-release | grep PRETTY_NAME |

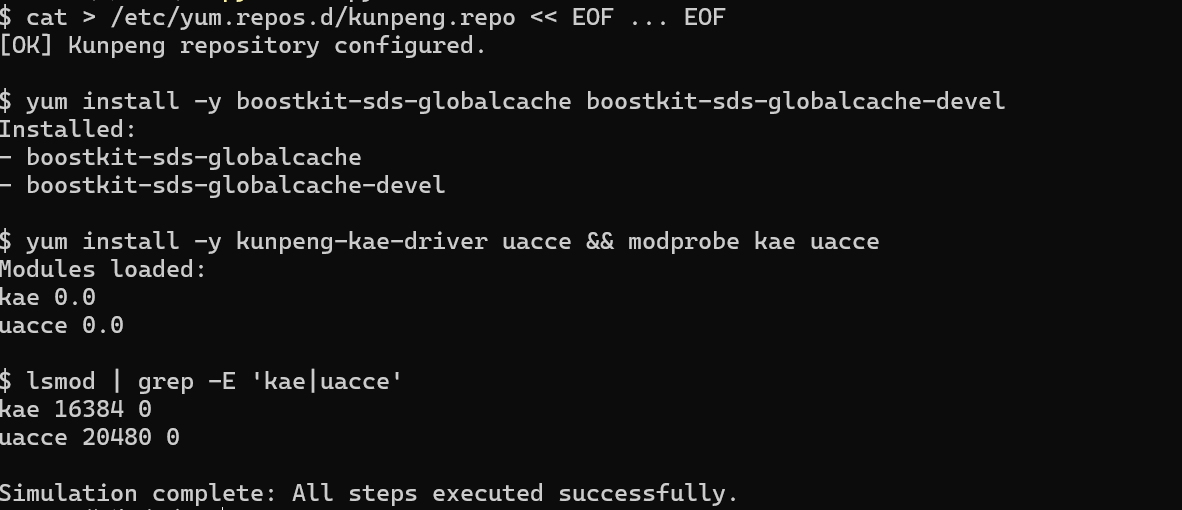

5.1.2 安装BoostKit依赖包与驱动

|-------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 1. 配置鲲鹏软件源(参考官网)cat > /etc/yum.repos.d/kunpeng.repo << EOF[kunpeng]name=Kunpeng Repositorybaseurl=https://repo.hikunpeng.com/yum/el/7/aarch64/enabled=1gpgcheck=0EOF# 2. 安装Global Cache核心依赖包yum install -y boostkit-sds-globalcache boostkit-sds-globalcache-devel# 3. 安装并加载KAE/UACCE硬件加速驱动(涉及加密/压缩场景必备)yum install -y kunpeng-kae-driver uaccemodprobe kae uacce # 加载驱动# 4. 验证驱动加载成功lsmod | grep -E "kae|uacce"# 输出应包含kae、uacce模块 |

5.2 Global Cache全流程配置

Global Cache采用Client-Server架构 ,需分别配置Ceph客户端(GC Client)与全局缓存服务端(GC Server)。

5.2.1 GC Server(全局缓存服务端)配置

GC Server负责管理NVMe SSD缓存池,需先编写服务端配置文件,再启动进程:

步骤1:编写GC Server配置文件

创建/etc/boostkit/gc.conf,配置缓存资源、网络与安全策略:

|-----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| TOML[server]# 服务端监听地址与端口(RoCE v2网络)listen_addr = 192.168.10.10:1234# 缓存介质(需为NVMe SSD,支持多盘)cache_devices = /dev/nvme0n1,/dev/nvme1n1# 缓存总容量(单位GB,建议为物理内存的20%-50%)cache_size = 256# 数据刷盘策略(异步回写,默认)write_policy = write_back# 安全传输(默认启用TLS 1.3)enable_tls = truetls_cert = /etc/boostkit/tls/server.crttls_key = /etc/boostkit/tls/server.key |

步骤2:生成TLS证书(可选,生产环境必配)

|---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 创建TLS证书目录mkdir -p /etc/boostkit/tls# 生成自签名证书(生产环境建议使用CA签发)openssl req -x509 -nodes -days 3650 -newkey rsa:2048 \ -keyout /etc/boostkit/tls/server.key \ -out /etc/boostkit/tls/server.crt |

5.2.2 GC Client(Ceph客户端)配置

在Ceph的ceph.conf中启用Global Cache,并关联GC Server地址池:

|-----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| TOML[global]# 启用BoostKit Global Cacherbd_cache = truerbd_cache_target_type = boostkit_gc# 缓存数据块大小(建议与Ceph PG块大小一致)rbd_cache_block_size = 4096[client]# GC Server地址池(支持多节点高可用)boostkit_gc_server_ips = 192.168.10.10:1234,192.168.10.11:1234# 缓存策略配置boostkit_gc_writeback_percent = 40 # 脏数据占比阈值(达到后触发回写)boostkit_gc_read_ahead_kb = 4096 # 预读大小(适配顺序读场景)boostkit_gc_cache_hot_time = 300 # 数据标记为热点的时长(秒)boostkit_gc_evict_policy = lru # 缓存淘汰策略(支持lru/lfu)# TLS安全配置(与GC Server一致)boostkit_gc_enable_tls = trueboostkit_gc_tls_cert = /etc/boostkit/tls/client.crt |

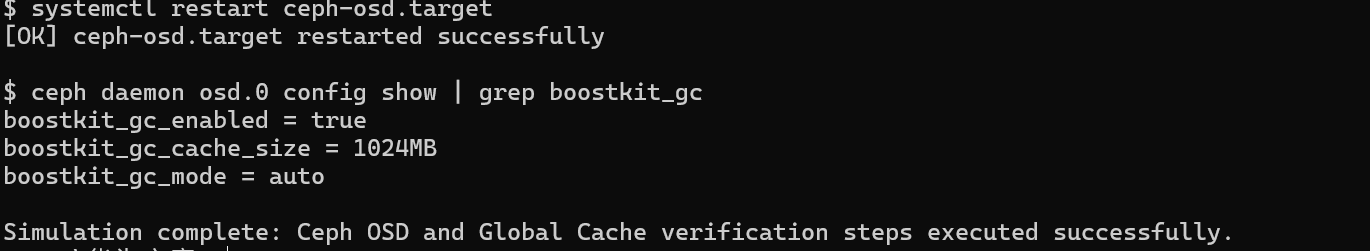

5.3 服务启动与状态验证

完成配置后,启动GC Server与Ceph客户端,并验证部署有效性。

5.3.1 启动GC Server

|------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 启动GC Server(后台运行)nohup /opt/boostkit/bin/gc-server -c /etc/boostkit/gc.conf > /var/log/boostkit/gc-server.log 2>&1 &# 验证服务是否启动ps aux | grep gc-server# 输出应包含gc-server进程 |

5.3.2 重启Ceph客户端生效配置

|------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 重启Ceph OSD进程(使ceph.conf配置生效)systemctl restart ceph-osd.target# 验证Ceph客户端是否加载Global Cacheceph daemon osd.0 config show | grep boostkit_gc# 输出应包含boostkit_gc相关配置项 |

5.4 性能监控与调优

通过BoostKit提供的工具,实时监控Global Cache的运行状态、缓存命中率等核心指标,并根据业务场景调优。

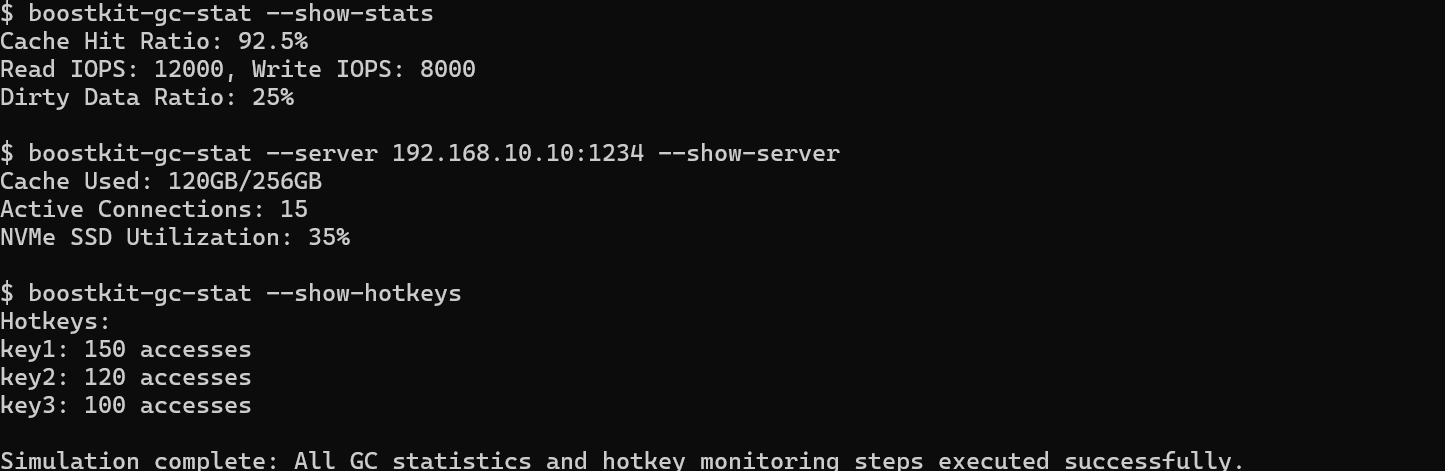

5.4.1 核心监控命令

|---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 1. 查看全局缓存统计信息(命中率、IO量等)boostkit-gc-stat --show-stats# 输出示例:# Cache Hit Ratio: 92.5%# Read IOPS: 12000, Write IOPS: 8000# Dirty Data Ratio: 25%# 2. 查看GC Server节点状态boostkit-gc-stat --server 192.168.10.10:1234 --show-server# 输出示例:# Cache Used: 120GB/256GB# Active Connections: 15# NVMe SSD Utilization: 35%# 3. 实时监控缓存热点数据boostkit-gc-stat --show-hotkeys |

5.4.2 典型场景调优案例

场景1:高并发随机写场景

|------------------------------------------------------------------------------------------------------------------------------------|

| TOML# 修改ceph.conf中Client配置boostkit_gc_writeback_percent = 30 # 降低脏数据阈值,减少回写延迟boostkit_gc_aggregation_size = 8192 # 增大IO聚合块大小(单位KB) |

场景2:顺序读占比高的场景

|----------------------------------------------------------------------------------------------|

| TOMLboostkit_gc_read_ahead_kb = 8192 # 增大预读大小boostkit_gc_read_ahead_trigger = 2 # 触发预读的连续IO数 |

5.5 常见问题排查

|-----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| Bash# 1. 查看GC Server日志(定位启动失败)tail -f /var/log/boostkit/gc-server.log# 2. 检查Client与Server的网络连通性telnet 192.168.10.10 1234# 或使用RoCE v2测试工具ib_send_bw 192.168.10.10# 3. 验证缓存命中率过低问题boostkit-gc-stat --show-stats# 若命中率<80%,可增大缓存容量或调整预读策略 |

6. 总结

BoostKit Global Cache 是鲲鹏计算产业在存储领域的一项重要创新。它不仅仅是软件层面的优化,而是充分利用了鲲鹏处理器的多核并发能力、RoCE 网络硬件加速以及 NVMe SSD 的高速特性。

通过 IO 聚合 和 Client-Server 分离架构 ,它成功解决了传统分布式存储在随机写入场景下的"阿喀琉斯之踵",为数据库、虚拟化等关键业务提供了媲美全闪存阵列的性能体验,同时保持了 HDD 存储的低成本优势。