做过AI绘画的朋友大概都有过这种抓狂时刻:光影完美、画质惊艳,但你想让猫在左边、狗在右边,AI偏偏给你画成它们抱在一起,或者干脆把猫画到了天上。

这种"构图靠抽卡"的玄学时代,可能要被小红书AI团队和复旦大学联手终结了。

就在最近,一项名为 InstanceAssemble 的技术被顶会 NeurIPS 2025 收录,并直接在 GitHub 上开源。简单来说,它给 AI 装上了一个精准的"空间导航仪",让文生图从"盲盒模式"进化到了"精准施工"阶段。

为什么现在的 AI 总是不听指挥?

目前的顶流模型,无论是 Stable Diffusion 还是 Flux,在处理"空间布局"时都有个通病:它们更擅长理解画面的整体氛围,却很难理解具体的空间指令。

当你输入"左边放个苹果,右边放个香蕉",AI 处理时往往是一股脑地把语义混合在一起。这就导致了业界著名的"语义泄漏"问题------比如把香蕉画成了红色,或者两个物体的位置完全错乱。一旦画面里的物体超过两三个,AI 基本就开始胡乱发挥了。

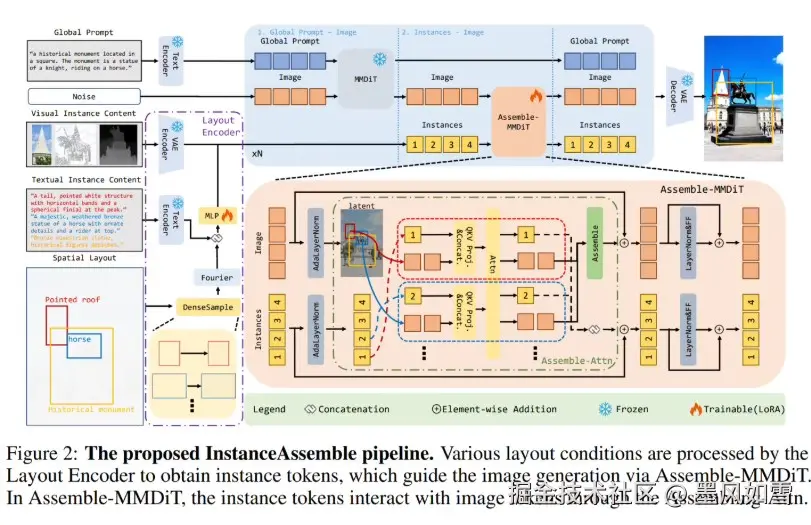

InstanceAssemble 的解题思路:分而治之

InstanceAssemble 的核心逻辑非常像是一个严谨的施工队。它抛弃了以往那种"大锅乱炖"的生成方式,引入了一种被称为 "实例组装注意力(Instance Assembly Attention)" 的新机制。

你可以把它理解为"分区分组管理":

- 全局控场:模型先通过基础架构生成画面的大背景和整体光影氛围。

- 定点组装:对于你指定的每一个物体(比如沙发、台灯、挂画),技术会锁定它们各自的坐标区域(Bounding Box)。

- 独立计算:最绝的一点在于,每个物体的注意力计算被严格限制在自己的"地盘"里。画沙发时,AI 绝不看旁边的台灯一眼。

这种机制完美解决了物体之间的干扰问题。哪怕是面对那种包含二三十个物体的超复杂室内设计图,它也能保证每个物体都在它该在的地方,长成它该有的样子。

惊人的"轻量化"数据

通常提到这种精细控制,大家的第一反应是:这得消耗多大的算力?模型得重训多久?

InstanceAssemble 给出的答案让人相当意外。它采用了 LoRA(低秩适配)方案,并不需要重新训练那个庞大的底模。

看看这组数据:

- 适配 Stable Diffusion 3-Medium :只需增加约 3.46% 的参数量。

- 适配最新的 Flux.1 :额外参数量甚至低至 0.84%。

这意味着,你不需要为了这就换一张4090显卡,也不需要下载几百个G的新模型,仅仅通过外挂一个极轻量的模块,就能让当红炸子鸡 Flux 拥有顶级的布局控制能力。

实战效果如何?

为了验证这东西到底行不行,团队甚至专门搞了个高难度的测试集 DenseLayout,里面塞满了密密麻麻的物体布局。

测试结果显示,在处理包含10个以上物体的"地狱级"构图时,现有的大部分主流方法(如 ControlNet 或 GLIGEN)性能都会出现断崖式下跌,只有 InstanceAssemble 依然稳得住。它的布局对齐准确率比现有基线方法提升了整整一截。

更具实用价值的是,由于它训练时并没有见过那么密集的布局,但测试时却能完美泛化。也就是说,你哪怕给它一个从未见过的复杂广告排版,它也能依样画葫芦地生成出来。

写在最后

InstanceAssemble 的出现,对于设计行业来说是个极大的利好。

以前设计师用 AI 做海报,最头疼的就是没法控制产品图的位置,往往需要生成几百张图再后期 PS 合成。现在,你只需要画好几个框,告诉 AI 这里放香水、那里放花瓣,一张符合排版规范的高质量商业图就出来了。

目前,该项目的代码和预训练模型已经全部在 GitHub 上开源。对于想要在广告设计、游戏美术或者电商素材生成领域应用 AI 的开发者和创作者来说,这绝对是一个值得立刻上手尝试的工具。

AI 绘画,正在从"玩具"向"工具"迈出坚实的一步。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站