Producer客户端工作机制与优化

核心机制

1 ) 异步发送模型

-

创建Producer时自动启动守护进程(常驻轮询线程),负责批量推送消息至Kafka集群

-

send()方法仅将消息追加到内存队列(RecordAccumulator),非实时发送 -

守护进程在满足以下条件时触发批量发送:

bash# 触发条件配置示例(NestJS) batch.size=16384 # 批次大小阈值(字节) linger.ms=5 # 最大等待时间(毫秒)

Kafka Producer 的 send() 方法并非直接将数据发送至服务端。创建 Producer 实例时,会启动后台守护线程(Sender Thread)持续轮询消息队列

调用 send() 时,数据被追加至RecordAccumulator 缓冲区,Sender Thread 在满足以下任一条件时批量推送:

- 批次大小达到

batch.size(默认 16KB) - 等待时间超过

linger.ms(默认 0ms) - 缓冲区满(由

buffer.memory控制,默认 32MB)

关键流程:

满足条件 Producer.send 序列化 Serialization 分区器 Partitioner RecordAccumulator 批次存储 Sender Thread 轮询 批量发送至 Broker 获取 Future 响应 触发 Callback/Get 结果

2 )消息处理流程

Producer.send 序列化消息 分区器路由 按分区存入批次 守护线程批量发送 Broker响应处理 回调onCompletion/Future.get

-

分区器选择:默认轮询(RoundRobin)或自定义策略(如按Key哈希)

-

线程模型:

- 主线程:执行

send()并追加消息至缓冲区 - Sender Thread:守护线程,负责批量发送与响应处理

- Callback Thread:可选线程池,处理异步回调(通过

onCompletion())

- 主线程:执行

-

工程实践建议:

- 通过

max.in.flight.requests.per.connection=1确保单分区有序 - 监控指标:

record-queue-time-avg(队列延迟)、record-error-rate(错误率)

- 通过

关键流程

- 消息提交:应用程序调用

send(record)提交消息记录。 - 序列化与分区:

- 消息经序列化器(如

StringSerializer)处理 - 通过分区器(Partitioner) 计算目标分区(默认

RoundRobinPartitioner或自定义逻辑)

- 消息经序列化器(如

- 批次聚合:消息按分区聚合为

RecordBatch(发送最小单位),存储在缓冲区(RecordAccumulator)。 - 异步发送:Sender 线程将批次通过

Selector组件批量发送至 Broker。 - 响应处理:

- 通过

Future<RecordMetadata>同步获取发送结果 - 或注册

Callback实现异步回调(onCompletion())

- 通过

线程模型:

- 主线程:执行

send()及业务逻辑 - Sender 线程:

- 独立守护线程,负责消息批量发送与重试

- 通过

Metadata对象维护集群元数据

- Callback 线程池:处理异步回调(默认单线程)

性能要点:缓冲区大小(buffer.memory)、批次阈值(batch.size)、等待时间(linger.ms)共同决定发送效率。

Kafka 消息有序性保障方案

核心约束:Kafka 仅保证分区内有序,跨分区无法保证全局顺序

Kafka原生支持

- 单分区有序:同一分区内消息按Offset严格顺序存储

- 全局无序:不同分区间顺序无法保证

实现方案对比:

| 方案 | 原理 | 缺点 | 适用场景 |

|---|---|---|---|

| 单分区强制有序 | Topic 仅设 1 个 Partition | 并行度归零,吞吐量骤降 | 低吞吐强有序场景 |

| Key-Based 业务有序 | 相同 Key 的消息路由到同一分区 | 需业务层排序逻辑 | 订单/用户行为追踪 |

业务层有序实现(以订单系统为例):

-

生产者:将订单 ID 作为消息 Key,确保同订单消息进入相同分区

typescript// NestJS 生产者示例 import { Producer, Message } from '@nestjs/microservices'; await this.kafkaProducer.send({ topic: 'order_events', messages: [ { key: orderId, // 相同订单ID确保同分区 value: JSON.stringify(payload) } ] }); -

消费者:

- 按 Key 分组消息,使用 Offset 顺序 在业务层排序

- 存储到时序数据库(如 InfluxDB)或 Elasticsearch 实现事件溯源

注意事项:需避免 Consumer 重平衡导致分区分配变化,可通过 max.poll.interval.ms 调优。

以订单系统为例(京东物流场景):

typescript

// NestJS 消费者有序处理示例

import { KafkaMessage } from '@nestjs/microservices';

class OrderProcessor {

private readonly orderMap: Map<string, Message[]> = new Map();

async handleMessage(message: KafkaMessage) {

const orderId = message.key.toString(); // 以订单ID为Key

const messages = this.orderMap.get(orderId) || [];

messages.push(message);

messages.sort((a, b) => a.offset - b.offset); // 按Offset排序

// 顺序处理:购物车→下单→物流→配送

for (const msg of messages) {

await this.processOrderStep(msg.value);

}

}

}关键技术点:

- 分区键设计:相同业务实体(如订单ID)映射到同一 Partition

- 时序数据库:使用 Elasticsearch 存储按 Offset 排序的消息流

- 消费者提交策略:手动提交 Offset 确保状态一致性

业务层有序方案

1 ) 强一致性方案

- 单Topic单分区架构

- 缺点:吞吐量骤降,仅支持单消费者

2 ) Key+Offset时序方案

- 实现原理:

- 将业务主键(如订单ID)作为消息Key

- 相同Key的消息路由到同一分区

- 消费者按Offset顺序处理同Key消息

typescript

// NestJS生产者示例

import { Message } from '@nestjs/microservices';

async function sendOrderEvent(orderId: string, event: object) {

await this.kafkaClient.emit('order_events', {

key: orderId, // 关键设计:业务主键作Key

value: JSON.stringify(event)

});

} - 消费端处理:

typescript

// 消费者按Key分组处理

@KafkaListener('order_events')

async handleOrderEvents(payload: Message) {

const events = await this.db.query(

`SELECT * FROM events WHERE key=$1 ORDER BY offset`,

[payload.key]

);

// 时序处理逻辑

} 3 ) 适用场景:

- 订单状态流转(创建→支付→发货)

- 用户行为追踪(页面浏览→点击→购买)

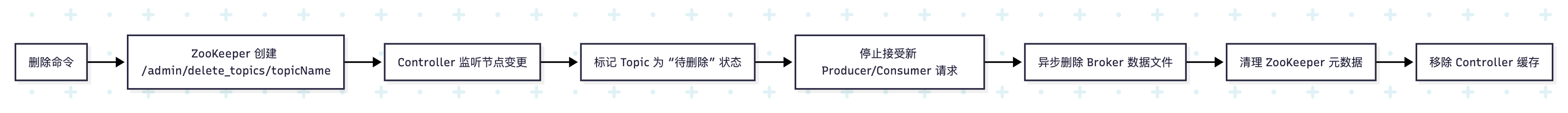

Kafka Topic 删除机制与生产环境实践

删除流程:

或参考如下

在/admin/delete_topics创建临时节点 节点创建事件 唤醒控制器线程 标记Topic为删除中 停止接受生产者请求 重命名Topic目录(.deleted后缀) 异步删除磁盘数据 删除完成 DeleteCommand ZKCreateNode TriggerWatcher WakeControllerThread MarkForDeletion StopTraffic RenameTopicDir DeletePartitions DeletePartitionsooKeeper元数据 RemoveZKMetadata

或

User Frontend Backend DB 提交表单 POST /api/data 查询数据 返回结果 响应JSON 显示成功页面 User Frontend Backend DB

关键风险与规避:

- 自动创建陷阱:

- 配置

auto.create.topics.enable=false,防止删除时 Producer 重建 Topic

- 配置

- 数据残留:

- 启用

delete.topic.enable=true(默认开启)

- 启用

- 流量隔离:

- 删除前通过负载均衡器切断流量(如 Nginx 屏蔽 Topic 域名)

- 通知上下游服务下线 Consumer/Producer

操作建议:

bash

# Kafka 删除命令(需验证 Topic 状态)

bin/kafka-topics.sh --delete \

--bootstrap-server localhost:9092 \

--topic high_risk_orders

# 监控删除状态

kafka-topics.sh --describe --topic high_risk_orders --bootstrap-server localhost:9092

# 强制清理残留数据(紧急情况)

bin/kafka-delete-records.sh \

--bootstrap-server localhost:9092 \

--offset-json-file offsets.json

# 物理清理(强制删除残留数据)

rm -rf /kafka-data/orders-*工程示例:1

1 ) 方案 1:原生 KafkaJS 集成

typescript

// producer.service.ts

import { Injectable } from '@nestjs/common';

import { Kafka, Producer, ProducerRecord } from 'kafkajs';

@Injectable()

export class KafkaService {

private producer: Producer;

constructor() {

const kafka = new Kafka({

brokers: ['kafka1:9092', 'kafka2:9092'],

ssl: true,

sasl: { mechanism: 'scram-sha-256', username: 'user', password: 'pass' }

});

this.producer = kafka.producer();

}

async sendMessage(topic: string, key: string, value: any) {

await this.producer.connect();

await this.producer.send({

topic,

messages: [{ key, value: JSON.stringify(value) }],

acks: -1 // 所有副本确认

});

}

}2 ) 方案 2:微服务透明接入

typescript

// main.ts

import { NestFactory } from '@nestjs/core';

import { MicroserviceOptions, Transport } from '@nestjs/microservices';

async function bootstrap() {

const app = await NestFactory.createMicroservice<MicroserviceOptions>(AppModule, {

transport: Transport.KAFKA,

options: {

client: {

brokers: ['kafka:9092'],

},

consumer: {

groupId: 'order-service',

allowAutoTopicCreation: false // 禁止自动创建Topic

}

}

});

await app.listen();

}3 ) 方案 3:Schema 注册集成(Avro 序列化)

typescript

// schema-registry.provider.ts

import { SchemaRegistry } from '@kafkajs/confluent-schema-registry';

export const schemaRegistryProvider = {

provide: 'SCHEMA_REGISTRY',

useFactory: () => new SchemaRegistry({ host: 'http://schema-registry:8081' })

};

// usage

const { id } = await registry.register({ type: 'AVRO', schema: orderSchema });

const encodedValue = await registry.encode(id, orderData);工程示例:2

1 ) 方案1:原生Kafkajs集成

typescript

// app.module.ts

import { KafkaModule } from 'nestjs-kafkajs-transport';

@Module({

imports: [

KafkaModule.register({

client: {

brokers: ['kafka1:9092'],

clientId: 'order-service'

},

consumer: { groupId: 'order-group' }

})

]

})

export class AppModule {} 2 ) 方案2:微服务架构封装

typescript

// main.ts

const app = await NestFactory.createMicroservice(AppModule, {

transport: Transport.KAFKA,

options: {

client: {

brokers: ['kafka1:9092'],

},

consumer: {

groupId: 'payment-group',

allowAutoTopicCreation: false // 关联生产配置

}

}

}); 3 ) 方案3:事务消息生产者

typescript

// transaction.producer.ts

import { Kafka, Producer } from 'kafkajs';

class TransactionalProducer {

private producer: Producer;

constructor() {

const kafka = new Kafka({

clientId: 'tx-client',

brokers: ['kafka1:9092'],

transactionTimeout: 30000

});

this.producer = kafka.producer({

idempotent: true, // 启用幂等

transactionalId: 'tx-order' // 事务ID

});

}

async sendInTransaction(messages: Message[]) {

const transaction = await this.producer.transaction();

try {

await transaction.send({ topic: 'orders', messages });

await transaction.commit();

} catch (e) {

await transaction.abort();

throw e;

}

}

} 工程示例:3

1 ) 方案1:基础生产者/消费者

typescript

// producer.service.ts

import { Injectable } from '@nestjs/common';

import { ClientKafka } from '@nestjs/microservices';

@Injectable()

export class OrderProducer {

constructor(private readonly client: ClientKafka) {}

async sendOrderEvent(orderId: string, payload: any) {

await this.client.emit('orders', {

key: orderId, // 关键:相同Key路由到同一分区

value: JSON.stringify(payload)

});

}

}

// consumer.service.ts

import { KafkaMessage } from '@nestjs/microservices';

@Controller()

export class OrderConsumer {

@EventPattern('orders')

async handleOrderMessage(message: KafkaMessage) {

const orderId = message.key.toString();

// 按Key分组处理(需实现本地排序逻辑)

}

}2 ) 方案2:事务性消息(Exactly-Once语义)

typescript

// transactional.producer.ts

import { Kafka, Producer } from 'kafkajs';

const kafka = new Kafka({ brokers: ['localhost:9092'] });

const producer = kafka.producer({

transactionalId: 'order-producer',

maxInFlightRequests: 1

});

async function sendTransactionalMessage() {

await producer.connect();

await producer.transaction().asyncRun(async () => {

await producer.send({

topic: 'orders',

messages: [{ key: 'order1', value: '...' }]

});

// 数据库操作(原子性保证)

await db.updateOrderStatus('order1', 'PAID');

});

}3 ) 方案3:Schema 注册(Confluent Schema Registry)

typescript

// schema-based.producer.ts

import { Kafka, SchemaRegistry } from '@kafkajs/confluent-schema-registry';

const registry = new SchemaRegistry({ host: 'http://schema-registry:8081' });

const kafka = new Kafka({ brokers: ['localhost:9092'] });

async function sendAvroMessage() {

const { id } = await registry.register({

type: 'record',

name: 'Order',

fields: [{ name: 'id', type: 'string' }]

});

const encoded = await registry.encode(id, { id: 'order-123' });

await producer.send({

topic: 'orders',

messages: [{ value: encoded }]

});

}关键配置清单

yaml

# kafka-config.yaml

acks: all # 全副本确认

compression.type: snappy # 压缩算法 或 lz4

max.in.flight.requests.per.connection: 1 # 保序模式

linger.ms: 20 # 批次等待时间

request.timeout.ms: 30000 # 超时阈值

enable.idempotence: true # 幂等发送

unclean.leader.election.enable: false

min.insync.replicas: 2 # 确保ISR最小副本数 生产环境配置

1 ) 必须配置

bash

# server.properties 关键配置

auto.create.topics.enable=false # 禁止自动创建Topic

delete.topic.enable=true # 启用物理删除

log.retention.hours=168 # 数据保留时间

unclean.leader.election.enable=false # 防止数据丢失2 ) 操作流程

- 前置操作:

bash

# 停止生产者

kafka-configs --bootstrap-server localhost:9092 \

--entity-type topics --entity-name my_topic \

--alter --add-config 'retention.ms=1000' # 加速日志删除 - 流量隔离:通过负载均衡器切断Topic访问

- 执行删除:

kafka-topics --delete --topic my_topic --bootstrap-server localhost:9092

3 ) 常见故障规避

- 问题:删除中Producer持续写入 → 导致新Topic自动创建

- 方案:前置配置

unclean.leader.election.enable=false避免数据不一致

进阶建议

1 ) 生产者优化

通过 max.in.flight.requests=1 牺牲吞吐换取强顺序,配合幂等性(enable.idempotence=true)防重复

2 ) 有序性本质

业务层通过 Key+Offset 组合排序才是 Kafka 高吞吐有序的最佳实践

3 ) 删除安全

生产环境务必结合 流量切流 + ZooKeeper 监控(stat /admin/delete_topics)

4 ) NestJS 实践

优先使用 @nestjs/microservices 抽象层,避免直接操作 KafkaJS 客户端

5 ) 监控指标

重点关注 ProducerBatchSizeAvg、RecordErrorRate、TopicDeletionTimeMs 等 JMX 指标。

周边配置要点

1 ) KafkaJS 配置:

typescript

// main.ts

app.connectMicroservice({

transport: Transport.KAFKA,

options: {

client: { brokers: ['kafka1:9092'] },

consumer: { groupId: 'order-service' },

producer: { allowAutoTopicCreation: false }

}

});2 ) 性能调优参数:

compression.type: 'snappy'(压缩提升吞吐)max.in.flight.requests.per.connection: 1(保序场景)acks: 'all'(ISR 全确认防数据丢失)

3 ) 监控集成:

yaml

# Prometheus 配置

kafka_metrics:

- kafka_producer_request_total

- kafka_consumer_lag_seconds关键知识补充

1 ) ISR 机制:

In-Sync Replicas 确保分区高可用,删除 Topic 时会校验 ISR 状态

2 ) Log Compaction:

对 Keyed Topic 的删除采用压缩而非物理删除

3 ) NestJS 生态替代方案:

- Spring Kafka →

@nestjs/microservices+kafkajs - Kafka Streams →

kafkajs+ 自定义状态机 - Connect API → NestJS + Kafka 自定义 Connector 模块

深度总结

- Producer优化本质:通过批处理+异步IO提升吞吐量,代价是引入毫秒级延迟

- 有序性真相:

- Kafka仅承诺分区内有序

- 业务有序需结合Key路由+时序数据库实现

- Topic删除核心:

- 依赖ZooKeeper协调的两阶段操作(流量隔离→数据清除)

- 生产环境必须配合流量调度系统操作

通过NestJS的@nestjs/microservices抽象层,开发者可无缝切换Kafka/RabbitMQ等消息中间件,但需警惕不同中间件的有序性语义差异(如RabbitMQ的全局有序需独占队列)。